Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Durch die Simulation von Gehirnfunktionen erreicht dieses KI-Modell wirklich kontinuierliches Lernen wie ein Mensch

Durch die Simulation von Gehirnfunktionen erreicht dieses KI-Modell wirklich kontinuierliches Lernen wie ein Mensch

Durch die Simulation von Gehirnfunktionen erreicht dieses KI-Modell wirklich kontinuierliches Lernen wie ein Mensch

Wie Durchbrüche in verschiedenen KI-Bereichen wie Bildverarbeitung, intelligente Gesundheitsversorgung, selbstfahrende Autos und intelligente Städte zeigen, erlebt Deep Learning zweifellos ein goldenes Zeitalter. Im Laufe des nächsten Jahrzehnts werden KI- und Computersysteme endlich über menschenähnliche Lern- und Denkfähigkeiten verfügen, um einen konstanten Informationsfluss zu verarbeiten und mit der realen Welt zu interagieren.

Allerdings erleiden aktuelle KI-Modelle Leistungseinbußen, wenn sie kontinuierlich auf neue Informationen trainiert werden. Dies liegt daran, dass bei der Generierung neuer Daten diese über die vorhandenen Daten geschrieben werden und die vorherigen Informationen gelöscht werden. Dieser Effekt wird als „katastrophales Vergessen“ bezeichnet. Das Stabilitäts-Plastizitäts-Dilemma führt dazu, dass KI-Modelle ihr Gedächtnis aktualisieren müssen, um sich kontinuierlich an neue Informationen anzupassen und gleichzeitig die Stabilität des aktuellen Wissens aufrechtzuerhalten. Dieses Problem verhindert, dass SOTA-KI-Modelle kontinuierlich aus realen Informationen lernen.

Mittlerweile ermöglichen Edge-Computing-Systeme die Verlagerung der Datenverarbeitung aus Cloud-Speichern und Rechenzentren näher an die ursprüngliche Quelle, beispielsweise Geräte, die mit dem Internet der Dinge verbunden sind. Die effiziente Anwendung von kontinuierlichem Lernen auf ressourcenbeschränkten Edge-Computing-Geräten bleibt eine Herausforderung, obwohl in diesem Bereich viele Modelle für kontinuierliches Lernen vorgeschlagen wurden, um dieses Problem zu lösen. Herkömmliche Modelle erfordern eine hohe Rechenleistung und große Speicherkapazität.

Kürzlich hat ein Forschungsteam der Singapore University of Technology and Design (SUTD) ein neues Modell entwickelt, das ein äußerst energieeffizientes System für kontinuierliches Lernen erreichen kann, indem es „Continuous Learning Electrical Conduction“ untersucht in Resistive-Switching“-Memory Materials“ wurde in der Fachzeitschrift „Advanced Theory and Simulation“ veröffentlicht.

Papieradresse: https://onlinelibrary.wiley.com/doi/abs/10.1002/adts.202200226

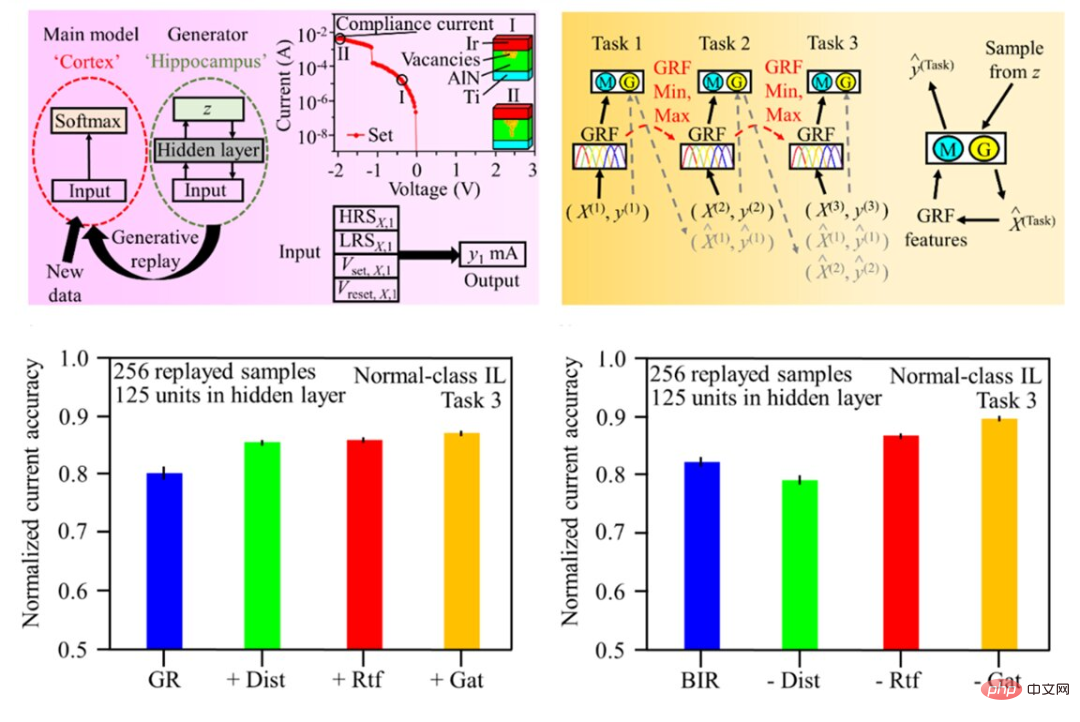

Das Team schlägt ein vom Gehirn inspiriertes Modell vor – Brain-Inspired Replay (BIR) – das kontinuierliches Lernen auf natürliche Weise ermöglicht. Das BIR-Modell basiert auf künstlichen neuronalen Netzen und Variations-Autoencodern, um die Funktionen des menschlichen Gehirns zu simulieren, und kann auch in inkrementellen Lernszenarien ohne gespeicherte Daten gut funktionieren. Forscher haben auch BIR-Modelle verwendet, um das Wachstum leitfähiger Filamente mithilfe von elektrischem Strom in digitalen Speichersystemen darzustellen.

Oben links in der Abbildung unten werden die generativen Wiedergabeeinstellungen angezeigt, oben rechts das Training des künstlichen neuronalen Netzwerks mit generativer Wiedergabe; unten links und unten rechts wird die normalisierte aktuelle Genauigkeit angezeigt des konventionellen bzw. BIR-Modells.

Assistenzprofessor Loke, einer der entsprechenden Autoren des Papiers, erklärte: „In BIR wird Wissen im trainierten Modell gespeichert , wodurch der Leistungsverlust bei der Einführung zusätzlicher Aufgaben ohne Rückgriff auf Daten aus früheren Arbeiten minimiert wird. Daher kann dieser Ansatz viel Energie sparen.“ Er fügte außerdem hinzu: „Ohne die Speicherung von Daten wird eine SOTA-Genauigkeit von 89 % bei der Compliance-Herausforderung erreicht.“ „#🎜🎜 #

Das obige ist der detaillierte Inhalt vonDurch die Simulation von Gehirnfunktionen erreicht dieses KI-Modell wirklich kontinuierliches Lernen wie ein Mensch. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1376

1376

52

52

So verwenden Sie MySQL nach der Installation

Apr 08, 2025 am 11:48 AM

So verwenden Sie MySQL nach der Installation

Apr 08, 2025 am 11:48 AM

Der Artikel führt den Betrieb der MySQL -Datenbank vor. Zunächst müssen Sie einen MySQL -Client wie MySQLworkBench oder Befehlszeilen -Client installieren. 1. Verwenden Sie den Befehl mySQL-uroot-P, um eine Verbindung zum Server herzustellen und sich mit dem Stammkonto-Passwort anzumelden. 2. Verwenden Sie die Erstellung von Createdatabase, um eine Datenbank zu erstellen, und verwenden Sie eine Datenbank aus. 3.. Verwenden Sie CreateTable, um eine Tabelle zu erstellen, Felder und Datentypen zu definieren. 4. Verwenden Sie InsertInto, um Daten einzulegen, Daten abzufragen, Daten nach Aktualisierung zu aktualisieren und Daten nach Löschen zu löschen. Nur indem Sie diese Schritte beherrschen, lernen, mit gemeinsamen Problemen umzugehen und die Datenbankleistung zu optimieren, können Sie MySQL effizient verwenden.

So stellen Sie die Zeitüberschreitung von Vue Axios fest

Apr 07, 2025 pm 10:03 PM

So stellen Sie die Zeitüberschreitung von Vue Axios fest

Apr 07, 2025 pm 10:03 PM

Um die Zeitüberschreitung für Vue Axios festzulegen, können wir eine Axios -Instanz erstellen und die Zeitleitungsoption angeben: in globalen Einstellungen: vue.Prototyp. $ Axios = axios.create ({Timeout: 5000}); In einer einzigen Anfrage: this. $ axios.get ('/api/user', {timeout: 10000}).

Wie man MySQL löst, kann nicht gestartet werden

Apr 08, 2025 pm 02:21 PM

Wie man MySQL löst, kann nicht gestartet werden

Apr 08, 2025 pm 02:21 PM

Es gibt viele Gründe, warum MySQL Startup fehlschlägt und durch Überprüfung des Fehlerprotokolls diagnostiziert werden kann. Zu den allgemeinen Ursachen gehören Portkonflikte (prüfen Portbelegung und Änderung der Konfiguration), Berechtigungsprobleme (Überprüfen Sie den Dienst Ausführen von Benutzerberechtigungen), Konfigurationsdateifehler (Überprüfung der Parametereinstellungen), Datenverzeichniskorruption (Wiederherstellung von Daten oder Wiederaufbautabellenraum), InnoDB-Tabellenraumprobleme (prüfen IBDATA1-Dateien), Plug-in-Ladeversagen (Überprüfen Sie Fehlerprotokolle). Wenn Sie Probleme lösen, sollten Sie sie anhand des Fehlerprotokolls analysieren, die Hauptursache des Problems finden und die Gewohnheit entwickeln, Daten regelmäßig zu unterstützen, um Probleme zu verhindern und zu lösen.

Laravels Geospatial: Optimierung interaktiver Karten und großen Datenmengen

Apr 08, 2025 pm 12:24 PM

Laravels Geospatial: Optimierung interaktiver Karten und großen Datenmengen

Apr 08, 2025 pm 12:24 PM

Verarbeiten Sie 7 Millionen Aufzeichnungen effizient und erstellen Sie interaktive Karten mit Geospatial -Technologie. In diesem Artikel wird untersucht, wie über 7 Millionen Datensätze mithilfe von Laravel und MySQL effizient verarbeitet und in interaktive Kartenvisualisierungen umgewandelt werden können. Erstes Herausforderungsprojektanforderungen: Mit 7 Millionen Datensätzen in der MySQL -Datenbank wertvolle Erkenntnisse extrahieren. Viele Menschen erwägen zunächst Programmiersprachen, aber ignorieren die Datenbank selbst: Kann sie den Anforderungen erfüllen? Ist Datenmigration oder strukturelle Anpassung erforderlich? Kann MySQL einer so großen Datenbelastung standhalten? Voranalyse: Schlüsselfilter und Eigenschaften müssen identifiziert werden. Nach der Analyse wurde festgestellt, dass nur wenige Attribute mit der Lösung zusammenhängen. Wir haben die Machbarkeit des Filters überprüft und einige Einschränkungen festgelegt, um die Suche zu optimieren. Kartensuche basierend auf der Stadt

Remote Senior Backend Engineers (Plattformen) benötigen Kreise

Apr 08, 2025 pm 12:27 PM

Remote Senior Backend Engineers (Plattformen) benötigen Kreise

Apr 08, 2025 pm 12:27 PM

Remote Senior Backend Engineer Job Vacant Company: Circle Standort: Remote-Büro-Jobtyp: Vollzeitgehalt: 130.000 bis 140.000 US-Dollar Stellenbeschreibung Nehmen Sie an der Forschung und Entwicklung von Mobilfunkanwendungen und öffentlichen API-bezogenen Funktionen, die den gesamten Lebenszyklus der Softwareentwicklung abdecken. Die Hauptaufgaben erledigen die Entwicklungsarbeit unabhängig von RubyonRails und arbeiten mit dem Front-End-Team von React/Redux/Relay zusammen. Erstellen Sie die Kernfunktionalität und -verbesserungen für Webanwendungen und arbeiten Sie eng mit Designer und Führung während des gesamten funktionalen Designprozesses zusammen. Fördern Sie positive Entwicklungsprozesse und priorisieren Sie die Iterationsgeschwindigkeit. Erfordert mehr als 6 Jahre komplexes Backend für Webanwendungen

So optimieren Sie die Datenbankleistung nach der MySQL -Installation

Apr 08, 2025 am 11:36 AM

So optimieren Sie die Datenbankleistung nach der MySQL -Installation

Apr 08, 2025 am 11:36 AM

Die MySQL -Leistungsoptimierung muss von drei Aspekten beginnen: Installationskonfiguration, Indexierung und Abfrageoptimierung, Überwachung und Abstimmung. 1. Nach der Installation müssen Sie die my.cnf -Datei entsprechend der Serverkonfiguration anpassen, z. 2. Erstellen Sie einen geeigneten Index, um übermäßige Indizes zu vermeiden und Abfrageanweisungen zu optimieren, z. B. den Befehl Erklärung zur Analyse des Ausführungsplans; 3. Verwenden Sie das eigene Überwachungstool von MySQL (ShowProcessList, Showstatus), um die Datenbankgesundheit zu überwachen und die Datenbank regelmäßig zu sichern und zu organisieren. Nur durch kontinuierliche Optimierung dieser Schritte kann die Leistung der MySQL -Datenbank verbessert werden.

Wie optimieren Sie die MySQL-Leistung für Hochlastanwendungen?

Apr 08, 2025 pm 06:03 PM

Wie optimieren Sie die MySQL-Leistung für Hochlastanwendungen?

Apr 08, 2025 pm 06:03 PM

Die MySQL-Datenbankleistung Optimierungshandbuch In ressourcenintensiven Anwendungen spielt die MySQL-Datenbank eine entscheidende Rolle und ist für die Verwaltung massiver Transaktionen verantwortlich. Mit der Erweiterung der Anwendung werden jedoch die Datenbankleistung Engpässe häufig zu einer Einschränkung. In diesem Artikel werden eine Reihe effektiver Strategien zur Leistungsoptimierung von MySQL -Leistung untersucht, um sicherzustellen, dass Ihre Anwendung unter hohen Lasten effizient und reaktionsschnell bleibt. Wir werden tatsächliche Fälle kombinieren, um eingehende Schlüsseltechnologien wie Indexierung, Abfrageoptimierung, Datenbankdesign und Caching zu erklären. 1. Das Design der Datenbankarchitektur und die optimierte Datenbankarchitektur sind der Eckpfeiler der MySQL -Leistungsoptimierung. Hier sind einige Kernprinzipien: Die Auswahl des richtigen Datentyps und die Auswahl des kleinsten Datentyps, der den Anforderungen entspricht, kann nicht nur Speicherplatz speichern, sondern auch die Datenverarbeitungsgeschwindigkeit verbessern.

Verstehen von Säureeigenschaften: Die Säulen einer zuverlässigen Datenbank

Apr 08, 2025 pm 06:33 PM

Verstehen von Säureeigenschaften: Die Säulen einer zuverlässigen Datenbank

Apr 08, 2025 pm 06:33 PM

Detaillierte Erläuterung von Datenbanksäureattributen Säureattribute sind eine Reihe von Regeln, um die Zuverlässigkeit und Konsistenz von Datenbanktransaktionen sicherzustellen. Sie definieren, wie Datenbanksysteme Transaktionen umgehen, und sorgen dafür, dass die Datenintegrität und -genauigkeit auch im Falle von Systemabstürzen, Leistungsunterbrechungen oder mehreren Benutzern gleichzeitiger Zugriff. Säureattributübersicht Atomizität: Eine Transaktion wird als unteilbare Einheit angesehen. Jeder Teil schlägt fehl, die gesamte Transaktion wird zurückgerollt und die Datenbank behält keine Änderungen bei. Wenn beispielsweise eine Banküberweisung von einem Konto abgezogen wird, jedoch nicht auf ein anderes erhöht wird, wird der gesamte Betrieb widerrufen. begintransaktion; updateAccountsSetBalance = Balance-100WH