Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Der erste 100-Milliarden-Modell-Komprimierungsalgorithmus SparseGPT ist da und reduziert die Kosten für die Rechenleistung bei gleichzeitiger Beibehaltung einer hohen Genauigkeit

Der erste 100-Milliarden-Modell-Komprimierungsalgorithmus SparseGPT ist da und reduziert die Kosten für die Rechenleistung bei gleichzeitiger Beibehaltung einer hohen Genauigkeit

Der erste 100-Milliarden-Modell-Komprimierungsalgorithmus SparseGPT ist da und reduziert die Kosten für die Rechenleistung bei gleichzeitiger Beibehaltung einer hohen Genauigkeit

Seit dem Aufkommen von GPT-3 im Jahr 2020 hat die Popularität von ChatGPT die generativen großen Sprachmodelle der GPT-Familie erneut ins Rampenlicht gerückt und sie haben bei verschiedenen Aufgaben eine starke Leistung gezeigt.

Der enorme Umfang des Modells führt jedoch auch zu einem Anstieg der Rechenkosten und einer Zunahme der Bereitstellungsschwierigkeiten.

Zum Beispiel belegt das Modell GPT-175B insgesamt mindestens 320 GB Speicherplatz im Halbgenauigkeitsformat (FP16). mit 80 GB Speicherplatz erforderlich.

Die Modellkomprimierung ist eine häufig verwendete Methode zur Reduzierung der Rechenkosten großer Modelle. Bisher konzentrieren sich jedoch fast alle vorhandenen GPT-Komprimierungsmethoden alle auf die Quantisierung, d. Verringerung der Genauigkeit der numerischen Darstellung eines einzelnen Gewichts.

Eine weitere Methode der Modellkomprimierung ist das Pruning, bei dem Netzwerkelemente entfernt werden, die von einzelnen Gewichten (unstrukturiertes Pruning) bis hin zu Komponenten mit höherer Granularität wie ganzen Zeilen/Spalten reichen von Gewichtsmatrizen (strukturiertes Pruning). Dieser Ansatz funktioniert gut in Vision- und kleineren Sprachmodellen, führt jedoch zu einem Genauigkeitsverlust und erfordert eine umfangreiche Neuschulung des Modells, um die Genauigkeit wiederherzustellen, sodass die Kosten bei groß angelegten Modellen wie GPT erneut zu hoch werden . Obwohl es einige Single-Shot-Pruning-Methoden gibt, mit denen das Modell ohne erneutes Training komprimiert werden kann, sind sie zu rechenintensiv und schwer auf Modelle mit Milliarden von Parametern anzuwenden.

Gibt es also für ein großes Modell der Größe von GPT-3 eine Möglichkeit, es genau zu beschneiden und gleichzeitig einen minimalen Genauigkeitsverlust beizubehalten und die Kosten zu reduzieren?

Kürzlich haben zwei Forscher des Österreichischen Instituts für Wissenschaft und Technologie (ISTA), Elias Frantar und Dan Alistarh, an einer Studie zusammengearbeitet, die auf 10 bis 100 Milliarden Parameter abzielte Zum ersten Mal im Modellmaßstab wird eine genaue Einzelschuss-Beschneidungsmethode SparseGPT vorgeschlagen.

Papieradresse: https://arxiv.org/pdf/2301.00774 .pdf

SparseGPT kann das GPT-Serienmodell in einem einzigen Schritt ohne Umschulung auf 50 % Sparsity beschneiden. Das größte öffentlich verfügbare Modell, GPT-175B, erreicht diese Bereinigung mit einer einzigen GPU in nur wenigen Stunden.

Darüber hinaus ist SparseGPT auch sehr genau und kann den Genauigkeitsverlust minimieren. Wenn beispielsweise SparseGPT auf den derzeit größten Open-Source-Modellen OPT-175B und BLOOM-176B ausgeführt wird, kann eine Sparsity von 60 % erreicht und gleichzeitig der Genauigkeitsverlust minimiert werden.

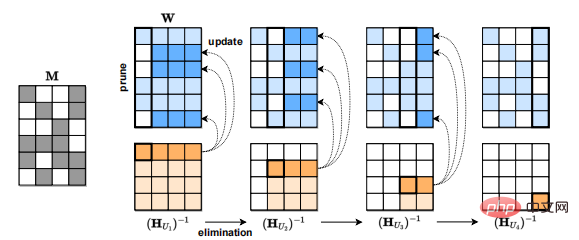

Electric Drive SparseGPT-Algorithmus

Die Forschung an sehr großen Modellen war in den letzten Jahren sehr aktiv, aber Bisher gibt es kein Modell mit mehr als 10 Milliarden Parametern, das eine sehr genaue hohe Sparsifizierung erreichen kann.

Bestehende Methoden stellen zu hohe Anforderungen an den Rechenaufwand. Am Beispiel der derzeit genauesten Post-Training-Methode OBC ist für ein Milliarde-Parameter-Modell eine Stunde erforderlich oder mehr zum Komprimieren. Die schnellste bekannte Post-Training-Methode, AdaPrune, benötigt ebenfalls Minuten, um ein Modell mit einer Milliarde Parametern zu bereinigen, und bei dieser Geschwindigkeit erfordert ein Modell im Maßstab von GPT-3 schätzungsweise Hunderte von Stunden (Wochen) Berechnung.

Die meisten bestehenden Beschneidungsmethoden, wie z. B. das schrittweise Beschneiden, erfordern nach dem Beschneidungsschritt eine umfangreiche Neuschulung, um die Genauigkeit wiederherzustellen, und Modelle im GPT-Maßstab erfordern normalerweise einen großen Rechen- und Parameteraufwand Anpassung für Training oder Feinabstimmung, was die Anwendung umschulungsbasierter Methoden erschwert. Daher ist die Anwendung dieses progressiven Beschneidungsansatzes im GPT-Maßstab nicht möglich.

Diese Arbeit des ISTA-Teams schlägt die SparseGPT-Methode vor, die Modelle mit mehr als 100 Milliarden Parametern auf einer einzigen GPU in wenigen Stunden ausführen kann und ausreichend genau ist to Modelle werden auf ein Sparsity-Niveau von 50–60 % reduziert, ohne die Leistung wesentlich zu beeinträchtigen.

Der Kern von SparseGPT ist ein neuer groß angelegter ungefährer spärlicher Regressionsalgorithmus, der auf halbstrukturierte Muster (2:4 und 4:8) verallgemeinert werden kann Kompatibel mit vorhandenen Gewichtsquantisierungsmethoden.

Die meisten vorhandenen Beschneidungsmethoden wie das progressive Amplitudenbeschneiden (Gradual Magnitude Pruning) Nach dem Bereinigungsschritt ist eine große Umschulung erforderlich, um die Genauigkeit wiederherzustellen, und Modelle im GPT-Maßstab erfordern normalerweise eine große Menge an Berechnungen und Parameteranpassungen für das Training oder die Feinabstimmung, was die Anwendung von Umschulungsmethoden erschwert. Daher ist die Anwendung dieses progressiven Beschneidungsansatzes im GPT-Maßstab nicht möglich.

SparseGPT ist eine Post-Training-Methode für Modelle im GPT-Maßstab, da keine Feinabstimmung durchgeführt wird.

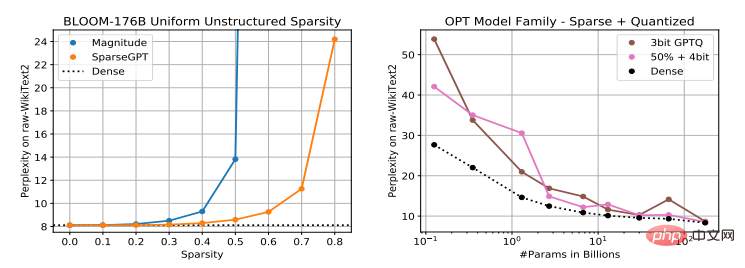

Es gibt derzeit viele Methoden zur Quantifizierung von Modellen im GPT-Maßstab nach dem Training, wie ZeroQuant, LLM.int8() und nuQmm usw., aber die Aktivierungsquantisierung kann aufgrund des Vorhandenseins abnormaler Merkmale schwierig sein. GPTQ nutzt ungefähre Informationen zweiter Ordnung, um Gewichte genau auf 2–4 Bit zu quantisieren, was für die größten Modelle geeignet ist und in Kombination mit effizienten GPU-Kernen zu einer 2–5-fachen Inferenzbeschleunigung führen kann.

Aber da sich GPTQ auf Sparsifizierung und nicht auf Quantisierung konzentriert, ist SparseGPT eine Ergänzung zur Quantifizierungsmethode, und beide können in Kombination angewendet werden.

Darüber hinaus eignet sich SparseGPT neben unstrukturiertem Pruning auch für halbstrukturierte Muster, wie das beliebte n:m-Sparse-Format, das auf Ampere-NVIDIA-GPUs eine Beschleunigung im Verhältnis 2:4 erreichen kann.

SparseGPT: hoher Sparsifizierungsgrad, geringer Genauigkeitsverlust

Nach der Bewertung des Effekts des SparseGPT-Komprimierungsmodells stellten die Forscher fest, dass die Schwierigkeit der Sparsifizierung großer Sprachmodelle proportional zur Modellgröße ist, die sich von bestehenden Modellen unterscheidet Mit der Magnitude Pruning-Methode kann durch die Verwendung von SparseGPT ein höherer Grad an Modellsparsität bei gleichzeitig minimalem Genauigkeitsverlust erreicht werden.

Die Forscher implementierten SparseGPT auf PyTorch und verwendeten die Transformers-Bibliothek von HuggingFace, um das Modell und den Datensatz zu verarbeiten, alles auf einer einzigen NVIDIA A100-GPU mit 80 GB Speicher. Unter solchen experimentellen Bedingungen kann SparseGPT in etwa 4 Stunden eine vollständige Sparsifizierung eines Modells mit 175 Milliarden Parametern erreichen.

Die Forscher teilen Transformer-Schichten nacheinander aus, was den Speicherbedarf erheblich reduziert und auch die Genauigkeit der parallelen Verarbeitung aller Schichten erheblich verbessert. Alle Kompressionsexperimente wurden in einem Durchgang ohne Feinabstimmung durchgeführt.

Bei den Bewertungsobjekten handelt es sich hauptsächlich um Modelle der OPT-Serie, die eine Reihe von Modellen mit 125 Millionen bis 175 Milliarden Parametern umfassen, wodurch die Skalierungsleistung des Beschneidens im Verhältnis zur Modellgröße leicht beobachtet werden kann. Zusätzlich wurden 176 Milliarden Parametervarianten von BLOOM analysiert.

In Bezug auf Datensätze und Bewertungsmetriken nutzt das Experiment die Verwirrung des ursprünglichen WikiText2-Testsatzes, um die Genauigkeit der SparseGPT-Komprimierungsmethode zu bewerten. Gleichzeitig werden einige ZeroShot-Genauigkeitsmetriken verwendet, um die Interpretierbarkeit zu erhöhen auch verwendet. Darüber hinaus konzentriert sich die Bewertung auf die Genauigkeit des spärlichen Modells im Verhältnis zur Grundlinie des dichten Modells und nicht auf absolute Zahlen.

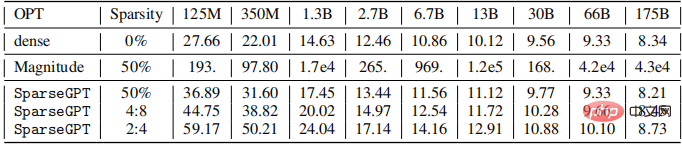

Die Forscher beschneiden alle linearen Schichten der gesamten OPT-Modellreihe (mit Ausnahme von Standardeinbettungen und Headern), um 50 % unstrukturierte Sparsity zu erreichen, volle 4:8 bzw. volle halbstrukturierte Sparsity, die Ergebnisse sind wie folgt unten dargestellt.

Es ist ersichtlich, dass die Genauigkeit des durch Amplitudenbeschneidung komprimierten Modells bei allen Größen schlecht ist und je größer das Modell ist, desto stärker sinkt die Genauigkeit.

Der Trend der mit SparseGPT komprimierten Modelle ist unterschiedlich. Unter 2,7 Milliarden Parametern beträgt der Ratlosigkeitsverlust

Große Modelle sind leichter zu spärlich zu besetzen

Bei einem festen Sparsity-Level nimmt die relative Genauigkeit von spärlichen Modellen im Vergleich zu dichten Modellen ab, wenn die Modellgröße zunimmt . Die Autoren vermuten, dass dies an ihrem höheren Parametrisierungsgrad und ihrer insgesamt größeren Immunität gegenüber Rauschen liegen könnte.

Verglichen mit der Basislinie des dichten Modells beträgt das Ratlosigkeitswachstum bei maximalem Maßstab bei Verwendung von SparseGPT zum Komprimieren des Modells auf 4:8 und 2:4 Sparsity nur 0,11 bzw. 0,39. Dieses Ergebnis bedeutet, dass wir in der Praxis eine Geschwindigkeitssteigerung um das Zweifache erreichen können und kommerzielle NVIDIA Ampere-GPUs bereits 2:4 Sparsity unterstützen.

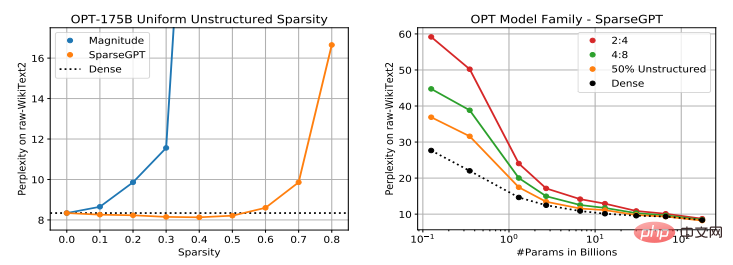

Der Autor untersuchte den Zusammenhang zwischen der Leistung von zwei Milliarden Modellen, OPT-175B und BLOOM-176B, und dem Grad der Sparsity, der durch die Verwendung von SparseGPT entsteht. Die Ergebnisse sind in der folgenden Abbildung dargestellt.

Es ist ersichtlich, dass beim Modell OPT-175B durch Amplitudenbeschneidung eine Sparsität von bis zu 10 % erreicht werden kann, gefolgt von einem großen Genauigkeitsverlust. SparseGPT kann mit zunehmender Ratlosigkeit auch eine Sparsität von 60 % erreichen.

Für das BLOOM-176B-Modell kann durch Amplitudenbereinigung zwar eine Sparsität von 30 % ohne nennenswerten Genauigkeitsverlust erreicht werden, im Vergleich dazu kann SparseGPT eine Sparsität von 50 % erreichen, was einer Verbesserung um das 1,66-fache entspricht. Darüber hinaus bleibt die Perplexität des mit SparseGPT komprimierten Modells bei 80 % Sparsity immer noch auf einem angemessenen Niveau, aber wenn die Amplitudenbereinigung 40 % Sparsity von OPT und 60 % Sparsity von BLOOM erreicht, beträgt die Perplexität bereits > 100.

Darüber hinaus ist SparseGPT in der Lage, etwa 100 Milliarden Gewichte aus diesen Modellen zu entfernen, mit begrenzten Auswirkungen auf die Modellgenauigkeit.

Schließlich zeigt diese Studie zum ersten Mal, dass ein groß angelegtes vorab trainiertes Modell auf Basis von Transformer durch einmalige Gewichtsbereinigung ohne Umschulung und mit sehr geringem Genauigkeitsverlust auf eine hohe Sparsität komprimiert werden kann.

Es ist erwähnenswert, dass die Methode von SparseGPT lokal ist: Nach jedem Bereinigungsschritt werden Gewichtsaktualisierungen durchgeführt, um die Eingabe-Ausgabe-Beziehung jeder Ebene beizubehalten, und diese Aktualisierungen werden ohne unter den gegebenen Umständen berechnete globale Gradienteninformationen durchgeführt . Daher scheint der hohe Parametrisierungsgrad großer GPT-Modelle es diesem Ansatz zu ermöglichen, spärlich genaue Modelle unter den „Nachbarn“ dichter vorab trainierter Modelle direkt zu identifizieren.

Da außerdem der im Experiment verwendete Genauigkeitsindikator (Perplexität) sehr empfindlich ist, scheint die generierte Ausgabe des spärlichen Modells eng mit der Ausgabe des dichten Modells verknüpft zu sein.

Diese Forschung ist von großer positiver Bedeutung für die Linderung der Rechenleistungsbeschränkungen großer Modelle. Eine zukünftige Arbeitsrichtung besteht darin, den Feinabstimmungsmechanismus großer Modelle zu untersuchen und gleichzeitig die Genauigkeit von SparseGPT zu erweitern Modelltraining. Durch die Anwendbarkeit wird der Rechenaufwand für das Training großer Modelle reduziert.

Das obige ist der detaillierte Inhalt vonDer erste 100-Milliarden-Modell-Komprimierungsalgorithmus SparseGPT ist da und reduziert die Kosten für die Rechenleistung bei gleichzeitiger Beibehaltung einer hohen Genauigkeit. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1378

1378

52

52

Roadmap zeigt den Trend, dass KI menschliche Berufe „ersetzt'.

Jan 04, 2024 pm 04:32 PM

Roadmap zeigt den Trend, dass KI menschliche Berufe „ersetzt'.

Jan 04, 2024 pm 04:32 PM

Ich habe gestern ein interessantes Bild gesehen, das eine „Ebenenkarte der KI, die menschliche Wege ersetzt“ zeigte. Wie im Bild gezeigt, ist das Spiel in sechs verschiedene Level unterteilt, von E1 bis E8+. Anhand der Abbildung können wir erkennen, dass künstliche Intelligenz (KI) menschliche Anwendungen in verschiedenen Bereichen ersetzt. Der Anwendungsbereich der künstlichen Intelligenz wird durch ihre Fehlertoleranzrate bestimmt. Kurz gesagt bezieht sich die Fehlertoleranz hier auf die Kosten für Versuch und Irrtum. KI wird nach und nach Branchen mit höheren bis niedrigeren Fehlertoleranzraten ersetzen und menschliche Berufe nach und nach „ersetzen“. Früher dachten wir oft, kreative Arbeit beruhe auf menschlichem Denken und sei nicht einfach zu ersetzen. Mit der Entwicklung der künstlichen Intelligenz scheint diese Ansicht jedoch nicht ganz richtig zu sein. In kreativen Berufen gibt es oft keine festen Antworten

Der erste 100-Milliarden-Modell-Komprimierungsalgorithmus SparseGPT ist da und reduziert die Kosten für die Rechenleistung bei gleichzeitiger Beibehaltung einer hohen Genauigkeit

Apr 12, 2023 pm 01:01 PM

Der erste 100-Milliarden-Modell-Komprimierungsalgorithmus SparseGPT ist da und reduziert die Kosten für die Rechenleistung bei gleichzeitiger Beibehaltung einer hohen Genauigkeit

Apr 12, 2023 pm 01:01 PM

Seit der Einführung von GPT-3 im Jahr 2020 hat die Popularität von ChatGPT die generativen groß angelegten Sprachmodelle der GPT-Familie erneut ins Rampenlicht gerückt und sie haben bei verschiedenen Aufgaben eine starke Leistung gezeigt. Der enorme Umfang des Modells führt jedoch auch zu höheren Rechenkosten und erhöhten Schwierigkeiten bei der Bereitstellung. Das Modell GPT-175B verfügt beispielsweise über insgesamt mindestens 320 GB Speicher im Half-Precision-Format (FP16), was für die Inferenz mindestens fünf A100-GPUs mit 80 GB Speicher erfordert. Die Modellkomprimierung ist derzeit eine häufig verwendete Methode, um den Rechenaufwand großer Modelle zu reduzieren, aber bisher gibt es fast alle

Generative KI in der Cloud: Bauen oder kaufen?

Dec 19, 2023 pm 08:15 PM

Generative KI in der Cloud: Bauen oder kaufen?

Dec 19, 2023 pm 08:15 PM

Zusammengestellt von David Linsigao |. Produkte produziert von Yanzheng 51CTO Technology Stack (WeChat ID: blog51cto) Es gibt eine ungeschriebene Regel im Technologiebereich: Jeder nutzt gerne die Technologie anderer Leute. Doch für viele Unternehmen scheint generative KI nicht in dieses Schema zu passen. Generative KI treibt schnell einige wichtige Entscheidungen voran. Jedes Unternehmen steht vor einer wichtigen Entscheidung: ob es intern eine benutzerdefinierte generative KI-Plattform aufbaut oder eine vorgefertigte Lösung von einem KI-Anbieter kauft (häufig als Cloud-Service angeboten, was Volumen und Möglichkeiten begünstigt). Es ist seltsam, aber der Grund könnte Sie überraschen. Sie könnten Sie sogar dazu veranlassen, die GenAI-Strategie Ihres Unternehmens zu überdenken. 1. Vollständige Anpassung und Kontrolle. Schreiben Sie den Inhalt wie folgt um: Erstellen Sie eine

C++-Programm zur Berechnung der Gesamtkosten, die ein Roboter benötigt, um eine Fahrt in einem Raster abzuschließen

Aug 25, 2023 pm 04:53 PM

C++-Programm zur Berechnung der Gesamtkosten, die ein Roboter benötigt, um eine Fahrt in einem Raster abzuschließen

Aug 25, 2023 pm 04:53 PM

Angenommen, wir haben ein Gitter der Größe hxb. Jede Zelle im Raster enthält eine positive ganze Zahl. Nun gibt es einen Wegfindungsroboter, der auf einer bestimmten Zelle (p, q) platziert ist (wobei p die Zeilennummer und q die Spaltennummer ist) und er kann sich zur Zelle (i, j) bewegen. Der Verschiebungsvorgang verursacht spezifische Kosten in Höhe von |p-i|+|q-j|. Mittlerweile gibt es q Fahrten mit folgenden Eigenschaften. Jede Reise hat zwei Werte (x, y) und einen gemeinsamen Wert d. Der Roboter wird auf einer Zelle mit dem Wert x platziert und bewegt sich dann zu einer anderen Zelle mit dem Wert x+d. Dann wird in eine andere Zelle mit dem Wert x+d+d verschoben. Dieser Vorgang wird fortgesetzt, bis der Roboter eine Zelle mit einem Wert größer oder gleich y erreicht. y-x ist ein Vielfaches von d

Minimaler Aufwand für die Umwandlung von 1 in N, der durch Multiplikation mit X oder Rechtsdrehung der Zahl erreicht werden kann

Sep 12, 2023 pm 08:09 PM

Minimaler Aufwand für die Umwandlung von 1 in N, der durch Multiplikation mit X oder Rechtsdrehung der Zahl erreicht werden kann

Sep 12, 2023 pm 08:09 PM

Wir können die folgende Technik verwenden, um den günstigsten Weg zu finden, X zu multiplizieren oder seine Zahl nach rechts von 1 nach N zu drehen. Um die anfänglichen Mindestkosten zu überwachen, erstellen Sie eine Kostenvariable. Wenn Sie von N auf 1 gehen, prüfen Sie auf jeder Stufe, ob N durch X teilbar ist. Wenn dies der Fall ist, dividieren Sie N durch X, um es zu aktualisieren und den Vorgang fortzusetzen. Wenn N nicht durch X teilbar ist, schleifen Sie die Ziffern von N nach rechts, um seinen Wert zu erhöhen. Fügen Sie in diesem Fall die Kostenvariable hinzu. Der endgültige Wert der Kostenvariablen ist der Mindestbetrag, der erforderlich ist, um 1 in N umzuwandeln. Der Algorithmus ermittelt mithilfe numerischer Rotation oder Multiplikation effizient die zur Durchführung der gewünschten Transformation erforderlichen Mindestoperationen. Verwendete Methode: Naiver Ansatz: Rechtsdrehung von Zahlen. Effiziente Methode: Mit X multiplizieren. Einfache Methode: Rechtsdrehung von Zahlen. Der naive Ansatz besteht darin, mit der Zahl 1 zu beginnen und sie wiederholt

Erforschung des Geheimnisses der Reifenpreise für Elektrofahrzeuge: Die Kosten hinter der Umweltenergie werden enthüllt

Aug 25, 2023 am 10:21 AM

Erforschung des Geheimnisses der Reifenpreise für Elektrofahrzeuge: Die Kosten hinter der Umweltenergie werden enthüllt

Aug 25, 2023 am 10:21 AM

Da das Bewusstsein für den Umweltschutz weltweit immer weiter zunimmt, haben sich verschiedene Länder für die Entwicklung neuer Energiefahrzeuge eingesetzt, wodurch Elektrofahrzeuge zu einem Highlight des Automobilmarktes werden. Doch obwohl Elektrofahrzeuge erhebliche Vorteile bei der Reduzierung des CO2-Ausstoßes und der Fahrzeugkosten haben, stehen sie vor einem Problem: Die Reifen von Elektrofahrzeugen sind nicht nur teurer, sondern auch anfälliger für Verschleiß. Das Thema hat große Aufmerksamkeit erregt, und Experten erklären, warum sich Reifen für Elektrofahrzeuge von herkömmlichen Reifen unterscheiden und höhere Leistungsstandards erfüllen müssen. Da Elektrofahrzeuge schwerer sind, müssen Reifen eine höhere Tragfähigkeit und Strukturfestigkeit aufweisen, was die Konstruktions- und Herstellungskosten erhöht. Darüber hinaus verfügen Elektrofahrzeuge in der Regel über eine stärkere Beschleunigungs- und Bremsleistung, sodass die Reifen einen besseren Grip und eine bessere Hitzebeständigkeit benötigen, was ebenfalls die Herstellungskosten erhöht.

Welche Kosten- und Preisfaktoren gibt es für die Nutzung von Java-Funktionen?

Apr 24, 2024 pm 12:54 PM

Welche Kosten- und Preisfaktoren gibt es für die Nutzung von Java-Funktionen?

Apr 24, 2024 pm 12:54 PM

Kosten- und Preisfaktoren: Instanzpreise: Abrechnung nach Nutzungsdauer und Funktionskonfiguration. Speicher- und CPU-Auslastung: Je höher die Auslastung, desto höher die Kosten. Netzwerkverkehr: Für die Kommunikation mit anderen Diensten fallen Gebühren an. Speicher: Persistenter Speicher wird separat abgerechnet. Praktischer Fall: Eine Funktion, die 10.000 Mal aufgerufen wird und 100 Millisekunden dauert, kostet etwa 0,000067 US-Dollar (der Instanzpreis beträgt 0,000055 US-Dollar und der Netzwerkverkehr 0,000012 US-Dollar).

Es hat sich herausgestellt, dass Meta die Entwicklung eines konkurrierenden Apple Vision Pro-Produkts aufgegeben hat, vor allem weil die Kosten zu hoch sind

Aug 27, 2024 pm 03:33 PM

Es hat sich herausgestellt, dass Meta die Entwicklung eines konkurrierenden Apple Vision Pro-Produkts aufgegeben hat, vor allem weil die Kosten zu hoch sind

Aug 27, 2024 pm 03:33 PM

Laut ausländischen Medienberichten hat Metas Chief Technology Officer nahezu bestätigt, dass das Unternehmen die Entwicklung eines mit Apples Vision Pro vergleichbaren Geräts aufgegeben hat. MetaLaJolla Vor der Veröffentlichung von VisionPro gab Meta seinen vierjährigen Entwicklungsplan für Virtual-Reality- und Mixed-Reality-Headsets bekannt. Ein wichtiger Teil davon war die Entwicklung eines Produkts mit dem internen Codenamen LaJolla, das zum Hauptkonkurrenten von VisionPro hätte werden können. Es wird davon ausgegangen, dass Meta im November 2023 mit der Entwicklung von LaJolla begonnen hat, das Projekt jedoch etwa Mitte August 2024 eingestellt hat, möglicherweise aus Kostengründen. Diese Entscheidung soll von Meta-CEO Zuckerberg und CTO Andrew Bosworth getroffen worden sein.