Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Die Gewinnquote gegen Menschen liegt bei 84 %. DeepMind AI erreicht erstmals das Niveau menschlicher Experten im westlichen Schach

Die Gewinnquote gegen Menschen liegt bei 84 %. DeepMind AI erreicht erstmals das Niveau menschlicher Experten im westlichen Schach

Die Gewinnquote gegen Menschen liegt bei 84 %. DeepMind AI erreicht erstmals das Niveau menschlicher Experten im westlichen Schach

DeepMind hat neue Erfolge im Bereich der Spiel-KI erzielt, dieses Mal im westlichen Schach.

Im Bereich der KI-Spiele wird der Fortschritt der künstlichen Intelligenz häufig anhand von Brettspielen demonstriert. Brettspiele können messen und bewerten, wie Menschen und Maschinen in kontrollierten Umgebungen Strategien entwickeln und ausführen. Seit Jahrzehnten ist die Fähigkeit zur Vorausplanung der Schlüssel zum Erfolg der KI bei Spielen mit perfekten Informationen wie Schach, Dame, Shogi und Go sowie bei Spielen mit unvollständigen Informationen wie Poker und Scotland Yard.

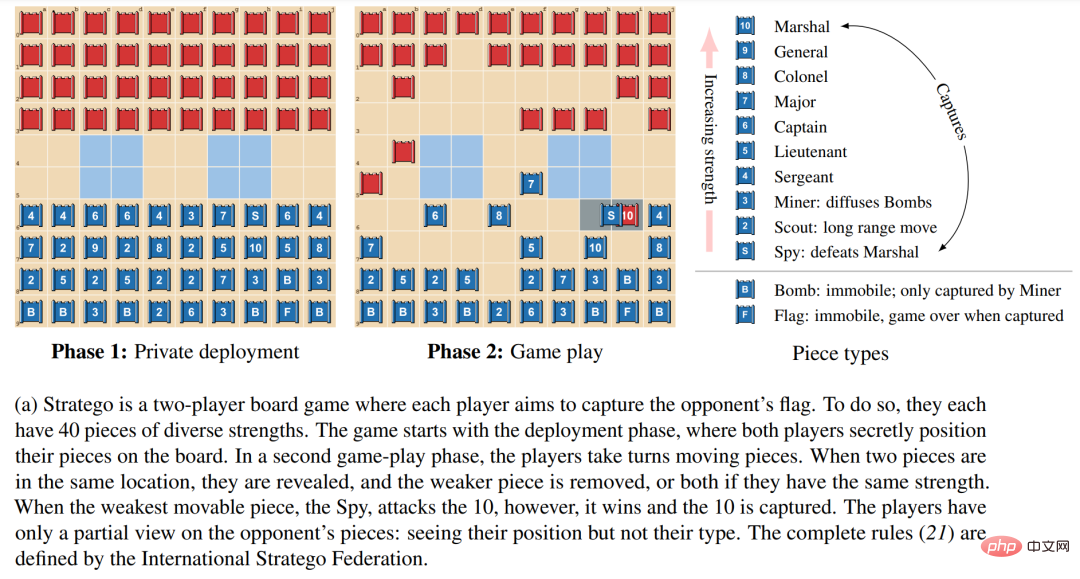

Stratego ist zu einer der nächsten Grenzen der KI-Forschung geworden. Eine Visualisierung der Phasen und Mechanismen des Spiels ist unten in 1a dargestellt. Das Spiel steht vor zwei Herausforderungen.

Erstens hat der Spielbaum von Stratego 10.535 mögliche Zustände, was mehr ist als die gut untersuchten unvollständigen Informationsspiele Unrestricted Texas Hold’em (10.164 mögliche Zustände) und Go (10.360 mögliche Zustände).

Zweitens erfordert das Agieren in einer bestimmten Umgebung in Stratego, dass zu Beginn des Spiels 1066 mögliche Einsatzmöglichkeiten für jeden Spieler berücksichtigt werden müssen, während es beim Poker nur 103 mögliche Handpaare gibt. Perfekte Informationsspiele wie Go und Schach haben keine private Bereitstellungsphase, wodurch die Komplexität dieser Herausforderung in Stratego umgangen wird.

Derzeit ist es weder möglich, modellbasierte SOTA-Techniken zur perfekten Informationsplanung zu verwenden, noch unvollständige Informationssuchtechniken zu verwenden, die das Spiel in unabhängige Situationen zerlegen.

Aus diesen Gründen bietet Stratego einen herausfordernden Maßstab für die Untersuchung groß angelegter politischer Wechselwirkungen. Wie die meisten Brettspiele testet Stratego unsere Fähigkeit, relativ langsame, durchdachte und logische Entscheidungen nacheinander zu treffen. Und weil die Struktur des Spiels sehr komplex ist, hat die KI-Forschungsgemeinschaft kaum Fortschritte gemacht und die künstliche Intelligenz kann nur das Niveau menschlicher Amateurspieler erreichen. Daher bleibt die Entwicklung eines Agenten zum Erlernen von End-to-End-Strategien, um optimale Entscheidungen auf der Grundlage der unvollständigen Informationen von Stratego zu treffen, von Grund auf und ohne menschliche Demonstrationsdaten, eine der größten Herausforderungen in der KI-Forschung.

Aus diesen Gründen bietet Stratego einen herausfordernden Maßstab für die Untersuchung groß angelegter politischer Wechselwirkungen. Wie die meisten Brettspiele testet Stratego unsere Fähigkeit, relativ langsame, durchdachte und logische Entscheidungen nacheinander zu treffen. Und weil die Struktur des Spiels sehr komplex ist, hat die KI-Forschungsgemeinschaft kaum Fortschritte gemacht und die künstliche Intelligenz kann nur das Niveau menschlicher Amateurspieler erreichen. Daher bleibt die Entwicklung eines Agenten zum Erlernen von End-to-End-Strategien, um optimale Entscheidungen auf der Grundlage der unvollständigen Informationen von Stratego zu treffen, von Grund auf und ohne menschliche Demonstrationsdaten, eine der größten Herausforderungen in der KI-Forschung.

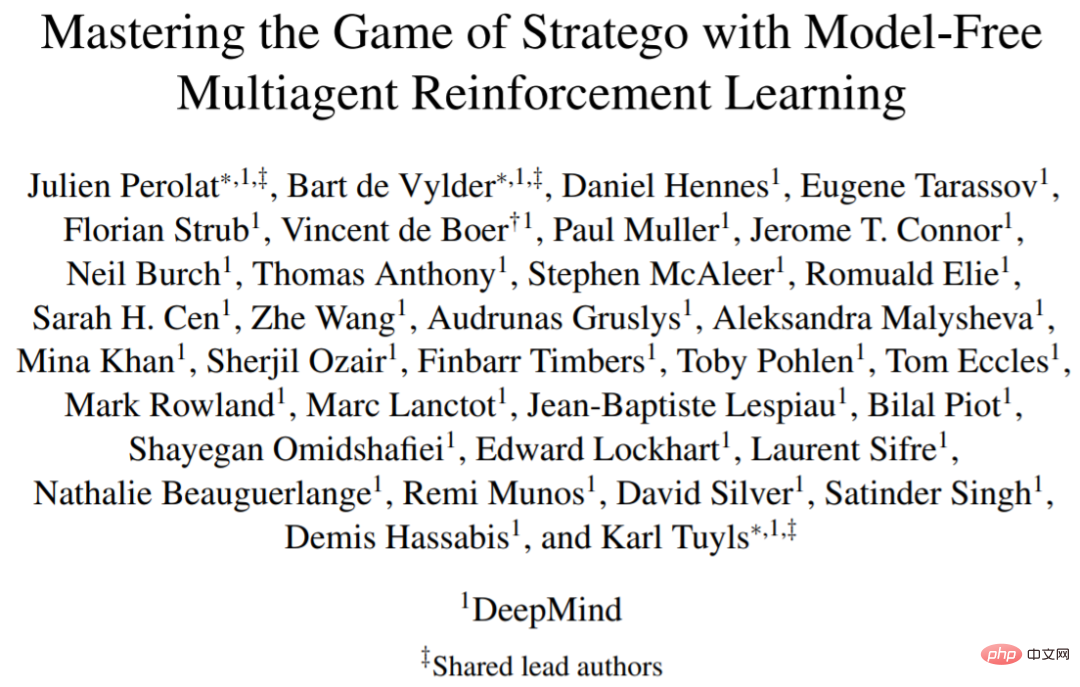

Kürzlich haben Forscher in einem aktuellen Artikel von DeepMind DeepNash vorgeschlagen, einen Agenten, der das Stratego-Selbstspiel modellfrei und ohne menschliche Demonstration lernt. DeepNask besiegte frühere SOTA-KI-Agenten und erreichte in der komplexesten Variante des Spiels, Stratego Classic, das Niveau eines erfahrenen menschlichen Spielers.

Papieradresse: https://arxiv.org/pdf/2206.15378.pdf.

Papieradresse: https://arxiv.org/pdf/2206.15378.pdf.

Der Kern von DeepNash ist ein strukturierter, modellfreier Reinforcement-Learning-Algorithmus, den Forscher Regularized Nash Dynamics (R-NaD) nennen. DeepNash kombiniert R-NaD mit einer tiefen neuronalen Netzwerkarchitektur und konvergiert zu einem Nash-Gleichgewicht, was bedeutet, dass es lernt, im Anreizwettbewerb zu spielen und robust gegenüber Konkurrenten ist, die versuchen, es auszunutzen.

Abbildung 1 b unten ist eine allgemeine Übersicht über die DeepNash-Methode. Die Forscher verglichen seine Leistung systematisch mit verschiedenen SOTA Stratego-Robotern und menschlichen Spielern auf der Gravon-Gaming-Plattform. Die Ergebnisse zeigen, dass DeepNash alle aktuellen SOTA-Roboter mit einer Gewinnquote von mehr als 97 % besiegte und mit menschlichen Spielern hart konkurrierte. Es rangierte im Jahr 2022 und in jedem Zeitraum mit einer Gewinnquote von 84 % unter den Top 3.

Forscher sagen, dass es das erste Mal ist, dass ein KI-Algorithmus das Niveau menschlicher Experten in einem komplexen Brettspiel erreichen kann, ohne Suchmethoden im Lernalgorithmus einzusetzen erreichte das Niveau menschlicher Experten im Stratego-Spiel.

Methodenübersicht

DeepNash verwendet eine End-to-End-Lernstrategie, um Stratego zu betreiben und die Spielsteine zu Beginn des Spiels strategisch auf dem Spielbrett zu platzieren (siehe Abbildung 1a). Deep RL und Game On-Methode. Ziel des Agenten ist es, durch Selbstspiel ein ungefähres Nash-Gleichgewicht zu erlernen.

Diese Forschung verwendet orthogonale Pfade ohne Suche und schlägt eine neue Methode vor, die modellfreies Verstärkungslernen im Selbstspiel mit der Idee des spieltheoretischen Algorithmus-Regularized Nash Dynamics (RNaD) kombiniert.

Der modellfreie Teil bedeutet, dass die Forschung kein explizites Gegnermodell erstellt, um die möglichen Zustände des Gegners zu verfolgen. Der spieltheoretische Teil basiert auf der Idee, dass sie auf der Grundlage der Reinforcement-Learning-Methode das Lernverhalten des Agenten steuern hin zu einer ausgewogenen Nash-Entwicklung. Der Hauptvorteil dieses kompositorischen Ansatzes besteht darin, dass es nicht notwendig ist, den privaten Staat explizit vom öffentlichen Staat zu verspotten. Eine weitere komplexe Herausforderung besteht darin, diesen modellfreien Reinforcement-Learning-Ansatz mit R-NaD zu kombinieren, um das Selbstspiel im westlichen Schach zu ermöglichen, mit menschlichen Expertenspielern zu konkurrieren, was bisher nicht erreicht wurde. Diese kombinierte DeepNash-Methode ist in Abbildung 1b oben dargestellt.

Regularisierter Nash-Dynamik-Algorithmus

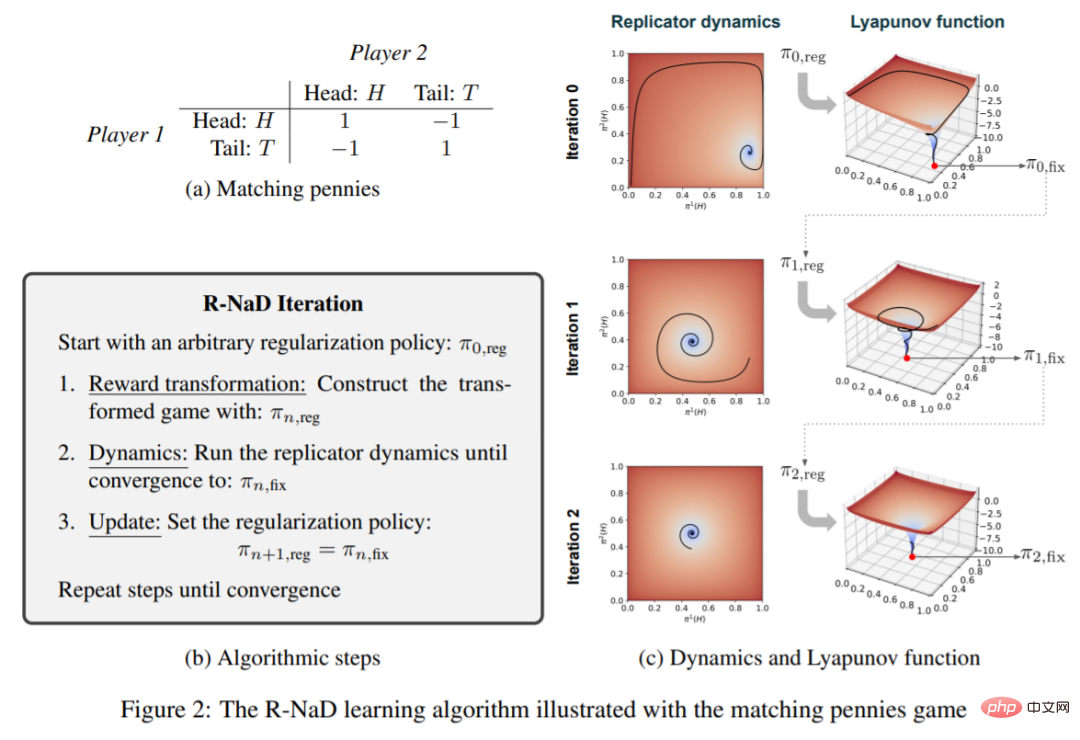

Der in DeepNash verwendete R-NaD-Lernalgorithmus basiert auf der Idee der Regularisierung, um Konvergenz zu erreichen, wie in Abbildung 2b unten dargestellt:

DeepNash besteht aus drei Komponenten: (1) der Kerntrainingskomponente R-NaD; (2) der Feinabstimmung der Lernstrategie, um die Restwahrscheinlichkeit zu verringern, dass das Modell äußerst unwahrscheinliche Maßnahmen ergreift, und (3) Post- Testverarbeitung, um Aktionen mit geringer Wahrscheinlichkeit herauszufiltern und Fehler zu korrigieren.

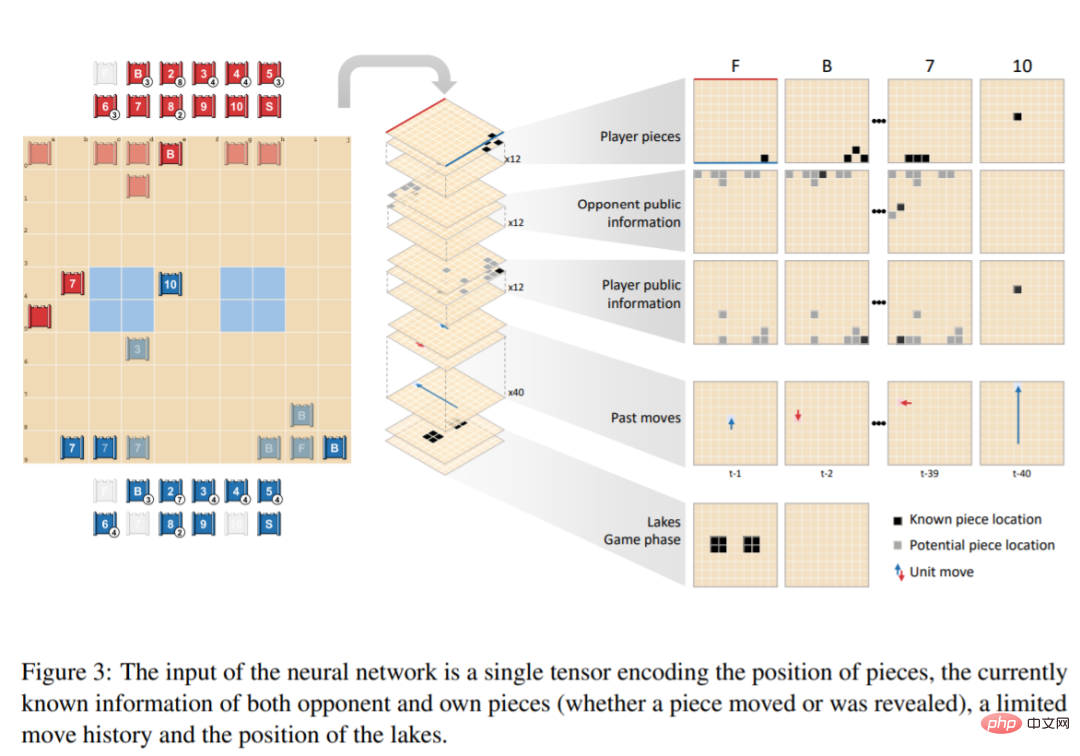

Das Netzwerk von DeepNash besteht aus den folgenden Komponenten: einem U-Net-Backbone mit Restblöcken und Skip-Verbindungen sowie vier Köpfen. Der erste DeepNash-Kopf gibt die Wertfunktion als Skalar aus, während die verbleibenden drei Köpfe die Agentenrichtlinie kodieren, indem sie eine Wahrscheinlichkeitsverteilung seiner Aktionen während der Bereitstellung und des Spiels ausgeben. Die Struktur dieses Beobachtungstensors ist in Abbildung 3 dargestellt:

Experimentelle Ergebnisse

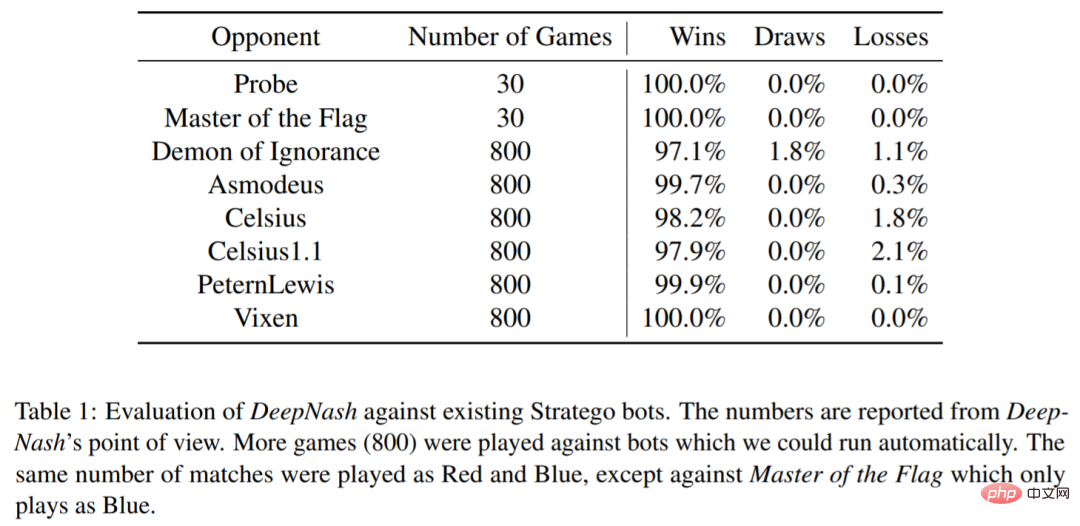

DeepNash wurde auch anhand mehrerer vorhandener Stratego-Computerprogramme bewertet: Probe bei der Computer Stratego-Weltmeisterschaft, drei Jahre davon Gewinner (2007 , 2008, 2010); Master of the Flag gewann die Meisterschaft im Jahr 2009; Demon of Ignorance ist eine Open-Source-Implementierung von Stratego, Celsius, Celsius1.1, PeternLewis und Vixen. Ein Programm wurde 2012 an australischen Universitäten eingereicht Wettbewerb, den Petern Lewis gewann.

Wie in Tabelle 1 gezeigt, gewann DeepNash die überwiegende Mehrheit der Spiele gegen all diese Agenten, obwohl DeepNash nicht dagegen trainiert wurde und nur Selbstspiel nutzte.

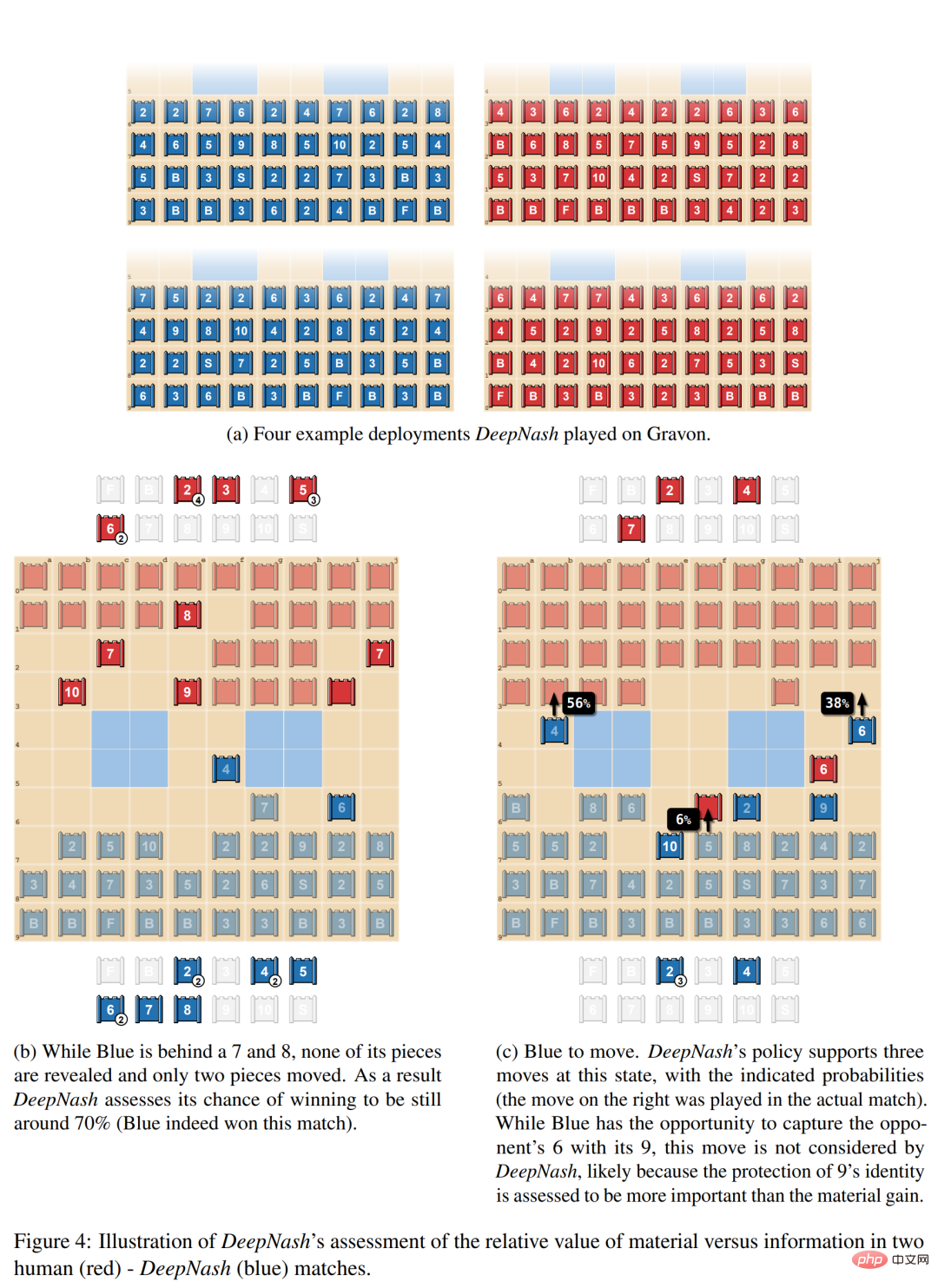

Abbildung 4a unten zeigt einige der oft wiederholten Einsatzmethoden in DeepNash; Abbildung 4b zeigt, wie DeepNash (blaue Seite) in Teilen zurückfällt (7 und 8 verliert), aber in der Informationssituation führt, weil der Gegner weiter ist Die rote Seite hat 10, 9, 8 und zwei 7er. Das zweite Beispiel in Abbildung 4c zeigt, dass DeepNash die Möglichkeit hatte, die 6 des Gegners mit seiner 9 zu erobern, aber dieser Zug wurde nicht in Betracht gezogen, möglicherweise weil DeepNash glaubte, dass der Schutz der Identität der 9 wichtiger war als der materielle Gewinn.

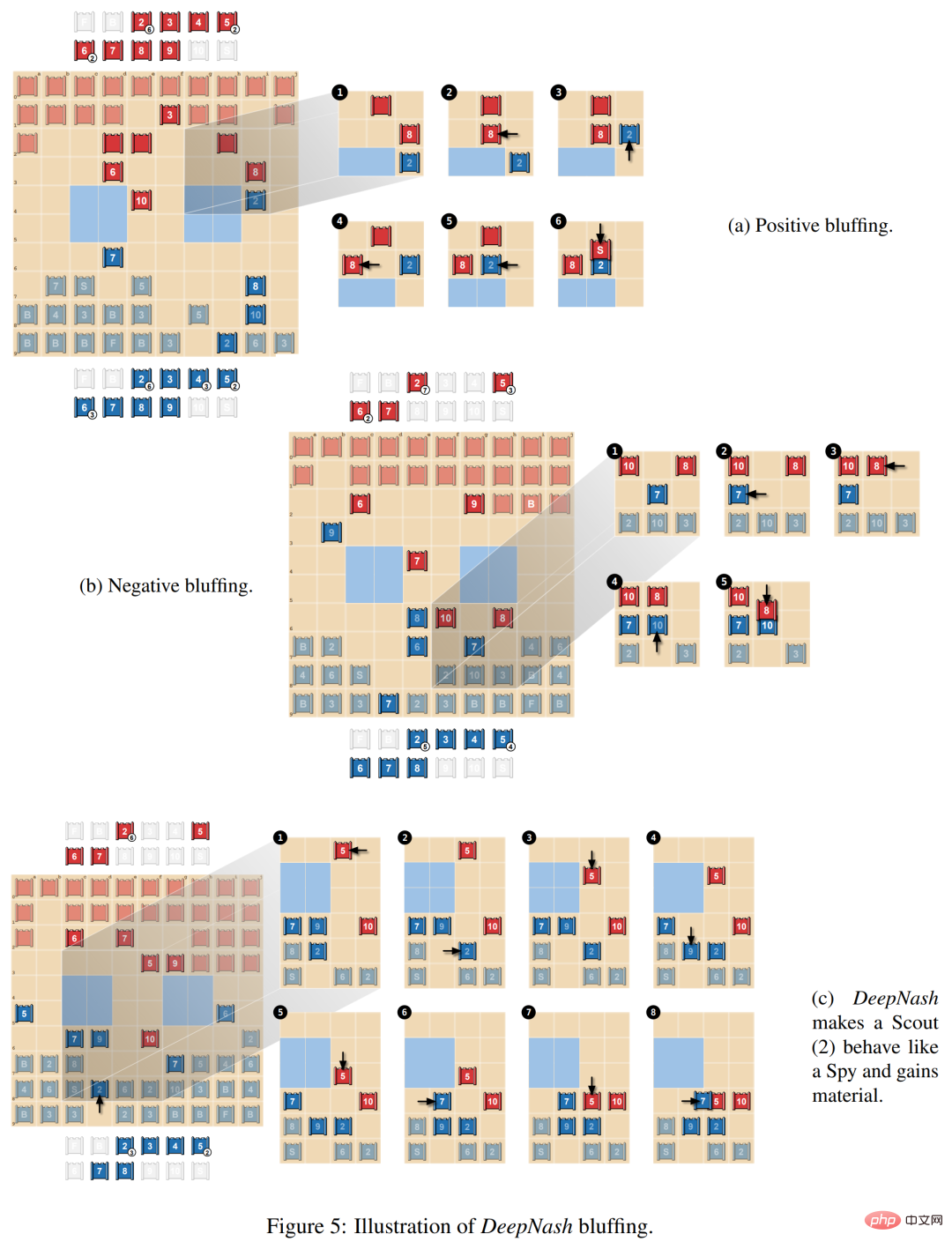

In Abbildung 5a unten demonstrieren die Forscher positives Bluffen, bei dem der Spieler vorgibt, dass der Wert der Figur höher ist als der tatsächliche Wert. DeepNash jagt die 8 des Gegners mit der unbekannten Figur Scout (2) und gibt vor, es sei eine 10. Der Gegner denkt, dass es sich bei der Figur um eine 10 handeln könnte und führt sie neben den Spy (wo die 10 geschlagen werden kann). Um diese Figur zu erobern, verlor der Spion des Gegners jedoch gegen DeepNashs Späher.

Die zweite Art des Bluffens ist das negative Bluffen, wie in Abbildung 5b unten dargestellt. Es ist das Gegenteil des aktiven Bluffens, bei dem der Spieler vorgibt, dass die Figur weniger wert ist, als sie tatsächlich ist.

Abbildung 5c unten zeigt einen komplexeren Bluff, bei dem DeepNash seinen unbekannten Scout (2) nahe an der 10 des Gegners platziert, was als Spy interpretiert werden könnte. Diese Strategie ermöglicht es Blau tatsächlich, die 5 von Rot ein paar Züge später mit 7 zu erobern, wodurch Material gewonnen wird, 5 daran gehindert wird, Scout (2) zu erobern, und enthüllt, dass es sich eigentlich nicht um einen Spion handelt.

Das obige ist der detaillierte Inhalt vonDie Gewinnquote gegen Menschen liegt bei 84 %. DeepMind AI erreicht erstmals das Niveau menschlicher Experten im westlichen Schach. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1376

1376

52

52

Bytedance Cutting führt SVIP-Supermitgliedschaft ein: 499 Yuan für ein fortlaufendes Jahresabonnement, das eine Vielzahl von KI-Funktionen bietet

Jun 28, 2024 am 03:51 AM

Bytedance Cutting führt SVIP-Supermitgliedschaft ein: 499 Yuan für ein fortlaufendes Jahresabonnement, das eine Vielzahl von KI-Funktionen bietet

Jun 28, 2024 am 03:51 AM

Diese Seite berichtete am 27. Juni, dass Jianying eine von FaceMeng Technology, einer Tochtergesellschaft von ByteDance, entwickelte Videobearbeitungssoftware ist, die auf der Douyin-Plattform basiert und grundsätzlich kurze Videoinhalte für Benutzer der Plattform produziert Windows, MacOS und andere Betriebssysteme. Jianying kündigte offiziell die Aktualisierung seines Mitgliedschaftssystems an und führte ein neues SVIP ein, das eine Vielzahl von KI-Schwarztechnologien umfasst, wie z. B. intelligente Übersetzung, intelligente Hervorhebung, intelligente Verpackung, digitale menschliche Synthese usw. Preislich beträgt die monatliche Gebühr für das Clipping von SVIP 79 Yuan, die Jahresgebühr 599 Yuan (Hinweis auf dieser Website: entspricht 49,9 Yuan pro Monat), das fortlaufende Monatsabonnement beträgt 59 Yuan pro Monat und das fortlaufende Jahresabonnement beträgt 499 Yuan pro Jahr (entspricht 41,6 Yuan pro Monat). Darüber hinaus erklärte der Cut-Beamte auch, dass diejenigen, die den ursprünglichen VIP abonniert haben, das Benutzererlebnis verbessern sollen

Kontexterweiterter KI-Codierungsassistent mit Rag und Sem-Rag

Jun 10, 2024 am 11:08 AM

Kontexterweiterter KI-Codierungsassistent mit Rag und Sem-Rag

Jun 10, 2024 am 11:08 AM

Verbessern Sie die Produktivität, Effizienz und Genauigkeit der Entwickler, indem Sie eine abrufgestützte Generierung und ein semantisches Gedächtnis in KI-Codierungsassistenten integrieren. Übersetzt aus EnhancingAICodingAssistantswithContextUsingRAGandSEM-RAG, Autor JanakiramMSV. Obwohl grundlegende KI-Programmierassistenten natürlich hilfreich sind, können sie oft nicht die relevantesten und korrektesten Codevorschläge liefern, da sie auf einem allgemeinen Verständnis der Softwaresprache und den gängigsten Mustern beim Schreiben von Software basieren. Der von diesen Coding-Assistenten generierte Code eignet sich zur Lösung der von ihnen zu lösenden Probleme, entspricht jedoch häufig nicht den Coding-Standards, -Konventionen und -Stilen der einzelnen Teams. Dabei entstehen häufig Vorschläge, die geändert oder verfeinert werden müssen, damit der Code in die Anwendung übernommen wird

Sieben coole technische Interviewfragen für GenAI und LLM

Jun 07, 2024 am 10:06 AM

Sieben coole technische Interviewfragen für GenAI und LLM

Jun 07, 2024 am 10:06 AM

Um mehr über AIGC zu erfahren, besuchen Sie bitte: 51CTOAI.x Community https://www.51cto.com/aigc/Translator|Jingyan Reviewer|Chonglou unterscheidet sich von der traditionellen Fragendatenbank, die überall im Internet zu sehen ist erfordert einen Blick über den Tellerrand hinaus. Large Language Models (LLMs) gewinnen in den Bereichen Datenwissenschaft, generative künstliche Intelligenz (GenAI) und künstliche Intelligenz zunehmend an Bedeutung. Diese komplexen Algorithmen verbessern die menschlichen Fähigkeiten, treiben Effizienz und Innovation in vielen Branchen voran und werden zum Schlüssel für Unternehmen, um wettbewerbsfähig zu bleiben. LLM hat ein breites Anwendungsspektrum und kann in Bereichen wie der Verarbeitung natürlicher Sprache, der Textgenerierung, der Spracherkennung und Empfehlungssystemen eingesetzt werden. Durch das Lernen aus großen Datenmengen ist LLM in der Lage, Text zu generieren

Kann LLM durch Feinabstimmung wirklich neue Dinge lernen: Die Einführung neuen Wissens kann dazu führen, dass das Modell mehr Halluzinationen hervorruft

Jun 11, 2024 pm 03:57 PM

Kann LLM durch Feinabstimmung wirklich neue Dinge lernen: Die Einführung neuen Wissens kann dazu führen, dass das Modell mehr Halluzinationen hervorruft

Jun 11, 2024 pm 03:57 PM

Large Language Models (LLMs) werden auf riesigen Textdatenbanken trainiert und erwerben dort große Mengen an realem Wissen. Dieses Wissen wird in ihre Parameter eingebettet und kann dann bei Bedarf genutzt werden. Das Wissen über diese Modelle wird am Ende der Ausbildung „verdinglicht“. Am Ende des Vortrainings hört das Modell tatsächlich auf zu lernen. Richten Sie das Modell aus oder verfeinern Sie es, um zu erfahren, wie Sie dieses Wissen nutzen und natürlicher auf Benutzerfragen reagieren können. Aber manchmal reicht Modellwissen nicht aus, und obwohl das Modell über RAG auf externe Inhalte zugreifen kann, wird es als vorteilhaft angesehen, das Modell durch Feinabstimmung an neue Domänen anzupassen. Diese Feinabstimmung erfolgt mithilfe von Eingaben menschlicher Annotatoren oder anderer LLM-Kreationen, wobei das Modell auf zusätzliches Wissen aus der realen Welt trifft und dieses integriert

Um ein neues wissenschaftliches und komplexes Frage-Antwort-Benchmark- und Bewertungssystem für große Modelle bereitzustellen, haben UNSW, Argonne, die University of Chicago und andere Institutionen gemeinsam das SciQAG-Framework eingeführt

Jul 25, 2024 am 06:42 AM

Um ein neues wissenschaftliches und komplexes Frage-Antwort-Benchmark- und Bewertungssystem für große Modelle bereitzustellen, haben UNSW, Argonne, die University of Chicago und andere Institutionen gemeinsam das SciQAG-Framework eingeführt

Jul 25, 2024 am 06:42 AM

Herausgeber | Der Frage-Antwort-Datensatz (QA) von ScienceAI spielt eine entscheidende Rolle bei der Förderung der Forschung zur Verarbeitung natürlicher Sprache (NLP). Hochwertige QS-Datensätze können nicht nur zur Feinabstimmung von Modellen verwendet werden, sondern auch effektiv die Fähigkeiten großer Sprachmodelle (LLMs) bewerten, insbesondere die Fähigkeit, wissenschaftliche Erkenntnisse zu verstehen und zu begründen. Obwohl es derzeit viele wissenschaftliche QS-Datensätze aus den Bereichen Medizin, Chemie, Biologie und anderen Bereichen gibt, weisen diese Datensätze immer noch einige Mängel auf. Erstens ist das Datenformular relativ einfach, die meisten davon sind Multiple-Choice-Fragen. Sie sind leicht auszuwerten, schränken jedoch den Antwortauswahlbereich des Modells ein und können die Fähigkeit des Modells zur Beantwortung wissenschaftlicher Fragen nicht vollständig testen. Im Gegensatz dazu offene Fragen und Antworten

Fünf Schulen des maschinellen Lernens, die Sie nicht kennen

Jun 05, 2024 pm 08:51 PM

Fünf Schulen des maschinellen Lernens, die Sie nicht kennen

Jun 05, 2024 pm 08:51 PM

Maschinelles Lernen ist ein wichtiger Zweig der künstlichen Intelligenz, der Computern die Möglichkeit gibt, aus Daten zu lernen und ihre Fähigkeiten zu verbessern, ohne explizit programmiert zu werden. Maschinelles Lernen hat ein breites Anwendungsspektrum in verschiedenen Bereichen, von der Bilderkennung und der Verarbeitung natürlicher Sprache bis hin zu Empfehlungssystemen und Betrugserkennung, und es verändert unsere Lebensweise. Im Bereich des maschinellen Lernens gibt es viele verschiedene Methoden und Theorien, von denen die fünf einflussreichsten Methoden als „Fünf Schulen des maschinellen Lernens“ bezeichnet werden. Die fünf Hauptschulen sind die symbolische Schule, die konnektionistische Schule, die evolutionäre Schule, die Bayes'sche Schule und die Analogieschule. 1. Der Symbolismus, auch Symbolismus genannt, betont die Verwendung von Symbolen zum logischen Denken und zum Ausdruck von Wissen. Diese Denkrichtung glaubt, dass Lernen ein Prozess der umgekehrten Schlussfolgerung durch das Vorhandene ist

SOTA Performance, eine multimodale KI-Methode zur Vorhersage der Protein-Ligand-Affinität in Xiamen, kombiniert erstmals molekulare Oberflächeninformationen

Jul 17, 2024 pm 06:37 PM

SOTA Performance, eine multimodale KI-Methode zur Vorhersage der Protein-Ligand-Affinität in Xiamen, kombiniert erstmals molekulare Oberflächeninformationen

Jul 17, 2024 pm 06:37 PM

Herausgeber |. KX Im Bereich der Arzneimittelforschung und -entwicklung ist die genaue und effektive Vorhersage der Bindungsaffinität von Proteinen und Liganden für das Arzneimittelscreening und die Arzneimitteloptimierung von entscheidender Bedeutung. Aktuelle Studien berücksichtigen jedoch nicht die wichtige Rolle molekularer Oberflächeninformationen bei Protein-Ligand-Wechselwirkungen. Auf dieser Grundlage schlugen Forscher der Universität Xiamen ein neuartiges Framework zur multimodalen Merkmalsextraktion (MFE) vor, das erstmals Informationen über Proteinoberfläche, 3D-Struktur und -Sequenz kombiniert und einen Kreuzaufmerksamkeitsmechanismus verwendet, um verschiedene Modalitäten zu vergleichen Ausrichtung. Experimentelle Ergebnisse zeigen, dass diese Methode bei der Vorhersage von Protein-Ligand-Bindungsaffinitäten Spitzenleistungen erbringt. Darüber hinaus belegen Ablationsstudien die Wirksamkeit und Notwendigkeit der Proteinoberflächeninformation und der multimodalen Merkmalsausrichtung innerhalb dieses Rahmens. Verwandte Forschungen beginnen mit „S

GlobalFoundries erschließt Märkte wie KI und erwirbt die Galliumnitrid-Technologie von Tagore Technology und zugehörige Teams

Jul 15, 2024 pm 12:21 PM

GlobalFoundries erschließt Märkte wie KI und erwirbt die Galliumnitrid-Technologie von Tagore Technology und zugehörige Teams

Jul 15, 2024 pm 12:21 PM

Laut Nachrichten dieser Website vom 5. Juli veröffentlichte GlobalFoundries am 1. Juli dieses Jahres eine Pressemitteilung, in der die Übernahme der Power-Galliumnitrid (GaN)-Technologie und des Portfolios an geistigem Eigentum von Tagore Technology angekündigt wurde, in der Hoffnung, seinen Marktanteil in den Bereichen Automobile und Internet auszubauen Anwendungsbereiche für Rechenzentren mit künstlicher Intelligenz, um höhere Effizienz und bessere Leistung zu erforschen. Da sich Technologien wie generative künstliche Intelligenz (GenerativeAI) in der digitalen Welt weiterentwickeln, ist Galliumnitrid (GaN) zu einer Schlüssellösung für nachhaltiges und effizientes Energiemanagement, insbesondere in Rechenzentren, geworden. Auf dieser Website wurde die offizielle Ankündigung zitiert, dass sich das Ingenieurteam von Tagore Technology im Rahmen dieser Übernahme mit GF zusammenschließen wird, um die Galliumnitrid-Technologie weiterzuentwickeln. G