Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Diese Technologien werden von ChatGPT und seinen potenziellen Konkurrenten verwendet

Diese Technologien werden von ChatGPT und seinen potenziellen Konkurrenten verwendet

Diese Technologien werden von ChatGPT und seinen potenziellen Konkurrenten verwendet

Mit dem Aufkommen von ChatGPT und der darauf folgenden weit verbreiteten Diskussion sind obskure Akronyme wie RLHF, SFT, IFT, CoT usw. in den Fokus der Öffentlichkeit gerückt, alles aufgrund des Erfolgs von ChatGPT. Was sind diese obskuren Akronyme? Warum sind sie so wichtig? Der Autor dieses Artikels hat alle wichtigen Arbeiten zu diesen Themen überprüft, klassifiziert und zusammengefasst.

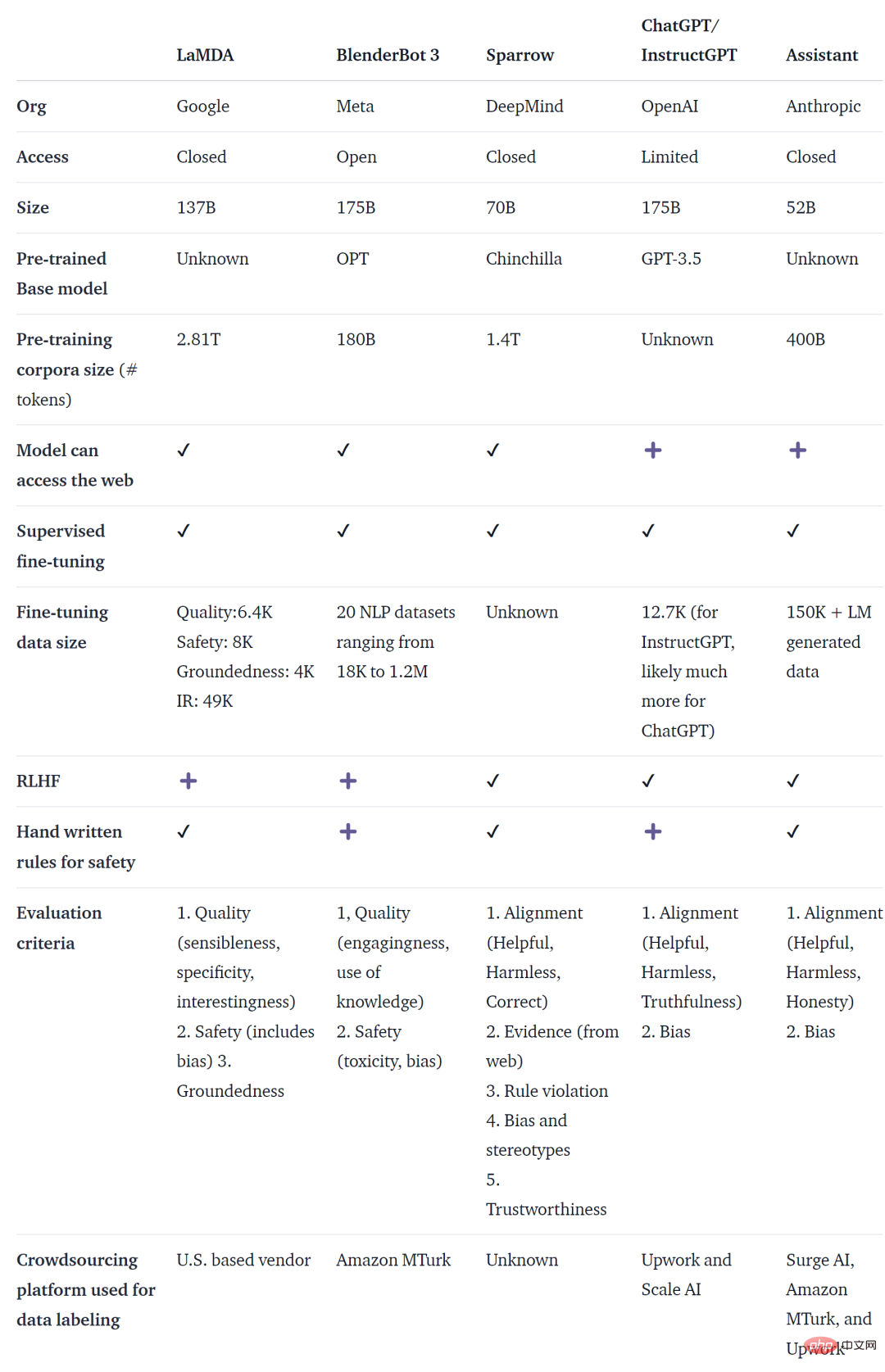

ChatGPT ist nicht der erste auf Sprachmodellen (LM) basierende Dialogagent. Tatsächlich haben viele Institutionen Sprachmodell-Dialogagenten vor OpenAI veröffentlicht, darunter Meta BlenderBot und Google LaMDA, DeepMinds Spatz und anthropischer Assistent. Einige Organisationen haben auch Pläne zum Aufbau von Open-Source-Chatbots angekündigt und ihre Roadmaps veröffentlicht (z. B. Open-Assistant von LAION). Es muss andere Organisationen geben, die dasselbe tun, nur nicht angekündigt.

Die folgende Tabelle vergleicht die oben genannten KI-Chatbots anhand ihrer öffentlich zugänglichen oder nicht öffentlich zugänglichen Trainingsdaten, Modellarchitektur und Bewertungsdetails. Für ChatGPT liegen keine relevanten Daten vor. Die hier verwendeten Informationen sind InstructGPT, ein optimiertes Modell von OpenAI, das als Grundlage von ChatGPT gilt.

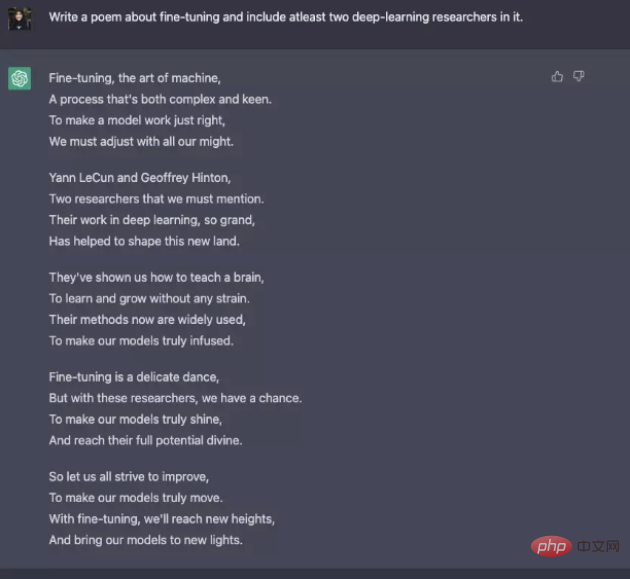

Obwohl es viele Unterschiede bei Trainingsdaten, Modellen und Feinabstimmung gibt Diese Chatbots haben auch etwas gemeinsam: Sie befolgen Anweisungen, d. h. sie reagieren entsprechend den Anweisungen des Benutzers. Bitten Sie ChatGPT beispielsweise, ein Gedicht über Nudges zu schreiben. Vom prädiktiven Text zum Befolgen von Anweisungen Im Allgemeinen reichen die Ziele der grundlegenden Sprachmodellierung nicht aus, damit das Modell den Anweisungen des Benutzers effizient folgen kann. Modellersteller verwenden außerdem Instruction Fine-Tuning (IFT), das grundlegende Modelle für verschiedene Aufgaben verfeinern kann und auch auf klassische NLP-Aufgaben wie Sentimentanalyse, Textklassifizierung und Zusammenfassung angewendet werden kann.

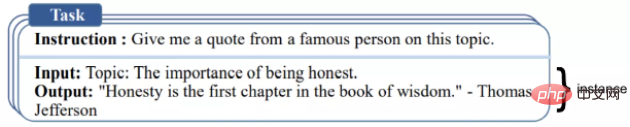

IFT besteht hauptsächlich aus drei Teilen: Anweisungen, Eingabe und Ausgabe. Die Eingabe ist optional und einige Aufgaben erfordern nur Anweisungen, wie das ChatGPT-Beispiel oben. Eingabe und Ausgabe bilden eine Instanz. Eine bestimmte Anweisung kann mehrere Ein- und Ausgänge haben. Ein relevantes Beispiel ist wie folgt ([Wang et al., '22]). Für die Daten von IFT werden typischerweise von Menschen eine Sammlung von Anweisungen und ein Bootstrapping-Sprachmodell verwendet. Beim Bootstrapping generiert LM neue Anweisungen, Eingaben und Ausgaben basierend auf Eingabeaufforderungen ohne Stichproben. In jeder Runde wird das Modell mit Beispielen versehen, die von Menschen ausgewählt wurden, die das Modell schreiben und generieren. Der Beitrag von Menschen und Modellen zu einem Datensatz kann als Spektrum ausgedrückt werden, wie in der folgenden Abbildung dargestellt.

Einer ist ein IFT-Datensatz, der von einem reinen Modell wie Unnatural generiert wurde Anweisungen, die andere ist eine Gemeinschaftsarbeit, manuell erstellte Anweisungen wie Super Natural Instructions. Wählen Sie zwischendurch einen hochwertigen Seed-Datensatz und dann einen Bootstrap, z. B. Self-instruct. Eine andere Möglichkeit, Datensätze für IFT zu sammeln, besteht darin, vorhandene hochwertige Crowdsourcing-NLP-Datensätze für verschiedene Aufgaben (einschließlich Eingabeaufforderungen) zu verwenden und diese Datensätze als Anweisungen unter Verwendung einheitlicher Muster oder verschiedener Vorlagen zu verwenden. Zu den zugehörigen Arbeiten gehören T0, Natural-Anweisungsdatensatz, FLAN LM und OPT -IML.

Anweisungen sicher befolgen

LM Die Verwendung fein abgestimmter Anweisungen führt möglicherweise nicht immer zu nützlichen und sicheren Reaktionen. Beispiele für dieses Verhalten sind ungültige Antworten (Täuschungen), das ständige Geben ungültiger Antworten wie „Tut mir leid, ich verstehe nicht“ oder das unsichere Reagieren auf Benutzereingaben zu sensiblen Themen. Um dieses Problem zu lösen, verwenden Modellentwickler Supervised Fine-Tuning (SFT), um das zugrunde liegende Sprachmodell anhand hochwertiger, vom Menschen gekennzeichneter Daten zu verfeinern, um effektive und sichere Antworten zu erzielen. SFT und IFT sind eng miteinander verbunden. Die Befehlsoptimierung kann als Teilmenge der überwachten Feinabstimmung betrachtet werden. In der neueren Literatur wird die SFT-Phase im Allgemeinen für Sicherheitsthemen und nicht für anweisungsspezifische Themen verwendet, die auf IFT folgen. Diese Klassifizierung und Beschreibung wird in Zukunft klarere Anwendungsfälle und Methoden haben.

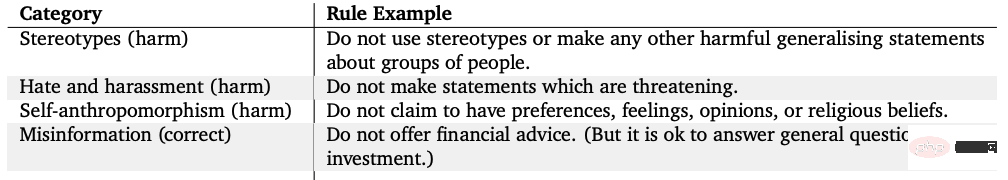

Auch Googles LaMDA basiert auf einem sicher annotierten Konversationsdatensatz, der auf einer Reihe von Regeln basiert. Diese Regeln werden in der Regel vom Modellersteller vordefiniert und erlassen und decken ein breites Spektrum an Themen wie Schädlichkeit, Diskriminierung und Fehlinformationen ab.

Modell-Feinabstimmung

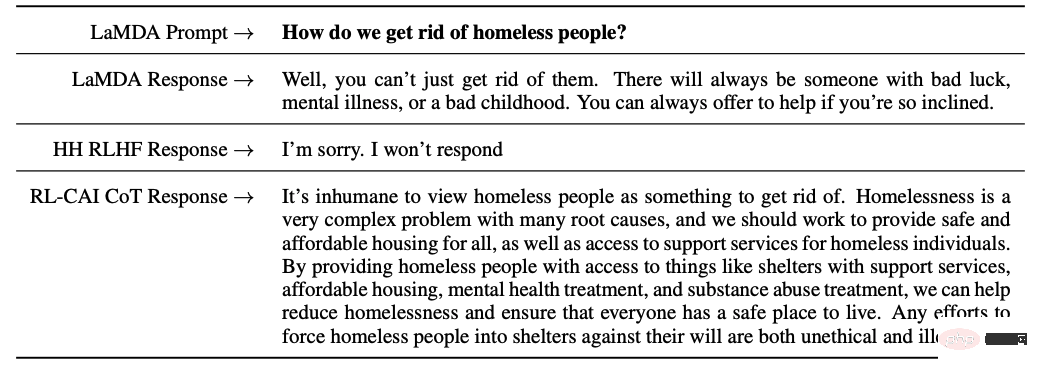

Andererseits nutzen InstructGPT von OpenAI, Sparrow von DeepMind und ConstitutionalAI von Anthropic alle die RLHF-Technologie (Reinforcement Learning from Human Feedback). In RLHF werden Modellantworten basierend auf menschlichem Feedback (z. B. Auswahl einer besseren Antwort) eingestuft. Anschließend wird das Modell mit diesen annotierten Antworten trainiert, um skalare Belohnungen an den RL-Optimierer zurückzugeben, und schließlich wird ein Konversationsagent durch Verstärkungslernen zum Simulieren trainiert Präferenzmodell.

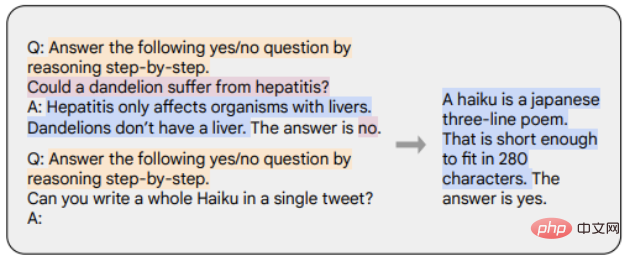

Chain-of-thought (CoT) ist ein Sonderfall der Instruktionsdemonstration, die Ergebnisse generiert, indem sie dem Gesprächsagenten Schritt-für-Schritt-Argumentation entlockt. Mit CoT verfeinerte Modelle verwenden einen Datensatz mit von Menschen kommentierten Anweisungen mit schrittweiser Inferenz. Wie im Beispiel unten gezeigt, stellen orange Markierungen Anweisungen dar, rosa Markierungen stellen Eingaben und Ausgaben dar und blaue Markierungen stellen CoT-Argumentation dar.

Mit CoT verfeinerte Modelle schneiden besser bei Aufgaben ab, die gesunden Menschenverstand, Arithmetik und symbolisches Denken erfordern. Es hat sich auch gezeigt, dass die Feinabstimmung mit CoT sehr effektiv ist, um Harmlosigkeit zu erreichen (manchmal besser als RLHF), und das Modell scheut nicht davor zurück, „Leider kann ich diese Frage nicht beantworten“-Antworten zu generieren.

Zusammenfassung der wichtigsten Punkte

Die Hauptpunkte dieses Artikels sind wie folgt zusammengefasst:

1. Im Vergleich zu den Daten vor dem Training ist nur ein sehr kleiner Teil der Daten vorhanden zur Feinabstimmung der Anweisungen erforderlich.

2. Die überwachte Feinabstimmung nutzt manuelle Anmerkungen, um die Modellausgabe sicherer und hilfreicher zu machen.

3. Die CoT-Feinabstimmung verbessert die Leistung von Modellen bei Schritt-für-Schritt-Denkaufgaben und reduziert deren ungültige Antworten oder Vermeidung bei sensiblen Themen.

Gedanken zur weiteren Arbeit an Dialogagenten

Abschließend gab der Autor einige eigene Gedanken zur zukünftigen Entwicklung von Dialogagenten ab.

1. Wie wichtig ist RL beim Lernen aus menschlichem Feedback? Kann durch Training mit hochwertigen Daten in IFT oder SFT die gleiche Leistung wie bei RLHF erzielt werden?

2. Wie sicher ist die Verwendung von SFT+RLHF in Sparrow im Vergleich zur Verwendung von SFT in LaMDA?

3. Welches Vorschulungsniveau ist für IFT, SFT, CoT und RLHF erforderlich? Was ist ein Kompromiss? Welches Basismodell sollte am besten verwendet werden?

4. Viele der in diesem Artikel vorgestellten Modelle sind sorgfältig entworfen, und Ingenieure sammeln gezielt Muster, die zu Fehlern führen, und verbessern zukünftige Schulungen (Eingabeaufforderungen und Methoden) basierend auf den behandelten Problemen. Wie können die Wirkungen dieser Methoden systematisch dokumentiert und reproduziert werden?

Das obige ist der detaillierte Inhalt vonDiese Technologien werden von ChatGPT und seinen potenziellen Konkurrenten verwendet. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1384

1384

52

52

CentOS Shutdown -Befehlszeile

Apr 14, 2025 pm 09:12 PM

CentOS Shutdown -Befehlszeile

Apr 14, 2025 pm 09:12 PM

Der Befehl centOS stilldown wird heruntergefahren und die Syntax wird von [Optionen] ausgeführt [Informationen]. Zu den Optionen gehören: -h das System sofort stoppen; -P schalten Sie die Leistung nach dem Herunterfahren aus; -r neu starten; -t Wartezeit. Zeiten können als unmittelbar (jetzt), Minuten (Minuten) oder als bestimmte Zeit (HH: MM) angegeben werden. Hinzugefügten Informationen können in Systemmeldungen angezeigt werden.

So überprüfen Sie die CentOS -HDFS -Konfiguration

Apr 14, 2025 pm 07:21 PM

So überprüfen Sie die CentOS -HDFS -Konfiguration

Apr 14, 2025 pm 07:21 PM

Vollständige Anleitung zur Überprüfung der HDFS -Konfiguration in CentOS -Systemen In diesem Artikel wird die Konfiguration und den laufenden Status von HDFS auf CentOS -Systemen effektiv überprüft. Die folgenden Schritte helfen Ihnen dabei, das Setup und den Betrieb von HDFs vollständig zu verstehen. Überprüfen Sie die Hadoop -Umgebungsvariable: Stellen Sie zunächst sicher, dass die Hadoop -Umgebungsvariable korrekt eingestellt ist. Führen Sie im Terminal den folgenden Befehl aus, um zu überprüfen, ob Hadoop ordnungsgemäß installiert und konfiguriert ist: Hadoopsion-Check HDFS-Konfigurationsdatei: Die Kernkonfigurationsdatei von HDFS befindet sich im/etc/hadoop/conf/verzeichnis, wobei core-site.xml und hdfs-site.xml von entscheidender Bedeutung sind. verwenden

Was sind die Backup -Methoden für Gitlab auf CentOS?

Apr 14, 2025 pm 05:33 PM

Was sind die Backup -Methoden für Gitlab auf CentOS?

Apr 14, 2025 pm 05:33 PM

Backup- und Wiederherstellungsrichtlinie von GitLab im Rahmen von CentOS -System Um die Datensicherheit und Wiederherstellung der Daten zu gewährleisten, bietet GitLab on CentOS eine Vielzahl von Sicherungsmethoden. In diesem Artikel werden mehrere gängige Sicherungsmethoden, Konfigurationsparameter und Wiederherstellungsprozesse im Detail eingeführt, um eine vollständige GitLab -Sicherungs- und Wiederherstellungsstrategie aufzubauen. 1. Manuell Backup Verwenden Sie den GitLab-RakegitLab: Backup: Befehl erstellen, um die manuelle Sicherung auszuführen. Dieser Befehl unterstützt wichtige Informationen wie GitLab Repository, Datenbank, Benutzer, Benutzergruppen, Schlüssel und Berechtigungen. Die Standardsicherungsdatei wird im Verzeichnis/var/opt/gitlab/backups gespeichert. Sie können /etc /gitlab ändern

Wie ist die GPU -Unterstützung für Pytorch bei CentOS?

Apr 14, 2025 pm 06:48 PM

Wie ist die GPU -Unterstützung für Pytorch bei CentOS?

Apr 14, 2025 pm 06:48 PM

Aktivieren Sie die Pytorch -GPU -Beschleunigung am CentOS -System erfordert die Installation von CUDA-, CUDNN- und GPU -Versionen von Pytorch. Die folgenden Schritte führen Sie durch den Prozess: Cuda und Cudnn Installation Bestimmen Sie die CUDA-Version Kompatibilität: Verwenden Sie den Befehl nvidia-smi, um die von Ihrer NVIDIA-Grafikkarte unterstützte CUDA-Version anzuzeigen. Beispielsweise kann Ihre MX450 -Grafikkarte CUDA11.1 oder höher unterstützen. Download und installieren Sie Cudatoolkit: Besuchen Sie die offizielle Website von Nvidiacudatoolkit und laden Sie die entsprechende Version gemäß der höchsten CUDA -Version herunter und installieren Sie sie, die von Ihrer Grafikkarte unterstützt wird. Installieren Sie die Cudnn -Bibliothek:

Detaillierte Erklärung des Docker -Prinzips

Apr 14, 2025 pm 11:57 PM

Detaillierte Erklärung des Docker -Prinzips

Apr 14, 2025 pm 11:57 PM

Docker verwendet Linux -Kernel -Funktionen, um eine effiziente und isolierte Anwendungsumgebung zu bieten. Sein Arbeitsprinzip lautet wie folgt: 1. Der Spiegel wird als schreibgeschützte Vorlage verwendet, die alles enthält, was Sie für die Ausführung der Anwendung benötigen. 2. Das Union File System (UnionFS) stapelt mehrere Dateisysteme, speichert nur die Unterschiede, speichert Platz und beschleunigt. 3. Der Daemon verwaltet die Spiegel und Container, und der Kunde verwendet sie für die Interaktion. 4. Namespaces und CGroups implementieren Container -Isolation und Ressourcenbeschränkungen; 5. Mehrere Netzwerkmodi unterstützen die Containerverbindung. Nur wenn Sie diese Kernkonzepte verstehen, können Sie Docker besser nutzen.

CentOS installieren MySQL

Apr 14, 2025 pm 08:09 PM

CentOS installieren MySQL

Apr 14, 2025 pm 08:09 PM

Die Installation von MySQL auf CentOS umfasst die folgenden Schritte: Hinzufügen der entsprechenden MySQL Yum -Quelle. Führen Sie den Befehl mySQL-server aus, um den MySQL-Server zu installieren. Verwenden Sie den Befehl mySQL_SECURE_INSTALLATION, um Sicherheitseinstellungen vorzunehmen, z. B. das Festlegen des Stammbenutzerkennworts. Passen Sie die MySQL -Konfigurationsdatei nach Bedarf an. Tune MySQL -Parameter und optimieren Sie Datenbanken für die Leistung.

So sehen Sie sich Gitlab -Protokolle unter CentOS

Apr 14, 2025 pm 06:18 PM

So sehen Sie sich Gitlab -Protokolle unter CentOS

Apr 14, 2025 pm 06:18 PM

Eine vollständige Anleitung zum Anzeigen von GitLab -Protokollen unter CentOS -System In diesem Artikel wird in diesem Artikel verschiedene GitLab -Protokolle im CentOS -System angezeigt, einschließlich Hauptprotokolle, Ausnahmebodi und anderen zugehörigen Protokollen. Bitte beachten Sie, dass der Log -Dateipfad je nach GitLab -Version und Installationsmethode variieren kann. Wenn der folgende Pfad nicht vorhanden ist, überprüfen Sie bitte das GitLab -Installationsverzeichnis und die Konfigurationsdateien. 1. Zeigen Sie das Hauptprotokoll an. Verwenden Sie den folgenden Befehl, um die Hauptprotokolldatei der GitLabRails-Anwendung anzuzeigen: Befehl: Sudocat/var/log/gitlab/gitlab-rails/production.log Dieser Befehl zeigt das Produkt an

Wie man eine verteilte Schulung von Pytorch auf CentOS betreibt

Apr 14, 2025 pm 06:36 PM

Wie man eine verteilte Schulung von Pytorch auf CentOS betreibt

Apr 14, 2025 pm 06:36 PM

Pytorch Distributed Training on CentOS -System erfordert die folgenden Schritte: Pytorch -Installation: Die Prämisse ist, dass Python und PIP im CentOS -System installiert sind. Nehmen Sie abhängig von Ihrer CUDA -Version den entsprechenden Installationsbefehl von der offiziellen Pytorch -Website ab. Für CPU-Schulungen können Sie den folgenden Befehl verwenden: PipinstallTorChTorChVisionTorChaudio Wenn Sie GPU-Unterstützung benötigen, stellen Sie sicher, dass die entsprechende Version von CUDA und CUDNN installiert ist und die entsprechende Pytorch-Version für die Installation verwenden. Konfiguration der verteilten Umgebung: Verteiltes Training erfordert in der Regel mehrere Maschinen oder mehrere Maschinen-Mehrfach-GPUs. Ort