ChatGPT erregte schnell die Aufmerksamkeit von Millionen Menschen, aber viele waren misstrauisch, weil sie nicht verstanden, wie es funktionierte. Und dieser Artikel ist ein Versuch, es aufzuschlüsseln, damit es leichter zu verstehen ist.

Im Kern ist ChatGPT jedoch ein sehr komplexes System. Wenn Sie mit ChatGPT spielen oder herausfinden möchten, was es ist, ist die Kernschnittstelle ein Chat-Fenster, in dem Sie Fragen stellen oder Anfragen stellen können und die KI antwortet. Ein wichtiges Detail, das Sie beachten sollten, ist, dass im Chat der Kontext erhalten bleibt, was bedeutet, dass Nachrichten auf frühere Informationen verweisen können und ChatGPT diese kontextbezogen verstehen kann.

Was passiert, wenn eine Anfrage in die Chatbox eingegeben wird?

Zunächst einmal gibt es im Rahmen von ChatGPT viel zu entdecken. Maschinelles Lernen hat sich in den letzten 10 Jahren rasant weiterentwickelt und ChatGPT nutzt viele hochmoderne Technologien, um seine Ergebnisse zu erzielen.

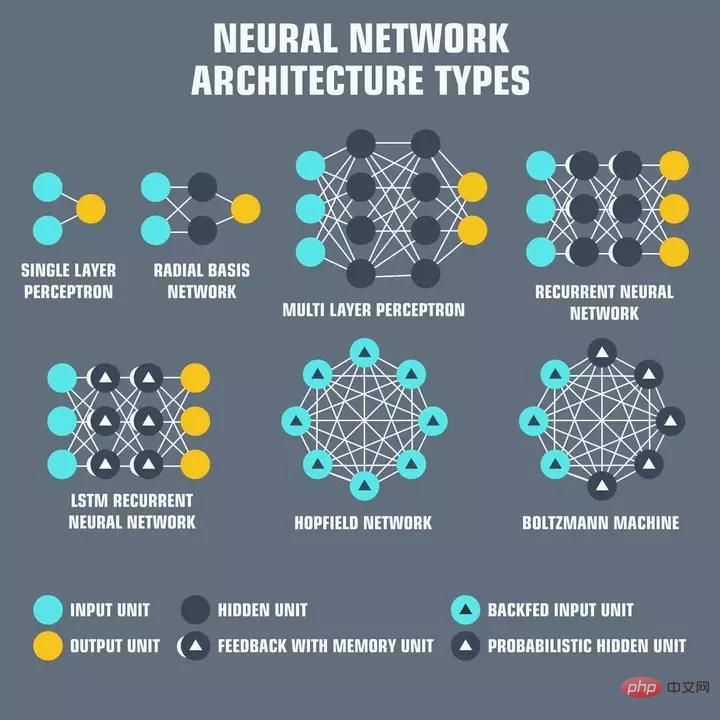

Neuronale Netzwerke sind Schichten miteinander verbundener „Neuronen“. Jedes Neuron ist dafür verantwortlich, Eingaben zu empfangen, zu verarbeiten und an das nächste Neuron im Netzwerk weiterzuleiten. Neuronale Netze bilden das Rückgrat der heutigen künstlichen Intelligenz. Die Eingabe besteht normalerweise aus einer Reihe numerischer Werte, die als „Merkmale“ bezeichnet werden und einen Aspekt der verarbeiteten Daten darstellen. Im Fall der Sprachverarbeitung könnten die Merkmale beispielsweise Worteinbettungen sein, die die Bedeutung jedes Wortes in einem Satz darstellen.

Eine Worteinbettung ist lediglich eine numerische Darstellung eines Textes, die ein neuronales Netzwerk verwendet, um die Semantik des Textes zu verstehen, die dann für andere Zwecke verwendet werden kann, beispielsweise für semantisch logische Antworten

Drücken Sie also in ChatGPT auf „Zurück“. Nach der Eingabe wird der Text zunächst in Worteinbettungen umgewandelt, die anhand von Texten aus dem gesamten Internet trainiert werden. Es gibt dann ein neuronales Netzwerk, das darauf trainiert ist, bei gegebenen Eingabeworteinbettungen einen Satz geeigneter Antwortworteinbettungen auszugeben. Diese Einbettungen werden dann mithilfe der umgekehrten Operation, die auf die Eingabeabfrage angewendet wird, in für Menschen lesbare Wörter übersetzt. Diese dekodierte Ausgabe wird von ChatGPT gedruckt.

Konvertierung und Ausgabegenerierung sind sehr rechenintensiv. ChatGPT basiert auf GPT-3, einem großen Sprachmodell mit 175 Milliarden Parametern. Das bedeutet, dass das umfangreiche neuronale Netzwerk OpenAI 175 Milliarden Gewichte enthält, die mithilfe seines großen Datensatzes optimiert wurden.

Für jede Abfrage sind also mindestens zwei 175-Milliarden-Berechnungen erforderlich, was sich schnell summiert. OpenAI hat möglicherweise eine Möglichkeit gefunden, diese Berechnungen zwischenzuspeichern, um die Rechenkosten zu senken. Es ist jedoch nicht bekannt, ob diese Informationen irgendwo veröffentlicht wurden. Darüber hinaus soll GPT-4, das voraussichtlich Anfang dieses Jahres veröffentlicht wird, 1000-mal mehr Parameter haben

Die Rechenkomplexität wird echte Kosten verursachen, wenn ChatGPT bald zu einem kostenpflichtigen Produkt wird! Hunderte Zehntausend Dollar, um es kostenlos zu betreiben.

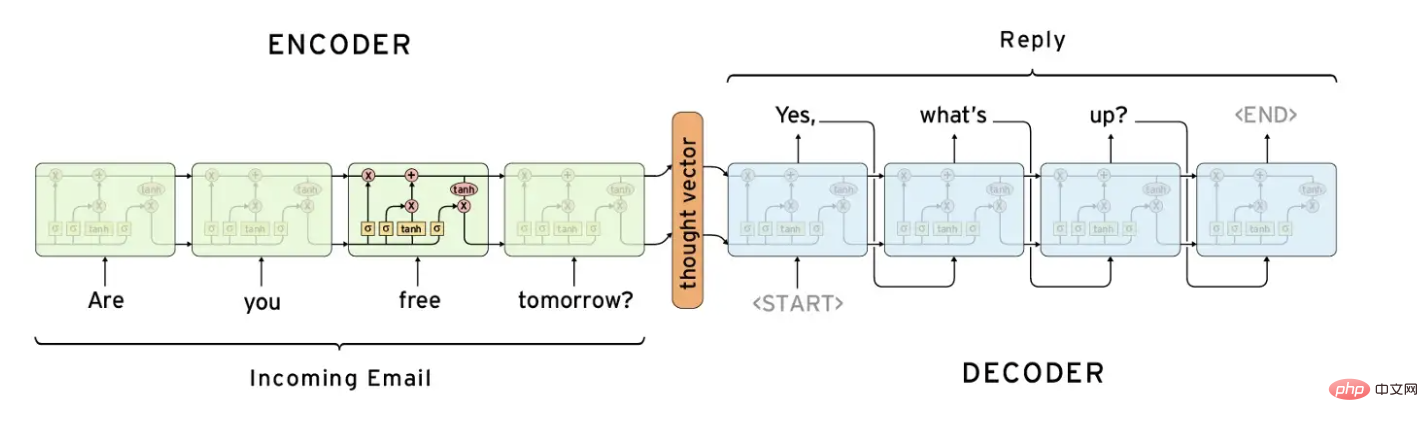

Eine häufig verwendete neuronale Netzwerkstruktur bei der Verarbeitung natürlicher Sprache ist das Encoder-Decoder-Netzwerk. Diese Netzwerke sind darauf ausgelegt, eine Eingabesequenz in eine kompakte Darstellung zu „kodieren“ und diese Darstellung dann in eine Ausgabesequenz zu „dekodieren“.

Traditionell wurden Encoder-Decoder-Netzwerke mit Recurrent Neural Networks (RNN) zur Verarbeitung sequentieller Daten gepaart. Der Encoder verarbeitet die Eingabesequenz und erzeugt eine Vektordarstellung fester Länge, die dann an den Decoder übergeben wird. Der Decoder verarbeitet diesen Vektor und erzeugt eine Ausgabesequenz.

Encoder-Decoder-Netzwerke werden häufig bei Aufgaben wie der maschinellen Übersetzung eingesetzt, bei denen die Eingabe ein Satz in einer Sprache und die Ausgabe die Übersetzung dieses Satzes in eine andere Sprache ist. Sie wurden auch auf Aufgaben zur Zusammenfassung und Generierung von Bildunterschriften angewendet.

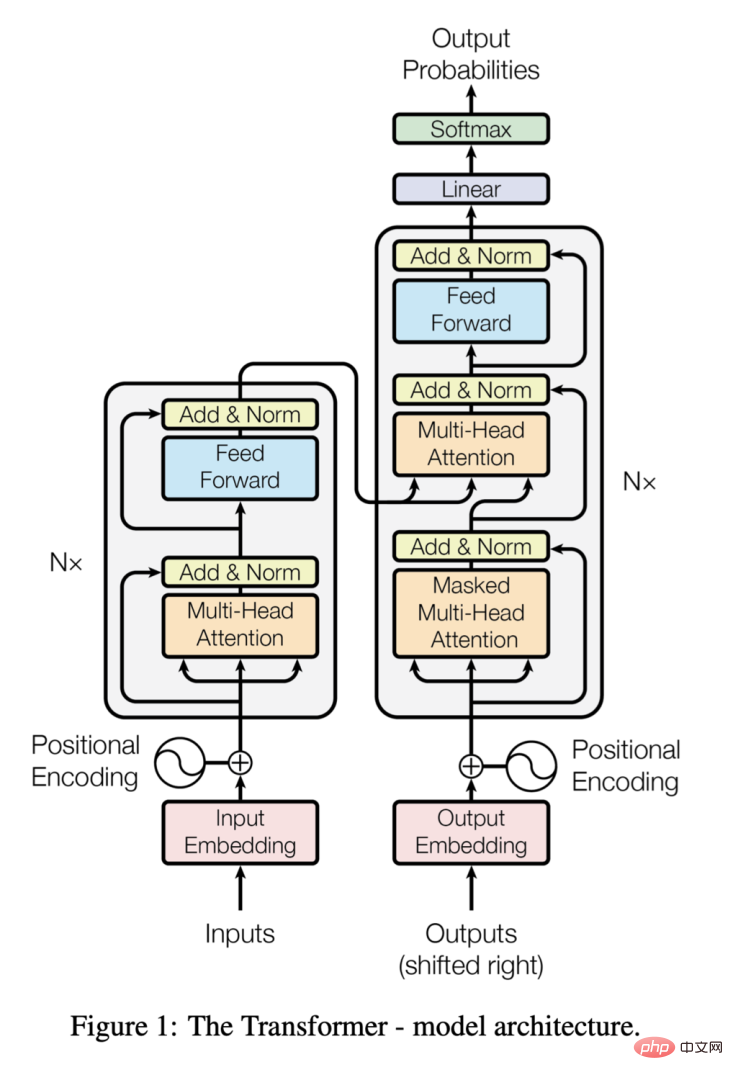

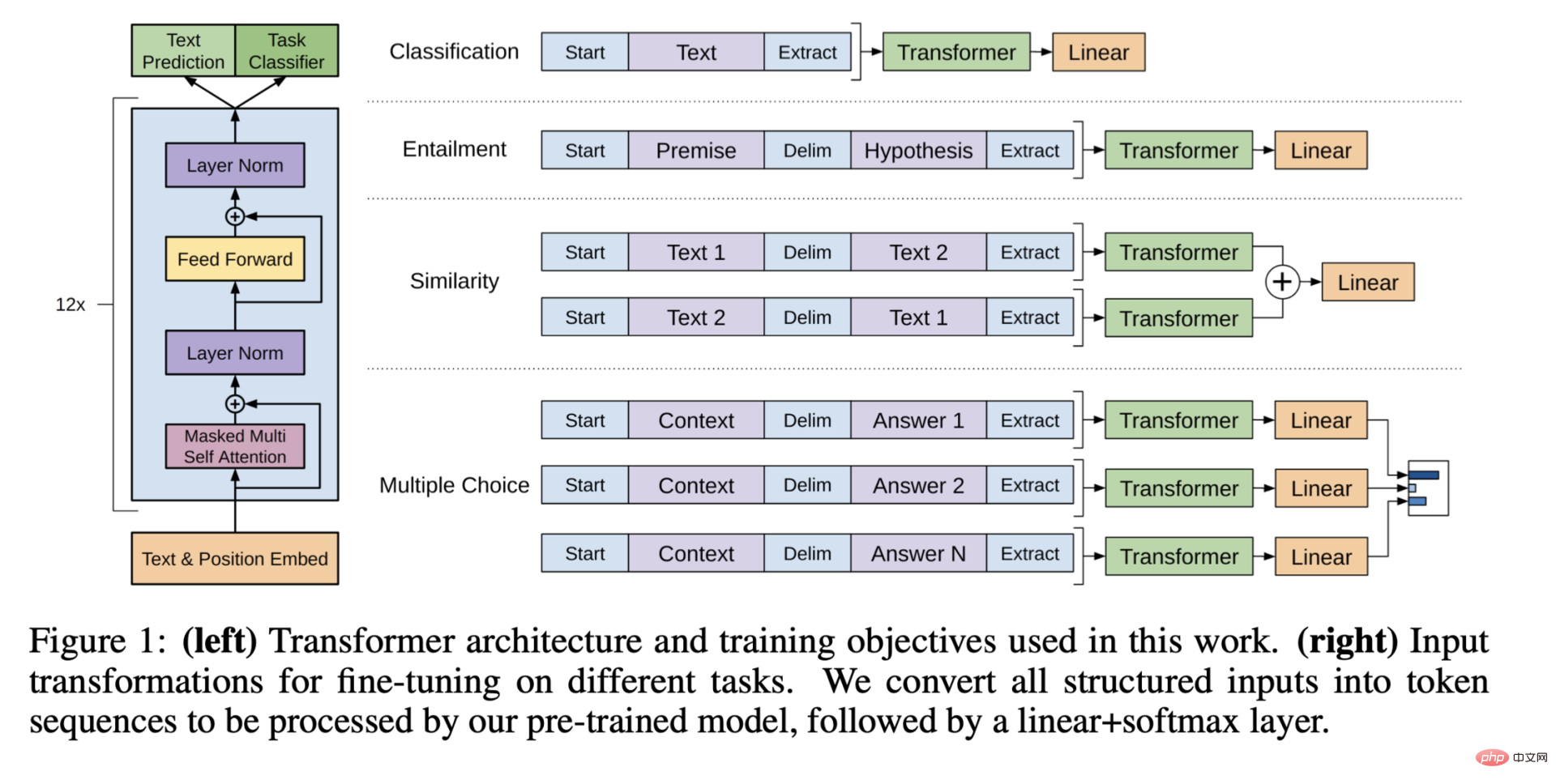

Ähnlich wie die Encoder-Decoder-Struktur besteht der Transformator aus zwei Komponenten; der Konverter unterscheidet sich jedoch dadurch, dass er einen Selbstaufmerksamkeitsmechanismus verwendet, der es jedem Eingabeelement ermöglicht, sich auf alle anderen zu konzentrieren Elemente, wodurch Beziehungen zwischen Elementen unabhängig von ihrem Abstand voneinander erfasst werden können.

Transformer nutzt außerdem die Multi-Head-Aufmerksamkeit, sodass er sich gleichzeitig auf mehrere Teile der Eingabe konzentrieren kann. Dadurch ist es möglich, komplexe Zusammenhänge im Eingabetext zu erfassen und hochpräzise Ergebnisse zu liefern.

Als 2017 das Paper „Attention is All You Need“ veröffentlicht wurde, löste der Transformer die Encoder-Decoder-Architektur als hochmodernes Modell für die Verarbeitung natürlicher Sprache ab, da er bei längeren Texten eine bessere Leistung erzielen konnte.

Transformer-Architektur, von https://arxiv.org/pdf/1706.03762.pdf

Generatives Pre-Training ist eine Technik, die besonders im Bereich der Verarbeitung natürlicher Sprache erfolgreich ist. Dabei werden umfangreiche neuronale Netze unbeaufsichtigt auf riesigen Datensätzen trainiert, um eine universelle Darstellung der Daten zu erlernen. Dieses vorab trainierte Netzwerk kann für bestimmte Aufgaben wie die Sprachübersetzung oder die Beantwortung von Fragen feinabgestimmt werden, wodurch die Leistung verbessert wird.

Generative Pre-Training-Architektur, Auszug aus „Verbesserung des Sprachverständnisses durch generatives Pre-Training“

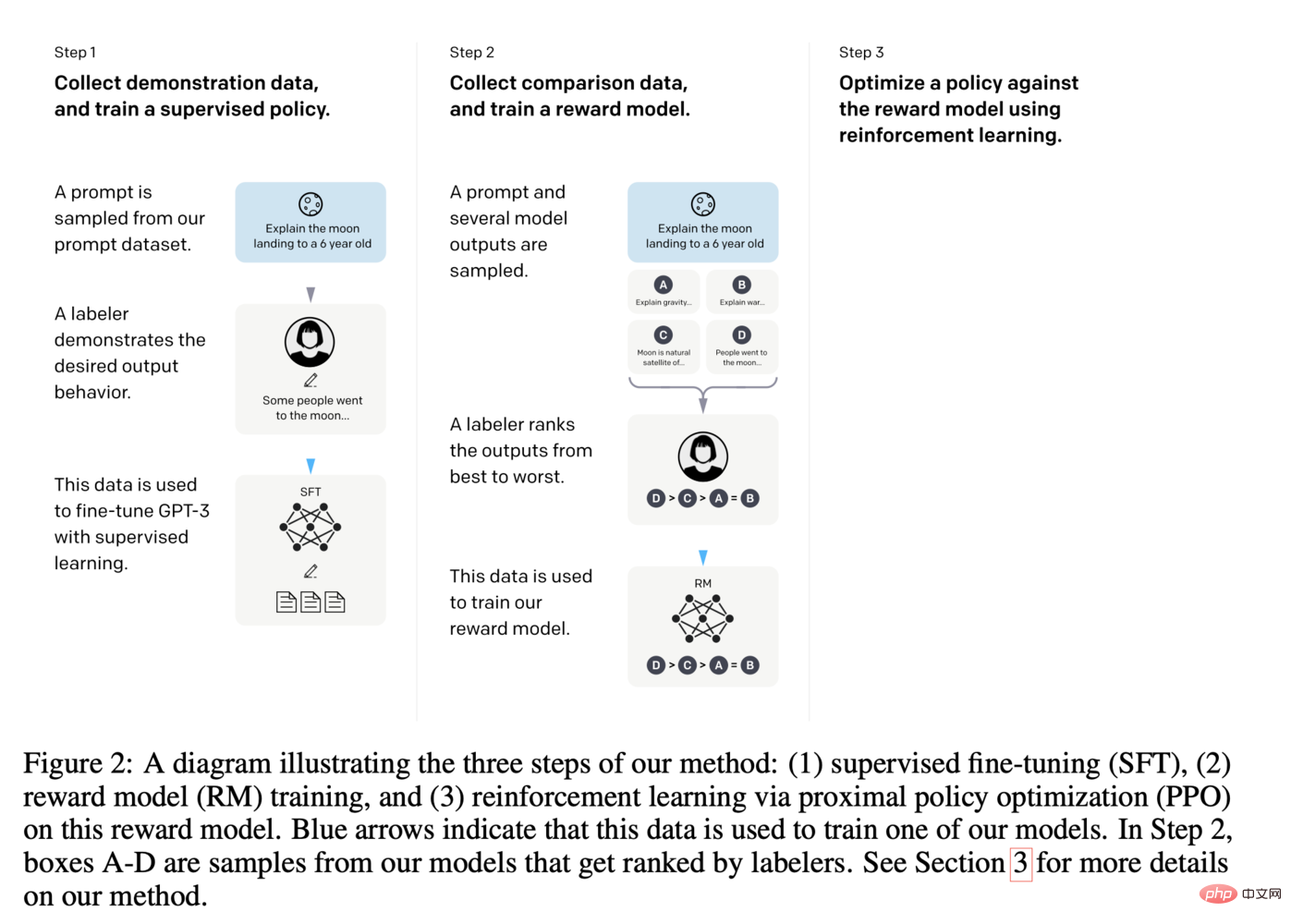

Im Fall von ChatGPT bedeutet dies eine Feinabstimmung der letzten Ebene des GPT-3-Modells zur Anpassung an die Verwendung Ein Beispiel für die Beantwortung von Fragen im Chat, bei dem auch menschliches Tagging genutzt wird. Die folgende Abbildung bietet einen detaillierteren Blick auf die Feinabstimmung von ChatGPT:

Schritte zur Feinabstimmung von ChatGPT, von https://arxiv.org/pdf/2203.02155.pdf

Daher gilt: im Rahmen von ChatGPT Da unten gibt es viele bewegliche Teile, und diese Teile werden immer weiter wachsen. Es wird sehr interessant sein zu beobachten, wie es sich weiterentwickelt, da Fortschritte in vielen verschiedenen Bereichen dazu beitragen werden, dass sich GPT-ähnliche Modelle weiter durchsetzen.

In den nächsten ein oder zwei Jahren werden wir möglicherweise große Störungen durch diese neue Basistechnologie erleben.

Das obige ist der detaillierte Inhalt vonKI-Enzyklopädie: So funktioniert ChatGPT. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Anwendung künstlicher Intelligenz im Leben

Anwendung künstlicher Intelligenz im Leben

ChatGPT-Registrierung

ChatGPT-Registrierung

Inländische kostenlose ChatGPT-Enzyklopädie

Inländische kostenlose ChatGPT-Enzyklopädie

Was ist das Grundkonzept der künstlichen Intelligenz?

Was ist das Grundkonzept der künstlichen Intelligenz?

So installieren Sie ChatGPT auf einem Mobiltelefon

So installieren Sie ChatGPT auf einem Mobiltelefon

Kann Chatgpt in China verwendet werden?

Kann Chatgpt in China verwendet werden?

Hongmeng-System

Hongmeng-System

Was ist der Unterschied zwischen 4g- und 5g-Mobiltelefonen?

Was ist der Unterschied zwischen 4g- und 5g-Mobiltelefonen?

node.js-Debugging

node.js-Debugging