Maschinelles Lernen hat in letzter Zeit große Fortschritte gemacht, aber es gibt immer noch eine große Herausforderung: die Notwendigkeit großer Mengen beschrifteter Daten zum Trainieren des Modells.

Manchmal sind diese Art von Daten in der realen Welt nicht verfügbar. Nehmen wir als Beispiel das Gesundheitswesen: Möglicherweise verfügen wir nicht über genügend Röntgenaufnahmen, um nach einer neuen Krankheit zu suchen. Aber durch Few-Shot-Learning kann das Modell Wissen aus nur wenigen Beispielen lernen!

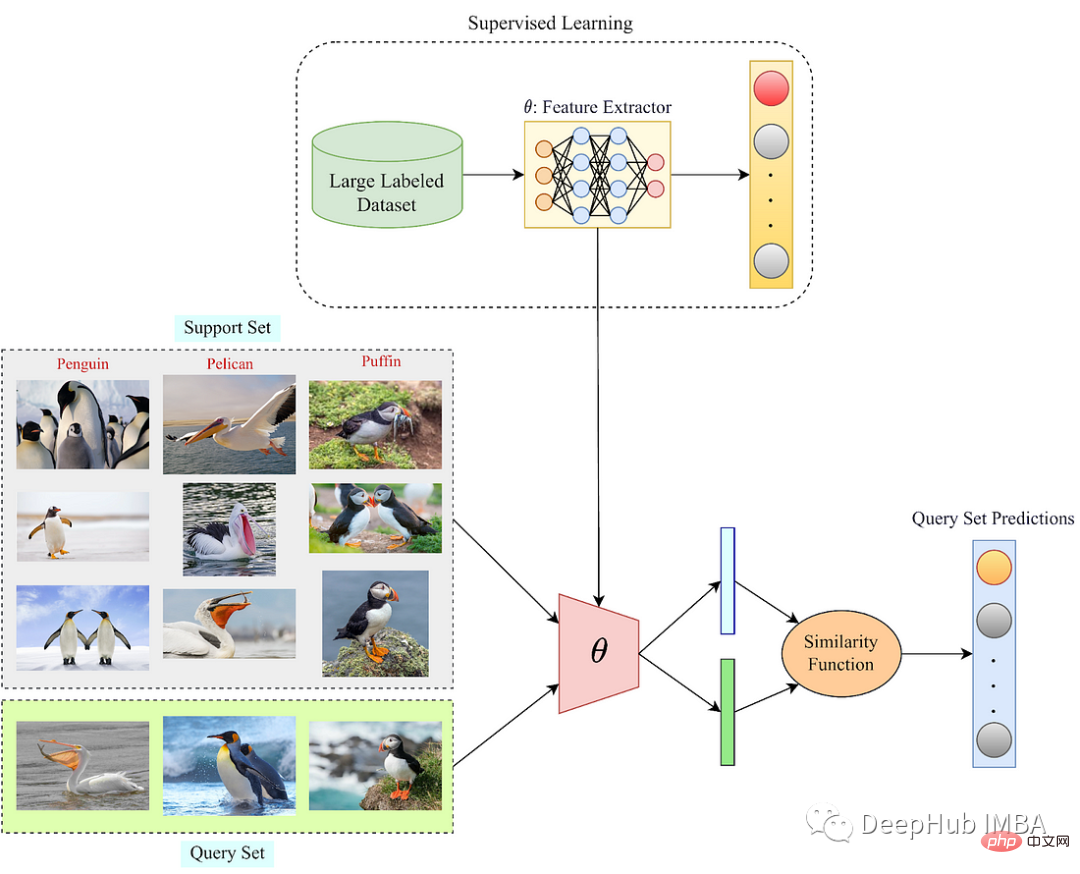

Fow-Shot-Learning (FSL) ist also ein Teilgebiet des maschinellen Lernens, das das Problem des Lernens neuer Aufgaben mit nur wenigen beschrifteten Beispielen löst Beispiele. Der ganze Sinn von FSL besteht darin, es Modellen für maschinelles Lernen zu ermöglichen, mit wenigen Daten neue Dinge zu lernen, was in Situationen nützlich ist, in denen das Sammeln einer Menge gekennzeichneter Daten zu teuer ist, zu lange dauert oder unpraktisch ist.

Unterstützungsbeispiel/Abfragesatz: Verwenden Sie eine kleine Anzahl von Bildern, um den Abfragesatz zu klassifizieren.

Es gibt drei Hauptmethoden zum Verständnis des Wenig-Schuss-Lernens: Meta-Lernen, Datenebene und Parameterebene.

Meta-Learning-Algorithmen trainieren typischerweise ein Modell für eine Reihe verwandter Aufgaben und lernen, aufgabenunabhängige und aufgabenspezifische Funktionen aus den verfügbaren Daten zu extrahieren. Aufgabenunabhängige Funktionen erfassen allgemeines Wissen über die Daten, während aufgabenspezifische Funktionen die Details der aktuellen Aufgabe erfassen. Während des Trainings lernt der Algorithmus, sich an neue Aufgaben anzupassen, indem er die Modellparameter anhand von nur wenigen beschrifteten Beispielen jeder neuen Aufgabe aktualisiert. Dadurch kann das Modell mit wenigen Beispielen auf neue Aufgaben verallgemeinert werden.

Methoden auf Datenebene

Die Hauptidee besteht darin, durch die Anwendung verschiedener Transformationen auf vorhandene Beispiele neue Beispiele zu erstellen, die dem Modell helfen können, die zugrunde liegende Struktur der Daten besser zu verstehen.

Es gibt zwei Arten von Methoden auf Datenebene:

Datenerweiterung: Bei der Datenerweiterung werden neue Beispiele durch Anwenden verschiedener Transformationen auf vorhandene Daten erstellt.Methoden auf Parameterebene zielen darauf ab, robustere Merkmalsdarstellungen zu erlernen, die sich besser auf neue Aufgaben verallgemeinern lassen.

Es gibt zwei Methoden auf Parameterebene:

Merkmalsextraktion: Bei der Merkmalsextraktion handelt es sich um das Erlernen einer Reihe von Merkmalen aus den Daten, die für neue Aufgaben verwendet werden können.Meta-Learning-Algorithmus

Meta-Lernalgorithmen können grob in zwei Typen unterteilt werden: metrische und Gradienten-basierte.

Metrikbasiertes Meta-Lernen

Ein beliebter metrikbasierter Algorithmus ist Siamese Network, der lernt, wie man den Abstand zwischen zwei Eingabebeispielen misst, indem er zwei identische Subnetzwerke verwendet. Diese Teilnetzwerke generieren Merkmalsdarstellungen für jedes Eingabebeispiel und vergleichen dann ihre Ausgaben mithilfe von Distanzmaßen wie der euklidischen Distanz oder der Kosinusähnlichkeit.

Gradienten-Meta-basiertes Lernen

Diese Algorithmen trainieren Modelle, um einen ersten Parametersatz zu erlernen und sich anhand weniger Beispiele schnell an neue Aufgaben anzupassen. MAML (Model-Agnostic Meta-Learning) ist ein beliebter Gradienten-basierter Meta-Learning-Algorithmus, der lernt, wie man die Parameter eines Modells optimiert, um sich schnell an neue Aufgaben anzupassen. Es trainiert das Modell durch eine Reihe verwandter Aufgaben und aktualisiert die Parameter des Modells anhand einiger Beispiele aus jeder Aufgabe. Sobald das Modell diese Parameter gelernt hat, kann es sie mithilfe anderer Beispiele aus der aktuellen Aufgabe verfeinern und so seine Leistung verbessern.

FSL verfügt über mehrere Algorithmen, darunter:

Die Kernidee von MAML besteht darin, die Initialisierung von Modellparametern zu erlernen, die anhand einiger Beispiele an neue Aufgaben angepasst werden können. Während des Trainings akzeptiert MAML eine Reihe verwandter Aufgaben und lernt, Modellparameter anhand einiger beschrifteter Beispiele jeder Aufgabe zu aktualisieren. Dieser Prozess ermöglicht es dem Modell, sich auf neue Aufgaben zu verallgemeinern, indem es gute Initialisierungen von Modellparametern erlernt, die schnell an neue Aufgaben angepasst werden können.

Matching Network ist ein weiterer häufig verwendeter Bildklassifizierungsalgorithmus für wenige Aufnahmen. Anstatt feste Metriken oder Parameter zu lernen, lernt es dynamische Metriken basierend auf dem aktuellen Support-Set. Dies bedeutet, dass die zum Vergleich des Abfragebilds und des Supportsatzes verwendete Metrik für jedes Abfragebild unterschiedlich ist.

Der Matching-Netzwerk-Algorithmus verwendet einen Aufmerksamkeitsmechanismus, um eine gewichtete Summe der Support-Set-Funktionen für jedes Abfragebild zu berechnen. Gewichtungen werden basierend auf der Ähnlichkeit zwischen dem Abfragebild und jedem Support-Set-Bild gelernt. Die gewichtete Summe der Support-Set-Features wird dann mit den Abfragebild-Features verkettet und die resultierenden Vektoren werden durch mehrere vollständig verbundene Schichten geleitet, um die endgültige Klassifizierung zu erstellen.

Prototype Network ist ein einfacher und effektiver Algorithmus zur Bildklassifizierung mit wenigen Aufnahmen. Es lernt eine Darstellung des Bildes und berechnet einen Prototyp für jede Klasse unter Verwendung des Durchschnitts der Einbettungsmerkmale der unterstützenden Beispiele. Beim Testen wird der Abstand zwischen dem Abfragebild und jedem Klassenprototyp berechnet und die Klasse mit dem nächstgelegenen Prototyp der Abfrage zugewiesen.

Beziehungsnetzwerklernen vergleicht unterstützte Beispielpaare und verwendet diese Informationen, um Abfragebeispiele zu klassifizieren. Das Beziehungsnetzwerk umfasst zwei Teilnetzwerke: das Feature-Einbettungsnetzwerk und das Beziehungsnetzwerk. Das Feature-Einbettungsnetzwerk ordnet jedes Beispiel im Support-Set und das Abfragebeispiel einem Feature-Space zu. Das Beziehungsnetzwerk berechnet dann den Beziehungswert zwischen dem Abfragebeispiel und jedem Support-Set-Beispiel. Abschließend werden diese Beziehungswerte zur Klassifizierung der Abfragebeispiele verwendet.

Few-Shot-Lernen hat viele Anwendungen in verschiedenen Bereichen, darunter:

Bei verschiedenen Computer-Vision-Aufgaben, einschließlich Bildklassifizierung, Objekterkennung und Segmentierung. Durch Few-Shot-Learning können neue Objekte in Bildern identifiziert werden, die in den Trainingsdaten nicht vorhanden sind.

Bei Aufgaben zur Verarbeitung natürlicher Sprache, wie z. B. Textklassifizierung, Stimmungsanalyse und Sprachmodellierung, trägt das Lernen mit wenigen Schüssen dazu bei, die Leistung von Sprachmodellen in Sprachen mit geringen Ressourcen zu verbessern.

Verwenden Sie Fear-Shot-Learning in der Robotik, damit Roboter schnell neue Aufgaben erlernen und sich an neue Umgebungen anpassen können. Beispielsweise kann ein Roboter anhand weniger Beispiele lernen, neue Gegenstände aufzunehmen.

Nur wenige Proben können seltene Krankheiten und Anomalien im Bereich der medizinischen Diagnose identifizieren, wenn die Daten begrenzt sind, und können dabei helfen, die Behandlung zu personalisieren und die Ergebnisse für den Patienten vorherzusagen.

Few-Shot-Learning ist eine leistungsstarke Technik, die es einem Modell ermöglicht, aus einer kleinen Anzahl von Beispielen zu lernen. Es hat zahlreiche Anwendungen in verschiedenen Bereichen und hat das Potenzial, maschinelles Lernen zu revolutionieren. Durch kontinuierliche Forschung und Entwicklung kann das Lernen mit wenigen Schüssen den Weg für effizientere und effektivere maschinelle Lernsysteme ebnen.

Das obige ist der detaillierte Inhalt vonEin Überblick über das Lernen mit wenigen Schüssen: Techniken, Algorithmen und Modelle. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!