Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

GPT-3 und Stable Diffusion arbeiten zusammen, um dem Modell zu helfen, die Bildretuscheanforderungen von Partei A zu verstehen

GPT-3 und Stable Diffusion arbeiten zusammen, um dem Modell zu helfen, die Bildretuscheanforderungen von Partei A zu verstehen

GPT-3 und Stable Diffusion arbeiten zusammen, um dem Modell zu helfen, die Bildretuscheanforderungen von Partei A zu verstehen

Nach der Popularität des Diffusionsmodells haben sich viele Menschen darauf konzentriert, effektivere Eingabeaufforderungen zu verwenden, um die gewünschten Bilder zu generieren. In den kontinuierlichen Versuchen einiger KI-Malmodelle haben die Leute sogar das Schlüsselwort „Erfahrung“ zusammengefasst, um KI-Bilder gut zeichnen zu lassen:

Mit anderen Worten: Wenn Sie die richtigen KI-Fähigkeiten beherrschen, wird die Qualität der Zeichnungen verbessert Der Effekt wird sehr offensichtlich sein (siehe: „Wie zeichnet man „Alpaca Playing Basketball“? Jemand hat 13 US-Dollar ausgegeben, um DALL·E 2 zu zwingen, seine wahren Fähigkeiten zu zeigen“).

Darüber hinaus arbeiten einige Forscher in eine andere Richtung: wie man ein Gemälde mit nur wenigen Worten in das verändert, was wir wollen.

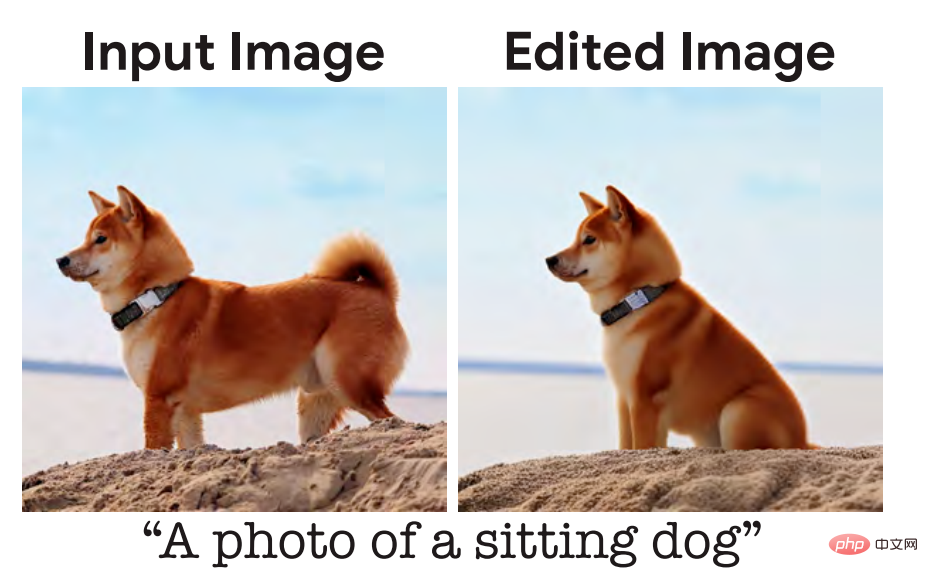

Vor einiger Zeit haben wir über eine Studievon Google Research und anderen Institutionen berichtet. Sagen Sie einfach, wie ein Bild aussehen soll, und es wird im Grunde Ihren Anforderungen entsprechen und fotorealistische Bilder erzeugen, wie zum Beispiel das Sitzen eines Welpen:

Hier sind die Eingaben für das Modell. Die Beschreibung lautet „a „Hund setzt sich hin“, aber entsprechend den täglichen Kommunikationsgewohnheiten der Menschen sollte die natürlichste Beschreibung „Lass diesen Hund sich setzen“ lauten. Einige Forscher sind der Ansicht, dass dies ein Problem ist, das optimiert werden sollte und das Modell besser den menschlichen Sprachgewohnheiten entsprechen sollte.

Kürzlich hat ein Forschungsteam der UC Berkeley eine neue Methode zum Bearbeiten von Bildern basierend auf menschlichen Anweisungen vorgeschlagen, InstructPix2Pix: Anhand eines Eingabebilds und einer Textbeschreibung, die dem Modell sagt, was zu tun ist, kann das Modell den Beschreibungsanweisungen folgen Bearbeiten Sie das Bild.

Papieradresse: https://arxiv.org/pdf/2211.09800.pdf

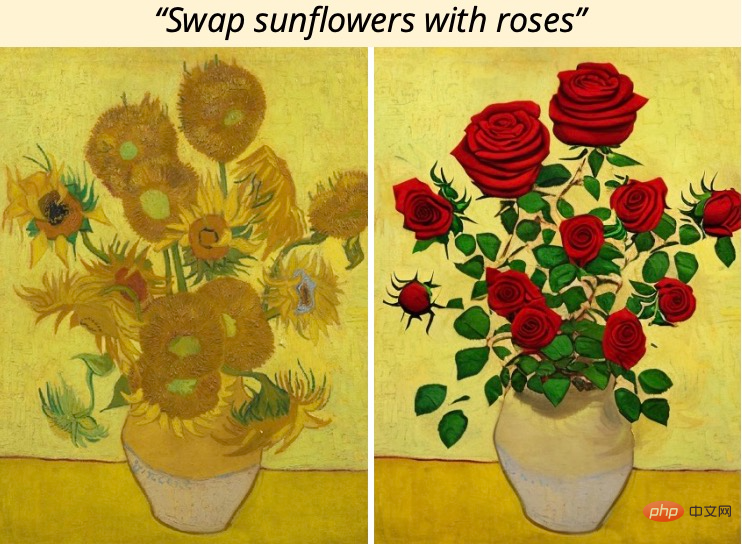

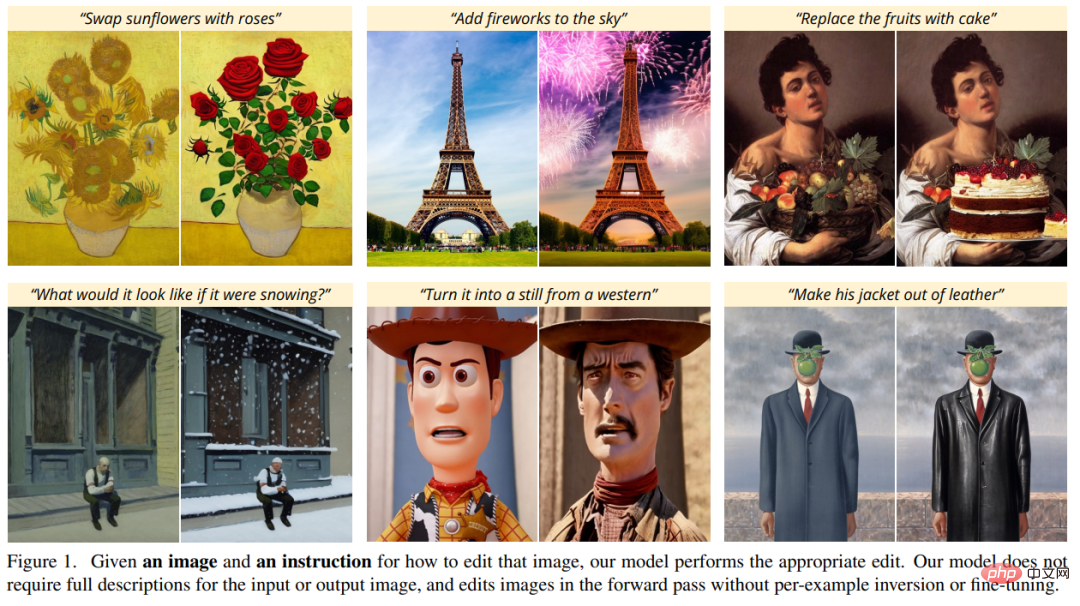

Um beispielsweise die Sonnenblumen im Gemälde durch Rosen zu ersetzen, müssen Sie nur direkt „Put“ sagen „zum Modell Sonnenblumen durch Rosen ersetzt“:

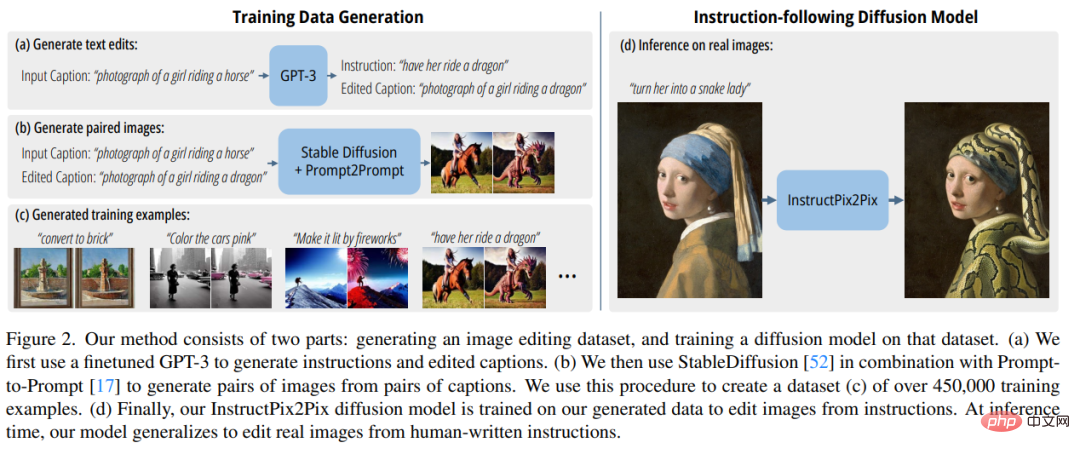

Um Trainingsdaten zu erhalten, kombinierte die Studie zwei groß angelegte vorab trainierte Modelle – Sprachmodell (GPT-3) und Text-zu-Bild-Generierung Modell (Stabile Diffusion) zum Generieren eines großen paarweisen Trainingsdatensatzes von Bildbearbeitungsbeispielen. Die Forscher trainierten ein neues Modell, InstructPix2Pix, auf diesem großen Datensatz und verallgemeinerten es zum Zeitpunkt der Inferenz auf reale Bilder und vom Benutzer geschriebene Anweisungen.

InstructPix2Pix ist ein bedingtes Diffusionsmodell, das ein bearbeitetes Bild generiert, wenn ein Eingabebild und eine Textanweisung zum Bearbeiten des Bildes vorliegen. Das Modell führt die Bildbearbeitung direkt im Vorwärtsdurchlauf durch und erfordert keine zusätzlichen Beispielbilder, keine vollständigen Beschreibungen der Eingabe-/Ausgabebilder oder eine Feinabstimmung der einzelnen Beispiele, sodass das Modell Bilder schnell in nur wenigen Sekunden bearbeiten kann.

Obwohl InstructPix2Pix vollständig an synthetischen Beispielen trainiert wird (d. h. von GPT-3 generierte Textbeschreibungen und von Stable Diffusion generierte Bilder), erreicht das Modell eine Zero-Shot-Verallgemeinerung auf beliebige reale Bilder und von Menschen geschriebenen Text. Das Modell unterstützt die intuitive Bildbearbeitung, einschließlich des Ersetzens von Objekten, des Änderns von Bildstilen und mehr.

Methodenübersicht

Die Forscher behandelten die anweisungsbasierte Bildbearbeitung als überwachtes Lernproblem: Zuerst generierten sie einen gepaarten Trainingsdatensatz mit Textbearbeitungsanweisungen und Bildern vor und nach der Bearbeitung (Abbildung 2a-c) und dann eine Bildbearbeitung Das Diffusionsmodell wurde auf diesem generierten Datensatz trainiert (Abb. 2d). Obwohl das Modell anhand generierter Bilder und Bearbeitungsanweisungen trainiert wurde, ist es dennoch in der Lage, reale Bilder mithilfe beliebiger, von Menschen geschriebener Anweisungen zu bearbeiten. Abbildung 2 unten gibt einen Überblick über die Methode.

Generieren Sie einen multimodalen Trainingsdatensatz

In der Datensatzgenerierungsphase kombinierten die Forscher ein großes Sprachmodell (GPT-3) und ein Text-zu-Bild-Modell ( Mit der Fähigkeit zur stabilen Diffusion (Stable Diffusion) wurde ein multimodaler Trainingsdatensatz generiert, der Textbearbeitungsanweisungen und entsprechende Bilder vor und nach der Bearbeitung enthält. Dieser Prozess besteht aus den folgenden Schritten:

- Feinabstimmung von GPT-3, um eine Sammlung von Textbearbeitungsinhalten zu generieren: Generieren Sie anhand einer Eingabeaufforderung, die ein Bild beschreibt, eine Textanweisung, die die vorzunehmende Änderung beschreibt, und eine Eingabeaufforderung, die das beschreibt geändertes Bild (Abbildung 2a);

- verwendet ein Text-zu-Bild-Modell, um zwei Textaufforderungen (d. h. vor und nach der Bearbeitung) in ein Paar entsprechender Bilder umzuwandeln (Abbildung 2b). Die Forscher nutzten die generierten Trainingsdaten, um ein bedingtes Diffusionsmodell basierend auf dem Stable Diffusion-Modell zu trainieren, das Bilder basierend auf schriftlichen Anweisungen bearbeiten kann.

Das Diffusionsmodell lernt, Datenproben durch eine Reihe von Entrauschungs-Autoencodern zu generieren, die den Anteil der Datenverteilung schätzen (in Richtung von Daten mit hoher Dichte zeigend). Die latente Diffusion verbessert die Effizienz und Qualität von Diffusionsmodellen, indem sie im latenten Raum eines vorab trainierten Variations-Autoencoders mit einem Encoder und einem Decoder

arbeitet. Für ein Bild Wir lernen ein Netzwerk

kennen, das das Rauschen vorhersagt, das einem verrauschten latenten z_t hinzugefügt wird, wenn ein Bildkonditionierungs-C_I und ein Textanweisungskonditionierungs-C_T gegeben sind. Die Forscher minimierten das folgende latente Diffusionsziel: Zuvor haben Studien (Wang et al.) gezeigt, dass bei Bildübersetzungsaufgaben, insbesondere wenn gepaarte Trainingsdaten begrenzt sind, die Feinabstimmung großer Bilddiffusionsmodelle das Training übertrifft sie von Grund auf. Daher verwenden die Autoren in neuen Forschungsarbeiten vorab trainierte Stable-Diffusion-Checkpoints, um die Gewichte des Modells zu initialisieren, und nutzen dabei die leistungsstarken Funktionen zur Text-zu-Bild-Generierung.

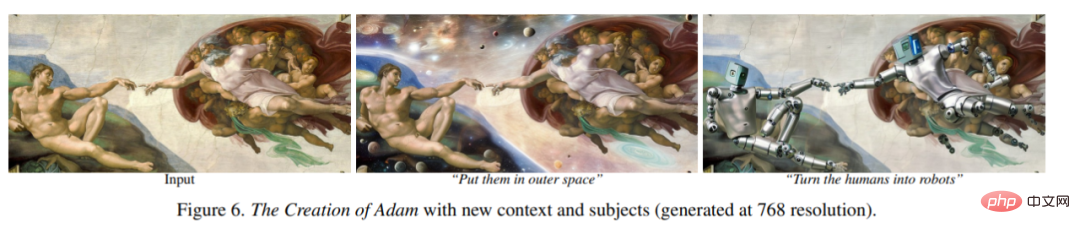

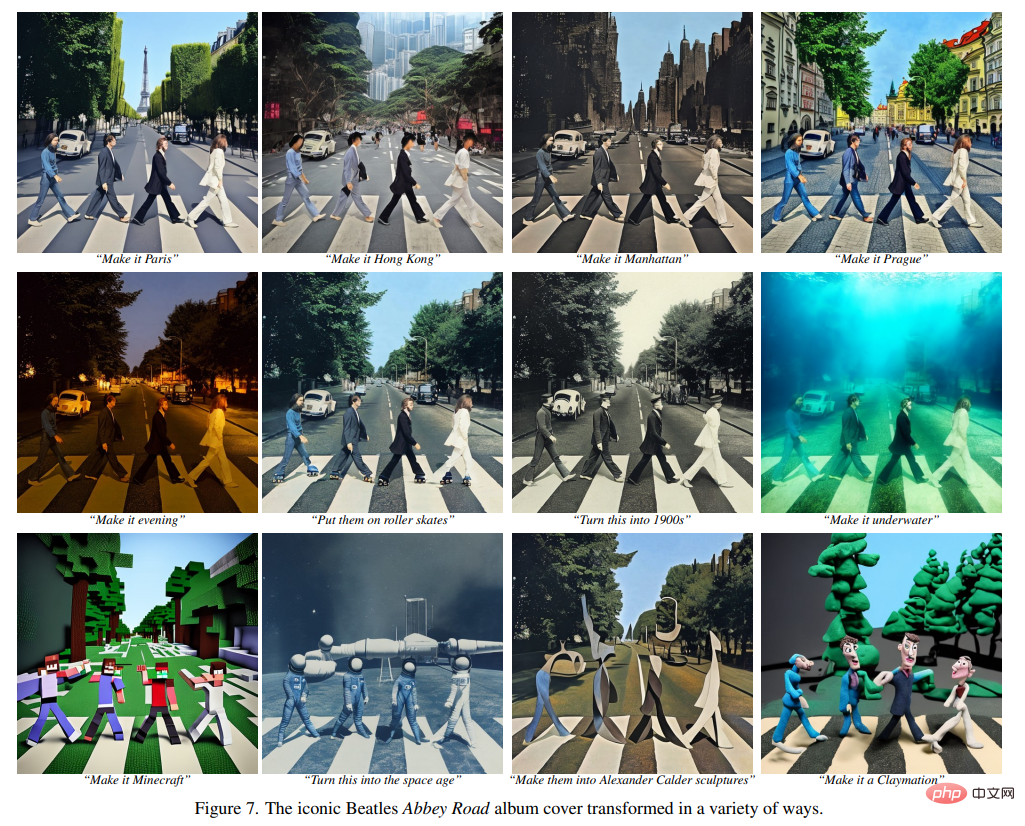

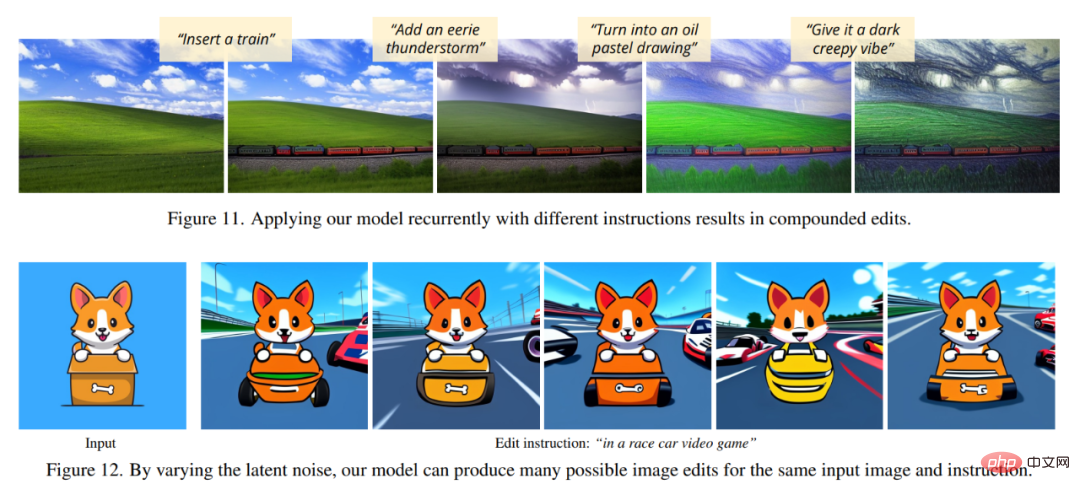

Um die Bildkonditionierung zu unterstützen, fügten die Forscher der ersten Faltungsschicht einen zusätzlichen Eingabekanal hinzu, der z_t und verbindet. Alle verfügbaren Gewichte des Diffusionsmodells werden vom vorab trainierten Prüfpunkt initialisiert, während Gewichte, die auf neu hinzugefügten Eingabekanälen wirken, auf Null initialisiert werden. Der Autor verwendet hier denselben Textkonditionierungsmechanismus, der ursprünglich für die Bildunterschrift verwendet wurde, ohne die Textbearbeitungsanweisung c_T als Eingabe zu verwenden. Experimentelle ErgebnisseIn den folgenden Abbildungen zeigen die Autoren die Bildbearbeitungsergebnisse ihres neuen Modells. Diese Ergebnisse beziehen sich auf einen anderen Satz echter Fotos und Kunstwerke. Das neue Modell führt viele anspruchsvolle Bearbeitungen erfolgreich durch, darunter das Ersetzen von Objekten, das Ändern von Jahreszeiten und Wetter, das Ersetzen von Hintergründen, das Ändern von Materialeigenschaften, das Konvertieren von Kunstmedien und mehr.

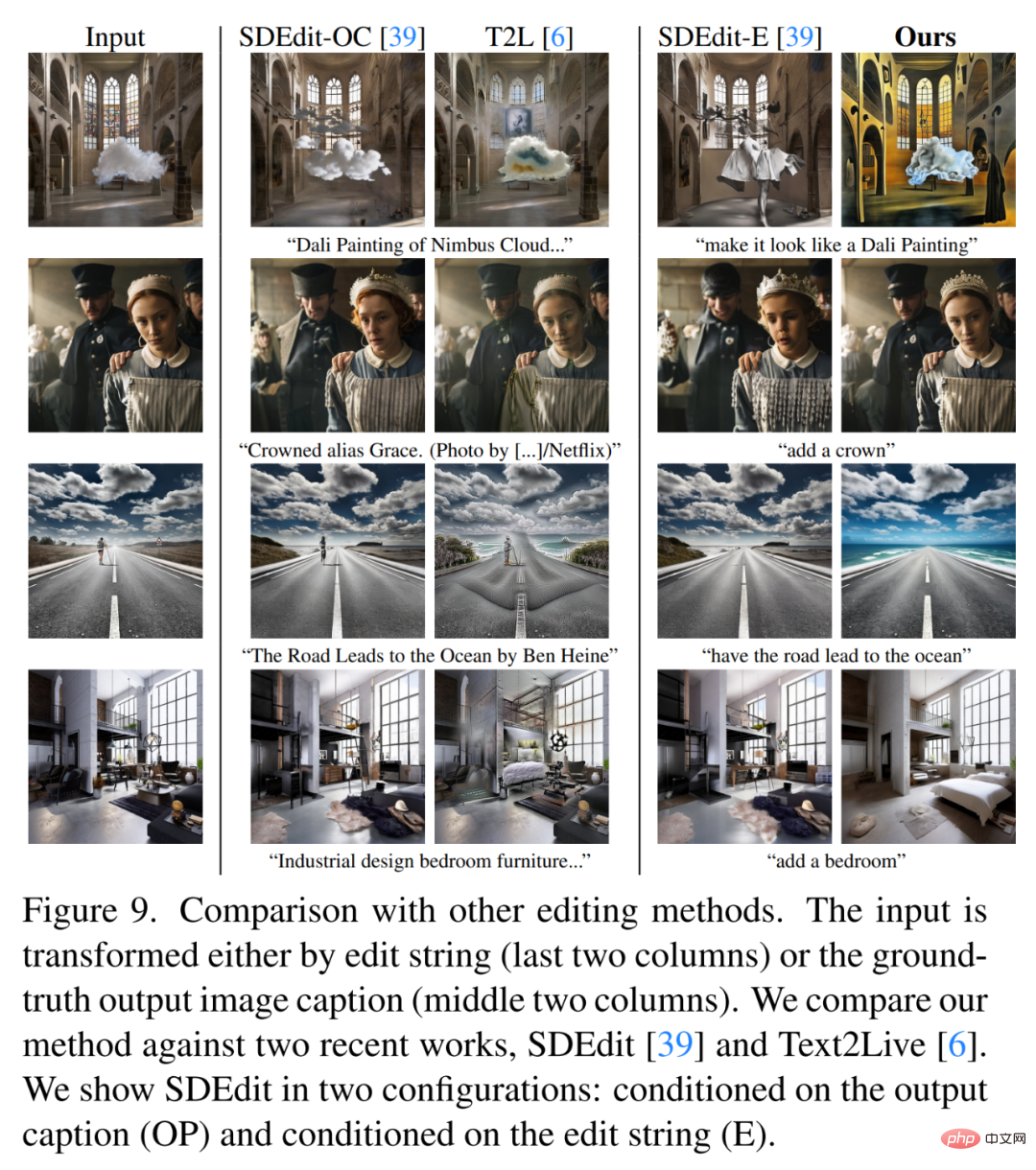

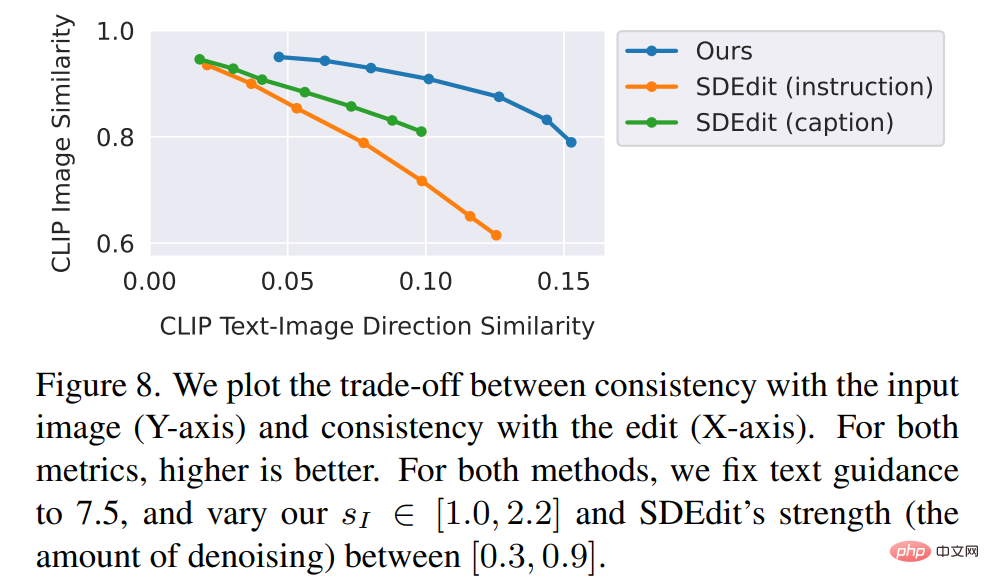

Die Forscher verglichen die neue Methode mit einigen neueren Technologien wie SDEdit, Text2Live usw. Das neue Modell folgt Anweisungen zum Bearbeiten von Bildern, während andere Methoden, einschließlich Basismethoden, Beschreibungen von Bildern oder Bearbeitungsebenen erfordern. Daher liefert der Autor beim Vergleich für letztere „bearbeitete“ Textanmerkungen anstelle von Bearbeitungsanweisungen. Die Autoren vergleichen die neue Methode auch quantitativ mit SDEdit und verwenden dabei zwei Metriken, die die Bildkonsistenz und die Bearbeitungsqualität messen. Abschließend zeigen die Autoren, wie sich die Größe und Qualität der generierten Trainingsdaten auf die Ablationsergebnisse in der Modellleistung auswirkt.

Das obige ist der detaillierte Inhalt vonGPT-3 und Stable Diffusion arbeiten zusammen, um dem Modell zu helfen, die Bildretuscheanforderungen von Partei A zu verstehen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

Warum ist es notwendig, Zeiger zu verabschieden, wenn sie GO- und Viper -Bibliotheken verwenden?

Apr 02, 2025 pm 04:00 PM

Warum ist es notwendig, Zeiger zu verabschieden, wenn sie GO- und Viper -Bibliotheken verwenden?

Apr 02, 2025 pm 04:00 PM

Go Zeigersyntax und Probleme bei der Verwendung der Viper -Bibliothek bei der Programmierung in Go -Sprache. Es ist entscheidend, die Syntax und Verwendung von Zeigern zu verstehen, insbesondere in ...

Gibt es ein kostenloses XML -zu -PDF -Tool für Mobiltelefone?

Apr 02, 2025 pm 09:12 PM

Gibt es ein kostenloses XML -zu -PDF -Tool für Mobiltelefone?

Apr 02, 2025 pm 09:12 PM

Es gibt kein einfaches und direktes kostenloses XML -zu -PDF -Tool auf Mobilgeräten. Der erforderliche Datenvisualisierungsprozess beinhaltet komplexes Datenverständnis und Rendering, und die meisten sogenannten "freien" Tools auf dem Markt haben schlechte Erfahrung. Es wird empfohlen, Computer-Seiten-Tools zu verwenden oder Cloud-Dienste zu verwenden oder Apps selbst zu entwickeln, um zuverlässigere Conversion-Effekte zu erhalten.

Warum werden alle Werte das letzte Element, wenn sie für den Bereich in der GO -Sprache verwendet werden, um Scheiben zu durchqueren und Karten zu speichern?

Apr 02, 2025 pm 04:09 PM

Warum werden alle Werte das letzte Element, wenn sie für den Bereich in der GO -Sprache verwendet werden, um Scheiben zu durchqueren und Karten zu speichern?

Apr 02, 2025 pm 04:09 PM

Warum bewirkt die Kartendiseration in Go alle Werte zum letzten Element? In Go -Sprache begegnen Sie, wenn Sie einige Interviewfragen konfrontiert sind, häufig Karten ...

So verschönern Sie das XML -Format

Apr 02, 2025 pm 09:57 PM

So verschönern Sie das XML -Format

Apr 02, 2025 pm 09:57 PM

Die XML -Verschönerung verbessert im Wesentlichen seine Lesbarkeit, einschließlich angemessener Einkerbung, Zeilenpausen und Tag -Organisation. Das Prinzip besteht darin, den XML -Baum zu durchqueren, die Eindrücke entsprechend der Ebene hinzuzufügen und leere Tags und Tags, die Text enthalten, zu verarbeiten. Pythons xml.etree.elementtree -Bibliothek bietet eine bequeme Funktion hübsch_xml (), die den oben genannten Verschönerungsprozess implementieren kann.

Wie kann ich benutzerdefinierte Pakete unter Go -Modulen korrekt importieren?

Apr 02, 2025 pm 03:42 PM

Wie kann ich benutzerdefinierte Pakete unter Go -Modulen korrekt importieren?

Apr 02, 2025 pm 03:42 PM

In der GO -Sprachentwicklung ist die ordnungsgemäße Einführung kundenspezifischer Pakete ein entscheidender Schritt. Dieser Artikel richtet sich an "Golang ...

Warum führt der Code, der mit Sperren in Go gelegentlich zu Panik führt?

Apr 02, 2025 pm 04:36 PM

Warum führt der Code, der mit Sperren in Go gelegentlich zu Panik führt?

Apr 02, 2025 pm 04:36 PM

Warum verursachen die Verwendung von Schlösser gelegentlich Panik? Schauen wir uns eine interessante Frage an: Warum in Go, auch wenn Schlösser im Code hinzugefügt werden, manchmal ...

So überprüfen Sie das XML -Format

Apr 02, 2025 pm 10:00 PM

So überprüfen Sie das XML -Format

Apr 02, 2025 pm 10:00 PM

Die Validierung des XML -Formats umfasst die Überprüfung der Struktur und der Einhaltung von DTD oder Schema. Ein XML -Parser ist erforderlich, wie z. Der Überprüfungsprozess umfasst das Parsen der XML -Datei, das Laden des XSD -Schemas und das Ausführen der AssertValid -Methode, um eine Ausnahme auszuführen, wenn ein Fehler erkannt wird. Das Überprüfen des XML -Formats erfordert auch die Handhabung verschiedener Ausnahmen und einen Einblick in die Sprache des XSD -Schemas.

Wie kann in Go Language das Problem verschiedener Parametertypen verschiedener Schnittstellen im Fabrikmodus gelöst werden?

Apr 02, 2025 pm 04:39 PM

Wie kann in Go Language das Problem verschiedener Parametertypen verschiedener Schnittstellen im Fabrikmodus gelöst werden?

Apr 02, 2025 pm 04:39 PM

In der GO -Sprache definieren Sie eine gemeinsame Schnittstelle und beschränken die von der Schnittstelle implementierten Methoden und verarbeiten gleichzeitig dieselben Methoden verschiedener Schnittstellen, aber unterschiedliche Parametertypen ...