Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Eine kurze Analyse der Bildverzerrungskorrekturtechnologie zu den Schwierigkeiten der Front-End-Verarbeitung der Smart-Car-Wahrnehmung

Eine kurze Analyse der Bildverzerrungskorrekturtechnologie zu den Schwierigkeiten der Front-End-Verarbeitung der Smart-Car-Wahrnehmung

Eine kurze Analyse der Bildverzerrungskorrekturtechnologie zu den Schwierigkeiten der Front-End-Verarbeitung der Smart-Car-Wahrnehmung

Wir wissen, dass beim Aufnehmen von Bildern die ideale Position der Kamera senkrecht zur Aufnahmeebene ist, um sicherzustellen, dass das Bild entsprechend seinen ursprünglichen geometrischen Proportionen wiedergegeben werden kann. Bei der tatsächlichen Anwendung intelligenter Autos erfordert die Karosseriesteuerung jedoch aufgrund der Einschränkungen der Karosseriestruktur einen bestimmten Vorschauabstand. Die horizontalen und vertikalen Scanflächen der Kamera dehnen sich normalerweise fächerförmig aus. und die Kamera hat im Allgemeinen Kontakt mit dem Boden. Installieren Sie sie in einem Winkel. Das Vorhandensein dieses Winkels führt zu gewissen Bildverzerrungen am Bildrand. Das Ergebnis der Verzerrung ist eine Reihe ähnlicher Probleme wie folgt bei der Nachbearbeitung von Bildern:

1) Vertikale Linien werden als diagonale Linien fotografiert, was zu Fehlern bei der Neigungsberechnung führt

2) Verzerrungen können zu weit entfernten Biegungen führen Die Komprimierung führt zu Fehlern bei der Krümmungsberechnung usw.; Bei den oben genannten Arten kann es zu Problemen bei der gesamten Bildwahrnehmung kommen, wenn die Verzerrung nicht richtig behandelt wird, was zu größeren Risiken für die Gesamtbildqualität und die anschließende Erkennung des neuronalen Netzwerks führt. Um den Echtzeitsteuerungsanforderungen intelligenter Autos gerecht zu werden, ist es im Allgemeinen erforderlich, entsprechende Korrekturalgorithmen für Kamerabildverzerrungen in praktischen Anwendungsszenarien vorzuschlagen.

01 Die wichtigsten Arten von Verzerrungen in Smart-Autos

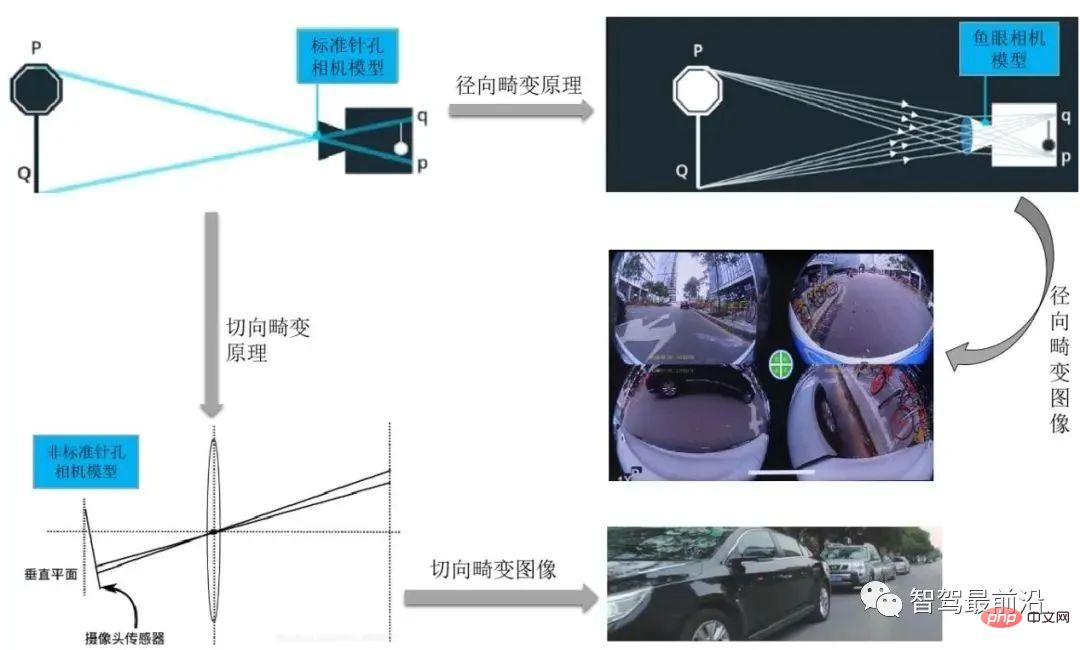

Zu den Kameraverzerrungen gehören Radialverzerrung, Tangentialverzerrung, Zentrifugalverzerrung, Verzerrung durch dünne Prismen usw. Zu den Hauptkameraverzerrungen bei Smart-Autos gehören Radialverzerrung und Tangentialverzerrung .

Radiale Verzerrung wird in Tonnenverzerrung und Kissenverzerrung unterteilt.

Normalerweise verwendet die in unserem intelligenten Parksystem verwendete Rundumsichtkamera Weitwinkelaufnahmen und der entsprechende Verzerrungstyp ist normalerweise eine radiale Verzerrung. Die Hauptursache für die radiale Verzerrung ist die unregelmäßige Änderung der radialen Krümmung der Linse, die zu einer Verzerrung des Bildes führt. Das Merkmal dieser Verzerrung ist, dass der Hauptpunkt das Zentrum ist und sich entlang der radialen Richtung bewegt Je weiter es entfernt ist, desto größer ist die erzeugte Verformung. Eine starke radiale Verzerrung eines Rechtecks muss in ein ideales lineares Linsenbild korrigiert werden, bevor es in den Back-End-Verarbeitungsprozess eintreten kann.

Die im Allgemeinen in Fahrsystemen verwendeten Front-, Seiten- und Rückfahrkameras verwenden allgemeine CMOS-Prozesskameras für die Aufnahme, und da der Installationsprozess der Front-Seitenkamera möglicherweise nicht gewährleistet, dass das Objektiv und Die Abbildungsfläche ist streng parallel, und gleichzeitig kann es an einem Herstellungsfehler liegen, dass das Objektiv nicht parallel zur Abbildungsebene ist, was zu einer tangentialen Verzerrung führt. Dieses Phänomen tritt normalerweise auf, wenn der Bildgeber an der Kamera angebracht ist.

In den Modellen für radiale Verzerrung und tangentiale Verzerrung sind sie in einer 5*1-Matrix angeordnet, einschließlich k1, k2, p1, p2, k3. wird oft in Form einer Mat-Matrix definiert.

Für die Verzerrungskorrektur sind diese 5 Parameter die 5 Verzerrungskoeffizienten der Kamera, die bei der Kamerakalibrierung ermittelt werden müssen. Die Parameter k1, k2 und k3 werden als radiale Verzerrungsparameter bezeichnet, wobei k3 ein optionaler Parameter ist. Bei Kameras mit starker Verzerrung (z. B. Augenkameras) können auch k4, k5 und k6 vorhanden sein. Die tangentiale Verzerrung kann durch zwei Parameter p1 und p2 dargestellt werden: Bisher wurden insgesamt fünf Parameter ermittelt: K1, K2, K3, P1, P2. Diese fünf Parameter sind zur Beseitigung der Verzerrung notwendig und werden auch Verzerrungsvektoren genannt werden als externe Parameter der Kamera bezeichnet.

Für die Verzerrungskorrektur sind diese 5 Parameter die 5 Verzerrungskoeffizienten der Kamera, die bei der Kamerakalibrierung ermittelt werden müssen. Die Parameter k1, k2 und k3 werden als radiale Verzerrungsparameter bezeichnet, wobei k3 ein optionaler Parameter ist. Bei Kameras mit starker Verzerrung (z. B. Augenkameras) können auch k4, k5 und k6 vorhanden sein. Die tangentiale Verzerrung kann durch zwei Parameter p1 und p2 dargestellt werden: Bisher wurden insgesamt fünf Parameter ermittelt: K1, K2, K3, P1, P2. Diese fünf Parameter sind zur Beseitigung der Verzerrung notwendig und werden auch Verzerrungsvektoren genannt werden als externe Parameter der Kamera bezeichnet.

Daher kann nach Erhalt dieser 5 Parameter die durch die Linsenverzerrung verursachte Verformungsverzerrung des Bildes korrigiert werden. Die folgende Abbildung zeigt den Effekt nach der Korrektur entsprechend dem Linsenverzerrungskoeffizienten:

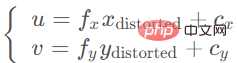

Finden Sie dies durch 5 Verzerrung Koeffizienten Die korrekte Positionsformel des Punktes auf der Pixelebene lautet wie folgt:

Der verzerrte Punkt kann über die interne Parametermatrix auf die Pixelebene projiziert werden, um die korrekte Position (u, v) des zu erhalten Punkt auf dem Bild:

02 Bildverzerrungskorrekturmethode

Unterscheidet sich von der Methode des Kameramodells, Bildentzerrung Um Objektivdefekte zu kompensieren, wird das Originalbild radial/tangential entzerrt und anschließend das Kameramodell verwendet. Der Umgang mit Bildverzerrungen hängt hauptsächlich davon ab, welches Kameramodell für die Bildprojektion ausgewählt werden soll.

Typische Kameramodell-Projektionsmethoden umfassen das sphärische Modell und das zylindrische Modell. #? # Normalerweise erzeugen Fischaugenobjektive eine starke Verformung. Während des Bildgebungsprozesses einer gewöhnlichen Kamera ist eine gerade Linie immer noch eine gerade Linie einer bestimmten Größe, wenn sie auf die Bildebene projiziert wird, aber wenn das Bild aufgenommen wird Wenn eine Fischaugenkamera auf die Bildebene projiziert wird, wird dies zu einer sehr großen und langen geraden Linie, und in einigen Szenen wird sogar die Erkennung gerader Linien auf unendlich projiziert, sodass das Lochkameramodell das Fischaugenobjektiv nicht modellieren kann.

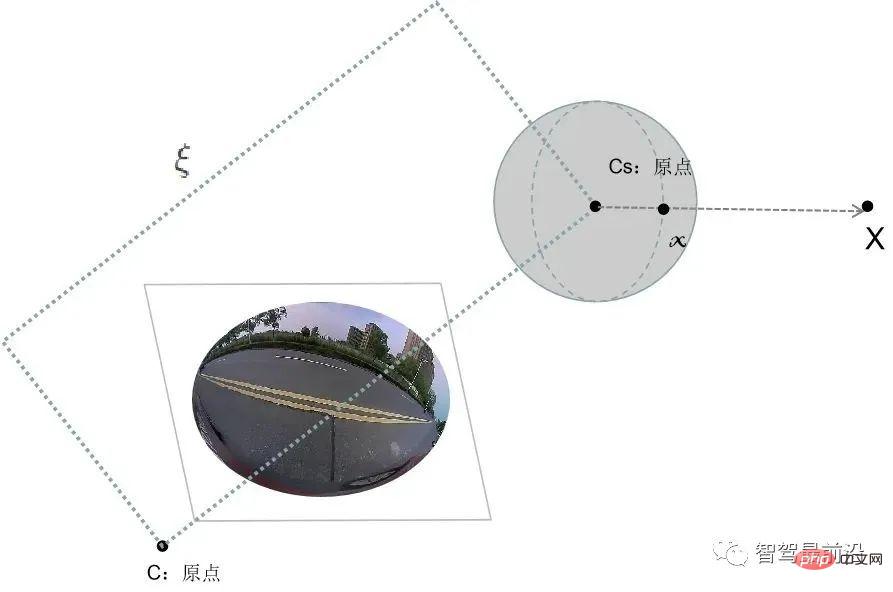

Um eine möglichst große Szene in eine begrenzte Bildebene zu projizieren, setzt sich die erste Version des Fischaugenobjektivs aus mehr als einem Dutzend verschiedener Linsen zusammen Dabei wird das einfallende Licht unterschiedlich stark gebrochen und auf eine Bildebene begrenzter Größe projiziert, wodurch das Fischaugenobjektiv im Vergleich zu herkömmlichen Objektiven ein größeres Sichtfeld hat. Untersuchungen zeigen, dass das Modell, dem Fischaugenkameras bei der Bildgebung folgen, ungefähr einem Einheitskugelprojektionsmodell entspricht. Um sich besser an den Ableitungsprozess des Kamera-Lochlochmodells anzupassen, besteht die übliche Methode darin, den Prozess der Projektion auf das sphärische Kameramodell zu verwenden.

Die Analyse des Fischaugenkamera-Bildgebungsprozesses kann in zwei Schritte unterteilt werden:

#🎜🎜 #Dreidimensional Der Raumpunkt wird linear auf eine Kugel projiziert. Natürlich handelt es sich bei dieser Kugel um die virtuelle Kugel, von der wir annehmen, dass ihr Mittelpunkt mit dem Ursprung der Kamerakoordinaten zusammenfällt.

Der Punkt auf der Einheitskugel wird auf die Bildebene projiziert. Dieser Vorgang ist nichtlinear.

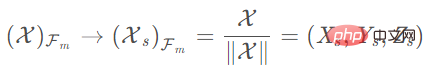

Die folgende Abbildung zeigt den Bildverarbeitungsprozess von einer Fischaugenkamera zu einer sphärischen Kamera in einem intelligenten Fahrsystem. Nehmen Sie an, dass der Punkt im Kamerakoordinatensystem X=(x,y,z) und die Pixelkoordinate x=(u,v) ist. Dann wird sein Projektionsprozess wie folgt ausgedrückt: Sammeln Sie mit einer Kamera dreidimensionale Punkte im Weltkoordinatensystem und projizieren Sie die Bildpunkte im Bildkoordinatensystem auf die normalisierten sphärischen Einheitskoordinaten #

- 2) Versetzen Sie das Kamerakoordinatenzentrum um Einheiten entlang der Z-Achse und erhalten Sie Folgendes: # 🎜🎜#

3) Betrachten Sie die Einheitskugel und normalisieren Sie die Kugel auf 1 Einheit: # 🎜🎜#

#🎜 🎜#

4) Transformieren Sie das sphärische Projektionsmodell in das Lochmodell, um das entsprechende zu erhalten Hauptpunktkoordinaten, die zum Herstellen einer Korrespondenz verwendet werden können. Das Standardmodell des Kamerakoordinatensystems:

#🎜 🎜#2. Zylinderkoordinatenprojektion

Bei Endgeräten wie Front- und Seitenansichtkameras erzeugen die aufgenommenen Bilder in der Regel hauptsächlich tangentiale Verzerrungen. Bei tangentialer Verzerrung empfiehlt sich in der Regel die Verwendung eines zylindrischen Kameramodells. Der Vorteil besteht darin, dass der Benutzer in einer Panoramaansicht wie einer Fischaugenkamera die Sichtlinie beliebig wechseln und auch die Perspektive ändern kann auf einer Sichtlinie, um den Effekt einer Annäherung oder Entfernung zu erzielen. Gleichzeitig sind zylindrische Panoramabilder auch einfacher zu verarbeiten, da die zylindrische Oberfläche entlang der Achse geschnitten und auf einer Ebene entfaltet werden kann Zylindrische Panoramabilder können oft nicht sehr genau kalibriert werden. Nutzer haben einen 360-Grad-Blickwinkel in horizontaler Richtung und können auch bestimmte Blickwinkeländerungen in vertikaler Richtung vornehmen, allerdings ist der Winkelbereich begrenzt, da die Bildqualität des zylindrischen Modells gleichmäßiger und die Details realistischer sind Es hat ein breiteres Anwendungsspektrum.

Im Allgemeinen lassen sich die wesentlichen Vorteile des zylindrischen Panoramas in den folgenden zwei Punkten zusammenfassen:

1) Die Aufnahmemethode für ein einzelnes Foto ist einfacher als die Aufnahmemethode für Würfelform und Kugelform. Gewöhnliche Fahrzeugkameras (z. B. Front- und Seitenkameras) können grundsätzlich Originalbilder erhalten.

2) Das zylindrische Panorama lässt sich leicht zu einem rechteckigen Bild erweitern, das direkt in gängigen Computerbildformaten gespeichert und abgerufen werden kann. Das zylindrische Panorama ermöglicht, dass der Rotationswinkel der Blickrichtung des Teilnehmers in vertikaler Richtung weniger als 180 Grad beträgt. In den meisten Anwendungen reicht jedoch eine 360-Grad-Panoramaszene in horizontaler Richtung aus, um räumliche Informationen auszudrücken.

Hier konzentrieren wir uns auf den Algorithmus zur Verwendung einer zylindrischen Kamera zur Korrektur der Verzerrung des Originalbilds. Tatsächlich handelt es sich hierbei um einen Prozess, bei dem die Zuordnungsbeziehung von der virtuellen Kamera zur Originalkamera ermittelt wird . Die virtuelle Kamera bezieht sich hier auf die Abbildungsbeziehung zwischen realen Bildern und generierten zylindrischen Bildern.

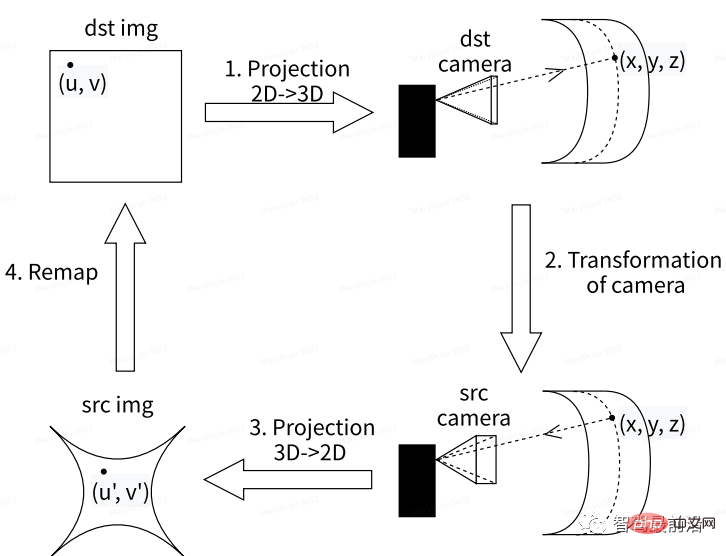

Die folgende Abbildung zeigt den Bildverarbeitungsprozess beim Konvertieren von gewöhnlichen Autokameraaufnahmen zu zylindrischen Kameras in einem intelligenten Fahrsystem. Unter anderem besteht das Wesentliche beim Erhalten des virtuellen Kamerabilds darin, die Zuordnungsbeziehung zwischen der virtuellen Kamera und der Originalkamera zu ermitteln. Der allgemeine Prozess ist wie folgt:

Zuerst das Originalvideo von vorne/von der Seite Das Bild kann als Zielbild festgelegt werden. dst img; wobei der Hauptpunkt (u, v) auf der Zielkarte der Basispunkt für die Rückprojektionstransformation von 2D in 3D ist, um die Zielkamera-Koordinatenkarte zu rekonstruieren Die Position des Punktes im Weltkoordinatensystem (x, y, z); dann kann das entsprechende ursprüngliche Kamerabild Src unter der virtuellen Kamera durch den Projektionstransformationsalgorithmus in das dreidimensionale Koordinatensystem erhalten werden; Erhalten Sie das Bild Src img (u', v'), indem Sie eine 3D- in eine 2D-Projektion des Originalkamerabilds umwandeln. Dieses Bild kann rekonstruiert werden, um das Originalbild dst img unter der virtuellen Kamera wiederherzustellen.

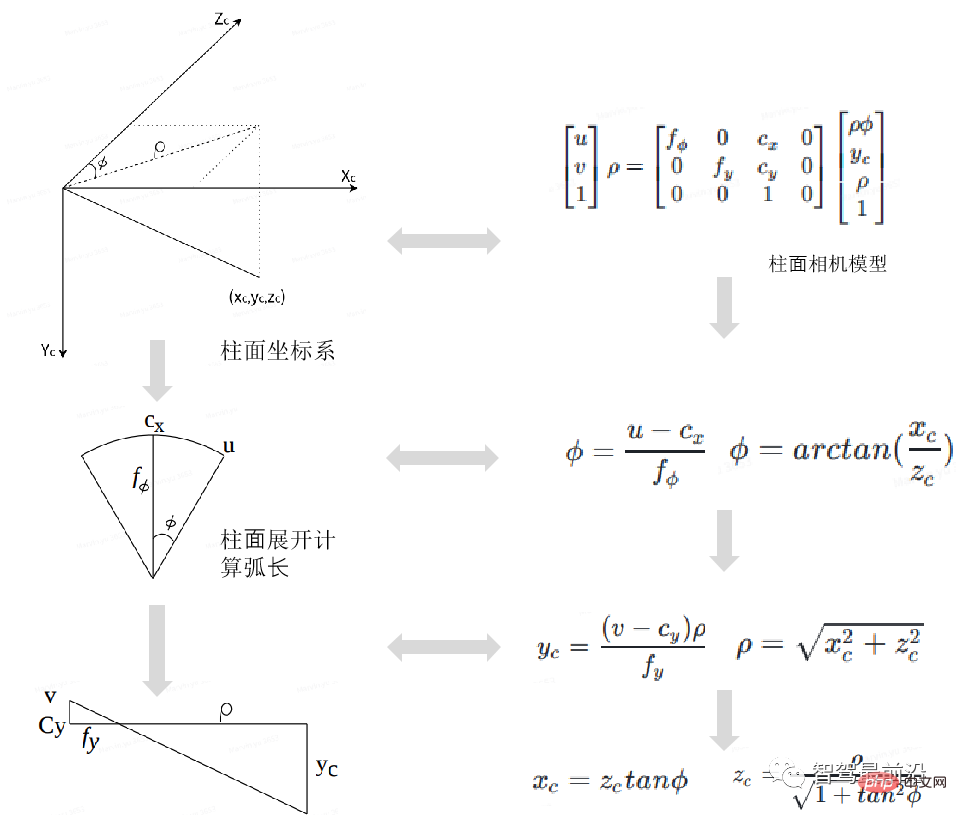

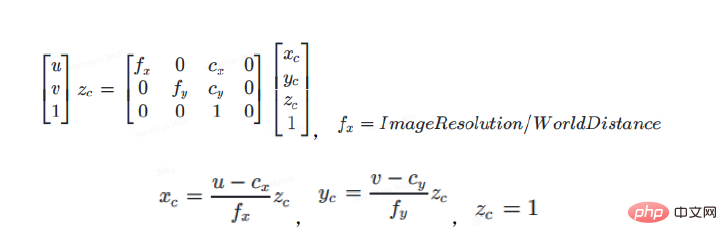

Aus dem zylindrischen Kameramodell ist ersichtlich, dass die Transformationsformel vom zylindrischen Kameramodell zum Lochkameramodell wie folgt lautet:

In der obigen Formel stellen u und v dar Hauptpunkte der Lochkameraebene (im Pixelkoordinatensystem auch Koordinaten genannt), fx, fy, cx, cy stellen die beiden Koordinatenachsen-Ablenkungsparameter dar, die durch Herstellungs- oder Installationsfehler verursacht werden. Der Hauptpunkt wird mit dem Radiusabstand im Zylinderkoordinatensystem multipliziert, um die entsprechende Projektion auf die Zylinderkoordinaten zu erhalten.

ρ wird verwendet, um eine polynomische Annäherung an den 2D->3D-Raum durchzuführen. Wenn Tdst = Tsrc ist, nimmt ρ unterschiedliche Werte an, und zwar aus dem 3D-Raum->Seiten-/Vorderansichtsraum der in 2D erhaltenen virtuellen Kamera ist derselbe, wenn Tdst! =Tsrc, das erhaltene virtuelle Kamerabild ändert sich mit ρ. Für eine gegebene zylindrische 2D-Position (u, v) können unter einer gegebenen ρ-Bedingung die 3D-Kamerakoordinaten xc, yc, zc im dst-Kamera-Zylinderkoordinatensystem gemäß der obigen Formel berechnet werden.

Φ wird verwendet, um eine polynomische Näherung durchzuführen. Φ ist der Winkel zwischen dem einfallenden Licht und der Bildebene. Dieser Wert ist den Parametern einer Fischaugenkamera sehr ähnlich.

Der nächste Schritt ist der Kameratransformationsprozess, der wie folgt zusammengefasst werden kann.

Stellen Sie zunächst die Bildauflösung der virtuellen Kamera auf die Auflösung der IPM-Karte aus der Vogelperspektive ein, die Sie erhalten möchten. Der Hauptpunkt des virtuellen Kamerabilds ist die Mitte der IPM-Kartenauflösung (im Allgemeinen unter der Annahme, dass kein Offset eingestellt ist). ). Zweitens stellen Sie fx, fy und die Kameraposition der virtuellen Kamera ein. Die Höhe ist auf 1 eingestellt, was der Einstellungsmethode von fx und fy entspricht. Der Offset von y kann je nach Bedarf geändert werden. Daraus können die Kamerakoordinaten der dst-Kamera (xc, yc, zc) dst gemäß den externen Parametern (R, T) dst der Zielkamera dst in die Koordinaten des Beobachtungskoordinatensystems vcs konvertiert und dann mit den externen Parametern kombiniert werden Parameter der src-Kamera (R, T) src, konvertieren Sie VCS-Koordinaten in src-Kamera-Kamerakoordinaten (xc, yc, zc) src.

03 Zusammenfassung

Da Fahrzeugkameras in der Regel mit unterschiedlichen Abbildungsobjektiven ausgestattet sind, macht es dieser Mehrelementaufbau unmöglich, einfach das ursprüngliche Lochkameramodell zur Analyse der Brechungsbeziehung zu verwenden von fahrzeugmontierten Kameras. Insbesondere bei Fischaugenkameras ist die durch diesen Brechungsindex verursachte Bildverzerrung aufgrund der Notwendigkeit, den Sichtbereich zu erweitern, noch deutlicher. In diesem Artikel konzentrieren wir uns auf die Entzerrungsmethode, die an verschiedene Arten von visuellen Sensoren in intelligenten Fahrsystemen angepasst ist. Dabei projizieren wir das Bild im Weltkoordinatensystem hauptsächlich in das virtuelle sphärische Koordinatensystem und das virtuelle zylindrische Koordinatensystem Verlassen Sie sich auf die 2D->3D-Kameratransformation, um Verzerrungen zu beseitigen. Einige Algorithmen wurden aufgrund langjähriger Praxis im Vergleich zum klassischen Entverzerrungsalgorithmus verbessert.

Das obige ist der detaillierte Inhalt vonEine kurze Analyse der Bildverzerrungskorrekturtechnologie zu den Schwierigkeiten der Front-End-Verarbeitung der Smart-Car-Wahrnehmung. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1377

1377

52

52

Smart App Control unter Windows 11: So aktivieren oder deaktivieren Sie es

Jun 06, 2023 pm 11:10 PM

Smart App Control unter Windows 11: So aktivieren oder deaktivieren Sie es

Jun 06, 2023 pm 11:10 PM

Intelligent App Control ist ein sehr nützliches Tool in Windows 11, das dabei hilft, Ihren PC vor nicht autorisierten Apps zu schützen, die Ihre Daten beschädigen können, wie z. B. Ransomware oder Spyware. In diesem Artikel wird erklärt, was Smart App Control ist, wie es funktioniert und wie man es in Windows 11 ein- oder ausschaltet. Was ist Smart App Control in Windows 11? Smart App Control (SAC) ist eine neue Sicherheitsfunktion, die mit dem Windows 1122H2-Update eingeführt wurde. Es arbeitet mit Microsoft Defender oder Antivirensoftware von Drittanbietern zusammen, um potenziell unnötige Apps zu blockieren, die Ihr Gerät verlangsamen, unerwartete Werbung anzeigen oder andere unerwartete Aktionen ausführen können. Intelligente Anwendung

Die herumfliegenden Gesichtszüge, das Öffnen des Mundes, das Starren und das Hochziehen der Augenbrauen können von der KI perfekt nachgeahmt werden, sodass Videobetrug nicht verhindert werden kann

Dec 14, 2023 pm 11:30 PM

Die herumfliegenden Gesichtszüge, das Öffnen des Mundes, das Starren und das Hochziehen der Augenbrauen können von der KI perfekt nachgeahmt werden, sodass Videobetrug nicht verhindert werden kann

Dec 14, 2023 pm 11:30 PM

Mit solch einer mächtigen KI-Imitationsfähigkeit ist es wirklich unmöglich, dies zu verhindern. Hat die Entwicklung der KI mittlerweile dieses Niveau erreicht? Ihr vorderer Fuß lässt Ihre Gesichtszüge fliegen, und auf Ihrem hinteren Fuß wird genau der gleiche Ausdruck reproduziert. Starren, Augenbrauen hochziehen, schmollen, egal wie übertrieben der Ausdruck ist, alles wird perfekt nachgeahmt. Erhöhen Sie den Schwierigkeitsgrad, heben Sie die Augenbrauen höher, öffnen Sie die Augen weiter, und sogar die Mundform ist schief und der Ausdruck des Avatars kann perfekt reproduziert werden. Wenn Sie die Parameter auf der linken Seite anpassen, ändert der virtuelle Avatar auf der rechten Seite auch seine Bewegungen entsprechend, um eine Nahaufnahme von Mund und Augen zu erhalten. Man kann nicht sagen, dass die Nachahmung genau gleich ist, aber der Ausdruck ist genau derselbe gleich (ganz rechts). Die Forschung stammt von Institutionen wie der Technischen Universität München, die GaussianAvatars vorschlägt

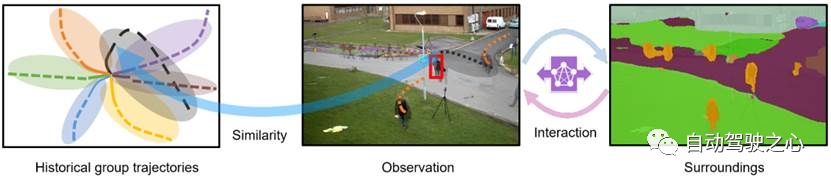

MotionLM: Sprachmodellierungstechnologie für die Bewegungsvorhersage mit mehreren Agenten

Oct 13, 2023 pm 12:09 PM

MotionLM: Sprachmodellierungstechnologie für die Bewegungsvorhersage mit mehreren Agenten

Oct 13, 2023 pm 12:09 PM

Dieser Artikel wird mit Genehmigung des öffentlichen Kontos von Autonomous Driving Heart nachgedruckt. Bitte wenden Sie sich für den Nachdruck an die Quelle. Originaltitel: MotionLM: Multi-Agent Motion Forecasting as Language Modeling Papierlink: https://arxiv.org/pdf/2309.16534.pdf Autorenzugehörigkeit: Waymo Konferenz: ICCV2023 Papieridee: Für die Sicherheitsplanung autonomer Fahrzeuge das zukünftige Verhalten zuverlässig vorhersagen der Straßenverkehrsbeamten ist von entscheidender Bedeutung. Diese Studie stellt kontinuierliche Trajektorien als Sequenzen diskreter Bewegungstokens dar und behandelt die Bewegungsvorhersage mit mehreren Agenten als eine Sprachmodellierungsaufgabe. Das von uns vorgeschlagene Modell MotionLM hat die folgenden Vorteile: Erstens

Wussten Sie, dass es bei Programmierern in ein paar Jahren einen Niedergang geben wird?

Nov 08, 2023 am 11:17 AM

Wussten Sie, dass es bei Programmierern in ein paar Jahren einen Niedergang geben wird?

Nov 08, 2023 am 11:17 AM

Die Zeitschrift „ComputerWorld“ schrieb einmal in einem Artikel, dass „die Programmierung bis 1960 verschwinden wird“, weil IBM eine neue Sprache FORTRAN entwickelt hat, die es Ingenieuren ermöglicht, die benötigten mathematischen Formeln zu schreiben und sie dann dem Computer zu übermitteln, damit das Programmieren endet. Ein paar Jahre später hörten wir ein neues Sprichwort: Jeder Unternehmer kann Geschäftsbegriffe verwenden, um seine Probleme zu beschreiben und dem Computer zu sagen, was er tun soll. Mit dieser Programmiersprache namens COBOL brauchen Unternehmen keine Programmierer mehr. Später soll IBM eine neue Programmiersprache namens RPG entwickelt haben, mit der Mitarbeiter Formulare ausfüllen und Berichte erstellen können, sodass die meisten Programmieranforderungen des Unternehmens damit erfüllt werden können.

Der intelligente universelle humanoide Roboter GR-1 Fourier steht kurz vor dem Vorverkaufsstart!

Sep 27, 2023 pm 08:41 PM

Der intelligente universelle humanoide Roboter GR-1 Fourier steht kurz vor dem Vorverkaufsstart!

Sep 27, 2023 pm 08:41 PM

Der humanoide Roboter, der 1,65 Meter groß ist, 55 Kilogramm wiegt und über 44 Freiheitsgrade in seinem Körper verfügt, kann schnell gehen, Hindernissen schnell ausweichen, Steigungen stetig hinauf und hinunter klettern und Stößen und Störungen standhalten. Jetzt können Sie ihn mit nach Hause nehmen ! Der universelle humanoide Roboter GR-1 von Fourier Intelligence hat mit dem Vorverkauf begonnen. Der universelle humanoide Roboter Fourier GR-1 ist jetzt zum Vorverkauf geöffnet. GR-1 verfügt über eine hochgradig bionische Rumpfkonfiguration und anthropomorphe Bewegungssteuerung. Er verfügt über 44 Freiheitsgrade im gesamten Körper. Er verfügt über die Fähigkeit zu gehen, Hindernissen auszuweichen, über Hindernisse zu klettern, Abhänge zu überwinden, Störungen zu widerstehen und sich anzupassen Es handelt sich um ein allgemeines künstliches Intelligenzsystem. Offizielle Vorverkaufsseite der Website: www.fftai.cn/order#FourierGR-1# Fourier Intelligence muss neu geschrieben werden.

Ein Artikel über die Anwendung der SLAM-Technologie beim autonomen Fahren

Apr 09, 2023 pm 01:11 PM

Ein Artikel über die Anwendung der SLAM-Technologie beim autonomen Fahren

Apr 09, 2023 pm 01:11 PM

Die Positionierung nimmt beim autonomen Fahren eine unersetzliche Stellung ein und es gibt vielversprechende Entwicklungen für die Zukunft. Derzeit basiert die Positionierung beim autonomen Fahren auf RTK und hochpräzisen Karten, was die Implementierung des autonomen Fahrens mit hohen Kosten und Schwierigkeiten verbunden macht. Stellen Sie sich vor, dass Menschen beim Fahren ihre eigene globale hochpräzise Positionierung und die detaillierte Umgebung nicht kennen müssen. Es reicht aus, einen globalen Navigationspfad zu haben und die Position des Fahrzeugs auf dem Pfad anzupassen SLAM-Schlüsseltechnologien. Was ist SLAMSLAM (Simultaneous Localization and Mapping), auch bekannt als CML (Concurrent Mapping and Localiza).

Was sind die effektiven Methoden und gängigen Basismethoden für die Vorhersage der Fußgängerbahn? Teilen der besten Konferenzbeiträge!

Oct 17, 2023 am 11:13 AM

Was sind die effektiven Methoden und gängigen Basismethoden für die Vorhersage der Fußgängerbahn? Teilen der besten Konferenzbeiträge!

Oct 17, 2023 am 11:13 AM

Die Flugbahnvorhersage stand in den letzten zwei Jahren im Rampenlicht, aber das meiste davon konzentriert sich auf die Richtung der Fahrzeugflugbahnvorhersage. Heute wird Autonomous Driving Heart den Algorithmus für die Flugbahnvorhersage von Fußgängern auf NeurIPS – SHENet teilen. Menschliche Bewegungsmuster unterliegen in der Regel bis zu einem gewissen Grad begrenzten Regeln. Basierend auf dieser Annahme sagt SHENet die zukünftige Flugbahn einer Person voraus, indem es implizite Szenenregeln lernt. Der Artikel wurde von Autonomous Driving Heart als Original zertifiziert! Nach persönlichem Verständnis des Autors ist die Vorhersage der zukünftigen Flugbahn einer Person aufgrund der Zufälligkeit und Subjektivität menschlicher Bewegungen derzeit immer noch ein herausforderndes Problem. Allerdings variieren menschliche Bewegungsmuster in eingeschränkten Szenen häufig aufgrund von Szenenbeschränkungen (z. B. Grundrissen, Straßen und Hindernissen) und der Interaktivität von Mensch zu Mensch oder Mensch zu Objekt.

Huawei wird das Xuanji-Sensorsystem im Bereich Smart Wearables auf den Markt bringen, das den emotionalen Zustand des Benutzers anhand der Herzfrequenz beurteilen kann

Aug 29, 2024 pm 03:30 PM

Huawei wird das Xuanji-Sensorsystem im Bereich Smart Wearables auf den Markt bringen, das den emotionalen Zustand des Benutzers anhand der Herzfrequenz beurteilen kann

Aug 29, 2024 pm 03:30 PM

Kürzlich gab Huawei bekannt, dass es im September ein neues intelligentes tragbares Produkt mit dem Xuanji-Sensorsystem auf den Markt bringen wird, bei dem es sich voraussichtlich um die neueste Smartwatch von Huawei handeln wird. Dieses neue Produkt wird fortschrittliche Funktionen zur Überwachung der emotionalen Gesundheit integrieren. Das Xuanji Perception System bietet Benutzern eine umfassende Gesundheitsbewertung mit seinen sechs Merkmalen – Genauigkeit, Vollständigkeit, Geschwindigkeit, Flexibilität, Offenheit und Skalierbarkeit. Das System nutzt ein Super-Sensing-Modul und optimiert die Mehrkanal-Optikpfad-Architekturtechnologie, wodurch die Überwachungsgenauigkeit grundlegender Indikatoren wie Herzfrequenz, Blutsauerstoff und Atemfrequenz erheblich verbessert wird. Darüber hinaus hat das Xuanji Sensing System auch die Erforschung emotionaler Zustände auf Basis von Herzfrequenzdaten erweitert. Es beschränkt sich nicht nur auf physiologische Indikatoren, sondern kann auch den emotionalen Zustand und das Stressniveau des Benutzers bewerten. Es unterstützt die Überwachung von mehr als 60 Sportarten Gesundheitsindikatoren, die kardiovaskuläre, respiratorische, neurologische, endokrine,