Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Studie zeigt, dass große Sprachmodelle Probleme mit dem logischen Denken haben

Studie zeigt, dass große Sprachmodelle Probleme mit dem logischen Denken haben

Studie zeigt, dass große Sprachmodelle Probleme mit dem logischen Denken haben

Übersetzer |. Li Rui

Rezensent |.Bevor Chatbots mit Empfindungsvermögen zu einem heißen Thema wurden, hatten große Sprachmodelle (LLM) bereits für mehr Aufregung und Besorgnis gesorgt. In den letzten Jahren haben Large Language Models (LLMs), Deep-Learning-Modelle, die auf große Textmengen trainiert werden, bei mehreren Benchmarks zur Messung der Sprachverständnisfähigkeit gute Ergebnisse erzielt.

Große Sprachmodelle wie GPT-3 und LaMDA schaffen es, die Kohärenz über längere Texte hinweg aufrechtzuerhalten. Sie scheinen über verschiedene Themen Bescheid zu wissen und bleiben auch bei längeren Gesprächen konsistent. Große Sprachmodelle (LLMs) sind so überzeugend geworden, dass manche Menschen sie mit Persönlichkeit und höheren Formen der Intelligenz assoziieren.

Aber können Large Language Models (LLMs) logisches Denken wie Menschen ausführen? Laut einem von UCLA-Wissenschaftlern veröffentlichten Forschungsbericht lernt Transformers, eine Deep-Learning-Architektur, die in großen Sprachmodellen (LLMs) verwendet wird, nicht, Denkfähigkeiten zu simulieren. Stattdessen haben Computer clevere Wege gefunden, die statistischen Eigenschaften von Denkproblemen zu erlernen.

Die Forscher testeten die derzeit beliebte Transformer-Architektur BERT in einem begrenzten Problemraum. Ihre Ergebnisse zeigen, dass BERT genau auf Inferenzprobleme an Beispielen innerhalb einer Verteilung im Trainingsraum reagieren kann, jedoch nicht auf Beispiele in anderen Verteilungen verallgemeinern kann, die auf demselben Problemraum basieren.

Und diese Tests verdeutlichen einige der Mängel tiefer neuronaler Netze und der Benchmarks, die zu ihrer Bewertung verwendet werden.

1. Wie misst man logisches Denken in der künstlichen Intelligenz?

Es gibt mehrere Benchmarks für Systeme der künstlichen Intelligenz, die auf Probleme bei der Verarbeitung und dem Verstehen natürlicher Sprache abzielen, wie GLUE, SuperGLUE, SNLI und SqUAD. Da Transformer immer größer wurde und auf größeren Datensätzen trainiert wurde, konnte Transformer diese Benchmarks schrittweise verbessern.

Es ist erwähnenswert, dass die Leistung von KI-Systemen bei diesen Benchmarks oft mit der menschlichen Intelligenz verglichen wird. Die menschliche Leistung bei diesen Benchmarks hängt eng mit gesundem Menschenverstand und logischen Denkfähigkeiten zusammen. Es ist jedoch unklar, ob sich große Sprachmodelle verbessern, weil sie die Fähigkeit zum logischen Denken erlangen oder weil sie großen Textmengen ausgesetzt sind.

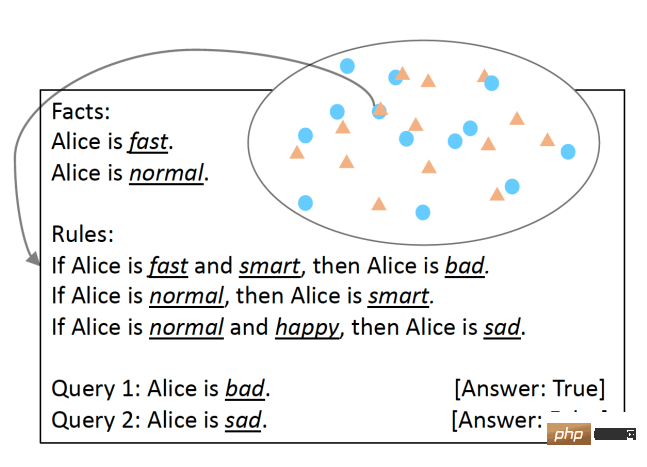

Um dies zu testen, haben UCLA-Forscher SimpleLogic entwickelt, eine Klasse von Fragen zum logischen Denken, die auf Aussagenlogik basieren. Um sicherzustellen, dass die Argumentationsfähigkeiten des Sprachmodells gründlich getestet wurden, beseitigten die Forscher Sprachunterschiede durch die Verwendung von Vorlagen-Sprachstrukturen. SimpleLogic-Probleme bestehen aus einer Reihe von Fakten, Regeln, Abfragen und Bezeichnungen. Fakten sind Prädikate, von denen man weiß, dass sie „wahr“ sind. Regeln sind Bedingungen, die als Begriffe definiert werden. Eine Abfrage ist eine Frage, auf die ein maschinelles Lernmodell antworten muss. Die Bezeichnung ist die Antwort auf die Abfrage, also „wahr“ oder „falsch“. SimpleLogic-Fragen werden in fortlaufende Textzeichenfolgen kompiliert, die die Signale und Trennzeichen enthalten, die das Sprachmodell während des Trainings und der Inferenz erwartet.

Fragen im SimpleLogic-Format Eines der Merkmale von SimpleLogic ist, dass seine Fragen in sich geschlossen sind und keine Vorkenntnisse erfordern. Dies ist besonders wichtig, da, wie viele Wissenschaftler sagen, Menschen beim Sprechen das gemeinsame Wissen ignorieren. Aus diesem Grund tappen Sprachmodelle oft in eine Falle, wenn Fragen zu grundlegendem Weltwissen gestellt werden, das jeder kennt. Im Gegensatz dazu bietet SimpleLogic Entwicklern alles, was sie zur Lösung ihrer Probleme benötigen. Daher sollte jeder Entwickler, der sich mit einem Problem befasst, das durch das SimpleLogic-Format entsteht, in der Lage sein, dessen Regeln abzuleiten und unabhängig von seinem Hintergrundwissen mit neuen Beispielen umgehen zu können.

Fragen im SimpleLogic-Format Eines der Merkmale von SimpleLogic ist, dass seine Fragen in sich geschlossen sind und keine Vorkenntnisse erfordern. Dies ist besonders wichtig, da, wie viele Wissenschaftler sagen, Menschen beim Sprechen das gemeinsame Wissen ignorieren. Aus diesem Grund tappen Sprachmodelle oft in eine Falle, wenn Fragen zu grundlegendem Weltwissen gestellt werden, das jeder kennt. Im Gegensatz dazu bietet SimpleLogic Entwicklern alles, was sie zur Lösung ihrer Probleme benötigen. Daher sollte jeder Entwickler, der sich mit einem Problem befasst, das durch das SimpleLogic-Format entsteht, in der Lage sein, dessen Regeln abzuleiten und unabhängig von seinem Hintergrundwissen mit neuen Beispielen umgehen zu können.

2. Statistische Charakterisierung und logische Inferenz

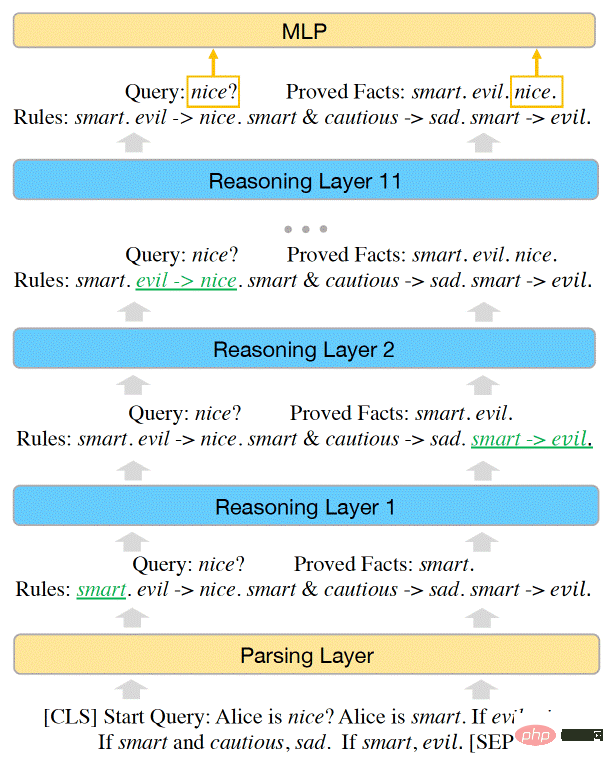

Forscher haben gezeigt, dass der Problemraum in SimpleLogic durch eine Inferenzfunktion dargestellt werden kann. Die Forscher zeigten außerdem, dass BERT leistungsstark genug ist, um alle Probleme in SimpleLogic zu lösen, und dass sie die Parameter des maschinellen Lernmodells manuell anpassen können, um die Inferenzfunktion darzustellen.

Als sie BERT jedoch anhand des SimpleLogic-Beispieldatensatzes trainierten, war das Modell nicht in der Lage, die Inferenzfunktion selbst zu erlernen. Modelle für maschinelles Lernen schaffen es, eine nahezu perfekte Genauigkeit bei der Datenverteilung zu erreichen. Es lässt sich jedoch nicht auf andere Distributionen innerhalb desselben Problemraums verallgemeinern. Dies ist der Fall, obwohl der Trainingsdatensatz den gesamten Problemraum abdeckt und alle Verteilungen aus derselben Inferenzfunktion stammen.

Die Kapazität des BERT Transformer-Modells reicht aus, um die Inferenzfähigkeiten von SimpleLogic darzustellen

Die Kapazität des BERT Transformer-Modells reicht aus, um die Inferenzfähigkeiten von SimpleLogic darzustellen

(Hinweis: Dies unterscheidet sich von der Out-of-Distribution-Generalisierungsherausforderung, die auf Open-Space-Probleme anwendbar ist. Wenn das Modell nicht verallgemeinern kann zu OOD-Daten, wenn die Daten bei der Verarbeitung außerhalb des Verteilungsbereichs ihres Trainingssatzes liegen, wird ihre Leistung erheblich sinken)

Die Forscher schrieben: „Nach weiteren Untersuchungen liefern wir eine Erklärung für dieses Paradoxon: Ein Modell, das nur bei Verteilungstestbeispielen eine hohe Genauigkeit erreicht, hat nicht gelernt, logische Schlussfolgerungen zu ziehen und statistische Merkmale zu verwenden.“ Vorhersagen treffen, anstatt korrekte Inferenzfunktionen zu modellieren.“

Dieser Befund verdeutlicht eine wichtige Herausforderung bei der Verwendung von Deep Learning für Sprachaufgaben. Neuronale Netze sind sehr gut darin, statistische Merkmale zu entdecken und anzupassen. In manchen Anwendungen kann dies sehr nützlich sein. Bei der Sentiment-Analyse gibt es beispielsweise starke Korrelationen zwischen bestimmten Wörtern und Sentiment-Kategorien.

Bei Aufgaben zum logischen Denken sollte das Modell jedoch versuchen, die zugrunde liegenden Argumentationsmerkmale zu finden und zu lernen, selbst wenn statistische Merkmale vorhanden sind.

„Vorsicht ist geboten, wenn wir versuchen, neuronale Modelle durchgängig zu trainieren, um Aufgaben der Verarbeitung natürlicher Sprache (NLP) zu lösen, die sowohl logisches Denken als auch Vorkenntnisse erfordern und sprachliche Unterschiede darstellen“, schreiben die Forscher Die Herausforderungen, die SimpleLogic mit sich bringt, werden in der realen Welt noch gravierender, da die riesigen Informationsmengen, die für große Sprachmodelle (LLMs) erforderlich sind, einfach nicht in den Daten enthalten sind.

Die Forscher beobachteten, dass sich die Leistung des Sprachmodells bei anderen Verteilungen desselben Problemraums verbesserte, wenn sie ein statistisches Merkmal aus dem Trainingsdatensatz entfernten. Das Problem besteht jedoch darin, dass das Entdecken und Entfernen mehrerer statistischer Merkmale leichter gesagt als getan ist. Wie die Forscher in ihrer Arbeit betonen, „können solche statistischen Merkmale zahlreich und äußerst komplex sein, was es schwierig macht, sie aus den Trainingsdaten zu entfernen.“ Wenn das Modell zunimmt, verschwindet das Problem des logischen Denkens nicht. Es ist einfach in riesigen Architekturen und sehr großen Trainingskorpora versteckt. Große Sprachmodelle (LLM) können Fakten sehr gut beschreiben und Sätze zusammenfügen, aber im Hinblick auf das logische Denken nutzen sie immer noch statistische Merkmale zum Denken, was keine solide Grundlage darstellt. Darüber hinaus gibt es keinen Hinweis darauf, dass durch das Hinzufügen von Ebenen, Parametern und Aufmerksamkeitsköpfen zu Transformers die Lücke im logischen Denken geschlossen wird.

Dieser Artikel steht im Einklang mit anderen Arbeiten, die die Grenzen neuronaler Netze beim Erlernen logischer Regeln zeigen, wie zum Beispiel beim Spiel des Lebens oder beim abstrakten Denken aus visuellen Daten. Der Artikel beleuchtet eine der größten Herausforderungen, denen sich aktuelle Sprachmodelle gegenübersehen. Wie UCLA-Forscher betonen: „Wenn ein Modell einerseits trainiert wird, eine Aufgabe aus Daten zu lernen, tendiert es immer dazu, statistische Muster zu lernen, die in den Inferenzbeispielen inhärent vorhanden sind. Logische Regeln andererseits jedoch nie Verlassen Sie sich auf statistische Muster, um Schlussfolgerungen zu ziehen. Da es schwierig ist, einen logischen Schlussfolgerungsdatensatz zu erstellen, der keine statistischen Merkmale enthält, ist es schwierig, Schlussfolgerungen aus Daten zu ziehen. Sprachmodelle-logisches-Argumentieren/

Das obige ist der detaillierte Inhalt vonStudie zeigt, dass große Sprachmodelle Probleme mit dem logischen Denken haben. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1371

1371

52

52

Bytedance Cutting führt SVIP-Supermitgliedschaft ein: 499 Yuan für ein fortlaufendes Jahresabonnement, das eine Vielzahl von KI-Funktionen bietet

Jun 28, 2024 am 03:51 AM

Bytedance Cutting führt SVIP-Supermitgliedschaft ein: 499 Yuan für ein fortlaufendes Jahresabonnement, das eine Vielzahl von KI-Funktionen bietet

Jun 28, 2024 am 03:51 AM

Diese Seite berichtete am 27. Juni, dass Jianying eine von FaceMeng Technology, einer Tochtergesellschaft von ByteDance, entwickelte Videobearbeitungssoftware ist, die auf der Douyin-Plattform basiert und grundsätzlich kurze Videoinhalte für Benutzer der Plattform produziert Windows, MacOS und andere Betriebssysteme. Jianying kündigte offiziell die Aktualisierung seines Mitgliedschaftssystems an und führte ein neues SVIP ein, das eine Vielzahl von KI-Schwarztechnologien umfasst, wie z. B. intelligente Übersetzung, intelligente Hervorhebung, intelligente Verpackung, digitale menschliche Synthese usw. Preislich beträgt die monatliche Gebühr für das Clipping von SVIP 79 Yuan, die Jahresgebühr 599 Yuan (Hinweis auf dieser Website: entspricht 49,9 Yuan pro Monat), das fortlaufende Monatsabonnement beträgt 59 Yuan pro Monat und das fortlaufende Jahresabonnement beträgt 499 Yuan pro Jahr (entspricht 41,6 Yuan pro Monat). Darüber hinaus erklärte der Cut-Beamte auch, dass diejenigen, die den ursprünglichen VIP abonniert haben, das Benutzererlebnis verbessern sollen

Das intelligente Fahrsystem Qiankun ADS3.0 von Huawei wird im August auf den Markt kommen und erstmals auf dem Xiangjie S9 eingeführt

Jul 30, 2024 pm 02:17 PM

Das intelligente Fahrsystem Qiankun ADS3.0 von Huawei wird im August auf den Markt kommen und erstmals auf dem Xiangjie S9 eingeführt

Jul 30, 2024 pm 02:17 PM

Am 29. Juli nahm Yu Chengdong, Huawei-Geschäftsführer, Vorsitzender von Terminal BG und Vorsitzender von Smart Car Solutions BU, an der Übergabezeremonie des 400.000sten Neuwagens von AITO Wenjie teil, hielt eine Rede und kündigte an, dass die Modelle der Wenjie-Serie dies tun werden Dieses Jahr auf den Markt kommen Im August wurde die Huawei Qiankun ADS 3.0-Version auf den Markt gebracht und es ist geplant, die Upgrades sukzessive von August bis September voranzutreiben. Das Xiangjie S9, das am 6. August auf den Markt kommt, wird erstmals mit dem intelligenten Fahrsystem ADS3.0 von Huawei ausgestattet sein. Mit Hilfe von Lidar wird Huawei Qiankun ADS3.0 seine intelligenten Fahrfähigkeiten erheblich verbessern, über integrierte End-to-End-Funktionen verfügen und eine neue End-to-End-Architektur von GOD (allgemeine Hinderniserkennung)/PDP (prädiktiv) einführen Entscheidungsfindung und Kontrolle), Bereitstellung der NCA-Funktion für intelligentes Fahren von Parkplatz zu Parkplatz und Aktualisierung von CAS3.0

Kontexterweiterter KI-Codierungsassistent mit Rag und Sem-Rag

Jun 10, 2024 am 11:08 AM

Kontexterweiterter KI-Codierungsassistent mit Rag und Sem-Rag

Jun 10, 2024 am 11:08 AM

Verbessern Sie die Produktivität, Effizienz und Genauigkeit der Entwickler, indem Sie eine abrufgestützte Generierung und ein semantisches Gedächtnis in KI-Codierungsassistenten integrieren. Übersetzt aus EnhancingAICodingAssistantswithContextUsingRAGandSEM-RAG, Autor JanakiramMSV. Obwohl grundlegende KI-Programmierassistenten natürlich hilfreich sind, können sie oft nicht die relevantesten und korrektesten Codevorschläge liefern, da sie auf einem allgemeinen Verständnis der Softwaresprache und den gängigsten Mustern beim Schreiben von Software basieren. Der von diesen Coding-Assistenten generierte Code eignet sich zur Lösung der von ihnen zu lösenden Probleme, entspricht jedoch häufig nicht den Coding-Standards, -Konventionen und -Stilen der einzelnen Teams. Dabei entstehen häufig Vorschläge, die geändert oder verfeinert werden müssen, damit der Code in die Anwendung übernommen wird

Sieben coole technische Interviewfragen für GenAI und LLM

Jun 07, 2024 am 10:06 AM

Sieben coole technische Interviewfragen für GenAI und LLM

Jun 07, 2024 am 10:06 AM

Um mehr über AIGC zu erfahren, besuchen Sie bitte: 51CTOAI.x Community https://www.51cto.com/aigc/Translator|Jingyan Reviewer|Chonglou unterscheidet sich von der traditionellen Fragendatenbank, die überall im Internet zu sehen ist erfordert einen Blick über den Tellerrand hinaus. Large Language Models (LLMs) gewinnen in den Bereichen Datenwissenschaft, generative künstliche Intelligenz (GenAI) und künstliche Intelligenz zunehmend an Bedeutung. Diese komplexen Algorithmen verbessern die menschlichen Fähigkeiten, treiben Effizienz und Innovation in vielen Branchen voran und werden zum Schlüssel für Unternehmen, um wettbewerbsfähig zu bleiben. LLM hat ein breites Anwendungsspektrum und kann in Bereichen wie der Verarbeitung natürlicher Sprache, der Textgenerierung, der Spracherkennung und Empfehlungssystemen eingesetzt werden. Durch das Lernen aus großen Datenmengen ist LLM in der Lage, Text zu generieren

Kann LLM durch Feinabstimmung wirklich neue Dinge lernen: Die Einführung neuen Wissens kann dazu führen, dass das Modell mehr Halluzinationen hervorruft

Jun 11, 2024 pm 03:57 PM

Kann LLM durch Feinabstimmung wirklich neue Dinge lernen: Die Einführung neuen Wissens kann dazu führen, dass das Modell mehr Halluzinationen hervorruft

Jun 11, 2024 pm 03:57 PM

Large Language Models (LLMs) werden auf riesigen Textdatenbanken trainiert und erwerben dort große Mengen an realem Wissen. Dieses Wissen wird in ihre Parameter eingebettet und kann dann bei Bedarf genutzt werden. Das Wissen über diese Modelle wird am Ende der Ausbildung „verdinglicht“. Am Ende des Vortrainings hört das Modell tatsächlich auf zu lernen. Richten Sie das Modell aus oder verfeinern Sie es, um zu erfahren, wie Sie dieses Wissen nutzen und natürlicher auf Benutzerfragen reagieren können. Aber manchmal reicht Modellwissen nicht aus, und obwohl das Modell über RAG auf externe Inhalte zugreifen kann, wird es als vorteilhaft angesehen, das Modell durch Feinabstimmung an neue Domänen anzupassen. Diese Feinabstimmung erfolgt mithilfe von Eingaben menschlicher Annotatoren oder anderer LLM-Kreationen, wobei das Modell auf zusätzliches Wissen aus der realen Welt trifft und dieses integriert

Um ein neues wissenschaftliches und komplexes Frage-Antwort-Benchmark- und Bewertungssystem für große Modelle bereitzustellen, haben UNSW, Argonne, die University of Chicago und andere Institutionen gemeinsam das SciQAG-Framework eingeführt

Jul 25, 2024 am 06:42 AM

Um ein neues wissenschaftliches und komplexes Frage-Antwort-Benchmark- und Bewertungssystem für große Modelle bereitzustellen, haben UNSW, Argonne, die University of Chicago und andere Institutionen gemeinsam das SciQAG-Framework eingeführt

Jul 25, 2024 am 06:42 AM

Herausgeber | Der Frage-Antwort-Datensatz (QA) von ScienceAI spielt eine entscheidende Rolle bei der Förderung der Forschung zur Verarbeitung natürlicher Sprache (NLP). Hochwertige QS-Datensätze können nicht nur zur Feinabstimmung von Modellen verwendet werden, sondern auch effektiv die Fähigkeiten großer Sprachmodelle (LLMs) bewerten, insbesondere die Fähigkeit, wissenschaftliche Erkenntnisse zu verstehen und zu begründen. Obwohl es derzeit viele wissenschaftliche QS-Datensätze aus den Bereichen Medizin, Chemie, Biologie und anderen Bereichen gibt, weisen diese Datensätze immer noch einige Mängel auf. Erstens ist das Datenformular relativ einfach, die meisten davon sind Multiple-Choice-Fragen. Sie sind leicht auszuwerten, schränken jedoch den Antwortauswahlbereich des Modells ein und können die Fähigkeit des Modells zur Beantwortung wissenschaftlicher Fragen nicht vollständig testen. Im Gegensatz dazu offene Fragen und Antworten

Fünf Schulen des maschinellen Lernens, die Sie nicht kennen

Jun 05, 2024 pm 08:51 PM

Fünf Schulen des maschinellen Lernens, die Sie nicht kennen

Jun 05, 2024 pm 08:51 PM

Maschinelles Lernen ist ein wichtiger Zweig der künstlichen Intelligenz, der Computern die Möglichkeit gibt, aus Daten zu lernen und ihre Fähigkeiten zu verbessern, ohne explizit programmiert zu werden. Maschinelles Lernen hat ein breites Anwendungsspektrum in verschiedenen Bereichen, von der Bilderkennung und der Verarbeitung natürlicher Sprache bis hin zu Empfehlungssystemen und Betrugserkennung, und es verändert unsere Lebensweise. Im Bereich des maschinellen Lernens gibt es viele verschiedene Methoden und Theorien, von denen die fünf einflussreichsten Methoden als „Fünf Schulen des maschinellen Lernens“ bezeichnet werden. Die fünf Hauptschulen sind die symbolische Schule, die konnektionistische Schule, die evolutionäre Schule, die Bayes'sche Schule und die Analogieschule. 1. Der Symbolismus, auch Symbolismus genannt, betont die Verwendung von Symbolen zum logischen Denken und zum Ausdruck von Wissen. Diese Denkrichtung glaubt, dass Lernen ein Prozess der umgekehrten Schlussfolgerung durch das Vorhandene ist

SOTA Performance, eine multimodale KI-Methode zur Vorhersage der Protein-Ligand-Affinität in Xiamen, kombiniert erstmals molekulare Oberflächeninformationen

Jul 17, 2024 pm 06:37 PM

SOTA Performance, eine multimodale KI-Methode zur Vorhersage der Protein-Ligand-Affinität in Xiamen, kombiniert erstmals molekulare Oberflächeninformationen

Jul 17, 2024 pm 06:37 PM

Herausgeber |. KX Im Bereich der Arzneimittelforschung und -entwicklung ist die genaue und effektive Vorhersage der Bindungsaffinität von Proteinen und Liganden für das Arzneimittelscreening und die Arzneimitteloptimierung von entscheidender Bedeutung. Aktuelle Studien berücksichtigen jedoch nicht die wichtige Rolle molekularer Oberflächeninformationen bei Protein-Ligand-Wechselwirkungen. Auf dieser Grundlage schlugen Forscher der Universität Xiamen ein neuartiges Framework zur multimodalen Merkmalsextraktion (MFE) vor, das erstmals Informationen über Proteinoberfläche, 3D-Struktur und -Sequenz kombiniert und einen Kreuzaufmerksamkeitsmechanismus verwendet, um verschiedene Modalitäten zu vergleichen Ausrichtung. Experimentelle Ergebnisse zeigen, dass diese Methode bei der Vorhersage von Protein-Ligand-Bindungsaffinitäten Spitzenleistungen erbringt. Darüber hinaus belegen Ablationsstudien die Wirksamkeit und Notwendigkeit der Proteinoberflächeninformation und der multimodalen Merkmalsausrichtung innerhalb dieses Rahmens. Verwandte Forschungen beginnen mit „S