Werden Schulhausaufgaben mit der Einführung von Sprachgenerierungsmodellen nutzlos? Kürzlich lösten New Yorker Bildungsbeamte Kontroversen aus, als sie ein Verbot für Schüler ankündigten, ChatGPT an öffentlichen Schulen zu nutzen.

Der vom Sprachmodell automatisch generierte Inhalt „referenziert“ vorhandene Werke und die Ausgabegeschwindigkeit ist nahezu unbegrenzt. Die Bedenken der Menschen darüber haben sich auf die akademische KI-Community selbst ausgeweitet Auf Lernkonferenzen, die ebenfalls kürzlich angekündigt wurden, sind Beiträge mit von ChatGPT und anderen ähnlichen Systemen generierten Inhalten verboten, um „unbeabsichtigte Folgen“ zu vermeiden.

Für eine solche Situation hat OpenAI, der Urheber von ChatGPT, angekündigt, dass es intensiv an der Entwicklung von „Abhilfemaßnahmen“ arbeitet, um Menschen dabei zu helfen, von KI automatisch generierten Text zu erkennen.

„Wir nutzen ChatGPT als Vorschautechnologie für neue Forschungen in der Hoffnung, aus realen Anwendungen zu lernen. Wir glauben, dass dies ein entscheidender Teil der Entwicklung und Bereitstellung leistungsstarker, sicherer KI-Systeme ist. Wir werden dies auch weiterhin tun.“ „Wir berücksichtigen Feedback und gewonnene Erkenntnisse“, sagte ein Unternehmenssprecher. „OpenAI fordert seit jeher Transparenz bei der Verwendung von KI-generiertem Text. Unsere Nutzungsbedingungen machen die Benutzer in erster Linie verantwortlich, wenn sie unsere API und kreativen Tools für die Zielgruppen verwenden, für die sie bestimmt sind. Wir freuen uns darauf, mit Pädagogen zusammenzuarbeiten, um effektive Lösungen zu entwickeln Lehrer, Schüler und andere finden Möglichkeiten, von KI zu profitieren. Schulen werden in der Lage sein, die durch künstliche Intelligenz erzeugten Arbeiten effektiver einzuschränken, und wenn sich die Einstellung der Menschen ändert und sie erwarten, dass diese Tools den Schülern helfen, können wir vielleicht auch nach und nach den Einsatz von KI zur Unterstützung akzeptieren und die Effizienz von Arbeit und Lernen verbessern.

Jetzt scheint es, dass noch ein langer Weg vor uns liegt. Während KI-generierte Texte auf wissenschaftlichen Konferenzen und in den Nachrichten über Schulen, die Maschinen das Betrügen von Aufsätzen verbieten, beeindruckend aussehen mögen, müssen Sie wissen, dass es ihnen im Vergleich zu echten menschlichen Texten oft an echtem Verständnis und Logik mangelt.

Während Tools wie GPT-3 oder ChatGPT Menschen mit erschreckend detaillierten Antworten überraschen, gibt es auch nüchterne Experten, die sagen, dies beweise, dass Modelle in der Lage seien, Wissen zu kodieren, aber wenn sie es nicht schaffen, die Dinge richtig zu machen, werden manchmal die Antworten gegeben sind oft unverschämt. Gary Smith, Wirtschaftsprofessor am Pomona College, erinnert uns daran, uns nicht täuschen zu lassen.

In einer Kolumne zeigte Gary Smith mehrere Beispiele für die Unfähigkeit von GPT-3, effektiv zu argumentieren und Fragen zu beantworten: „Wenn Sie versuchen, GPT-3 zu verwenden, kann Ihre erste Reaktion überraschend sein – es scheint, dass Sie ein echtes Gespräch mit führen.“ ein sehr kluger Mensch, aber wenn man genauer hinschaut, stellt man schnell fest, dass GPT-3 zwar Wörter auf überzeugende Weise aneinanderreihen kann, aber nicht weiß, was sie bedeuten.“ Herbst erfordert kein Verständnis der Bedeutung dieser beiden Wörter. Allein durch statistische Berechnungen kann die KI denken, dass diese Wörter oft zusammenpassen. Daher macht es GPT-3 leicht, völlig falsche, aber willkürliche Behauptungen aufzustellen OpenAI veröffentlichte im November 2022 ChatGPT, ein neueres Modell, das GPT-3 verbessert. Dennoch weist es immer noch die gleichen Probleme auf wie alle existierenden Sprachmodelle.

Wie nutzt man KI, um KI-generierten Text zu erkennen?

Früher waren die von KI generierten Textinhalte noch „auf den ersten Blick gefälscht“, aber seit dem Aufkommen von ChatGPT ist diese Art der Diskriminierung immer schwieriger geworden.Im Bildungsbereich dreht sich die Debatte über ChatGPT um die Möglichkeit des Betrugs. Suchen Sie bei Google nach „ChatGPT-Aufsatzschreiben“ und Sie werden zahlreiche Beispiele von Pädagogen, Journalisten und Studenten finden, die ChatGPT für Hausaufgaben und standardisierte Aufsatztests nutzen.

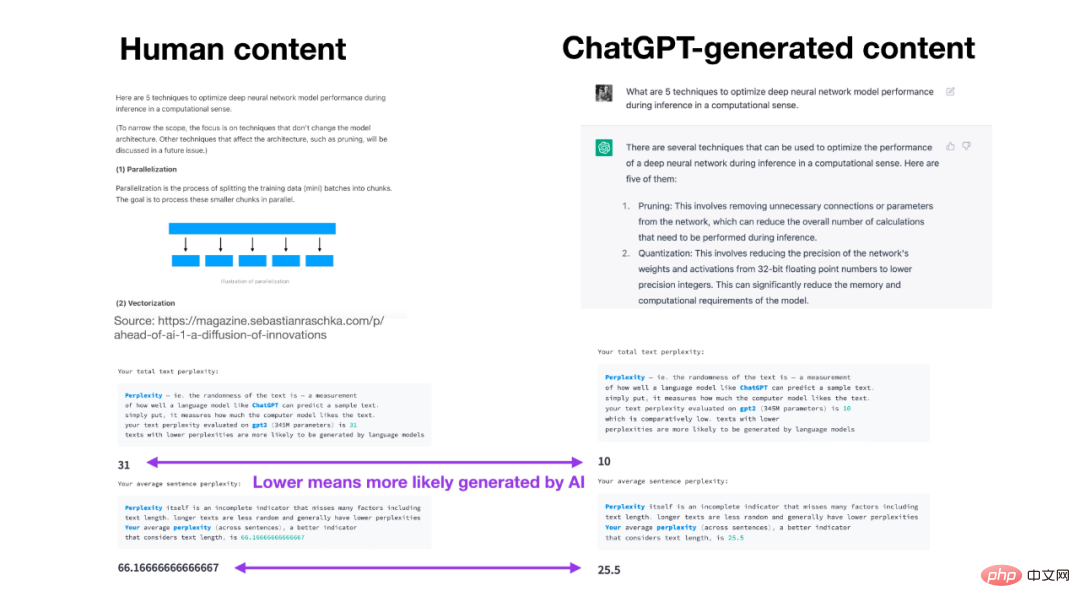

Ein Kolumnist des Wall Street Journal nutzte ChatGPT, um einen erfolgreichen AP-Artikel auf Englisch zu schreiben, während ein Forbes-Reporter es nutzte, um zwei College-Aufsätze in 20 Minuten fertigzustellen. Dan Gillmor, Professor an der Arizona State University, erinnerte sich in einem Interview mit dem Guardian daran, dass er versucht habe, ChatGPT eine Aufgabe an Studenten zu geben, und festgestellt habe, dass KI-generierte Arbeiten ebenfalls gute Noten erzielen könnten. Derzeit haben einige Entwickler ein Erkennungstool für von ChatGPT generierte Inhalte entwickelt – „GPTZero“. Sie müssen den Inhalt nur in das Eingabefeld einfügen, und Sie können die Analyseergebnisse innerhalb weniger Sekunden erhalten und schnell erkennen Ob der Artikel von ChatGPT oder von Menschen geschrieben wurde. Der Autor ist Edward Tian, ein Student der Princeton University, der einen Teil seiner Ferienzeit genutzt hat, um GPTZero zu schreiben. Werfen wir einen Blick auf den Erkennungsprozess, indem wir zunächst einen Inhalt aus dem New Yorker-Bericht als Beispiel nehmen (100 % sicher, dass er von Menschen geschrieben wurde): Schauen wir mal an einem von ChatGPT generierten Inhalt, um ihn zu akzeptieren Erkennung: Das Prinzip der GPTZero-Anwendung besteht darin, mithilfe einiger Textattribute zu analysieren. Die erste ist die Ratlosigkeit, also die Zufälligkeit des Textes gegenüber dem Modell, oder der Grad, in dem das Sprachmodell den Text „mag“, und dann gibt es die Burstigkeit, also den Grad der Verwirrung, den maschinengeschriebener Text aufweist ein einheitlicherer und konstanterer Zeitraum, was bei von Menschen geschriebenen Texten nicht der Fall ist. Laut Guardian entwickelt OpenAI derzeit eine Funktion, um die „Wasserzeichen“ der ChatGPT-Ausgabeergebnisse zu zählen ” damit Leser versteckte Muster in der KI-Textauswahl entdecken können. In einer Rede an der University of Texas sagte OpenAI-Gastforscher Scott Aaronson, dass das Unternehmen an einem System zur Bekämpfung von Betrug arbeitet, indem es „die Ausgabe statistisch mit Wasserzeichen versehen“ soll. Aaronson sagte, dass die Technologie durch eine subtile Anpassung der von ChatGPT ausgewählten spezifischen Wortwahlen in einer Weise funktioniert, die für die Leser nicht auffällt, aber für jeden, der nach Anzeichen von maschinengeneriertem Text sucht, statistisch erkennbar ist. „Wir haben tatsächlich einen funktionierenden Prototyp der Wasserzeichenlösung“, fügte Aaronson hinzu. „Es scheint sehr gut zu funktionieren – erfahrungsgemäß scheinen ein paar hundert Wörter zu reichen, um ein Signal zu bekommen: Ja, dieser Text kommt von GPT Trotz der Bedenken der Menschen verbreiten sich auch Anwendungen rund um ChatGPT rasant.“ offen. In vielen Fällen möchten Menschen nicht mit einem Chatbot sprechen, der einfache Anfragen nicht verstehen kann, und ChatGPT, das alles sagen kann, kann dieses Problem lösen. Das in Toronto ansässige Unternehmen Ada hat sich mit OpenAI zusammengetan, um GPT-3.5, das große Modell hinter ChatGPT, auf Kundenservice-Chatbots anzuwenden und so 4,5 Milliarden Kundenservice-Interaktionen durchzuführen. Den Informationen zufolge hat Microsoft außerdem eine exklusive Lizenzvereinbarung mit OpenAI unterzeichnet und plant, die Technologie in die Bing-Suchmaschine zu integrieren. ChatGPT beschleunigt seinen Weg zur Simulation realer Menschen und dieser Kampf gegen Fälschungen wird weitergehen.  Netizen-Kommentare: Studenten auf der ganzen Welt weinten, nachdem sie es gesehen hatten.

Netizen-Kommentare: Studenten auf der ganzen Welt weinten, nachdem sie es gesehen hatten.

GPTZero: „Studenten, es tut mir leid! Professoren, gern geschehen!“

GPTZero: „Studenten, es tut mir leid! Professoren, gern geschehen!“

Das obige ist der detaillierte Inhalt vonChatGPT-Betrug gibt Anlass zur Sorge, OpenAI entwickelt ein eigenes Audit-Tool. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

ChatGPT-Registrierung

ChatGPT-Registrierung

Inländische kostenlose ChatGPT-Enzyklopädie

Inländische kostenlose ChatGPT-Enzyklopädie

So installieren Sie ChatGPT auf einem Mobiltelefon

So installieren Sie ChatGPT auf einem Mobiltelefon

Kann Chatgpt in China verwendet werden?

Kann Chatgpt in China verwendet werden?

Was passiert, wenn ich keine Verbindung zum Netzwerk herstellen kann?

Was passiert, wenn ich keine Verbindung zum Netzwerk herstellen kann?

Warum kann ich nicht auf den Ethereum-Browser zugreifen?

Warum kann ich nicht auf den Ethereum-Browser zugreifen?

Verwendung von Hintergrundbildern

Verwendung von Hintergrundbildern

So verwenden Sie die Suchfunktion

So verwenden Sie die Suchfunktion