Groß angelegte Sprachmodelle können als Eckpfeiler der modernen Technologie zur Verarbeitung natürlicher Sprache bezeichnet werden, wie z. B. GPT-3 mit 175 Milliarden Parametern und PaLM mit 540 Milliarden Parametern. Vorab trainierte Modelle bieten sehr leistungsstarke Lernfunktionen für wenige Schüsse nachgelagerte Aufgaben.

Aber Denkaufgaben sind immer noch ein schwieriges Problem, insbesondere Fragen, bei denen mehrstufiges Denken erforderlich ist, um die richtige Antwort zu erhalten.

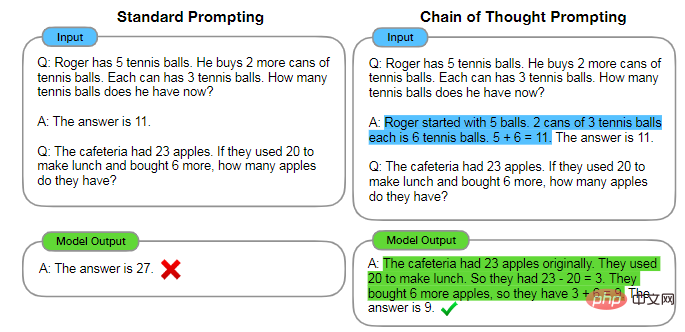

Kürzlich haben Forscher herausgefunden, dass diese Methode auch als Gedankenkettenschlussfolgerung bezeichnet wird, solange eine richtig gestaltete Eingabeaufforderung das Modell dazu anleiten kann, mehrstufige Argumentationen durchzuführen, um die endgültige Antwort zu generieren.

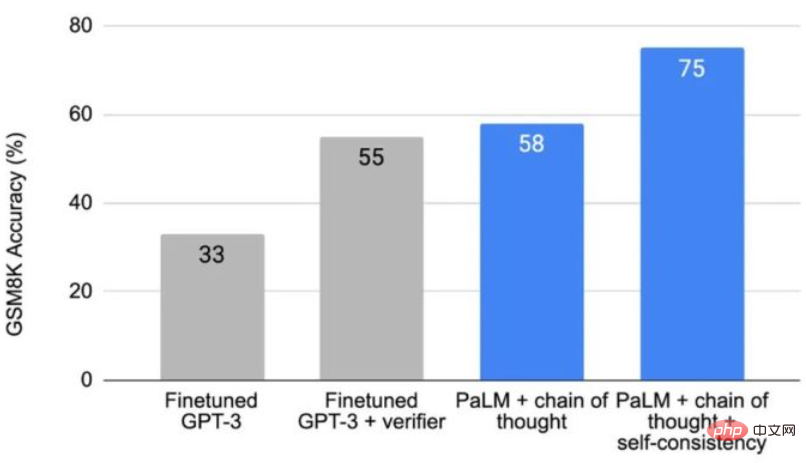

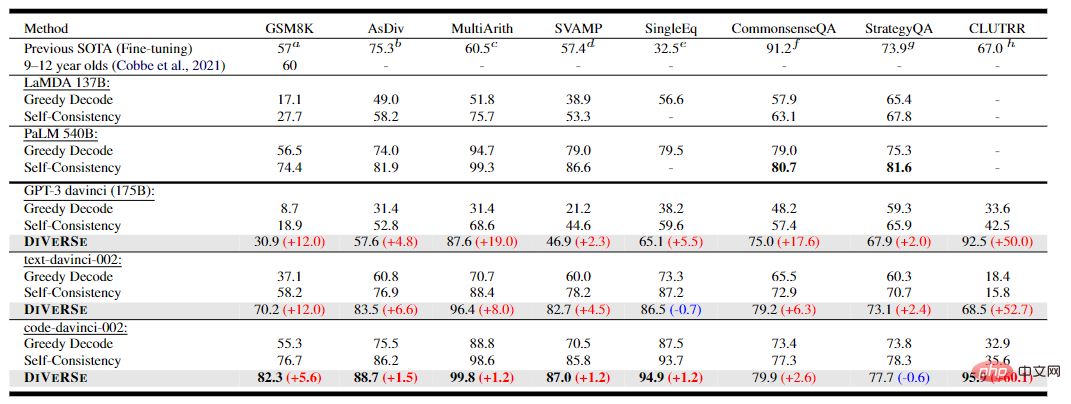

Die Gedankenkettentechnologie erhöhte die Genauigkeit von 17,9 % auf 58,1 % beim arithmetischen Benchmark GSM8K, und der später eingeführte Selbstkonsistenzmechanismus erhöhte die Genauigkeit weiter auf 74,4 %

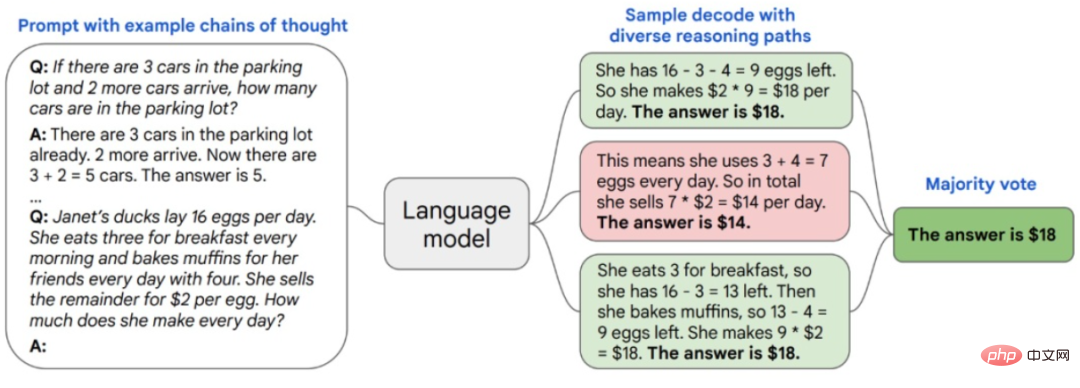

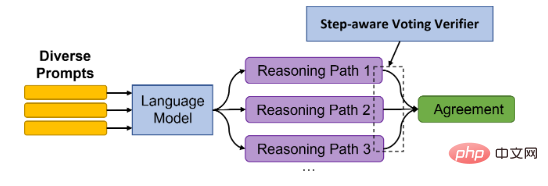

Einfache Aufgaben zum Beispiel bei komplexen Denkaufgaben Normalerweise gibt es mehrere Argumentationspfade, die zu korrekten Antworten führen können. Die selbstkonsistente Methode tastet eine Reihe verschiedener Argumentationspfade aus dem Sprachmodell durch die Denkkette ab und gibt dann die konsistenteste Antwort unter ihnen zurück.

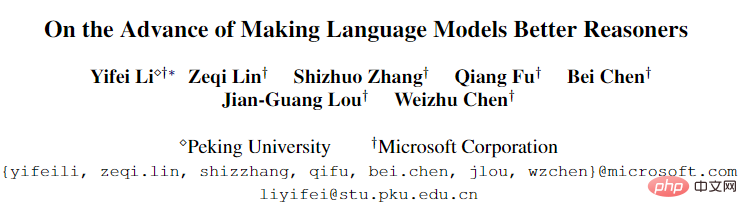

Kürzlich haben Forscher der Peking-Universität und von Microsoft auf die selbstkonsistente neue Methode DiVeRSe gesetzt, die drei wesentliche Neuerungen enthält und die Argumentationsfähigkeiten des Modells weiter verbessert.

Papier-Link: https://arxiv.org/abs/2206.02336

Code-Link: https://github.com/microsoft/DiVeRSe

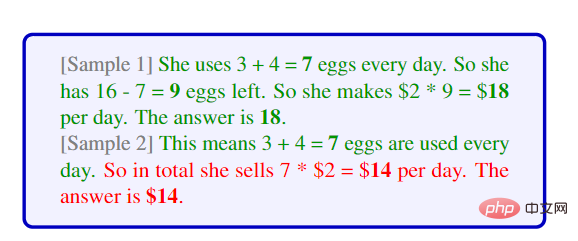

Zunächst betroffen durch den selbstkonsistenten Ansatz „unterschiedliche Ideen, gleiche Antworten „Inspiriert durch die Auswahl verschiedener Argumentationspfade aus Sprachmodellen geht DiVerSe in puncto Diversität noch einen Schritt weiter. Gemäß dem Konzept „Alle Wege führen nach Rom“ werden mehrere Eingabeaufforderungen verwendet, um Antworten zu generieren, die zu vollständigeren Ergebnissen führen können und ergänzende Antworten.

Die Forscher stellen zunächst 5 verschiedene Eingabeaufforderungen für jede Frage bereit, testen dann 20 Argumentationspfade für jede Eingabeaufforderung und generieren schließlich 100 Antwortbegründungspfade für jede Frage.

Eine Schlüsselfrage ist, wie man verschiedene Eingabeaufforderungen erhält. Gehen wir davon aus, dass wir nach Erhalt einer Beispielbibliothek K Proben daraus entnehmen können, um eine Eingabeaufforderung zu erstellen, und diese dann fünfmal wiederholen können.

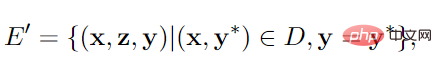

Wenn nicht genügend Proben vorhanden sind, verwenden wir „self“. -Lehrmethode zur Verbesserung der Prompt-Diversität, d. h. Generierung von Pseudo-Inferenzpfaden und -Paaren aus einem Teil der Stichproben.

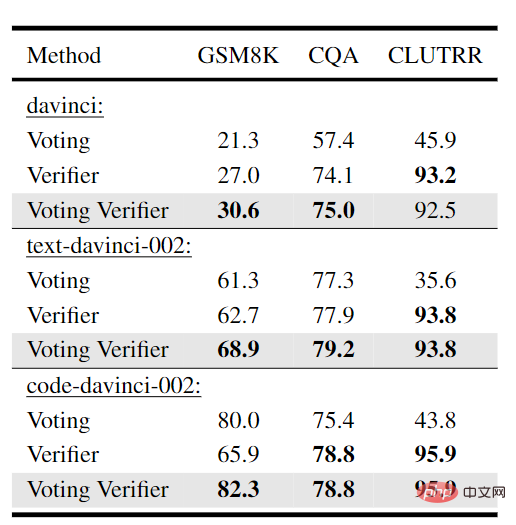

Zweitens gibt es beim Generieren des Inferenzpfads keinen Mechanismus im Sprachmodell, um Fehler in vorherigen Schritten zu korrigieren, was zu Verwirrung im endgültigen Vorhersageergebnis führen kann. DiVeRSe stützt sich auf die Idee des Verifizierers, um die Richtigkeit jedes Argumentationspfads zu überprüfen und den Abstimmungsmechanismus zu leiten. Das heißt, nicht alle Argumentationsmechanismen sind gleich wichtig oder gut.

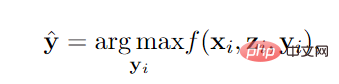

Angenommen, wir haben 100 Argumentationspfade für eine Frage, von denen 60 zu „Die Antwort ist 110“ und 40 zu „Die Antwort ist 150“ führen. Ohne Validator (d. h. die ursprüngliche selbstkonsistente Methode) ist „die Antwort ist 110“ eine Mehrheitsentscheidung, sodass wir 110 als endgültige Antwort behandeln und die 40 Argumentationspfade löschen können, die zu 150 führen.

Verifier bewertet den Argumentationspfad. Die Funktion f wird durch einen Zwei-Klassifikator trainiert. Die Eingabe ist Frage x, Pfad z und Antwort y, und die Ausgabe ist die Wahrscheinlichkeit von positiv.

Angenommen, dass die durchschnittliche Punktzahl der 60 Argumentationspfade von „Die Antwort ist 110“ 0,3 beträgt; die durchschnittliche Punktzahl der 40 Argumentationspfade von „Die Antwort ist 150“ beträgt 0,8. Dann sollte die endgültige Antwort 150 sein, weil 40*0,8>60*0,3

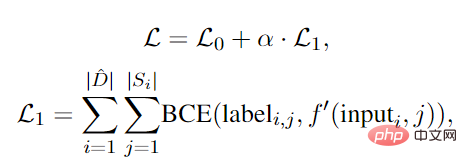

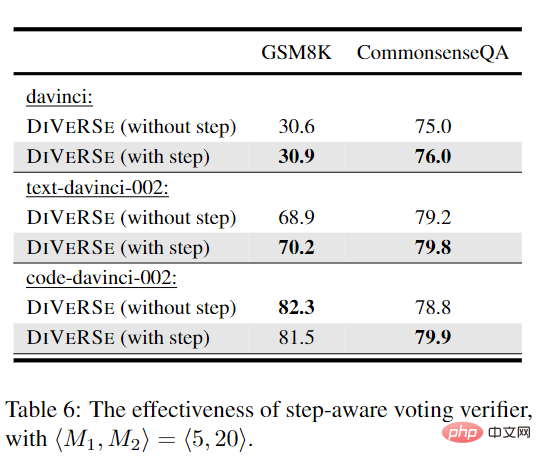

Drittens, da die Antwort auf der Grundlage der Argumentation mehrerer Schritte generiert wird, können alle Schritte berücksichtigt werden, wenn ein Pfad eine richtige Antwort generiert. Zur endgültigen Richtigkeit beigetragen . Wenn jedoch eine falsche Antwort generiert wird, bedeutet das nicht, dass alle Schritte falsch waren oder zum Fehler beigetragen haben.

Mit anderen Worten: Obwohl das Ergebnis falsch ist, können einige Zwischenschritte immer noch richtig sein, aber einige nachfolgende Abweichungsschritte führen zur endgültigen falschen Antwort. DiVeRSe entwickelte einen Mechanismus, um jedem Schritt eine feinkörnige Bezeichnung zuzuweisen, schlug einen schrittorientierten Verifizierer vor und ordnete der Begründung jedes Schritts Richtigkeit zu, anstatt nur die endgültige Antwort zu betrachten.

Der Hauptteil ist immer noch ein Zwei-Klassifikator, aber die Schlüsselfrage ist, wie man die negative Bezeichnung auf Schrittebene erhält, denn wenn die endgültige Antwort falsch ist, wissen wir ohne menschliche Beteiligung nicht, welcher Schritt falsch ist und die richtige. Die Antwort und der Prozess sollten alle korrekt sein.

Forscher haben das Konzept der Unterstützung vorgeschlagen. Bei Rechenaufgaben muss beispielsweise ein Zwischenergebnis eines anderen Beispiels vorhanden sein, das mit dem Ergebnis des Zwischenschritts identisch ist.

Basierend auf diesen drei Verbesserungen führten die Forscher Experimente mit 5 Datensätzen zum arithmetischen Denken durch. Es ist ersichtlich, dass die auf code-davinci-002 basierende DiVeRSe-Methode einen neuen SOTA-Algorithmus mit einer durchschnittlichen Verbesserungsrate erreicht hat 6,2 %

Bei den beiden Aufgaben zum gesunden Menschenverstand ist die Leistung von DiVeRSe etwas geringer als bei der PaLM-basierten Selbstkonsistenz (-2,2 %). Es wird spekuliert, dass der Grund dafür die Aufgabe zum gesunden Menschenverstand sein könnte ist eher eine Multiple-Choice-Aufgabe als eine offene Aufgabe. Die Generierungsaufgabe führte zu mehr falsch-positiven Instanzen.

Bei der Aufgabe des induktiven Denkens erreichte DiVeRSe bei der CLUTRR-Aufgabe eine Punktzahl von 95,9 % und übertraf damit das vorherige SOTA-Feinabstimmungsergebnis (+28,9 %). Leistung.

In den meisten Experimenten kann die Erweiterung des Abstimmungsverifizierers auf eine schrittbasierte Version die Leistung verbessern. Für code-davinci-002 auf GSM8K führt die stufenbasierte Version des Verifiers zu einer leichten Leistungseinbuße.

In den meisten Experimenten kann die Erweiterung des Abstimmungsverifizierers auf eine schrittbasierte Version die Leistung verbessern. Für code-davinci-002 auf GSM8K führt die stufenbasierte Version des Verifiers zu einer leichten Leistungseinbuße.

Mögliche Gründe dafür sind, dass Code-Davinci-002 leistungsfähiger ist und qualitativ hochwertigere Inferenzpfade für GSM8K erzeugen kann, wodurch die Notwendigkeit von Informationen auf Schrittebene verringert wird, d. h. Text-Davinci erzeugt eher kurze/unvollständige Inferenzpfade code-davinci ist benutzerfreundlicher für die Generierung wachsender Inhalte.

Der erste Autor des Artikels ist Yifei Li. Er schloss 2020 seinen Bachelor-Abschluss in Software-Engineering ab. Derzeit studiert er an der Peking-Universität. Sein Forschungsschwerpunkt ist die Verarbeitung natürlicher Sprache , insbesondere Eingabeaufforderungen in umfangreichen Sprachmodellen – Optimierung und Argumentation.

Der erste Autor des Artikels ist Yifei Li. Er schloss 2020 seinen Bachelor-Abschluss in Software-Engineering ab. Derzeit studiert er an der Peking-Universität. Sein Forschungsschwerpunkt ist die Verarbeitung natürlicher Sprache , insbesondere Eingabeaufforderungen in umfangreichen Sprachmodellen – Optimierung und Argumentation.

Der zweite Autor des Artikels ist Zeqi Lin, ein DKI-Forscher bei Microsoft Research Asia. Er erhielt 2014 bzw. 2019 seinen Bachelor-Abschluss und seinen Doktortitel. Sein Forschungsschwerpunkt ist maschinelles Lernen und seine Anwendung in der Softwareanalyse und Datenanalyse.

Das obige ist der detaillierte Inhalt vonJenseits von PaLM! Der Master der Peking-Universität schlug DiVerSe vor und erneuerte damit die Rangliste der NLP-Argumentation völlig. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Algorithmus zum Ersetzen von Seiten

Algorithmus zum Ersetzen von Seiten

Anwendung künstlicher Intelligenz im Leben

Anwendung künstlicher Intelligenz im Leben

Was ist das Grundkonzept der künstlichen Intelligenz?

Was ist das Grundkonzept der künstlichen Intelligenz?

Tutorial zur Serverguide-Installation

Tutorial zur Serverguide-Installation

Art der Systemschwachstelle

Art der Systemschwachstelle

Der Unterschied zwischen Zugangs- und Trunk-Ports

Der Unterschied zwischen Zugangs- und Trunk-Ports

Einführung in SEO-Diagnosemethoden

Einführung in SEO-Diagnosemethoden

BAT-Skript-Batch ändert Dateinamen

BAT-Skript-Batch ändert Dateinamen