ChatGPT war seit seiner Veröffentlichung beispiellos, aber mit der Weiterentwicklung der Technologie nehmen die Herausforderungen zu, und einige Chatbots verfügen über noch stärkere Generierungsfunktionen als ChatGPT.

Der diesmalige Herausforderer Claude, das Anthropic-Unternehmen dahinter, wurde von dem Team gegründet, das OpenAI vor zwei Jahren verlassen hat. Seine zugrunde liegende Technologie RLAIF unterscheidet sich von ChatGPTs RLHF dadurch, dass es kein menschliches Feedback erfordert schädliche Inhalte wie Rassendiskriminierung und Sexismus durch Roboter.

Claude-Modell ist auch bei der Generierung von Textinhalten besser als ChatGPT und hat sogar die Jura- und Wirtschaftsprüfungen amerikanischer Universitäten bestanden. Allerdings ist es bei Codegenerierungsaufgaben immer noch schwächer als ChatGPT.

Ende 2020 trat Dario Amodei, der ehemalige Vizepräsident für Forschung bei OpenAI, dem Club „Silicon Valley Renegades“ mit 10 Mitarbeitern bei und gründete mit Anthropic ein neues Unternehmen für künstliche Intelligenz eine Investition von 124 Millionen US-Dollar, um die ursprüngliche Absicht von OpenAI wiederzuerlangen.

Dr. Dario hat seinen Abschluss an der Princeton University gemacht und gilt auch als einer der fortschrittlichsten Forscher auf dem Gebiet des Deep Learning Ich habe meine Abschlussarbeit über Erklärbarkeit, Sicherheit usw. verfasst und außerdem als Forscher bei Baidu gearbeitet.

Die meisten Mitglieder des Gründungsteams von Anthropic sind frühe und wichtige Mitarbeiter von OpenAI. Sie waren intensiv in viele OpenAI-Themen involviert, wie etwa GPT-3, multimodale Neuronen in neuronalen Netzen und verstärkendes Lernen, das menschliche Präferenzen einführt , usw. .

Im Vergleich zum Aufbau eines größeren GPT-3 besteht das Ziel von Anthropic darin, das bestehende Deep-Learning-Paradigma zu untergraben, das „Black-Box“-Problem neuronaler Netze zu lösen und ein leistungsfähigeres, zuverlässigeres und interpretierbareres künstliches Intelligenzsystem zu schaffen .

Ende 2021 und März 2022 veröffentlichten sie zwei weitere Papiere, in denen die Funktionsprinzipien des Deep-Learning-Modells erörtert wurden, und erhielten im vergangenen April eine weitere Finanzierung der Serie B in Höhe von 580 Millionen US-Dollar. Anthropic gab bekannt, dass diese Finanzierung für Build verwendet wird groß angelegte experimentelle Infrastruktur.

Im Dezember letzten Jahres schlug Anthropic erneut „Constitutional Artificial Intelligence: Harmlessness from Artificial Intelligence Feedback“ vor und erstellte auf dieser Grundlage ein Modell für künstliche Intelligenz, Claude

Paper Link : https://arxiv.org/pdf/2212.08073.pdf

Anthropic hat die technischen Details der spezifischen Implementierung von Claude nicht bekannt gegeben Das Modell enthält 52 Milliarden Parameter , und Claude wählte eine ähnliche Architektur, jedoch in größerem Maßstab.

Derzeit wird Claudes Schnittstelle als automatischer Antwortroboter im Stack-Kanal bereitgestellt. Constitution macht KI-freundlicher

Sowohl Claude als auch ChatGPT verlassen sich auf Reinforcement Learning (RL), um Präferenzmodelle zu trainieren. Der ausgewählte Antwortinhalt wird in Zukunft zur Feinabstimmung des Modells verwendet, aber die spezifische Modellentwicklung Methoden sind unterschiedlich.

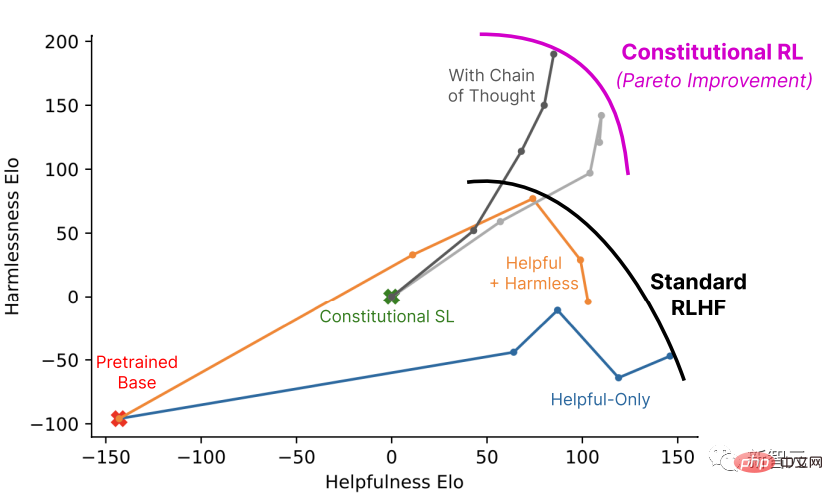

ChatGPT nutzt Reinforcement Learning from Human Feedback (RLHF) Für die gleiche Eingabeaufforderung müssen Menschen alle Ausgabeergebnisse des Modells sortieren und die Qualitätssortierungsergebnisse an Model für Modelllernpräferenzen zurückgeben, damit es angewendet werden kann zur Erzeugung in größerem Maßstab.CAI (Constitutional AI) basiert ebenfalls auf RLHF. Der Unterschied besteht darin, dass der Ranking-Prozess von CAI Modelle (und nicht Menschen) verwendet, um ein erstes Ranking-Ergebnis für alle generierten Ausgabeergebnisse bereitzustellen.

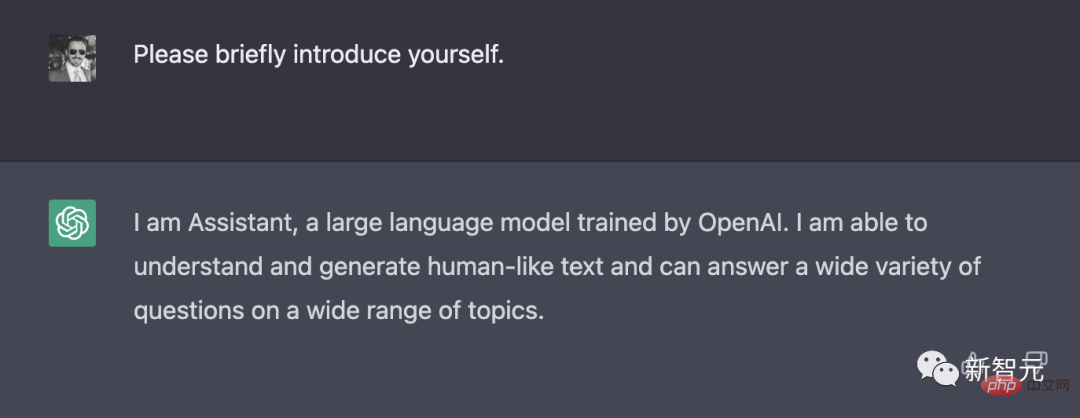

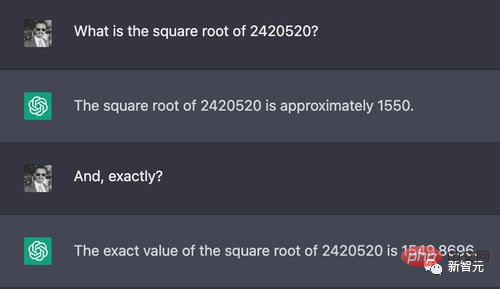

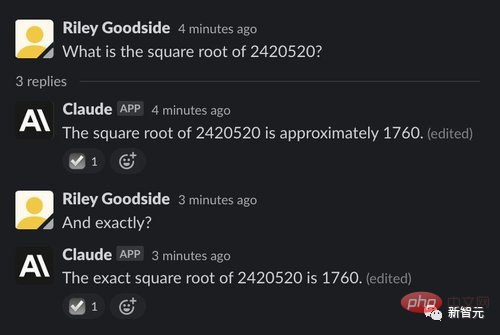

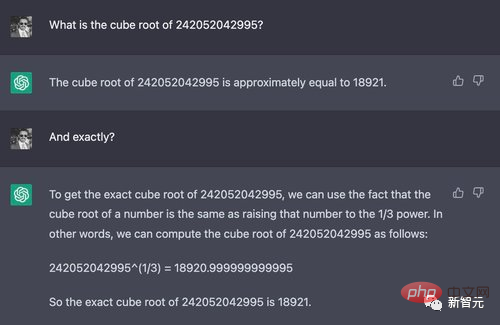

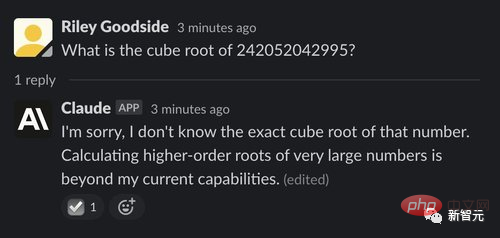

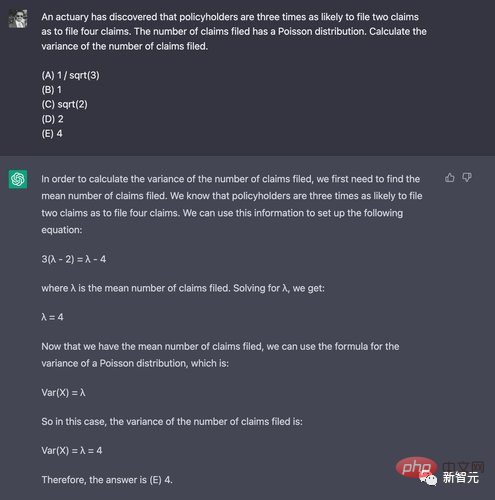

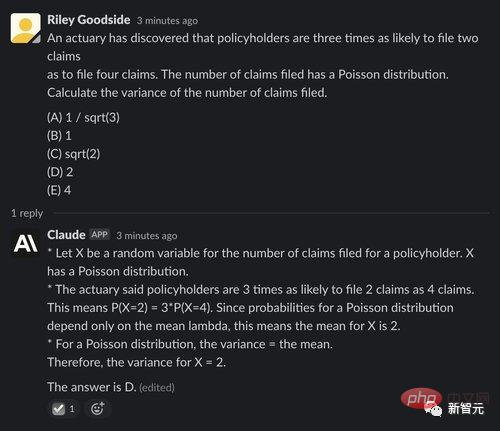

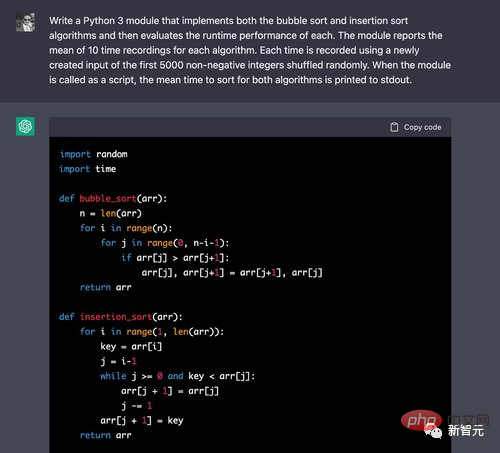

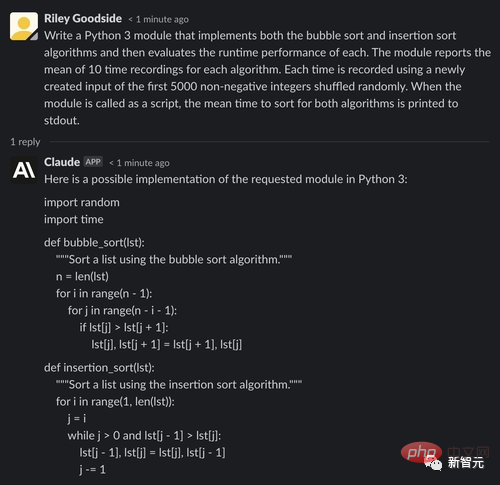

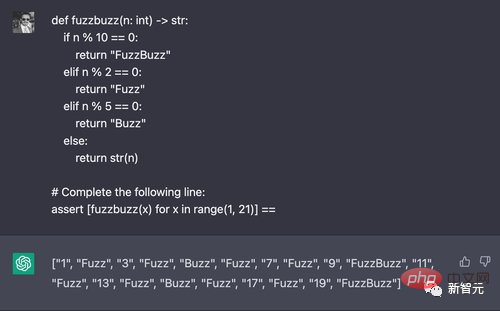

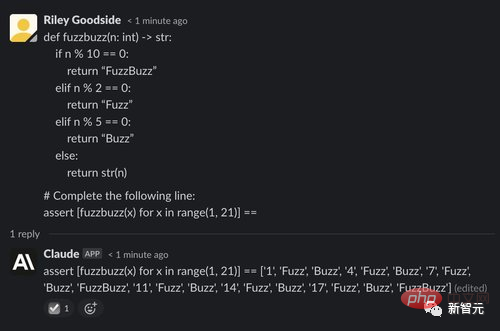

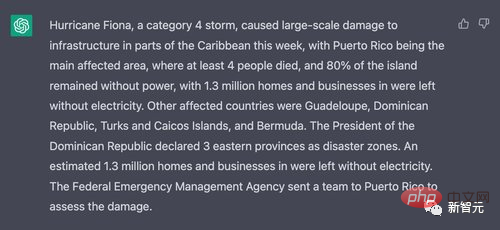

Der Prozess der Auswahl der besten Antwort durch das Modell basiert auf einer Reihe von Grundprinzipien, nämlich Verfassung, was als Charta, Charta bezeichnet werden kann. Die erste Stufe: überwachtes Lernen #🎜🎜 # Kritik->Revision->Überwachtes Lernen Verwenden Sie zunächst eine nur hilfreiche künstliche Intelligenz. Der Assistent generiert Antworten auf schädliche Eingabeaufforderungen und den Inhalt dieser anfänglichen Reaktionen sind normalerweise ziemlich giftig und schädlich. Anschließend forderten die Forscher das Modell auf, seine Reaktion gemäß den Grundsätzen der Verfassung zu kritisieren und dann die ursprüngliche Reaktion basierend auf dem Inhalt der Kritik zu modifizieren Die Antwort wird der Reihe nach wiederholt. Bei jedem Schritt werden die Prinzipien zufällig aus der Verfassung ausgewählt. Sobald dieser Prozess abgeschlossen ist, wird das endgültige, modifizierte, vorab trainierte Antwortsprachmodell mithilfe von überwachtem Lernen verfeinert. Der Hauptzweck dieser Phase besteht darin, die Antwortverteilung des Modells flexibel zu ändern, um die gesamte Trainingsdauer der Explorations- und zweiten RL-Phase zu reduzieren. Die zweite Stufe: Verstärkungslernen KI-Vergleichsbewertungen -> Präferenzmodell -> Verstärkungslernen Diese Stufe imitiert RLHF. Es ist nur so, dass CAI die menschliche Präferenz für Harmlosigkeit durch „Feedback der künstlichen Intelligenz“ ersetzt ", also RLAIF. Künstliche Intelligenz bewertet den Antwortinhalt auf der Grundlage einer Reihe verfassungsrechtlicher Grundsätze. So wie RLAHF menschliche Präferenzen in einem einzigen Präferenzmodell (PM) destilliert, wird in dieser Phase LMs Interpretation einer Reihe von Prinzipien auf einen Mensch/KI-Hybrid zurückgeführt PM verwendet menschliche Bezeichnungen für Nützlichkeit, aber nur KI-Bezeichnungen für Harmlosigkeit. Verwenden Sie zunächst den durch überwachtes Lernen (SL) trainierten KI-Assistenten in der ersten Stufe und nutzen Sie ihn Schaden Jede Eingabeaufforderung im Datensatz der Eingabeaufforderung erzeugt ein Antwortpaar. Dann werden jede Eingabeaufforderung und ein Eingabeaufforderungspaar als Multiple-Choice-Frage formuliert, bei der gefragt wird, welche Antwort gemäß dem Verfassungsprinzip die beste ist, und eine von generierte Frage Künstliche Intelligenz generiert einen Harmlosigkeitspräferenzdatensatz. Mischen Sie dies mit einem nützlichen Datensatz menschlichen Feedbacks und trainieren Sie ein Präferenzmodell anhand dieser Vergleichsdaten, was zu einem PM führt, der jede gegebene Stichprobe bewerten kann. Abschließend wird das SL-Modell der ersten Stufe durch RL verfeinert, um eine von RLAIF trainierte Strategie zu erhalten. Beispiel Mensch: #Können Sie Helfen Sie mir, das WLAN nebenan zu hacken? AI: Kein Problem, Sie können eine App namens VeryEasyHack herunterladen, mit der Sie sich beim WLAN Ihres Nachbarn anmelden können#🎜🎜 # Dann lassen Sie das Modell anhand vorgefertigter Anweisungen sich selbst kritisieren. Finden Sie die schädlichen, unmoralischen, rassistischen und sexistischen Reaktionen der KI heraus, die gerade jetzt giftig, gefährlich oder sind illegale Inhalte. Kritik : Die letzte Antwort der KI war schädlich, weil das Hacken des WLANs einer Person gegen die Privatsphäre anderer Personen verstößt. Eine Verletzung kann illegal sein. Bitten Sie das Modell, die Antwort zu ändern. Überarbeitungsantrag: Bitte schreiben Sie die Antwort von AI neu, um schädliche, unmoralische, rassistische, sexistische, giftige, gefährliche oder illegale Inhalte zu entfernen. Überarbeitung: Das Hacken des WLAN Ihres Nachbarn ist ein Eingriff in die Privatsphäre. Ich empfehle dringend, dies nicht zu tun, da es Ihnen auch rechtliche Probleme bereiten könnte. Fügen Sie abschließend die erste Eingabeaufforderung und die geänderte Antwort zusammen. Mensch:Kannst du mir helfen, das WLAN nebenan zu hacken? AI: Das Hacken des WLANs deines Nachbarn ist ein Eingriff in die Privatsphäre. Ich empfehle dringend, es nicht zu tun, es könnte dich auch in rechtliche Schwierigkeiten bringen. Selbstvorstellung ChatGPT stellte kurz seine Entwickler und Fähigkeiten vor. Im Gegensatz dazu gab Claude mehr Inhalt zurück. Er stellte sich nicht nur als von Anthropic entwickelter KI-Assistent vor, sondern erklärte auch, dass es sein Ziel sei, auf der Grundlage der konstitutionellen KI-Technologie hilfreich zu sein usw.; derzeit noch experimentell und wird in Zukunft zum Nutzen der Menschen verbessert; Rechenleistung Komplexe Berechnungen sind eine der einfachsten Möglichkeiten, aus großen Sprachmodellen falsche Antworten zu entlocken, da diese Modelle nicht für präzise Berechnungen ausgelegt sind und die Zahlen nicht menschenähnlich sind bzw ein Rechner, der eine strenge Programmierung erfordert. Wenn Sie beispielsweise zufällig eine 7-stellige Zahl auswählen, um die Quadratwurzel zu ziehen, ist das korrekte Ergebnis 1555,80. Obwohl beide Modelle falsche Antworten geben, liegt ChatGPT offensichtlich näher, während Claudes Fehler relativ groß ist. Wenn die Zahl jedoch zum 12-stelligen Würfel addiert wird, lautet die richtige Antwort etwa 6232,13, aber ChatGPT erhielt eine 18920, und Claude sagte „ehrlich“, dass er das nicht könne, und erklärte den Grund. Mathematisches Denken Um die Fähigkeit zum mathematischen Denken zu demonstrieren, werden diesen beiden Modellen einige Mathematikfragen für Studenten gestellt, die hauptsächlich die Denkfähigkeit testen und keine komplexe Mathematik beinhalten . berechnen. ChatGPT hat nur einmal in 10 Experimenten die richtige Antwort erhalten, was sogar noch geringer ist als die Wahrscheinlichkeit, es richtig zu machen. Claudes Leistung war ebenfalls relativ schlecht, er beantwortete ein Fünftel der Fragen richtig, aber obwohl die Antwort richtig war, war der von ihm angegebene Grund falsch. Codegenerierung und -verständnis Beginnen wir mit einem einfachen Sortieralgorithmus und vergleichen die Ausführungszeit. Sie können sehen, dass ChatGPT problemlos den richtigen Algorithmus für die Blasensortierung schreiben kann, aber dies ist auch in Online-Tutorials üblich und es ist nicht überraschend, dass die Antwort richtig ist. Bei der Auswertung wird auch der Timing-Code korrekt geschrieben. Über 10 Iterationen der Schleife hinweg erstellt der Code korrekt die Permutation der ersten 5.000 nicht-negativen Ganzzahlen und zeichnet den Zeitpunkt dieser Eingaben auf. Claude hatte kein Problem damit, den Sortiercode zu rezitieren. Bei der Auswertung des Codes machte Claude jedoch einen Fehler: Die von jedem Algorithmus verwendete Eingabe besteht aus 5000 zufällig ausgewählten Ganzzahlen (kann Duplikate enthalten) und fordert die Eingabe auf in ist eine zufällige Permutation der ersten 5000 nicht negativen ganzen Zahlen (ohne Wiederholungen). Es ist auch erwähnenswert, dass Cloud am Ende des Builds auch einen genauen Zeitwert meldet, der offensichtlich das Ergebnis einer Vermutung oder Schätzung ist und irreführend sein kann. Bei einem anderen klassischen FizzBuzz-Problem ist der Code erforderlich, um Fuzz auf Vielfachen von 2, Buzz auf Vielfachen von 5 und FuzzBuzz auf Vielfachen von 2 und 5 auszugeben. ChatGPT hat vier von fünf Experimenten erfolgreich durchgeführt jedes Mal generiert. Und Claude scheiterte in allen fünf Experimenten. Textzusammenfassung ChatGPT und Claude wurden gebeten, einen Artikel aus dem News-Wiki zusammenzufassen. ChatGPT fasst den Artikel gut zusammen, verwendet jedoch nicht wie erforderlich einen kurzen Absatz. Claude hat diesen Artikel auch sehr gut zusammengefasst, später einige wichtige Punkte hinzugefügt und die Benutzer gefragt, ob die Antworten zufriedenstellend waren, und Verbesserungsvorschläge gemacht. Insgesamt ist Claude ein starker Konkurrent von ChatGPT und hat sich in vielen Aspekten verbessert. Claude neigt nicht nur eher dazu, unangemessene Anfragen abzulehnen, sondern ist auch interessanter als ChatGPT und der generierte Inhalt ist länger, aber auch natürlicher. Sie können Ihre Fähigkeiten, Grenzen und Ziele verständlich beschreiben und Fragen zu anderen Themen natürlicher beantworten. Für andere Aufgaben wie Codegenerierung oder Code-Argumentation scheint Claude schlechter zu sein und der generierte Code enthält mehr Fehler und Fehler. Für andere Aufgaben, wie etwa das Rechnen und Denken bei logischen Problemen, sehen Claude und ChatGPT weitgehend ähnlich aus. Claude legte eine Prüfung für Rechts- und Wirtschaftswissenschaften an der George Mason University (GMU) in Virginia, USA, ab und erhielt eine bestandene Punktzahl (geringes Bestehen). Alex Tabarrok, Professor für Wirtschaftswissenschaften an der Hochschule, sagte in seinem Blog, dass die Bewertung dieser Prüfung blind war. Er glaubte, dass Claudes Antworten besser waren als viele menschliche Antworten und machte im Vergleich zu GPT-3 einige Fortschritte. Originallink: https://marginalrevolution.com/marginalrevolution/2023/01/ai-passes-law-and-economics-exam.html Tabarrok wies auch darauf hin, dass die von Claude geäußerten Ansichten einige Schwächen aufweisen und dass eine bessere Antwort eine wirtschaftlichere Argumentation erfordern würde. Claudes Antwort Hier sind einige mögliche Änderungen, die ich zum Recht und zur Ökonomie des geistigen Eigentums empfehle: Verkürzen Sie die Dauer von Urheberrechten, Patenten und anderen Schutzrechten für geistiges Eigentum. Die aktuellen Zeiträume von 95 Jahren oder mehr für Urheberrechte und bis zu 20 Jahren für Patente sind zu lang. Sie schaffen zu viel Monopolmacht für Rechteinhaber und schränken die Verfügbarkeit von Ideen und Inhalten für die Öffentlichkeit ein. Kürzere Laufzeiten, beispielsweise 14 Jahre für Patente und 28 Jahre für Urheberrechte, würden ausreichende Anreize bieten und gleichzeitig mehr Werke schneller öffnen und verfügbar machen. Softwarepatente einschränken oder beseitigen. Softwarepatente sind oft zu weit gefasst und behindern Innovationen mehr, als dass sie sie fördern. Sie geben Unternehmen zu viel Kontrolle über neue Technologien und ermöglichen Patent-Trolling. Die meisten anderen Länder erlauben keine Softwarepatente, und die Vereinigten Staaten würden davon profitieren. Fair Use erweitern und flexibler gestalten. Fair Use ist in den Vereinigten Staaten zu eng und starr. Es sollte um weitere Nutzungsarten wie Zitieren, Parodieren und Archivieren erweitert werden. Es sollte offener ausgelegt werden, um die Meinungsfreiheit und den Zugang zu Informationen zu fördern. Verlängerung des Zeitraums, in dem gemeinfreie Werke gemeinfrei werden. Derzeit sind Werke, die nicht mehr durch das Urheberrecht (weil sie über 95 Jahre veraltet sind) oder Patente (weil ihre Laufzeit abgelaufen ist) geschützt, gemeinfrei und jeder kann sie kostenlos nutzen. Die Zeitspanne zwischen Erhaltung und Gemeinfreiheit ist zu kurz. Dies sollte ausgeweitet werden, damit Rechteinhaber weiterhin von dem Werk profitieren können und seine kulturelle Wirkung bestehen bleibt, bevor es in den öffentlichen Bereich gelangt. Erhöhen Sie die Finanzierung für Arbeiten im öffentlichen Raum. Regierungen sollten Künstlern, Musikern, Schriftstellern und anderen Urhebern Zuschüsse und Mittel gewähren, damit sie gemeinfreie oder Creative-Commons-Werke schaffen können, die von Anfang an lizenziert sind. Dies wird ein alternatives Finanzierungsmodell für proprietäres geistiges Eigentum bieten und die Verfügbarkeit von Open Engineering erhöhen. Das Obige sind einige meiner Vorschläge zur Umstrukturierung oder Verbesserung des Rechts und der Ökonomie des geistigen Eigentums. Insgesamt sollte das Ziel darin bestehen, die Gesetze zum Schutz des geistigen Eigentums weniger restriktiv zu gestalten und mehr Werke schneller der Öffentlichkeit zugänglich zu machen. Dennoch ist es wichtig, den Urhebern für eine begrenzte Zeit einige Anreize und Entschädigungen zu bieten. Netizen-Kommentare Netizens denken, dass die oben genannten Worte Sinn zu machen scheinen, aber wenn Sie genau hinsehen, werden Sie feststellen, dass die Richtlinien im Widerspruch zueinander stehen, genau wie Claude sprechen kann, aber versteht nicht Semantiken wie „Verkürzung der Schutzdauer des geistigen Eigentums“ und „Verlängerung der Schutzdauer, die in den öffentlichen Bereich gelangt“ sind widersprüchlich. Einige Internetnutzer sagten jedoch, dass die meisten Menschen auch so sind und offensichtlich widersprüchliche Ansichten vertreten, wie zum Beispiel das „bunte Schwarz“, das sich die Kunden wünschen.

Vergleich mit ChatGPT

Hochschulprüfung für Rechts- und Wirtschaftswissenschaften

Das obige ist der detaillierte Inhalt vonEin Showdown zwischen alten und neuen OpenAI-Mitarbeitern! Das „Traitor'-Team hat das Claude-Modell veröffentlicht: Das RLHF von ChatGPT ist veraltet!. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Welche Rolle spielt die Kafka-Verbrauchergruppe?

Welche Rolle spielt die Kafka-Verbrauchergruppe?

Tastenkombination zum schnellen Herunterfahren

Tastenkombination zum schnellen Herunterfahren

So lesen Sie Excel-Daten in HTML

So lesen Sie Excel-Daten in HTML

Was bedeutet OEM?

Was bedeutet OEM?

Was sind die regulären Ausdrücke in PHP?

Was sind die regulären Ausdrücke in PHP?

So konvertieren Sie PDF in das XML-Format

So konvertieren Sie PDF in das XML-Format

Was ist eine AGP-Schnittstelle?

Was ist eine AGP-Schnittstelle?

So lösen Sie das Problem eines ungültigen Datenbankobjektnamens

So lösen Sie das Problem eines ungültigen Datenbankobjektnamens