Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Können sich DALL-E und Flamingo verstehen? Drei vorab trainierte SOTA-Neuronale Netze vereinheitlichen Bilder und Text

Können sich DALL-E und Flamingo verstehen? Drei vorab trainierte SOTA-Neuronale Netze vereinheitlichen Bilder und Text

Können sich DALL-E und Flamingo verstehen? Drei vorab trainierte SOTA-Neuronale Netze vereinheitlichen Bilder und Text

Ein wichtiges Ziel der multimodalen Forschung ist die Verbesserung der Fähigkeit der Maschine, Bilder und Texte zu verstehen. Insbesondere haben Forscher große Anstrengungen unternommen, um eine sinnvolle Kommunikation zwischen den beiden Modellen zu erreichen. Beispielsweise sollte die Generierung von Bildunterschriften in der Lage sein, den semantischen Inhalt des Bildes in kohärenten Text umzuwandeln, der für Menschen verständlich ist. Im Gegensatz dazu können generative Text-Bild-Modelle auch die Semantik von Textbeschreibungen nutzen, um realistische Bilder zu erstellen.

Dies wirft einige interessante Fragen im Zusammenhang mit der Semantik auf: Welche Textbeschreibung beschreibt das Bild für ein bestimmtes Bild am genauesten? Und wie lässt sich für einen gegebenen Text ein Bild am sinnvollsten umsetzen? Bezüglich der ersten Frage behaupten einige Studien, dass die beste Bildbeschreibung Informationen sein sollte, die sowohl natürlich sind als auch den visuellen Inhalt wiederherstellen können. Was die zweite Frage betrifft, sollten aussagekräftige Bilder von hoher Qualität, vielfältig und dem Textinhalt treu sein.

In jedem Fall können uns interaktive Aufgaben mit Text-Bild-Generierungsmodellen und Bild-Text-Generierungsmodellen, angetrieben durch menschliche Kommunikation, dabei helfen, den korrektesten Bildtext auszuwählen.

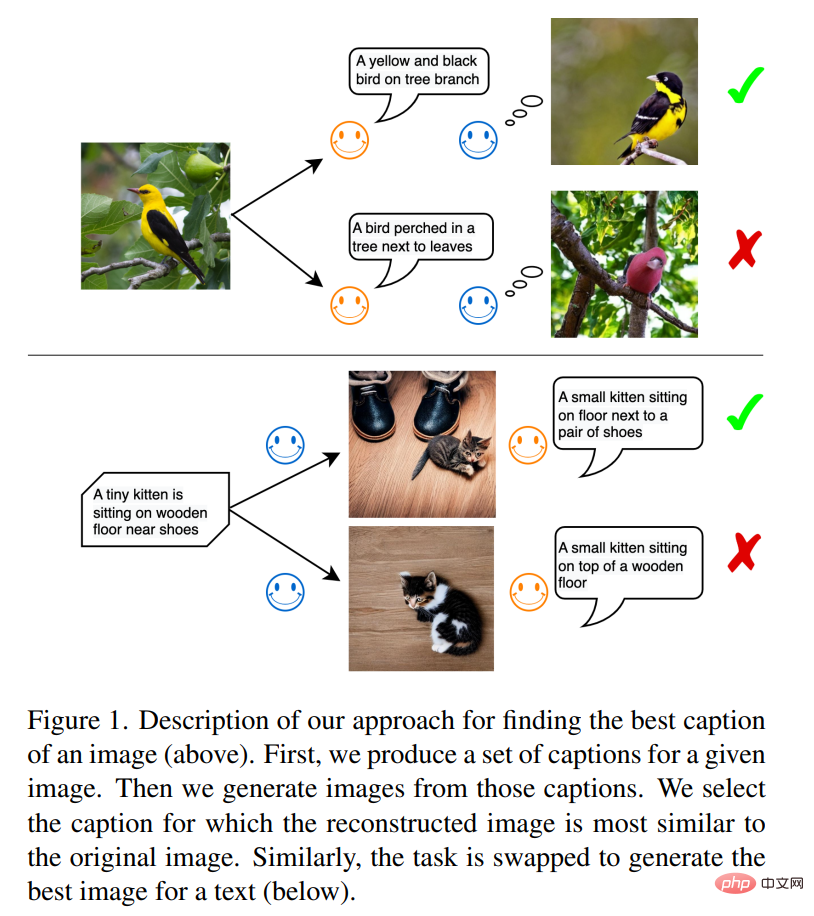

Wie in Abbildung 1 gezeigt, ist in der ersten Aufgabe das Bild-Text-Modell der Informationssender und das Text-Bild-Modell der Informationsempfänger. Ziel des Senders ist es, dem Empfänger den Bildinhalt in natürlicher Sprache zu vermitteln, sodass dieser die Sprache versteht und eine realistische visuelle Darstellung rekonstruiert. Sobald der Empfänger die ursprünglichen Bildinformationen mit hoher Wiedergabetreue rekonstruieren kann, zeigt dies an, dass die Informationen erfolgreich übertragen wurden. Forscher glauben, dass die auf diese Weise generierte Textbeschreibung optimal ist und das dadurch generierte Bild dem Originalbild am ähnlichsten ist.

Diese Regel ist vom Sprachgebrauch der Menschen zur Kommunikation inspiriert. Stellen Sie sich folgendes Szenario vor: In einem Notruf erfährt die Polizei per Telefon etwas über den Autounfall und den Status der Verletzten. Dabei handelt es sich im Wesentlichen um den Prozess der Bildbeschreibung durch Zeugen vor Ort. Die Polizei muss die Umgebungsszene anhand der verbalen Beschreibung gedanklich rekonstruieren, um eine angemessene Rettungsaktion zu organisieren. Offensichtlich sollte die beste Textbeschreibung der beste Leitfaden für die Rekonstruktion der Szene sein.

Die zweite Aufgabe beinhaltet die Textrekonstruktion: Das Text-Bild-Modell wird zum Nachrichtensender und das Bild-Text-Modell zum Nachrichtenempfänger. Sobald sich die beiden Modelle über den Inhalt der Informationen auf der Textebene einig sind, ist das zur Informationsvermittlung verwendete Bildmedium das optimale Bild, das den Quelltext wiedergibt.

In diesem Artikel steht die von Forschern der Universität München, Siemens und anderen Institutionen vorgeschlagene Methode in engem Zusammenhang mit der Kommunikation zwischen Agenten. Sprache ist die wichtigste Methode zum Austausch von Informationen zwischen Agenten. Aber wie können wir sicher sein, dass der erste Agent und der zweite Agent das gleiche Verständnis davon haben, was eine Katze oder ein Hund ist?

Papieradresse: https://arxiv.org/pdf/2212.12249.pdf#🎜 🎜#

Die Idee, die dieser Artikel untersuchen möchte, besteht darin, den ersten Agenten das Bild analysieren und einen das Bild beschreibenden Text generieren zu lassen, und dann erhält der zweite Agent das Bild Text und simulieren Sie Bilder entsprechend. Unter diesen kann der letztere Prozess als ein Prozess der Verkörperung betrachtet werden. Die Studie geht davon aus, dass die Kommunikation erfolgreich ist, wenn das vom zweiten Agenten simulierte Bild dem vom ersten Agenten empfangenen Eingabebild ähnelt (siehe Abbildung 1).

In den Experimenten wurden in dieser Studie Standardmodelle verwendet, insbesondere kürzlich entwickelte vorab trainierte Großmodelle. Flamingo und BLIP sind beispielsweise Bildbeschreibungsmodelle, die automatisch Textbeschreibungen basierend auf Bildern generieren können. Ebenso können auf Bild-Text-Paaren trainierte Bilderzeugungsmodelle die tiefe Semantik von Text verstehen und qualitativ hochwertige Bilder synthetisieren, wie das DALL-E-Modell und das latente Diffusionsmodell (SD).

Darüber hinaus nutzte die Studie auch das CLIP-Modell, um Bilder oder Text zu vergleichen. CLIP ist ein visuelles Sprachmodell, das Bilder und Text in einem gemeinsamen Einbettungsraum zuordnet. Diese Studie verwendet manuell erstellte Bildtextdatensätze wie COCO und NoCaps, um die Qualität des generierten Textes zu bewerten. Generative Bild- und Textmodelle verfügen über stochastische Komponenten, die es ermöglichen, aus einer Verteilung Stichproben zu ziehen und so aus einer Reihe von Kandidatentexten und -bildern die besten auszuwählen. In Bildbeschreibungsmodellen können verschiedene Sampling-Methoden, einschließlich Kernel-Sampling, verwendet werden. In diesem Artikel wird Kernel-Sampling als Grundmodell verwendet, um die Überlegenheit der in diesem Artikel verwendeten Methode zu zeigen.

Methodenübersicht

Das Framework dieses Artikels besteht aus drei vorab trainierten SOTA-Neuronalen Netzen. Erstens das Bild-Text-Generierungsmodell; zweitens das multimodale Darstellungsmodell, das aus einem Bild-Encoder und einem Text-Encoder besteht, die Bilder bzw. Texte in ihre semantischen Einbettungen abbilden können.

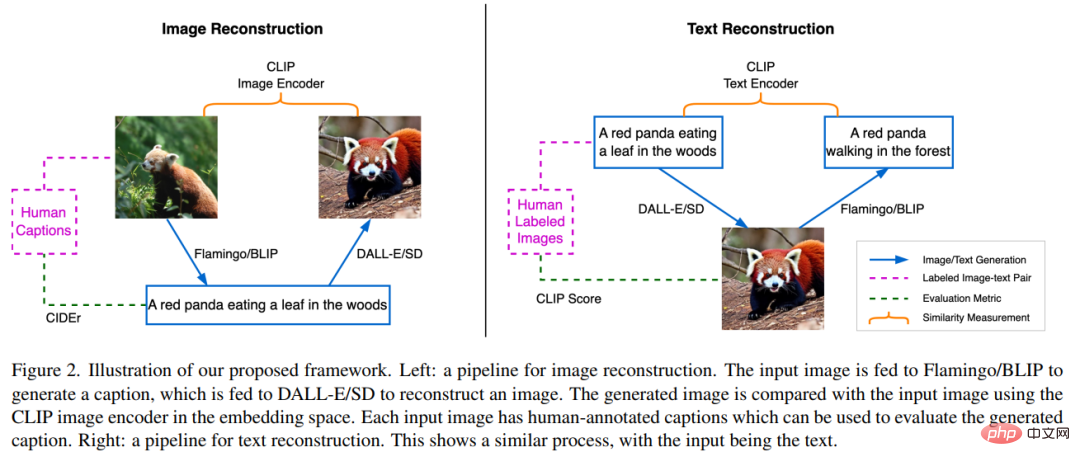

Bildrekonstruktion über Textbeschreibung

# 🎜🎜#Wie in der linken Hälfte von Abbildung 2 dargestellt, besteht die Aufgabe der Bildrekonstruktion darin, Sprache als Anweisungen zur Rekonstruktion des Quellbildes zu verwenden. Der Effekt dieses Prozesses führt zur Generierung des besten Textes, der die Quelle beschreibt Szene. Zunächst wird ein Quellbild x dem BLIP-Modell zugeführt, um mehrere Kandidatentexte y_k zu generieren. Zum Beispiel frisst ein Roter Panda Blätter im Wald. Der generierte Textkandidatensatz wird mit C bezeichnet, und dann wird der Text y_k an das SD-Modell gesendet, um das Bild x’_k zu generieren. Hier bezieht sich x’_k auf das Bild, das basierend auf Roter Panda generiert wurde. Anschließend wird ein CLIP-Bildencoder verwendet, um semantische Merkmale aus der Quelle und den generierten Bildern zu extrahieren: und  .

.

Dann wird die Kosinusähnlichkeit zwischen den beiden Einbettungsvektoren berechnet, um die Kandidatentextbeschreibung y_s zu finden, d. h. #🎜 🎜 #

Die Studie verwendete CIDEr (Image Description Metric) und referenzierte menschliche Anmerkungen, um die besten Texte zu bewerten. Da wir an der Qualität des generierten Textes interessiert waren, wurde in dieser Studie das BLIP-Modell so eingestellt, dass Text ungefähr gleicher Länge ausgegeben wird. Dies gewährleistet einen relativ fairen Vergleich, da die Länge des Textes positiv mit der Informationsmenge im Bild korreliert, die vermittelt werden kann. Während dieser Arbeit werden alle Modelle eingefroren und es werden keine Feinabstimmungen vorgenommen.

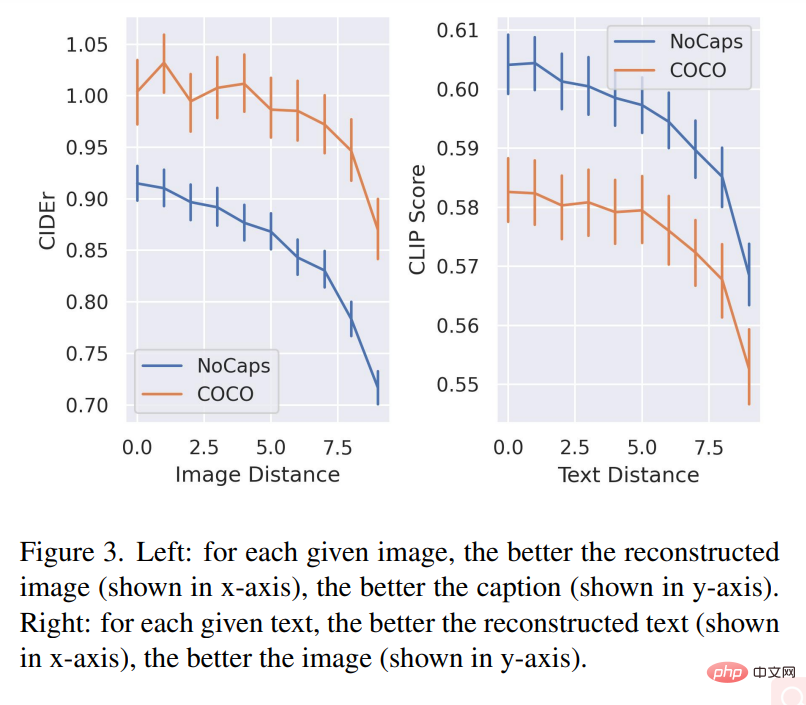

Textrekonstruktion durch Bilder Der rechte Teil von Abbildung 2 zeigt die Umkehrung des im vorherigen Abschnitt beschriebenen Prozesses. Das BLIP-Modell erfordert das Erraten des Quelltexts mithilfe eines SD, der Zugriff auf den Text hat, seinen Inhalt jedoch nur in Form eines Bildes wiedergeben kann. Der Prozess beginnt mit der Verwendung von SD, um Kandidatenbilder x_k für den Text y zu generieren, und der resultierende Satz von Kandidatenbildern wird mit K bezeichnet. Die Generierung von Bildern mithilfe von SD erfordert einen Zufallsstichprobenprozess, bei dem jeder Generierungsprozess zu unterschiedlichen gültigen Bildproben in einem riesigen Pixelraum führen kann. Diese Stichprobenvielfalt bietet einen Pool von Kandidaten, um die besten Bilder herauszufiltern. Anschließend generiert das BLIP-Modell eine Textbeschreibung y’_k für jedes abgetastete Bild x_k. Hier bezieht sich y’_k auf den Anfangstext. Ein roter Panda krabbelt im Wald. Die Studie verwendet dann einen CLIP-Text-Encoder, um Merkmale des Quelltexts und des generierten Texts zu extrahieren, dargestellt durch , das dem Text y entspricht, als Referenzdarstellung von y und quantifiziert das beste Bild anhand seiner Nähe zum Referenzbild. Das rechte Diagramm von Abbildung 3 zeigt die Beziehung zwischen der Qualität des wiederhergestellten Texts und der Qualität des generierten Bildes: Für jeden gegebenen Text wird die rekonstruierte Textbeschreibung ( Je höher die Bildqualität (auf der x-Achse dargestellt), desto besser ist die Bildqualität (auf der y-Achse dargestellt). Abbildung 4(a) und (b) zeigen die Bildrekonstruktionsqualität und die durchschnittliche Textqualität basierend auf dem Quellbild. Abbildung 4(c) und (d) zeigen die Korrelation zwischen Textabstand und rekonstruierter Bildqualität.

bzw.

bzw.  . Der Zweck dieser Aufgabe besteht darin, das beste Kandidatenbild x_s zu finden, das der Semantik des Textes y entspricht. Dazu muss die Studie den Abstand zwischen dem generierten Text und dem Eingabetext vergleichen und dann das Bild mit dem kleinsten gepaarten Textabstand auswählen, d. h.

. Der Zweck dieser Aufgabe besteht darin, das beste Kandidatenbild x_s zu finden, das der Semantik des Textes y entspricht. Dazu muss die Studie den Abstand zwischen dem generierten Text und dem Eingabetext vergleichen und dann das Bild mit dem kleinsten gepaarten Textabstand auswählen, d. h.  # 🎜🎜##🎜 🎜#

# 🎜🎜##🎜 🎜# Experimentelle Ergebnisse

Experimentelle Ergebnisse

Das obige ist der detaillierte Inhalt vonKönnen sich DALL-E und Flamingo verstehen? Drei vorab trainierte SOTA-Neuronale Netze vereinheitlichen Bilder und Text. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1377

1377

52

52

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Stellen Sie sich ein Modell der künstlichen Intelligenz vor, das nicht nur die Fähigkeit besitzt, die traditionelle Datenverarbeitung zu übertreffen, sondern auch eine effizientere Leistung zu geringeren Kosten erzielt. Dies ist keine Science-Fiction, DeepSeek-V2[1], das weltweit leistungsstärkste Open-Source-MoE-Modell, ist da. DeepSeek-V2 ist ein leistungsstarkes MoE-Sprachmodell (Mix of Experts) mit den Merkmalen eines wirtschaftlichen Trainings und einer effizienten Inferenz. Es besteht aus 236B Parametern, von denen 21B zur Aktivierung jedes Markers verwendet werden. Im Vergleich zu DeepSeek67B bietet DeepSeek-V2 eine stärkere Leistung, spart gleichzeitig 42,5 % der Trainingskosten, reduziert den KV-Cache um 93,3 % und erhöht den maximalen Generierungsdurchsatz auf das 5,76-fache. DeepSeek ist ein Unternehmen, das sich mit allgemeiner künstlicher Intelligenz beschäftigt

KI untergräbt die mathematische Forschung! Der Gewinner der Fields-Medaille und der chinesisch-amerikanische Mathematiker führten 11 hochrangige Arbeiten an | Gefällt mir bei Terence Tao

Apr 09, 2024 am 11:52 AM

KI untergräbt die mathematische Forschung! Der Gewinner der Fields-Medaille und der chinesisch-amerikanische Mathematiker führten 11 hochrangige Arbeiten an | Gefällt mir bei Terence Tao

Apr 09, 2024 am 11:52 AM

KI verändert tatsächlich die Mathematik. Vor kurzem hat Tao Zhexuan, der diesem Thema große Aufmerksamkeit gewidmet hat, die neueste Ausgabe des „Bulletin of the American Mathematical Society“ (Bulletin der American Mathematical Society) weitergeleitet. Zum Thema „Werden Maschinen die Mathematik verändern?“ äußerten viele Mathematiker ihre Meinung. Der gesamte Prozess war voller Funken, knallhart und aufregend. Der Autor verfügt über eine starke Besetzung, darunter der Fields-Medaillengewinner Akshay Venkatesh, der chinesische Mathematiker Zheng Lejun, der NYU-Informatiker Ernest Davis und viele andere bekannte Wissenschaftler der Branche. Die Welt der KI hat sich dramatisch verändert. Viele dieser Artikel wurden vor einem Jahr eingereicht.

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas tritt offiziell in die Ära der Elektroroboter ein! Gestern hat sich der hydraulische Atlas einfach „unter Tränen“ von der Bühne der Geschichte zurückgezogen. Heute gab Boston Dynamics bekannt, dass der elektrische Atlas im Einsatz ist. Es scheint, dass Boston Dynamics im Bereich kommerzieller humanoider Roboter entschlossen ist, mit Tesla zu konkurrieren. Nach der Veröffentlichung des neuen Videos wurde es innerhalb von nur zehn Stunden bereits von mehr als einer Million Menschen angesehen. Die alten Leute gehen und neue Rollen entstehen. Das ist eine historische Notwendigkeit. Es besteht kein Zweifel, dass dieses Jahr das explosive Jahr der humanoiden Roboter ist. Netizens kommentierten: Die Weiterentwicklung der Roboter hat dazu geführt, dass die diesjährige Eröffnungsfeier wie Menschen aussieht, und der Freiheitsgrad ist weitaus größer als der von Menschen. Aber ist das wirklich kein Horrorfilm? Zu Beginn des Videos liegt Atlas ruhig auf dem Boden, scheinbar auf dem Rücken. Was folgt, ist atemberaubend

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

Anfang dieses Monats schlugen Forscher des MIT und anderer Institutionen eine vielversprechende Alternative zu MLP vor – KAN. KAN übertrifft MLP in Bezug auf Genauigkeit und Interpretierbarkeit. Und es kann MLP, das mit einer größeren Anzahl von Parametern ausgeführt wird, mit einer sehr kleinen Anzahl von Parametern übertreffen. Beispielsweise gaben die Autoren an, dass sie KAN nutzten, um die Ergebnisse von DeepMind mit einem kleineren Netzwerk und einem höheren Automatisierungsgrad zu reproduzieren. Konkret verfügt DeepMinds MLP über etwa 300.000 Parameter, während KAN nur etwa 200 Parameter hat. KAN hat eine starke mathematische Grundlage wie MLP und basiert auf dem universellen Approximationssatz, während KAN auf dem Kolmogorov-Arnold-Darstellungssatz basiert. Wie in der folgenden Abbildung gezeigt, hat KAN

Google ist begeistert: JAX-Leistung übertrifft Pytorch und TensorFlow! Es könnte die schnellste Wahl für das GPU-Inferenztraining werden

Apr 01, 2024 pm 07:46 PM

Google ist begeistert: JAX-Leistung übertrifft Pytorch und TensorFlow! Es könnte die schnellste Wahl für das GPU-Inferenztraining werden

Apr 01, 2024 pm 07:46 PM

Die von Google geförderte Leistung von JAX hat in jüngsten Benchmark-Tests die von Pytorch und TensorFlow übertroffen und belegt bei 7 Indikatoren den ersten Platz. Und der Test wurde nicht auf der TPU mit der besten JAX-Leistung durchgeführt. Obwohl unter Entwicklern Pytorch immer noch beliebter ist als Tensorflow. Aber in Zukunft werden möglicherweise mehr große Modelle auf Basis der JAX-Plattform trainiert und ausgeführt. Modelle Kürzlich hat das Keras-Team drei Backends (TensorFlow, JAX, PyTorch) mit der nativen PyTorch-Implementierung und Keras2 mit TensorFlow verglichen. Zunächst wählen sie eine Reihe von Mainstream-Inhalten aus

Tesla-Roboter arbeiten in Fabriken, Musk: Der Freiheitsgrad der Hände wird dieses Jahr 22 erreichen!

May 06, 2024 pm 04:13 PM

Tesla-Roboter arbeiten in Fabriken, Musk: Der Freiheitsgrad der Hände wird dieses Jahr 22 erreichen!

May 06, 2024 pm 04:13 PM

Das neueste Video von Teslas Roboter Optimus ist veröffentlicht und er kann bereits in der Fabrik arbeiten. Bei normaler Geschwindigkeit sortiert es Batterien (Teslas 4680-Batterien) so: Der Beamte hat auch veröffentlicht, wie es bei 20-facher Geschwindigkeit aussieht – auf einer kleinen „Workstation“, pflücken und pflücken und pflücken: Dieses Mal wird es freigegeben. Eines der Highlights Der Vorteil des Videos besteht darin, dass Optimus diese Arbeit in der Fabrik völlig autonom und ohne menschliches Eingreifen während des gesamten Prozesses erledigt. Und aus Sicht von Optimus kann es auch die krumme Batterie aufnehmen und platzieren, wobei der Schwerpunkt auf der automatischen Fehlerkorrektur liegt: In Bezug auf die Hand von Optimus gab der NVIDIA-Wissenschaftler Jim Fan eine hohe Bewertung ab: Die Hand von Optimus ist der fünffingrige Roboter der Welt am geschicktesten. Seine Hände sind nicht nur taktil

FisheyeDetNet: der erste Zielerkennungsalgorithmus basierend auf einer Fischaugenkamera

Apr 26, 2024 am 11:37 AM

FisheyeDetNet: der erste Zielerkennungsalgorithmus basierend auf einer Fischaugenkamera

Apr 26, 2024 am 11:37 AM

Die Zielerkennung ist ein relativ ausgereiftes Problem in autonomen Fahrsystemen, wobei die Fußgängererkennung einer der ersten Algorithmen ist, die eingesetzt werden. In den meisten Arbeiten wurde eine sehr umfassende Recherche durchgeführt. Die Entfernungswahrnehmung mithilfe von Fischaugenkameras für die Rundumsicht ist jedoch relativ wenig untersucht. Aufgrund der großen radialen Verzerrung ist es schwierig, die standardmäßige Bounding-Box-Darstellung in Fischaugenkameras zu implementieren. Um die obige Beschreibung zu vereinfachen, untersuchen wir erweiterte Begrenzungsrahmen-, Ellipsen- und allgemeine Polygondesigns in Polar-/Winkeldarstellungen und definieren eine mIOU-Metrik für die Instanzsegmentierung, um diese Darstellungen zu analysieren. Das vorgeschlagene Modell „fisheyeDetNet“ mit polygonaler Form übertrifft andere Modelle und erreicht gleichzeitig 49,5 % mAP auf dem Valeo-Fisheye-Kameradatensatz für autonomes Fahren

DualBEV: BEVFormer und BEVDet4D deutlich übertreffen, öffnen Sie das Buch!

Mar 21, 2024 pm 05:21 PM

DualBEV: BEVFormer und BEVDet4D deutlich übertreffen, öffnen Sie das Buch!

Mar 21, 2024 pm 05:21 PM

In diesem Artikel wird das Problem der genauen Erkennung von Objekten aus verschiedenen Blickwinkeln (z. B. Perspektive und Vogelperspektive) beim autonomen Fahren untersucht, insbesondere wie die Transformation von Merkmalen aus der Perspektive (PV) in den Raum aus der Vogelperspektive (BEV) effektiv ist implementiert über das Modul Visual Transformation (VT). Bestehende Methoden lassen sich grob in zwei Strategien unterteilen: 2D-zu-3D- und 3D-zu-2D-Konvertierung. 2D-zu-3D-Methoden verbessern dichte 2D-Merkmale durch die Vorhersage von Tiefenwahrscheinlichkeiten, aber die inhärente Unsicherheit von Tiefenvorhersagen, insbesondere in entfernten Regionen, kann zu Ungenauigkeiten führen. Während 3D-zu-2D-Methoden normalerweise 3D-Abfragen verwenden, um 2D-Features abzutasten und die Aufmerksamkeitsgewichte der Korrespondenz zwischen 3D- und 2D-Features über einen Transformer zu lernen, erhöht sich die Rechen- und Bereitstellungszeit.