Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Beiträge, die von den Gutachtern während der Blind-Review-Phase des ICLR hoch gelobt wurden: Wird es eine große Innovation in der Transformer-Architektur sein?

Beiträge, die von den Gutachtern während der Blind-Review-Phase des ICLR hoch gelobt wurden: Wird es eine große Innovation in der Transformer-Architektur sein?

Beiträge, die von den Gutachtern während der Blind-Review-Phase des ICLR hoch gelobt wurden: Wird es eine große Innovation in der Transformer-Architektur sein?

Trotz vieler bemerkenswerter Erfolge waren die praktischen Fortschritte beim Training tiefer neuronaler Netze (DNNs) weitgehend unabhängig von der theoretischen Grundlage. Die meisten erfolgreichen modernen DNNs basieren auf spezifischen Anordnungen von Restverbindungen und Normalisierungsschichten, aber die allgemeinen Prinzipien für die Verwendung dieser Komponenten in neuen Architekturen sind noch unbekannt und ihre Rolle in bestehenden Architekturen ist noch nicht vollständig verstanden.

Restarchitekturen sind die beliebtesten und erfolgreichsten und wurden ursprünglich im Zusammenhang mit Faltungs-Neuronalen Netzen (CNN) entwickelt, aus denen später die allgegenwärtige Transformatorarchitektur aus Aufmerksamkeitsnetzen hervorging. Ein Grund für den Erfolg von Restarchitekturen ist die bessere Signalausbreitung im Vergleich zu gewöhnlichen DNNs, bei denen sich die Signalausbreitung auf die Übertragung geometrischer Informationen durch DNN-Schichten bezieht und durch eine Kernelfunktion dargestellt wird.

In letzter Zeit ist die Verwendung von Signalausbreitungsprinzipien zum Trainieren tieferer DNNs ohne die Beteiligung von Restverbindungen und/oder Normalisierungsschichten in Restarchitekturen zu einem Bereich von Gemeinschaftsinteresse geworden. Dafür gibt es zwei Gründe: Erstens validiert es die Signalausbreitungshypothese hinsichtlich der Wirksamkeit von Restarchitekturen und verdeutlicht so das Verständnis der DNN-Interpretierbarkeit. Zweitens ermöglicht dies möglicherweise allgemeine Prinzipien und Methoden für die DNN-Trainingsfähigkeit, die über das Restparadigma hinausgehen.

Für CNNs zeigt die Arbeit von Xiao et al. (2018), dass eine verbesserte Signalausbreitung durch bessere Initialisierung gewöhnliche tiefe Netzwerke effizient trainieren kann, wenn auch mit einer erheblichen Geschwindigkeitsreduzierung im Vergleich zu Restnetzwerken. Die Arbeit von Martens et al. (2021) schlug Deep Kernel Shaping (DKS) vor, das die Aktivierungsfunktionstransformation zur Steuerung der Signalausbreitung verwendet und starke Optimierer zweiter Ordnung wie K-FAC verwendet, um das Training gewöhnlicher Netzwerke und Restnetzwerke zu implementieren auf ImageNet. Die Geschwindigkeiten sind gleich. Die Arbeit von Zhang et al. (2022) erweitert DKS auf eine größere Klasse von Aktivierungsfunktionen und erreicht nahezu Gleichheit bei der Generalisierung.

Die bei der Signalausbreitung zu analysierende Schlüsselgröße ist der Initialisierungszeitkern des DNN, oder genauer gesagt, der ungefähre Kernel unter der unendlichen Breitengrenze. Für mehrschichtige Perzeptrone (MLPs) und CNNs mit Delta-Initialisierung kann der Kernel als einfache Schichtrekursion geschrieben werden, die nur 2D-Funktionen enthält, um eine einfache Analyse zu ermöglichen. Die Kernel-Evolution von Cross-Layer-Transformatoren ist komplexer, daher sind bestehende Methoden wie DKS nicht für Transformatoren oder Architekturen mit Selbstaufmerksamkeitsschichten geeignet.

In MLP wird die Signalausbreitung anhand des Verhaltens von (eindimensionalen) Kerneln beurteilt, während die Signalausbreitung in Transformatoren anhand der Entwicklung von (hochdimensionalen) Kernelmatrizen in den Netzwerkschichten beurteilt werden kann.

Diese Forschung muss eine Situation vermeiden, in der diagonale Elemente mit zunehmender Tiefe schnell wachsen oder schrumpfen, was mit unkontrollierten Aktivierungsnormen zusammenhängt und zu Sättigungsverlust oder numerischen Problemen führen kann. Für die Trainierbarkeit tiefer Transformatoren ist es notwendig, einen Rangkollaps zu vermeiden, und ob tiefe, residuenfreie Transformatoren trainiert werden können, bleibt eine offene Frage.

Dieses Papier aus der Blind-Review-Phase von ICLR 2023 löst dieses Problem und zeigt zum ersten Mal, dass es möglich ist, Tiefentransformatoren ohne verbleibende Verbindungen oder Normalisierungsschichten erfolgreich zu trainieren. Zu diesem Zweck untersuchen sie Probleme der Signalausbreitung und des Rangkollaps in tiefen, rückstandsfreien Transformatoren und leiten drei Methoden ab, um diese zu verhindern. Konkret verwendet der Ansatz eine Kombination aus Parameterinitialisierung, Bias-Matrizen und ortsabhängiger Neuskalierung und hebt verschiedene Komplexitäten hervor, die für die Signalausbreitung in Transformatoren spezifisch sind, einschließlich Interaktionen mit Positionskodierung und kausaler Maskierung. Die Forscher haben empirisch gezeigt, dass ihre Methode tief trainierbare, residuenfreie Transformatoren erzeugen kann.

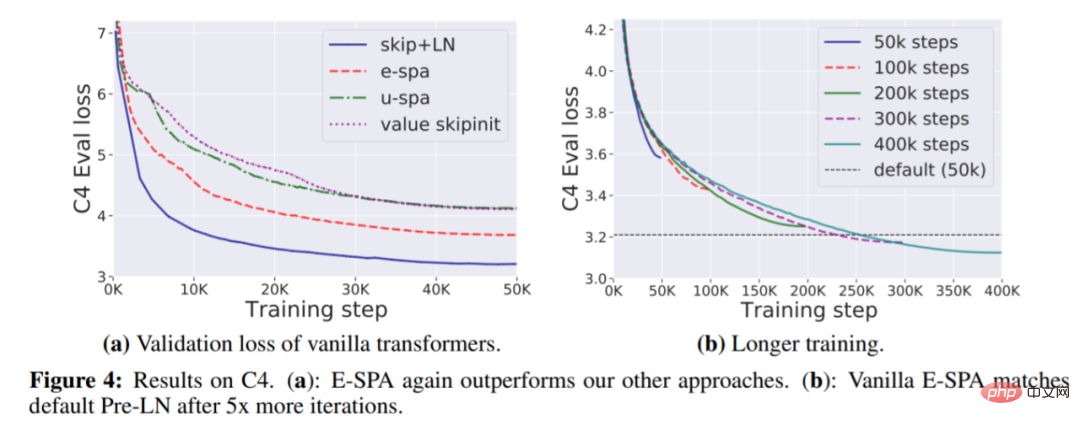

Im experimentellen Teil zeigten die Forscher anhand der WikiText-103- und C4-Datensätze, dass mit ihrer Hauptmethode, Exponential Signal Preserving Attention (E-SPA), die Trainingszeit um etwa das Fünffache verlängert werden kann Verlust des Standardtransformators vergleichbar mit dem des Resttransformators im Papier. Darüber hinaus zeigten die Forscher durch die Kombination dieser Methode mit Restverbindungen, dass Transformatoren ohne Normalisierungsschichten Trainingsgeschwindigkeiten erreichen können, die mit Standardtransformatoren vergleichbar sind.

Papieradresse: https://openreview.net/pdf?id=NPrsUQgMjKK

Für dieses Papier glaubt Google AI-Chefingenieur Rohan Anil, dass es einen Fortschritt für die Transformer-Architektur darstellt Ein großer Schritt oder eine grundlegende Verbesserung.

Konstruieren eines tiefen Transformers, der ohne Abkürzungen trainierbar ist

Bisher basiert die einzige Strategie zur Korrektur des Zusammenbruchs des Transformer-Rangs auf Restverbindungen, wodurch die inhärenten Trainierbarkeitsprobleme von Selbstaufmerksamkeitsschichten übersprungen werden. Im Gegensatz dazu befasst sich diese Studie direkt mit dieser Frage. Verstehen Sie zunächst die Signalausbreitung durch Aufmerksamkeitsschichten besser und ändern Sie sie dann basierend auf den Erkenntnissen, um eine originalgetreue Signalübertragung in Tiefentransformatoren zu erreichen, die mit oder ohne Restverbindungen trainiert werden können.

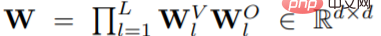

Konkret führte die Studie zunächst eine einfache Einstellung eines Deep-Vanilla-Transformators mit nur Aufmerksamkeit durch und ging dann davon aus, dass der Transformator eine Einzelkopf-Einstellung (h = 1) oder eine Mehrkopf-Einstellung hat, wobei die Aufmerksamkeitsmatrix A ändert sich nicht zwischen den Köpfen. Wenn der Block l ≤ L bei der Initialisierung eine Aufmerksamkeitsmatrix A_l hat, ist die Darstellung des letzten Blocks

und kann während der Initialisierung orthogonal sein.

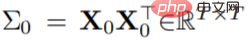

Unter den oben genannten Annahmen kann, wenn  zur Darstellung der positionübergreifenden Eingabekernmatrix verwendet wird, nach einiger Vereinfachungsverarbeitung die folgende Formel erhalten werden:

zur Darstellung der positionübergreifenden Eingabekernmatrix verwendet wird, nach einiger Vereinfachungsverarbeitung die folgende Formel erhalten werden:

Aus dieser vereinfachten Formel (Tiefe). (nur Aufmerksamkeitstransformator-Kernelmatrix) können drei Anforderungen für (A_l)_l bestimmt werden:

Aus dieser vereinfachten Formel (Tiefe). (nur Aufmerksamkeitstransformator-Kernelmatrix) können drei Anforderungen für (A_l)_l bestimmt werden:

muss in jedem Block gut funktionieren und degenerierte Situationen wie Rangkollaps und explodierende/verschwindende Diagonalwerte vermeiden;

muss in jedem Block gut funktionieren und degenerierte Situationen wie Rangkollaps und explodierende/verschwindende Diagonalwerte vermeiden;

A_l muss elementweise nicht negativ sein ∀l;

A_l sollte unteres Dreieck ∀l sein, um mit der Kausalmaskenaufmerksamkeit kompatibel zu sein.

-

In den nächsten Abschnitten 3.1 und 3.2 konzentriert sich die Forschung auf die Suche nach einer Aufmerksamkeitsmatrix, die die oben genannten Anforderungen erfüllt, und schlägt drei Methoden vor: E-SPA, U-SPA und Value-Skipinit, wobei jede Methode die verwendete Aufmerksamkeitsmatrix verwendet Die Steuerung des Transformators ermöglicht eine originalgetreue Signalausbreitung auch in großen Tiefen. Darüber hinaus zeigt Abschnitt 3.3, wie man die Softmax-Aufmerksamkeit ändert, um diese Aufmerksamkeitsmatrizen zu implementieren.

In den nächsten Abschnitten 3.1 und 3.2 konzentriert sich die Forschung auf die Suche nach einer Aufmerksamkeitsmatrix, die die oben genannten Anforderungen erfüllt, und schlägt drei Methoden vor: E-SPA, U-SPA und Value-Skipinit, wobei jede Methode die verwendete Aufmerksamkeitsmatrix verwendet Die Steuerung des Transformators ermöglicht eine originalgetreue Signalausbreitung auch in großen Tiefen. Darüber hinaus zeigt Abschnitt 3.3, wie man die Softmax-Aufmerksamkeit ändert, um diese Aufmerksamkeitsmatrizen zu implementieren.

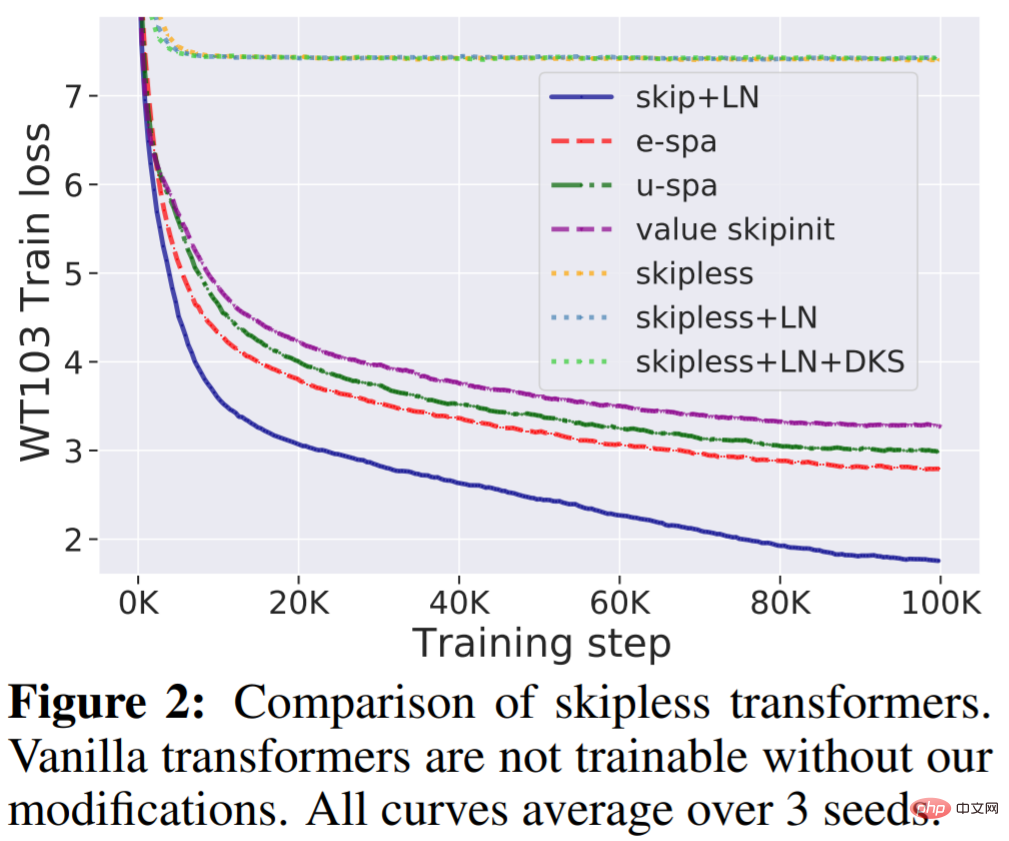

- In der folgenden Abbildung wurden die beiden vorgeschlagenen SPA-Systeme U-SPA und E-SPA überprüft. Die Ergebnisse zeigen, dass das Phänomen der reinen Rangaufmerksamkeit bei Vanilla-Transformatoren erfolgreich vermieden werden kann .

Experimente

WikiText-103 Basislinie: Erstens bestätigt diese Studie, dass Standard-Tiefentransformatoren ohne Restverbindungen nicht trainierbar sind, selbst wenn sie über Normalisierungsschichten (LN) und transformierte Aktivierungen verfügen, aber unsere Methode kann diese Frage lösen. Wie in Abbildung 2 dargestellt, ist deutlich zu erkennen, dass das Entfernen der Restverbindung vom Standardtransformator ihn untrainierbar macht und sich der Trainingsverlust bei etwa 7,5 stabilisiert. Wie in Abbildung 1 dargestellt, leidet der Standardtransformator unter einem Rangzusammenbruch.

Andererseits übertrifft die in dieser Studie vorgeschlagene E-SPA-Methode U-SPA und Value-Skipinit. Der Standardtransformator mit Rest und LN behält jedoch immer noch den Trainingsgeschwindigkeitsvorteil im Vergleich zu unserer Methode ohne Reste bei.

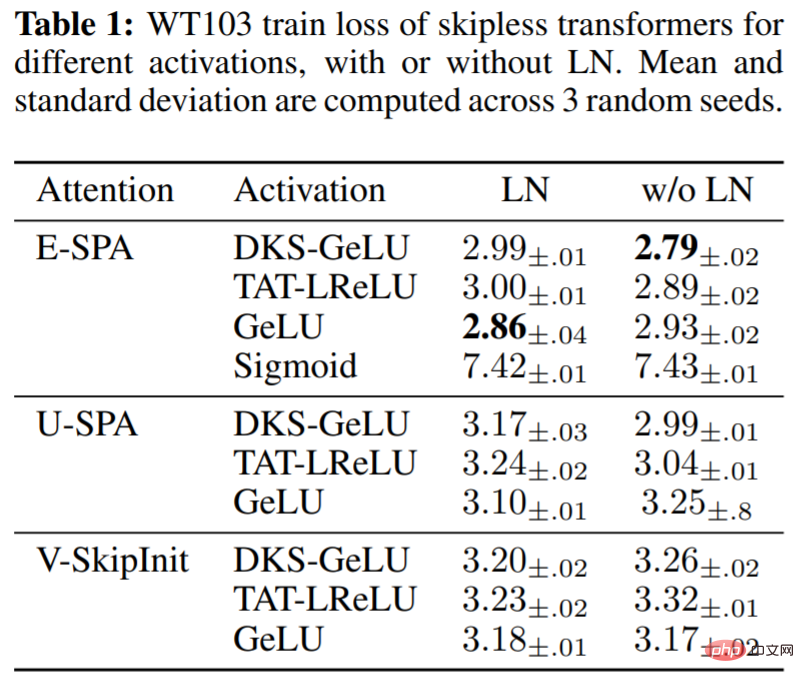

In Tabelle 1 bewertet die Studie die Auswirkungen verschiedener Aktivierungsfunktionen im MLP-Block unter Verwendung der vorgeschlagenen Methode sowie die Verwendung von LN im rückstandsfreien Transformator. Es ist ersichtlich, dass unsere Methode bei Tiefe 36 eine gute Trainingsleistung für eine Reihe von Aktivierungen erzielt: DKS-transformiertes GeLU, TAT-transformiertes Leaky ReLU und untransformiertes GeLU, aber nicht untransformiertes Sigmoid. Es wurde auch experimentell festgestellt, dass die Layer-Normalisierung für die Trainingsgeschwindigkeit relativ unwichtig ist und sogar schädlich für die transformierte Aktivierung sein kann, wenn SPA verwendet wird, das bereits über integrierte Mechanismen zur Steuerung der Aktivierungsspezifikationen verfügt.

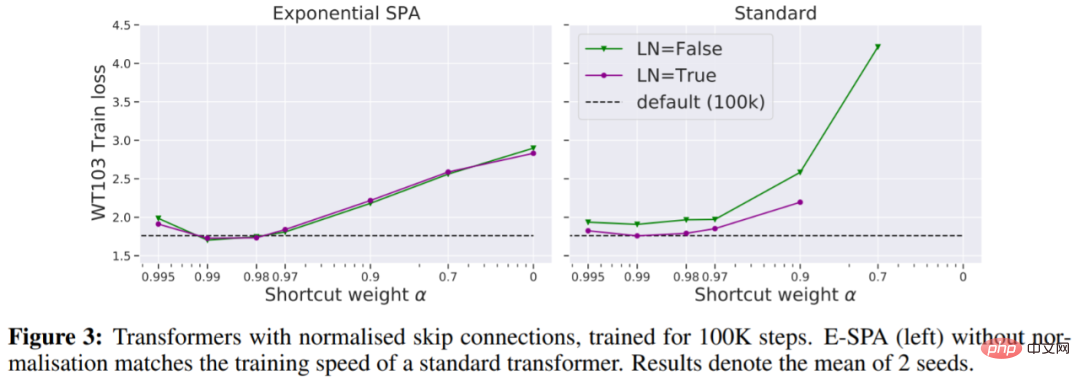

In Abbildung 3 sehen wir, dass eine Möglichkeit, den standardmäßigen Transformator-Trainingsverlust anzupassen, ohne dass weitere Iterationen erforderlich sind, darin besteht, eine normalisierte Restverbindung zu verwenden.

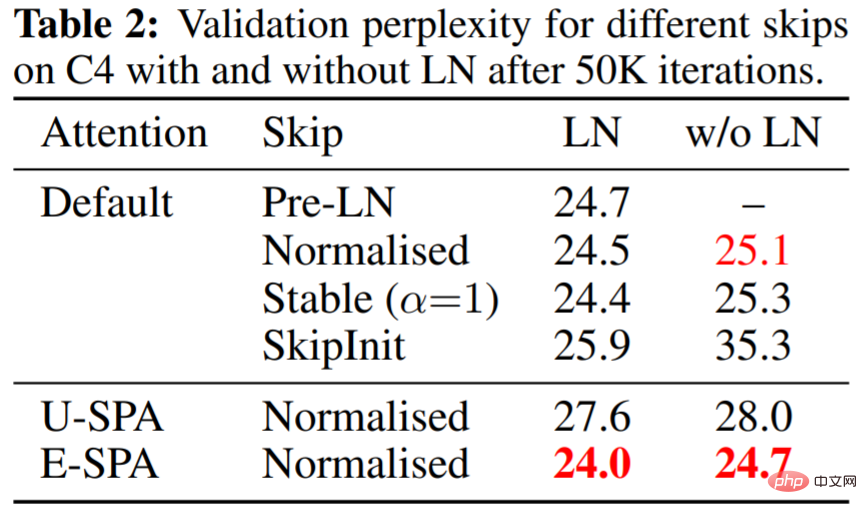

Tabelle 2 zeigt, dass E-SPA mit normalisierten Residuen und LN den standardmäßigen PreLN-Transformator übertrifft.

Abbildung 4(a) unten zeigt, dass E-SPA wiederum andere Methoden übertrifft; 4(b) zeigt, dass die Trainingsverlustlücke durch einfaches Erhöhen der Trainingszeit beseitigt werden kann.

Das obige ist der detaillierte Inhalt vonBeiträge, die von den Gutachtern während der Blind-Review-Phase des ICLR hoch gelobt wurden: Wird es eine große Innovation in der Transformer-Architektur sein?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1378

1378

52

52

Open Source! Jenseits von ZoeDepth! DepthFM: Schnelle und genaue monokulare Tiefenschätzung!

Apr 03, 2024 pm 12:04 PM

Open Source! Jenseits von ZoeDepth! DepthFM: Schnelle und genaue monokulare Tiefenschätzung!

Apr 03, 2024 pm 12:04 PM

0.Was bewirkt dieser Artikel? Wir schlagen DepthFM vor: ein vielseitiges und schnelles generatives monokulares Tiefenschätzungsmodell auf dem neuesten Stand der Technik. Zusätzlich zu herkömmlichen Tiefenschätzungsaufgaben demonstriert DepthFM auch hochmoderne Fähigkeiten bei nachgelagerten Aufgaben wie dem Tiefen-Inpainting. DepthFM ist effizient und kann Tiefenkarten innerhalb weniger Inferenzschritte synthetisieren. Lassen Sie uns diese Arbeit gemeinsam lesen ~ 1. Titel der Papierinformationen: DepthFM: FastMonocularDepthEstimationwithFlowMatching Autor: MingGui, JohannesS.Fischer, UlrichPrestel, PingchuanMa, Dmytr

Verzichten Sie auf die Encoder-Decoder-Architektur und verwenden Sie das Diffusionsmodell zur Kantenerkennung, das effektiver ist. Die National University of Defense Technology hat DiffusionEdge vorgeschlagen

Feb 07, 2024 pm 10:12 PM

Verzichten Sie auf die Encoder-Decoder-Architektur und verwenden Sie das Diffusionsmodell zur Kantenerkennung, das effektiver ist. Die National University of Defense Technology hat DiffusionEdge vorgeschlagen

Feb 07, 2024 pm 10:12 PM

Aktuelle Deep-Edge-Erkennungsnetzwerke verwenden normalerweise eine Encoder-Decoder-Architektur, die Up- und Down-Sampling-Module enthält, um mehrstufige Merkmale besser zu extrahieren. Diese Struktur schränkt jedoch die Ausgabe genauer und detaillierter Kantenerkennungsergebnisse des Netzwerks ein. Als Antwort auf dieses Problem bietet ein Papier zu AAAI2024 eine neue Lösung. Titel der Abschlussarbeit: DiffusionEdge:DiffusionProbabilisticModelforCrispEdgeDetection Autoren: Ye Yunfan (Nationale Universität für Verteidigungstechnologie), Xu Kai (Nationale Universität für Verteidigungstechnologie), Huang Yuxing (Nationale Universität für Verteidigungstechnologie), Yi Renjiao (Nationale Universität für Verteidigungstechnologie), Cai Zhiping (National University of Defense Technology) Link zum Papier: https://ar

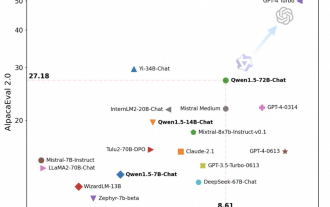

Tongyi Qianwen ist wieder Open Source, Qwen1.5 bietet sechs Volumenmodelle und seine Leistung übertrifft GPT3.5

Feb 07, 2024 pm 10:15 PM

Tongyi Qianwen ist wieder Open Source, Qwen1.5 bietet sechs Volumenmodelle und seine Leistung übertrifft GPT3.5

Feb 07, 2024 pm 10:15 PM

Pünktlich zum Frühlingsfest ist Version 1.5 des Tongyi Qianwen Large Model (Qwen) online. Heute Morgen erregten die Neuigkeiten über die neue Version die Aufmerksamkeit der KI-Community. Die neue Version des großen Modells umfasst sechs Modellgrößen: 0,5B, 1,8B, 4B, 7B, 14B und 72B. Unter ihnen übertrifft die Leistung der stärksten Version GPT3.5 und Mistral-Medium. Diese Version umfasst das Basismodell und das Chat-Modell und bietet Unterstützung für mehrere Sprachen. Das Tongyi Qianwen-Team von Alibaba gab an, dass die entsprechende Technologie auch auf der offiziellen Website von Tongyi Qianwen und der Tongyi Qianwen App eingeführt wurde. Darüber hinaus bietet die heutige Version von Qwen 1.5 auch die folgenden Highlights: Unterstützt eine Kontextlänge von 32 KB und öffnet den Prüfpunkt des Base+Chat-Modells.

Große Modelle können ebenfalls in Scheiben geschnitten werden, und Microsoft SliceGPT erhöht die Recheneffizienz von LLAMA-2 erheblich

Jan 31, 2024 am 11:39 AM

Große Modelle können ebenfalls in Scheiben geschnitten werden, und Microsoft SliceGPT erhöht die Recheneffizienz von LLAMA-2 erheblich

Jan 31, 2024 am 11:39 AM

Große Sprachmodelle (LLMs) verfügen typischerweise über Milliarden von Parametern und werden auf Billionen von Token trainiert. Die Schulung und Bereitstellung solcher Modelle ist jedoch sehr teuer. Um den Rechenaufwand zu reduzieren, werden häufig verschiedene Modellkomprimierungstechniken eingesetzt. Diese Modellkomprimierungstechniken können im Allgemeinen in vier Kategorien unterteilt werden: Destillation, Tensorzerlegung (einschließlich Faktorisierung mit niedrigem Rang), Bereinigung und Quantisierung. Pruning-Methoden gibt es schon seit einiger Zeit, aber viele erfordern nach dem Pruning eine Feinabstimmung der Wiederherstellung (Recovery Fine-Tuning, RFT), um die Leistung aufrechtzuerhalten, was den gesamten Prozess kostspielig und schwierig zu skalieren macht. Forscher der ETH Zürich und von Microsoft haben eine Lösung für dieses Problem namens SliceGPT vorgeschlagen. Die Kernidee dieser Methode besteht darin, die Einbettung des Netzwerks durch das Löschen von Zeilen und Spalten in der Gewichtsmatrix zu reduzieren.

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas tritt offiziell in die Ära der Elektroroboter ein! Gestern hat sich der hydraulische Atlas einfach „unter Tränen“ von der Bühne der Geschichte zurückgezogen. Heute gab Boston Dynamics bekannt, dass der elektrische Atlas im Einsatz ist. Es scheint, dass Boston Dynamics im Bereich kommerzieller humanoider Roboter entschlossen ist, mit Tesla zu konkurrieren. Nach der Veröffentlichung des neuen Videos wurde es innerhalb von nur zehn Stunden bereits von mehr als einer Million Menschen angesehen. Die alten Leute gehen und neue Rollen entstehen. Das ist eine historische Notwendigkeit. Es besteht kein Zweifel, dass dieses Jahr das explosive Jahr der humanoiden Roboter ist. Netizens kommentierten: Die Weiterentwicklung der Roboter hat dazu geführt, dass die diesjährige Eröffnungsfeier wie Menschen aussieht, und der Freiheitsgrad ist weitaus größer als der von Menschen. Aber ist das wirklich kein Horrorfilm? Zu Beginn des Videos liegt Atlas ruhig auf dem Boden, scheinbar auf dem Rücken. Was folgt, ist atemberaubend

Aktualisierter Point Transformer: effizienter, schneller und leistungsfähiger!

Jan 17, 2024 am 08:27 AM

Aktualisierter Point Transformer: effizienter, schneller und leistungsfähiger!

Jan 17, 2024 am 08:27 AM

Originaltitel: PointTransformerV3: Simpler, Faster, Stronger Papier-Link: https://arxiv.org/pdf/2312.10035.pdf Code-Link: https://github.com/Pointcept/PointTransformerV3 Autor: HKUSHAILabMPIPKUMIT Papier-Idee: Dieser Artikel ist nicht zur Veröffentlichung in „Suche nach Innovation innerhalb des Aufmerksamkeitsmechanismus“ gedacht. Stattdessen liegt der Schwerpunkt darauf, die Macht der Skalierung zu nutzen, um bestehende Kompromisse zwischen Genauigkeit und Effizienz im Kontext der Punktwolkenverarbeitung zu überwinden. Lassen Sie sich von den jüngsten Fortschritten beim Lernen groß angelegter 3D-Darstellungen inspirieren.

Die Kuaishou-Version von Sora „Ke Ling' steht zum Testen offen: Sie generiert über 120 Sekunden Videos, versteht die Physik besser und kann komplexe Bewegungen genau modellieren

Jun 11, 2024 am 09:51 AM

Die Kuaishou-Version von Sora „Ke Ling' steht zum Testen offen: Sie generiert über 120 Sekunden Videos, versteht die Physik besser und kann komplexe Bewegungen genau modellieren

Jun 11, 2024 am 09:51 AM

Was? Wird Zootopia durch heimische KI in die Realität umgesetzt? Zusammen mit dem Video wird ein neues groß angelegtes inländisches Videogenerationsmodell namens „Keling“ vorgestellt. Sora geht einen ähnlichen technischen Weg und kombiniert eine Reihe selbst entwickelter technologischer Innovationen, um Videos zu produzieren, die nicht nur große und vernünftige Bewegungen aufweisen, sondern auch die Eigenschaften der physischen Welt simulieren und über starke konzeptionelle Kombinationsfähigkeiten und Vorstellungskraft verfügen. Den Daten zufolge unterstützt Keling die Erstellung ultralanger Videos von bis zu 2 Minuten mit 30 Bildern pro Sekunde, mit Auflösungen von bis zu 1080p und unterstützt mehrere Seitenverhältnisse. Ein weiterer wichtiger Punkt ist, dass es sich bei Keling nicht um eine vom Labor veröffentlichte Demo oder Video-Ergebnisdemonstration handelt, sondern um eine Anwendung auf Produktebene, die von Kuaishou, einem führenden Anbieter im Bereich Kurzvideos, gestartet wurde. Darüber hinaus liegt das Hauptaugenmerk darauf, pragmatisch zu sein, keine Blankoschecks auszustellen und sofort nach der Veröffentlichung online zu gehen. Das große Modell von Ke Ling wurde bereits in Kuaiying veröffentlicht.

Die Vitalität der Superintelligenz erwacht! Aber mit der Einführung der sich selbst aktualisierenden KI müssen sich Mütter keine Sorgen mehr über Datenengpässe machen

Apr 29, 2024 pm 06:55 PM

Die Vitalität der Superintelligenz erwacht! Aber mit der Einführung der sich selbst aktualisierenden KI müssen sich Mütter keine Sorgen mehr über Datenengpässe machen

Apr 29, 2024 pm 06:55 PM

Ich weine zu Tode. Die Daten im Internet reichen überhaupt nicht aus. Das Trainingsmodell sieht aus wie „Die Tribute von Panem“, und KI-Forscher auf der ganzen Welt machen sich Gedanken darüber, wie sie diese datenhungrigen Esser ernähren sollen. Dieses Problem tritt insbesondere bei multimodalen Aufgaben auf. Zu einer Zeit, als sie ratlos waren, nutzte ein Start-up-Team der Abteilung der Renmin-Universität von China sein eigenes neues Modell, um als erstes in China einen „modellgenerierten Datenfeed selbst“ in die Realität umzusetzen. Darüber hinaus handelt es sich um einen zweigleisigen Ansatz auf der Verständnisseite und der Generierungsseite. Beide Seiten können hochwertige, multimodale neue Daten generieren und Datenrückmeldungen an das Modell selbst liefern. Was ist ein Modell? Awaker 1.0, ein großes multimodales Modell, das gerade im Zhongguancun-Forum erschienen ist. Wer ist das Team? Sophon-Motor. Gegründet von Gao Yizhao, einem Doktoranden an der Hillhouse School of Artificial Intelligence der Renmin University.

In den nächsten Abschnitten 3.1 und 3.2 konzentriert sich die Forschung auf die Suche nach einer Aufmerksamkeitsmatrix, die die oben genannten Anforderungen erfüllt, und schlägt drei Methoden vor: E-SPA, U-SPA und Value-Skipinit, wobei jede Methode die verwendete Aufmerksamkeitsmatrix verwendet Die Steuerung des Transformators ermöglicht eine originalgetreue Signalausbreitung auch in großen Tiefen. Darüber hinaus zeigt Abschnitt 3.3, wie man die Softmax-Aufmerksamkeit ändert, um diese Aufmerksamkeitsmatrizen zu implementieren.

In den nächsten Abschnitten 3.1 und 3.2 konzentriert sich die Forschung auf die Suche nach einer Aufmerksamkeitsmatrix, die die oben genannten Anforderungen erfüllt, und schlägt drei Methoden vor: E-SPA, U-SPA und Value-Skipinit, wobei jede Methode die verwendete Aufmerksamkeitsmatrix verwendet Die Steuerung des Transformators ermöglicht eine originalgetreue Signalausbreitung auch in großen Tiefen. Darüber hinaus zeigt Abschnitt 3.3, wie man die Softmax-Aufmerksamkeit ändert, um diese Aufmerksamkeitsmatrizen zu implementieren.