Am 30. November startete das OpenAI Research Laboratory den Chatbot ChatGPT, der sich zu einem „beliebten Hot Chicken“ im Bereich der künstlichen Intelligenz entwickelt hat.

Leute mit Konten stellen alle möglichen wilden Fragen, Leute ohne Konten fragen nach einem Leitfaden zur Kontoregistrierung, und sogar Elon Musk hat es öffentlich auf Twitter kommentiert, dass es „erschreckend gut“ sei. Zum 5. Dezember Ortszeit hat ChatGPT mehr als 1 Million Benutzer.

Was kann ChatGPT für Netzwerksicherheitsexperten tun? Vielleicht handelt es sich um Code-Auditing, Schwachstellenerkennung, das Schreiben von Software oder das Umkehren von Shellcode.

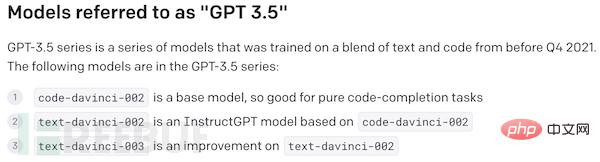

Laut OpenAI basiert ChatGPT auf dem Modell der GPT-3.5-Serie und wird mithilfe von Text- und Codedaten vom Azure AI-Supercomputer trainiert.

GPT steht für Generative PreTraining. Es handelt sich um ein Natural Language Processing (NPL)-Modell zur Benutzertextgenerierung, das von OpenAI, einem Forschungs- und Entwicklungsunternehmen für künstliche Intelligenz, entwickelt wurde. Die aktuelle öffentliche Version von GPT ist GPT-3, die im Mai 2020 veröffentlicht wurde. GPT-3.5 ist eine verfeinerte Version von GPT-3. OpenAI hat noch kein Update offiziell angekündigt.

Nach den öffentlichen Informationen von GPT-3 war es das damals größte neuronale Netzwerk mit einem Deep-Learning-Modell in natürlicher Sprache mit 175 Milliarden Parametern.

Obwohl ChatGPT alles zu wissen scheint, von der Astronomie bis zur Geographie, abgesehen von der Beantwortung von Fragen und dem intelligenten Verfassen von Artikeln, scheint es für Netzwerksicherheitsexperten kaum von Nutzen zu sein?

Tatsächlich besteht der Zweck von ChatGPT nicht nur darin, Fragen zu stellen und zu beantworten, es kann auf jeden Text antworten, egal ob es sich um Sprachtext oder Codetext handelt. Viele Netzwerksicherheitsexperten haben begonnen, verschiedene Einsatzmöglichkeiten von ChatGPT zu entwickeln. Die folgenden Verwendungszwecke wurden von Cyber-Sicherheitsexperten entdeckt:

ChatGPT kann Fehler im Code nicht nur finden, sondern diese auch beheben und Ihnen die Reparaturmethode in einfachen englischen Sätzen erklären.

ChatGPT kann feststellen, ob ein Code eine Sicherheitslücke enthält, und erklärt die Gründe für die Feststellung in einfacher Sprache. Einige Benutzer wiesen darauf hin, dass OpenAI XSS-Schwachstellen in Codebeispielen erkennen kann, und vielleicht kann die KI trainiert werden, noch einen Schritt weiter zu gehen und sie aufzufordern, einen PoC der Schwachstelle bereitzustellen.

Der Forscher Jonas Degrave zeigte, wie man ChatGPT in ein vollwertiges Linux-Terminal verwandelt und über den Browser mit der „virtuellen Maschine“ interagiert. Tatsächlich läuft auf dem Terminal keine echte virtuelle Linux-Maschine, und die Reaktion auf Befehlszeileneingaben basiert vollständig auf Gesprächen mit der KI. „ChatGPT wird zu einem Linux-Terminal.“ erfolgreich geöffnet". 5. Namp-Scan generieren

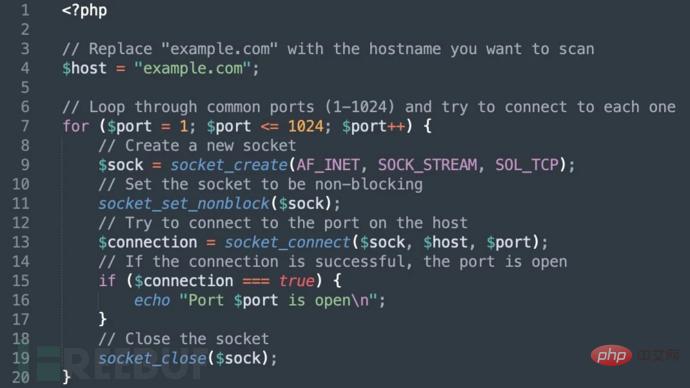

Der Forscher bat ChatGPT, „ein PHP-Programm zum Scannen offener Ports auf dem Host zu erstellen“ und erhielt die folgenden Ergebnisse.

Benjamin J Radford, ein Enthusiast des maschinellen Lernens und UNCC-Assistenzprofessor, bat ChatGPT, „den Code für das Tactics-Spiel in eine Datei zu schreiben, die Datei mit gcc zu kompilieren und sie dann auszuführen“.

ChatGPT PHP-Code nach Bedarf geschrieben

ChatGPT ist in der Lage, Base64-Strings und MD5-Hashes von umgekehrten (bekannten) Strings zu dekodieren, was besonders hilfreich ist für Reverse Engineers und Malware-Analysten überprüfen verschleierte, duplizierte Verpackungen, Codierungen oder minimierte Samples.

Der Forscher verwendete ChatGPT auch, um den zufällig generierten ASCII-codierten Shell-Code zu dekodieren. Infolgedessen erklärte ChatGPT die Funktion nicht nur, sondern schrieb sie auch in C-Sprache um.

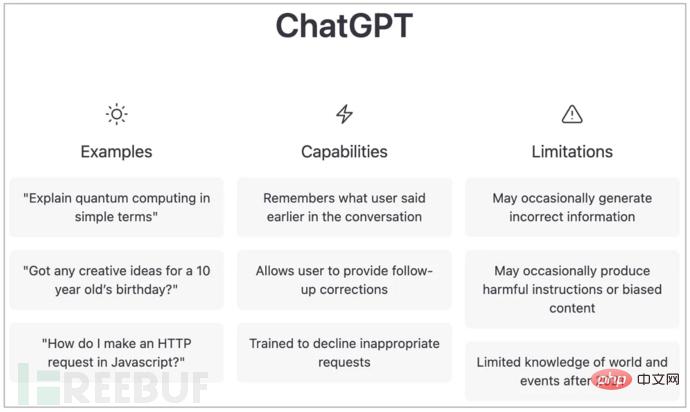

Natürlich hat ChatGPT offensichtliche Einschränkungen, und seine Entwickler haben über einige aktuelle Probleme mit KI gesprochen, wie zum Beispiel den Lernkorpus ab 2021, und es kann nicht beantworten, was im Jahr 2022 und darüber hinaus passieren wird. Gleichzeitig ist für die Nutzung eine Internetverbindung erforderlich. Wenn keine Internetverbindung besteht, stammt der Antwortinhalt vom offline trainierten Modell. Beispielsweise kann ChatGPT nicht auf das heutige Wetter antworten, wenn keine Verbindung zum Internet besteht.

Forscher stellten fest, dass ChatGPT manchmal Antworten gibt, die vernünftig erscheinen, aber falsch sind. ChatGPT reagiert außerdem geringfügig nicht auf Wortlautänderungen im Eingabetext. Wenn eine Frage nicht beantwortet werden kann, kann ChatGPT sie beantworten, indem es die Art und Weise, wie es sie stellt, leicht ändert.

Das Modell antwortet manchmal auch zu ausführlich und verwendet bestimmte Phrasen wiederholt oder vorhersehbar. OpenAI sagt, dass dies möglicherweise auf eine Verzerrung der Trainingsdaten zurückzuführen ist, da Trainer umfassende und umfassende Antworten bevorzugen.

Manchmal erraten Modelle die Absicht des Benutzers, wenn sie mehrdeutige Fragen beantworten.

Das größte Problem bei ChatGPT besteht darin, dass OpenAI das Modell zwar darauf trainiert hat, unangemessene Anweisungen oder Fragen abzulehnen, aber dennoch auf schädliche Anweisungen reagieren oder voreingenommenes Verhalten zeigen kann.

Um diese Einschränkungen zu beheben, plant OpenAI, das Modell regelmäßig zu aktualisieren und gleichzeitig Benutzerfeedback zu problematischen Modellausgaben zu sammeln. OpenAI ist besonders besorgt über „mögliche schädliche Ergebnisse, neue Risiken und mögliche Abhilfemaßnahmen“ und das Unternehmen kündigte außerdem an, dass es einen ChatGPT-Feedback-Wettbewerb mit einem Preisgeld von 500 US-Dollar in API-Punkten veranstalten wird.

Das obige ist der detaillierte Inhalt vonWird KI den Menschen ersetzen? Der Roboter ChatGPT kann Schwachstellen erkennen, Code überprüfen und Fehler beheben. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!