Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Einheitliche visuelle KI-Funktionen! Automatisierte Bilderkennung und -segmentierung sowie kontrollierbare vinzentinische Bilder, erstellt von einem chinesischen Team

Einheitliche visuelle KI-Funktionen! Automatisierte Bilderkennung und -segmentierung sowie kontrollierbare vinzentinische Bilder, erstellt von einem chinesischen Team

Einheitliche visuelle KI-Funktionen! Automatisierte Bilderkennung und -segmentierung sowie kontrollierbare vinzentinische Bilder, erstellt von einem chinesischen Team

Dieser Artikel wird mit Genehmigung von AI New Media Qubit (öffentliche Konto-ID: QbitAI) nachgedruckt. Bitte wenden Sie sich für einen Nachdruck an die Quelle.

Jetzt ist es wirklich an der Zeit, im KI-Kreis mit der Handgeschwindigkeit zu konkurrieren.

Nein, Metas SAM wurde erst vor ein paar Tagen auf den Markt gebracht und einheimische Programmierer sind gekommen, um die Verbesserungen zu überlagern und Zielerkennung, Segmentierung und Generierung wichtiger visueller KI-Funktionen in einem zu integrieren!

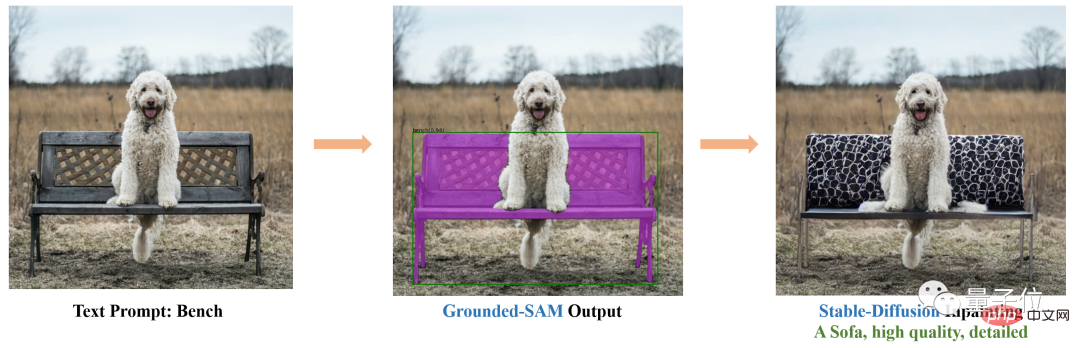

Zum Beispiel können Sie basierend auf Stable Diffusion und SAM den Stuhl auf dem Foto nahtlos durch ein Sofa ersetzen:

Auch das Ändern von Kleidung und Haarfarbe ist so einfach:

Sobald das Projekt abgeschlossen ist veröffentlicht wurde, riefen viele Leute aus: Die Handgeschwindigkeit ist zu hoch!

Jemand anderes sagte: Es gibt neue Hochzeitsfotos von Yui Aragaki und mir.

Das Obige ist der Effekt von Gounded-SAM. Das Projekt hat 1,8.000 Sterne auf GitHub erhalten.

Einfach ausgedrückt handelt es sich um eine Zero-Shot-Vision-Anwendung, die nur Bilder eingeben muss, um Bilder automatisch zu erkennen und zu segmentieren.

Diese Forschung stammt vom IDEA Research Institute (Guangdong-Hong Kong-Macao Greater Bay Area Digital Economy Research Institute), dessen Gründer und Vorsitzender Shen Xiangyang ist.

Keine zusätzliche Schulung erforderlich

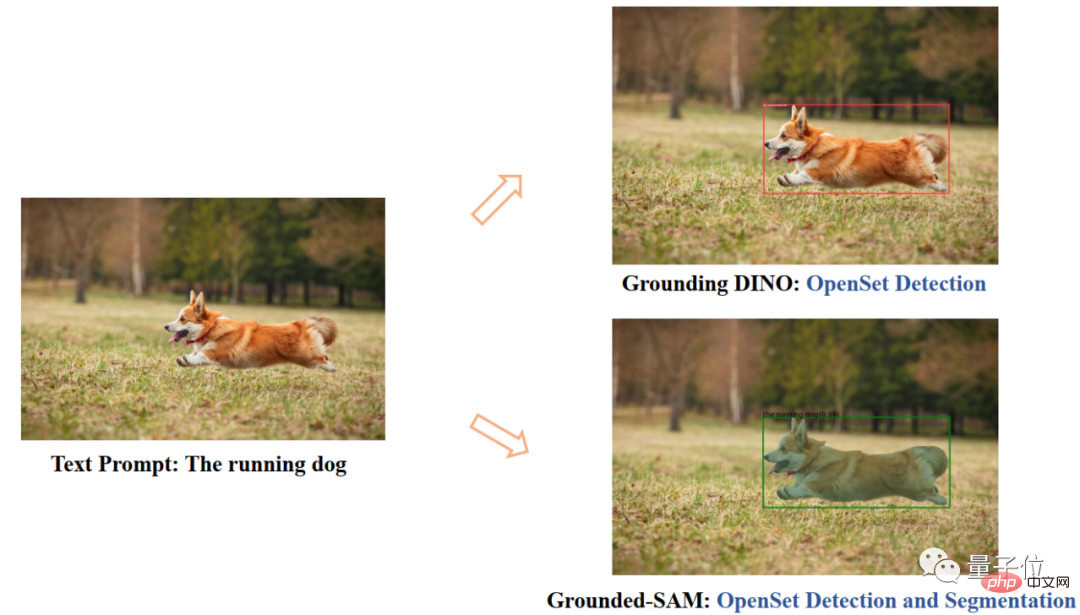

Grounded SAM besteht hauptsächlich aus zwei Modellen: Grounding DINO und SAM.

Unter diesen ist SAM (Segment Anything) ein Zero-Sample-Segmentierungsmodell, das Meta erst vor 4 Tagen eingeführt hat.

Es können Masken für alle Objekte in Bildern/Videos generiert werden, einschließlich Objekten und Bildern, die während des Trainingsprozesses nicht erschienen sind.

Indem SAM eine gültige Maske für jede Eingabeaufforderung zurückgibt, kann das Modell eine sinnvolle Maske unter allen Möglichkeiten ausgeben, selbst wenn die Eingabeaufforderung mehrdeutig ist oder auf mehrere Objekte verweist. Diese Aufgabe wird verwendet, um das Modell vorab zu trainieren und allgemeine nachgelagerte Segmentierungsaufgaben über Hinweise zu lösen.

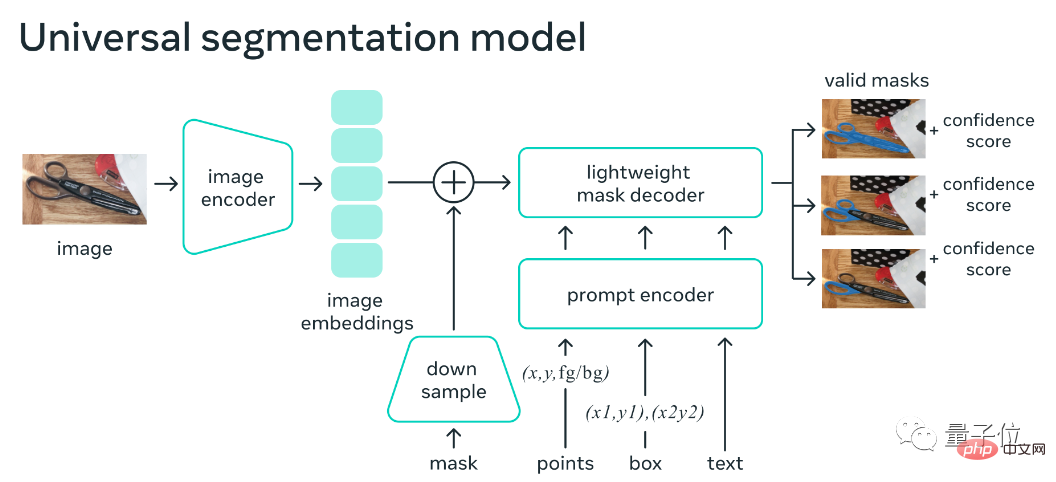

Das Modell-Framework besteht hauptsächlich aus einem Bild-Encoder, einem Hinweis-Encoder und einem schnellen Masken-Decoder. Nach der Berechnung der Bildeinbettung ist SAM in der Lage, innerhalb von 50 Millisekunden eine Segmentierung basierend auf einer beliebigen Eingabeaufforderung im Web zu generieren.

Die Erdung von DINO ist eine bestehende Errungenschaft dieses Forschungsteams.

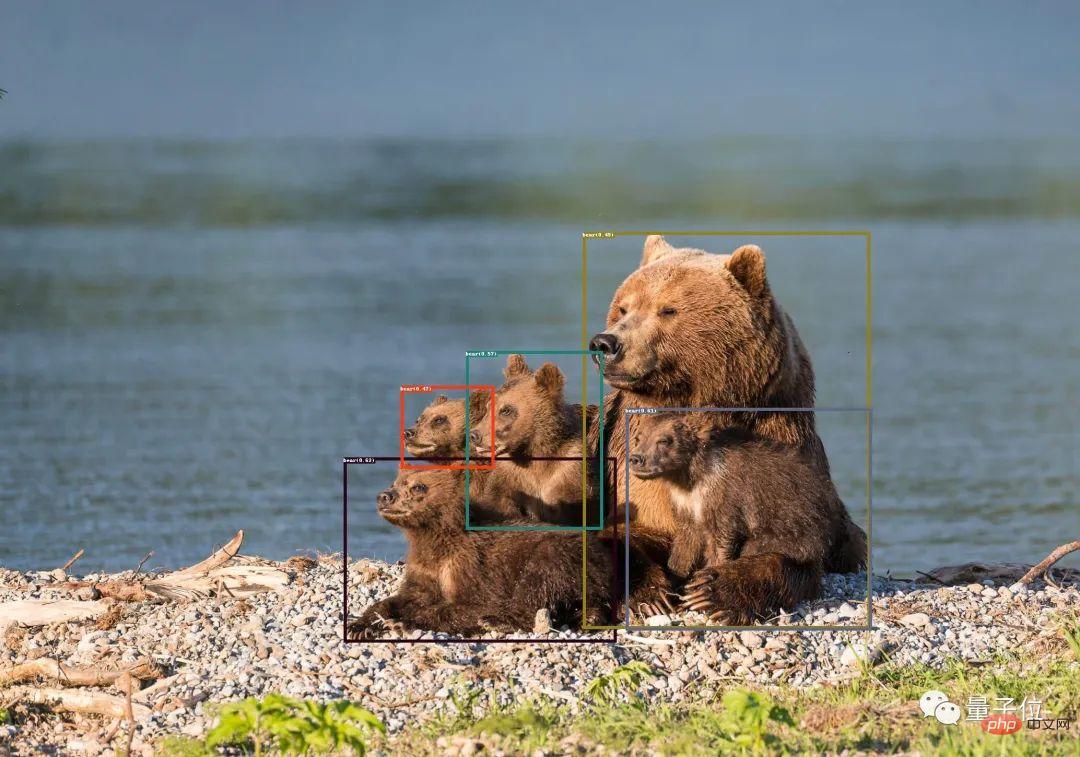

Dies ist ein Zero-Shot-Erkennungsmodell, das Objektboxen und Beschriftungen mit Textbeschreibungen generieren kann.

Nachdem Sie beides kombiniert haben, können Sie jedes Objekt im Bild anhand der Textbeschreibung finden und dann die leistungsstarken Segmentierungsfunktionen von SAM verwenden, um die Maske feinkörnig zu segmentieren.

Zusätzlich zu diesen Funktionen Sie überlagern auch die Fähigkeit der stabilen Diffusion, der eingangs gezeigten steuerbaren Bilderzeugung.

Es ist erwähnenswert, dass Stable Diffusion zuvor ähnliche Funktionen erreichen konnte. Löschen Sie einfach die Bildelemente, die Sie ersetzen möchten, und geben Sie die Textaufforderung ein.

Dieses Mal kann Grounded SAM den Schritt der manuellen Auswahl einsparen und ihn direkt über die Textbeschreibung steuern.

Darüber hinaus werden in Kombination mit BLIP (Bootstrapping Language-Image Pre-training) Bildtitel generiert, Beschriftungen extrahiert und anschließend Objektboxen und Masken generiert.

Derzeit sind weitere interessante Funktionen in der Entwicklung.

Zum Beispiel einige Erweiterungen der Charaktere: Änderung der Kleidung, Haarfarbe, Hautfarbe usw.

Die spezifische Verbrauchsmethode wurde auch auf GitHub angegeben. Das Projekt erfordert Python 3.8 oder höher, Pytorch 1.7 oder höher, Torchvision 0.8 oder höher und relevante Abhängigkeiten müssen installiert sein. Spezifische Inhalte finden Sie auf der GitHub-Projektseite.

Das Forschungsteam stammt vom IDEA Research Institute (Guangdong-Hong Kong-Macao Greater Bay Area Digital Economy Research Institute).

Öffentliche Informationen zeigen, dass das Institut eine internationale innovative Forschungseinrichtung für künstliche Intelligenz, digitale Wirtschaftsindustrie und Spitzentechnologie ist. Der ehemalige Chefwissenschaftler des Microsoft Asia Research Institute und der ehemalige Vizepräsident von Microsoft Global Intelligence Dr fungiert als Gründerperson und Vorsitzender.

Noch etwasFür die zukünftige Arbeit von Grounded SAM hat das Team mehrere Perspektiven:- Bilder automatisch generieren, um einen neuen Datensatz zu bilden

- Leistungsstarkes Basismodell mit Segmentierungs-Vorschulung

- Kooperieren mit (Chat- )GPT

- Bilden Sie eine Pipeline, die automatisch Bildbeschriftungen, Boxen und Masken generiert und neue Bilder generieren kann.

Das obige ist der detaillierte Inhalt vonEinheitliche visuelle KI-Funktionen! Automatisierte Bilderkennung und -segmentierung sowie kontrollierbare vinzentinische Bilder, erstellt von einem chinesischen Team. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1374

1374

52

52

Welche Methode wird verwendet, um Strings in Objekte in Vue.js umzuwandeln?

Apr 07, 2025 pm 09:39 PM

Welche Methode wird verwendet, um Strings in Objekte in Vue.js umzuwandeln?

Apr 07, 2025 pm 09:39 PM

Bei der Konvertierung von Zeichenfolgen in Objekte in Vue.js wird JSON.Parse () für Standard -JSON -Zeichenfolgen bevorzugt. Bei nicht standardmäßigen JSON-Zeichenfolgen kann die Zeichenfolge durch Verwendung regelmäßiger Ausdrücke verarbeitet und Methoden gemäß dem Format oder dekodierten URL-kodiert reduziert werden. Wählen Sie die entsprechende Methode gemäß dem String -Format aus und achten Sie auf Sicherheits- und Codierungsprobleme, um Fehler zu vermeiden.

VUE.JS Wie kann man ein Array von String -Typ in ein Array von Objekten umwandeln?

Apr 07, 2025 pm 09:36 PM

VUE.JS Wie kann man ein Array von String -Typ in ein Array von Objekten umwandeln?

Apr 07, 2025 pm 09:36 PM

Zusammenfassung: Es gibt die folgenden Methoden zum Umwandeln von VUE.JS -String -Arrays in Objektarrays: Grundlegende Methode: Verwenden Sie die Kartenfunktion, um regelmäßige formatierte Daten zu entsprechen. Erweitertes Gameplay: Die Verwendung regulärer Ausdrücke kann komplexe Formate ausführen, müssen jedoch sorgfältig geschrieben und berücksichtigt werden. Leistungsoptimierung: In Betracht ziehen die große Datenmenge, asynchrone Operationen oder effiziente Datenverarbeitungsbibliotheken können verwendet werden. Best Practice: Clear Code -Stil, verwenden Sie sinnvolle variable Namen und Kommentare, um den Code präzise zu halten.

Remote Senior Backend Engineers (Plattformen) benötigen Kreise

Apr 08, 2025 pm 12:27 PM

Remote Senior Backend Engineers (Plattformen) benötigen Kreise

Apr 08, 2025 pm 12:27 PM

Remote Senior Backend Engineer Job Vacant Company: Circle Standort: Remote-Büro-Jobtyp: Vollzeitgehalt: 130.000 bis 140.000 US-Dollar Stellenbeschreibung Nehmen Sie an der Forschung und Entwicklung von Mobilfunkanwendungen und öffentlichen API-bezogenen Funktionen, die den gesamten Lebenszyklus der Softwareentwicklung abdecken. Die Hauptaufgaben erledigen die Entwicklungsarbeit unabhängig von RubyonRails und arbeiten mit dem Front-End-Team von React/Redux/Relay zusammen. Erstellen Sie die Kernfunktionalität und -verbesserungen für Webanwendungen und arbeiten Sie eng mit Designer und Führung während des gesamten funktionalen Designprozesses zusammen. Fördern Sie positive Entwicklungsprozesse und priorisieren Sie die Iterationsgeschwindigkeit. Erfordert mehr als 6 Jahre komplexes Backend für Webanwendungen

Vue- und Element-UI-Kaskaden-Dropdown-Box V-Model-Bindung

Apr 07, 2025 pm 08:06 PM

Vue- und Element-UI-Kaskaden-Dropdown-Box V-Model-Bindung

Apr 07, 2025 pm 08:06 PM

Vue- und Element-UI-kaskadierte Dropdown-Boxen V-Model-Bindung gemeinsame Grubenpunkte: V-Model bindet ein Array, das die ausgewählten Werte auf jeder Ebene des kaskadierten Auswahlfelds darstellt, nicht auf einer Zeichenfolge; Der Anfangswert von ausgewählten Optionen muss ein leeres Array sein, nicht null oder undefiniert. Die dynamische Belastung von Daten erfordert die Verwendung asynchroner Programmierkenntnisse, um Datenaktualisierungen asynchron zu verarbeiten. Für riesige Datensätze sollten Leistungsoptimierungstechniken wie virtuelles Scrollen und fauler Laden in Betracht gezogen werden.

So stellen Sie die Zeitüberschreitung von Vue Axios fest

Apr 07, 2025 pm 10:03 PM

So stellen Sie die Zeitüberschreitung von Vue Axios fest

Apr 07, 2025 pm 10:03 PM

Um die Zeitüberschreitung für Vue Axios festzulegen, können wir eine Axios -Instanz erstellen und die Zeitleitungsoption angeben: in globalen Einstellungen: vue.Prototyp. $ Axios = axios.create ({Timeout: 5000}); In einer einzigen Anfrage: this. $ axios.get ('/api/user', {timeout: 10000}).

Laravels Geospatial: Optimierung interaktiver Karten und großen Datenmengen

Apr 08, 2025 pm 12:24 PM

Laravels Geospatial: Optimierung interaktiver Karten und großen Datenmengen

Apr 08, 2025 pm 12:24 PM

Verarbeiten Sie 7 Millionen Aufzeichnungen effizient und erstellen Sie interaktive Karten mit Geospatial -Technologie. In diesem Artikel wird untersucht, wie über 7 Millionen Datensätze mithilfe von Laravel und MySQL effizient verarbeitet und in interaktive Kartenvisualisierungen umgewandelt werden können. Erstes Herausforderungsprojektanforderungen: Mit 7 Millionen Datensätzen in der MySQL -Datenbank wertvolle Erkenntnisse extrahieren. Viele Menschen erwägen zunächst Programmiersprachen, aber ignorieren die Datenbank selbst: Kann sie den Anforderungen erfüllen? Ist Datenmigration oder strukturelle Anpassung erforderlich? Kann MySQL einer so großen Datenbelastung standhalten? Voranalyse: Schlüsselfilter und Eigenschaften müssen identifiziert werden. Nach der Analyse wurde festgestellt, dass nur wenige Attribute mit der Lösung zusammenhängen. Wir haben die Machbarkeit des Filters überprüft und einige Einschränkungen festgelegt, um die Suche zu optimieren. Kartensuche basierend auf der Stadt

So verwenden Sie MySQL nach der Installation

Apr 08, 2025 am 11:48 AM

So verwenden Sie MySQL nach der Installation

Apr 08, 2025 am 11:48 AM

Der Artikel führt den Betrieb der MySQL -Datenbank vor. Zunächst müssen Sie einen MySQL -Client wie MySQLworkBench oder Befehlszeilen -Client installieren. 1. Verwenden Sie den Befehl mySQL-uroot-P, um eine Verbindung zum Server herzustellen und sich mit dem Stammkonto-Passwort anzumelden. 2. Verwenden Sie die Erstellung von Createdatabase, um eine Datenbank zu erstellen, und verwenden Sie eine Datenbank aus. 3.. Verwenden Sie CreateTable, um eine Tabelle zu erstellen, Felder und Datentypen zu definieren. 4. Verwenden Sie InsertInto, um Daten einzulegen, Daten abzufragen, Daten nach Aktualisierung zu aktualisieren und Daten nach Löschen zu löschen. Nur indem Sie diese Schritte beherrschen, lernen, mit gemeinsamen Problemen umzugehen und die Datenbankleistung zu optimieren, können Sie MySQL effizient verwenden.

Wie man MySQL löst, kann nicht gestartet werden

Apr 08, 2025 pm 02:21 PM

Wie man MySQL löst, kann nicht gestartet werden

Apr 08, 2025 pm 02:21 PM

Es gibt viele Gründe, warum MySQL Startup fehlschlägt und durch Überprüfung des Fehlerprotokolls diagnostiziert werden kann. Zu den allgemeinen Ursachen gehören Portkonflikte (prüfen Portbelegung und Änderung der Konfiguration), Berechtigungsprobleme (Überprüfen Sie den Dienst Ausführen von Benutzerberechtigungen), Konfigurationsdateifehler (Überprüfung der Parametereinstellungen), Datenverzeichniskorruption (Wiederherstellung von Daten oder Wiederaufbautabellenraum), InnoDB-Tabellenraumprobleme (prüfen IBDATA1-Dateien), Plug-in-Ladeversagen (Überprüfen Sie Fehlerprotokolle). Wenn Sie Probleme lösen, sollten Sie sie anhand des Fehlerprotokolls analysieren, die Hauptursache des Problems finden und die Gewohnheit entwickeln, Daten regelmäßig zu unterstützen, um Probleme zu verhindern und zu lösen.