Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

ImageNet-Labelfehler entfernt, Modellranking erheblich geändert

ImageNet-Labelfehler entfernt, Modellranking erheblich geändert

ImageNet-Labelfehler entfernt, Modellranking erheblich geändert

Früher wurde ImageNet aufgrund des Problems der Etikettenfehler zu einem heißen Thema. Sie werden überrascht sein, diese Zahl zu hören. Es gibt mindestens 100.000 Etiketten mit Problemen. Studien, die auf falschen Etiketten basieren, müssen möglicherweise annulliert und wiederholt werden.

Aus dieser Sicht ist die Verwaltung der Qualität des Datensatzes immer noch sehr wichtig.

Viele Menschen verwenden den ImageNet-Datensatz als Benchmark, aber basierend auf vorab trainierten ImageNet-Modellen können die Endergebnisse aufgrund der Datenqualität variieren.

In diesem Artikel untersucht Kenichi Higuchi, ein Ingenieur von Adansons Company, den ImageNet-Datensatz im Artikel „Sind wir mit ImageNet fertig?“ erneut und bewertet ihn nach dem Entfernen erneut Die falschen Etikettendaten. Das Modell wurde auf Torchvision veröffentlicht.

Fehlerhafte Daten aus ImageNet entfernen und das Modell neu bewerten

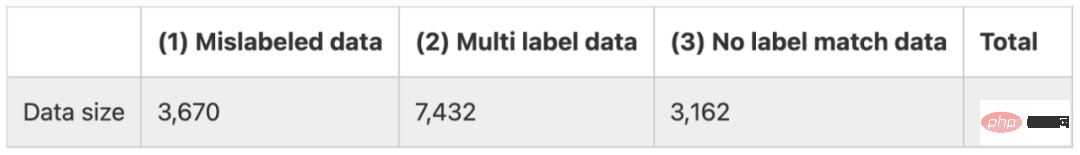

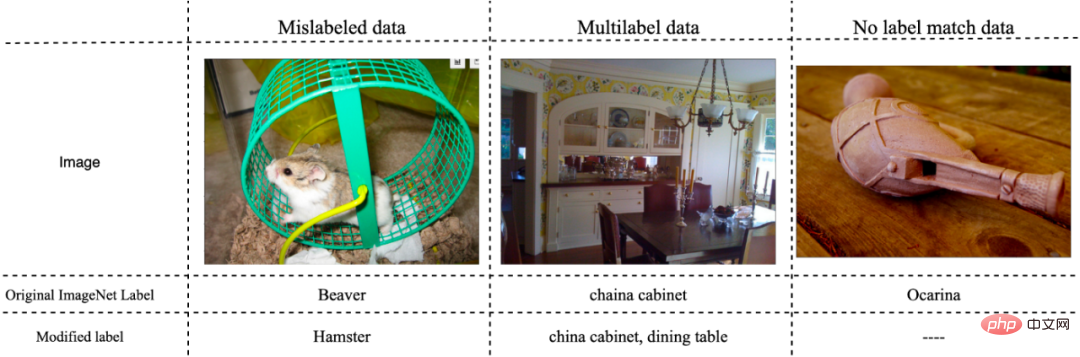

Dieses Dokument unterteilt Beschriftungsfehler in ImageNet in drei Kategorien, wie unten gezeigt.

(1) Daten mit falscher Beschriftung

(2) Daten, die mehreren Beschriftungen entsprechen

(3) Gehört nicht zu beliebige Etikettendaten

Methode

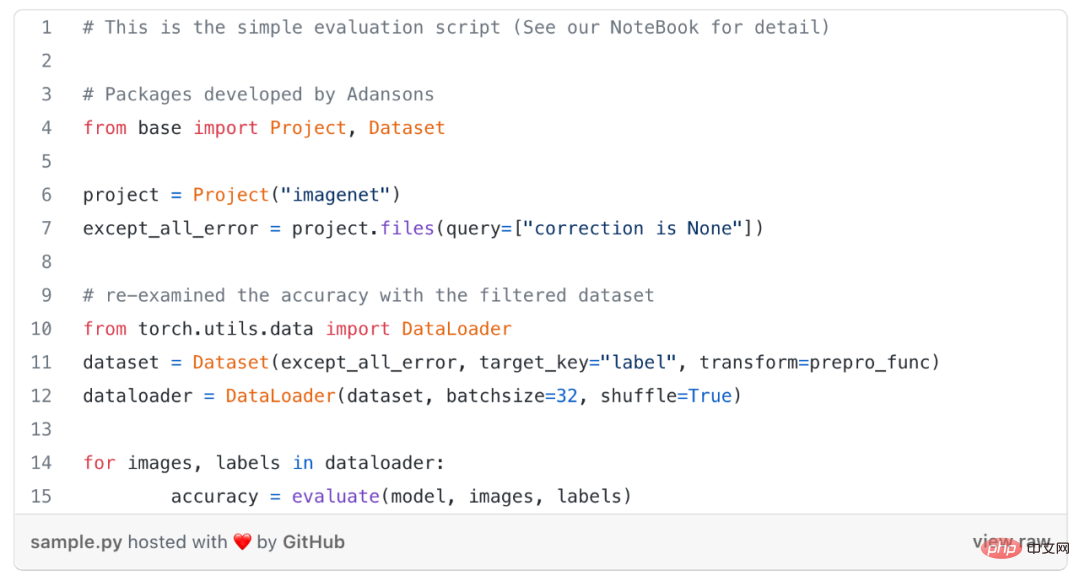

Ohne Umschulung des Modells wurde diese Studie untersucht die Genauigkeit des Modells, indem nur falsch gekennzeichnete Daten, d. h. die oben genannten Fehlerdaten vom Typ (1), und alle falschen Daten aus den Bewertungsdaten, d. h. (1)–(3) Fehlerdaten, ausgeschlossen werden.

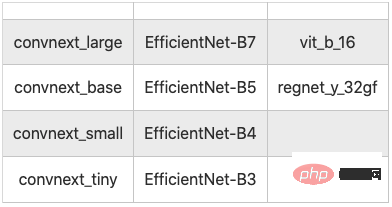

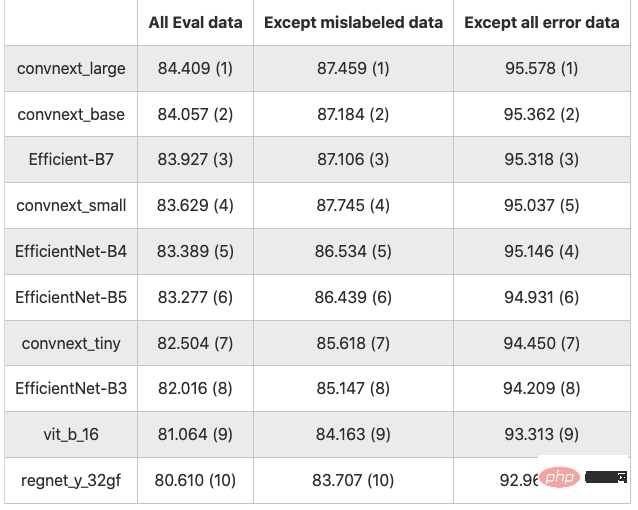

#🎜🎜 #Die Ergebnisse sind in der folgenden Tabelle aufgeführt (Werte sind Genauigkeit in %, Zahlen in Klammern sind Rangfolgen)

Die Ergebnisse von 10 Klassifizierungsmodellen

Nimmt man alle Eval-Daten als Basis, mit Ausnahme falscher Datentypen (1), erhöht sich die Genauigkeit um durchschnittlich 3,122 Punkte, ohne alle falschen Daten (1)~ (3) stieg die Genauigkeit um durchschnittlich 11.743 Punkte.

Wie erwartet ist die Genauigkeitsrate durchweg verbessert, wenn man fehlerhafte Daten ausschließt. Es besteht kein Zweifel daran, dass fehlerhafte Daten im Vergleich zu sauberen Daten fehleranfällig sind.

Wie erwartet ist die Genauigkeitsrate durchweg verbessert, wenn man fehlerhafte Daten ausschließt. Es besteht kein Zweifel daran, dass fehlerhafte Daten im Vergleich zu sauberen Daten fehleranfällig sind.

Bei der Auswertung ohne Ausschluss fehlerhafter Daten und wenn alle fehlerhaften Daten (1) bis (3) ausgeschlossen werden, ändert sich die Genauigkeitsbewertung des Modells.

In diesem Artikel gibt es 3.670 fehlerhafte Daten (1), was 7,34 % der insgesamt 50.000 Daten ausmacht. Nach dem Entfernen stieg die Genauigkeitsrate im Durchschnitt um etwa 3,22 Punkte . Wenn fehlerhafte Daten entfernt werden, ändert sich der Datenmaßstab und ein einfacher Vergleich der Genauigkeitsraten kann verzerrt sein.

Fazit

Obwohl dies nicht ausdrücklich betont wird, ist es wichtig, bei der Durchführung des Bewertungstrainings genau gekennzeichnete Daten zu verwenden.

Frühere Studien haben beim Vergleich der Genauigkeit zwischen Modellen möglicherweise falsche Schlussfolgerungen gezogen. Die Daten sollten also zunächst ausgewertet werden, aber lässt sich damit wirklich die Leistung des Modells bewerten?

Viele Modelle, die Deep Learning verwenden, scheuen es oft, über die Daten nachzudenken, sind aber bestrebt, die Genauigkeit und andere Bewertungsmetriken durch die Leistung des Modells zu verbessern, selbst wenn die Bewertungsdaten Fehler enthalten Daten werden nicht korrekt verarbeitet.

Bei der Erstellung eigener Datensätze, beispielsweise bei der Anwendung von KI in Unternehmen, steht die Erstellung hochwertiger Datensätze in direktem Zusammenhang mit der Verbesserung der Genauigkeit und Zuverlässigkeit der KI. Die experimentellen Ergebnisse dieser Arbeit zeigen, dass eine einfache Verbesserung der Datenqualität die Genauigkeit um etwa 10 Prozentpunkte verbessern kann, was zeigt, wie wichtig es ist, bei der Entwicklung von KI-Systemen nicht nur das Modell, sondern auch den Datensatz zu verbessern.

Allerdings ist es nicht einfach, die Qualität des Datensatzes sicherzustellen. Während die Erhöhung der Metadatenmenge wichtig ist, um die Qualität von KI-Modellen und -Daten richtig einzuschätzen, kann die Verwaltung insbesondere bei unstrukturierten Daten umständlich sein.

Das obige ist der detaillierte Inhalt vonImageNet-Labelfehler entfernt, Modellranking erheblich geändert. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1376

1376

52

52

Laravels Geospatial: Optimierung interaktiver Karten und großen Datenmengen

Apr 08, 2025 pm 12:24 PM

Laravels Geospatial: Optimierung interaktiver Karten und großen Datenmengen

Apr 08, 2025 pm 12:24 PM

Verarbeiten Sie 7 Millionen Aufzeichnungen effizient und erstellen Sie interaktive Karten mit Geospatial -Technologie. In diesem Artikel wird untersucht, wie über 7 Millionen Datensätze mithilfe von Laravel und MySQL effizient verarbeitet und in interaktive Kartenvisualisierungen umgewandelt werden können. Erstes Herausforderungsprojektanforderungen: Mit 7 Millionen Datensätzen in der MySQL -Datenbank wertvolle Erkenntnisse extrahieren. Viele Menschen erwägen zunächst Programmiersprachen, aber ignorieren die Datenbank selbst: Kann sie den Anforderungen erfüllen? Ist Datenmigration oder strukturelle Anpassung erforderlich? Kann MySQL einer so großen Datenbelastung standhalten? Voranalyse: Schlüsselfilter und Eigenschaften müssen identifiziert werden. Nach der Analyse wurde festgestellt, dass nur wenige Attribute mit der Lösung zusammenhängen. Wir haben die Machbarkeit des Filters überprüft und einige Einschränkungen festgelegt, um die Suche zu optimieren. Kartensuche basierend auf der Stadt

Wie man MySQL löst, kann nicht gestartet werden

Apr 08, 2025 pm 02:21 PM

Wie man MySQL löst, kann nicht gestartet werden

Apr 08, 2025 pm 02:21 PM

Es gibt viele Gründe, warum MySQL Startup fehlschlägt und durch Überprüfung des Fehlerprotokolls diagnostiziert werden kann. Zu den allgemeinen Ursachen gehören Portkonflikte (prüfen Portbelegung und Änderung der Konfiguration), Berechtigungsprobleme (Überprüfen Sie den Dienst Ausführen von Benutzerberechtigungen), Konfigurationsdateifehler (Überprüfung der Parametereinstellungen), Datenverzeichniskorruption (Wiederherstellung von Daten oder Wiederaufbautabellenraum), InnoDB-Tabellenraumprobleme (prüfen IBDATA1-Dateien), Plug-in-Ladeversagen (Überprüfen Sie Fehlerprotokolle). Wenn Sie Probleme lösen, sollten Sie sie anhand des Fehlerprotokolls analysieren, die Hauptursache des Problems finden und die Gewohnheit entwickeln, Daten regelmäßig zu unterstützen, um Probleme zu verhindern und zu lösen.

So verwenden Sie MySQL nach der Installation

Apr 08, 2025 am 11:48 AM

So verwenden Sie MySQL nach der Installation

Apr 08, 2025 am 11:48 AM

Der Artikel führt den Betrieb der MySQL -Datenbank vor. Zunächst müssen Sie einen MySQL -Client wie MySQLworkBench oder Befehlszeilen -Client installieren. 1. Verwenden Sie den Befehl mySQL-uroot-P, um eine Verbindung zum Server herzustellen und sich mit dem Stammkonto-Passwort anzumelden. 2. Verwenden Sie die Erstellung von Createdatabase, um eine Datenbank zu erstellen, und verwenden Sie eine Datenbank aus. 3.. Verwenden Sie CreateTable, um eine Tabelle zu erstellen, Felder und Datentypen zu definieren. 4. Verwenden Sie InsertInto, um Daten einzulegen, Daten abzufragen, Daten nach Aktualisierung zu aktualisieren und Daten nach Löschen zu löschen. Nur indem Sie diese Schritte beherrschen, lernen, mit gemeinsamen Problemen umzugehen und die Datenbankleistung zu optimieren, können Sie MySQL effizient verwenden.

Kann MySQL JSON zurückgeben?

Apr 08, 2025 pm 03:09 PM

Kann MySQL JSON zurückgeben?

Apr 08, 2025 pm 03:09 PM

MySQL kann JSON -Daten zurückgeben. Die JSON_EXTRACT -Funktion extrahiert Feldwerte. Über komplexe Abfragen sollten Sie die Where -Klausel verwenden, um JSON -Daten zu filtern, aber auf die Leistungsauswirkungen achten. Die Unterstützung von MySQL für JSON nimmt ständig zu, und es wird empfohlen, auf die neuesten Versionen und Funktionen zu achten.

Remote Senior Backend Engineers (Plattformen) benötigen Kreise

Apr 08, 2025 pm 12:27 PM

Remote Senior Backend Engineers (Plattformen) benötigen Kreise

Apr 08, 2025 pm 12:27 PM

Remote Senior Backend Engineer Job Vacant Company: Circle Standort: Remote-Büro-Jobtyp: Vollzeitgehalt: 130.000 bis 140.000 US-Dollar Stellenbeschreibung Nehmen Sie an der Forschung und Entwicklung von Mobilfunkanwendungen und öffentlichen API-bezogenen Funktionen, die den gesamten Lebenszyklus der Softwareentwicklung abdecken. Die Hauptaufgaben erledigen die Entwicklungsarbeit unabhängig von RubyonRails und arbeiten mit dem Front-End-Team von React/Redux/Relay zusammen. Erstellen Sie die Kernfunktionalität und -verbesserungen für Webanwendungen und arbeiten Sie eng mit Designer und Führung während des gesamten funktionalen Designprozesses zusammen. Fördern Sie positive Entwicklungsprozesse und priorisieren Sie die Iterationsgeschwindigkeit. Erfordert mehr als 6 Jahre komplexes Backend für Webanwendungen

Verstehen von Säureeigenschaften: Die Säulen einer zuverlässigen Datenbank

Apr 08, 2025 pm 06:33 PM

Verstehen von Säureeigenschaften: Die Säulen einer zuverlässigen Datenbank

Apr 08, 2025 pm 06:33 PM

Detaillierte Erläuterung von Datenbanksäureattributen Säureattribute sind eine Reihe von Regeln, um die Zuverlässigkeit und Konsistenz von Datenbanktransaktionen sicherzustellen. Sie definieren, wie Datenbanksysteme Transaktionen umgehen, und sorgen dafür, dass die Datenintegrität und -genauigkeit auch im Falle von Systemabstürzen, Leistungsunterbrechungen oder mehreren Benutzern gleichzeitiger Zugriff. Säureattributübersicht Atomizität: Eine Transaktion wird als unteilbare Einheit angesehen. Jeder Teil schlägt fehl, die gesamte Transaktion wird zurückgerollt und die Datenbank behält keine Änderungen bei. Wenn beispielsweise eine Banküberweisung von einem Konto abgezogen wird, jedoch nicht auf ein anderes erhöht wird, wird der gesamte Betrieb widerrufen. begintransaktion; updateAccountsSetBalance = Balance-100WH

MySQL kann nach dem Herunterladen nicht installiert werden

Apr 08, 2025 am 11:24 AM

MySQL kann nach dem Herunterladen nicht installiert werden

Apr 08, 2025 am 11:24 AM

Die Hauptgründe für den Fehler bei MySQL -Installationsfehlern sind: 1. Erlaubnisprobleme, Sie müssen als Administrator ausgeführt oder den Sudo -Befehl verwenden. 2. Die Abhängigkeiten fehlen, und Sie müssen relevante Entwicklungspakete installieren. 3. Portkonflikte müssen Sie das Programm schließen, das Port 3306 einnimmt, oder die Konfigurationsdatei ändern. 4. Das Installationspaket ist beschädigt. Sie müssen die Integrität herunterladen und überprüfen. 5. Die Umgebungsvariable ist falsch konfiguriert und die Umgebungsvariablen müssen korrekt entsprechend dem Betriebssystem konfiguriert werden. Lösen Sie diese Probleme und überprüfen Sie jeden Schritt sorgfältig, um MySQL erfolgreich zu installieren.

Der Hauptschlüssel von MySQL kann null sein

Apr 08, 2025 pm 03:03 PM

Der Hauptschlüssel von MySQL kann null sein

Apr 08, 2025 pm 03:03 PM

Der MySQL -Primärschlüssel kann nicht leer sein, da der Primärschlüssel ein Schlüsselattribut ist, das jede Zeile in der Datenbank eindeutig identifiziert. Wenn der Primärschlüssel leer sein kann, kann der Datensatz nicht eindeutig identifiziert werden, was zu Datenverwirrung führt. Wenn Sie selbstsinkrementelle Ganzzahlsspalten oder UUIDs als Primärschlüssel verwenden, sollten Sie Faktoren wie Effizienz und Raumbelegung berücksichtigen und eine geeignete Lösung auswählen.