Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

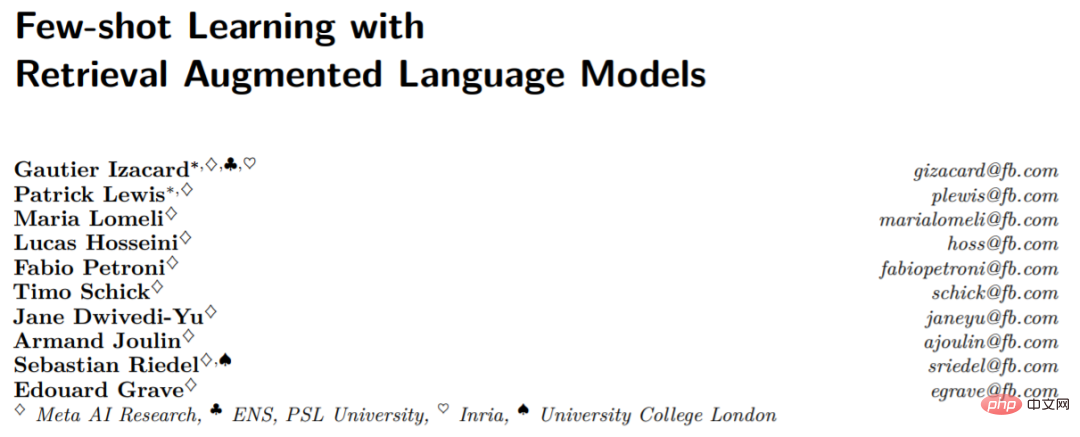

Die Anzahl der Parameter beträgt 1/50, Meta veröffentlicht ein 11-Milliarden-Parametermodell und besiegt damit Google PaLM

Die Anzahl der Parameter beträgt 1/50, Meta veröffentlicht ein 11-Milliarden-Parametermodell und besiegt damit Google PaLM

Die Anzahl der Parameter beträgt 1/50, Meta veröffentlicht ein 11-Milliarden-Parametermodell und besiegt damit Google PaLM

Wir können große Sprachmodelle (LLMs) als Lernende mit kleinen Stichproben verstehen, die mit wenigen Beispielen oder sogar mit einfachen Anweisungen neue Aufgaben erlernen können, wobei das Modell die Anzahl der Parameter und die Größe skaliert Die Trainingsdaten sind der Schlüssel zur Generalisierungsfähigkeit des Modells. Diese Verbesserung bei LLMs ist auf größere Rechenleistung und Speicherkapazitäten zurückzuführen. Intuitiv führen verbesserte Inferenzfähigkeiten zu einer besseren Generalisierung und damit zu weniger Stichprobenlernen. Es ist jedoch unklar, inwieweit effektives Lernen kleiner Stichproben umfassende Kenntnisse der Modellparameter erfordert.

Bisher haben Retrieval-Enhancement-Modelle keine überzeugenden Lernfähigkeiten für kleine Stichproben gezeigt. In der Arbeit fragen Forscher von Meta AI Research und anderen Institutionen, ob das Lernen in kleinen Stichproben erfordert, dass das Modell eine große Menge an Informationen in seinen Parametern speichert, und ob die Speicherung von der Generalisierung entkoppelt werden kann. Sie schlugen Atlas vor, eine Art abrufgestütztes Sprachmodell, das über starke Lernfähigkeiten für kleine Stichproben verfügt, auch wenn die Anzahl der Parameter geringer ist als bei anderen aktuellen leistungsstarken Lernmodellen für kleine Stichproben.

Das Modell verwendet nichtparametrische Speicherung, das heißt, es werden neuronale Retriever verwendet, die auf großen externen nichtstatischen Wissensquellen basieren, um das parametrische Sprachmodell zu verbessern. Zusätzlich zu den Speicherfähigkeiten sind solche Architekturen aufgrund ihrer Vorteile in Bezug auf Anpassungsfähigkeit, Interpretierbarkeit und Effizienz attraktiv.

Papieradresse: https://arxiv.org /pdf/2208.03299.pdf

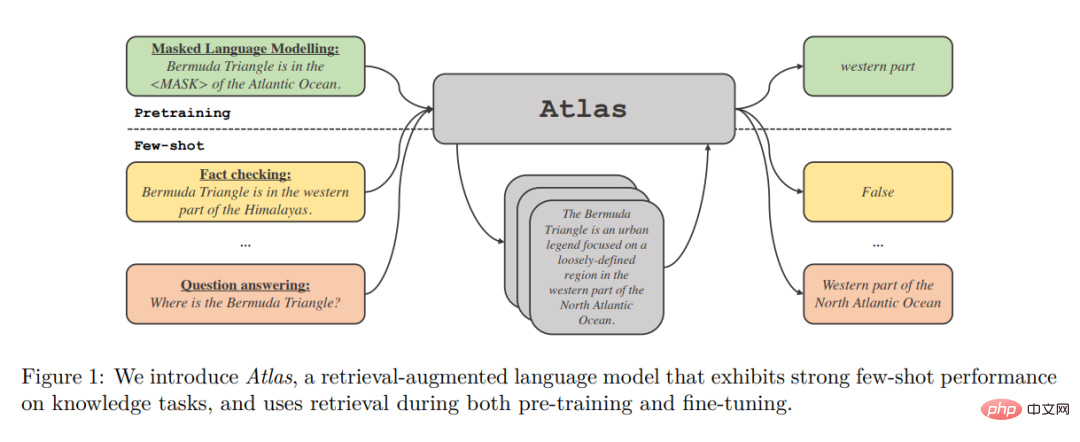

Atlas Retrieval of Related Documents ist ein universeller Dichte-Retriever, der auf der Contriever-Dual-Encoder-Architektur beim Abrufen von Dateien basiert Es basiert auf dem aktuellen Kontext, um verwandte Dokumente abzurufen. Die abgerufenen Dokumente werden zusammen mit dem aktuellen Kontext von einem Sequenz-zu-Sequenz-Modell verarbeitet, das die Fusion-in-Decoder-Architektur verwendet, um die entsprechende Ausgabe zu generieren.

Die Autoren untersuchten die Auswirkungen verschiedener Techniken auf die Leistung des Trainingsatlas an einem kleinen Beispieldatensatz für eine Reihe nachgelagerter Aufgaben, einschließlich der Beantwortung von Fragen und der Überprüfung von Fakten. Die Studie ergab, dass die gemeinsame Vortrainingskomponente für die Leistung bei kleinen Stichproben von entscheidender Bedeutung ist, und die Autoren bewerteten viele bestehende und neuartige Vortrainingsaufgaben und -schemata. Atlas weist sowohl in Umgebungen mit kleinen Stichproben als auch in ressourcenreichen Umgebungen eine starke nachgelagerte Leistung auf.

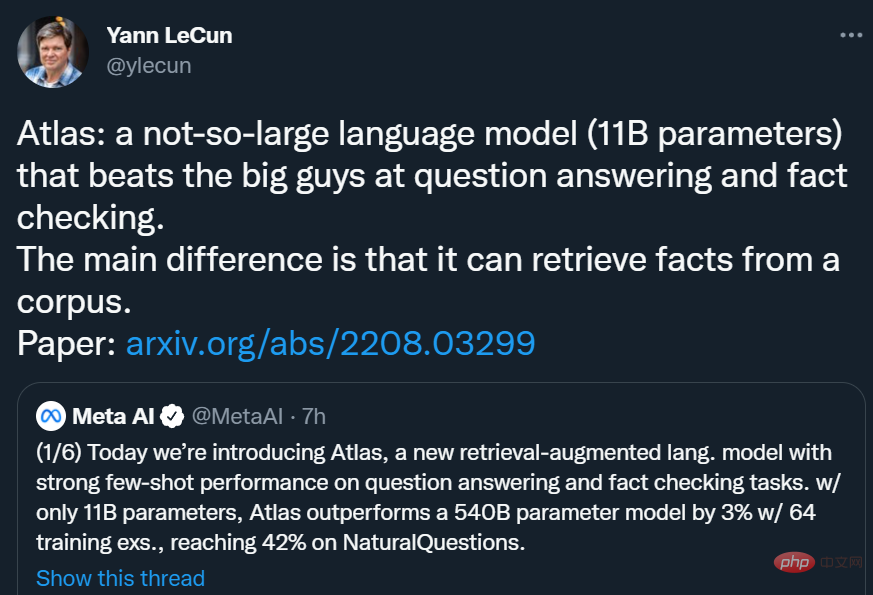

Mit nur 11B Parametern erreichte Atlas bei NaturalQuestions (NQ) unter Verwendung von 64 Trainingsbeispielen eine Genauigkeit von 42,4 %, was besser ist als das 540B-Parametermodell PaLM (39,6 %). fast 3 Prozentpunkte höher und erreicht eine Genauigkeit von 64,0 % in der Einstellung „Vollständiger Datensatz“.

Yann LeCun sagte: Atlas ist ein nicht allzu großes Sprachmodell ( 11B-Parameter), die „Großen“ bei Fragen und Antworten und Faktenchecks schlagen. Der Hauptunterschied von Atlas besteht darin, dass es Fakten aus einem Korpus abrufen kann.

Methodenübersicht

Atlas Folgen Sie dem Text zum Textrahmen. Das bedeutet, dass der allgemeine Rahmen aller Aufgaben so ist: Das System nimmt eine Textabfrage als Eingabe und generiert eine Textausgabe. Bei Frage-Antwort-Aufgaben entspricht beispielsweise die Anfrage einer Frage und das Modell muss eine Antwort generieren. Bei Klassifikationsaufgaben entspricht die Abfrage einer Texteingabe und das Modell generiert Klassenlabels, also die den Labels entsprechenden Wörter. Der KILT-Benchmark in Abbildung 2 enthält weitere Beispiele für nachgelagerte Aufgaben. Viele Aufgaben zur Verarbeitung natürlicher Sprache erfordern Kenntnisse, und Atlas zielt darauf ab, Standard-Text-zu-Text-Modelle durch Retrieval zu verbessern, da Retrieval für die Lernfähigkeit des Modells in Szenarien mit kleinen Stichproben von entscheidender Bedeutung sein kann. Das Atlas-Modell basiert auf zwei Untermodellen: Retriever- und Sprachmodellen. Bei der Ausführung einer Aufgabe, von der Beantwortung von Fragen bis zur Generierung von Wikipedia-Artikeln, ruft das Modell zunächst über einen Retriever die k relevantesten Dokumente aus einem großen Textkorpus ab. Diese Dokumente werden dann zusammen mit der Abfrage als Eingabe an das Sprachmodell übergeben, das eine Ausgabe generiert. Sowohl der Retriever als auch das Sprachmodell basieren auf vorab trainierten Transformatornetzwerken, die im Folgenden ausführlich beschrieben werden.

Abruf: Das Retriever-Modul von Atlas basiert auf Contriever, einer Informationsabruftechnologie, die auf kontinuierlicher Dichteeinbettung basiert. Contriever verwendet eine Dual-Encoder-Architektur, bei der Abfragen und Dokumente unabhängig voneinander durch Transformer-Encoder eingebettet werden. Auf die Ausgabe der letzten Ebene wird ein durchschnittliches Pooling angewendet, um eine Vektordarstellung jeder Abfrage oder jedes Dokuments zu erhalten. Durch die Berechnung des Skalarprodukts der gegenseitigen Einbettungen zwischen der Abfrage und jedem Dokument werden dann deren Ähnlichkeitswerte ermittelt. Das Contriever-Modell wird mithilfe des MoCo-Kontrastverlusts vorab trainiert und verwendet nur unbeaufsichtigte Daten. Einer der Vorteile von Density Retrievern besteht darin, dass sowohl Abfrage- als auch Dokumentencoder ohne Dokumentanmerkungen mithilfe von Standardtechniken wie Gradientenabstieg und Destillation trainiert werden können.

Sprachmodell: Als Sprachmodell verlässt sich Atlas auf die T5-Sequenz-zu-Sequenz-Architektur. Das Modell basiert außerdem auf Fusion-in-Decoder-Modifikationen des Sequenz-zu-Sequenz-Modells und verarbeitet jedes Dokument unabhängig im Encoder. Das Modell verkettet dann die Ausgaben der Encoder, die verschiedenen Dokumenten entsprechen, und führt eine Queraufmerksamkeit auf eine einzelne Sequenz im Decoder durch. Das Modell verbindet die Abfrage mit jedem Dokument im Encoder. Eine andere Möglichkeit, abgerufene Dokumente in einem Sprachmodell zu verarbeiten, besteht darin, die Abfrage und alle Dokumente zu verketten und diese lange Sequenz als Eingabe für das Modell zu verwenden. Diese Methode ist jedoch weniger skalierbar, das heißt, sie skaliert nicht mit zunehmender Anzahl von Dokumenten, da der Selbstaufmerksamkeitsmechanismus im Encoder zu einer Zeitkomplexität von O(n^2) führt (wobei n die Anzahl von Dokumenten ist). Dokumente).

Experimentelle Ergebnisse

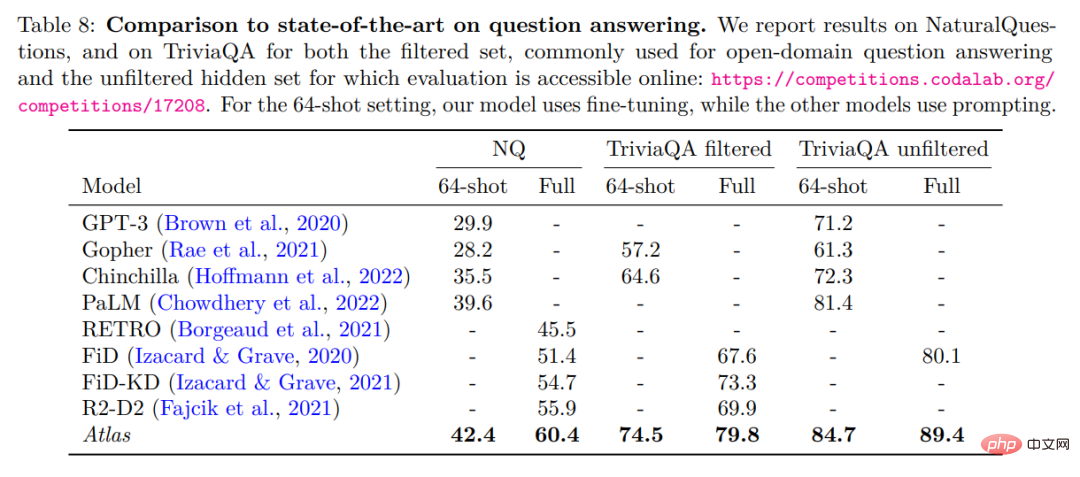

Die Autoren bewerten Atlas anhand von zwei Open-Domain-Fragen-Antwort-Benchmarks, NaturalQuestions und TriviaQA. Zum Vergleich mit früheren Arbeiten wurde ein kleiner Beispieldatensatz von 64 Beispielen und ein vollständiger Trainingssatz verwendet. Der detaillierte Vergleich ist in der folgenden Tabelle dargestellt.

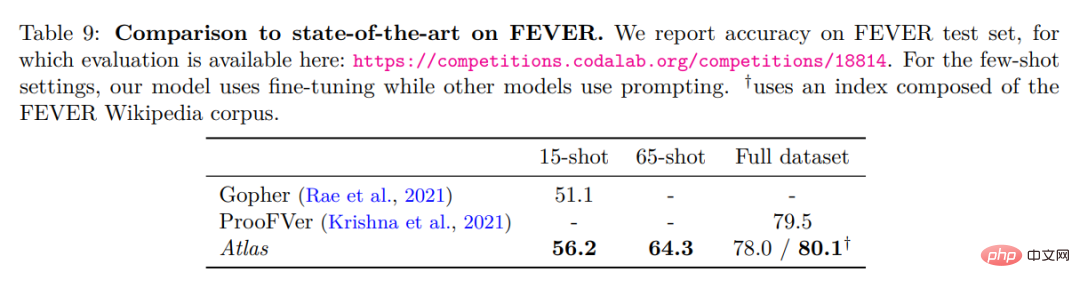

Beste Leistung bei 64-Schuss-Fragen und -Antworten von NaturalQuestions und TriviaQA. Insbesondere übertrifft es größere Modelle (PaLM) oder Modelle, die mehr Trainingsberechnungen erfordern (Chinchilla). Atlas kann auch bei Verwendung des gesamten Trainingssatzes optimale Ergebnisse erzielen, beispielsweise die Erhöhung der Genauigkeit von NaturalQuestions von 55,9 % auf 60,4 %. Dieses Ergebnis wurde unter den Standardeinstellungen von Atlas unter Verwendung eines Index bestehend aus CCNet und dem Wikipedia-Korpus vom Dezember 2021 ermittelt. Die folgende Tabelle zeigt die Testergebnisse zum Faktencheck-Datensatz FEVER.

Atlas Im 64-Schuss-Fall werden die Trainingsproben aus dem vollständigen Trainingssatz entnommen. Atlas erreichte eine Genauigkeit von 64,3 %. Im 15-Schuss-Fall werden 5 Proben gleichmäßig aus jeder Klasse entnommen. Im Vergleich zu den Gopher-Ergebnissen beträgt die Atlas-Genauigkeit 56,2 %, was 5,1 Prozentpunkte höher ist als bei Gopher. Das Atlas-Modell wurde auf den gesamten Trainingssatz abgestimmt und erreichte eine Genauigkeit von 78 %, was 1,5 % weniger als ProoFVer ist. ProoFVer verwendet eine spezielle Architektur, um Retriever mit Annotationen auf Satzebene zu trainieren und wird vom mit FEVER veröffentlichten Wikipedia-Korpus bereitgestellt, während Atlas aus CCNet und dem Wikipedia-Dump vom Dezember 2021 abruft. Bei einem Index, der aus dem FEVER-Wikipedia-Korpus besteht, erreichte Atlas einen optimalen Wert von 80,1 %.

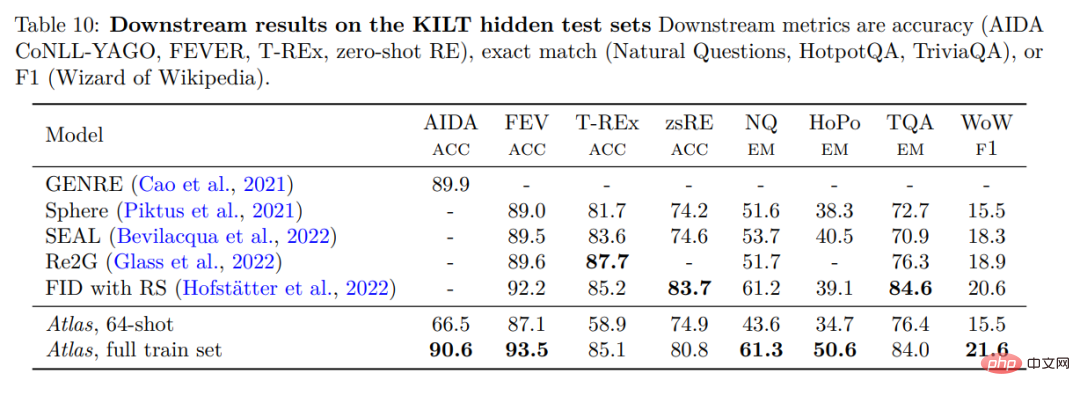

Um die Leistung von Atlas zu überprüfen, wurde Atlas anhand von KILT bewertet, einem Benchmark, der aus mehreren verschiedenen wissensintensiven Aufgaben besteht. Die folgende Tabelle zeigt die Ergebnisse des Testsatzes.

Atlas 64-shot übertrifft Zufallsalgorithmen in Experimenten bei weitem und liegt sogar auf Augenhöhe mit einigen fein abgestimmten Modellen auf der Bestenliste. Beispielsweise liegt Atlas 64-Schuss bei FEVER nur 2-2,5 Punkte hinter Sphere, SEAL und Re2G, während es bei Zero-Shot RE Sphere und SEAL übertrifft. Im gesamten Datensatz liegt die Leistung von Atlas in drei Datensätzen innerhalb von 3 % des besten Modells, in den verbleibenden fünf Datensätzen ist sie jedoch die beste.

Das obige ist der detaillierte Inhalt vonDie Anzahl der Parameter beträgt 1/50, Meta veröffentlicht ein 11-Milliarden-Parametermodell und besiegt damit Google PaLM. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1376

1376

52

52

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Stellen Sie sich ein Modell der künstlichen Intelligenz vor, das nicht nur die Fähigkeit besitzt, die traditionelle Datenverarbeitung zu übertreffen, sondern auch eine effizientere Leistung zu geringeren Kosten erzielt. Dies ist keine Science-Fiction, DeepSeek-V2[1], das weltweit leistungsstärkste Open-Source-MoE-Modell, ist da. DeepSeek-V2 ist ein leistungsstarkes MoE-Sprachmodell (Mix of Experts) mit den Merkmalen eines wirtschaftlichen Trainings und einer effizienten Inferenz. Es besteht aus 236B Parametern, von denen 21B zur Aktivierung jedes Markers verwendet werden. Im Vergleich zu DeepSeek67B bietet DeepSeek-V2 eine stärkere Leistung, spart gleichzeitig 42,5 % der Trainingskosten, reduziert den KV-Cache um 93,3 % und erhöht den maximalen Generierungsdurchsatz auf das 5,76-fache. DeepSeek ist ein Unternehmen, das sich mit allgemeiner künstlicher Intelligenz beschäftigt

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas tritt offiziell in die Ära der Elektroroboter ein! Gestern hat sich der hydraulische Atlas einfach „unter Tränen“ von der Bühne der Geschichte zurückgezogen. Heute gab Boston Dynamics bekannt, dass der elektrische Atlas im Einsatz ist. Es scheint, dass Boston Dynamics im Bereich kommerzieller humanoider Roboter entschlossen ist, mit Tesla zu konkurrieren. Nach der Veröffentlichung des neuen Videos wurde es innerhalb von nur zehn Stunden bereits von mehr als einer Million Menschen angesehen. Die alten Leute gehen und neue Rollen entstehen. Das ist eine historische Notwendigkeit. Es besteht kein Zweifel, dass dieses Jahr das explosive Jahr der humanoiden Roboter ist. Netizens kommentierten: Die Weiterentwicklung der Roboter hat dazu geführt, dass die diesjährige Eröffnungsfeier wie Menschen aussieht, und der Freiheitsgrad ist weitaus größer als der von Menschen. Aber ist das wirklich kein Horrorfilm? Zu Beginn des Videos liegt Atlas ruhig auf dem Boden, scheinbar auf dem Rücken. Was folgt, ist atemberaubend

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

Anfang dieses Monats schlugen Forscher des MIT und anderer Institutionen eine vielversprechende Alternative zu MLP vor – KAN. KAN übertrifft MLP in Bezug auf Genauigkeit und Interpretierbarkeit. Und es kann MLP, das mit einer größeren Anzahl von Parametern ausgeführt wird, mit einer sehr kleinen Anzahl von Parametern übertreffen. Beispielsweise gaben die Autoren an, dass sie KAN nutzten, um die Ergebnisse von DeepMind mit einem kleineren Netzwerk und einem höheren Automatisierungsgrad zu reproduzieren. Konkret verfügt DeepMinds MLP über etwa 300.000 Parameter, während KAN nur etwa 200 Parameter hat. KAN hat eine starke mathematische Grundlage wie MLP und basiert auf dem universellen Approximationssatz, während KAN auf dem Kolmogorov-Arnold-Darstellungssatz basiert. Wie in der folgenden Abbildung gezeigt, hat KAN

KI untergräbt die mathematische Forschung! Der Gewinner der Fields-Medaille und der chinesisch-amerikanische Mathematiker führten 11 hochrangige Arbeiten an | Gefällt mir bei Terence Tao

Apr 09, 2024 am 11:52 AM

KI untergräbt die mathematische Forschung! Der Gewinner der Fields-Medaille und der chinesisch-amerikanische Mathematiker führten 11 hochrangige Arbeiten an | Gefällt mir bei Terence Tao

Apr 09, 2024 am 11:52 AM

KI verändert tatsächlich die Mathematik. Vor kurzem hat Tao Zhexuan, der diesem Thema große Aufmerksamkeit gewidmet hat, die neueste Ausgabe des „Bulletin of the American Mathematical Society“ (Bulletin der American Mathematical Society) weitergeleitet. Zum Thema „Werden Maschinen die Mathematik verändern?“ äußerten viele Mathematiker ihre Meinung. Der gesamte Prozess war voller Funken, knallhart und aufregend. Der Autor verfügt über eine starke Besetzung, darunter der Fields-Medaillengewinner Akshay Venkatesh, der chinesische Mathematiker Zheng Lejun, der NYU-Informatiker Ernest Davis und viele andere bekannte Wissenschaftler der Branche. Die Welt der KI hat sich dramatisch verändert. Viele dieser Artikel wurden vor einem Jahr eingereicht.

Google ist begeistert: JAX-Leistung übertrifft Pytorch und TensorFlow! Es könnte die schnellste Wahl für das GPU-Inferenztraining werden

Apr 01, 2024 pm 07:46 PM

Google ist begeistert: JAX-Leistung übertrifft Pytorch und TensorFlow! Es könnte die schnellste Wahl für das GPU-Inferenztraining werden

Apr 01, 2024 pm 07:46 PM

Die von Google geförderte Leistung von JAX hat in jüngsten Benchmark-Tests die von Pytorch und TensorFlow übertroffen und belegt bei 7 Indikatoren den ersten Platz. Und der Test wurde nicht auf der TPU mit der besten JAX-Leistung durchgeführt. Obwohl unter Entwicklern Pytorch immer noch beliebter ist als Tensorflow. Aber in Zukunft werden möglicherweise mehr große Modelle auf Basis der JAX-Plattform trainiert und ausgeführt. Modelle Kürzlich hat das Keras-Team drei Backends (TensorFlow, JAX, PyTorch) mit der nativen PyTorch-Implementierung und Keras2 mit TensorFlow verglichen. Zunächst wählen sie eine Reihe von Mainstream-Inhalten aus

Tesla-Roboter arbeiten in Fabriken, Musk: Der Freiheitsgrad der Hände wird dieses Jahr 22 erreichen!

May 06, 2024 pm 04:13 PM

Tesla-Roboter arbeiten in Fabriken, Musk: Der Freiheitsgrad der Hände wird dieses Jahr 22 erreichen!

May 06, 2024 pm 04:13 PM

Das neueste Video von Teslas Roboter Optimus ist veröffentlicht und er kann bereits in der Fabrik arbeiten. Bei normaler Geschwindigkeit sortiert es Batterien (Teslas 4680-Batterien) so: Der Beamte hat auch veröffentlicht, wie es bei 20-facher Geschwindigkeit aussieht – auf einer kleinen „Workstation“, pflücken und pflücken und pflücken: Dieses Mal wird es freigegeben. Eines der Highlights Der Vorteil des Videos besteht darin, dass Optimus diese Arbeit in der Fabrik völlig autonom und ohne menschliches Eingreifen während des gesamten Prozesses erledigt. Und aus Sicht von Optimus kann es auch die krumme Batterie aufnehmen und platzieren, wobei der Schwerpunkt auf der automatischen Fehlerkorrektur liegt: In Bezug auf die Hand von Optimus gab der NVIDIA-Wissenschaftler Jim Fan eine hohe Bewertung ab: Die Hand von Optimus ist der fünffingrige Roboter der Welt am geschicktesten. Seine Hände sind nicht nur taktil

FisheyeDetNet: der erste Zielerkennungsalgorithmus basierend auf einer Fischaugenkamera

Apr 26, 2024 am 11:37 AM

FisheyeDetNet: der erste Zielerkennungsalgorithmus basierend auf einer Fischaugenkamera

Apr 26, 2024 am 11:37 AM

Die Zielerkennung ist ein relativ ausgereiftes Problem in autonomen Fahrsystemen, wobei die Fußgängererkennung einer der ersten Algorithmen ist, die eingesetzt werden. In den meisten Arbeiten wurde eine sehr umfassende Recherche durchgeführt. Die Entfernungswahrnehmung mithilfe von Fischaugenkameras für die Rundumsicht ist jedoch relativ wenig untersucht. Aufgrund der großen radialen Verzerrung ist es schwierig, die standardmäßige Bounding-Box-Darstellung in Fischaugenkameras zu implementieren. Um die obige Beschreibung zu vereinfachen, untersuchen wir erweiterte Begrenzungsrahmen-, Ellipsen- und allgemeine Polygondesigns in Polar-/Winkeldarstellungen und definieren eine mIOU-Metrik für die Instanzsegmentierung, um diese Darstellungen zu analysieren. Das vorgeschlagene Modell „fisheyeDetNet“ mit polygonaler Form übertrifft andere Modelle und erreicht gleichzeitig 49,5 % mAP auf dem Valeo-Fisheye-Kameradatensatz für autonomes Fahren

Mit einer einzelnen Karte läuft Llama 70B schneller als mit zwei Karten, Microsoft hat gerade FP6 in A100 integriert |

Apr 29, 2024 pm 04:55 PM

Mit einer einzelnen Karte läuft Llama 70B schneller als mit zwei Karten, Microsoft hat gerade FP6 in A100 integriert |

Apr 29, 2024 pm 04:55 PM

FP8 und die geringere Gleitkomma-Quantifizierungsgenauigkeit sind nicht länger das „Patent“ von H100! Lao Huang wollte, dass jeder INT8/INT4 nutzt, und das Microsoft DeepSpeed-Team begann, FP6 auf A100 ohne offizielle Unterstützung von NVIDIA auszuführen. Testergebnisse zeigen, dass die FP6-Quantisierung der neuen Methode TC-FPx auf A100 nahe an INT4 liegt oder gelegentlich schneller als diese ist und eine höhere Genauigkeit aufweist als letztere. Darüber hinaus gibt es eine durchgängige Unterstützung großer Modelle, die als Open-Source-Lösung bereitgestellt und in Deep-Learning-Inferenz-Frameworks wie DeepSpeed integriert wurde. Dieses Ergebnis wirkt sich auch unmittelbar auf die Beschleunigung großer Modelle aus – in diesem Rahmen ist der Durchsatz bei Verwendung einer einzelnen Karte zum Ausführen von Llama 2,65-mal höher als der von Doppelkarten. eins