In letzter Zeit war AIGC auf der Suche, und seine Popularität ist nach wie vor hoch. Natürlich sind neben seinem äußerst berühmten Namen auch seine Durchbrüche absolut bemerkenswert: Bilder, Videos und sogar 3D-Modelle können automatisch durch Eingabe natürlicher Sprache generiert werden. Sind Sie überrascht?

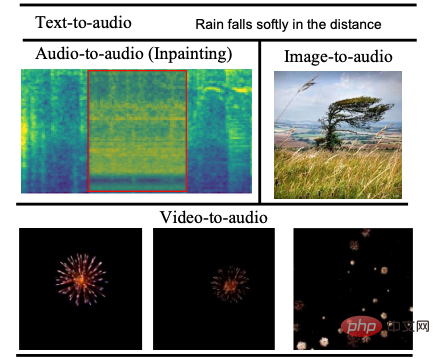

Aber im Bereich Audio und Soundeffekte scheint es AIGC etwas schlechter zu gehen. Hauptsächlich, weil die Audioerzeugung mit hohem Freiheitsgrad auf einer großen Menge an Text-Audio-Paardaten beruht und es viele Schwierigkeiten bei der langfristigen Wellenformmodellierung gibt. Um die oben genannten Schwierigkeiten zu lösen, haben die Zhejiang-Universität und die Peking-Universität gemeinsam ein innovatives Text-zu-Audio-Generierungssystem vorgeschlagen, nämlich Make-An-Audio#🎜🎜 #. Es kann eine Beschreibung in natürlicher Sprache als Eingabe verwenden und in jeder Modalität (z. B. Text, Audio, Bild, Video usw.) vorliegen und gleichzeitig Audio-Soundeffekte ausgeben, die der Beschreibung entsprechen Die Mehrheit der Internetnutzer schätzt seine Kontrollierbarkeit und Verallgemeinerung.

Nach Silvester im Jahr 2023 erschienen zahlreiche Artikel zur Audiosynthese, darunter Make-An-Audio und MusicLM. Innerhalb von 48 Jahren gab es 4 bahnbrechende Entwicklungen Std.

Netizen-Kommentar 1#🎜 🎜 # Viele Internetnutzer haben zum Ausdruck gebracht, dass die AIGC-Soundeffektsynthese die Zukunft der Film- und Kurzvideoproduktion verändern wird.

Netizen-Kommentar 2#🎜 🎜 #

Einige Internetnutzer beklagten: „Audio ist alles, was Sie brauchen ...“ #🎜🎜 ##🎜 🎜#

Netizen Kommentare 4

Netizen Kommentare 4

erweisen sich als sehr praktisch und reibungslos. Text 1:

ein Schnellboot, das läuft, während der Wind in ein Mikrofon blästAudio: 00:0000:09

#🎜 🎜#

Text 2: Feuerwerk platzt und explodiert Konvertierung Audio 2Audio: 00 :0000:09

Hatten Sie auch Probleme mit Reparatur defekter Audiogeräte? Sobald das Make-An-Audio-Modell herauskommt, wird dies viel einfacher.

vor der Reparatur

#🎜 🎜#

#🎜 🎜#

Audio vor der Wiederherstellung

Audio vor der Wiederherstellung Audio: #🎜 🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜#00: 0000: 09#🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜##🎜 🎜#Nach der Reparatur#🎜 🎜#Nach der Reparatur Audio

Nach der Reparatur AudioAudio:

00:0000:09

Es ist nicht unmöglich, Soundeffekte durch zu erzeugen.

Bild 1#🎜 🎜# Audiokonvertierung

00:0000:09

Bild 2#🎜 🎜 #Audio konvertieren

Bildkonvertierung Audio 2Audio: # 🎜🎜#

# 🎜🎜#

Generieren Sie entsprechende Soundeffekte basierend auf

Videoinhalten, dieses Modell kann es auch leicht. Video 1#🎜🎜 #

Konvertierung AudioVideo 1

Audio:00:0000:09

Video. 2

#🎜🎜 # Konvertierung AudioVideo 2Audio:

00:0000:09

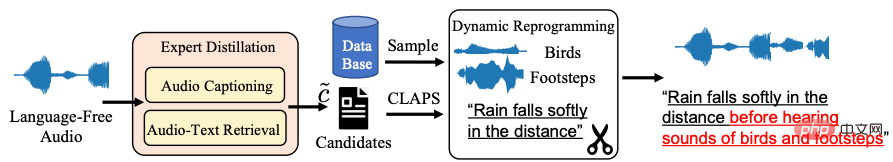

Eine eingehende Analyse der magischen Konnotationen des „Internet Celebrity“-Modells muss auf das objektive Problem der spärlichen audio-natürlichen Sprache zurückgreifen In diesem Zusammenhang haben die Peking-Universität der Zhejiang-Universität und das Volcano Speech Team gemeinsam mit den beiden Universitäten die Textverbesserungsstrategie Distill-then-Reprogram vorgeschlagen Verwenden Sie das Lehrermodell, um die Beschreibung des Audios in natürlicher Sprache zu erhalten, und führen Sie dann eine zufällige Rekombination durch, um dynamische Trainingsbeispiele zu erhalten.

Insbesondere werden im Distill-Link Audio-zu-Text- und Audio-Text-Retrieval-Modelle verwendet, um Kandidaten für die Beschreibung natürlicher Sprache für sprachfreies Audio zu finden (Kandidat ) erzielt durch die Berechnung der übereinstimmenden Ähnlichkeit zwischen Kandidatentext und Audio das beste Ergebnis unterhalb des Schwellenwerts als Beschreibung des Audios. Diese Methode weist eine starke Verallgemeinerung auf und echte natürliche Sprache vermeidet in der Testphase Text außerhalb der Domäne. „In der Reprogrammierungsphase entnahm das Team zufällig Stichproben aus zusätzlichen Ereignisdatensätzen und kombinierte sie mit den aktuellen Trainingsbeispielen, um neue Konzeptkombinationen und Beschreibungen zu erhalten und so die Robustheit des Modells gegenüber verschiedenen Ereigniskombinationen zu erhöhen“, sagte das Forschungsteam. Textverstärktes Strategierahmendiagramm

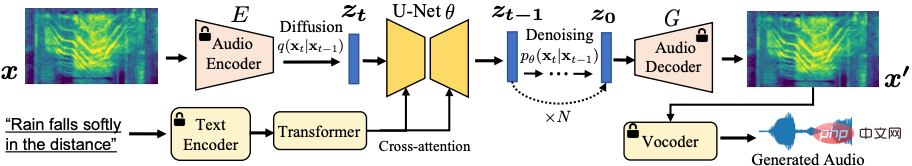

Make-An-Audio Model System Framework Diagramm# 🎜🎜#

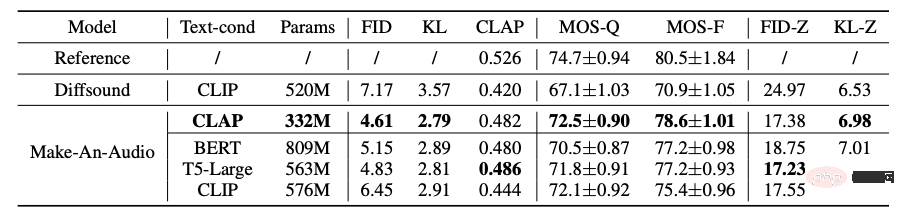

Darüber hinaus untersuchte das Team im Rahmen der Forschung auch leistungsstarke Strategien zur Textkonditionierung, darunter Contrastive Language-Audio Pretraining (CLAP) und Language Model (LLM). T5, BERT usw. haben die Wirksamkeit und Rechenfreundlichkeit der CLAP-Textdarstellung überprüft. Gleichzeitig wurde zum ersten Mal der CLAP Score zur Bewertung des generierten Audios verwendet, mit dem die Konsistenz zwischen Text und generierten Szenen gemessen werden kann. Mithilfe einer Kombination aus subjektiven und objektiven Bewertungsmethoden wurde die Wirksamkeit des Modells überprüft Im Benchmark-Datensatztest wurde demonstriert, dass das Modell über eine hervorragende Verallgemeinerung des Zero-Shot-Lernens (Zero-Shot) usw. verfügt.

Make-An-Audio vs. Basismodell Subjektiv und Ergebnisse des objektiven Bewertungsexperiments

Wie viel wissen Sie über die Anwendungsaussichten des magischen Modells?

Insgesamt erreicht das Make-An-Audio-Modell eine hochwertige, gut kontrollierbare Audiosynthese und schlägt „Keine Modalität zurück“ für textbedingte Audiomodelle vor. Durch Feinabstimmung kann Audio freigeschaltet werden Synthese (Audio/Bild/Video) für jede modale Eingabe.

Insgesamt erreicht das Make-An-Audio-Modell eine hochwertige, gut kontrollierbare Audiosynthese und schlägt „Keine Modalität zurück“ für textbedingte Audiomodelle vor. Durch Feinabstimmung kann Audio freigeschaltet werden Synthese (Audio/Bild/Video) für jede modale Eingabe.

Make-An-Audio erreicht eine hohe Steuerbarkeit für die Zum ersten Mal X - AIGC-Synthese von Audio,

Make-An-Audio Visual-Audio-Synthese-Framework Bild Es ist absehbar, dass die Audiosynthese AIGC in der zukünftigen Filmsynchronisation, der Erstellung von Kurzvideos und anderen Bereichen eine wichtige Rolle spielen wird, und mit Hilfe von Modellen wie Make-An-Audio könnte dies möglich sein für alle in der Zukunft Als professioneller Soundeffekt-Ingenieur können Sie Text, Videos und Bilder verwenden, um jederzeit und an jedem Ort lebensechte Audio- und Soundeffekte zu synthetisieren. Allerdings ist Make-An-Audio zu diesem Zeitpunkt noch nicht perfekt. Aufgrund der umfangreichen Datenquellen und der unvermeidlichen Probleme mit der Beispielqualität treten während des Trainingsprozesses zwangsläufig Nebenwirkungen auf, z. B. die Generierung von Audio, das nicht mit dem Textinhalt übereinstimmt. Make-An-Audio ist technisch gesehen als „unterstützte Künstlergeneration“ positioniert, und eines ist sicher: Die Fortschritte im AIGC-Bereich sind tatsächlich überraschend. Huoshan Voice bietet seit langem weltweit vorteilhafte KI-Sprachtechnologiefunktionen und Full-Stack-Sprachproduktlösungen für die wichtigsten Geschäftsbereiche von ByteDance, einschließlich Audioverständnis, Audiosynthese und virtueller digitaler Mensch , Dialoginteraktion, Musikabruf, intelligente Hardware usw. Seit seiner Gründung im Jahr 2017 konzentriert sich das Team auf die Entwicklung branchenführender intelligenter KI-Sprachtechnologie und die kontinuierliche Erforschung der effizienten Kombination von KI und Geschäftsszenarien, um einen größeren Benutzernutzen zu erzielen. Derzeit decken seine Spracherkennung und Sprachsynthese mehrere Sprachen und Dialekte ab. Viele technische Vorträge wurden für verschiedene Top-KI-Konferenzen ausgewählt und bieten führende Sprachfunktionen für Douyin, Jianying, Feishu, Tomato Novels, Pico und andere Unternehmen Es eignet sich für verschiedene Szenarien wie Kurzvideos, Live-Übertragungen, Videoerstellung, Büro- und tragbare Geräte und ist über die Volcano Engine für externe Unternehmen offen.

Das obige ist der detaillierte Inhalt vonDieses Audio ging im Internet viral! Generieren Sie mit einem Klick realistische Soundeffekte aus Text und Bildern, AIGC kommt in die Audiobranche. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Welche Fähigkeiten sind erforderlich, um in der PHP-Branche zu arbeiten?

Welche Fähigkeiten sind erforderlich, um in der PHP-Branche zu arbeiten?

Was tun, wenn das angegebene Modul nicht gefunden werden kann?

Was tun, wenn das angegebene Modul nicht gefunden werden kann?

Antivirus für Apple-Handys

Antivirus für Apple-Handys

Was tun, wenn die temporäre Dateiumbenennung fehlschlägt?

Was tun, wenn die temporäre Dateiumbenennung fehlschlägt?

Wie wäre es mit der Binance-Börse?

Wie wäre es mit der Binance-Börse?

So überprüfen Sie den Speicher

So überprüfen Sie den Speicher

So lesen Sie Makrosteuerdaten in Javascript

So lesen Sie Makrosteuerdaten in Javascript

SVG in JPG umwandeln

SVG in JPG umwandeln

Auf welcher Börse ist Sols Inscription Coin?

Auf welcher Börse ist Sols Inscription Coin?