Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Bitte schauen Sie sich am ersten Tag des Jahres 2023 die Jahresendzusammenfassung von ChatGPT an!

Bitte schauen Sie sich am ersten Tag des Jahres 2023 die Jahresendzusammenfassung von ChatGPT an!

Bitte schauen Sie sich am ersten Tag des Jahres 2023 die Jahresendzusammenfassung von ChatGPT an!

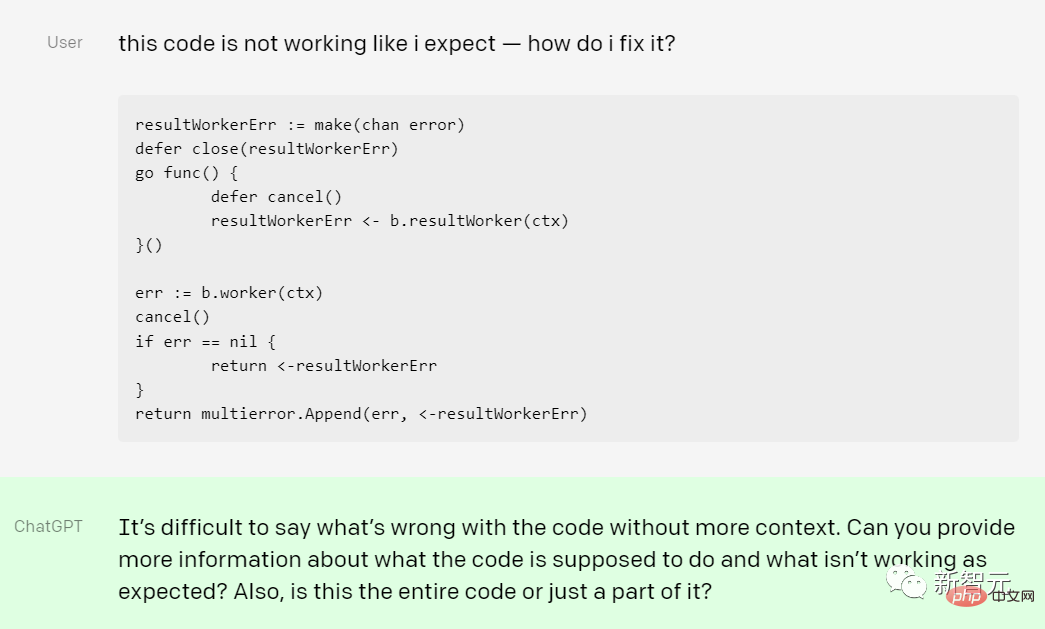

Das Aufkommen von ChatGPT ist möglicherweise der auffälligste KI-Durchbruch in der zweiten Hälfte des Jahres 2022, wenn auch möglicherweise nicht der technischste.

Vor nicht allzu langer Zeit, beim NeurIPS 2022 in New Orleans, gab es gleichzeitig endlose Gerüchte über GPT-4 , OpenAI wird auch zum Fokus der gesamten Nachrichtenmedien.

OpenAI hat ein neues Modell in der GPT-3-Serie von KI-Großsprachmodellen angekündigt: text-davinci-003, das ist Teil der „GPT-3.5-Serie“, die die Leistung verbessern kann, indem komplexere Anweisungen verarbeitet und qualitativ hochwertigere Inhalte in längerer Form erstellt werden.

Das neue Modell basiert auf InstructGPT und wird mit menschlichem Feedback zur Verstärkung des Lernens verwendet um Sprachmodelle besser an menschliche Anweisungen anzupassen.

DaVinci-003 ist ein echtes Reinforcement Learning with Human Feedback (RLHF)-Modell, das bei der Feinabstimmung unter Aufsicht von Menschen demonstriert wurde wird bei Modellproben mit hoher Bewertung verwendet, um die Generierungsqualität zu verbessern. „

Als weiterer Teil der „GPT-3.5-Serie“ veröffentlichte OpenAI eine frühe Demonstration von ChatGPT. Das behauptete das Unternehmen Das interaktive Dialogmodell kann nicht nur eine Vielzahl von Folgefragen beantworten, sondern auch Fehler eingestehen, falsche Frageprämissen in Frage stellen und unangemessene Fragewünsche ablehnen.

OpenAI gab im Blog an, dass die Forschungsversion von ChatGPT eine „OpenAI-Iteration“ sei Der jüngste Schritt bei der Bereitstellung zunehmend sicherer und nützlicher KI-Systeme basiert auf vielen Erkenntnissen aus früheren Modellbereitstellungen wie GPT-3 und Codex, die bei der Nutzung von Reinforcement Learning mit menschlichem Feedback (RLHF) schädlich und unecht waren Vor nicht allzu langer Zeit löste Googles Chatbot LaMDA eine Kontroverse darüber aus, ob KI bewusst ist.

Natürlich hat ChatGPT auch Einschränkungen.

In einem Blogbeitrag beschreibt OpenAI seine Einschränkungen, einschließlich der Tatsache, dass die Antworten manchmal vernünftig klingen, in Wirklichkeit jedoch falsch oder bedeutungslos sind .

„Die Lösung dieses Problems ist eine große Herausforderung, denn (1) während des Reinforcement-Learning-Trainings gibt es derzeit keine Garantie dafür, dass es zuverlässig ist.“ Quellen; (2) trainierte Modelle sind vorsichtiger und lehnen Fragen ab, die möglicherweise richtig beantwortet werden, da die ideale Antwort davon abhängt, was das Modell weiß, und nicht davon, was der menschliche Demonstrator weiß 🎜#

Open AI sagte, dass ChatGPT „manchmal auf schädliche Anweisungen reagiert oder voreingenommenes Verhalten zeigt. Wir verwenden die API, um Warnungen zu erhalten oder bestimmte Arten von zu blockieren.“ Es wird mit unsicheren Inhalten gerechnet, aber derzeit gibt es einige falsche Negativ- und Positivmeldungen. Wir sind sehr daran interessiert, Benutzerfeedback zu sammeln, um unsere laufende Arbeit zur Verbesserung dieses Modells zu unterstützen.

Obwohl ChatGPT möglicherweise noch viele Probleme hat, die verbessert werden müssen, können wir nicht leugnen, dass ChatGPT dies tun wird, bevor GPT-4 auf den Plan tritt immer noch das aktuelle erstklassige Sprachmodell in großem Maßstab.

In der jüngsten Community gibt es jedoch ein neues Modell, das die Begeisterung aller für Diskussionen entfacht hat. Das Wichtigste ist, dass es Open Source ist.

Diese Woche hat Philip Wang, ein Entwickler, der für das Reverse Engineering von Closed-Source-KI-Systemen, einschließlich Metas Make-A-Video, verantwortlich ist, PaLM + RLHF gepostet: ein Textgenerierungsmodell, das sich wie ChatGPT verhält.

Codeadresse: https://github.com/lucidrains/PaLM-rlhf-pytorch

Dieses System kombiniert Googles großes Sprachmodell PaLM und Reinforcement Learning mit Human-Feedback-Technologie (RLHF). ein System, das fast jede Aufgabe bei ChatGPT erledigen kann, einschließlich des Verfassens von E-Mails und des Vorschlagens von Computercode.

Die Kraft von PaLm + RLHF

Seit seiner Veröffentlichung hat ChatGPT in der Technologiewelt für Aufsehen gesorgt, da es in der Lage ist, hochauflösenden, menschenähnlichen Text zu generieren und auf Benutzerfragen im Gespräch zu antworten. Ein Sturm.

Obwohl dies ein großer Fortschritt in den frühen Phasen der Chatbot-Entwicklung ist, haben viele Fans im Bereich der künstlichen Intelligenz Bedenken hinsichtlich der geschlossenen Natur von ChatGPT geäußert.

Bis heute bleibt das ChatGPT-Modell proprietär, was bedeutet, dass der zugrunde liegende Code nicht für die Öffentlichkeit einsehbar ist. Nur OpenAI weiß wirklich, wie es funktioniert und welche Daten es verarbeitet. Dieser Mangel an Transparenz kann weitreichende Folgen haben und das Vertrauen der Nutzer langfristig beeinträchtigen.

Viele Entwickler wollten unbedingt eine Open-Source-Alternative entwickeln, und jetzt ist sie endlich da. PaLM+RLHF wurde speziell für die Python-Sprache entwickelt und kann für PyTorch implementiert werden.

Entwickler können PaLM so einfach trainieren wie einen autoregressiven Transformator und dann menschliches Feedback nutzen, um das Belohnungsmodell zu trainieren.

PaLM + RLHF ist wie ChatGPT im Wesentlichen ein statistisches Tool zur Vorhersage von Wörtern. Wenn PaLM+RLHF mit einer großen Anzahl von Beispielen aus den Trainingsdaten gefüttert wird – beispielsweise Reddit-Beiträge, Nachrichtenartikel und E-Books –, lernt es anhand von Mustern wie dem semantischen Kontext des umgebenden Textes, wie wahrscheinlich es ist, dass ein Wort vorkommt.

Ist es wirklich so perfekt?

Natürlich gibt es immer noch eine große Lücke zwischen Ideal und Realität. PaLM + RLHF scheint perfekt, aber es gibt auch verschiedene Probleme. Das größte Problem ist, dass die Leute es noch nicht nutzen können.

Um PaLM + RLHF zu starten, müssen Benutzer Gigabyte an Text zusammenstellen, der aus verschiedenen Quellen wie Blogs, sozialen Medien, Nachrichtenartikeln, E-Books usw. stammt.

Diese Daten werden einem fein abgestimmten PaLm-Modell zugeführt, das mehrere Antworten generiert. Wenn Sie beispielsweise das Modell „Was sind die Grundkenntnisse der Wirtschaftswissenschaften?“ fragen, gibt PaLm Antworten wie „Wirtschaftswissenschaft ist die Sozialwissenschaft, die studiert …“.

Anschließend wird der Entwickler die Leute bitten, die vom Modell generierten Antworten vom besten zum schlechtesten zu ordnen und ein Belohnungsmodell zu erstellen. Schließlich werden die Rankings verwendet, um ein „Belohnungsmodell“ zu trainieren, das die Antworten des ursprünglichen Modells nimmt und sie nach Präferenz sortiert, um die beste Antwort für eine bestimmte Eingabeaufforderung herauszufiltern.

Dies ist jedoch ein teurer Prozess. Das Sammeln von Trainingsdaten und das Training des Modells selbst ist nicht billig. PaLM verfügt über 540 Milliarden Parameter, bei denen es sich um die aus den Trainingsdaten gelernten Teile des Sprachmodells handelt. Eine Studie aus dem Jahr 2020 zeigte, dass die Entwicklung eines Textgenerierungsmodells mit nur 1,5 Milliarden Parametern bis zu 1,6 Millionen US-Dollar kosten würde.

Um das Open-Source-Modell Bloom mit 176 Milliarden Parametern zu trainieren, verbrachten die Forscher von Hugging Face im Juli dieses Jahres drei Monate und verwendeten 384 NVIDIA A100-GPUs. Jeder A100 kostet Tausende von Dollar, was sich kein durchschnittlicher Benutzer leisten kann.

Auch nach dem Training des Modells ist es nicht trivial, ein Modell der Größe PaLM + RLHF zu betreiben. Bloom verfügt über einen dedizierten PC mit acht A100-GPUs, und der Betrieb von OpenAIs Textgenerierung GPT-3 (mit etwa 175 Milliarden Parametern) kostet etwa 87.000 US-Dollar pro Jahr.

KI-Forscher Sebastian Raschka weist in einem Artikel über PaLM + RLHF darauf hin, dass auch die Skalierung des notwendigen Entwicklungsworkflows eine Herausforderung sein kann. „Selbst wenn Ihnen jemand 500 GPUs gibt, um dieses Modell zu trainieren, müssen Sie sich dennoch um die Infrastruktur kümmern und über die Software verfügen, um damit umzugehen“, sagte er. „Obwohl dies machbar ist, erfordert es derzeit viel Aufwand.“ PaLM + RLHF ist derzeit nicht in der Lage, ChatGPT zu ersetzen.

Bisher gibt es keinen genauen Veröffentlichungstermin für PaLM + RLHF. Zur Veranschaulichung: Hugging Face brauchte drei Monate, um Bloom zu trainieren. Im Gegensatz dazu muss PaLM + RLHF mit 540 Milliarden Parametern möglicherweise 6–8 Monate warten, um eine aussagekräftige Version zu erstellen.

Die gute Nachricht ist, dass wir bisher drei bekannte Spieler haben, die an dieser Open-Source-ChatGPT-Alternative arbeiten: # 🎜🎜##🎜 🎜#

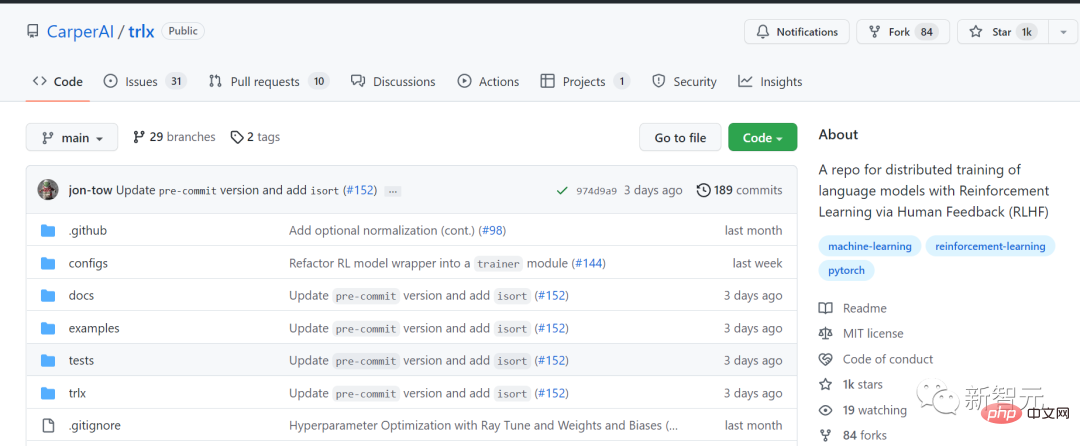

CarperAI

#🎜 🎜##🎜 🎜#LA ION#🎜 🎜#

Yannic Kilcher # 🎜🎜#

Auto perAI-Pläne arbeitet mit EleutherAI und den Startups Scale AI und Hugging Face zusammen, um das erste betriebsbereite, ChatGPT-ähnliche KI-Modell zu veröffentlichen, das mit menschlichem Feedback trainiert wird.- Code-Adresse: https://github.com/CarperAI/trlx

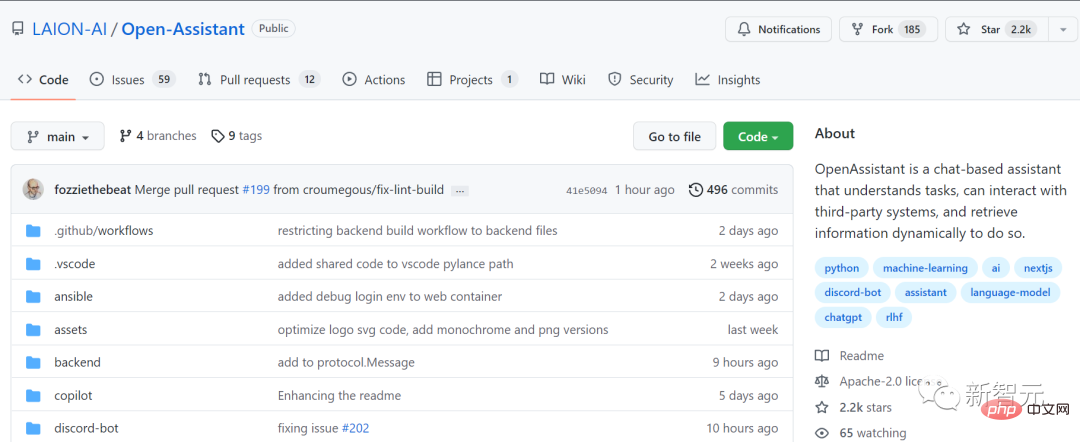

- LAION, die gemeinnützige Organisation, die den ersten Datensatz für Stable Diffusion bereitgestellt hat, leitet ebenfalls eine Replikation mithilfe neuester maschineller Lernmethoden Technologie ChatGPT-Projekt.

Code-Adresse: https://github.com/LAION-AI /Open-Assistant

LAION möchte einen „Assistenten der Zukunft“ schaffen, der nicht nur E-Mails und Anschreiben schreiben kann, sondern auch … auch „Sinnvolle Arbeit leisten, APIs verwenden, Informationen dynamisch recherchieren usw.“ Es befindet sich noch im Anfangsstadium, aber vor einigen Wochen wurde ein Projekt mit entsprechenden Ressourcen auf GitHub live geschaltet.

GPT-4chan, erstellt vom YouTube-Star und KI-Forscher Yannic Kilcher, ist eher so, als würde man „aus dem Schlick kommen und völlig gefärbt“ „Der schlechtredende Meister.“ #4chan Ängstlich und macht alle möglichen politisch inkorrekten Bemerkungen. Kilcher nutzte offiziell Beiträge auf 4chan, um das Modell zu trainieren, und die Ergebnisse sind vorhersehbar.

Ähnlich wie der allgemeine Ton des Forums waren die Antworten von GPT-4chan voller Rassismus, Sexismus und Antisemitismus. Darüber hinaus hat Kilcher das zugrunde liegende Modell auch auf Hugging Face veröffentlicht, damit andere es herunterladen können. Aufgrund der Verurteilung vieler KI-Forscher schränkten die Behörden jedoch schnell den Zugang der Internetnutzer zu dem Modell ein.

Während wir uns auf das Aufkommen weiterer Open-Source-Sprachmodelle freuen, können wir jetzt nur noch warten. Natürlich ist es auch eine gute Idee, ChatGPT weiterhin kostenlos zu nutzen.

Es ist erwähnenswert, dass OpenAI in der Entwicklung noch weit fortgeschritten ist, bevor eine Open-Source-Version offiziell veröffentlicht wird. Im Jahr 2023 ist GPT-4 zweifellos das, worauf sich KI-Enthusiasten auf der ganzen Welt freuen.

Unzählige KI-Giganten haben ihre eigenen Vorhersagen darüber gemacht, ob sie gut oder schlecht sind, aber wie OpenAI-COO Sam Altman sagte: „Allgemeine künstliche Intelligenz wird früher entwickelt als die meisten Menschen.“ Stellen Sie sich vor, und es wird alles verändern, was sich die meisten Menschen vorstellen.

Das obige ist der detaillierte Inhalt vonBitte schauen Sie sich am ersten Tag des Jahres 2023 die Jahresendzusammenfassung von ChatGPT an!. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1372

1372

52

52

Welche Methode wird verwendet, um Strings in Objekte in Vue.js umzuwandeln?

Apr 07, 2025 pm 09:39 PM

Welche Methode wird verwendet, um Strings in Objekte in Vue.js umzuwandeln?

Apr 07, 2025 pm 09:39 PM

Bei der Konvertierung von Zeichenfolgen in Objekte in Vue.js wird JSON.Parse () für Standard -JSON -Zeichenfolgen bevorzugt. Bei nicht standardmäßigen JSON-Zeichenfolgen kann die Zeichenfolge durch Verwendung regelmäßiger Ausdrücke verarbeitet und Methoden gemäß dem Format oder dekodierten URL-kodiert reduziert werden. Wählen Sie die entsprechende Methode gemäß dem String -Format aus und achten Sie auf Sicherheits- und Codierungsprobleme, um Fehler zu vermeiden.

Vue- und Element-UI-Kaskaden-Dropdown-Box V-Model-Bindung

Apr 07, 2025 pm 08:06 PM

Vue- und Element-UI-Kaskaden-Dropdown-Box V-Model-Bindung

Apr 07, 2025 pm 08:06 PM

Vue- und Element-UI-kaskadierte Dropdown-Boxen V-Model-Bindung gemeinsame Grubenpunkte: V-Model bindet ein Array, das die ausgewählten Werte auf jeder Ebene des kaskadierten Auswahlfelds darstellt, nicht auf einer Zeichenfolge; Der Anfangswert von ausgewählten Optionen muss ein leeres Array sein, nicht null oder undefiniert. Die dynamische Belastung von Daten erfordert die Verwendung asynchroner Programmierkenntnisse, um Datenaktualisierungen asynchron zu verarbeiten. Für riesige Datensätze sollten Leistungsoptimierungstechniken wie virtuelles Scrollen und fauler Laden in Betracht gezogen werden.

VUE.JS Wie kann man ein Array von String -Typ in ein Array von Objekten umwandeln?

Apr 07, 2025 pm 09:36 PM

VUE.JS Wie kann man ein Array von String -Typ in ein Array von Objekten umwandeln?

Apr 07, 2025 pm 09:36 PM

Zusammenfassung: Es gibt die folgenden Methoden zum Umwandeln von VUE.JS -String -Arrays in Objektarrays: Grundlegende Methode: Verwenden Sie die Kartenfunktion, um regelmäßige formatierte Daten zu entsprechen. Erweitertes Gameplay: Die Verwendung regulärer Ausdrücke kann komplexe Formate ausführen, müssen jedoch sorgfältig geschrieben und berücksichtigt werden. Leistungsoptimierung: In Betracht ziehen die große Datenmenge, asynchrone Operationen oder effiziente Datenverarbeitungsbibliotheken können verwendet werden. Best Practice: Clear Code -Stil, verwenden Sie sinnvolle variable Namen und Kommentare, um den Code präzise zu halten.

So stellen Sie die Zeitüberschreitung von Vue Axios fest

Apr 07, 2025 pm 10:03 PM

So stellen Sie die Zeitüberschreitung von Vue Axios fest

Apr 07, 2025 pm 10:03 PM

Um die Zeitüberschreitung für Vue Axios festzulegen, können wir eine Axios -Instanz erstellen und die Zeitleitungsoption angeben: in globalen Einstellungen: vue.Prototyp. $ Axios = axios.create ({Timeout: 5000}); In einer einzigen Anfrage: this. $ axios.get ('/api/user', {timeout: 10000}).

So verwenden Sie MySQL nach der Installation

Apr 08, 2025 am 11:48 AM

So verwenden Sie MySQL nach der Installation

Apr 08, 2025 am 11:48 AM

Der Artikel führt den Betrieb der MySQL -Datenbank vor. Zunächst müssen Sie einen MySQL -Client wie MySQLworkBench oder Befehlszeilen -Client installieren. 1. Verwenden Sie den Befehl mySQL-uroot-P, um eine Verbindung zum Server herzustellen und sich mit dem Stammkonto-Passwort anzumelden. 2. Verwenden Sie die Erstellung von Createdatabase, um eine Datenbank zu erstellen, und verwenden Sie eine Datenbank aus. 3.. Verwenden Sie CreateTable, um eine Tabelle zu erstellen, Felder und Datentypen zu definieren. 4. Verwenden Sie InsertInto, um Daten einzulegen, Daten abzufragen, Daten nach Aktualisierung zu aktualisieren und Daten nach Löschen zu löschen. Nur indem Sie diese Schritte beherrschen, lernen, mit gemeinsamen Problemen umzugehen und die Datenbankleistung zu optimieren, können Sie MySQL effizient verwenden.

Laravels Geospatial: Optimierung interaktiver Karten und großen Datenmengen

Apr 08, 2025 pm 12:24 PM

Laravels Geospatial: Optimierung interaktiver Karten und großen Datenmengen

Apr 08, 2025 pm 12:24 PM

Verarbeiten Sie 7 Millionen Aufzeichnungen effizient und erstellen Sie interaktive Karten mit Geospatial -Technologie. In diesem Artikel wird untersucht, wie über 7 Millionen Datensätze mithilfe von Laravel und MySQL effizient verarbeitet und in interaktive Kartenvisualisierungen umgewandelt werden können. Erstes Herausforderungsprojektanforderungen: Mit 7 Millionen Datensätzen in der MySQL -Datenbank wertvolle Erkenntnisse extrahieren. Viele Menschen erwägen zunächst Programmiersprachen, aber ignorieren die Datenbank selbst: Kann sie den Anforderungen erfüllen? Ist Datenmigration oder strukturelle Anpassung erforderlich? Kann MySQL einer so großen Datenbelastung standhalten? Voranalyse: Schlüsselfilter und Eigenschaften müssen identifiziert werden. Nach der Analyse wurde festgestellt, dass nur wenige Attribute mit der Lösung zusammenhängen. Wir haben die Machbarkeit des Filters überprüft und einige Einschränkungen festgelegt, um die Suche zu optimieren. Kartensuche basierend auf der Stadt

Remote Senior Backend Engineers (Plattformen) benötigen Kreise

Apr 08, 2025 pm 12:27 PM

Remote Senior Backend Engineers (Plattformen) benötigen Kreise

Apr 08, 2025 pm 12:27 PM

Remote Senior Backend Engineer Job Vacant Company: Circle Standort: Remote-Büro-Jobtyp: Vollzeitgehalt: 130.000 bis 140.000 US-Dollar Stellenbeschreibung Nehmen Sie an der Forschung und Entwicklung von Mobilfunkanwendungen und öffentlichen API-bezogenen Funktionen, die den gesamten Lebenszyklus der Softwareentwicklung abdecken. Die Hauptaufgaben erledigen die Entwicklungsarbeit unabhängig von RubyonRails und arbeiten mit dem Front-End-Team von React/Redux/Relay zusammen. Erstellen Sie die Kernfunktionalität und -verbesserungen für Webanwendungen und arbeiten Sie eng mit Designer und Führung während des gesamten funktionalen Designprozesses zusammen. Fördern Sie positive Entwicklungsprozesse und priorisieren Sie die Iterationsgeschwindigkeit. Erfordert mehr als 6 Jahre komplexes Backend für Webanwendungen

Wie man MySQL löst, kann nicht gestartet werden

Apr 08, 2025 pm 02:21 PM

Wie man MySQL löst, kann nicht gestartet werden

Apr 08, 2025 pm 02:21 PM

Es gibt viele Gründe, warum MySQL Startup fehlschlägt und durch Überprüfung des Fehlerprotokolls diagnostiziert werden kann. Zu den allgemeinen Ursachen gehören Portkonflikte (prüfen Portbelegung und Änderung der Konfiguration), Berechtigungsprobleme (Überprüfen Sie den Dienst Ausführen von Benutzerberechtigungen), Konfigurationsdateifehler (Überprüfung der Parametereinstellungen), Datenverzeichniskorruption (Wiederherstellung von Daten oder Wiederaufbautabellenraum), InnoDB-Tabellenraumprobleme (prüfen IBDATA1-Dateien), Plug-in-Ladeversagen (Überprüfen Sie Fehlerprotokolle). Wenn Sie Probleme lösen, sollten Sie sie anhand des Fehlerprotokolls analysieren, die Hauptursache des Problems finden und die Gewohnheit entwickeln, Daten regelmäßig zu unterstützen, um Probleme zu verhindern und zu lösen.