Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Regressions-Meta-Lernen, Zielerkennung mit wenigen Stichproben basierend auf der Aggregation von Variationsmerkmalen, um neue SOTA zu erreichen

Regressions-Meta-Lernen, Zielerkennung mit wenigen Stichproben basierend auf der Aggregation von Variationsmerkmalen, um neue SOTA zu erreichen

Regressions-Meta-Lernen, Zielerkennung mit wenigen Stichproben basierend auf der Aggregation von Variationsmerkmalen, um neue SOTA zu erreichen

Im Gegensatz zu herkömmlichen Objekterkennungsproblemen geht die Wenig-Schuss-Objekterkennung (FSOD) davon aus, dass wir über viele Basisklassenbeispiele, aber nur eine kleine Anzahl neuartiger Klassenbeispiele verfügen. Ziel ist es, zu untersuchen, wie Wissen von Grundklassen auf neuartige Klassen übertragen werden kann, um so die Fähigkeit des Detektors zu verbessern, neuartige Klassen zu erkennen.

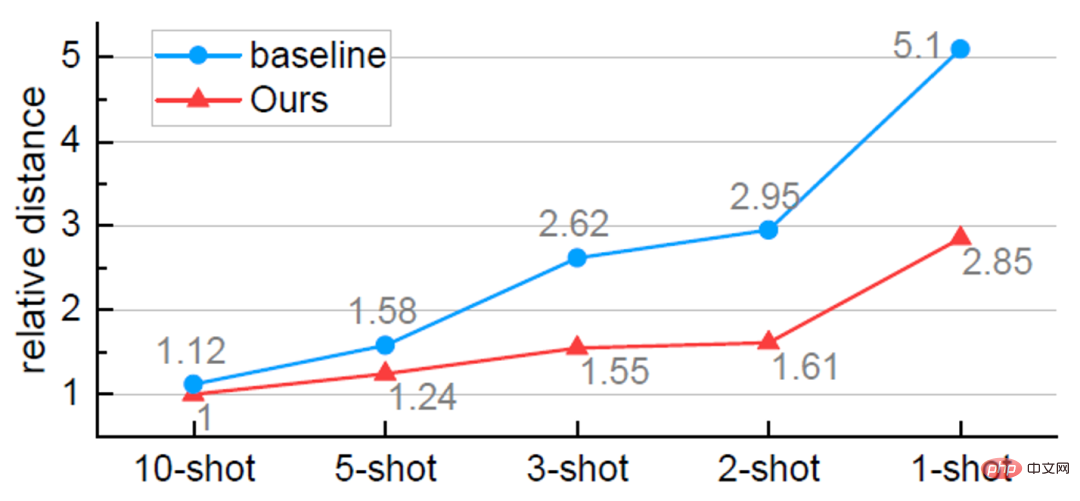

FSOD folgt in der Regel einem zweistufigen Trainingsparadigma . In der ersten Phase wird der Detektor mithilfe umfangreicher Basisklassenproben trainiert, um allgemeine Darstellungen zu erlernen, die für Objekterkennungsaufgaben wie Objektlokalisierung und -klassifizierung erforderlich sind. In der zweiten Stufe erfolgt die Feinabstimmung des Detektors unter Verwendung nur einer kleinen Anzahl (z. B. 1, 2, 3 ...) von Proben neuer Klassen. Aufgrund des Ungleichgewichts in der Anzahl der Basisklassen- und neuartigen Klassenstichproben ist das erlernte Modell jedoch normalerweise auf die Basisklasse ausgerichtet, was zu einer Verwechslung von neuartigen Klassenzielen mit ähnlichen Basisklassen führt. Da es für jede neuartige Klasse nur wenige Stichproben gibt, reagiert das Modell außerdem empfindlich auf die Varianz der neuartigen Klassen. Wenn Sie beispielsweise für mehrere Schulungen zufällig Stichproben aus neuartigen Klassen ziehen, fallen die Ergebnisse jedes Mal recht unterschiedlich aus. Daher ist es unbedingt erforderlich, die Robustheit des Modells bei kleinen Stichproben zu verbessern.

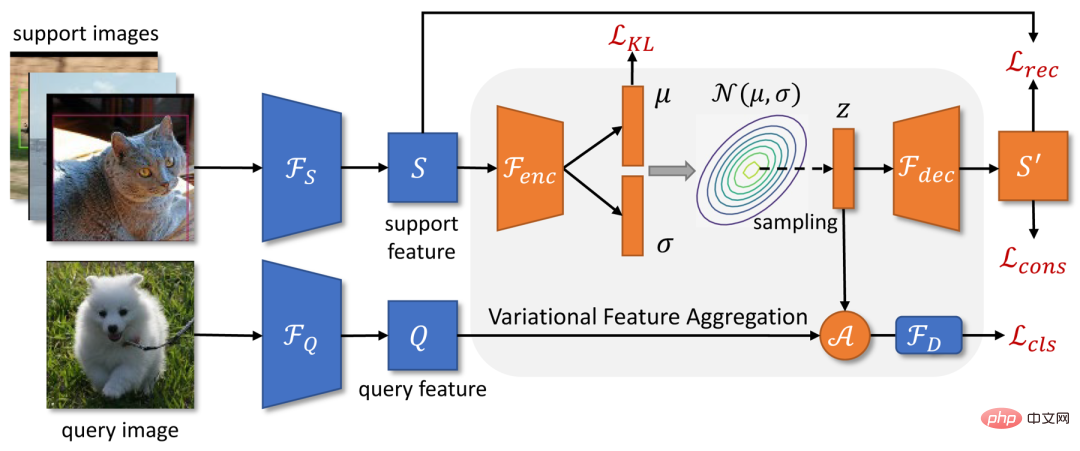

Kürzlich haben Tencent Youtu Lab und die Universität Wuhan ein Zielerkennungsmodell VFA mit wenigen Stichproben vorgeschlagen, das auf der Aggregation von Variationsmerkmalen basiert. Die Gesamtstruktur von VFA basiert auf einer verbesserten Version des Meta-Learning-Zielerkennungs-Frameworks Meta R-CNN++, und es werden zwei Methoden zur Merkmalsaggregation vorgeschlagen: Class-Agnostic Aggregation CAA (Class-Agnostic Aggregation) und Variationsmerkmalsaggregation VFA (Variationsmerkmalsaggregation).

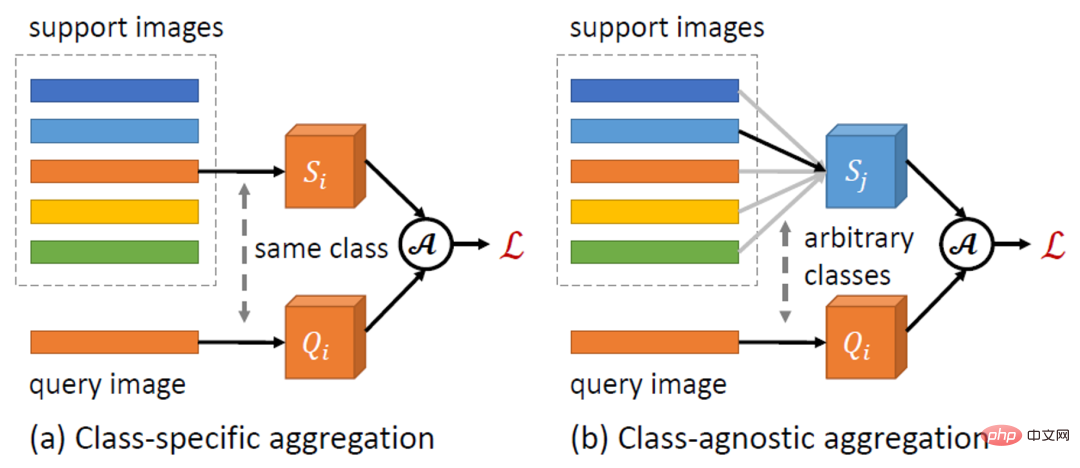

Feature-Aggregation ist ein Schlüsseldesign in FSOD, das die Interaktion zwischen Abfrage- und Support-Beispielen definiert. Frühere Methoden wie Meta R-CNN verwenden normalerweise die klassenspezifische Aggregation (CSA), d. h. Features ähnlicher Abfrage- und Supportbeispiele für die Feature-Aggregation. Im Gegensatz dazu ermöglicht die in diesem Artikel vorgeschlagene CAA die Merkmalsaggregation zwischen Stichproben verschiedener Klassen. Da CAA das Modell dazu ermutigt, klassenunabhängige Darstellungen zu lernen, verringert es die Ausrichtung des Modells auf Basisklassen. Darüber hinaus können Interaktionen zwischen verschiedenen Klassen die Beziehungen zwischen Klassen besser modellieren und so die Klassenverwirrung verringern.Basierend auf CAA schlägt dieses Papier VFA vor, das Variationsencoder (VAEs) verwendet, um Support-Beispiele in Klassenverteilungen zu codieren, und neue Support-Funktionen aus der erlernten Verteilung für die Feature-Fusion zu testen. In einer verwandten Arbeit [1] heißt es, dass die Varianz innerhalb der Klasse (z. B. Variation im Aussehen) zwischen den Klassen ähnlich ist und durch gemeinsame Verteilungen modelliert werden kann. Daher können wir die Verteilung der Basisklassen verwenden, um die Verteilung neuer Klassen abzuschätzen und so die Robustheit der Merkmalsaggregation bei wenigen Stichproben zu verbessern.

VFA schneidet bei mehreren FSOD-Datensätzen besser ab als die derzeit besten Modelle. Verwandte Forschung wurde von AAAI 2023 als mündlich anerkannt.

Papieradresse: https://arxiv.org/abs/2301.13411VFA-Modelldetails

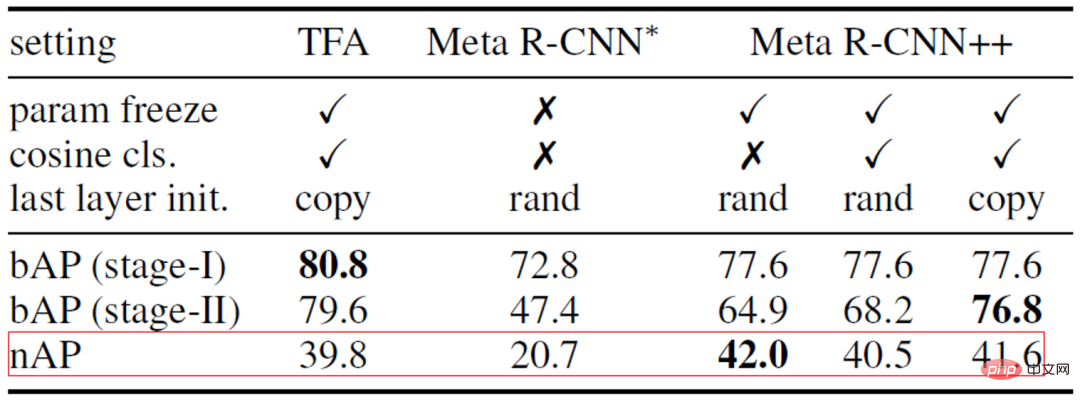

Stärkere Basismethode: Meta R-CNN++

Aktueller FSOD Die Arbeit kann hauptsächlich in zwei Kategorien unterteilt werden: Methoden, die auf Meta-Lernen basieren, und Methoden, die auf Feinabstimmung basieren. Einige frühe Arbeiten zeigten, dass Meta-Learning für FSOD effektiv ist, aber auf Feinabstimmung basierende Methoden haben in letzter Zeit zunehmende Aufmerksamkeit erhalten.In diesem Artikel wird zunächst eine auf Meta-Learning basierende Basismethode Meta R-CNN++ etabliert, die die Lücke zwischen den beiden Methoden verringert und bei einigen Indikatoren sogar die Methode übertrifft, die auf der Feinabstimmung basiert.

Wir haben zunächst einige Lücken in der Implementierung der beiden Methoden analysiert und dabei die Meta-Lernmethode Meta R-CNN [2] und die auf Feinabstimmung basierende Methode TFA [3] als Beispiele genommen, obwohl beide Methoden a folgen Beim zweistufigen Trainingsparadigma optimiert TFA das Modell mithilfe zusätzlicher Techniken während der Feinabstimmungsphase:Angesichts des Erfolgs von TFA haben wir Meta R-CNN++ entwickelt. Wie in Tabelle 1 unten gezeigt, können auch Meta-Lernmethoden gute Ergebnisse erzielen, sofern wir die Feinabstimmungsphase sorgfältig durchführen. Daher wählt dieser Artikel Meta R-CNN++ als Basismethode. Tabelle 1: Vergleich und Analyse von Meta R-CNN und TFA Kategorieunabhängige Feature-Aggregation. CAA Bild 1: Schematische Darstellung der kategorieunabhängigen Feature-Aggregation CAA

Dieser Artikel schlägt eine einfache und effektive kategorieunabhängige Feature-Aggregation-Methode CAA vor. Wie in Abbildung 1 oben dargestellt, ermöglicht CAA die Aggregation von Merkmalen zwischen verschiedenen Klassen und ermutigt so das Modell, klassenunabhängige Darstellungen zu lernen, wodurch die Verzerrung zwischen den Klassen und die Verwirrung zwischen den Klassen verringert werden. Konkret wählen wir für jedes RoI-Feature der Klasse und eine Reihe von Support-Features  ,

,

zufällig das Support-Feature einer Klasse

zufällig das Support-Feature einer Klasse  aus, das mit dem Abfragefeature aggregiert werden soll:

aus, das mit dem Abfragefeature aggregiert werden soll:

Dann geben wir die aggregierten Merkmale

Dann geben wir die aggregierten Merkmale

an das Erkennungs-Subnetzwerk

weiter, um einen Klassifizierungswert  auszugeben

auszugeben

.

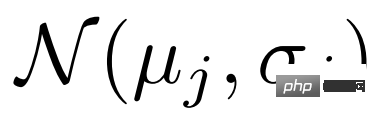

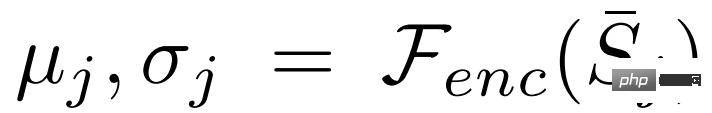

Frühere Arbeiten codierten Support-Beispiele normalerweise in einen einzelnen Feature-Vektor, um das Zentrum der Kategorie darzustellen. Wenn die Stichproben jedoch klein und die Varianz groß sind, ist es für uns schwierig, genaue Schätzungen des Klassenzentrums vorzunehmen. In diesem Artikel konvertieren wir zunächst die Support-Funktionen in Verteilungen über Klassen. Da die geschätzte Klassenverteilung nicht auf bestimmte Stichproben ausgerichtet ist, sind aus der Verteilung entnommene Merkmale relativ robust gegenüber der Varianz der Stichproben. Der Rahmen von VFA ist in Abbildung 2 oben dargestellt. a) Variationelles Feature-Lernen. VFA verwendet Variations-Autoencoder-VAEs [4], um die Verteilung von Kategorien zu lernen. Wie in Abbildung 2 dargestellt, verwenden wir für ein Support-Feature S zunächst den Encoder

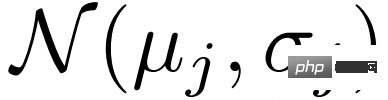

, um die Parameter der Verteilung

, um die Parameter der Verteilung  und

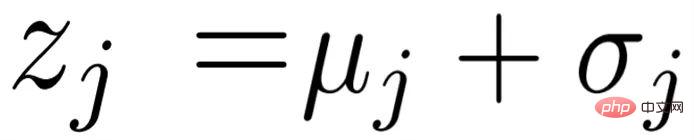

und  zu schätzen, und nehmen dann Stichproben aus der Verteilung

zu schätzen, und nehmen dann Stichproben aus der Verteilung  durch Variationsinferenz

durch Variationsinferenz  , und schließlich wird die rekonstruierte Support-Funktion

, und schließlich wird die rekonstruierte Support-Funktion  über den Decoder

über den Decoder  abgerufen. Bei der Optimierung von VAE wird in diesem Artikel neben dem üblichen KL-Verlust

abgerufen. Bei der Optimierung von VAE wird in diesem Artikel neben dem üblichen KL-Verlust und dem Rekonstruktionsverlust

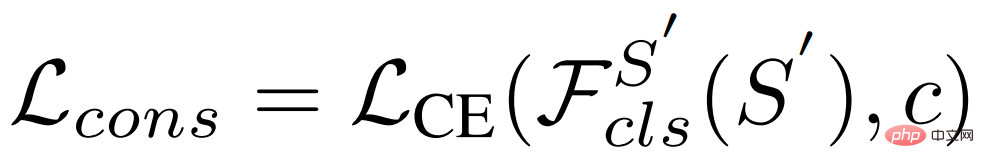

und dem Rekonstruktionsverlust auch der Konsistenzverlust verwendet, damit die erlernte Verteilung die Kategorieinformationen beibehält:

auch der Konsistenzverlust verwendet, damit die erlernte Verteilung die Kategorieinformationen beibehält:

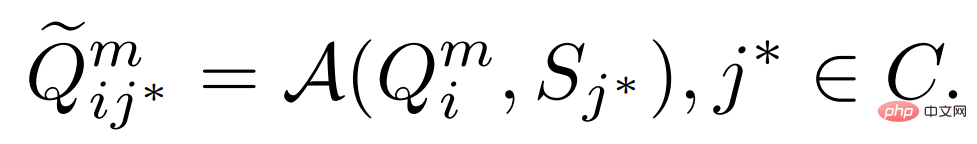

b) Variationelle Feature-Fusion. Da die Support-Funktion in eine Verteilung von Kategorien umgewandelt wird, können wir Features aus der Verteilung auswählen und sie mit der Abfragefunktion aggregieren. Insbesondere verwendet VFA auch kategorieunabhängige Aggregations-CAA, aggregiert jedoch Abfragefunktionen  und Variationsfunktionen

und Variationsfunktionen  zusammen. Bei einer Abfragefunktion der Klasse

zusammen. Bei einer Abfragefunktion der Klasse  und einer Supportfunktion der Klasse

und einer Supportfunktion der Klasse

schätzen wir zunächst deren Verteilung

schätzen wir zunächst deren Verteilung  und führen eine Stichprobenvariation durch Funktionen

und führen eine Stichprobenvariation durch Funktionen

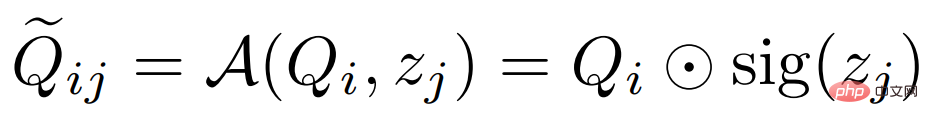

und verschmelzen sie dann mit der folgenden Formel:  # 🎜🎜#

# 🎜🎜# #🎜 🎜#

#🎜 🎜#

die Kanalmultiplikation darstellt und sig die Abkürzung für Sigmoidoperation ist. In der Trainingsphase wählen wir zufällig eine Support-Funktion

die Kanalmultiplikation darstellt und sig die Abkürzung für Sigmoidoperation ist. In der Trainingsphase wählen wir zufällig eine Support-Funktion

wie  # 🎜🎜# Unterstützungsfunktionen werden gemittelt

# 🎜🎜# Unterstützungsfunktionen werden gemittelt

und die Verteilung wird geschätzt

und die Verteilung wird geschätzt

, wobei Typischerweise enthält das Erkennungs-Subnetzwerk  #🎜 🎜 #.

#🎜 🎜 #.

Klassifizierung – Entkopplung von Regressionsaufgaben

Klassifizierung – Entkopplung von Regressionsaufgaben

einen gemeinsamen Feature-Extraktor

einen gemeinsamen Feature-Extraktor  und Zwei unabhängige Netzwerke: Klassifizierungs-Subnetzwerk

und Zwei unabhängige Netzwerke: Klassifizierungs-Subnetzwerk  und Regressions-Subnetzwerk

und Regressions-Subnetzwerk  . In früheren Arbeiten wurden die aggregierten Merkmale zur Objektklassifizierung und Bounding-Box-Regression in das Erkennungssubnetzwerk eingegeben. Für Klassifizierungsaufgaben sind jedoch übersetzungsinvariante Merkmale erforderlich, während für die Regression übersetzungskovariante Merkmale erforderlich sind. Da das Support-Feature das Zentrum der Kategorie darstellt und übersetzungsinvariant ist, beeinträchtigen die aggregierten Features die Regressionsaufgabe.

. In früheren Arbeiten wurden die aggregierten Merkmale zur Objektklassifizierung und Bounding-Box-Regression in das Erkennungssubnetzwerk eingegeben. Für Klassifizierungsaufgaben sind jedoch übersetzungsinvariante Merkmale erforderlich, während für die Regression übersetzungskovariante Merkmale erforderlich sind. Da das Support-Feature das Zentrum der Kategorie darstellt und übersetzungsinvariant ist, beeinträchtigen die aggregierten Features die Regressionsaufgabe.

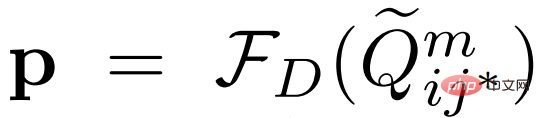

Dieser Artikel schlägt eine einfache Entkopplung von Klassifizierungs- und Regressionsaufgaben vor. Lassen Sie  und

und  die ursprünglichen und aggregierten Abfragefunktionen darstellen. Die vorherige Methode übernimmt # für beide Aufgaben.

die ursprünglichen und aggregierten Abfragefunktionen darstellen. Die vorherige Methode übernimmt # für beide Aufgaben.  , wobei der Klassifizierungswert

, wobei der Klassifizierungswert  und der vorhergesagte Begrenzungsrahmen

und der vorhergesagte Begrenzungsrahmen  wie folgt definiert sind:

wie folgt definiert sind:

Um diese Aufgaben zu entkoppeln, übernehmen wir separate Feature-Extraktoren und verwenden die ursprünglichen Support-Features#🎜🎜 ##🎜 🎜#Bounding-Box-Regression durchführen: #Experimentelle Auswertung Der von uns verwendete Datensatz:

Der von uns verwendete Datensatz:

PASCAL VOC, MS COCO.

Novel-Klasse durchschnittliche Präzision nAP, Basisklasse durchschnittliche Präzision bAP

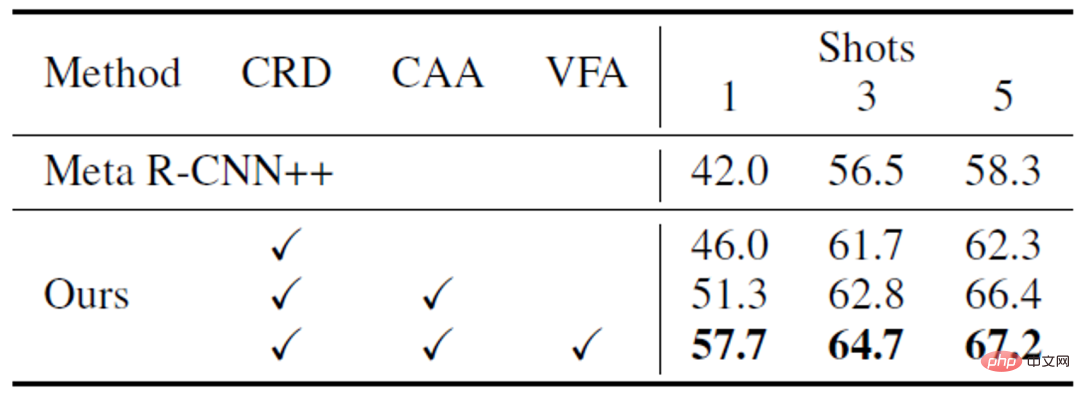

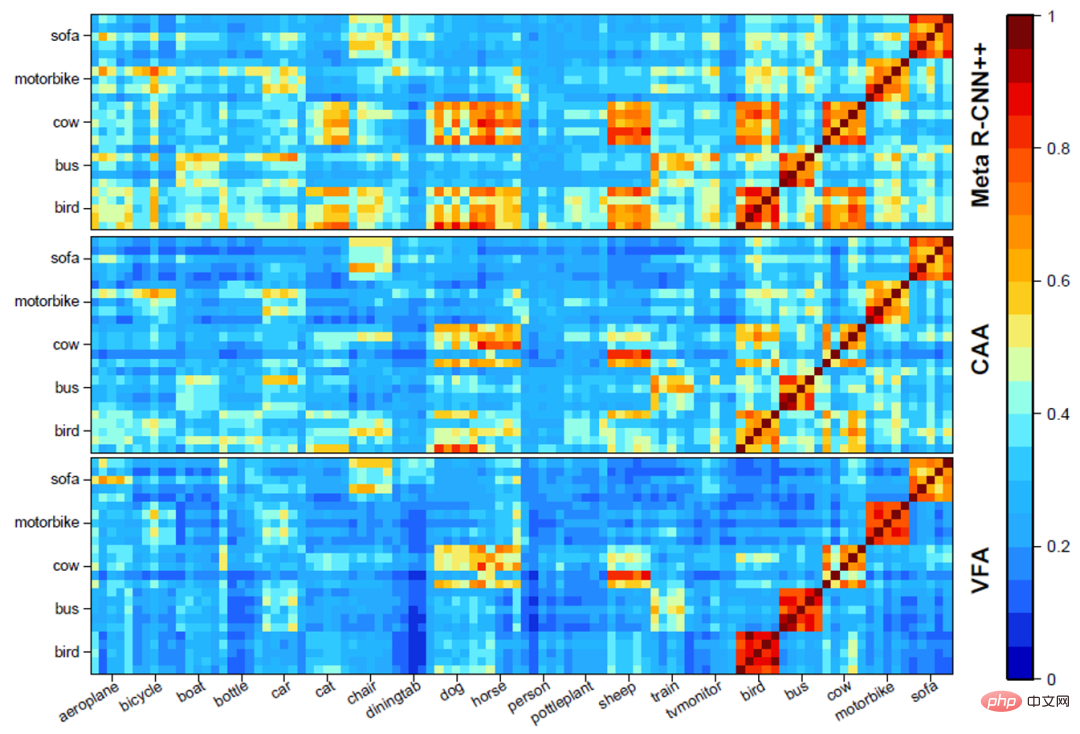

Ablationsexperiment a) Die Rolle verschiedener Module# 🎜 🎜#. Wie in Tabelle 3 unten gezeigt, können verschiedene VFA-Module zusammenarbeiten, um die Leistung des Modells zu verbessern. b) Visuelle Analyse verschiedener Feature-Aggregation-Methoden #🎜 🎜#. Wie in Abbildung 3 unten dargestellt, kann CAA die Verwirrung zwischen Basisklassen und neuartigen Klassen verringern und die Unterscheidung zwischen auf CAA basierenden Klassen weiter verbessern. Abbildung 5 Visualisierungsergebnisse#🎜 🎜# Fazit

Dieses Papier kehrt zur Feature-Aggregation-Methode in FSOD basierend auf Meta-Learning zurück und schlägt Kategorien vor. Unabhängige Features Aggregate CAA und Variationsfeature Aggregation VFA. CAA kann Klassenverzerrungen und Verwirrung zwischen Basisklassen und neuartigen Klassen reduzieren; VFA wandelt Stichproben in Klassenverteilungen um, um eine robustere Merkmalsaggregation zu erreichen. Experimente mit den PASCAL VOC- und MS COCO-Datensätzen zeigen die Wirksamkeit der in diesem Artikel vorgeschlagenen Methode.

Dieses Papier kehrt zur Feature-Aggregation-Methode in FSOD basierend auf Meta-Learning zurück und schlägt Kategorien vor. Unabhängige Features Aggregate CAA und Variationsfeature Aggregation VFA. CAA kann Klassenverzerrungen und Verwirrung zwischen Basisklassen und neuartigen Klassen reduzieren; VFA wandelt Stichproben in Klassenverteilungen um, um eine robustere Merkmalsaggregation zu erreichen. Experimente mit den PASCAL VOC- und MS COCO-Datensätzen zeigen die Wirksamkeit der in diesem Artikel vorgeschlagenen Methode.

Das obige ist der detaillierte Inhalt vonRegressions-Meta-Lernen, Zielerkennung mit wenigen Stichproben basierend auf der Aggregation von Variationsmerkmalen, um neue SOTA zu erreichen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem völlig kostenlosen KI-Gesichtstausch-Tool aus!

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

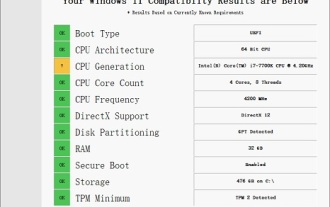

Lösung für i7-7700, kein Upgrade auf Windows 11 möglich

Dec 26, 2023 pm 06:52 PM

Lösung für i7-7700, kein Upgrade auf Windows 11 möglich

Dec 26, 2023 pm 06:52 PM

Die Leistung des i77700 reicht völlig aus, um Win11 auszuführen, aber Benutzer stellen fest, dass ihr i77700 nicht auf Win11 aktualisiert werden kann. Dies ist hauptsächlich auf die von Microsoft auferlegten Einschränkungen zurückzuführen, sodass sie es installieren können, solange sie diese Einschränkung überspringen. i77700 kann nicht auf win11 aktualisiert werden: 1. Weil Microsoft die CPU-Version begrenzt. 2. Nur die Intel-Versionen der achten Generation und höher können direkt auf Win11 aktualisiert werden. 3. Als 7. Generation kann der i77700 die Upgrade-Anforderungen von Win11 nicht erfüllen. 4. Der i77700 ist jedoch hinsichtlich der Leistung durchaus in der Lage, Win11 reibungslos zu nutzen. 5. Sie können also das Win11-Direktinstallationssystem dieser Site verwenden. 6. Nachdem der Download abgeschlossen ist, klicken Sie mit der rechten Maustaste auf die Datei und „laden“ sie. 7. Doppelklicken Sie, um den „One-Click“-Vorgang auszuführen

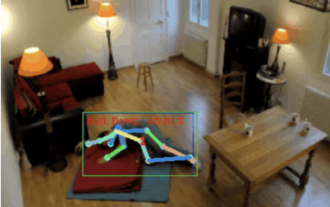

Die Sturzerkennung basiert auf der Erkennung menschlicher Skelettpunkte. Ein Teil des Codes wird mit Chatgpt vervollständigt

Apr 12, 2023 am 08:19 AM

Die Sturzerkennung basiert auf der Erkennung menschlicher Skelettpunkte. Ein Teil des Codes wird mit Chatgpt vervollständigt

Apr 12, 2023 am 08:19 AM

Hallo zusammen. Heute möchte ich Ihnen ein Projekt zur Sturzerkennung vorstellen. Genauer gesagt handelt es sich um die Erkennung menschlicher Bewegungen auf der Grundlage von Skelettpunkten. Es ist grob in drei Schritte unterteilt: Erkennung des menschlichen Körpers, Punktaktionsklassifizierung des menschlichen Skeletts. Der Quellcode des Projekts wurde gepackt. Informationen zum Erhalt finden Sie am Ende des Artikels. 0. chatgpt Zuerst müssen wir den überwachten Videostream abrufen. Dieser Code ist relativ fest. Wir können chatgpt den von chatgpt geschriebenen Code direkt vervollständigen lassen. Wenn es jedoch später um geschäftliche Aufgaben geht, beispielsweise die Verwendung von Mediapipe zur Identifizierung menschlicher Skelettpunkte, ist der von chatgpt bereitgestellte Code falsch. Ich denke, dass chatgpt als Toolbox verwendet werden kann, die unabhängig von der Geschäftslogik sein kann. Sie können versuchen, es an c zu übergeben

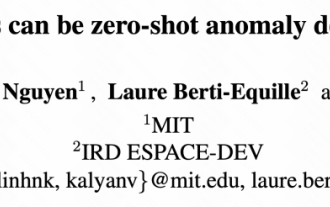

Das neueste Meisterwerk des MIT: Verwendung von GPT-3.5 zur Lösung des Problems der Erkennung von Zeitreihenanomalien

Jun 08, 2024 pm 06:09 PM

Das neueste Meisterwerk des MIT: Verwendung von GPT-3.5 zur Lösung des Problems der Erkennung von Zeitreihenanomalien

Jun 08, 2024 pm 06:09 PM

Heute möchte ich Ihnen einen letzte Woche vom MIT veröffentlichten Artikel vorstellen, in dem GPT-3.5-turbo verwendet wird, um das Problem der Erkennung von Zeitreihenanomalien zu lösen, und zunächst die Wirksamkeit von LLM bei der Erkennung von Zeitreihenanomalien überprüft wird. Im gesamten Prozess gibt es keine Feinabstimmung, und GPT-3.5-Turbo wird direkt zur Anomalieerkennung verwendet. Der Kern dieses Artikels besteht darin, wie man Zeitreihen in Eingaben umwandelt, die von GPT-3.5-Turbo erkannt werden können, und wie man sie entwirft Eingabeaufforderungen oder Pipelines, damit LLM die Anomalieerkennungsaufgabe lösen kann. Lassen Sie mich Ihnen diese Arbeit im Detail vorstellen. Titel des Bildpapiers: Largelingualmodelscanbezero-shotanomalydete

Verbesserter Erkennungsalgorithmus: zur Zielerkennung in hochauflösenden optischen Fernerkundungsbildern

Jun 06, 2024 pm 12:33 PM

Verbesserter Erkennungsalgorithmus: zur Zielerkennung in hochauflösenden optischen Fernerkundungsbildern

Jun 06, 2024 pm 12:33 PM

01Ausblicksübersicht Derzeit ist es schwierig, ein angemessenes Gleichgewicht zwischen Detektionseffizienz und Detektionsergebnissen zu erreichen. Wir haben einen verbesserten YOLOv5-Algorithmus zur Zielerkennung in hochauflösenden optischen Fernerkundungsbildern entwickelt, der mehrschichtige Merkmalspyramiden, Multierkennungskopfstrategien und hybride Aufmerksamkeitsmodule verwendet, um die Wirkung des Zielerkennungsnetzwerks in optischen Fernerkundungsbildern zu verbessern. Laut SIMD-Datensatz ist der mAP des neuen Algorithmus 2,2 % besser als YOLOv5 und 8,48 % besser als YOLOX, wodurch ein besseres Gleichgewicht zwischen Erkennungsergebnissen und Geschwindigkeit erreicht wird. 02 Hintergrund und Motivation Mit der rasanten Entwicklung der Fernerkundungstechnologie wurden hochauflösende optische Fernerkundungsbilder verwendet, um viele Objekte auf der Erdoberfläche zu beschreiben, darunter Flugzeuge, Autos, Gebäude usw. Objekterkennung bei der Interpretation von Fernerkundungsbildern

Fügen Sie SOTA in Echtzeit hinzu und explodieren Sie! FastOcc: Schnellere Inferenz und ein einsatzfreundlicher Occ-Algorithmus sind da!

Mar 14, 2024 pm 11:50 PM

Fügen Sie SOTA in Echtzeit hinzu und explodieren Sie! FastOcc: Schnellere Inferenz und ein einsatzfreundlicher Occ-Algorithmus sind da!

Mar 14, 2024 pm 11:50 PM

Oben geschrieben & Das persönliche Verständnis des Autors ist, dass im autonomen Fahrsystem die Wahrnehmungsaufgabe eine entscheidende Komponente des gesamten autonomen Fahrsystems ist. Das Hauptziel der Wahrnehmungsaufgabe besteht darin, autonome Fahrzeuge in die Lage zu versetzen, Umgebungselemente wie auf der Straße fahrende Fahrzeuge, Fußgänger am Straßenrand, während der Fahrt angetroffene Hindernisse, Verkehrszeichen auf der Straße usw. zu verstehen und wahrzunehmen und so flussabwärts zu helfen Module Treffen Sie richtige und vernünftige Entscheidungen und Handlungen. Ein Fahrzeug mit autonomen Fahrfähigkeiten ist in der Regel mit verschiedenen Arten von Informationserfassungssensoren ausgestattet, wie z. B. Rundumsichtkamerasensoren, Lidar-Sensoren, Millimeterwellenradarsensoren usw., um sicherzustellen, dass das autonome Fahrzeug die Umgebung genau wahrnehmen und verstehen kann Elemente, die es autonomen Fahrzeugen ermöglichen, beim autonomen Fahren die richtigen Entscheidungen zu treffen. Kopf

Wie erkennt und behandelt man Nullwertfehler bei der PHP-Sprachentwicklung?

Jun 11, 2023 am 10:51 AM

Wie erkennt und behandelt man Nullwertfehler bei der PHP-Sprachentwicklung?

Jun 11, 2023 am 10:51 AM

Mit der kontinuierlichen Weiterentwicklung moderner Webanwendungen wird PHP als eine der beliebtesten Programmiersprachen häufig in der Website-Entwicklung eingesetzt. Während des Entwicklungsprozesses treten jedoch häufig Nullwertfehler auf, die dazu führen können, dass die Anwendung Ausnahmen auslöst und somit die Benutzererfahrung beeinträchtigt. Daher ist das Erkennen und Behandeln von Nullfehlern im PHP-Entwicklungsprozess eine wichtige Fähigkeit, die Programmierer beherrschen müssen. 1. Was ist ein Nullwertfehler? Im PHP-Entwicklungsprozess beziehen sich Nullwertfehler normalerweise auf zwei Situationen: nicht initialisierte Variablen und variable Variablen.

AAAI2024: Far3D – Innovative Idee zur direkten visuellen 3D-Zielerkennung von 150 m

Dec 15, 2023 pm 01:54 PM

AAAI2024: Far3D – Innovative Idee zur direkten visuellen 3D-Zielerkennung von 150 m

Dec 15, 2023 pm 01:54 PM

Kürzlich habe ich auf Arxiv eine aktuelle Studie zur reinen visuellen Umgebungswahrnehmung gelesen. Diese Forschung basiert auf der PETR-Methodenreihe und konzentriert sich auf die Lösung des rein visuellen Wahrnehmungsproblems der Zielerkennung über große Entfernungen, wobei der Wahrnehmungsbereich auf 150 Meter erweitert wird. Die Methoden und Ergebnisse dieses Papiers haben für uns einen großen Referenzwert, daher habe ich versucht, es zu interpretieren. Originaltitel: Far3D: Expanding the Horizon for Surround-view3DObject Detection. Papierlink: https://arxiv.org/abs/2308.09616 Autorenzugehörigkeit :Beijing Institute of Technology & Megvii Technology Aufgabenhintergrund 3D-Objekterkennung zum Verständnis des autonomen Fahrens

Wie kann ein Transformator verwendet werden, um die visuellen Merkmale des Lidar-Millimeterwellenradars effektiv zu korrelieren?

Apr 19, 2024 pm 04:01 PM

Wie kann ein Transformator verwendet werden, um die visuellen Merkmale des Lidar-Millimeterwellenradars effektiv zu korrelieren?

Apr 19, 2024 pm 04:01 PM

Eine der Grundaufgaben für das persönliche Verständnis des Autors zum autonomen Fahren ist die dreidimensionale Zielerkennung, und viele Methoden werden mittlerweile auf Basis der Multisensorfusion implementiert. Warum ist also eine Multisensorfusion erforderlich? Ob Lidar- und Kamerafusion oder Millimeterwellenradar- und Kamerafusion, der Hauptzweck besteht darin, die komplementäre Verbindung zwischen Punktwolken und Bildern zu nutzen, um die Genauigkeit der Zielerkennung zu verbessern. Mit der kontinuierlichen Anwendung der Transformer-Architektur im Bereich Computer Vision haben auf Aufmerksamkeitsmechanismen basierende Methoden die Genauigkeit der Fusion zwischen mehreren Sensoren verbessert. Die beiden gemeinsamen Arbeiten basieren auf dieser Architektur und schlagen neuartige Fusionsmethoden vor, um die nützlichen Informationen ihrer jeweiligen Modalitäten besser zu nutzen und eine bessere Fusion zu erreichen. TransFusion: Hauptbeitrag