Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Yann LeCun spricht über Google Research: Zielgerichtete Kommunikation gibt es schon lange, wo ist Ihre Innovation?

Yann LeCun spricht über Google Research: Zielgerichtete Kommunikation gibt es schon lange, wo ist Ihre Innovation?

Yann LeCun spricht über Google Research: Zielgerichtete Kommunikation gibt es schon lange, wo ist Ihre Innovation?

Vor ein paar Tagen stellte der akademische Turing-Award-Gewinner Yann LeCun eine Google-Studie in Frage.

Vor einiger Zeit schlug Google AI in seiner neuen Forschung „LocoProp: Enhancing BackProp via Local Loss Optimization“ ein allgemeines hierarchisches Verlustkonstruktions-Framework LocoProp für mehrschichtige neuronale Netze vor, das nur Optimierer erster Ordnung verwendet und gleichzeitig Leistung erzielt nahe an dem von Methoden zweiter Ordnung.

Genauer gesagt stellt sich das Framework ein neuronales Netzwerk als eine modulare Zusammensetzung aus mehreren Schichten vor, wobei jede Schicht ihre eigene Gewichtsregulierungs-, Zielausgabe- und Verlustfunktion verwendet, wodurch letztendlich sowohl Leistung als auch Effizienz erreicht werden.

Google hat die Wirksamkeit seiner Methode experimentell anhand von Benchmark-Modellen und Datensätzen überprüft und so die Lücke zwischen Optimierern erster und zweiter Ordnung verringert. Darüber hinaus gaben Google-Forscher an, dass ihre Methode zur Konstruktion lokaler Verluste das erste Mal ist, dass quadratische Verluste als lokale Verluste verwendet werden.

Bildquelle: @Google AI

Zu dieser Recherche von Google haben einige Leute kommentiert, dass sie großartig und interessant ist. Einige Leute äußerten jedoch unterschiedliche Ansichten, darunter der Turing-Preisträger Yann LeCun.

Er glaubt, dass es viele Versionen dessen gibt, was wir heute als Zielobjekte bezeichnen, einige davon stammen aus dem Jahr 1986. Was ist also der Unterschied zwischen Googles LocoProp und ihnen?

Bildquelle: @Yann LeCun

In Bezug auf LeCuns Frage stimmte Haohan Wang, der im Begriff ist, Assistenzprofessor an der UIUC zu werden, zu. Er sagte, es sei manchmal überraschend, warum einige Autoren dachten, eine so einfache Idee sei die erste ihrer Art. Vielleicht haben sie etwas anderes gemacht, aber das Werbeteam konnte es kaum erwarten, herauszukommen und alles zu behaupten ...

Fotoquelle: @HaohanWang

Einige Leute sind jedoch „nicht kalt“ gegenüber LeCun und denken, dass er Aus Wettbewerbsüberlegungen werfe man Fragen auf und provoziere sogar „Krieg“. LeCun antwortete und behauptete, dass seine Frage nichts mit Konkurrenz zu tun habe, und nannte als Beispiel ehemalige Mitglieder seines Labors wie Marc'Aurelio Ranzato, Karol Gregor, Koray Kavukcuoglu usw., die alle einige Versionen der Zielausbreitung verwendet hätten. und jetzt arbeiten sie alle bei Google DeepMind. Fotoquelle: @Gabriel Jimenez @Yann LeCun Werfen wir zunächst einen Blick darauf, worum es in dieser Google-Studie geht. Gibt es eine herausragende Innovation?

Google LocoProp: Verbesserte Backpropagation mit lokaler Verlustoptimierung

Papieradresse: https://proceedings.mlr.press/v151/amid22a/amid22a.pdf

Es gibt auch fortgeschrittenere Optimierungsmethoden wie Shampoo, K-FAC usw., die nachweislich die Konvergenz verbessern und die Anzahl der Iterationen reduzieren. Diese Methoden können Änderungen in Gradienten erfassen. Mithilfe dieser zusätzlichen Informationen können Optimierer höherer Ordnung effizientere Aktualisierungsrichtungen für das trainierte Modell ermitteln, indem sie Korrelationen zwischen verschiedenen Parametergruppen berücksichtigen. Der Nachteil besteht darin, dass die Berechnung von Aktualisierungsrichtungen höherer Ordnung rechenintensiver ist als Aktualisierungen erster Ordnung.

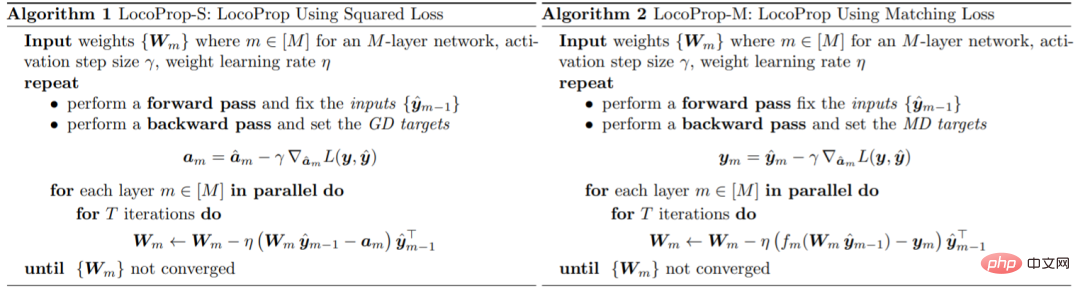

Google stellte in dem Artikel ein Framework zum Training von DNN-Modellen vor: LocoProp, das neuronale Netze als modulare Kombinationen von Schichten betrachtet. Im Allgemeinen führt jede Schicht eines neuronalen Netzwerks eine lineare Transformation der Eingabe durch, gefolgt von einer nichtlinearen Aktivierungsfunktion. In dieser Studie wurde jeder Schicht des Netzwerks ein eigener Gewichtsregulator, ein eigenes Ausgabeziel und eine eigene Verlustfunktion zugewiesen. Die Verlustfunktion jeder Schicht ist so konzipiert, dass sie mit der Aktivierungsfunktion dieser Schicht übereinstimmt. Mit dieser Form kann das Training einer bestimmten kleinen Menge lokaler Verluste minimiert werden, indem parallel zwischen Schichten iteriert wird.

Google verwendet diesen Optimierer erster Ordnung für Parameteraktualisierungen und vermeidet so den Rechenaufwand, der für Optimierer höherer Ordnung erforderlich ist.

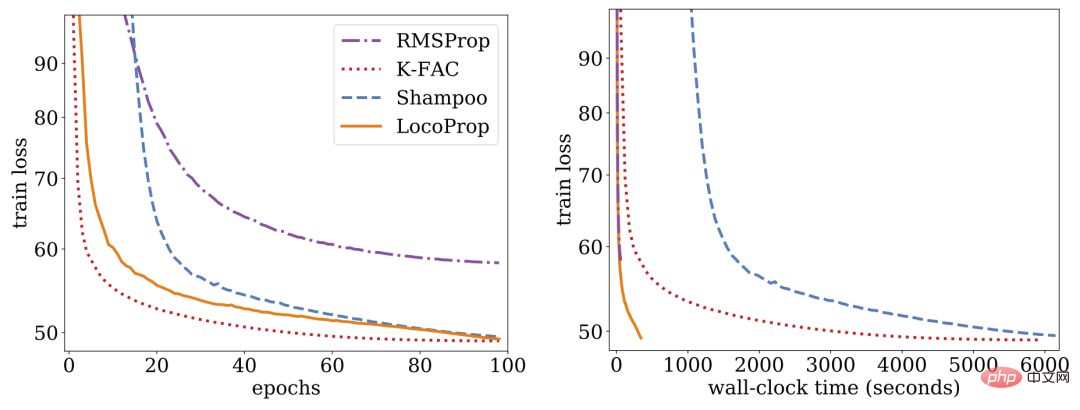

Untersuchungen zeigen, dass LocoProp Methoden erster Ordnung bei Deep-Autoencoder-Benchmarks übertrifft und eine vergleichbare Leistung wie Optimierer höherer Ordnung wie Shampoo und K-FAC ohne hohen Speicher- und Rechenaufwand erbringt.

LocoProp: Verbesserte Backpropagation mit lokaler Verlustoptimierung

Typischerweise werden neuronale Netze als zusammengesetzte Funktionen betrachtet, die die Eingabe jeder Schicht in eine Ausgabedarstellung umwandeln. LocoProp übernimmt diese Perspektive bei der Zerlegung des Netzwerks in Schichten. Anstatt die Gewichtungen einer Schicht zu aktualisieren, um eine Verlustfunktion auf die Ausgabe zu minimieren, wendet LocoProp insbesondere eine vordefinierte lokale Verlustfunktion an, die für jede Schicht spezifisch ist. Für eine bestimmte Schicht wird die Verlustfunktion so gewählt, dass sie mit der Aktivierungsfunktion übereinstimmt. Beispielsweise würde ein Tanh-Verlust für eine Schicht mit Tanh-Aktivierung gewählt. Darüber hinaus stellt der Regularisierungsterm sicher, dass die aktualisierten Gewichte nicht zu weit von ihren aktuellen Werten abweichen.

Ähnlich wie bei der Backpropagation wendet LocoProp einen Vorwärtsdurchlauf an, um Aktivierungen zu berechnen. Beim Rückwärtsdurchlauf legt LocoProp Ziele für Neuronen in jeder Schicht fest. Schließlich zerlegt LocoProp das Modelltraining in unabhängige Probleme über Schichten hinweg, wobei mehrere lokale Aktualisierungen parallel auf die Gewichte jeder Schicht angewendet werden können.

Google hat Experimente mit Deep-Autoencoder-Modellen durchgeführt, einem gängigen Maßstab für die Bewertung der Leistung von Optimierungsalgorithmen. Sie führten umfangreiche Optimierungen an mehreren häufig verwendeten Optimierern erster Ordnung durch, darunter SGD, SGD mit Momentum, AdaGrad, RMSProp, Adam und Optimierern höherer Ordnung, einschließlich Shampoo, K-FAC, und verglichen die Ergebnisse mit LocoProp. Die Ergebnisse zeigen, dass die LocoProp-Methode eine deutlich bessere Leistung als Optimierer erster Ordnung erbringt und mit Optimierern höherer Ordnung vergleichbar ist, während sie bei der Ausführung auf einer einzelnen GPU deutlich schneller ist.

Das obige ist der detaillierte Inhalt vonYann LeCun spricht über Google Research: Zielgerichtete Kommunikation gibt es schon lange, wo ist Ihre Innovation?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1377

1377

52

52

Wie man MySQL löst, kann nicht gestartet werden

Apr 08, 2025 pm 02:21 PM

Wie man MySQL löst, kann nicht gestartet werden

Apr 08, 2025 pm 02:21 PM

Es gibt viele Gründe, warum MySQL Startup fehlschlägt und durch Überprüfung des Fehlerprotokolls diagnostiziert werden kann. Zu den allgemeinen Ursachen gehören Portkonflikte (prüfen Portbelegung und Änderung der Konfiguration), Berechtigungsprobleme (Überprüfen Sie den Dienst Ausführen von Benutzerberechtigungen), Konfigurationsdateifehler (Überprüfung der Parametereinstellungen), Datenverzeichniskorruption (Wiederherstellung von Daten oder Wiederaufbautabellenraum), InnoDB-Tabellenraumprobleme (prüfen IBDATA1-Dateien), Plug-in-Ladeversagen (Überprüfen Sie Fehlerprotokolle). Wenn Sie Probleme lösen, sollten Sie sie anhand des Fehlerprotokolls analysieren, die Hauptursache des Problems finden und die Gewohnheit entwickeln, Daten regelmäßig zu unterstützen, um Probleme zu verhindern und zu lösen.

Kann MySQL JSON zurückgeben?

Apr 08, 2025 pm 03:09 PM

Kann MySQL JSON zurückgeben?

Apr 08, 2025 pm 03:09 PM

MySQL kann JSON -Daten zurückgeben. Die JSON_EXTRACT -Funktion extrahiert Feldwerte. Über komplexe Abfragen sollten Sie die Where -Klausel verwenden, um JSON -Daten zu filtern, aber auf die Leistungsauswirkungen achten. Die Unterstützung von MySQL für JSON nimmt ständig zu, und es wird empfohlen, auf die neuesten Versionen und Funktionen zu achten.

Verstehen von Säureeigenschaften: Die Säulen einer zuverlässigen Datenbank

Apr 08, 2025 pm 06:33 PM

Verstehen von Säureeigenschaften: Die Säulen einer zuverlässigen Datenbank

Apr 08, 2025 pm 06:33 PM

Detaillierte Erläuterung von Datenbanksäureattributen Säureattribute sind eine Reihe von Regeln, um die Zuverlässigkeit und Konsistenz von Datenbanktransaktionen sicherzustellen. Sie definieren, wie Datenbanksysteme Transaktionen umgehen, und sorgen dafür, dass die Datenintegrität und -genauigkeit auch im Falle von Systemabstürzen, Leistungsunterbrechungen oder mehreren Benutzern gleichzeitiger Zugriff. Säureattributübersicht Atomizität: Eine Transaktion wird als unteilbare Einheit angesehen. Jeder Teil schlägt fehl, die gesamte Transaktion wird zurückgerollt und die Datenbank behält keine Änderungen bei. Wenn beispielsweise eine Banküberweisung von einem Konto abgezogen wird, jedoch nicht auf ein anderes erhöht wird, wird der gesamte Betrieb widerrufen. begintransaktion; updateAccountsSetBalance = Balance-100WH

Laravel eloquent orm bei bangla partieller Modellsuche)

Apr 08, 2025 pm 02:06 PM

Laravel eloquent orm bei bangla partieller Modellsuche)

Apr 08, 2025 pm 02:06 PM

Laraveleloquent-Modellab Abruf: Das Erhalten von Datenbankdaten Eloquentorm bietet eine prägnante und leicht verständliche Möglichkeit, die Datenbank zu bedienen. In diesem Artikel werden verschiedene eloquente Modellsuchtechniken im Detail eingeführt, um Daten aus der Datenbank effizient zu erhalten. 1. Holen Sie sich alle Aufzeichnungen. Verwenden Sie die Methode All (), um alle Datensätze in der Datenbanktabelle zu erhalten: UseApp \ Models \ post; $ posts = post :: all (); Dies wird eine Sammlung zurückgeben. Sie können mit der Foreach-Schleife oder anderen Sammelmethoden auf Daten zugreifen: foreach ($ postas $ post) {echo $ post->

Master SQL Limit -Klausel: Steuern Sie die Anzahl der Zeilen in einer Abfrage

Apr 08, 2025 pm 07:00 PM

Master SQL Limit -Klausel: Steuern Sie die Anzahl der Zeilen in einer Abfrage

Apr 08, 2025 pm 07:00 PM

SQllimit -Klausel: Steuern Sie die Anzahl der Zeilen in Abfrageergebnissen. Die Grenzklausel in SQL wird verwendet, um die Anzahl der von der Abfrage zurückgegebenen Zeilen zu begrenzen. Dies ist sehr nützlich, wenn große Datensätze, paginierte Anzeigen und Testdaten verarbeitet werden und die Abfrageeffizienz effektiv verbessern können. Grundlegende Syntax der Syntax: SelectColumn1, Spalte2, ... Fromtable_Namelimitnumber_of_rows; number_of_rows: Geben Sie die Anzahl der zurückgegebenen Zeilen an. Syntax mit Offset: SelectColumn1, Spalte2, ... Fromtable_NamelimitOffset, Number_of_rows; Offset: Skip überspringen

Wie optimieren Sie die MySQL-Leistung für Hochlastanwendungen?

Apr 08, 2025 pm 06:03 PM

Wie optimieren Sie die MySQL-Leistung für Hochlastanwendungen?

Apr 08, 2025 pm 06:03 PM

Die MySQL-Datenbankleistung Optimierungshandbuch In ressourcenintensiven Anwendungen spielt die MySQL-Datenbank eine entscheidende Rolle und ist für die Verwaltung massiver Transaktionen verantwortlich. Mit der Erweiterung der Anwendung werden jedoch die Datenbankleistung Engpässe häufig zu einer Einschränkung. In diesem Artikel werden eine Reihe effektiver Strategien zur Leistungsoptimierung von MySQL -Leistung untersucht, um sicherzustellen, dass Ihre Anwendung unter hohen Lasten effizient und reaktionsschnell bleibt. Wir werden tatsächliche Fälle kombinieren, um eingehende Schlüsseltechnologien wie Indexierung, Abfrageoptimierung, Datenbankdesign und Caching zu erklären. 1. Das Design der Datenbankarchitektur und die optimierte Datenbankarchitektur sind der Eckpfeiler der MySQL -Leistungsoptimierung. Hier sind einige Kernprinzipien: Die Auswahl des richtigen Datentyps und die Auswahl des kleinsten Datentyps, der den Anforderungen entspricht, kann nicht nur Speicherplatz speichern, sondern auch die Datenverarbeitungsgeschwindigkeit verbessern.

Der Hauptschlüssel von MySQL kann null sein

Apr 08, 2025 pm 03:03 PM

Der Hauptschlüssel von MySQL kann null sein

Apr 08, 2025 pm 03:03 PM

Der MySQL -Primärschlüssel kann nicht leer sein, da der Primärschlüssel ein Schlüsselattribut ist, das jede Zeile in der Datenbank eindeutig identifiziert. Wenn der Primärschlüssel leer sein kann, kann der Datensatz nicht eindeutig identifiziert werden, was zu Datenverwirrung führt. Wenn Sie selbstsinkrementelle Ganzzahlsspalten oder UUIDs als Primärschlüssel verwenden, sollten Sie Faktoren wie Effizienz und Raumbelegung berücksichtigen und eine geeignete Lösung auswählen.

Navicat -Methode zum Anzeigen von MongoDB -Datenbankkennwort

Apr 08, 2025 pm 09:39 PM

Navicat -Methode zum Anzeigen von MongoDB -Datenbankkennwort

Apr 08, 2025 pm 09:39 PM

Es ist unmöglich, das MongoDB -Passwort direkt über Navicat anzuzeigen, da es als Hash -Werte gespeichert ist. So rufen Sie verlorene Passwörter ab: 1. Passwörter zurücksetzen; 2. Überprüfen Sie die Konfigurationsdateien (können Hash -Werte enthalten). 3. Überprüfen Sie Codes (May Hardcode -Passwörter).