In den letzten zwei Tagen hatte Turing-Award-Gewinner Yann LeCun einen kleinen Nervenzusammenbruch.

Seit ChatGPT populär wurde, hat Microsoft mit OpenAI seinen Rücken wieder aufgerichtet.

Google, das eine Ohrfeige bekam, sagte nichts über „Reputationsrisiko“.

Alle seine Sprachmodelle, ob LaMDA, DeepMind's Sparrow und Apprentice Bard, können beschleunigt und in die Regale gestellt werden. Dann investierte er fast 400 Millionen US-Dollar in Anthropic, in der Hoffnung, schnell seine eigene OpenAI unterstützen zu können. (Ich möchte auch, was Microsoft hat)

Es gibt jedoch eine Person, die darauf schaut, dass Microsoft und Google die Führung übernehmen, aber nur ängstlich herumspringen kann.

Diese Person ist Metas Chef-KI-Wissenschaftler Yann LeCun.

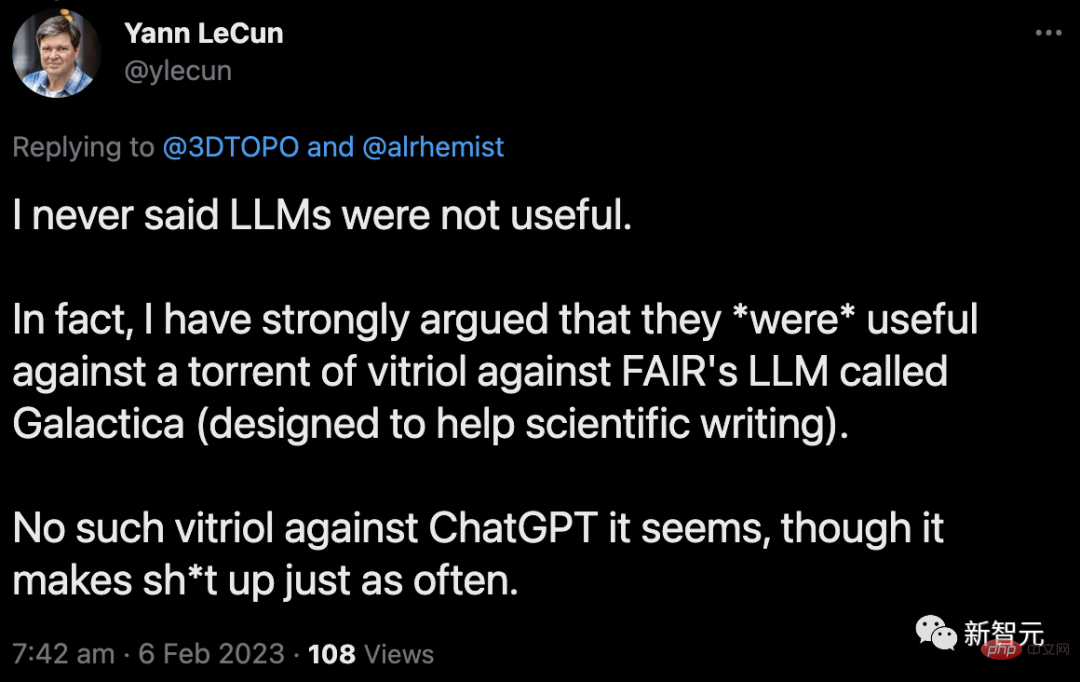

Er war auf Twitter sehr verärgert: „ChatGPT ist voller Unsinn, aber du bist so tolerant, aber meine Galactica ist erst seit drei Tagen draußen und du hast sie offline gescholten.“

Als einer der drei Giganten des Deep Learning und Gewinner des Turing Award ist jede Bewegung von LeCun ein echter Hingucker.

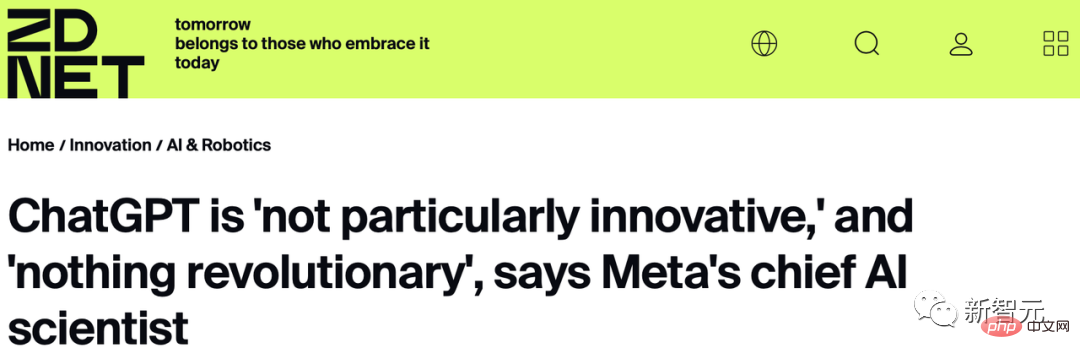

Am 27. Januar gab LeCun bei einem kleinen Treffen von Medien und Führungskräften bei Zoom eine überraschende Bewertung von ChatGPT ab: „Was die zugrunde liegende Technologie betrifft, ist ChatGPT keine große Innovation. Obwohl in der Öffentlichkeit Es ist revolutionär, aber wir wissen, dass es einfach ein gut zusammengestelltes Produkt ist, das ist alles.“ „Neben Google und Meta gibt es im Grunde noch sechs andere Startups, die sehr ähnliche Technologien haben.“ Die von ChatGPT verwendete Architektur wurde von Google vorgeschlagen, und die verwendete Selbstüberwachungsmethode war genau das, was er damals bei OpenAI befürwortete.

Sobald diese Bemerkungen herauskamen, war die Öffentlichkeit in Aufruhr. Sam Altman, CEO von Open AI, scheint LeCun aufgrund dieser Aussage direkt entlassen zu haben.

Danach setzte LeCun seinen verbalen Kampf mit den Fans fort.

Am 28. Januar twitterte LeCun: „Große Sprachmodelle haben keine physische Intuition, sie sind auf Text trainiert. Wenn sie Antworten auf ähnliche Fragen aus ihrem riesigen assoziativen Gedächtnis abrufen können, können sie Fragen zur physischen Intuition beantworten.“ Aber ihre Antworten könnten auch völlig falsch sein.“

Sobald er das sagte, waren die Internetnutzer aufgeregt und stürmten in den Kommentarbereich, um Nachrichten zu hinterlassen.

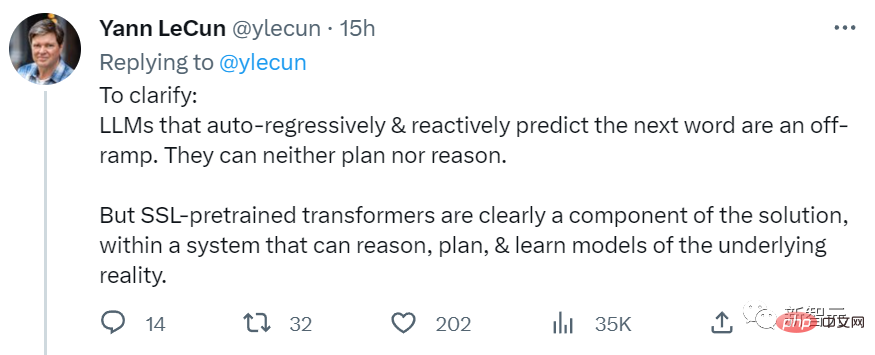

LeCun fügte später hinzu: „LLMs, die auf automatischer Regression und Antwortvorhersage des nächsten Wortes basieren, sind ein falscher Weg, weil sie weder planen noch argumentieren können .“

„Aber der vorab trainierte SSL-Transformer ist die Lösung, weil das reale System, in dem er sich befindet, über die Fähigkeit verfügt, zu denken, zu planen und zu lernen.“

LeCun gab ein interessantes Beispiel: Er ist es Während des Podcasts habe ich die Antwort von ChatGPT gezeigt. Es schien vernünftig, aber es war so falsch. Nachdem der Moderator jedoch die Antwort von ChatGPT gelesen hatte, war ihm nicht sofort klar, dass sie falsch war.

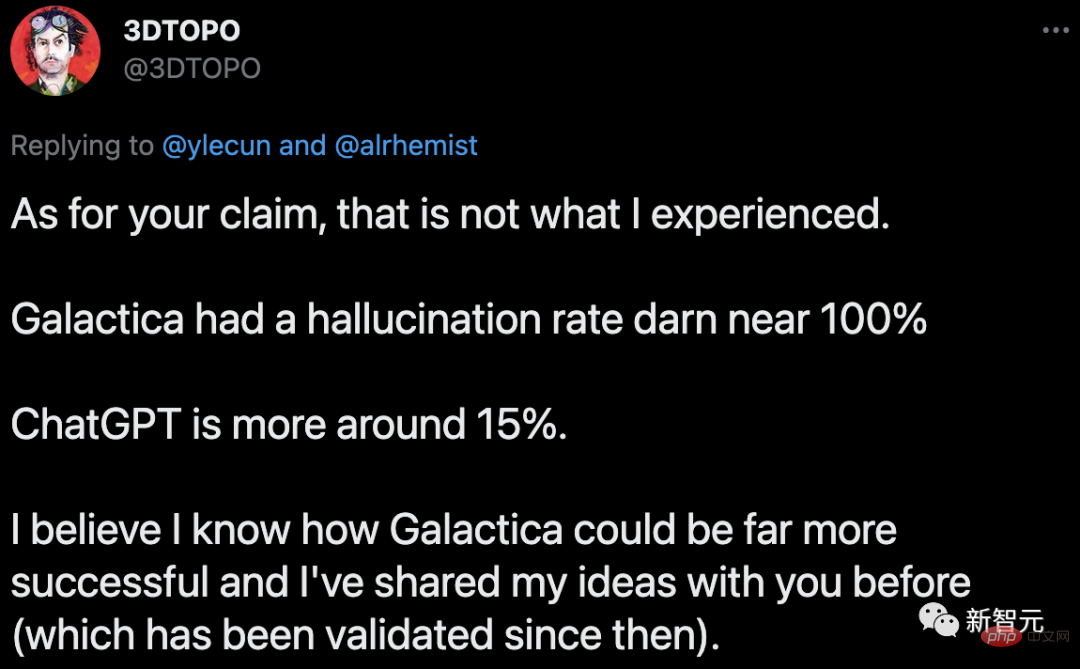

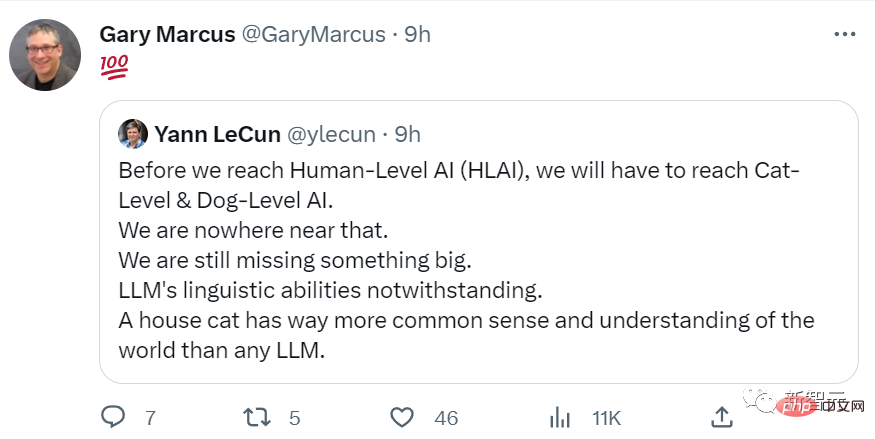

LeCun erklärte: „Unsere Art zu denken und die Welt wahrzunehmen, ermöglicht es uns, vorherzusehen, was passieren wird. Dies ist die Grundlage dafür, dass wir uns gesunden Menschenverstand aneignen, und LLM verfügt nicht über diese Fähigkeit.“ Er twitterte erneut: „Bevor wir eine KI auf menschlicher Ebene entwickeln können, müssen wir eine KI auf Katzen-/Hundeebene entwickeln. Und jetzt können wir nicht einmal das tun. Uns fehlt etwas sehr Wichtiges. Wissen Sie, sogar eine Haustierkatze.“ hat mehr gesunden Menschenverstand und mehr Verständnis für die Welt als jedes große Sprachmodell.“ Im Nachrichtenbereich kritisierten einige Internetnutzer kurzerhand: „Ist Ihr falsch? fast 15 %.“

Als Antwort sagten einige Internetnutzer im Kommentarbereich sarkastisch: „Du bist großartig. Warum gehst du nicht zurück ins Labor und erzählst mir, was du gesagt hast? Dinge sind gemacht.“

LeCun ist verständlicherweise verärgert.

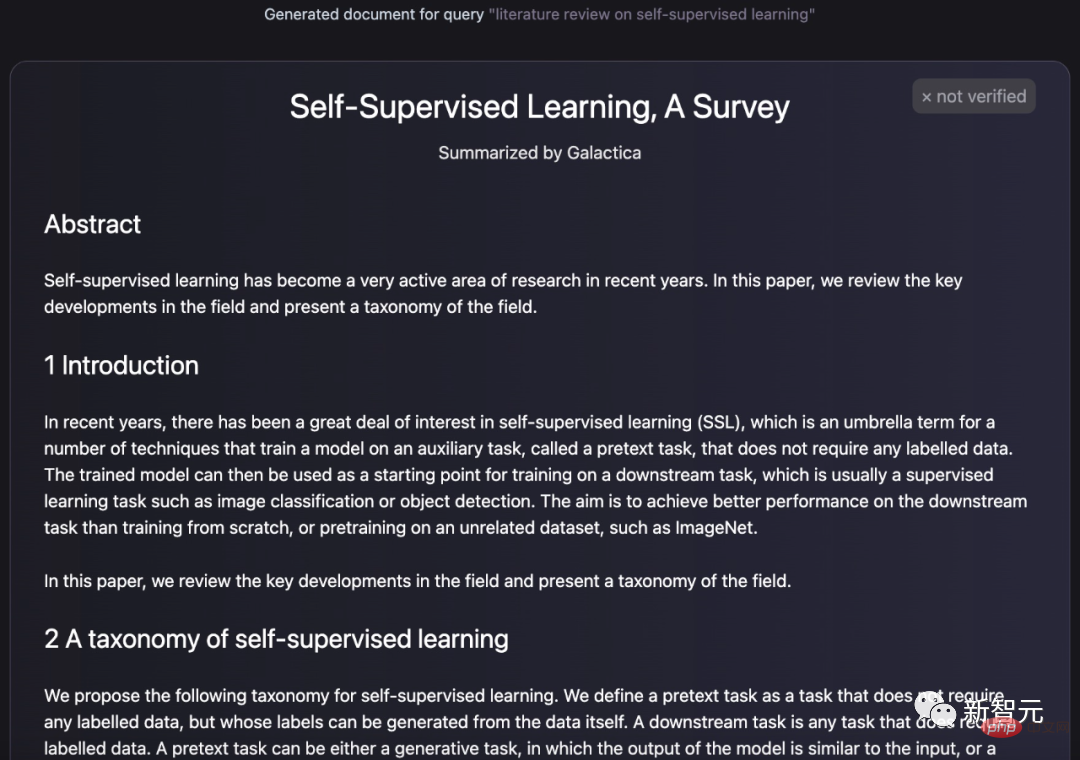

Mitte November letzten Jahres schlug das FAIR-Labor von Meta ein Galactica-Modell vor, das Aufsätze erstellen, Enzyklopädieeinträge erstellen, Fragen beantworten, multimodale Aufgaben chemischer Formeln und Proteinsequenzen erledigen und vieles mehr können kann.

LeCun twitterte und lobte es ebenfalls und sagte, dass es sich um ein Modell handelt, das auf der Grundlage akademischer Literatur trainiert wurde, und es wird eine Struktur generieren . Abschlussarbeit.

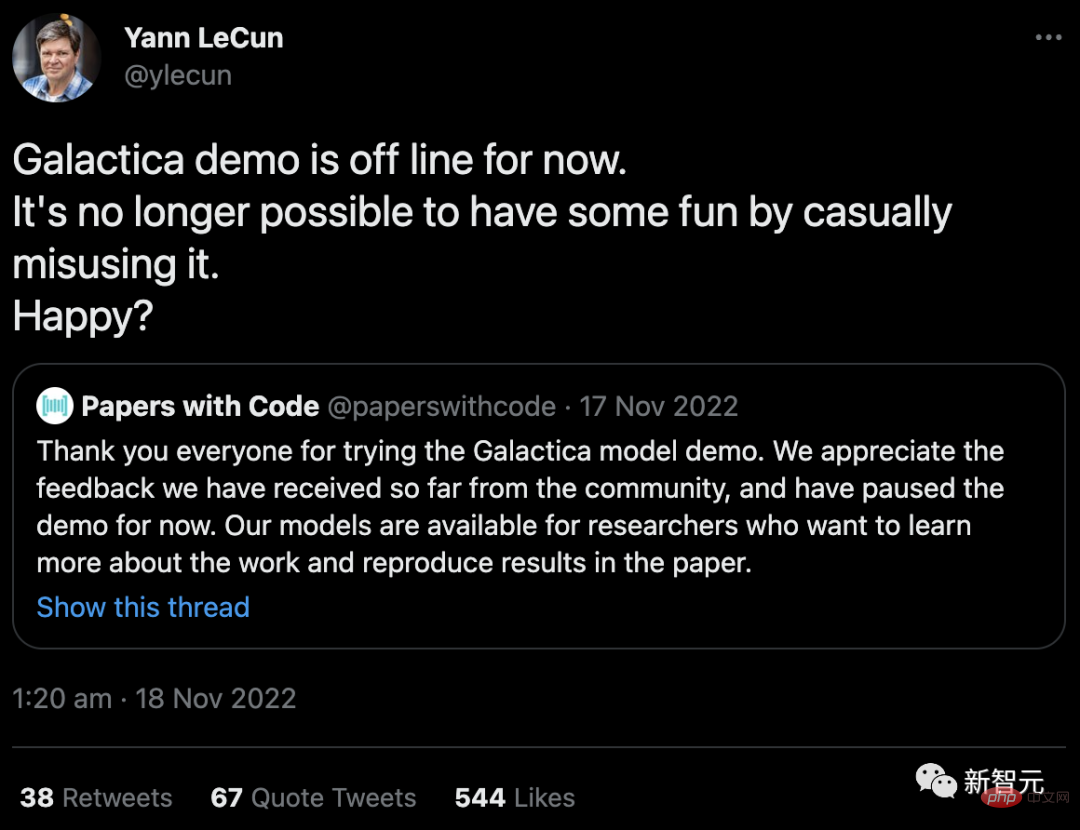

Da Galactica jedoch voller Lügen war, war es nur drei Tage, nachdem es online war, und es wurde von Internetnutzern offline getrollt. LeCun hat Papers with Codes Mitteilung retweetet und sagte wie ein „großer Groll“: „Jetzt, wo wir nicht mehr glücklich mit Galactica spielen können, sind Sie glücklich?“

Obwohl die Demo von Galactica nur online war ein paar Tage, aber die Benutzer hatten damals das Gefühl, einem gewaltigen Feind gegenüberzustehen.

Einige Internetnutzer warnten: Überlegen Sie, wofür Schüler dieses Werkzeug zum „Schreiben auf Papier“ verwenden werden.

Einige Internetnutzer sagten: „Die Antworten des Galactica-Modells sind voller Fehler und Vorurteile, aber sein Ton ist sehr selbstbewusst und maßgeblich. Das ist schrecklich.“

Ma Kus äußerte auch Bedenken, dass solch große Sprachmodelle von Schülern genutzt werden könnten, um Lehrer zu täuschen.

Diese vertraute Formel und der vertraute Geschmack sind wirklich rührend: Waren die durch die Galactica verursachte Panik und der Zweifel nicht genau das, was ChatGPT später erlebte?

Wenn man beobachtet, wie sich dieser Abschnitt der Geschichte wiederholt, aber mit einem völlig anderen Ende, kann man nicht sagen, dass LeCun ohne Grund so bitter ist.

Warum kann dann ChatGPT inmitten des Lärms der Zweifel immer beliebter werden, die Galactica aber nur kläglich beschimpft und offline genommen werden?

Zunächst wurde Galactica von Meta vorgeschlagen, dass große Unternehmen tatsächlich mehr „Reputationsrisiken“ ausgesetzt sind als kleine Startups wie OpenAI.

Darüber hinaus ist die Produktpositionierungsstrategie von OpenAI sehr intelligent. Aus dem Namen ChatGTP geht hervor, dass das Hauptkonzept das Chatten ist.

Man kann damit über Wissen und Papiere chatten, aber da es sich um „Chat“ handelt, kann man es natürlich auch lassen. Wer schreibt vor, dass es beim Chat um „genaue“ und „strenge“ Dinge gehen muss?

Aber Glactica ist anders: „Dies ist ein Modell für wissenschaftliche Forschung.“ Wir greifen auf unser Wissen über das Universum zu und manipulieren es.“

Natürlich stellt mir das eine große Falle.

Obwohl ChatGPT aus technischer Sicht nicht viel Innovation bietet, hat OpenAI aus Sicht des Produktbetriebs sehr gute Arbeit geleistet.

Warum redet LLM Unsinn?

Warum reden große Sprachmodelle also Unsinn?

In einem von LeCun gemochten Artikel erklärte der Autor: „Ich habe versucht, ChatGPT zum Schreiben von Blogbeiträgen zu verwenden, aber alle scheiterten. Der Grund ist einfach: ChatGPT erzeugt oft viele falsche „Fakten“ ".

Wissen Sie, bei LLM geht es darum, in einem Gespräch mit anderen Menschen wie ein Mensch zu klingen, und dieses Ziel erreichen sie sehr gut. Tatsache ist jedoch, dass es zwei völlig unterschiedliche Dinge sind, natürlich zu klingen und die Richtigkeit der Informationen zu beurteilen.

Also, wie kann man dieses Problem lösen?

Zum Beispiel können wir eine Maschine verwenden, die das Verständnis der Physik kodiert hat – die Physik-Engine:

Für das „Fake-Paper-Problem“ können wir auch ähnliche Korrekturen verwenden.

Das heißt, ChatGPT erkennt, dass ihm eine Frage zu einer wissenschaftlichen Arbeit gestellt wurde oder dass es etwas über eine Arbeit schreibt, und zwingt es, eine vertrauenswürdige Datenbank zu konsultieren, bevor es fortfährt.

Aber bitte beachten Sie, dass dies bedeutet, dass Sie dem LLM ein bestimmtes zusätzliches „Denken“ aufgepfropft haben. Und es gibt eine ganze Reihe besonderer Umstände, die berücksichtigt werden müssen. Zu diesem Zeitpunkt wussten die menschlichen Ingenieure, woher die Wahrheit kam, das LLM jedoch nicht.

Darüber hinaus wird immer klarer, dass LLM keine Form künstlicher allgemeiner Intelligenz ist, da Ingenieure immer mehr dieser Korrekturen zusammenfügen.

Was auch immer menschliche Intelligenz ist, wir alle wissen, dass es sich dabei um mehr als nur die Fähigkeit handelt, gut zu sprechen.

Warum reden Menschen miteinander oder schreiben sich gegenseitig Dinge auf?

Einer der Zwecke besteht darin, sachliche Informationen direkt zu vermitteln, wie zum Beispiel „Ich bin im Laden“, „Es ist nicht angeschlossen“ usw., aber das ist bei weitem nicht der einzige Grund, warum wir die Sprache verwenden:

Das heißt, es muss lernen, Bullshit nicht ernst zu nehmen, Überzeugung und Propaganda von objektiver Analyse zu unterscheiden, die Glaubwürdigkeit einer Quelle unabhängig von ihrer Popularität zu beurteilen und so weiter.

Das ist selbst für Menschen ein sehr schwieriger Trick. Studien haben gezeigt, dass sich falsche Informationen auf Twitter um ein Vielfaches schneller verbreiten als genaue Informationen – oft hetzerischer, unterhaltsamer oder scheinbar neuartiger.

Die Frage ist also, warum generative künstliche Intelligenz bei Computercode so gut funktioniert? Warum führt die Genauigkeit beim Schreiben von Funktionscode nicht zu einer Genauigkeit bei der Kommunikation von Fakten?

Eine mögliche Antwort darauf ist, dass Computercode funktional und nicht kommunikativ ist. Das Schreiben eines Codeabschnitts mit korrekter Grammatik führt automatisch einige Aufgaben aus, während das Schreiben eines Satzes mit korrekter Grammatik nicht unbedingt etwas bewirkt.

Darüber hinaus ist es einfach, den Trainingskorpus von Computercode auf „guten“ Code zu beschränken, also Code, der seinen beabsichtigten Zweck perfekt erfüllt. Im Gegensatz dazu ist es nahezu unmöglich, einen Textkorpus zu erstellen, der seinen Zweck erfolgreich erfüllt.

Um sich also zu einem vertrauenswürdigen Verbreiter von Fakten auszubilden, muss LLLM eine Aufgabe erfüllen, die viel schwieriger ist, als sich selbst darin zu trainieren, funktionierenden Computercode zu entwickeln.

Um sich also zu einem vertrauenswürdigen Verbreiter von Fakten auszubilden, muss LLLM eine Aufgabe erfüllen, die viel schwieriger ist, als sich selbst darin zu trainieren, funktionierenden Computercode zu entwickeln.

Obwohl ich nicht weiß, wie schwierig es für Ingenieure ist, ein LLM zu bauen, das Fakten von Unsinn unterscheiden kann, ist es selbst für Menschen eine schwierige Aufgabe.

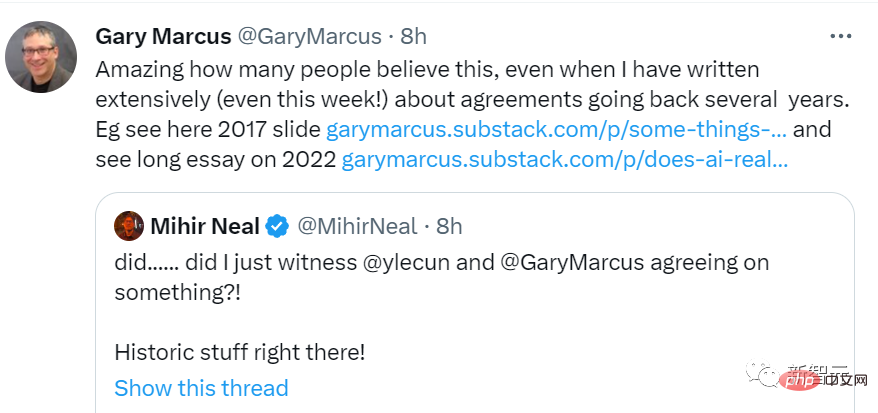

Marcus: Die Versöhnung des Jahrhunderts LeCuns Reihe von Bemerkungen ließ alle fragen: Ist das nicht das, was Marcus sagen würde?

Heiße (chi) leidenschaftliche (gua) Internetnutzer haben @Marcus und freuen sich auf seine scharfen Kommentare zu diesem Thema.

Marcus, der schon lange an GPT leidet, war natürlich überglücklich und leitete LeCuns Beitrag sofort weiter und kommentierte „100 Ohnmachtsanfälle“.

Marcus hat auch auf seinem Blog gepostet und seine „Hassliebe“ mit LeCun besprochen.

Marcus sagte, dass er und LeCun seit vielen Jahren alte Freunde seien, sich aber wegen einiger Worte, die sie über die Galactica sagten, gegeneinander wandten.

Tatsächlich liegen Marcus und LeCun seit mehreren Jahren im Krieg miteinander, und das nicht nur, weil die Galactica offline gegangen ist.

Anders als die relativ geringe Bekanntheit der anderen beiden Turing-Award-Gewinner Bengio und Hinton in den letzten Jahren ist LeCun in der KI-Szene auch dafür bekannt, in den sozialen Medien aktiv zu sein. Viele Jobs wurden auf Twitter beworben, sobald sie bei Arxiv scheiterten.

Marcus, der ebenfalls bekannt ist, hat Twitter immer als sein Heimatgericht betrachtet. Wenn LeCuns Publicity im Widerspruch zu Marcus‘ Ansichten steht, hat keine der Parteien vor, sich zurückzuhalten.

In den sozialen Medien kann man sagen, dass die beiden den Punkt erreicht haben, an dem sie sich streiten, wenn sie sich streiten. Sie reden so unhöflich miteinander, dass sie vielleicht sogar anfangen, sich zu streiten, wenn sie sich treffen .

Apropos Liang Zi: Nachdem LeCun 2019 mit Hinton und Bengio den Turing Award gewonnen hatte, gab es ein Gruppenfoto, auf dem Marcus ursprünglich neben LeCun stand, aber auf dem von LeCun geteilten Foto wurde Marcus rücksichtslos beschnitten aus.

Die Geburt von ChatGPT hat jedoch alles verändert.

ChatGPT ging viral und Galactica wurde drei Tage später vom Markt genommen. Marcus war natürlich froh, LeCuns verrückte Leistung gegen LLM zu sehen.

Wie das Sprichwort sagt: Der Feind meines Feindes ist mein Freund. Egal, ob LeCuns Bemerkungen eine Offenbarung nach dem Scheitern seines eigenen Produkts sind oder ob er eifersüchtig auf die aktuelle Situation erstklassiger Konkurrenzprodukte ist, Marcus ist bereit um Öl ins Feuer zu gießen.

Marcus glaubt, dass er und LeCun sich über mehr als nur den Hype und die Grenzen von LLM einig sind. Sie sind beide der Meinung, dass Cicero mehr Aufmerksamkeit verdient.

Schließlich war Marcus @ die Person, die alles versteht und sagte: „Es ist Zeit, der Familie Vorteile zu bieten.“

Man kann sagen, dass der von LeCun auf Twitter begonnene Schimpfkrieg nicht nur Marcus‘ Anti-GPT-Armee um ein starkes Mitglied erweitert hat, sondern den beiden auch die Gelegenheit gegeben hat, sich die Hand zu schütteln und Frieden zu schließen.

So gesehen ist Marcus vielleicht der ultimative Gewinner.

Das obige ist der detaillierte Inhalt vonChatGPT ging viral, LeCuns Mentalität brach zusammen! Da große Sprachmodelle ein böser Weg seien, wurde das Meta-Modell innerhalb von drei Tagen offline geschaltet. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Der Unterschied zwischen Gateway und Router

Der Unterschied zwischen Gateway und Router

So stellen Sie aus dem Papierkorb geleerte Dateien wieder her

So stellen Sie aus dem Papierkorb geleerte Dateien wieder her

So beheben Sie, dass libcurl.dll auf Ihrem Computer fehlt

So beheben Sie, dass libcurl.dll auf Ihrem Computer fehlt

Exif-Informationen löschen

Exif-Informationen löschen

WLAN zeigt keinen Zugang zum Internet an

WLAN zeigt keinen Zugang zum Internet an

Mein Computer kann es nicht durch Doppelklick öffnen.

Mein Computer kann es nicht durch Doppelklick öffnen.

So stellen Sie Freunde wieder her, nachdem Sie auf TikTok blockiert wurden

So stellen Sie Freunde wieder her, nachdem Sie auf TikTok blockiert wurden

Einführung in den Javascript-Spezialeffektcode

Einführung in den Javascript-Spezialeffektcode