Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Eine weitere Revolution im Reinforcement Learning! DeepMind schlägt eine „Algorithmus-Destillation' vor: einen erforschbaren, vorab trainierten Reinforcement-Learning-Transformer

Eine weitere Revolution im Reinforcement Learning! DeepMind schlägt eine „Algorithmus-Destillation' vor: einen erforschbaren, vorab trainierten Reinforcement-Learning-Transformer

Eine weitere Revolution im Reinforcement Learning! DeepMind schlägt eine „Algorithmus-Destillation' vor: einen erforschbaren, vorab trainierten Reinforcement-Learning-Transformer

In aktuellen Sequenzmodellierungsaufgaben kann Transformer als die leistungsstärkste neuronale Netzwerkarchitektur bezeichnet werden, und das vorab trainierte Transformer-Modell kann Eingabeaufforderungen als Bedingungen oder kontextbezogenes Lernen verwenden, um sich an verschiedene nachgelagerte Aufgaben anzupassen.

Die Generalisierungsfähigkeit des vorab trainierten Transformer-Modells in großem Maßstab wurde in mehreren Bereichen überprüft, z. B. Textvervollständigung, Sprachverständnis, Bilderzeugung usw.

Seit letztem Jahr gibt es relevante Arbeiten, die belegen, dass das Modell durch die Behandlung von Offline-Reinforcement-Learning (Offline-RL) als Sequenzvorhersageproblem „Richtlinien aus Offline-Daten lernen“ kann.

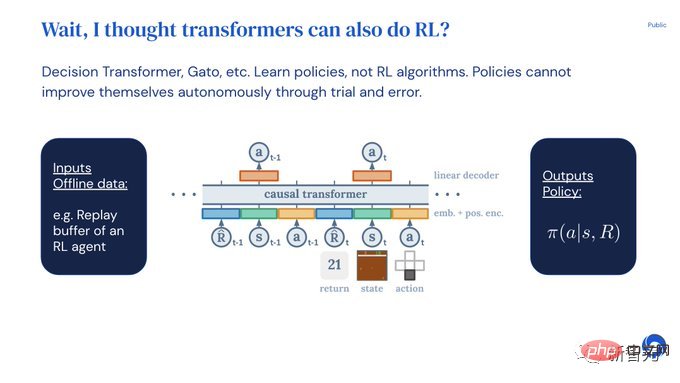

Aber aktuelle Methoden lernen die Richtlinie entweder aus Daten, die kein Lernen enthalten (z. B. eine durch Destillation festgelegte Expertenrichtlinie), oder lernen aus Daten, die Lernen enthalten (z. B. dem Wiedergabepuffer des Agenten), aber weil ihr Kontext vorhanden ist zu klein, es kann politische Verbesserungen nicht erfassen.

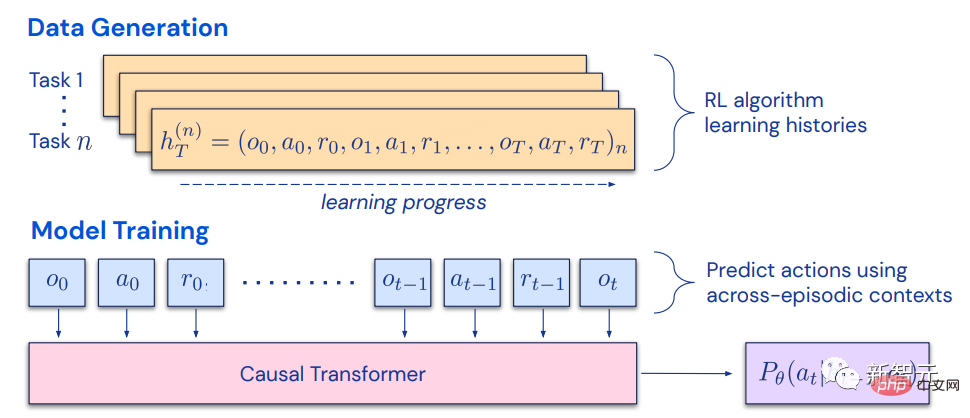

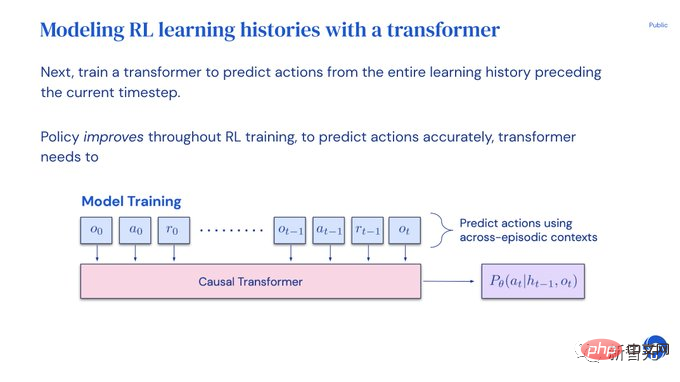

die sequentielle Natur des Lernens beim Training von Reinforcement-Learning-Algorithmen den Reinforcement-Learning-Prozess selbst als „Problem der kausalen Sequenzvorhersage“ modellieren kann .

Insbesondere wenn der Kontext eines Transformers lang genug ist, um Richtlinienverbesserungen aufgrund von Lernaktualisierungen einzuschließen, sollte er nicht nur in der Lage sein, eine feste Richtlinie darzustellen, sondern auch in der Lage sein, den Status, die Aktionen und Belohnungen der vorherigen darzustellen Episoden, indem man sich darauf konzentriert, als Betreiber zur Politikverbesserung dargestellt.Dies bietet auch die technische Machbarkeit, dass jeder RL-Algorithmus durch Nachahmungslernen in ein ausreichend leistungsfähiges Sequenzmodell destilliert und in einen kontextbezogenen RL-Algorithmus umgewandelt werden kann.

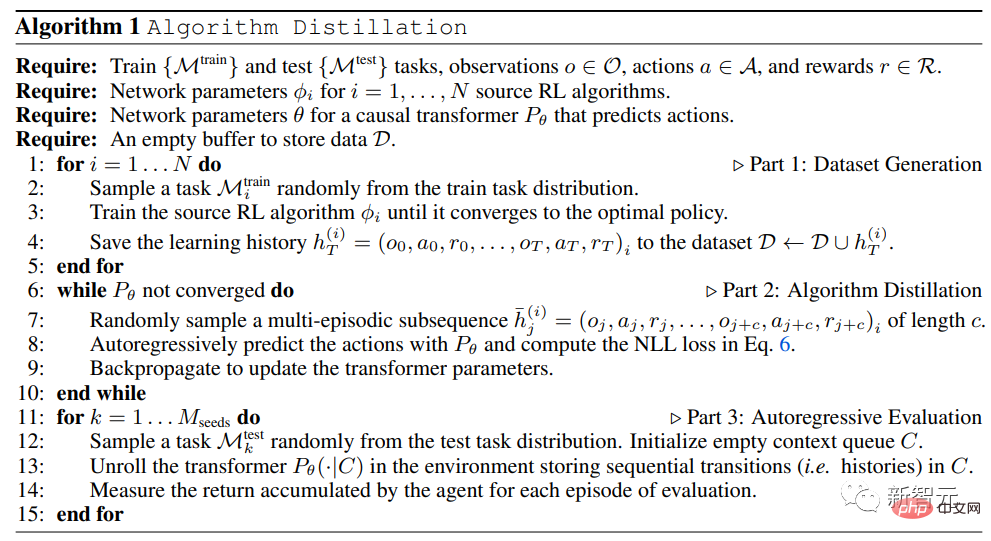

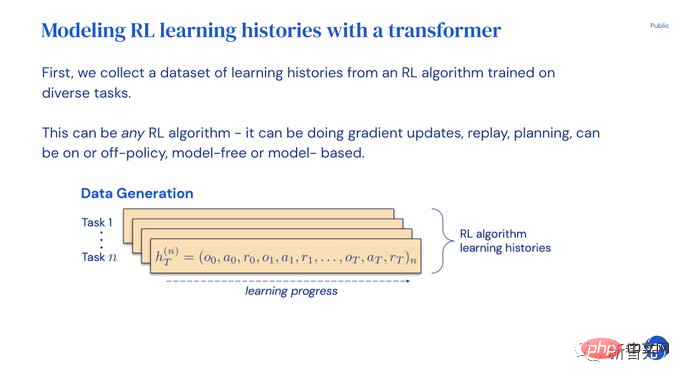

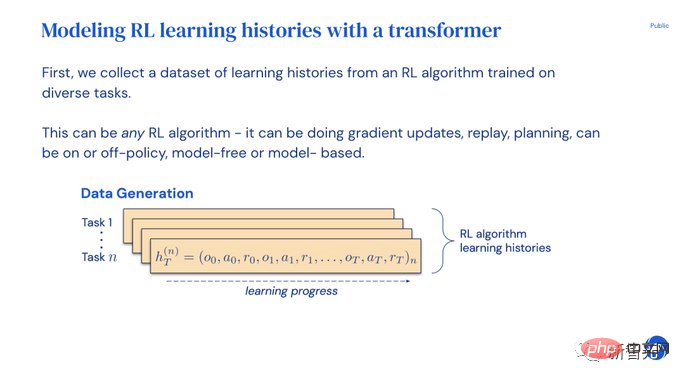

Auf dieser Grundlage schlug DeepMind die Algorithmusdestillation (AD) vor, die durch die Erstellung eines Kausalsequenzmodells Verstärkungslernalgorithmen in neuronale Netze extrahiert.

... generiert einen Lernverlaufsdatensatz und trainiert dann den Kausaltransformer, indem er das Verhalten durch Autoregression basierend auf dem Lernverlauf als Kontext vorhersagt.

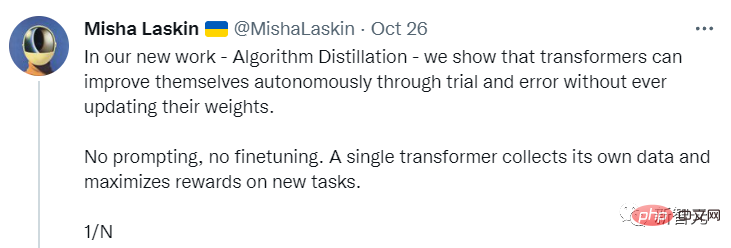

Transfomer sammelt seine eigenen Daten und maximiert die Belohnungen für neue Aufgaben.

Keine Eingabeaufforderung oder Feinabstimmung erforderlich.

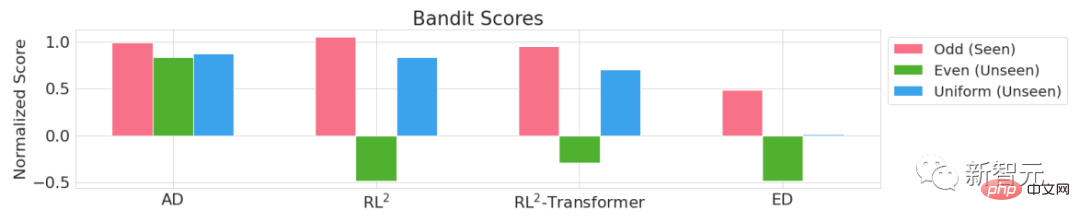

Mit eingefrorenen Gewichten erkundet, nutzt und maximiert Transformer den Kontext. Experten-Destillationsmethoden wie Gato können nicht erforschen und die Erträge nicht maximieren.

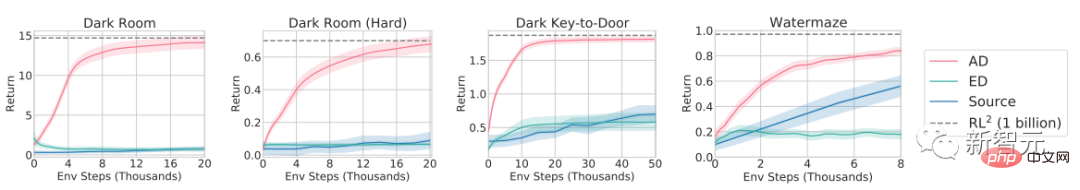

- Experimentelle Ergebnisse belegen, dass AD verstärkendes Lernen in verschiedenen Umgebungen mit spärlichen Belohnungen, kombinierten Aufgabenstrukturen und pixelbasierten Beobachtungen durchführen kann und dass AD-Lernen dateneffizienter ist als der RL-Algorithmus, der Quelldaten generiert .

- AD ist auch das erste

- , das kontextbestärkende Lernmethoden durch Sequenzmodellierung von Offline-Daten mit Imitationsverlust demonstriert. Algorithmusdestillation

Im Jahr 2021 entdeckten einige Forscher erstmals, dass Transformer durch Nachahmungslernen Einzelaufgabenrichtlinien aus Offline-RL-Daten lernen kann, und wurde anschließend erweitert, um Multiaufgabenrichtlinien sowohl in derselben Domäne als auch domänenübergreifend zu extrahieren Einstellungen.

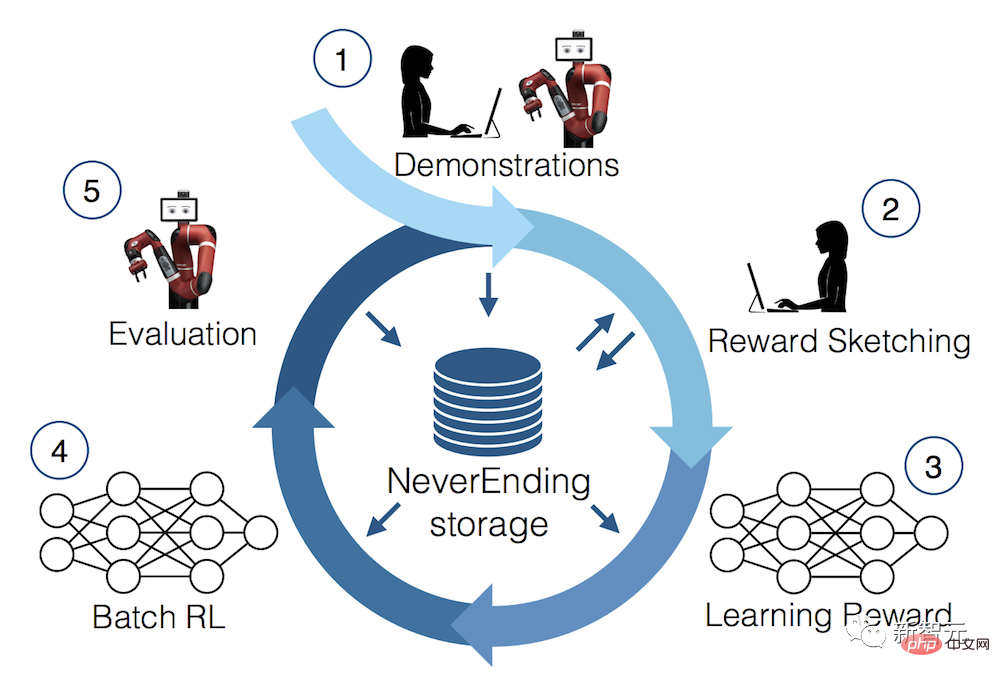

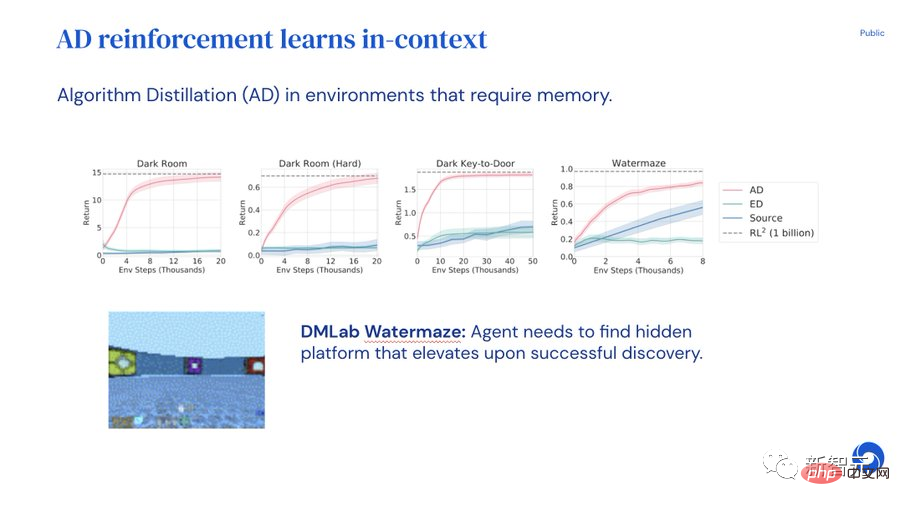

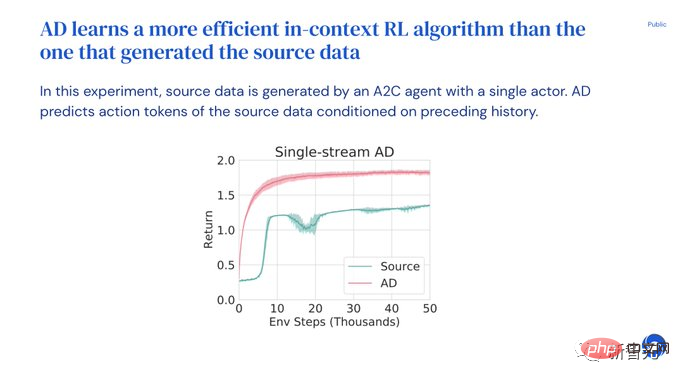

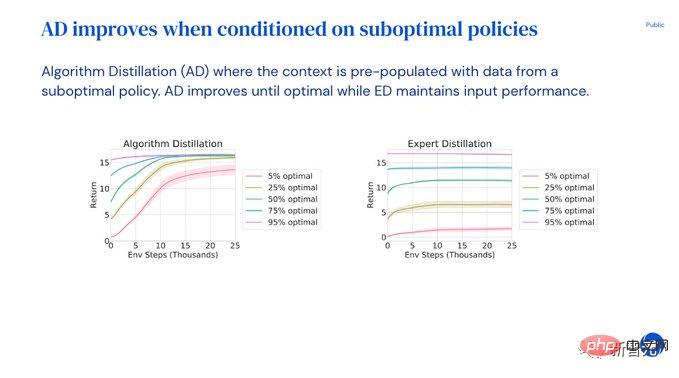

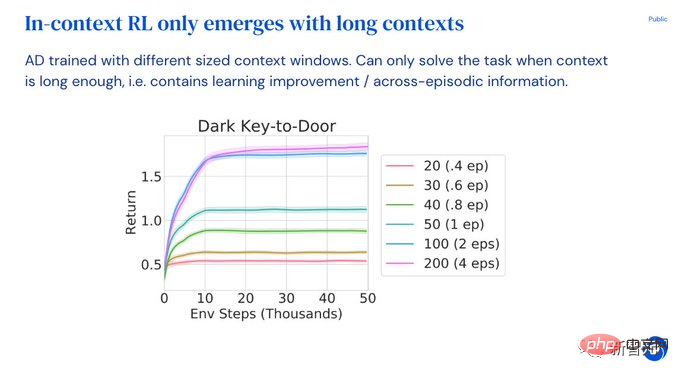

Diese Arbeiten schlagen ein vielversprechendes Paradigma für die Extraktion allgemeiner Multitasking-Richtlinien vor: Sammeln Sie zunächst einen großen und vielfältigen Datensatz von Umweltinteraktionen und extrahieren Sie dann durch Sequenzmodellierung eine Richtlinie aus den Daten. Die Methode zum Erlernen von Richtlinien aus Offline-RL-Daten durch Nachahmungslernen wird auch Offline-Richtliniendestillation oder einfach Richtliniendestillation (PD) genannt. Obwohl die Idee von PD sehr einfach und leicht zu erweitern ist, weist PD einen großen Fehler auf: Die generierte Strategie verbessert sich nicht durch zusätzliche Interaktionen mit der Umgebung. Zum Beispiel hat MultiGame Decision Transformer (MGDT) eine Return-Conditional-Richtlinie gelernt, mit der eine große Anzahl von Atari-Spielen gespielt werden kann, während Gato eine Richtlinie zum Lösen von Aufgaben in verschiedenen Umgebungen durch Kontextinferenzaufgaben gelernt hat, aber beide Methoden nicht verbessert seine Strategie durch Versuch und Irrtum. MGDT passt den Transformator durch Feinabstimmung der Gewichte des Modells an neue Aufgaben an, während Gato fachmännische Demonstrationstipps benötigt, um sich an neue Aufgaben anzupassen. Kurz gesagt, die Policy-Destillation-Methode lernt Richtlinien statt verstärkender Lernalgorithmen. Der Grund, warum Forscher die Hypothese aufstellten, dass Policy Distillation nicht durch Versuch und Irrtum verbessert werden kann, liegt darin, dass es auf Daten trainiert wird, die keinen Lernfortschritt zeigen. Algorithmische Destillation (AD) ist eine Methode zum Erlernen intrinsischer Richtlinienverbesserungsoperatoren durch Optimierung des kausalen Sequenzvorhersageverlusts in der Lernhistorie eines RL-Algorithmus. AD umfasst zwei Komponenten: 1. Generieren Sie einen großen Multitask-Datensatz, indem Sie den Trainingsverlauf eines RL-Algorithmus für viele einzelne Aufgaben speichern; 2, den Transformer nutzt die bisherige Lerngeschichte als Hintergrund, um Handlungen kausal zu modellieren. Da sich die Richtlinie während des gesamten Trainingsprozesses des Quell-RL-Algorithmus ständig verbessert, muss AD lernen, wie der Operator verbessert werden kann, um die Aktionen an jedem beliebigen Punkt im Trainingsverlauf genau zu simulieren. Am wichtigsten ist, dass die Kontextgröße des Transformers groß genug sein muss (d. h. über Epochen hinweg), um Verbesserungen in den Trainingsdaten zu erfassen. Um die Vorteile von AD bei kontextbezogenen RL-Fähigkeiten zu erkunden, konzentrierten sich die Forscher im experimentellen Teil auf Umgebungen, die nach dem Vortraining nicht durch Zero-Shot-Generalisierung gelöst werden können, d Umgebung ist erforderlich. Es werden verschiedene Aufgaben unterstützt, und die Lösung der Aufgabe kann vom Modell nicht einfach aus Beobachtungen abgeleitet werden. Gleichzeitig müssen Episoden kurz genug sein, damit kausale Transformer über Episoden hinweg trainiert werden können. Wie aus den experimentellen Ergebnissen der vier Umgebungen Adversarial Bandit, Dark Room, Dark Key-to-Door und DMLab Watermaze hervorgeht, wird durch die Nachahmung des Gradienten-basierten RL-Algorithmus ein kausaler Transformer mit einem großen Wenn genügend Kontext vorhanden ist, kann AD das Erlernen neuer Aufgaben im Kontext vollständig verstärken. AD ist in der Lage, kontextbezogene Exploration, zeitliche Credit-Zuweisung und Generalisierung durchzuführen. Der von AD erlernte Algorithmus ist dateneffizienter als der Algorithmus, der die Quelldaten für das Transformer-Training generiert. Um das Verständnis des Papiers zu erleichtern, veröffentlichte Michael Laskin, einer der Autoren des Papiers, eine PPT-Erklärung auf Twitter. Experimente zur Algorithmusdestillation zeigen, dass Transformer das Modell durch Versuch und Irrtum autonom verbessern kann, ohne Gewichtungen, Eingabeaufforderungen oder Feinabstimmungen zu aktualisieren. Ein einzelner Transformer kann seine eigenen Daten sammeln und die Belohnungen für neue Aufgaben maximieren. Obwohl es viele erfolgreiche Modelle gibt, die zeigen, wie Transformer im Kontext lernt, konnte noch nicht nachgewiesen werden, dass Transformer das Lernen im Kontext stärkt. Um sich an neue Aufgaben anzupassen, müssen Entwickler entweder manuell eine Eingabeaufforderung festlegen oder das Modell anpassen. Wäre es nicht schön, wenn Transformer sich an Reinforcement Learning anpassen und sofort einsetzbar wäre? Aber Decision Transformers oder Gato können Strategien nur aus Offline-Daten lernen und sich nicht automatisch durch wiederholte Experimente verbessern. Der mit der Pre-Training-Methode der Algorithmic Distillation (AD) generierte Transformer kann bestärkendes Lernen im Kontext durchführen. Trainieren Sie zunächst mehrere Kopien eines Reinforcement-Learning-Algorithmus, um verschiedene Aufgaben zu lösen und den Lernverlauf zu speichern. Sobald der Lernverlaufsdatensatz erfasst ist, kann ein Transformer trainiert werden, um die Aktionen des vorherigen Lernverlaufs vorherzusagen. Da sich Richtlinien in der Vergangenheit verbessert haben, wird die genaue Vorhersage von Aktionen den Transformer dazu zwingen, Richtlinienverbesserungen zu modellieren. Der gesamte Prozess ist so einfach, dass er nur durch Nachahmung von Aktionen trainiert wird. Es gibt keinen Q-Wert wie bei herkömmlichen Verstärkungslernmodellen und keine Rückgaben wie bei DTs. Im Kontext verursacht Reinforcement Learning keinen zusätzlichen Overhead, und das Modell wird dann bewertet, indem beobachtet wird, ob AD die Belohnung für die neue Aufgabe maximieren kann. Transformer erforscht, nutzt und maximiert Erträge, wenn im Kontext seine Gewichte eingefroren sind! Andererseits kann Expert Distillation (das Gato am ähnlichsten ist) weder Renditen erforschen noch maximieren. AD kann jeden RL-Algorithmus extrahieren. Die Forscher haben UCB und DQNA2C ausprobiert. Ein interessantes Ergebnis ist, dass AD beim kontextuellen RL-Algorithmuslernen effizienter ist. Benutzer können auch schnelle und suboptimale Demos eingeben, und das Modell verbessert die Strategie automatisch, bis die optimale Lösung erreicht ist! Und von Experten destilliertes ED kann nur eine suboptimale Demoleistung aufrechterhalten. Context RL wird nur angezeigt, wenn der Kontext des Transformers lang genug ist und mehrere Episoden umfasst. AD erfordert eine ausreichend lange Historie für effektive Modellverbesserungs- und Identifizierungsaufgaben. Durch Experimente kamen Forscher zu folgenden Schlussfolgerungen:

PPT-Erklärung

Das obige ist der detaillierte Inhalt vonEine weitere Revolution im Reinforcement Learning! DeepMind schlägt eine „Algorithmus-Destillation' vor: einen erforschbaren, vorab trainierten Reinforcement-Learning-Transformer. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1377

1377

52

52

Open Source! Jenseits von ZoeDepth! DepthFM: Schnelle und genaue monokulare Tiefenschätzung!

Apr 03, 2024 pm 12:04 PM

Open Source! Jenseits von ZoeDepth! DepthFM: Schnelle und genaue monokulare Tiefenschätzung!

Apr 03, 2024 pm 12:04 PM

0.Was bewirkt dieser Artikel? Wir schlagen DepthFM vor: ein vielseitiges und schnelles generatives monokulares Tiefenschätzungsmodell auf dem neuesten Stand der Technik. Zusätzlich zu herkömmlichen Tiefenschätzungsaufgaben demonstriert DepthFM auch hochmoderne Fähigkeiten bei nachgelagerten Aufgaben wie dem Tiefen-Inpainting. DepthFM ist effizient und kann Tiefenkarten innerhalb weniger Inferenzschritte synthetisieren. Lassen Sie uns diese Arbeit gemeinsam lesen ~ 1. Titel der Papierinformationen: DepthFM: FastMonocularDepthEstimationwithFlowMatching Autor: MingGui, JohannesS.Fischer, UlrichPrestel, PingchuanMa, Dmytr

Verzichten Sie auf die Encoder-Decoder-Architektur und verwenden Sie das Diffusionsmodell zur Kantenerkennung, das effektiver ist. Die National University of Defense Technology hat DiffusionEdge vorgeschlagen

Feb 07, 2024 pm 10:12 PM

Verzichten Sie auf die Encoder-Decoder-Architektur und verwenden Sie das Diffusionsmodell zur Kantenerkennung, das effektiver ist. Die National University of Defense Technology hat DiffusionEdge vorgeschlagen

Feb 07, 2024 pm 10:12 PM

Aktuelle Deep-Edge-Erkennungsnetzwerke verwenden normalerweise eine Encoder-Decoder-Architektur, die Up- und Down-Sampling-Module enthält, um mehrstufige Merkmale besser zu extrahieren. Diese Struktur schränkt jedoch die Ausgabe genauer und detaillierter Kantenerkennungsergebnisse des Netzwerks ein. Als Antwort auf dieses Problem bietet ein Papier zu AAAI2024 eine neue Lösung. Titel der Abschlussarbeit: DiffusionEdge:DiffusionProbabilisticModelforCrispEdgeDetection Autoren: Ye Yunfan (Nationale Universität für Verteidigungstechnologie), Xu Kai (Nationale Universität für Verteidigungstechnologie), Huang Yuxing (Nationale Universität für Verteidigungstechnologie), Yi Renjiao (Nationale Universität für Verteidigungstechnologie), Cai Zhiping (National University of Defense Technology) Link zum Papier: https://ar

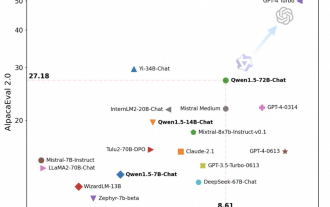

Tongyi Qianwen ist wieder Open Source, Qwen1.5 bietet sechs Volumenmodelle und seine Leistung übertrifft GPT3.5

Feb 07, 2024 pm 10:15 PM

Tongyi Qianwen ist wieder Open Source, Qwen1.5 bietet sechs Volumenmodelle und seine Leistung übertrifft GPT3.5

Feb 07, 2024 pm 10:15 PM

Pünktlich zum Frühlingsfest ist Version 1.5 des Tongyi Qianwen Large Model (Qwen) online. Heute Morgen erregten die Neuigkeiten über die neue Version die Aufmerksamkeit der KI-Community. Die neue Version des großen Modells umfasst sechs Modellgrößen: 0,5B, 1,8B, 4B, 7B, 14B und 72B. Unter ihnen übertrifft die Leistung der stärksten Version GPT3.5 und Mistral-Medium. Diese Version umfasst das Basismodell und das Chat-Modell und bietet Unterstützung für mehrere Sprachen. Das Tongyi Qianwen-Team von Alibaba gab an, dass die entsprechende Technologie auch auf der offiziellen Website von Tongyi Qianwen und der Tongyi Qianwen App eingeführt wurde. Darüber hinaus bietet die heutige Version von Qwen 1.5 auch die folgenden Highlights: Unterstützt eine Kontextlänge von 32 KB und öffnet den Prüfpunkt des Base+Chat-Modells.

Große Modelle können ebenfalls in Scheiben geschnitten werden, und Microsoft SliceGPT erhöht die Recheneffizienz von LLAMA-2 erheblich

Jan 31, 2024 am 11:39 AM

Große Modelle können ebenfalls in Scheiben geschnitten werden, und Microsoft SliceGPT erhöht die Recheneffizienz von LLAMA-2 erheblich

Jan 31, 2024 am 11:39 AM

Große Sprachmodelle (LLMs) verfügen typischerweise über Milliarden von Parametern und werden auf Billionen von Token trainiert. Die Schulung und Bereitstellung solcher Modelle ist jedoch sehr teuer. Um den Rechenaufwand zu reduzieren, werden häufig verschiedene Modellkomprimierungstechniken eingesetzt. Diese Modellkomprimierungstechniken können im Allgemeinen in vier Kategorien unterteilt werden: Destillation, Tensorzerlegung (einschließlich Faktorisierung mit niedrigem Rang), Bereinigung und Quantisierung. Pruning-Methoden gibt es schon seit einiger Zeit, aber viele erfordern nach dem Pruning eine Feinabstimmung der Wiederherstellung (Recovery Fine-Tuning, RFT), um die Leistung aufrechtzuerhalten, was den gesamten Prozess kostspielig und schwierig zu skalieren macht. Forscher der ETH Zürich und von Microsoft haben eine Lösung für dieses Problem namens SliceGPT vorgeschlagen. Die Kernidee dieser Methode besteht darin, die Einbettung des Netzwerks durch das Löschen von Zeilen und Spalten in der Gewichtsmatrix zu reduzieren.

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas tritt offiziell in die Ära der Elektroroboter ein! Gestern hat sich der hydraulische Atlas einfach „unter Tränen“ von der Bühne der Geschichte zurückgezogen. Heute gab Boston Dynamics bekannt, dass der elektrische Atlas im Einsatz ist. Es scheint, dass Boston Dynamics im Bereich kommerzieller humanoider Roboter entschlossen ist, mit Tesla zu konkurrieren. Nach der Veröffentlichung des neuen Videos wurde es innerhalb von nur zehn Stunden bereits von mehr als einer Million Menschen angesehen. Die alten Leute gehen und neue Rollen entstehen. Das ist eine historische Notwendigkeit. Es besteht kein Zweifel, dass dieses Jahr das explosive Jahr der humanoiden Roboter ist. Netizens kommentierten: Die Weiterentwicklung der Roboter hat dazu geführt, dass die diesjährige Eröffnungsfeier wie Menschen aussieht, und der Freiheitsgrad ist weitaus größer als der von Menschen. Aber ist das wirklich kein Horrorfilm? Zu Beginn des Videos liegt Atlas ruhig auf dem Boden, scheinbar auf dem Rücken. Was folgt, ist atemberaubend

Die Kuaishou-Version von Sora „Ke Ling' steht zum Testen offen: Sie generiert über 120 Sekunden Videos, versteht die Physik besser und kann komplexe Bewegungen genau modellieren

Jun 11, 2024 am 09:51 AM

Die Kuaishou-Version von Sora „Ke Ling' steht zum Testen offen: Sie generiert über 120 Sekunden Videos, versteht die Physik besser und kann komplexe Bewegungen genau modellieren

Jun 11, 2024 am 09:51 AM

Was? Wird Zootopia durch heimische KI in die Realität umgesetzt? Zusammen mit dem Video wird ein neues groß angelegtes inländisches Videogenerationsmodell namens „Keling“ vorgestellt. Sora geht einen ähnlichen technischen Weg und kombiniert eine Reihe selbst entwickelter technologischer Innovationen, um Videos zu produzieren, die nicht nur große und vernünftige Bewegungen aufweisen, sondern auch die Eigenschaften der physischen Welt simulieren und über starke konzeptionelle Kombinationsfähigkeiten und Vorstellungskraft verfügen. Den Daten zufolge unterstützt Keling die Erstellung ultralanger Videos von bis zu 2 Minuten mit 30 Bildern pro Sekunde, mit Auflösungen von bis zu 1080p und unterstützt mehrere Seitenverhältnisse. Ein weiterer wichtiger Punkt ist, dass es sich bei Keling nicht um eine vom Labor veröffentlichte Demo oder Video-Ergebnisdemonstration handelt, sondern um eine Anwendung auf Produktebene, die von Kuaishou, einem führenden Anbieter im Bereich Kurzvideos, gestartet wurde. Darüber hinaus liegt das Hauptaugenmerk darauf, pragmatisch zu sein, keine Blankoschecks auszustellen und sofort nach der Veröffentlichung online zu gehen. Das große Modell von Ke Ling wurde bereits in Kuaiying veröffentlicht.

Die Vitalität der Superintelligenz erwacht! Aber mit der Einführung der sich selbst aktualisierenden KI müssen sich Mütter keine Sorgen mehr über Datenengpässe machen

Apr 29, 2024 pm 06:55 PM

Die Vitalität der Superintelligenz erwacht! Aber mit der Einführung der sich selbst aktualisierenden KI müssen sich Mütter keine Sorgen mehr über Datenengpässe machen

Apr 29, 2024 pm 06:55 PM

Ich weine zu Tode. Die Daten im Internet reichen überhaupt nicht aus. Das Trainingsmodell sieht aus wie „Die Tribute von Panem“, und KI-Forscher auf der ganzen Welt machen sich Gedanken darüber, wie sie diese datenhungrigen Esser ernähren sollen. Dieses Problem tritt insbesondere bei multimodalen Aufgaben auf. Zu einer Zeit, als sie ratlos waren, nutzte ein Start-up-Team der Abteilung der Renmin-Universität von China sein eigenes neues Modell, um als erstes in China einen „modellgenerierten Datenfeed selbst“ in die Realität umzusetzen. Darüber hinaus handelt es sich um einen zweigleisigen Ansatz auf der Verständnisseite und der Generierungsseite. Beide Seiten können hochwertige, multimodale neue Daten generieren und Datenrückmeldungen an das Modell selbst liefern. Was ist ein Modell? Awaker 1.0, ein großes multimodales Modell, das gerade im Zhongguancun-Forum erschienen ist. Wer ist das Team? Sophon-Motor. Gegründet von Gao Yizhao, einem Doktoranden an der Hillhouse School of Artificial Intelligence der Renmin University.

LLaVA-1.6, das mit Gemini Pro gleichzieht und die Argumentations- und OCR-Fähigkeiten verbessert, ist zu leistungsstark

Feb 01, 2024 pm 04:51 PM

LLaVA-1.6, das mit Gemini Pro gleichzieht und die Argumentations- und OCR-Fähigkeiten verbessert, ist zu leistungsstark

Feb 01, 2024 pm 04:51 PM

Im April letzten Jahres veröffentlichten Forscher der University of Wisconsin-Madison, Microsoft Research und der Columbia University gemeinsam LLaVA (Large Language and Vision Assistant). Obwohl LLaVA nur mit einem kleinen multimodalen Befehlsdatensatz trainiert wird, zeigt es bei einigen Proben sehr ähnliche Inferenzergebnisse wie GPT-4. Im Oktober brachten sie dann LLaVA-1.5 auf den Markt, das den SOTA in 11 Benchmarks mit einfachen Modifikationen am ursprünglichen LLaVA aktualisierte. Die Ergebnisse dieses Upgrades sind sehr aufregend und bringen neue Durchbrüche auf dem Gebiet der multimodalen KI-Assistenten. Das Forschungsteam kündigte die Einführung der LLaVA-1.6-Version an, die auf Argumentation, OCR und zielt