Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Das „Geheimnis' der Roboterimplementierung: kontinuierliches Lernen, Wissenstransfer und autonome Teilnahme

Das „Geheimnis' der Roboterimplementierung: kontinuierliches Lernen, Wissenstransfer und autonome Teilnahme

Das „Geheimnis' der Roboterimplementierung: kontinuierliches Lernen, Wissenstransfer und autonome Teilnahme

Dieser Artikel wurde von Lei Feng.com reproduziert. Wenn Sie einen Nachdruck benötigen, besuchen Sie bitte die offizielle Website von Lei Feng.com, um eine Genehmigung zu beantragen.

Am 23. Mai 2022 fand wie geplant in Philadelphia, USA, die ICRA 2022 (IEEE International Conference on Robotics and Automation), die jährlich stattfindende internationale Spitzenkonferenz im Bereich Robotik, statt.

Dies ist das 39. Jahr von ICRA. ICRA ist die Flaggschiffkonferenz der IEEE Robotics and Automation Society und das wichtigste internationale Forum für Robotikforscher, um ihre Arbeit vorzustellen und zu diskutieren.

Auf der diesjährigen ICRA diskutierten drei der Chefrobotikexperten von Amazon, Sidd Srinivasa, Tye Brady und Philipp Michel, kurz die Herausforderungen beim Aufbau von Robotersystemen für die Mensch-Maschine-Interaktion in der realen Welt.

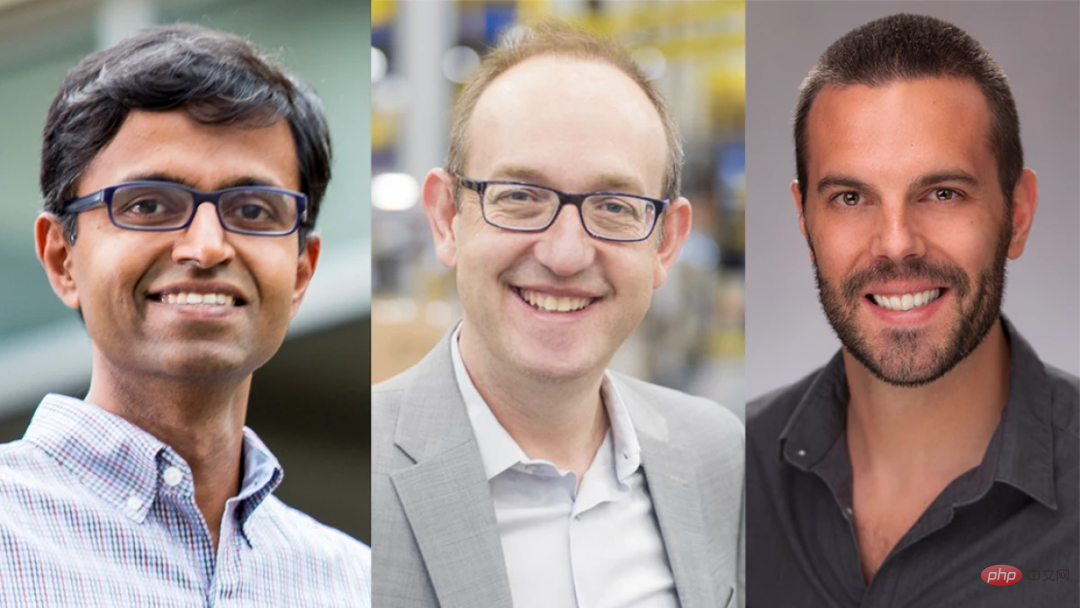

Bildunterschrift: Von links nach rechts sind Sidd Srinivasa, Direktor für künstliche Intelligenz bei Amazon Robotics, Tye Brady, technischer Chefexperte von Amazon Robotics (Global), und Philipp MichelSidd, Senior Manager für angewandte Wissenschaft bei Amazon Scout

Srinivasa ist ein weltbekannter Roboterexperte, IEEE Fellow, derzeit Distinguished Professor bei Boeing an der University of Washington und Leiter des Amazon Robot Artificial Intelligence Project. Er ist für die Verwaltung der Algorithmen autonomer Roboter verantwortlich, die das Amazon-Logistikzentrum unterstützen Mitarbeiter und die Erforschung von Robotern, die Produkte verpacken und verpacken können, sowie der autonomen Handhabung und eines wagenartigen Roboters, der Waren transportiert.

Tye Brady ist der leitende technische Experte von Amazon Robotics (global) und hat einen Master-Abschluss in Luft- und Raumfahrttechnik vom MIT. Philipp Michel und Sidd Srinivasa sind beide Doktoranden des CMU Robotics Institute und leitende Manager des Scout-Roboterprojekts von Amazon.

Sie bringen ihre eigenen Ansichten zur Lösung der Herausforderungen der Roboterimplementierung vor. Die Kommentare zur KI-Technologie wurden wie folgt zusammengestellt, ohne die ursprüngliche Bedeutung zu ändern:

F: Ihre Forschung auf dem Gebiet der Robotik löst verschiedene Probleme.

Sidd Srinivasa: Eine wichtige Schwierigkeit in der Robotikforschung ist: Wir leben in einer offenen Welt. Wir wissen nicht einmal, was der „Input“ erwartet. In unserem Fulfillment-Center muss ich über 20 Millionen Artikel kontrollieren, und die Anzahl der Artikel wächst täglich um Hunderte. Meistens wissen unsere Roboter nicht, welche Gegenstände sie aufnehmen, aber sie müssen sie vorsichtig aufnehmen und schnell verpacken, ohne sie zu beschädigen.

Philipp Michel: Für Scout liegt die Schwierigkeit in den Gegenständen, die auf dem Bürgersteig angetroffen werden, und in der Umgebung des Transports. Wir verfügen über private Liefereinrichtungen in vier Bundesstaaten der Vereinigten Staaten. Wetterbedingungen, Lichtverhältnisse ... Es war von Anfang an klar, dass wir uns mit einer Vielzahl von Variablen auseinandersetzen mussten, damit sich der Roboter an komplexe Umgebungen anpassen kann.

Tye Brady: Bei der Entwicklung von Ausführungsrobotern haben wir einen wesentlichen Vorteil, nämlich den Betrieb in einer halbstrukturierten Umgebung. Wir können unsere eigenen Verkehrsregeln für Roboter festlegen, und das Verständnis der Umgebung hilft unseren Wissenschaftlern und Ingenieuren wirklich dabei, ein tiefes Verständnis der Objekte zu erlangen, die wir bewegen, manipulieren, klassifizieren und identifizieren müssen, um Befehle auszuführen. Mit anderen Worten: Wir können das Streben nach Technologie in der realen Welt verwirklichen.

Philipp Michel: Eine weitere Gemeinsamkeit ist, dass wir bei der Lösung von Problemen stark darauf angewiesen sind, aus Daten zu lernen. Scout empfängt bei der Ausführung von Aufgaben reale Daten und entwickelt dann iterativ Lösungen für maschinelles Lernen für Wahrnehmung, Lokalisierung und Navigation.

Sidd Srinivasa: Ich stimme voll und ganz zu (aus Daten lernen, um Probleme zu lösen). Ich denke, maschinelles Lernen und adaptive Steuerung sind der Schlüssel zur superlinearen Skalierung. Wenn wir Tausende von Robotern einsetzen, können nicht Tausende von Wissenschaftlern und Ingenieuren daran arbeiten. Wir müssen uns auf reale Daten verlassen, um ein superlineares Wachstum zu erreichen.

Darüber hinaus denke ich, dass die offene Welt uns dazu zwingen wird, über „kontinuierliches Lernen“ nachzudenken. Unsere Modelle für maschinelles Lernen werden häufig auf der Grundlage einiger Eingabedatenverteilungen trainiert. Da es sich jedoch um eine offene Welt handelt, tritt das Problem der „Kovariatenverschiebung“ auf, d Lernmodelle neigen dazu, oft ohne Grund zu selbstsicher zu sein.

Ein Großteil unserer Arbeit bestand also darin, „Watchdogs“ (Watchdogs, eine Art Überwachungsgerät) zu erstellen, die erkennen, wann die Verteilung der Eingabedaten von der Verteilung abweicht, auf die sie trainiert wurden. Anschließend führen wir eine „Wichtigkeitsstichprobe“ durch, damit wir die geänderten Daten auswählen und das maschinelle Lernmodell neu trainieren können.

Philipp Michel: Das ist einer der Gründe, warum wir Roboter an verschiedenen Orten trainieren wollen, damit wir frühzeitig wissen, auf welche realen Daten der Roboter stoßen kann, was uns wiederum dazu zwingt, Lösungen zu entwickeln, die das können Neue Daten lösen.

Sidd Srinivasa: Das ist in der Tat eine gute Idee. Einer der Vorteile mehrerer Roboter ist die Fähigkeit des Systems, geänderte Inhalte zu erkennen, neu zu trainieren und dieses Wissen dann mit anderen Robotern zu teilen.

Denken Sie an die Geschichte eines Sortierroboters: In einem Winkel der Welt stößt ein Roboter auf eine neue Verpackungsart. Zuerst war es beunruhigt, weil es so etwas noch nie zuvor gesehen hatte und es nicht erkennen konnte. Dann entstand eine neue Lösung: ein Roboter, der neue Verpackungstypen an alle Roboter der Welt übertragen konnte. Auf diese Weise wissen die anderen Roboter, was sie damit machen sollen, wenn diese neue Verpackungsart an anderer Stelle auftaucht. Dies entspricht einem „Backup“. Wenn an einer Stelle neue Daten auftauchen, wissen andere davon, weil das System in der Lage war, sich neu zu trainieren und Informationen auszutauschen.

Philipp Michel: Unser Roboter macht ähnliche Dinge. Wenn unsere Roboter auf neue Hindernisse stoßen, auf die sie zuvor noch nicht gestoßen sind, versuchen wir, das Modell so anzupassen, dass es diese Hindernisse erkennt und mit ihnen umgeht, und stellen das neue Modell dann für alle Roboter bereit.

Eines der Dinge, die mich nachts wach halten, ist die Vorstellung, dass unsere Roboter auf dem Bürgersteig auf neue Objekte stoßen, denen sie in den nächsten drei Jahren nicht mehr begegnen werden, zum Beispiel: Menschen verwenden sie an Halloween, Gargoyles schmücken Rasenflächen, oder man stellt einen Regenschirm auf einen Picknicktisch, damit er weniger wie ein „Picknicktisch“ aussieht. In diesem Fall erkennen alle maschinellen Lernalgorithmen nicht, dass es sich um einen Picknicktisch handelt.

Ein Teil unserer Forschung befasst sich also mit der Frage, wie wir alltägliche Dinge, die nicht mit bestimmten Kategorien von Dingen verknüpft werden müssen, in Einklang bringen können. Wenn es sich um einen offenen Schachtdeckel handelt, muss der Roboter ihn gut erkennen können, sonst fällt er herunter. Wenn es sich jedoch nur um eine zufällige Box handelt, müssen wir die Hierarchie der Box wahrscheinlich nicht kennen, sondern nur, dass dies das Objekt ist, um das wir herumgehen möchten.

Sidd Srinivasa: Eine weitere Herausforderung besteht darin, dass eine Änderung Ihres Modells unbeabsichtigte Folgen haben kann. Das geänderte Modell hat möglicherweise keinen Einfluss auf die Wahrnehmung des Roboters, kann jedoch die Art und Weise verändern, wie der Roboter „bremst“, was dazu führt, dass die Kugellager nach zwei Monaten verschleißen. Bei End-to-End-Systemen geht es in vielen interessanten zukünftigen Forschungen darum, „die Auswirkungen von Änderungen in Teilen des Systems auf die Leistung des gesamten Systems zu verstehen“.

Philipp Michel: Wir haben viel Zeit damit verbracht, darüber nachzudenken, ob wir verschiedene Teile des Roboterstapels aufteilen sollten. Die Integration zwischen ihnen kann viele Vorteile bringen, ist aber auch begrenzt. Ein Extremfall ist das Lernen von Kamera zu Motor und Drehmoment, was in jeder realen Robotikanwendung eine große Herausforderung darstellt. Dann gibt es noch den traditionellen Robotik-Stack, der gut in Teile wie Lokalisierung, Wahrnehmung, Planung und Kontrolle unterteilt ist.

Wir haben auch viel Zeit damit verbracht, darüber nachzudenken, wie sich der Stapel im Laufe der Zeit entwickeln sollte und welche Leistungsverbesserungen es gibt, wenn diese Teile näher zusammengebracht werden? Gleichzeitig wollen wir ein möglichst interpretierbares System haben. Wir versuchen, die Integration von Lernkomponenten zu maximieren, indem wir den gesamten Stack nutzen und gleichzeitig die Interpretierbarkeit und die Anzahl der Sicherheitsfunktionen beibehalten.

Sidd Srinivasa: Das ist ein toller Punkt. Ich stimme Philipp voll und ganz zu. Es ist nicht unbedingt richtig, ein Modell zu verwenden, um alle Modelle zu beherrschen. Aber oft bauen wir am Ende Modelle für maschinelles Lernen, die ein gemeinsames Rückgrat mit mehreren angewandten Köpfen haben. Was ist ein Objekt und was bedeutet es, ein Objekt zu segmentieren? Es kann so etwas wie Pflücken, Stapeln oder Verpacken sein, aber jedes erfordert einen speziellen Kopf, der auf einem Rückgrat sitzt, das auf Aufgaben spezialisiert ist.

Philipp Michel: Einige Faktoren, die wir berücksichtigen, sind Batterie-, Reichweiten-, Temperatur-, Platz- und Rechenbeschränkungen. Daher müssen wir mit unseren Modellen effizient umgehen, die Modelle optimieren und versuchen, möglichst viel vom gemeinsamen Rückgrat zu nutzen, wie Sidd erwähnt hat: unterschiedliche Köpfe für unterschiedliche Aufgaben.

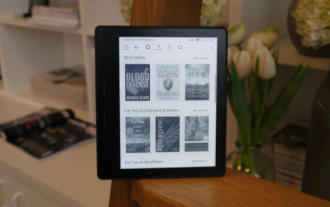

Bildunterschrift: Amazon Scout ist ein autonomer Lieferroboter, der sich mit Schrittgeschwindigkeit auf öffentlichen Gehwegen bewegen kann und derzeit in vier Bundesstaaten der USA im Feldtest getestet wird.

F: Als ich nach den Gemeinsamkeiten zwischen Ihren Projekten fragte, fiel mir eines ein: Ihre Roboter arbeiten alle in der gleichen Umgebung wie Menschen. Warum verkompliziert dies das Problem?

Sidd Srinivasa: Roboter nähern sich dem menschlichen Leben, und wir müssen alle komplexen Interaktionen respektieren, die in der menschlichen Welt stattfinden. Neben dem Gehen, Fahren und Ausführen von Aufgaben gibt es auch komplexe soziale Interaktionen. Für einen Roboter ist es erstens wichtig, dass er bei Bewusstsein ist und zweitens, dass er involviert ist.

Es ist wirklich schwer, wenn man Auto fährt. Manchmal ist es schwer zu erkennen, was andere Leute denken, und auf der Grundlage ihrer Gedanken zu entscheiden, wie man sich verhält. Es ist schwierig, nur über das Problem nachzudenken, und dann ist es noch schwieriger, den Kreis zu schließen.

Wenn ein Roboter Schach spielt oder gegen einen Menschen spielt, ist es viel einfacher vorherzusagen, was er tun wird, da die Regeln bereits klar festgelegt sind. Wenn Sie davon ausgehen, dass Ihre Gegner optimal sind, werden Sie gut abschneiden, auch wenn sie suboptimal sind. Dies ist in einigen Zwei-Spieler-Spielen garantiert.

Aber die tatsächliche Situation ist nicht so. Wenn wir ein solches kooperatives Spiel spielen, das eine Win-Win-Situation gewährleistet, ist es für uns tatsächlich schwierig, während des Spiels genaue Vorhersagen zu treffen, selbst wenn die Kollaborateure gute Absichten haben.

Philipp Michel: Und das Verhalten der Menschenwelt verändert sich sehr. Einige Haustiere ignorieren den Roboter völlig und andere laufen auf den Roboter zu. Das Gleiche gilt für Fußgänger: Manche ignorieren den Roboter und andere gehen direkt auf ihn zu. Vor allem Kinder sind äußerst neugierig und sehr interaktiv, und wir müssen in der Lage sein, mit allen Situationen sicher umzugehen, und diese Variabilität macht es spannend.

Das obige ist der detaillierte Inhalt vonDas „Geheimnis' der Roboterimplementierung: kontinuierliches Lernen, Wissenstransfer und autonome Teilnahme. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1378

1378

52

52

Amazon Kindle Oasis wird in den USA eingestellt und markiert damit das Ende der Ära der High-End-E-Reader

Feb 25, 2024 pm 12:10 PM

Amazon Kindle Oasis wird in den USA eingestellt und markiert damit das Ende der Ära der High-End-E-Reader

Feb 25, 2024 pm 12:10 PM

Aktuellen Nachrichten zufolge hat Amazon die Einstellung seines High-End-E-Readers Kindle Oasis angekündigt und ihn vom US-Markt genommen. Dieser Schritt deutet darauf hin, dass der einst mit Spannung erwartete Kindle Oasis offiziell vom Markt genommen wurde. Obwohl es in einigen Überseemärkten wie Kanada und dem Vereinigten Königreich noch kleine Mengen an Lagerbeständen gibt, sind diese nach dem Ausverkauf nicht mehr verfügbar. Dies ist der Anfang dafür, dass dieser gefeierte High-End-Reader der Vergangenheit angehört. Kindle Oasis wird von Benutzern wegen seiner hervorragenden Leistung und seines Designs geliebt. Da sich die Marktnachfrage ändert und neue Produkte auf den Markt kommen, hat Amazon möglicherweise beschlossen, dieses Produkt einzustellen. Obwohl Kindle Oasis gewisse Spuren auf dem Markt hinterlassen hat, hat Amazon seinen Fokus möglicherweise auf andere Produktlinien verlagert

Der Ameca der zweiten Generation ist da! Er kann fließend mit dem Publikum kommunizieren, sein Gesichtsausdruck ist realistischer und er kann Dutzende Sprachen sprechen.

Mar 04, 2024 am 09:10 AM

Der Ameca der zweiten Generation ist da! Er kann fließend mit dem Publikum kommunizieren, sein Gesichtsausdruck ist realistischer und er kann Dutzende Sprachen sprechen.

Mar 04, 2024 am 09:10 AM

Der humanoide Roboter Ameca wurde auf die zweite Generation aufgerüstet! Kürzlich erschien auf der World Mobile Communications Conference MWC2024 erneut der weltweit fortschrittlichste Roboter Ameca. Rund um den Veranstaltungsort lockte Ameca zahlreiche Zuschauer an. Mit dem Segen von GPT-4 kann Ameca in Echtzeit auf verschiedene Probleme reagieren. „Lass uns tanzen.“ Auf die Frage, ob sie Gefühle habe, antwortete Ameca mit einer Reihe von Gesichtsausdrücken, die sehr lebensecht aussahen. Erst vor wenigen Tagen stellte EngineeredArts, das britische Robotikunternehmen hinter Ameca, die neuesten Entwicklungsergebnisse des Teams vor. Im Video verfügt der Roboter Ameca über visuelle Fähigkeiten und kann den gesamten Raum und bestimmte Objekte sehen und beschreiben. Das Erstaunlichste ist, dass sie es auch kann

Implementierung von Algorithmen für maschinelles Lernen in C++: Häufige Herausforderungen und Lösungen

Jun 03, 2024 pm 01:25 PM

Implementierung von Algorithmen für maschinelles Lernen in C++: Häufige Herausforderungen und Lösungen

Jun 03, 2024 pm 01:25 PM

Zu den häufigsten Herausforderungen, mit denen Algorithmen für maschinelles Lernen in C++ konfrontiert sind, gehören Speicherverwaltung, Multithreading, Leistungsoptimierung und Wartbarkeit. Zu den Lösungen gehören die Verwendung intelligenter Zeiger, moderner Threading-Bibliotheken, SIMD-Anweisungen und Bibliotheken von Drittanbietern sowie die Einhaltung von Codierungsstilrichtlinien und die Verwendung von Automatisierungstools. Praktische Fälle zeigen, wie man die Eigen-Bibliothek nutzt, um lineare Regressionsalgorithmen zu implementieren, den Speicher effektiv zu verwalten und leistungsstarke Matrixoperationen zu nutzen.

Wie kann KI Roboter autonomer und anpassungsfähiger machen?

Jun 03, 2024 pm 07:18 PM

Wie kann KI Roboter autonomer und anpassungsfähiger machen?

Jun 03, 2024 pm 07:18 PM

Im Bereich der industriellen Automatisierungstechnik gibt es zwei aktuelle Hotspots, die kaum zu ignorieren sind: Künstliche Intelligenz (KI) und Nvidia. Ändern Sie nicht die Bedeutung des ursprünglichen Inhalts, optimieren Sie den Inhalt, schreiben Sie den Inhalt neu, fahren Sie nicht fort: „Darüber hinaus sind beide eng miteinander verbunden, da Nvidia nicht auf seine ursprüngliche Grafikverarbeitungseinheit (GPU) beschränkt ist ) erweitert es seine GPU. Die Technologie erstreckt sich auf den Bereich der digitalen Zwillinge und ist eng mit neuen KI-Technologien verbunden. „Vor kurzem hat NVIDIA eine Zusammenarbeit mit vielen Industrieunternehmen geschlossen, darunter führende Industrieautomatisierungsunternehmen wie Aveva, Rockwell Automation und Siemens und Schneider Electric sowie Teradyne Robotics und seine Unternehmen MiR und Universal Robots. Kürzlich hat Nvidia gesammelt

Nach 2 Monaten kann der humanoide Roboter Walker S Kleidung falten

Apr 03, 2024 am 08:01 AM

Nach 2 Monaten kann der humanoide Roboter Walker S Kleidung falten

Apr 03, 2024 am 08:01 AM

Herausgeber des Machine Power Report: Wu Xin Die heimische Version des humanoiden Roboters + eines großen Modellteams hat zum ersten Mal die Betriebsaufgabe komplexer flexibler Materialien wie das Falten von Kleidung abgeschlossen. Mit der Enthüllung von Figure01, das das multimodale große Modell von OpenAI integriert, haben die damit verbundenen Fortschritte inländischer Kollegen Aufmerksamkeit erregt. Erst gestern veröffentlichte UBTECH, Chinas „größter Bestand an humanoiden Robotern“, die erste Demo des humanoiden Roboters WalkerS, der tief in das große Modell von Baidu Wenxin integriert ist und einige interessante neue Funktionen aufweist. Jetzt sieht WalkerS, gesegnet mit Baidu Wenxins großen Modellfähigkeiten, so aus. Wie Figure01 bewegt sich WalkerS nicht umher, sondern steht hinter einem Schreibtisch, um eine Reihe von Aufgaben zu erledigen. Es kann menschlichen Befehlen folgen und Kleidung falten

Der erste Roboter erscheint, der menschliche Aufgaben autonom erledigt, mit fünf flexiblen Fingern und übermenschlicher Geschwindigkeit, und große Modelle unterstützen das Training im virtuellen Raum

Mar 11, 2024 pm 12:10 PM

Der erste Roboter erscheint, der menschliche Aufgaben autonom erledigt, mit fünf flexiblen Fingern und übermenschlicher Geschwindigkeit, und große Modelle unterstützen das Training im virtuellen Raum

Mar 11, 2024 pm 12:10 PM

Diese Woche gab FigureAI, ein Robotikunternehmen, an dem OpenAI, Microsoft, Bezos und Nvidia beteiligt sind, bekannt, dass es fast 700 Millionen US-Dollar an Finanzmitteln erhalten hat und plant, im nächsten Jahr einen humanoiden Roboter zu entwickeln, der selbstständig gehen kann. Und Teslas Optimus Prime hat immer wieder gute Nachrichten erhalten. Niemand zweifelt daran, dass dieses Jahr das Jahr sein wird, in dem humanoide Roboter explodieren. SanctuaryAI, ein in Kanada ansässiges Robotikunternehmen, hat kürzlich einen neuen humanoiden Roboter auf den Markt gebracht: Phoenix. Beamte behaupten, dass es viele Aufgaben autonom und mit der gleichen Geschwindigkeit wie Menschen erledigen kann. Pheonix, der weltweit erste Roboter, der Aufgaben autonom in menschlicher Geschwindigkeit erledigen kann, kann jedes Objekt sanft greifen, bewegen und elegant auf der linken und rechten Seite platzieren. Es kann Objekte autonom identifizieren

Cloud-Computing-Riese startet Rechtsstreit: Amazon verklagt Nokia wegen Patentverletzung

Jul 31, 2024 pm 12:47 PM

Cloud-Computing-Riese startet Rechtsstreit: Amazon verklagt Nokia wegen Patentverletzung

Jul 31, 2024 pm 12:47 PM

Laut Nachrichten dieser Website vom 31. Juli verklagte der Technologieriese Amazon am Dienstag vor dem Bundesgericht in Delaware das finnische Telekommunikationsunternehmen Nokia und beschuldigte es, mehr als ein Dutzend Amazon-Patente im Zusammenhang mit Cloud-Computing-Technologie verletzt zu haben. 1. Amazon gab in der Klage an, dass Nokia mit dem Amazon Cloud Computing Service (AWS) verbundene Technologien, einschließlich Cloud-Computing-Infrastruktur, Sicherheits- und Leistungstechnologien, missbraucht habe, um seine eigenen Cloud-Service-Produkte zu verbessern. Amazon habe AWS im Jahr 2006 eingeführt und seine bahnbrechende Cloud-Computing-Technologie sei seit Anfang der 2000er Jahre entwickelt worden, heißt es in der Beschwerde. „Amazon ist ein Pionier im Cloud Computing, und jetzt nutzt Nokia Amazons patentierte Cloud-Computing-Innovationen ohne Erlaubnis“, heißt es in der Beschwerde. Amazon beantragt vor Gericht eine einstweilige Verfügung zur Sperrung

Zehn humanoide Roboter gestalten die Zukunft

Mar 22, 2024 pm 08:51 PM

Zehn humanoide Roboter gestalten die Zukunft

Mar 22, 2024 pm 08:51 PM

Die folgenden 10 humanoiden Roboter prägen unsere Zukunft: 1. ASIMO: ASIMO wurde von Honda entwickelt und ist einer der bekanntesten humanoiden Roboter. Mit einer Höhe von 1,20 m und einem Gewicht von 50 kg ist ASIMO mit fortschrittlichen Sensoren und künstlichen Intelligenzfunktionen ausgestattet, die es ihm ermöglichen, sich in komplexen Umgebungen zurechtzufinden und mit Menschen zu interagieren. Aufgrund seiner Vielseitigkeit eignet sich ASIMO für eine Vielzahl von Aufgaben, von der Unterstützung von Menschen mit Behinderungen bis hin zur Durchführung von Präsentationen bei Veranstaltungen. 2. Pepper: Pepper wurde von Softbank Robotics entwickelt und möchte ein sozialer Begleiter für Menschen sein. Mit seinem ausdrucksstarken Gesicht und der Fähigkeit, Emotionen zu erkennen, kann Pepper an Gesprächen teilnehmen, im Einzelhandel helfen und sogar pädagogische Unterstützung leisten. Pfeffer