Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Eine kurze Analyse der Entwicklung der Mensch-Computer-Interaktion in intelligenten Cockpits

Eine kurze Analyse der Entwicklung der Mensch-Computer-Interaktion in intelligenten Cockpits

Eine kurze Analyse der Entwicklung der Mensch-Computer-Interaktion in intelligenten Cockpits

Gegenwärtig haben sich Autos nicht nur in Bezug auf Antriebsquellen, Fahrmethoden und Fahrerlebnis verändert, auch das Cockpit hat sich vom traditionell langweiligen mechanischen und elektronischen Raum verabschiedet. Das Niveau der Intelligenz ist sprunghaft angestiegen und hat sich zum „dritten Raum“ entwickelt „Nach dem Leben der Menschen außerhalb von Zuhause und Büro. Drei Räume“. Durch Spitzentechnologien wie Gesichts- und Fingerabdruckerkennung, Sprach-/Gesteninteraktion und Multi-Screen-Verknüpfung haben die heutigen intelligenten Cockpits in Automobilen ihre Fähigkeiten in der Umweltwahrnehmung, Informationserfassung und -verarbeitung erheblich verbessert und sind zu „intelligenten Assistenten“ für das menschliche Fahren geworden .

Das intelligente Cockpit verabschiedet sich von der einfachen Elektronik und tritt in die Phase des intelligenten Assistenten ein. Eines der wesentlichen Anzeichen ist, dass die Interaktion zwischen Mensch und Cockpit vom Passiven zum Aktiven wechselt . Die Kabine selbst ist zentral definiert. Früher wurde der Informationsaustausch hauptsächlich von Menschen initiiert, heute kann er sowohl von Menschen als auch von Maschinen initiiert werden. Der Grad der Interaktion zwischen Menschen und Maschinen ist zu einem wichtigen Symbol für die Definition des Niveaus von Smart-Cockpit-Produkten geworden.

Hintergrund der Entwicklung der Mensch-Computer-Interaktion

Die Geschichte von Computern und Mobiltelefonen kann die Entwicklung von Interaktionsmethoden zwischen Maschinen und Menschen widerspiegeln, von Komplexität zu Einfachheit, von abstrakten Handlungen zu natürlichen Interaktion. Der wichtigste Entwicklungstrend der Mensch-Computer-Interaktion in der Zukunft besteht darin, Maschinen von der passiven Reaktion zur aktiven Interaktion zu bewegen. Betrachtet man die Ausweitung dieses Trends, besteht das ultimative Ziel der Mensch-Maschine-Interaktion darin, Maschinen zu vermenschlichen und die Interaktion zwischen Menschen und Maschinen so natürlich und reibungslos zu gestalten wie die Kommunikation zwischen Menschen. Mit anderen Worten: Die Geschichte der Mensch-Computer-Interaktion ist die Geschichte der Anpassung von Menschen von Maschinen an Menschen durch Maschinen.

Die Entwicklung intelligenter Cockpits verläuft ebenfalls nach einem ähnlichen Prozess. Mit der Weiterentwicklung der elektronischen Technologie und den Erwartungen der Autobesitzer gibt es immer mehr elektronische Signale und Funktionen innerhalb und außerhalb des Autos, sodass Autobesitzer die Verschwendung von Aufmerksamkeitsressourcen und damit die Ablenkung beim Fahren reduzieren können Dadurch hat sich die Fahrzeuginteraktion nach und nach verändert: Physischer Knopf/Tastatur – digitaler Touchscreen – Sprachsteuerung – natürliche Interaktion.

Natürliche Interaktion ist das ideale Modell für die nächste Generation der Mensch-Computer-Interaktion

Was ist natürliche Interaktion?

Kurz gesagt, Kommunikation wird durch Bewegung, Blickverfolgung, Sprache usw. erreicht. Die Bewusstseinsmodalität ähnelt hier insbesondere der menschlichen „Wahrnehmung“. Ihre Form ist mit verschiedenen Wahrnehmungen vermischt und entspricht den fünf wichtigsten menschlichen Wahrnehmungen: Sehen, Hören, Berühren, Riechen und Schmecken. Zu den entsprechenden Informationsmedien gehören verschiedene Sensoren wie Ton, Video, Text und Infrarot, Druck und Radar. Ein intelligentes Auto ist im Wesentlichen ein bemannter Roboter. Seine beiden wichtigsten Funktionen sind Selbstkontrolle und Interaktion mit Menschen. Ohne eine dieser Funktionen kann es nicht effizient mit Menschen zusammenarbeiten. Daher ist ein intelligentes Mensch-Computer-Interaktionssystem dringend erforderlich.

Wie man natürliche Interaktion realisiert

Immer mehr Sensoren werden in das Cockpit integriert, und die Sensoren haben die Möglichkeiten der Formvielfalt, Datenfülle und Genauigkeit verbessert. Einerseits lässt es den Rechenleistungsbedarf im Cockpit sprunghaft ansteigen, andererseits sorgt es auch für eine bessere Unterstützung der Wahrnehmungsfähigkeit. Dieser Trend ermöglicht die Schaffung umfassenderer Innovationen in der Cockpit-Szene und besserer interaktiver Erlebnisse. Unter ihnen ist die visuelle Verarbeitung der Schlüssel zur Mensch-Computer-Interaktionstechnologie im Cockpit. Und Fusionstechnologie ist die eigentliche Lösung, wenn es beispielsweise um die Spracherkennung in lauten Umgebungen geht, reichen Mikrofone allein nicht aus. In diesem Fall können Menschen der Rede einer Person nicht nur mit den Ohren, sondern auch mit den Augen selektiv zuhören. Daher ist es möglich, durch visuelle Identifizierung der Schallquelle und Lippenlesen bessere Ergebnisse zu erzielen als durch einfache Spracherkennung. Wenn der Sensor die fünf Sinne eines Menschen sind, dann ist die Rechenleistung ein automatisch interaktives menschliches Gehirn. Der KI-Algorithmus kombiniert Sehen und Sprechen. Durch verschiedene kognitive Methoden kann er verschiedene Signale wie Gesicht, Bewegung, Körperhaltung, verarbeiten. und Stimmerkennung. Dadurch kann eine intelligentere menschliche Zielinteraktion erreicht werden, einschließlich Blickverfolgung, Spracherkennung, Verknüpfung der Erkennung gesprochener Sprache und Erkennung des Ermüdungsstatus des Fahrers usw.

Die Gestaltung der Interaktion des Cockpit-Personals muss in der Regel durch Edge-Computing und nicht durch Cloud-Computing erfolgen. Drei Punkte: Sicherheit, Echtzeit- und Datenschutzsicherheit. Cloud Computing ist auf das Netzwerk angewiesen. Bei intelligenten Autos kann die Zuverlässigkeit ihrer Verbindungen nicht gewährleistet werden, wenn man sich auf drahtlose Netzwerke verlässt. Gleichzeitig ist die Verzögerung der Datenübertragung unkontrollierbar und ein reibungsloses Zusammenspiel kann nicht gewährleistet werden. Um ein umfassendes Benutzererlebnis für automatisierte Sicherheitsdomänen zu gewährleisten, liegt die Lösung im Edge Computing.

Allerdings ist auch die Sicherheit personenbezogener Daten eines der Probleme. Der private Raum im Fahrerhaus ist in puncto Sicherheit besonders sicher. Die heutige personalisierte Spracherkennung wird hauptsächlich in der Cloud implementiert, und private biometrische Informationen wie Stimmabdrücke können private Identitätsinformationen bequemer anzeigen. Durch die Verwendung des Edge-KI-Designs auf der Fahrzeugseite können private biometrische Informationen wie Bilder und Töne in semantische Informationen des Fahrzeugs umgewandelt und dann in die Cloud hochgeladen werden, wodurch die Sicherheit der persönlichen Daten des Fahrzeugs effektiv gewährleistet wird.

Im Zeitalter des autonomen Fahrens muss interaktive Intelligenz mit der Fahrintelligenz übereinstimmen

In absehbarer Zukunft wird der kooperative Drohnenflug ein langjähriges Phänomen sein und die Drohneninteraktion im Cockpit wird vom Menschen gesteuert Die erste Schnittstelle für aktive Flugfähigkeiten. Derzeit ist der Bereich des intelligenten Fahrens mit dem Problem einer ungleichmäßigen Entwicklung konfrontiert. Der Grad der Mensch-Computer-Interaktion bleibt hinter der Verbesserung des autonomen Fahrens zurück, was häufig zu Problemen beim autonomen Fahren führt und die Entwicklung des autonomen Fahrens behindert. Das Merkmal des Kooperationsverhaltens bei der Mensch-Computer-Interaktion ist die menschliche Operationsschleife. Daher muss die Mensch-Computer-Interaktionsfunktion mit der autonomen Fahrfunktion konsistent sein. Andernfalls sind ernsthafte Risiken für die funktionale Sicherheit zu erwarten, die mit der überwiegenden Mehrheit der tödlichen Unfälle beim autonomen Fahren verbunden sind. Sobald die Mensch-Computer-Interaktionsschnittstelle die kognitiven Ergebnisse des eigenen Fahrens liefern kann, kann die Energiegrenze des autonomen Fahrsystems besser verstanden werden, was erheblich dazu beitragen wird, die Akzeptanz autonomer Fahrfunktionen der Stufe L+ zu verbessern.

Natürlich ist die aktuelle Smart-Cockpit-Interaktionsmethode hauptsächlich eine Erweiterung des mobilen Android-Ökosystems, die hauptsächlich vom Host-Bildschirm unterstützt wird. Heutige Monitore werden immer größer, und das liegt tatsächlich daran, dass Funktionen mit niedriger Priorität den Platz von Funktionen mit hoher Priorität einnehmen, was zu zusätzlichen Signalstörungen führt und die Betriebssicherheit beeinträchtigt. Obwohl es in Zukunft immer noch physische Displays geben wird, glaube ich, dass sie durch natürliche Mensch-Computer-Interaktion + AR-HUD ersetzt werden.

Wenn das intelligente Fahrsystem auf L4 oder höher weiterentwickelt wird, werden die Menschen vom langweiligen und ermüdenden Fahren befreit und Autos werden zum „dritten Lebensraum der Menschen“. Auf diese Weise werden in Zukunft die Standorte des Unterhaltungsbereichs und des Sicherheitsfunktionsbereichs (Mensch-Computer-Interaktion und automatische Steuerung) in der Kabine geändert und der Sicherheitsbereich wird zum Hauptkontrollbereich. Autonomes Fahren ist die Interaktion zwischen Autos und der Umwelt, und die Interaktion zwischen Menschen ist die Interaktion zwischen Menschen und Autos. Beide werden integriert, um die Zusammenarbeit von Menschen, Autos und der Umwelt zu vervollständigen und einen vollständig geschlossenen Fahrkreislauf zu bilden.

Zweitens ist die automatische Dialog- und AR-HUD-Dialogschnittstelle sicherer. Bei der Kommunikation mit Worten oder Gesten kann eine Ablenkung der Sicht des Fahrers vermieden werden, wodurch die Fahrsicherheit verbessert wird. Dies ist auf einem großen Cockpit-Bildschirm einfach nicht möglich, aber ARHUD umgeht dieses Problem, indem es Sensorsignale für das autonome Fahren anzeigt.

Drittens ist die natürliche Gesprächsmethode eine implizite, prägnante und emotionale natürliche Gesprächsmethode. Sie können nicht zu viel wertvollen physischen Platz im Auto einnehmen, aber Sie können jederzeit und überall mit der freien Person zusammen sein. Daher wird die domäneninterne Integration von Smart Driving und Smart Cockpit in Zukunft eine sicherere Entwicklungsmethode sein und die endgültige Entwicklung wird das zentrale System des Autos sein.

Praktische Prinzipien der Mensch-Computer-Interaktion

Touch-Interaktion

Auf dem Bildschirm der frühen Mittelkonsole wurden nur Radioinformationen angezeigt, und der größte Teil des Bereichs beherbergte eine große Anzahl physischer Interaktionstasten Grundsätzlich erfolgt die Kommunikation mit Menschen durch taktile Interaktion.

Mit der Entwicklung der intelligenten Interaktion sind große Bildschirme für die zentrale Steuerung entstanden und die Anzahl der physischen Interaktionstasten nimmt allmählich ab. Der große zentrale Kontrollbildschirm wird immer größer und nimmt eine immer wichtigere Position ein. Die physischen Tasten auf der Mittelkonsole wurden auf Null reduziert. Zu diesem Zeitpunkt können die Insassen nicht mehr durch Berührung mit anderen kommunizieren , sondern nutzen hauptsächlich das Sehen, um zu kommunizieren. Aber es wird für Menschen absolut unbequem sein, im intelligenten Cockpit nur über das Sehen mit Menschen zu kommunizieren. Insbesondere beim Autofahren muss der Mensch 90 % seiner visuellen Aufmerksamkeit auf die Beobachtung der Straßenverhältnisse richten, damit er sich lange auf den Bildschirm konzentrieren und mit dem smarten Cockpit sprechen kann.

Sprachinteraktion

(1) Prinzip der Sprachinteraktion.

Verstehen natürlicher Sprache – Spracherkennung – Sprache in Sprache.

(2) Für die Sprachinteraktion erforderliche Szenarien.

Es gibt zwei Hauptelemente in der Szenarioanwendung der Sprachsteuerung: Zum einen kann sie die Funktion ohne Eingabeaufforderungen auf dem Touchscreen ersetzen und zum anderen einen natürlichen Dialog mit der Mensch-Maschine-Schnittstelle führen Auswirkungen der manuellen Steuerung der Mensch-Maschine-Schnittstelle. Verbesserung der Sicherheit.

Wenn Sie von der Arbeit nach Hause kommen, möchten Sie zunächst während der Fahrt schnell das Fahrzeug steuern, Informationen abfragen und Klimaanlage, Sitze usw. überprüfen. Informieren Sie sich auf langen Fahrten unterwegs über Raststätten und Tankstellen sowie über den Fahrplan. Die zweite besteht darin, alles per Sprache zu verknüpfen. Musik und Subscreen-Entertainment im Auto sind schnell herbeigerufen. Was wir also tun müssen, ist, das Fahrzeug schnell zu kontrollieren.

Zu den Grundfunktionen gehört die Einstellung der Umgebungsbeleuchtung im Auto, die Einstellung der Temperaturregelung der Klimaanlage im Auto, die Einstellung der Fenster und die Einstellung des Rückspiegels Die ursprüngliche Absicht der schnellen Steuerung des Fahrzeugs besteht darin, den Fahrer schneller zu machen. Eine sorgfältige Steuerung des Fahrzeugs und die Reduzierung von Ablenkungen tragen dazu bei, den Sicherheitsfaktor zu erhöhen. Die Sprachinteraktion aus der Ferne ist ein wichtiger Zugang zur Implementierung des gesamten Systems, da das System die Sprachanweisungen des Fahrers verstehen und eine intelligente Navigation ermöglichen muss. Wir können nicht nur passiv Aufgaben annehmen, sondern Ihnen auch Zusatzleistungen wie Zielvorstellung und Terminplanung anbieten.

Dazu kommt noch die Überwachung von Fahrzeug und Fahrer. Im Echtzeitbetrieb können Sie jederzeit den Reifendruck, die Tanktemperatur, das Kühlmittel, das Motoröl und andere Fahrzeugleistungen sowie den Fahrzeugstatus abfragen. Die Echtzeit-Informationsabfrage hilft Fahrern, Informationen im Voraus zu verarbeiten. Selbstverständlich sollten Sie auch beim Erreichen des warnungskritischen Punktes in Echtzeit aufpassen. Neben der internen Überwachung ist natürlich auch eine externe Überwachung erforderlich. Durch eine gemischte Überwachung von Biometrie und Sprachüberwachung können die Emotionen des Fahrers überwacht werden. Erinnern Sie den Fahrer rechtzeitig daran, aufzumuntern, um Verkehrsunfälle zu vermeiden. Sowie Vorsichtsmaßnahmen gegen Ermüdungsgeräusche, die durch langes Fahren verursacht werden. Im Hinblick auf Multimedia-Unterhaltung schließlich sind Fahrszenen, Musikwiedergabe und Radio die häufigsten Vorgänge und Bedürfnisse. Neben einfachen Funktionen wie Abspielen, Pause und Songwechsel wartet auch die Entwicklung personalisierter Funktionen wie Sammeln, Kontoregistrierung, Öffnen des Spielverlaufs, Wechseln der Spielreihenfolge und Interaktion vor Ort auf Sie.

Fehler berücksichtigen

In Sprachgesprächen muss Fehlertoleranz zugelassen werden. Die grundlegende Fehlertoleranz wird auch auf Szenario-für-Szenario-Basis gehandhabt. Das erste ist, dass der Benutzer es nicht versteht und aufgefordert wird, es noch einmal zu sagen. Das zweite ist, dass der Benutzer zugehört hat, aber nicht in der Lage ist, das Problem zu lösen. Das dritte ist, dass es als Fehlermeldung erkannt wird. was wiederum bestätigt werden kann.

Gesichtserkennung

(1) Prinzip der Gesichtserkennung.

Die Gesichtsmerkmalserkennungstechnologie im Cockpit umfasst im Allgemeinen die folgenden drei Aspekte: Gesichtsmerkmalsinspektion und Mustererkennung. Da die gesamten Informationen im Internet biogen werden, werden Gesichtsinformationen auf mehreren Plattformen eingegeben, und Autos stehen im Mittelpunkt des Internet of Everything. Da sich immer mehr Szenarien für die Nutzung mobiler Endgeräte auf das Auto verlagern, müssen Kontoregistrierung und Identitätsauthentifizierung durchgeführt werden das Auto.

(2) Anwendungsszenarien für die Gesichtserkennung.

Bevor Sie losfahren, müssen Sie in das Auto einsteigen, um die Informationen zum Autobesitzer zu überprüfen und die Antrags-ID zu registrieren. Die Gesichtserkennung ist das Hauptarbeitsszenario für Ermüdung beim Gehen mit geschlossenen Augen, Telefonerinnerung, fehlendem Sehvermögen und Gähnen.

Einfache Interaktion kann es für den Fahrer unbequemer machen. Beispielsweise ist die alleinige Verwendung der Sprache anfällig für Fehlleitungen und einfache Touch-Bedienungen, und der Fahrer kann das 3-Sekunden-Prinzip nicht einhalten. Nur wenn mehrere Interaktionsmethoden wie Stimme, Gesten und Vision integriert werden, kann das intelligente System in verschiedenen Szenarien präziser, bequemer und sicherer mit dem Fahrer kommunizieren. „Herausforderungen und Zukunft der Mensch-Computer-Interaktion“ Aber egal wie reich das Leben ist, wir müssen immer von den Fakten ausgehen. Es gibt derzeit noch viele Herausforderungen.

Derzeit ist die Fehlerkennung natürlicher Wechselwirkungen immer noch sehr schwerwiegend und Zuverlässigkeit und Genauigkeit unter allen Arbeitsbedingungen und bei jedem Wetter reichen bei weitem nicht aus. Daher ist bei der Gestenerkennung die auf dem Sehen basierende Gestenerkennungsrate immer noch sehr niedrig, sodass verschiedene Algorithmen entwickelt werden müssen, um die Genauigkeit und Geschwindigkeit der Erkennung zu verbessern. Unbeabsichtigte Gesten können mit Befehlshandlungen verwechselt werden, aber tatsächlich ist dies nur eines von unzähligen Missverständnissen. Bei Bewegung sind Projektion, Vibration und Verdeckung von Licht allesamt große technische Probleme. Daher werden je nach Betriebsszenario Multisensor-Fusionsüberprüfungsmethoden, Schallbestätigungen und andere Methoden eingesetzt. Um die Falscherkennungsrate zu reduzieren, müssen verschiedene technische Mittel umfassend unterstützt werden. Zweitens ist das aktuelle Problem der Glätte der natürlichen Interaktion immer noch eine Schwierigkeit, die überwunden werden muss und fortschrittlichere Sensoren, leistungsfähigere Fähigkeiten und effizientere Berechnungen erfordert. Gleichzeitig stecken die Fähigkeiten zur Verarbeitung natürlicher Sprache und zum Ausdruck von Absichten noch in den Kinderschuhen und erfordern eine eingehende Erforschung der algorithmischen Technologie.

In Zukunft wird sich die Mensch-Computer-Interaktion im Cockpit in Richtung der virtuellen Welt und der emotionalen Verbindung verlagern

Einer der Gründe, warum Verbraucher bereit sind, für zusätzliche intelligente Funktionen über die Mobilität im Auto hinaus zu zahlen, sind Gespräche und Erlebnisse. Wir haben oben erwähnt, dass die Entwicklung intelligenter Cockpits in Zukunft auf den Menschen ausgerichtet sein wird und sich zum dritten Raum im Leben der Menschen entwickeln wird.

Bei dieser Art der Mensch-Computer-Interaktion handelt es sich keineswegs um eine einfache Anrufbeantwortung, sondern um ein Kommunikationserlebnis auf mehreren Kanälen, auf mehreren Ebenen und in mehreren Modi. Aus der Sicht der Insassen wird das zukünftige intelligente Mensch-Computer-Interaktionssystem im Cockpit intelligente Sprache als Hauptkommunikationsmittel und Berührungen, Gesten, Dynamik, Ausdrücke usw. als Hilfskommunikationsmittel verwenden, wodurch die Hände und Augen der Insassen frei werden Insassen, um das Risiko einer Manipulation durch den Fahrer zu verringern.

Mit der Zunahme von Sensoren im Cockpit ist es ein eindeutiger Trend, das Dienstleistungsobjekt der Mensch-Computer-Interaktion vom fahrerzentrierten hin zum kompletten Fahrzeug-Passagierservice zu verlagern. Das intelligente Cockpit schafft einen virtuellen Raum und die natürliche Interaktion zwischen Menschen wird ein neues, immersives Extended-Reality-Unterhaltungserlebnis ermöglichen. Die leistungsstarke Konfiguration kann in Kombination mit der leistungsstarken interaktiven Ausrüstung im Cockpit ein Metaversum im Auto aufbauen und verschiedene immersive Spiele ermöglichen. Intelligente Cockpits können ein guter Träger für ursprünglichen Raum sein.

Die natürliche Interaktion zwischen Mensch und Maschine bringt auch eine emotionale Verbindung mit sich. Das Cockpit wird zum Begleiter einer Person, zu einem intelligenteren Begleiter, indem es das Verhalten, die Gewohnheiten und Vorlieben des Autobesitzers lernt, die Umgebung im Cockpit wahrnimmt und kombiniert mit dem aktuellen Standort des Fahrzeugs und stellt bei Bedarf proaktiv Informationen und Funktionstipps bereit. Mit der Entwicklung der künstlichen Intelligenz haben wir im Laufe unseres Lebens die Möglichkeit, menschliche emotionale Verbindungen allmählich in unser Privatleben einzubeziehen. Sicherzustellen, dass die Technologie gut ist, könnte ein weiteres großes Problem sein, dem wir uns in dieser Zeit stellen müssen. Aber egal was passiert, die Technologie wird sich in diese Richtung entwickeln.

Zusammenfassung der Mensch-Computer-Interaktion im intelligenten Cockpit

Im aktuellen harten Wettbewerb in der Automobilindustrie ist das Cockpitsystem mit künstlicher Intelligenz zu einem Schlüsselthema bei der Verwirklichung der funktionalen Differenzierung der gesamten Maschinenfabrik geworden, denn Das Mensch-Computer-Interaktionssystem im Cockpit ist eng mit dem Kommunikationsverhalten, der Sprache, der Kultur usw. der Menschen verbunden und muss daher stark lokalisiert werden. Intelligente Fahrzeug-Mensch-Computer-Interaktion ist ein wichtiger Durchbruch für die Markenaufwertung chinesischer Hersteller intelligenter Fahrzeuge und ein Durchbruch für Chinas intelligente Fahrzeugtechnologie, um die technologischen Entwicklungstrends der Welt zu leiten.

Die Integration dieser Interaktionen wird in Zukunft ein umfassenderes immersives Erlebnis bieten und die Reife neuer Interaktionsmethoden und -technologien weiter fördern. Es wird erwartet, dass sich die aktuelle erlebnissteigernde Funktion zu einer unverzichtbaren Funktion entwickelt für zukünftige smarte Cockpits. Künftig soll die intelligente Cockpit-Interaktionstechnologie eine Vielzahl von Reisebedürfnissen abdecken, seien es grundlegende Sicherheitsbedürfnisse oder tiefere psychologische Bedürfnisse nach Zugehörigkeitsgefühl und Selbstverwirklichung.

Das obige ist der detaillierte Inhalt vonEine kurze Analyse der Entwicklung der Mensch-Computer-Interaktion in intelligenten Cockpits. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1375

1375

52

52

Smart App Control unter Windows 11: So aktivieren oder deaktivieren Sie es

Jun 06, 2023 pm 11:10 PM

Smart App Control unter Windows 11: So aktivieren oder deaktivieren Sie es

Jun 06, 2023 pm 11:10 PM

Intelligent App Control ist ein sehr nützliches Tool in Windows 11, das dabei hilft, Ihren PC vor nicht autorisierten Apps zu schützen, die Ihre Daten beschädigen können, wie z. B. Ransomware oder Spyware. In diesem Artikel wird erklärt, was Smart App Control ist, wie es funktioniert und wie man es in Windows 11 ein- oder ausschaltet. Was ist Smart App Control in Windows 11? Smart App Control (SAC) ist eine neue Sicherheitsfunktion, die mit dem Windows 1122H2-Update eingeführt wurde. Es arbeitet mit Microsoft Defender oder Antivirensoftware von Drittanbietern zusammen, um potenziell unnötige Apps zu blockieren, die Ihr Gerät verlangsamen, unerwartete Werbung anzeigen oder andere unerwartete Aktionen ausführen können. Intelligente Anwendung

Die herumfliegenden Gesichtszüge, das Öffnen des Mundes, das Starren und das Hochziehen der Augenbrauen können von der KI perfekt nachgeahmt werden, sodass Videobetrug nicht verhindert werden kann

Dec 14, 2023 pm 11:30 PM

Die herumfliegenden Gesichtszüge, das Öffnen des Mundes, das Starren und das Hochziehen der Augenbrauen können von der KI perfekt nachgeahmt werden, sodass Videobetrug nicht verhindert werden kann

Dec 14, 2023 pm 11:30 PM

Mit solch einer mächtigen KI-Imitationsfähigkeit ist es wirklich unmöglich, dies zu verhindern. Hat die Entwicklung der KI mittlerweile dieses Niveau erreicht? Ihr vorderer Fuß lässt Ihre Gesichtszüge fliegen, und auf Ihrem hinteren Fuß wird genau der gleiche Ausdruck reproduziert. Starren, Augenbrauen hochziehen, schmollen, egal wie übertrieben der Ausdruck ist, alles wird perfekt nachgeahmt. Erhöhen Sie den Schwierigkeitsgrad, heben Sie die Augenbrauen höher, öffnen Sie die Augen weiter, und sogar die Mundform ist schief und der Ausdruck des Avatars kann perfekt reproduziert werden. Wenn Sie die Parameter auf der linken Seite anpassen, ändert der virtuelle Avatar auf der rechten Seite auch seine Bewegungen entsprechend, um eine Nahaufnahme von Mund und Augen zu erhalten. Man kann nicht sagen, dass die Nachahmung genau gleich ist, aber der Ausdruck ist genau derselbe gleich (ganz rechts). Die Forschung stammt von Institutionen wie der Technischen Universität München, die GaussianAvatars vorschlägt

MotionLM: Sprachmodellierungstechnologie für die Bewegungsvorhersage mit mehreren Agenten

Oct 13, 2023 pm 12:09 PM

MotionLM: Sprachmodellierungstechnologie für die Bewegungsvorhersage mit mehreren Agenten

Oct 13, 2023 pm 12:09 PM

Dieser Artikel wird mit Genehmigung des öffentlichen Kontos von Autonomous Driving Heart nachgedruckt. Bitte wenden Sie sich für den Nachdruck an die Quelle. Originaltitel: MotionLM: Multi-Agent Motion Forecasting as Language Modeling Papierlink: https://arxiv.org/pdf/2309.16534.pdf Autorenzugehörigkeit: Waymo Konferenz: ICCV2023 Papieridee: Für die Sicherheitsplanung autonomer Fahrzeuge das zukünftige Verhalten zuverlässig vorhersagen der Straßenverkehrsbeamten ist von entscheidender Bedeutung. Diese Studie stellt kontinuierliche Trajektorien als Sequenzen diskreter Bewegungstokens dar und behandelt die Bewegungsvorhersage mit mehreren Agenten als eine Sprachmodellierungsaufgabe. Das von uns vorgeschlagene Modell MotionLM hat die folgenden Vorteile: Erstens

Der intelligente universelle humanoide Roboter GR-1 Fourier steht kurz vor dem Vorverkaufsstart!

Sep 27, 2023 pm 08:41 PM

Der intelligente universelle humanoide Roboter GR-1 Fourier steht kurz vor dem Vorverkaufsstart!

Sep 27, 2023 pm 08:41 PM

Der humanoide Roboter, der 1,65 Meter groß ist, 55 Kilogramm wiegt und über 44 Freiheitsgrade in seinem Körper verfügt, kann schnell gehen, Hindernissen schnell ausweichen, Steigungen stetig hinauf und hinunter klettern und Stößen und Störungen standhalten. Jetzt können Sie ihn mit nach Hause nehmen ! Der universelle humanoide Roboter GR-1 von Fourier Intelligence hat mit dem Vorverkauf begonnen. Der universelle humanoide Roboter Fourier GR-1 ist jetzt zum Vorverkauf geöffnet. GR-1 verfügt über eine hochgradig bionische Rumpfkonfiguration und anthropomorphe Bewegungssteuerung. Er verfügt über 44 Freiheitsgrade im gesamten Körper. Er verfügt über die Fähigkeit zu gehen, Hindernissen auszuweichen, über Hindernisse zu klettern, Abhänge zu überwinden, Störungen zu widerstehen und sich anzupassen Es handelt sich um ein allgemeines künstliches Intelligenzsystem. Offizielle Vorverkaufsseite der Website: www.fftai.cn/order#FourierGR-1# Fourier Intelligence muss neu geschrieben werden.

Wussten Sie, dass es bei Programmierern in ein paar Jahren einen Niedergang geben wird?

Nov 08, 2023 am 11:17 AM

Wussten Sie, dass es bei Programmierern in ein paar Jahren einen Niedergang geben wird?

Nov 08, 2023 am 11:17 AM

Die Zeitschrift „ComputerWorld“ schrieb einmal in einem Artikel, dass „die Programmierung bis 1960 verschwinden wird“, weil IBM eine neue Sprache FORTRAN entwickelt hat, die es Ingenieuren ermöglicht, die benötigten mathematischen Formeln zu schreiben und sie dann dem Computer zu übermitteln, damit das Programmieren endet. Ein paar Jahre später hörten wir ein neues Sprichwort: Jeder Unternehmer kann Geschäftsbegriffe verwenden, um seine Probleme zu beschreiben und dem Computer zu sagen, was er tun soll. Mit dieser Programmiersprache namens COBOL brauchen Unternehmen keine Programmierer mehr. Später soll IBM eine neue Programmiersprache namens RPG entwickelt haben, mit der Mitarbeiter Formulare ausfüllen und Berichte erstellen können, sodass die meisten Programmieranforderungen des Unternehmens damit erfüllt werden können.

Ein Artikel über die Anwendung der SLAM-Technologie beim autonomen Fahren

Apr 09, 2023 pm 01:11 PM

Ein Artikel über die Anwendung der SLAM-Technologie beim autonomen Fahren

Apr 09, 2023 pm 01:11 PM

Die Positionierung nimmt beim autonomen Fahren eine unersetzliche Stellung ein und es gibt vielversprechende Entwicklungen für die Zukunft. Derzeit basiert die Positionierung beim autonomen Fahren auf RTK und hochpräzisen Karten, was die Implementierung des autonomen Fahrens mit hohen Kosten und Schwierigkeiten verbunden macht. Stellen Sie sich vor, dass Menschen beim Fahren ihre eigene globale hochpräzise Positionierung und die detaillierte Umgebung nicht kennen müssen. Es reicht aus, einen globalen Navigationspfad zu haben und die Position des Fahrzeugs auf dem Pfad anzupassen SLAM-Schlüsseltechnologien. Was ist SLAMSLAM (Simultaneous Localization and Mapping), auch bekannt als CML (Concurrent Mapping and Localiza).

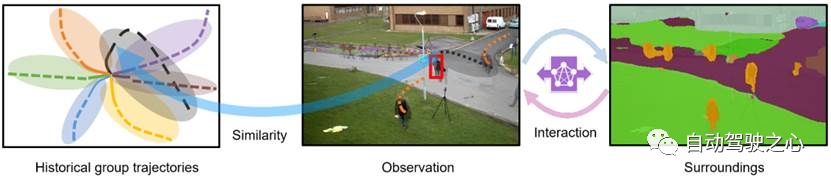

Was sind die effektiven Methoden und gängigen Basismethoden für die Vorhersage der Fußgängerbahn? Teilen der besten Konferenzbeiträge!

Oct 17, 2023 am 11:13 AM

Was sind die effektiven Methoden und gängigen Basismethoden für die Vorhersage der Fußgängerbahn? Teilen der besten Konferenzbeiträge!

Oct 17, 2023 am 11:13 AM

Die Flugbahnvorhersage stand in den letzten zwei Jahren im Rampenlicht, aber das meiste davon konzentriert sich auf die Richtung der Fahrzeugflugbahnvorhersage. Heute wird Autonomous Driving Heart den Algorithmus für die Flugbahnvorhersage von Fußgängern auf NeurIPS – SHENet teilen. Menschliche Bewegungsmuster unterliegen in der Regel bis zu einem gewissen Grad begrenzten Regeln. Basierend auf dieser Annahme sagt SHENet die zukünftige Flugbahn einer Person voraus, indem es implizite Szenenregeln lernt. Der Artikel wurde von Autonomous Driving Heart als Original zertifiziert! Nach persönlichem Verständnis des Autors ist die Vorhersage der zukünftigen Flugbahn einer Person aufgrund der Zufälligkeit und Subjektivität menschlicher Bewegungen derzeit immer noch ein herausforderndes Problem. Allerdings variieren menschliche Bewegungsmuster in eingeschränkten Szenen häufig aufgrund von Szenenbeschränkungen (z. B. Grundrissen, Straßen und Hindernissen) und der Interaktivität von Mensch zu Mensch oder Mensch zu Objekt.

Huawei wird das Xuanji-Sensorsystem im Bereich Smart Wearables auf den Markt bringen, das den emotionalen Zustand des Benutzers anhand der Herzfrequenz beurteilen kann

Aug 29, 2024 pm 03:30 PM

Huawei wird das Xuanji-Sensorsystem im Bereich Smart Wearables auf den Markt bringen, das den emotionalen Zustand des Benutzers anhand der Herzfrequenz beurteilen kann

Aug 29, 2024 pm 03:30 PM

Kürzlich gab Huawei bekannt, dass es im September ein neues intelligentes tragbares Produkt mit dem Xuanji-Sensorsystem auf den Markt bringen wird, bei dem es sich voraussichtlich um die neueste Smartwatch von Huawei handeln wird. Dieses neue Produkt wird fortschrittliche Funktionen zur Überwachung der emotionalen Gesundheit integrieren. Das Xuanji Perception System bietet Benutzern eine umfassende Gesundheitsbewertung mit seinen sechs Merkmalen – Genauigkeit, Vollständigkeit, Geschwindigkeit, Flexibilität, Offenheit und Skalierbarkeit. Das System nutzt ein Super-Sensing-Modul und optimiert die Mehrkanal-Optikpfad-Architekturtechnologie, wodurch die Überwachungsgenauigkeit grundlegender Indikatoren wie Herzfrequenz, Blutsauerstoff und Atemfrequenz erheblich verbessert wird. Darüber hinaus hat das Xuanji Sensing System auch die Erforschung emotionaler Zustände auf Basis von Herzfrequenzdaten erweitert. Es beschränkt sich nicht nur auf physiologische Indikatoren, sondern kann auch den emotionalen Zustand und das Stressniveau des Benutzers bewerten. Es unterstützt die Überwachung von mehr als 60 Sportarten Gesundheitsindikatoren, die kardiovaskuläre, respiratorische, neurologische, endokrine,