Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Die beiden Auszubildenden von Li Feifei leiten gemeinsam: Ein Roboter, der „multimodale Eingabeaufforderungen' verstehen kann, kann die Nullschussleistung um das 2,9-fache verbessern

Die beiden Auszubildenden von Li Feifei leiten gemeinsam: Ein Roboter, der „multimodale Eingabeaufforderungen' verstehen kann, kann die Nullschussleistung um das 2,9-fache verbessern

Die beiden Auszubildenden von Li Feifei leiten gemeinsam: Ein Roboter, der „multimodale Eingabeaufforderungen' verstehen kann, kann die Nullschussleistung um das 2,9-fache verbessern

Die nächste Entwicklungschance im Bereich der künstlichen Intelligenz könnte darin bestehen, das KI-Modell mit einem „Körper“ auszustatten und mit der realen Welt zu interagieren, um zu lernen.

Verglichen mit vorhandener natürlicher Sprachverarbeitung, Computer Vision und anderen Aufgaben, die in bestimmten Umgebungen ausgeführt werden, Offenfeldroboter-Technologie #🎜🎜 # ist offensichtlich schwieriger.

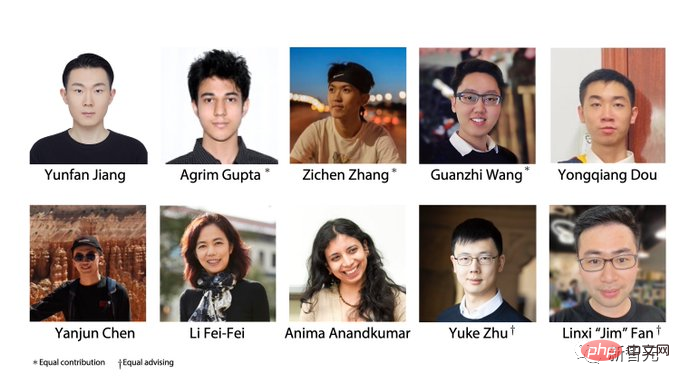

Promptbasiertes Lernen kann es beispielsweise ermöglichen, dass ein einzelnes Sprachmodell beliebige Verarbeitungsaufgaben in natürlicher Sprache ausführt, z B. beim Schreiben von Code. Um Zusammenfassungen und Fragen und Antworten zu erstellen, müssen Sie nur die Eingabeaufforderung ändern.

Aber Es gibt noch mehr Arten von Aufgabenspezifikationen in der Robotik , wie zum Beispiel die Nachahmung einer einzelnen Beispieldemonstration, das Befolgen mündlicher Anweisungen oder das Erreichen einer bestimmte visuelle Ziel, diese werden in der Regel als unterschiedliche Aufgaben angesehen, die von speziell ausgebildeten Modellen erledigt werden.

Forscher von NVIDIA, der Stanford University, dem Macalester College, Caltech, der Tsinghua University und der University of Texas in Austin haben gemeinsam ein VIMA vorgeschlagen, Ein universeller Roboteragent, der auf Transformer basiert, nutzt multimodale Eingabeaufforderung, um eine extrem hohe Generalisierungsleistung zu erreichen und kann eine große Anzahl von Roboteroperationsaufgaben bewältigen.

Papierlink: https://arxiv.org/abs/2210.03094

Projektlink: https://vimalabs.github.io/

# 🎜🎜#Code-Link: https://github.com/vimalabs/VIMA

Eingabeaufforderung fürgestaffelte Verwendung Der Text und die visuellen Symbole von .

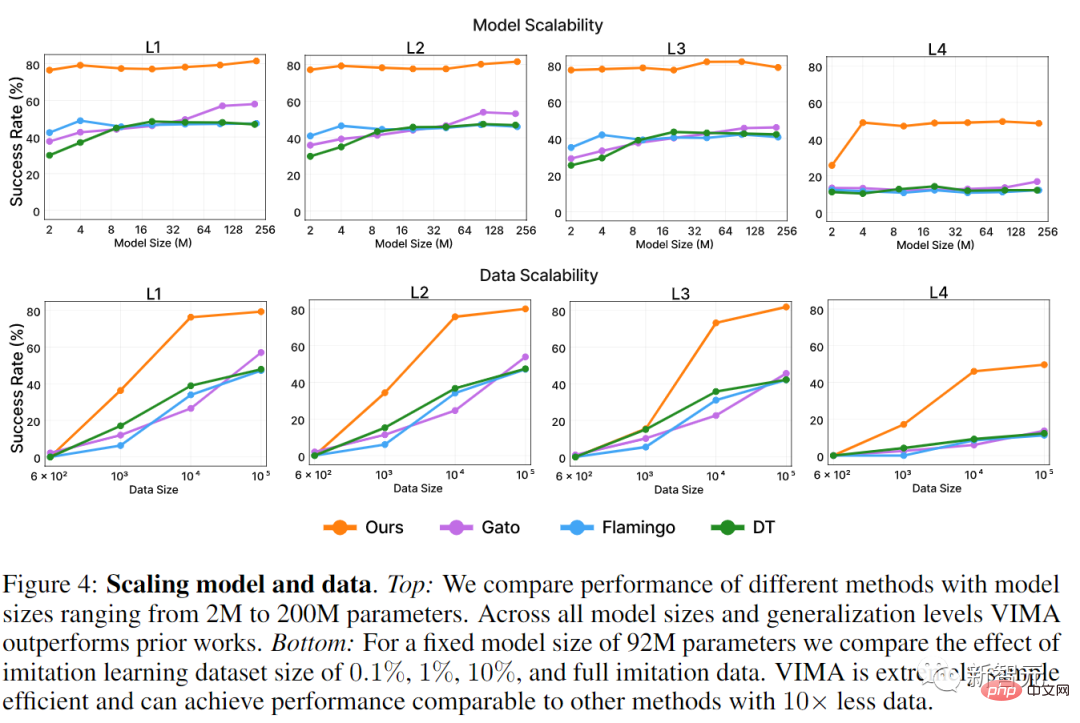

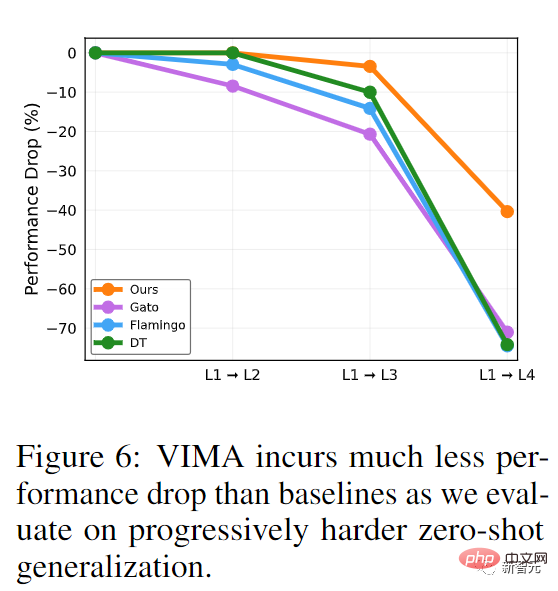

Um VIMA zu trainieren und zu bewerten, schlugen die Forscher einenneuen Simulations-Benchmark-Datensatz vor, der Tausende von programmgesteuert generierten Desktop-Aufgaben mit multimodalen Eingabeaufforderungen enthält und mehr als 600.000 Expertentrajektorien werden für Nachahmungslernen verwendet, um die Generalisierungsleistung des Modells in vier Ebenen zu bewerten. Unter der Bedingung eines Modells gleicher Größe und derselben Menge an Trainingsdaten werden VIMA-Aufgaben unter der schwierigsten Null-Schuss-Generalisierungseinstellung durchgeführt

Erfolgsquote Es ist das 2,9-facheder aktuellen Sota-Methode. Mit 10-mal weniger Trainingsdaten ist VIMA immer noch 2,7-mal besser als andere Methoden.

Derzeit sind alle Codes, vorab trainierten Modelle, Datensätze und Simulationsbenchmarks

vollständig Open Source. Der Erstautor des Artikels ist

Yunfan Jiang, ein Masterstudent im zweiten Jahr an der Stanford University, der derzeit Praktikant bei NVIDIA ist Forschungsinstitut. Abschluss an der University of Edinburgh im Jahr 2020. Sein Forschungsschwerpunkt ist verkörperte künstliche Intelligenz (verkörperte KI), die durch Interaktion mit der Umwelt lernt. Der spezifische Forschungsinhalt ist die Verwendung groß angelegter Basismodelle zur Implementierung offener verkörperter Agenten 🎜🎜#Der Artikel enthält zwei Tutoren, die beide ehemalige Schüler von Li Feifei waren.

Zhu Yuke

Zhu Yuke

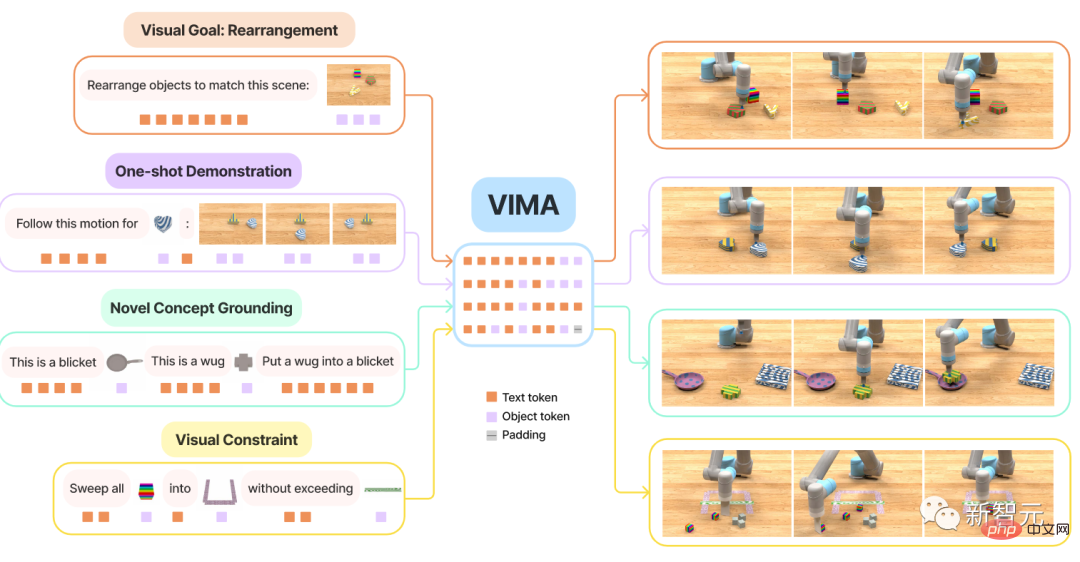

Fan Linxi, hat an der Stanford University promoviert, bei Li Feifei studiert und ist derzeit wissenschaftlicher Mitarbeiter bei NVIDIA AI. Die Hauptforschungsrichtung ist die Entwicklung allgemein fähiger autonomer Agenten. Spezifische Forschungsarbeiten umfassen grundlegende Modelle, politisches Lernen, Robotik, multimodales Lernen und Großsysteme. Transformer hat im Bereich NLP eine sehr hohe Leistung beim Multitasking erzielt. Nur ein Modell kann gleichzeitig Fragen und Antworten, maschinelle Übersetzung, Textzusammenfassung usw. durchführen. Die Schnittstelle zur Umsetzung verschiedener Aufgaben liegt in den Eingabetext-Prompts, wodurch spezifische Aufgabenanforderungen an das allgemeine Großmodell übergeben werden. Kann diese Eingabeaufforderungsschnittstelle auf einem allgemeinen Roboteragenten verwendet werden? Für einen Hausarbeitsroboter müssen Sie im Idealfall nur Bring es zu mir eintreten und der Roboter kann den Becher gemäß dem Bild holen. Wenn der Roboter neue Fähigkeiten erlernen muss, ist es am besten, diese durch die Eingabe von Videodemonstrationen zu erlernen. Wenn der Roboter mit unbekannten Objekten interagieren muss, kann dies einfach anhand einer Illustration erklärt werden. Um eine sichere Bereitstellung zu gewährleisten, können Benutzer gleichzeitig visuelle Einschränkungen festlegen, z Enthält hauptsächlich drei Teile: 1, Formale multimodale Eingabeaufforderung, die die Robotermanipulationsaufgabe in ein Sequenzmodellierungsproblem umwandelt; 3. Ein neues Roboter-Agentenmodell mit verschiedenen der Aufgabe zur systematischen Bewertung der Skalierbarkeit und Allgemeingültigkeit von Agenten Erstens ermöglicht die Flexibilität, die multimodale Eingabeaufforderungen bieten, Entwicklern die Spezifizierung und Erstellung eines einzelnen Modell zur Unterstützung einer großen Anzahl von Aufgabenspezifikationen. In diesem Artikel werden hauptsächlich sechs Arten von Aufgaben berücksichtigt: 1, Einfache Objektmanipulation (Einfache Objektmanipulation) , die Aufgabenaufforderung erfolgt in Form von in 4; Einzelbeispiel-One-Shot-Videoimitation 6. Visuelles Denken (Visuelles Denken) in einen Container legen“ oder visuelles Denken erfordern Erinnerung, wie zum Beispiel „Legen Sie in den Behälter und stellen Sie ihn dann wieder an seinen Platz“ Es ist zu beachten, dass sich diese sechs Arten von Aufgaben nicht gegenseitig ausschließen, zum Beispiel einige Aufgaben Ein Verb (Romankonzept ), die noch nie zuvor gesehen wurde, kann durch das Demonstrationsvideo (Nachahmung) vorgestellt werden. Neuer Benchmark VIM-BENCH Es ist für eine kluge Frau schwierig, ohne Reis zu kochen, um das Modell zu trainieren einige unterstützende Daten als Multimodaler Roboter-Lern-Benchmark VIMA-BENCH vorbereitet. In der Simulationsumgebung zielen bestehende Benchmarks im Allgemeinen auf bestimmte Aufgabenspezifikationen ab. Derzeit gibt es keinen Benchmark, der eine umfangreiche multimodale Aufgabensuite und eine umfassende Testplattform zur gezielten Erkennung von Agentenfunktionen bereitstellen kann. Zu diesem Zweck bauten die Forscher VIMA-BENCH, indem sie den Ravens-Robotersimulator erweiterten, um eine erweiterbare Sammlung von Objekten und Texturen zu unterstützen, um multimodale Hinweise zu erstellen und eine große Anzahl von Aufgaben prozedural zu generieren. Konkret stellt VIMA-BENCH 17 Metaaufgaben mit multimodalen Eingabeaufforderungsvorlagen bereit, die in 1000 unabhängige Aufgaben instanziiert werden können. Jede Metaaufgabe gehört zu einer oder mehreren der oben genannten sechs Aufgabenspezifikationsmethoden. VIMA-BENCH kann durch geskriptete Oracle-Agenten eine große Menge an Nachahmungslerndaten generieren. Unter Beobachtung und Aktionen umfasst der Beobachtungsraum des Simulators RGB-Bilder, die aus Vorder- und Draufsichten gerendert wurden, und der Benchmark bietet außerdem realistische Objektsegmentierung und Begrenzungsrahmen für objektzentrierte Train-Modelle. VIM-BENCH erbt den erweiterten Aktionsraum aus früheren Arbeiten, der aus den grundlegendsten Bewegungsfertigkeiten wie „Pick and Place“, „Wischen“ usw. besteht, die durch die Haltung des Endeffekts bestimmt werden . Der Simulator verfügt außerdem über ein Skript-Orakelprogramm, das Expertendemonstrationen generieren kann, indem es privilegierte Simulatorzustandsinformationen verwendet, wie z. B. die genaue Position aller Objekte und die zugrunde liegende Interpretation multimodaler Anweisungen. Schließlich generierten die Forscher einen großen Offline-Datensatz von Expertenverläufen für Nachahmungslernen durch vorprogrammierte Orakel. Der Datensatz umfasst 50.000 Trajektorien für jede Metaaufgabe, also insgesamt 650.000 erfolgreiche Trajektorien. Behalten Sie außerdem eine Teilmenge von Objektmodellen und Texturen zur einfachen Auswertung bei und verwenden Sie 4 der 17 Metaaufgaben für Zero-Shot-Generalisierungstests. VIMA-BENCHs Standard für jede Aufgabe hat nur Erfolg und Misserfolg, und es gibt kein Belohnungssignal für Zwischenzustände. Zur Testzeit führten die Forscher die Agentenstrategie in einem Physiksimulator aus, um die Erfolgsquote zu berechnen, und die durchschnittliche Erfolgsquote über alle bewerteten Metaaufgaben hinweg war die endgültige gemeldete Metrik. Das Bewertungsprotokoll enthält vier Ebenen, um systematisch die Generalisierungsfähigkeit des Agenten zu prüfen. Jede Ebene weicht stärker von der Trainingsverteilung ab, sodass streng genommen eine Ebene schwieriger ist als die nächste. 1. Platzierungsverallgemeinerung: Während des Trainings sind alle Eingabeaufforderungen wörtlich, aber während des Tests ist die Platzierung von Objekten auf dem Desktop zufällig. 2, Kombinatorische Verallgemeinerung: Alle Materialien (Adjektive) und dreidimensionale Objekte (Substantive) können im Training gesehen werden, aber einige neue Kombinationsformen werden im Test auftauchen. 3. Neuartige Objektverallgemeinerung: Testaufforderungen und simulierte Arbeitsbereiche enthalten neue Adjektive und Objekte. 4, Neuartige Aufgabenverallgemeinerung: Eine neue Metaaufgabe mit einer neuen Eingabeaufforderungsvorlage während des Tests In der multimodalen Eingabeaufforderung sind insgesamt drei Formate enthalten: 1, Text, verwenden Sie das vorab trainierte T5-Modell, um Wörter zu segmentieren und Wortvektoren zu erhalten 2, Die gesamte Desktop-Szene, verwenden Sie zunächst Mask R-CNN, um alle unabhängigen Objekte zu identifizieren dargestellt durch einen Begrenzungsrahmen und ein zugeschnittenes Bild und dann mit einem Begrenzungsbo-Encoder bzw. ViT codiert. 3, Bild eines einzelnen Objekts, verwenden Sie auch ViT, um Token zu erhalten, und geben Sie dann die Ergebnissequenz in das vorab trainierte T5-Encodermodell ein. Robotersteuerung, das heißt, die Eingabe des Decoders ist die Darstellungs- und Trajektorienverlaufssequenz nach mehreren Queraufmerksamkeitsebenen in der Eingabeaufforderungssequenz. Ein solches Design kann die Verbindung zu Eingabeaufforderungen verbessern; die ursprünglichen Eingabeaufforderungs-Tokens besser behalten und verarbeiten und die Recheneffizienz steigern. Das experimentelle Design in der Testphase dient hauptsächlich der Beantwortung von drei Fragen: 1, Vergleich der Leistung von VIMA und früheren SOTA Transformer-basierten Agenten bei verschiedenen Aufgaben mit multimodalen Eingabeaufforderungen ; 2, VIMAs Skalierungseigenschaften in Bezug auf Modellkapazität und Datenvolumen; 3, Ob unterschiedliche visuelle Wortsegmentierer, bedingte Hinweise und bedingte Kodierung die endgültige Entscheidungsfindung beeinflussen. Die im Vergleich zu Basismodellen umfassen gato, flamingo und decision Transformator (DT). Wird für das Training verwendet und die Größe des Encoders wird immer beibehalten, da VIMA auf T5-Basis definitiv besser ist als andere Werke bei der Zero-Shot-Generalisierungsbewertung auf allen Ebenen. Obwohl Gato und Flamingo bei größeren Modellen eine verbesserte Leistung aufweisen, ist VIMA immer noch besser als alle Modelle. Bei der Datenskalierung Im Leistungsvergleich Progressive Generalisierung Referenz: https://arxiv.org/abs/2210.03094Roboter und multimodale Eingabeaufforderungen

VIMA-Modell

Das obige ist der detaillierte Inhalt vonDie beiden Auszubildenden von Li Feifei leiten gemeinsam: Ein Roboter, der „multimodale Eingabeaufforderungen' verstehen kann, kann die Nullschussleistung um das 2,9-fache verbessern. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1386

1386

52

52

Die herumfliegenden Gesichtszüge, das Öffnen des Mundes, das Starren und das Hochziehen der Augenbrauen können von der KI perfekt nachgeahmt werden, sodass Videobetrug nicht verhindert werden kann

Dec 14, 2023 pm 11:30 PM

Die herumfliegenden Gesichtszüge, das Öffnen des Mundes, das Starren und das Hochziehen der Augenbrauen können von der KI perfekt nachgeahmt werden, sodass Videobetrug nicht verhindert werden kann

Dec 14, 2023 pm 11:30 PM

Mit solch einer mächtigen KI-Imitationsfähigkeit ist es wirklich unmöglich, dies zu verhindern. Hat die Entwicklung der KI mittlerweile dieses Niveau erreicht? Ihr vorderer Fuß lässt Ihre Gesichtszüge fliegen, und auf Ihrem hinteren Fuß wird genau der gleiche Ausdruck reproduziert. Starren, Augenbrauen hochziehen, schmollen, egal wie übertrieben der Ausdruck ist, alles wird perfekt nachgeahmt. Erhöhen Sie den Schwierigkeitsgrad, heben Sie die Augenbrauen höher, öffnen Sie die Augen weiter, und sogar die Mundform ist schief und der Ausdruck des Avatars kann perfekt reproduziert werden. Wenn Sie die Parameter auf der linken Seite anpassen, ändert der virtuelle Avatar auf der rechten Seite auch seine Bewegungen entsprechend, um eine Nahaufnahme von Mund und Augen zu erhalten. Man kann nicht sagen, dass die Nachahmung genau gleich ist, aber der Ausdruck ist genau derselbe gleich (ganz rechts). Die Forschung stammt von Institutionen wie der Technischen Universität München, die GaussianAvatars vorschlägt

Der Ameca der zweiten Generation ist da! Er kann fließend mit dem Publikum kommunizieren, sein Gesichtsausdruck ist realistischer und er kann Dutzende Sprachen sprechen.

Mar 04, 2024 am 09:10 AM

Der Ameca der zweiten Generation ist da! Er kann fließend mit dem Publikum kommunizieren, sein Gesichtsausdruck ist realistischer und er kann Dutzende Sprachen sprechen.

Mar 04, 2024 am 09:10 AM

Der humanoide Roboter Ameca wurde auf die zweite Generation aufgerüstet! Kürzlich erschien auf der World Mobile Communications Conference MWC2024 erneut der weltweit fortschrittlichste Roboter Ameca. Rund um den Veranstaltungsort lockte Ameca zahlreiche Zuschauer an. Mit dem Segen von GPT-4 kann Ameca in Echtzeit auf verschiedene Probleme reagieren. „Lass uns tanzen.“ Auf die Frage, ob sie Gefühle habe, antwortete Ameca mit einer Reihe von Gesichtsausdrücken, die sehr lebensecht aussahen. Erst vor wenigen Tagen stellte EngineeredArts, das britische Robotikunternehmen hinter Ameca, die neuesten Entwicklungsergebnisse des Teams vor. Im Video verfügt der Roboter Ameca über visuelle Fähigkeiten und kann den gesamten Raum und bestimmte Objekte sehen und beschreiben. Das Erstaunlichste ist, dass sie es auch kann

Wie kann KI Roboter autonomer und anpassungsfähiger machen?

Jun 03, 2024 pm 07:18 PM

Wie kann KI Roboter autonomer und anpassungsfähiger machen?

Jun 03, 2024 pm 07:18 PM

Im Bereich der industriellen Automatisierungstechnik gibt es zwei aktuelle Hotspots, die kaum zu ignorieren sind: Künstliche Intelligenz (KI) und Nvidia. Ändern Sie nicht die Bedeutung des ursprünglichen Inhalts, optimieren Sie den Inhalt, schreiben Sie den Inhalt neu, fahren Sie nicht fort: „Darüber hinaus sind beide eng miteinander verbunden, da Nvidia nicht auf seine ursprüngliche Grafikverarbeitungseinheit (GPU) beschränkt ist ) erweitert es seine GPU. Die Technologie erstreckt sich auf den Bereich der digitalen Zwillinge und ist eng mit neuen KI-Technologien verbunden. „Vor kurzem hat NVIDIA eine Zusammenarbeit mit vielen Industrieunternehmen geschlossen, darunter führende Industrieautomatisierungsunternehmen wie Aveva, Rockwell Automation und Siemens und Schneider Electric sowie Teradyne Robotics und seine Unternehmen MiR und Universal Robots. Kürzlich hat Nvidia gesammelt

Nach 2 Monaten kann der humanoide Roboter Walker S Kleidung falten

Apr 03, 2024 am 08:01 AM

Nach 2 Monaten kann der humanoide Roboter Walker S Kleidung falten

Apr 03, 2024 am 08:01 AM

Herausgeber des Machine Power Report: Wu Xin Die heimische Version des humanoiden Roboters + eines großen Modellteams hat zum ersten Mal die Betriebsaufgabe komplexer flexibler Materialien wie das Falten von Kleidung abgeschlossen. Mit der Enthüllung von Figure01, das das multimodale große Modell von OpenAI integriert, haben die damit verbundenen Fortschritte inländischer Kollegen Aufmerksamkeit erregt. Erst gestern veröffentlichte UBTECH, Chinas „größter Bestand an humanoiden Robotern“, die erste Demo des humanoiden Roboters WalkerS, der tief in das große Modell von Baidu Wenxin integriert ist und einige interessante neue Funktionen aufweist. Jetzt sieht WalkerS, gesegnet mit Baidu Wenxins großen Modellfähigkeiten, so aus. Wie Figure01 bewegt sich WalkerS nicht umher, sondern steht hinter einem Schreibtisch, um eine Reihe von Aufgaben zu erledigen. Es kann menschlichen Befehlen folgen und Kleidung falten

Der erste Roboter erscheint, der menschliche Aufgaben autonom erledigt, mit fünf flexiblen Fingern und übermenschlicher Geschwindigkeit, und große Modelle unterstützen das Training im virtuellen Raum

Mar 11, 2024 pm 12:10 PM

Der erste Roboter erscheint, der menschliche Aufgaben autonom erledigt, mit fünf flexiblen Fingern und übermenschlicher Geschwindigkeit, und große Modelle unterstützen das Training im virtuellen Raum

Mar 11, 2024 pm 12:10 PM

Diese Woche gab FigureAI, ein Robotikunternehmen, an dem OpenAI, Microsoft, Bezos und Nvidia beteiligt sind, bekannt, dass es fast 700 Millionen US-Dollar an Finanzmitteln erhalten hat und plant, im nächsten Jahr einen humanoiden Roboter zu entwickeln, der selbstständig gehen kann. Und Teslas Optimus Prime hat immer wieder gute Nachrichten erhalten. Niemand zweifelt daran, dass dieses Jahr das Jahr sein wird, in dem humanoide Roboter explodieren. SanctuaryAI, ein in Kanada ansässiges Robotikunternehmen, hat kürzlich einen neuen humanoiden Roboter auf den Markt gebracht: Phoenix. Beamte behaupten, dass es viele Aufgaben autonom und mit der gleichen Geschwindigkeit wie Menschen erledigen kann. Pheonix, der weltweit erste Roboter, der Aufgaben autonom in menschlicher Geschwindigkeit erledigen kann, kann jedes Objekt sanft greifen, bewegen und elegant auf der linken und rechten Seite platzieren. Es kann Objekte autonom identifizieren

Der humanoide Roboter kann zaubern. Lassen Sie das Programmteam der Frühlingsfest-Gala mehr erfahren

Feb 04, 2024 am 09:03 AM

Der humanoide Roboter kann zaubern. Lassen Sie das Programmteam der Frühlingsfest-Gala mehr erfahren

Feb 04, 2024 am 09:03 AM

Roboter haben im Handumdrehen gelernt, zu zaubern? Es war zu sehen, dass es zuerst den Wasserlöffel auf dem Tisch aufhob und damit dem Publikum bewies, dass nichts darin war ... Dann nahm es den eiähnlichen Gegenstand in seine Hand und stellte den Wasserlöffel zurück auf den Tisch und begann „einen Zauber zu wirken“... …Gerade als es den Wasserlöffel wieder aufhob, geschah ein Wunder. Das ursprünglich hineingelegte Ei verschwand und das Ding, das heraussprang, verwandelte sich in einen Basketball ... Schauen wir uns noch einmal die fortlaufenden Aktionen an: △ Diese Animation zeigt eine Reihe von Aktionen mit doppelter Geschwindigkeit und läuft nur durch Zuschauen reibungslos ab Das Video kann wiederholt mit 0,5-facher Geschwindigkeit verstanden werden. Schließlich habe ich die Hinweise entdeckt: Wenn meine Handgeschwindigkeit schneller wäre, könnte ich es möglicherweise vor dem Feind verbergen. Einige Internetnutzer beklagten, dass die magischen Fähigkeiten des Roboters sogar noch höher seien als ihre eigenen: Mag war derjenige, der diese Magie für uns ausgeführt hat.

Zehn humanoide Roboter gestalten die Zukunft

Mar 22, 2024 pm 08:51 PM

Zehn humanoide Roboter gestalten die Zukunft

Mar 22, 2024 pm 08:51 PM

Die folgenden 10 humanoiden Roboter prägen unsere Zukunft: 1. ASIMO: ASIMO wurde von Honda entwickelt und ist einer der bekanntesten humanoiden Roboter. Mit einer Höhe von 1,20 m und einem Gewicht von 50 kg ist ASIMO mit fortschrittlichen Sensoren und künstlichen Intelligenzfunktionen ausgestattet, die es ihm ermöglichen, sich in komplexen Umgebungen zurechtzufinden und mit Menschen zu interagieren. Aufgrund seiner Vielseitigkeit eignet sich ASIMO für eine Vielzahl von Aufgaben, von der Unterstützung von Menschen mit Behinderungen bis hin zur Durchführung von Präsentationen bei Veranstaltungen. 2. Pepper: Pepper wurde von Softbank Robotics entwickelt und möchte ein sozialer Begleiter für Menschen sein. Mit seinem ausdrucksstarken Gesicht und der Fähigkeit, Emotionen zu erkennen, kann Pepper an Gesprächen teilnehmen, im Einzelhandel helfen und sogar pädagogische Unterstützung leisten. Pfeffer

Der Kehr- und Wischroboter Cloud Whale Xiaoyao 001 hat ein „Gehirn'! |. Erfahrung

Apr 26, 2024 pm 04:22 PM

Der Kehr- und Wischroboter Cloud Whale Xiaoyao 001 hat ein „Gehirn'! |. Erfahrung

Apr 26, 2024 pm 04:22 PM

Kehr- und Wischroboter gehören in den letzten Jahren zu den beliebtesten Smart-Home-Geräten bei Verbrauchern. Die damit verbundene Bequemlichkeit der Bedienung oder sogar die Notwendigkeit einer Bedienung ermöglicht es faulen Menschen, ihre Hände frei zu haben, was es den Verbrauchern ermöglicht, sich von der täglichen Hausarbeit zu „befreien“ und mehr Zeit mit den Dingen zu verbringen, die sie in getarnter Form genießen. Aufgrund dieser Begeisterung stellen fast alle Haushaltsgerätemarken auf dem Markt ihre eigenen Kehr- und Wischroboter her, was den gesamten Markt für Kehr- und Wischroboter sehr lebendig macht. Allerdings wird die schnelle Expansion des Marktes unweigerlich eine versteckte Gefahr mit sich bringen: Viele Hersteller werden die Taktik des Maschinenmeeres nutzen, um schnell mehr Marktanteile zu erobern, was zu vielen neuen Produkten ohne Upgrade-Punkte führen wird Es handelt sich um „Matroschka“-Modelle. Keine Übertreibung. Allerdings sind das nicht alle Kehr- und Wischroboter