Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Neuer Durchbruch im HCP-Labor der Sun Yat-sen-Universität: Verwendung eines Kausalparadigmas zur Verbesserung multimodaler großer Modelle

Neuer Durchbruch im HCP-Labor der Sun Yat-sen-Universität: Verwendung eines Kausalparadigmas zur Verbesserung multimodaler großer Modelle

Neuer Durchbruch im HCP-Labor der Sun Yat-sen-Universität: Verwendung eines Kausalparadigmas zur Verbesserung multimodaler großer Modelle

Das Human-Machine Intelligence Fusion Laboratory (HCP) der Sun Yat-sen University hat fruchtbare Erfolge in AIGC und multimodalen Großmodellen erzielt. Es wurde für mehr als zehn Arbeiten im aktuellen AAAI 2023 und CVPR 2023 ausgewählt die ersten Ebenen globaler Forschungseinrichtungen.

Eine der Arbeiten implementierte den Einsatz von Kausalmodellen, um die Steuerbarkeit und Generalisierung multimodaler großer Modelle beim Tuning deutlich zu verbessern – „Masked Images Are Counterfactual Samples for Robust Fine-tuning“.

Link: https://arxiv.org/abs/2303.03052

Die Verwendung vorab trainierter Großmodelle zur Feinabstimmung nachgelagerter Aufgaben ist derzeit ein beliebtes Deep-Learning-Paradigma . Insbesondere die jüngste herausragende Leistung von ChatGPT, einem großen vorab trainierten Sprachmodell, hat diesem technischen Paradigma weithin Anerkennung verschafft. Nach dem Vortraining mit umfangreichen Daten können sich diese großen vorab trainierten Modelle an die sich ändernde Datenverteilung in der realen Umgebung anpassen und zeigen daher in allgemeinen Szenarien eine hohe Robustheit.

Wenn jedoch das vorab trainierte große Modell mit nachgelagerten Szenendaten verfeinert wird, um es an bestimmte Anwendungsaufgaben anzupassen, sind diese Daten in den allermeisten Fällen singulär. Die Verwendung dieser Daten zur Feinabstimmung des vorab trainierten großen Modells verringert häufig die Robustheit des Modells, was die Anwendung auf der Grundlage des vorab trainierten großen Modells erschwert. Insbesondere im Hinblick auf visuelle Modelle ist das Problem des nachgelagerten Feinabstimmungstrainings, das zu einer Verringerung der Robustheit visueller vorab trainierter großer Modelle führt, besonders ausgeprägt, da die Vielfalt der Bilder die der Sprache bei weitem übersteigt.

Frühere Forschungsmethoden bewahren die Robustheit des fein abgestimmten vorab trainierten Modells normalerweise implizit auf der Ebene der Modellparameter durch Modellintegration und andere Methoden. In diesen Arbeiten wurden jedoch weder die wesentlichen Gründe analysiert, warum die Feinabstimmung zu einer Leistungsverschlechterung des Modells außerhalb der Verteilung führt, noch wurde das oben erwähnte Problem der verringerten Robustheit nach der Feinabstimmung großer Modelle klar gelöst.

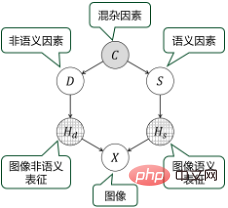

Diese Arbeit basiert auf dem modalübergreifenden großen Modell und analysiert die wesentlichen Gründe für den Robustheitsverlust des vorab trainierten großen Modells aus der Perspektive der Kausalität und schlägt dementsprechend eine Methode vor, mit der die Robustheit erheblich verbessert werden kann Optimieren Sie Ihre Trainingsmethoden. Diese Methode ermöglicht es dem Modell, eine hohe Robustheit beizubehalten, während es sich an nachgelagerte Aufgaben anpasst, und erfüllt die Anforderungen praktischer Anwendungen besser.

Nehmen Sie als Beispiel das große modalübergreifende Vortrainingsmodell CLIP (Contrastive Language–Image Pre-Training), das 2021 von OpenAI veröffentlicht wurde: CLIP ist ein großes modalübergreifendes Vortrainingsmodell, das auf kontrastivem Bildtext basiert Das gemeinsame Lernen ist die Grundlage generativer Modelle wie Stable Diffusion. Das Modell wird auf umfangreichen Multi-Source-Daten mit etwa 400 Millionen Bild-Text-Paaren trainiert und lernt einige kausale Zusammenhänge, die bis zu einem gewissen Grad robust gegenüber Verteilungsänderungen sind.

Bei der Feinabstimmung von CLIP mit Single-Feature-Downstream-Daten ist es jedoch leicht, dieses vom Modell erlernte kausale Wissen zu zerstören, da die nicht-semantische Darstellung und die semantische Darstellung des Trainingsbildes stark miteinander verflochten sind. Wenn man beispielsweise die CLIP-Modellübertragung auf das Downstream-Szenario „Bauernhof“ anwendet, zeigen viele der Trainingsbilder „Kühe“ im Gras. An diesem Punkt kann das Feinabstimmungstraining es dem Modell ermöglichen, zu lernen, sich auf die semantische Nicht-„Kuh“-Darstellung von Gras zu verlassen, um die Semantik des Bildes vorherzusagen. Dieser Zusammenhang stimmt jedoch nicht unbedingt, es können beispielsweise auch „Kühe“ auf der Straße auftauchen. Nachdem das Modell fein abgestimmt und trainiert wurde, verringert sich daher seine Robustheit, und die Ausgabeergebnisse während der Anwendung können extrem instabil werden und es fehlt ihnen an Kontrollierbarkeit.

Basierend auf der jahrelangen Erfahrung des Teams beim Aufbau und Training großer Modelle untersucht diese Arbeit das Problem der verringerten Robustheit, die durch die Feinabstimmung vorab trainierter Modelle verursacht wird, aus der Perspektive der Kausalität erneut. Basierend auf der kausalen Modellierung und Analyse schlägt diese Arbeit eine Trainingsmethode zur Feinabstimmung vor, die kontrafaktische Stichproben auf der Grundlage von Bildmasken erstellt und die Robustheit des Modells durch Lernen von Maskenbildern verbessert.

Um die falsche Korrelation in den nachgelagerten Trainingsbildern aufzubrechen, schlägt diese Arbeit insbesondere eine auf einer Klassenaktivierungskarte (CAM) basierende Methode vor, um den Inhalt bestimmter Bereiche des Bildes zu maskieren und zu ersetzen, um das Nichtsemantische zu manipulieren Die Bedeutung des Bildes erzeugt kontrafaktische Beispiele. Das fein abgestimmte Modell kann lernen, die Darstellung dieser kontrafaktischen Stichproben durch das vorab trainierte Modell durch Destillation zu imitieren, wodurch der Einfluss semantischer Faktoren und nicht-semantischer Faktoren besser entkoppelt und die Anpassungsfähigkeit an Verteilungsverschiebungen in nachgelagerten Feldern verbessert wird.

Experimente zeigen, dass diese Methode die Leistung vorab trainierter Modelle in nachgelagerten Aufgaben erheblich verbessern kann und gleichzeitig erhebliche Vorteile bei der Verbesserung der Robustheit im Vergleich zu bestehenden Trainingsmethoden zur Feinabstimmung großer Modelle bietet.

Die wichtige Bedeutung dieser Arbeit besteht darin, dass sie bis zu einem gewissen Grad die „Black Box“ öffnet, die vorab trainierte große Modelle vom Deep-Learning-Paradigma erben, und die Probleme der „Interpretierbarkeit“ und „Steuerbarkeit“ löst Große Modelle bringen uns den spürbaren Produktivitätssteigerungen näher, die durch vorab trainierte große Modelle erzielt werden.

Das HCP-Team der Sun Yat-sen-Universität beschäftigt sich seit der Einführung des Transformer-Mechanismus seit vielen Jahren mit der Erforschung großer Modelltechnologieparadigmen. Es hat sich zum Ziel gesetzt, die Trainingseffizienz großer Modelle zu verbessern und kausale Modelle einzuführen Lösen Sie das „Steuerbarkeitsproblem“ großer Modelle. Im Laufe der Jahre hat das Team unabhängig voneinander mehrere große Pre-Training-Modelle für Vision, Sprache, Sprache und Cross-Modalität erforscht und entwickelt. Das modalübergreifende große Modell „Wukong“ wurde gemeinsam mit dem Noah's Ark Laboratory von Huawei entwickelt (Link: https:/ /arxiv.org/abs/2202.06767) ist ein typischer Fall.

Teamvorstellung

Das Human-Computer Intelligence Convergence Laboratory (HCP Lab) der Sun Yat-sen University beschäftigt sich mit multimodalem kognitivem Computing, Robotik und eingebetteten Systemen, Metaversum und digitalen Menschen, kontrollierbarer Inhaltsgenerierung, usw. Führen Sie systematische Forschung auf diesem Gebiet durch, erstellen Sie Produktprototypen, detaillierte Anwendungsszenarien, exportieren Sie eine große Anzahl Originaltechnologien und bilden Sie unternehmerische Teams. Das Labor wurde 2010 von Professor Lin Liang, IAPR Fellow, gegründet. Es hat den ersten Preis des Science and Technology Award der China Image and Graphics Society, den Wu Wenjun Natural Science Award, den ersten Preis der Provinz-Naturwissenschaften und andere Auszeichnungen gewonnen. Es hat junge Talente auf nationaler Ebene wie Liang Xiaodan und Wang Keze ausgebildet.

Das obige ist der detaillierte Inhalt vonNeuer Durchbruch im HCP-Labor der Sun Yat-sen-Universität: Verwendung eines Kausalparadigmas zur Verbesserung multimodaler großer Modelle. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1382

1382

52

52

Open Source! Jenseits von ZoeDepth! DepthFM: Schnelle und genaue monokulare Tiefenschätzung!

Apr 03, 2024 pm 12:04 PM

Open Source! Jenseits von ZoeDepth! DepthFM: Schnelle und genaue monokulare Tiefenschätzung!

Apr 03, 2024 pm 12:04 PM

0.Was bewirkt dieser Artikel? Wir schlagen DepthFM vor: ein vielseitiges und schnelles generatives monokulares Tiefenschätzungsmodell auf dem neuesten Stand der Technik. Zusätzlich zu herkömmlichen Tiefenschätzungsaufgaben demonstriert DepthFM auch hochmoderne Fähigkeiten bei nachgelagerten Aufgaben wie dem Tiefen-Inpainting. DepthFM ist effizient und kann Tiefenkarten innerhalb weniger Inferenzschritte synthetisieren. Lassen Sie uns diese Arbeit gemeinsam lesen ~ 1. Titel der Papierinformationen: DepthFM: FastMonocularDepthEstimationwithFlowMatching Autor: MingGui, JohannesS.Fischer, UlrichPrestel, PingchuanMa, Dmytr

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Stellen Sie sich ein Modell der künstlichen Intelligenz vor, das nicht nur die Fähigkeit besitzt, die traditionelle Datenverarbeitung zu übertreffen, sondern auch eine effizientere Leistung zu geringeren Kosten erzielt. Dies ist keine Science-Fiction, DeepSeek-V2[1], das weltweit leistungsstärkste Open-Source-MoE-Modell, ist da. DeepSeek-V2 ist ein leistungsstarkes MoE-Sprachmodell (Mix of Experts) mit den Merkmalen eines wirtschaftlichen Trainings und einer effizienten Inferenz. Es besteht aus 236B Parametern, von denen 21B zur Aktivierung jedes Markers verwendet werden. Im Vergleich zu DeepSeek67B bietet DeepSeek-V2 eine stärkere Leistung, spart gleichzeitig 42,5 % der Trainingskosten, reduziert den KV-Cache um 93,3 % und erhöht den maximalen Generierungsdurchsatz auf das 5,76-fache. DeepSeek ist ein Unternehmen, das sich mit allgemeiner künstlicher Intelligenz beschäftigt

KI untergräbt die mathematische Forschung! Der Gewinner der Fields-Medaille und der chinesisch-amerikanische Mathematiker führten 11 hochrangige Arbeiten an | Gefällt mir bei Terence Tao

Apr 09, 2024 am 11:52 AM

KI untergräbt die mathematische Forschung! Der Gewinner der Fields-Medaille und der chinesisch-amerikanische Mathematiker führten 11 hochrangige Arbeiten an | Gefällt mir bei Terence Tao

Apr 09, 2024 am 11:52 AM

KI verändert tatsächlich die Mathematik. Vor kurzem hat Tao Zhexuan, der diesem Thema große Aufmerksamkeit gewidmet hat, die neueste Ausgabe des „Bulletin of the American Mathematical Society“ (Bulletin der American Mathematical Society) weitergeleitet. Zum Thema „Werden Maschinen die Mathematik verändern?“ äußerten viele Mathematiker ihre Meinung. Der gesamte Prozess war voller Funken, knallhart und aufregend. Der Autor verfügt über eine starke Besetzung, darunter der Fields-Medaillengewinner Akshay Venkatesh, der chinesische Mathematiker Zheng Lejun, der NYU-Informatiker Ernest Davis und viele andere bekannte Wissenschaftler der Branche. Die Welt der KI hat sich dramatisch verändert. Viele dieser Artikel wurden vor einem Jahr eingereicht.

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas tritt offiziell in die Ära der Elektroroboter ein! Gestern hat sich der hydraulische Atlas einfach „unter Tränen“ von der Bühne der Geschichte zurückgezogen. Heute gab Boston Dynamics bekannt, dass der elektrische Atlas im Einsatz ist. Es scheint, dass Boston Dynamics im Bereich kommerzieller humanoider Roboter entschlossen ist, mit Tesla zu konkurrieren. Nach der Veröffentlichung des neuen Videos wurde es innerhalb von nur zehn Stunden bereits von mehr als einer Million Menschen angesehen. Die alten Leute gehen und neue Rollen entstehen. Das ist eine historische Notwendigkeit. Es besteht kein Zweifel, dass dieses Jahr das explosive Jahr der humanoiden Roboter ist. Netizens kommentierten: Die Weiterentwicklung der Roboter hat dazu geführt, dass die diesjährige Eröffnungsfeier wie Menschen aussieht, und der Freiheitsgrad ist weitaus größer als der von Menschen. Aber ist das wirklich kein Horrorfilm? Zu Beginn des Videos liegt Atlas ruhig auf dem Boden, scheinbar auf dem Rücken. Was folgt, ist atemberaubend

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

Anfang dieses Monats schlugen Forscher des MIT und anderer Institutionen eine vielversprechende Alternative zu MLP vor – KAN. KAN übertrifft MLP in Bezug auf Genauigkeit und Interpretierbarkeit. Und es kann MLP, das mit einer größeren Anzahl von Parametern ausgeführt wird, mit einer sehr kleinen Anzahl von Parametern übertreffen. Beispielsweise gaben die Autoren an, dass sie KAN nutzten, um die Ergebnisse von DeepMind mit einem kleineren Netzwerk und einem höheren Automatisierungsgrad zu reproduzieren. Konkret verfügt DeepMinds MLP über etwa 300.000 Parameter, während KAN nur etwa 200 Parameter hat. KAN hat eine starke mathematische Grundlage wie MLP und basiert auf dem universellen Approximationssatz, während KAN auf dem Kolmogorov-Arnold-Darstellungssatz basiert. Wie in der folgenden Abbildung gezeigt, hat KAN

Die Vitalität der Superintelligenz erwacht! Aber mit der Einführung der sich selbst aktualisierenden KI müssen sich Mütter keine Sorgen mehr über Datenengpässe machen

Apr 29, 2024 pm 06:55 PM

Die Vitalität der Superintelligenz erwacht! Aber mit der Einführung der sich selbst aktualisierenden KI müssen sich Mütter keine Sorgen mehr über Datenengpässe machen

Apr 29, 2024 pm 06:55 PM

Ich weine zu Tode. Die Daten im Internet reichen überhaupt nicht aus. Das Trainingsmodell sieht aus wie „Die Tribute von Panem“, und KI-Forscher auf der ganzen Welt machen sich Gedanken darüber, wie sie diese datenhungrigen Esser ernähren sollen. Dieses Problem tritt insbesondere bei multimodalen Aufgaben auf. Zu einer Zeit, als sie ratlos waren, nutzte ein Start-up-Team der Abteilung der Renmin-Universität von China sein eigenes neues Modell, um als erstes in China einen „modellgenerierten Datenfeed selbst“ in die Realität umzusetzen. Darüber hinaus handelt es sich um einen zweigleisigen Ansatz auf der Verständnisseite und der Generierungsseite. Beide Seiten können hochwertige, multimodale neue Daten generieren und Datenrückmeldungen an das Modell selbst liefern. Was ist ein Modell? Awaker 1.0, ein großes multimodales Modell, das gerade im Zhongguancun-Forum erschienen ist. Wer ist das Team? Sophon-Motor. Gegründet von Gao Yizhao, einem Doktoranden an der Hillhouse School of Artificial Intelligence der Renmin University.

Die Kuaishou-Version von Sora „Ke Ling' steht zum Testen offen: Sie generiert über 120 Sekunden Videos, versteht die Physik besser und kann komplexe Bewegungen genau modellieren

Jun 11, 2024 am 09:51 AM

Die Kuaishou-Version von Sora „Ke Ling' steht zum Testen offen: Sie generiert über 120 Sekunden Videos, versteht die Physik besser und kann komplexe Bewegungen genau modellieren

Jun 11, 2024 am 09:51 AM

Was? Wird Zootopia durch heimische KI in die Realität umgesetzt? Zusammen mit dem Video wird ein neues groß angelegtes inländisches Videogenerationsmodell namens „Keling“ vorgestellt. Sora geht einen ähnlichen technischen Weg und kombiniert eine Reihe selbst entwickelter technologischer Innovationen, um Videos zu produzieren, die nicht nur große und vernünftige Bewegungen aufweisen, sondern auch die Eigenschaften der physischen Welt simulieren und über starke konzeptionelle Kombinationsfähigkeiten und Vorstellungskraft verfügen. Den Daten zufolge unterstützt Keling die Erstellung ultralanger Videos von bis zu 2 Minuten mit 30 Bildern pro Sekunde, mit Auflösungen von bis zu 1080p und unterstützt mehrere Seitenverhältnisse. Ein weiterer wichtiger Punkt ist, dass es sich bei Keling nicht um eine vom Labor veröffentlichte Demo oder Video-Ergebnisdemonstration handelt, sondern um eine Anwendung auf Produktebene, die von Kuaishou, einem führenden Anbieter im Bereich Kurzvideos, gestartet wurde. Darüber hinaus liegt das Hauptaugenmerk darauf, pragmatisch zu sein, keine Blankoschecks auszustellen und sofort nach der Veröffentlichung online zu gehen. Das große Modell von Ke Ling wurde bereits in Kuaiying veröffentlicht.

Tesla-Roboter arbeiten in Fabriken, Musk: Der Freiheitsgrad der Hände wird dieses Jahr 22 erreichen!

May 06, 2024 pm 04:13 PM

Tesla-Roboter arbeiten in Fabriken, Musk: Der Freiheitsgrad der Hände wird dieses Jahr 22 erreichen!

May 06, 2024 pm 04:13 PM

Das neueste Video von Teslas Roboter Optimus ist veröffentlicht und er kann bereits in der Fabrik arbeiten. Bei normaler Geschwindigkeit sortiert es Batterien (Teslas 4680-Batterien) so: Der Beamte hat auch veröffentlicht, wie es bei 20-facher Geschwindigkeit aussieht – auf einer kleinen „Workstation“, pflücken und pflücken und pflücken: Dieses Mal wird es freigegeben. Eines der Highlights Der Vorteil des Videos besteht darin, dass Optimus diese Arbeit in der Fabrik völlig autonom und ohne menschliches Eingreifen während des gesamten Prozesses erledigt. Und aus Sicht von Optimus kann es auch die krumme Batterie aufnehmen und platzieren, wobei der Schwerpunkt auf der automatischen Fehlerkorrektur liegt: In Bezug auf die Hand von Optimus gab der NVIDIA-Wissenschaftler Jim Fan eine hohe Bewertung ab: Die Hand von Optimus ist der fünffingrige Roboter der Welt am geschicktesten. Seine Hände sind nicht nur taktil