Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Wie viel Potenzial haben Festparametermodelle? Hong Kong Chinese, Shanghai AI Lab und andere schlugen ein effizientes Videoverständnis-Framework EVL vor

Wie viel Potenzial haben Festparametermodelle? Hong Kong Chinese, Shanghai AI Lab und andere schlugen ein effizientes Videoverständnis-Framework EVL vor

Wie viel Potenzial haben Festparametermodelle? Hong Kong Chinese, Shanghai AI Lab und andere schlugen ein effizientes Videoverständnis-Framework EVL vor

Visuelle Basismodelle haben in den letzten zwei Jahren eine bemerkenswerte Entwicklung erzielt. Einerseits hat das auf großen Internetdaten basierende Vortraining eine große Anzahl semantischer Konzepte für das Modell voreingestellt und somit eine gute Generalisierungsleistung erzielt, andererseits aber auch die volle Nutzung der Modellgröße ermöglicht Durch das Wachstum großer Datensätze stehen verwandte Modelle bei der Migration zu nachgelagerten Aufgaben vor Ineffizienzproblemen, insbesondere bei Videoverständnismodellen, die mehrere Frames verarbeiten müssen.

- Papierlink: https://arxiv.org/abs/2208.03550

- Codelink: https://github.com/OpenGVLab/efficient-video-recognition

Basierend auf den beiden oben genannten Merkmalen schlugen Forscher der Chinesischen Universität Hongkong, des Shanghai Artificial Intelligence Laboratory und anderer Institutionen ein effizientes EVL-Framework für das Videoverständnis-Transferlernen vor, das Trainingsberechnungen und Speicher spart, indem es das Gewicht des Grundgerüsts festlegt Modellverbrauch; gleichzeitig bleibt durch die Verwendung mehrstufiger, feinkörniger Zwischenfunktionen die Flexibilität der traditionellen End-to-End-Feinabstimmung weitestgehend erhalten.

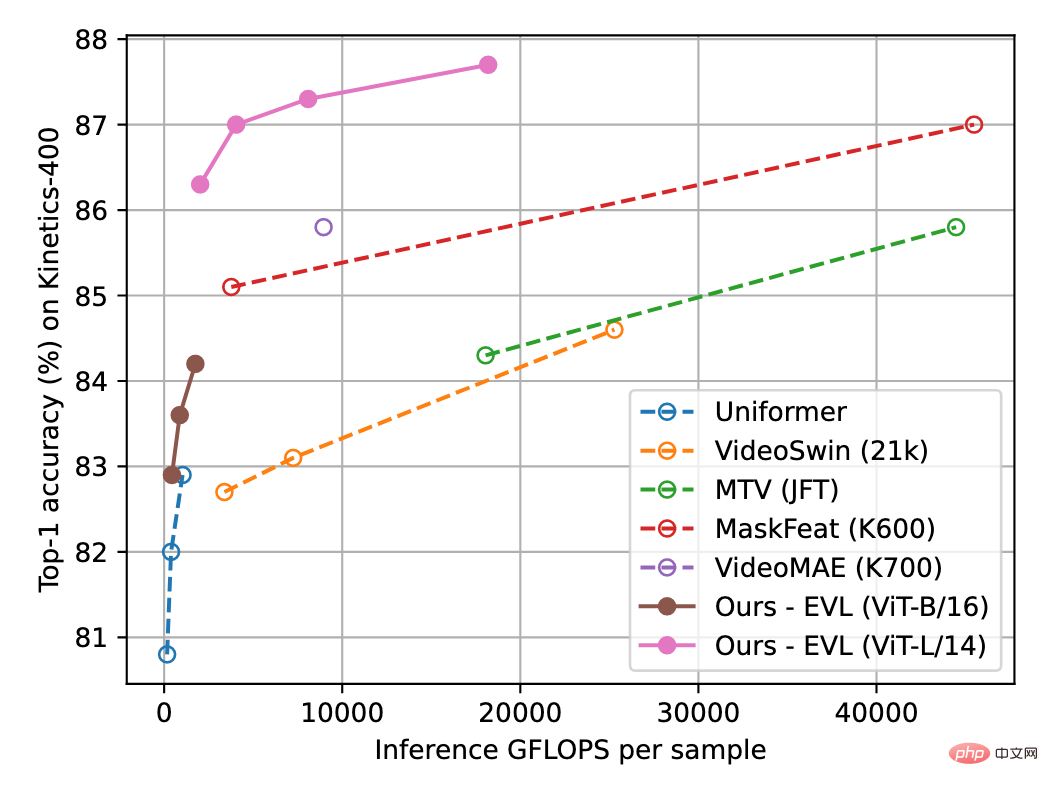

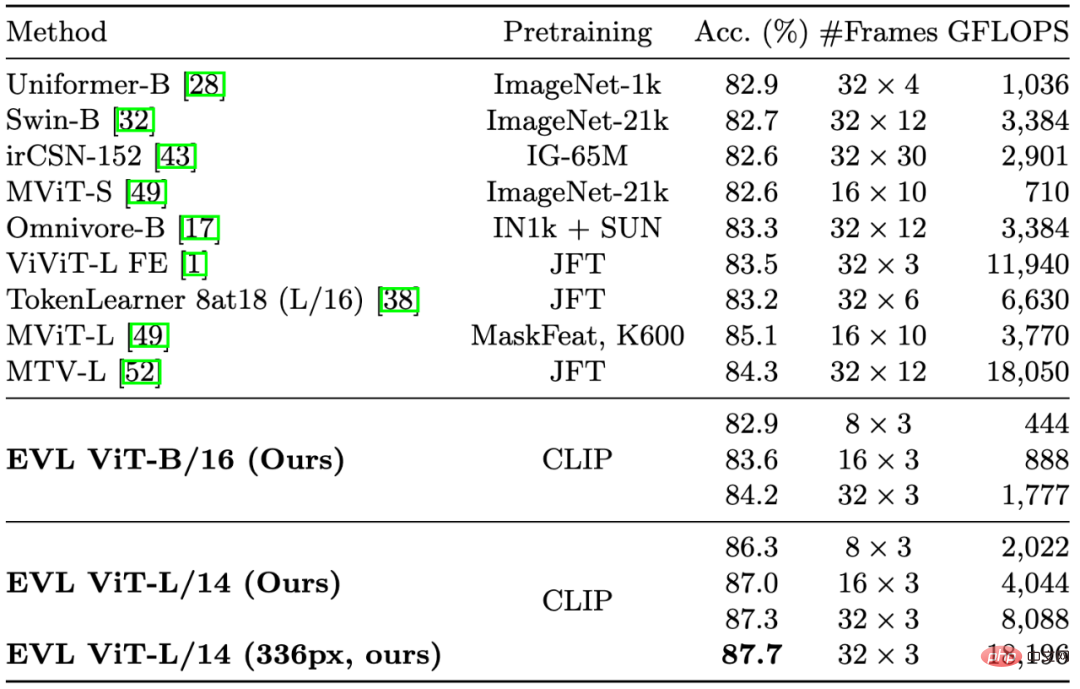

Abbildung 1 unten zeigt die Ergebnisse der EVL-Methode für den Videoverständnisdatensatz Kinetics-400. Experimente zeigen, dass diese Methode zwar Trainingsaufwand spart, aber dennoch das Potenzial des grundlegenden visuellen Modells bei Videoverständnisaufgaben vollständig ausschöpft.

Abbildung 1: Vergleich der Erkennungsgenauigkeit von Kinetics-400. Die horizontale Achse ist der Umfang der Inferenzberechnung und die vertikale Achse ist die Genauigkeit. Das gesamte schematische Diagramm des Algorithmus

Methode

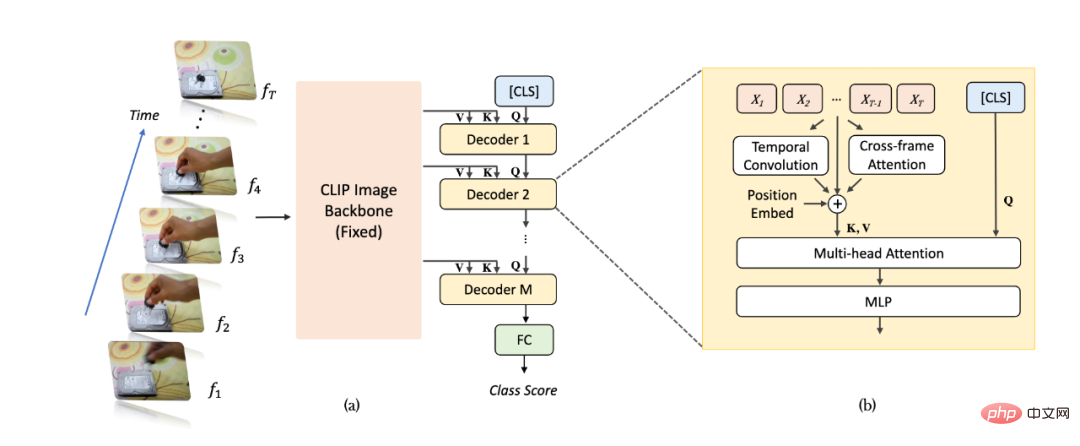

ist in Abbildung 2(a) dargestellt. Für ein Videobeispiel nehmen wir T-Frames, geben sie in ein Bilderkennungsnetzwerk ein (am Beispiel von CLIP) und extrahieren Merkmale. Im Vergleich zu herkömmlichen Methoden extrahieren wir mehrschichtige, nicht gepoolte Merkmale aus den letzten Schichten des Bilderkennungsnetzwerks, um reichhaltigere und feinkörnigere Bildinformationen zu erhalten, und die Parametergewichte des Bilderkennungsnetzwerks bleiben beim Videolernen immer konsistent behoben. Anschließend werden die mehrschichtigen Feature-Maps nacheinander in einen Transformer-Decoder zur Informationsaggregation auf Videoebene eingegeben. Die mehrschichtig dekodierten [CLS]-Merkmale werden verwendet, um die endgültige Klassifizierungsvorhersage zu generieren.

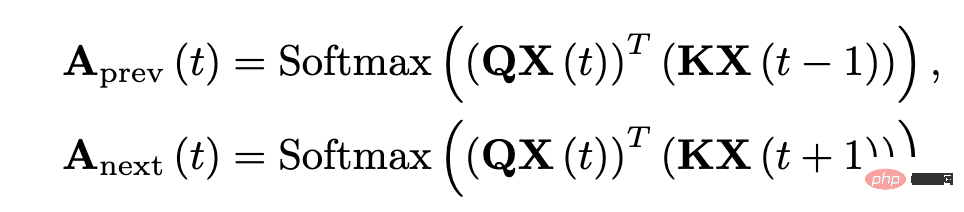

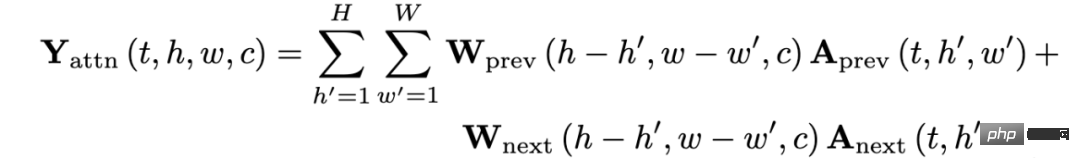

Wie in Abbildung 2(b) dargestellt, haben wir aufgrund der Störung bei der Aggregation von Funktionen des Transformer-Decoders ein zusätzliches Timing-Informationsmodellierungsmodul im Netzwerk hinzugefügt, um positionsbezogene feinkörnige Timing-Informationen besser zu extrahieren. Insbesondere fügen wir drei zusätzliche Arten von positionsbezogenen Zeitinformationen hinzu: Die erste ist die zeitliche Positionseinbettung (Position Embeddings), die zweite ist die tiefentrennbare Faltung der zeitlichen Dimension (Depthwise Convolution) und die dritte ist die Aufmerksamkeit zwischen benachbarten Frames Informationen erzwingen. Für interframe-Aufmerksamkeitsinformationen extrahieren wir die Abfrage- und Schlüsselmerkmale der entsprechenden Ebene aus dem Bilderkennungsnetzwerk und berechnen die Aufmerksamkeitskarte zwischen benachbarten Frames (im Gegensatz zum Bilderkennungsnetzwerk besteht die Aufmerksamkeitskarte aus der Abfrage aus dem der gleiche Rahmen und die gleichen Hauptmerkmale werden erhalten). Die resultierende Aufmerksamkeitskarte kann die Positionsänderungen von Objekten zwischen benachbarten Frames explizit widerspiegeln. Nach der linearen Projektion erhält die Aufmerksamkeitskarte eine Vektorgruppe, die die Verschiebungseigenschaften des Objekts widerspiegelt und in Form einer Element-für-Element-Addition in die Bildmerkmale integriert wird.

Abbildung 2: Strukturdiagramm des EVL-Algorithmus. (a) Gesamtstruktur, (b) Sequentielles Informationsmodellierungsmodul.

Abbildung 3: Mathematischer Ausdruck von Inter-Frame-Aufmerksamkeitsmerkmalen.

Experiment

In Abbildung 1 und Tabelle 1 haben wir einige wichtige Methoden des vorherigen Videoverständnisses zitiert. Obwohl wir uns auf die Reduzierung des Trainingsaufwands konzentrieren, übertrifft unsere Methode immer noch bestehende Methoden in Bezug auf Genauigkeit (bei gleichem Rechenaufwand).

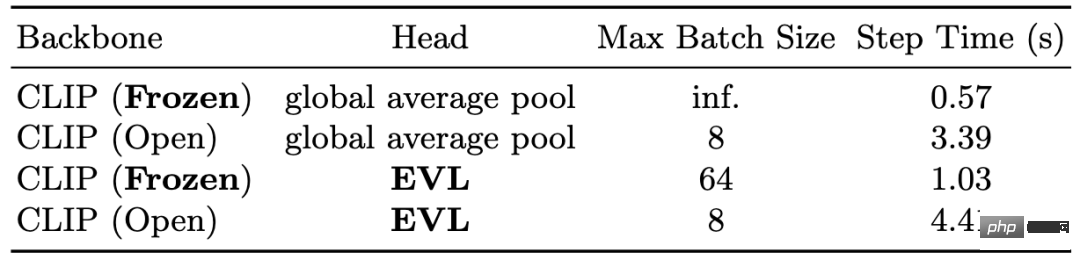

In Tabelle 2 zeigen wir die Reduzierung des Trainingsaufwands, die das feste Backbone-Netzwerk mit sich bringt. In Bezug auf den Speicher kann das feste Backbone-Netzwerk auf der V100-GPU eine maximale Stapelgröße von 64 erreichen, während das End-to-End-Training zeitlich nur 8 erreichen kann Netzwerk kann das Drei- bis Vierfache der Trainingszeit einsparen.

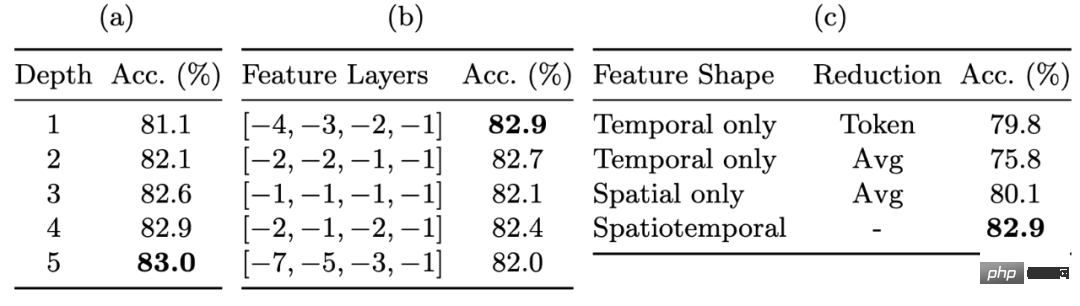

In Tabelle 3 zeigen wir die Verbesserung der Erkennungsleistung durch feinkörnige Feature-Maps. Die mehrschichtigen Unpooled-Funktionen ermöglichen es uns, ein erhebliches Maß an Flexibilität bei der Festlegung der Gewichte des Backbone-Netzwerks aufrechtzuerhalten. Die Verwendung nicht gepoolter Features bringt die deutlichste Verbesserung (ca. 3 %), gefolgt von der Verwendung von Multi-Layer-Decodern und Mid-Layer-Features, die ebenfalls jeweils etwa 1 % Leistungsverbesserung bringen.

Abschließend zeigen wir die Wirkung des feinkörnigen Timing-Informationsmoduls in Tabelle 4. Obwohl feinkörnige Timing-Informationen einen begrenzten Einfluss auf die Leistung von Kinetics-400 haben, sind sie für die Leistung von Something-Something-v2 sehr wichtig: Die drei Arten von feinkörnigen Timing-Informationsmodulen bringen insgesamt etwa 0,5 % und ca. 14 % Leistungsverbesserung. Tabelle 1: Vergleichsergebnisse mit vorhandenen Methoden für Kinetics-400

Tabelle 3: Die Auswirkung feinkörniger Feature-Maps auf die Genauigkeit

Tabelle 4: Die Auswirkung feinkörniger zeitlicher Informationsmodellierung auf verschiedene Datensätze

Zusammenfassung

Zusammenfassung

In diesem Artikel wird das EVL-Videoverständnis-Lernframework vorgeschlagen, das zum ersten Mal das große Potenzial eines Festbild-Backbone-Netzwerks bei Videoverständnisproblemen demonstriert und außerdem leistungsstarkes Videoverständnis für Forschungsgruppen mit begrenzter Rechenleistung benutzerfreundlicher macht Ressourcen. Wir glauben auch, dass unsere Methode mit der Verbesserung der Qualität und des Maßstabs grundlegender visueller Modelle eine Referenz für nachfolgende Forschungen zu leichtgewichtigen Transferlernalgorithmen sein kann.

Das obige ist der detaillierte Inhalt vonWie viel Potenzial haben Festparametermodelle? Hong Kong Chinese, Shanghai AI Lab und andere schlugen ein effizientes Videoverständnis-Framework EVL vor. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1382

1382

52

52

Keine OpenAI-Daten erforderlich, schließen Sie sich der Liste der großen Codemodelle an! UIUC veröffentlicht StarCoder-15B-Instruct

Jun 13, 2024 pm 01:59 PM

Keine OpenAI-Daten erforderlich, schließen Sie sich der Liste der großen Codemodelle an! UIUC veröffentlicht StarCoder-15B-Instruct

Jun 13, 2024 pm 01:59 PM

An der Spitze der Softwaretechnologie kündigte die Gruppe von UIUC Zhang Lingming zusammen mit Forschern der BigCode-Organisation kürzlich das StarCoder2-15B-Instruct-Großcodemodell an. Diese innovative Errungenschaft erzielte einen bedeutenden Durchbruch bei Codegenerierungsaufgaben, übertraf erfolgreich CodeLlama-70B-Instruct und erreichte die Spitze der Codegenerierungsleistungsliste. Die Einzigartigkeit von StarCoder2-15B-Instruct liegt in seiner reinen Selbstausrichtungsstrategie. Der gesamte Trainingsprozess ist offen, transparent und völlig autonom und kontrollierbar. Das Modell generiert über StarCoder2-15B Tausende von Anweisungen als Reaktion auf die Feinabstimmung des StarCoder-15B-Basismodells, ohne auf teure manuelle Annotationen angewiesen zu sein.

Yolov10: Ausführliche Erklärung, Bereitstellung und Anwendung an einem Ort!

Jun 07, 2024 pm 12:05 PM

Yolov10: Ausführliche Erklärung, Bereitstellung und Anwendung an einem Ort!

Jun 07, 2024 pm 12:05 PM

1. Einleitung In den letzten Jahren haben sich YOLOs aufgrund ihres effektiven Gleichgewichts zwischen Rechenkosten und Erkennungsleistung zum vorherrschenden Paradigma im Bereich der Echtzeit-Objekterkennung entwickelt. Forscher haben das Architekturdesign, die Optimierungsziele, Datenerweiterungsstrategien usw. von YOLO untersucht und erhebliche Fortschritte erzielt. Gleichzeitig behindert die Verwendung von Non-Maximum Suppression (NMS) bei der Nachbearbeitung die End-to-End-Bereitstellung von YOLO und wirkt sich negativ auf die Inferenzlatenz aus. In YOLOs fehlt dem Design verschiedener Komponenten eine umfassende und gründliche Prüfung, was zu erheblicher Rechenredundanz führt und die Fähigkeiten des Modells einschränkt. Es bietet eine suboptimale Effizienz und ein relativ großes Potenzial zur Leistungsverbesserung. Ziel dieser Arbeit ist es, die Leistungseffizienzgrenze von YOLO sowohl in der Nachbearbeitung als auch in der Modellarchitektur weiter zu verbessern. zu diesem Zweck

Die Tsinghua-Universität übernahm und YOLOv10 kam heraus: Die Leistung wurde erheblich verbessert und es stand auf der GitHub-Hotlist

Jun 06, 2024 pm 12:20 PM

Die Tsinghua-Universität übernahm und YOLOv10 kam heraus: Die Leistung wurde erheblich verbessert und es stand auf der GitHub-Hotlist

Jun 06, 2024 pm 12:20 PM

Die Benchmark-Zielerkennungssysteme der YOLO-Serie haben erneut ein großes Upgrade erhalten. Seit der Veröffentlichung von YOLOv9 im Februar dieses Jahres wurde der Staffelstab der YOLO-Reihe (YouOnlyLookOnce) in die Hände von Forschern der Tsinghua-Universität übergeben. Letztes Wochenende erregte die Nachricht vom Start von YOLOv10 die Aufmerksamkeit der KI-Community. Es gilt als bahnbrechendes Framework im Bereich Computer Vision und ist für seine End-to-End-Objekterkennungsfunktionen in Echtzeit bekannt. Es führt das Erbe der YOLO-Serie fort und bietet eine leistungsstarke Lösung, die Effizienz und Genauigkeit vereint. Papieradresse: https://arxiv.org/pdf/2405.14458 Projektadresse: https://github.com/THU-MIG/yo

So bewerten Sie die Kosteneffizienz der kommerziellen Unterstützung für Java-Frameworks

Jun 05, 2024 pm 05:25 PM

So bewerten Sie die Kosteneffizienz der kommerziellen Unterstützung für Java-Frameworks

Jun 05, 2024 pm 05:25 PM

Die Bewertung des Kosten-/Leistungsverhältnisses des kommerziellen Supports für ein Java-Framework umfasst die folgenden Schritte: Bestimmen Sie das erforderliche Maß an Sicherheit und Service-Level-Agreement-Garantien (SLA). Die Erfahrung und das Fachwissen des Forschungsunterstützungsteams. Erwägen Sie zusätzliche Services wie Upgrades, Fehlerbehebung und Leistungsoptimierung. Wägen Sie die Kosten für die Geschäftsunterstützung gegen Risikominderung und Effizienzsteigerung ab.

Technischer Bericht von Google Gemini 1.5: Einfache Prüfung von Mathematik-Olympiade-Fragen, die Flash-Version ist fünfmal schneller als GPT-4 Turbo

Jun 13, 2024 pm 01:52 PM

Technischer Bericht von Google Gemini 1.5: Einfache Prüfung von Mathematik-Olympiade-Fragen, die Flash-Version ist fünfmal schneller als GPT-4 Turbo

Jun 13, 2024 pm 01:52 PM

Im Februar dieses Jahres brachte Google das multimodale Großmodell Gemini 1.5 auf den Markt, das durch technische und Infrastrukturoptimierung, MoE-Architektur und andere Strategien die Leistung und Geschwindigkeit erheblich verbesserte. Mit längerem Kontext, stärkeren Argumentationsfähigkeiten und besserem Umgang mit modalübergreifenden Inhalten. Diesen Freitag hat Google DeepMind offiziell den technischen Bericht zu Gemini 1.5 veröffentlicht, der die Flash-Version und andere aktuelle Upgrades behandelt. Das Dokument ist 153 Seiten lang. Link zum technischen Bericht: https://storage.googleapis.com/deepmind-media/gemini/gemini_v1_5_report.pdf In diesem Bericht stellt Google Gemini1 vor

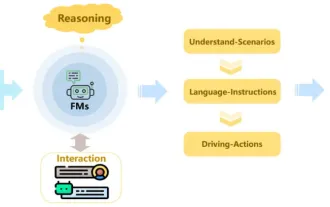

Rezension! Fassen Sie umfassend die wichtige Rolle von Basismodellen bei der Förderung des autonomen Fahrens zusammen

Jun 11, 2024 pm 05:29 PM

Rezension! Fassen Sie umfassend die wichtige Rolle von Basismodellen bei der Förderung des autonomen Fahrens zusammen

Jun 11, 2024 pm 05:29 PM

Oben geschrieben und das persönliche Verständnis des Autors: Mit der Entwicklung und den Durchbrüchen der Deep-Learning-Technologie haben kürzlich groß angelegte Grundlagenmodelle (Foundation Models) bedeutende Ergebnisse in den Bereichen natürlicher Sprachverarbeitung und Computer Vision erzielt. Große Entwicklungsperspektiven bietet auch die Anwendung von Basismodellen beim autonomen Fahren, die das Verständnis und die Argumentation von Szenarien verbessern können. Durch Vortraining mit umfangreichen Sprach- und visuellen Daten kann das Basismodell verschiedene Elemente in autonomen Fahrszenarien verstehen und interpretieren und Schlussfolgerungen ziehen, indem es Sprach- und Aktionsbefehle für die Entscheidungsfindung und Planung im Fahrbetrieb bereitstellt. Das Basismodell kann durch Datenergänzung mit einem Verständnis des Fahrszenarios ergänzt werden, um jene seltenen realisierbaren Merkmale in Long-Tail-Verteilungen bereitzustellen, die bei routinemäßigem Fahren und bei der Datenerfassung unwahrscheinlich anzutreffen sind.

Wie ist die Lernkurve von PHP-Frameworks im Vergleich zu anderen Sprach-Frameworks?

Jun 06, 2024 pm 12:41 PM

Wie ist die Lernkurve von PHP-Frameworks im Vergleich zu anderen Sprach-Frameworks?

Jun 06, 2024 pm 12:41 PM

Die Lernkurve eines PHP-Frameworks hängt von Sprachkenntnissen, Framework-Komplexität, Dokumentationsqualität und Community-Unterstützung ab. Die Lernkurve von PHP-Frameworks ist im Vergleich zu Python-Frameworks höher und im Vergleich zu Ruby-Frameworks niedriger. Im Vergleich zu Java-Frameworks haben PHP-Frameworks eine moderate Lernkurve, aber eine kürzere Einstiegszeit.

Wie wirken sich die Lightweight-Optionen von PHP-Frameworks auf die Anwendungsleistung aus?

Jun 06, 2024 am 10:53 AM

Wie wirken sich die Lightweight-Optionen von PHP-Frameworks auf die Anwendungsleistung aus?

Jun 06, 2024 am 10:53 AM

Das leichte PHP-Framework verbessert die Anwendungsleistung durch geringe Größe und geringen Ressourcenverbrauch. Zu seinen Merkmalen gehören: geringe Größe, schneller Start, geringer Speicherverbrauch, verbesserte Reaktionsgeschwindigkeit und Durchsatz sowie reduzierter Ressourcenverbrauch. Praktischer Fall: SlimFramework erstellt eine REST-API, nur 500 KB, hohe Reaktionsfähigkeit und hoher Durchsatz