Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Was passiert beim Lernen von ChatGPT, wenn menschliches Feedback in die KI-Malerei eingeführt wird?

Was passiert beim Lernen von ChatGPT, wenn menschliches Feedback in die KI-Malerei eingeführt wird?

Was passiert beim Lernen von ChatGPT, wenn menschliches Feedback in die KI-Malerei eingeführt wird?

In jüngster Zeit haben tiefe generative Modelle bemerkenswerte Erfolge bei der Generierung hochwertiger Bilder aus Textaufforderungen erzielt, was teilweise auf die Skalierung tiefer generativer Modelle auf große Webdatensätze wie LAION zurückzuführen ist. Es bleiben jedoch einige erhebliche Herausforderungen bestehen, die verhindern, dass groß angelegte Text-zu-Bild-Modelle Bilder erzeugen, die perfekt auf Textaufforderungen abgestimmt sind. Beispielsweise können aktuelle Text-zu-Bild-Modelle häufig keinen zuverlässigen visuellen Text generieren und haben Schwierigkeiten bei der kombinierten Bildgenerierung.

Zurück im Bereich der Sprachmodellierung ist das Lernen aus menschlichem Feedback zu einer leistungsstarken Lösung geworden, um „Modellverhalten mit menschlichen Absichten in Einklang zu bringen“. Diese Art von Methode lernt zunächst durch menschliches Feedback zur Modellausgabe eine Belohnungsfunktion, die das widerspiegeln soll, was den Menschen bei der Aufgabe wichtig ist, und verwendet dann die gelernte Belohnungsfunktion durch einen verstärkenden Lernalgorithmus (z. B. PPO für die proximale Richtlinienoptimierung), um die Sprache zu optimieren Modelle. Dieses Reinforcement Learning with Human Feedback Framework (RLHF) hat erfolgreich groß angelegte Sprachmodelle (wie GPT-3) mit einer anspruchsvollen menschlichen Qualitätsbewertung kombiniert.

Inspiriert durch den Erfolg von RLHF im Sprachbereich schlugen Forscher von Google Research und Berkeley, Kalifornien, kürzlich eine Feinabstimmungsmethode zur Ausrichtung von Text an Bildmodellen unter Verwendung menschlichen Feedbacks vor.

Papieradresse: https://arxiv.org/pdf/2302.12192v1.pdf

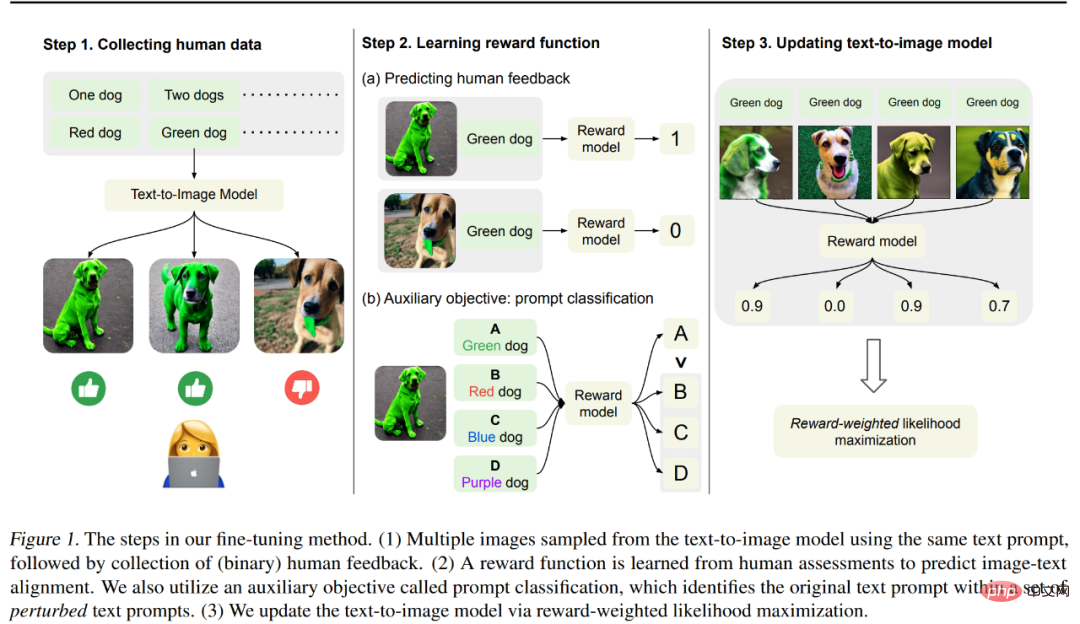

Die Methode dieses Artikels ist in Abbildung 1 unten dargestellt, die hauptsächlich in 3 unterteilt ist Schritte.

Schritt 1: Generieren Sie zunächst verschiedene Bilder aus einer Reihe von Textaufforderungen, „die dazu dienen, die Ausrichtung von Text an der Bildmodellausgabe zu testen“. Untersuchen Sie insbesondere die fehleranfälligeren Eingabeaufforderungen des vorab trainierten Modells – das Generieren von Objekten mit einer bestimmten Farbe, Nummer und einem bestimmten Hintergrund und das anschließende Sammeln binären menschlichen Feedbacks, das zur Bewertung der Modellausgabe verwendet wird.

Schritt 2: Trainieren Sie mithilfe eines von Menschen gekennzeichneten Datensatzes eine Belohnungsfunktion, um menschliches Feedback anhand von Bild- und Textaufforderungen vorherzusagen. Wir schlagen eine Hilfsaufgabe vor, um ursprüngliche Textaufforderungen aus einer Reihe gestörter Textaufforderungen zu identifizieren, um menschliches Feedback effektiver für das Belohnungslernen zu nutzen. Diese Technik verbessert die Verallgemeinerung der Belohnungsfunktion auf unsichtbare Bilder und Textaufforderungen.

Schritt 3: Aktualisieren Sie das Text-zu-Bild-Modell durch belohnungsgewichtete Wahrscheinlichkeitsmaximierung, um es besser an menschliches Feedback anzupassen. Im Gegensatz zu früheren Arbeiten, bei denen Reinforcement Learning zur Optimierung eingesetzt wurde, verwendeten die Forscher halbüberwachtes Lernen, um das Modell zu aktualisieren und die Qualität der Modellausgabe, also die erlernte Belohnungsfunktion, zu messen.

Die Forscher verwendeten 27.000 Bild-Text-Paare mit menschlichem Feedback, um das Stable Diffusion-Modell zu verfeinern. Die Ergebnisse zeigten, dass das fein abgestimmte Modell erhebliche Verbesserungen bei der Generierung von Objekten mit bestimmten Farben, Mengen usw. erzielte. und Hintergründe. Es wurde eine Verbesserung der Bild-Text-Ausrichtung um bis zu 47 % bei leichtem Verlust der Bildtreue erreicht.

Darüber hinaus wurden die kombinierten Generierungsergebnisse verbessert, um unsichtbare Objekte anhand einer Kombination aus unsichtbaren Farben, Mengen und Hintergrundaufforderungen besser zu generieren. Sie stellten außerdem fest, dass die erlernte Belohnungsfunktion besser mit den menschlichen Einschätzungen der Ausrichtung übereinstimmte als die CLIP-Werte bei Testtextaufforderungen.

Kimin Lee, der Erstautor des Papiers, sagte jedoch auch, dass die Ergebnisse dieses Papiers nicht alle Fehlermodelle im bestehenden Text-zu-Bild-Modell lösen und es noch viele Herausforderungen gebe. Sie hoffen, dass diese Arbeit das Potenzial des Lernens aus menschlichem Feedback bei der Ausrichtung von Vincent-Graphmodellen hervorheben wird.

Methodeneinführung

Um das generierte Bild an der Textaufforderung auszurichten, führte diese Studie eine Reihe von Feinabstimmungen am vorab trainierten Modell durch, und der Prozess ist siehe Abbildung 1 oben. Zuerst wurden entsprechende Bilder aus einer Reihe von Textaufforderungen generiert, ein Prozess, der darauf ausgelegt war, verschiedene Leistungen des vinzentinischen Graphenmodells zu testen. Anschließend gaben menschliche Bewerter binäres Feedback zu diesen generierten Bildern. Anschließend trainierte die Studie ein Belohnungsmodell, um menschliches Feedback vorherzusagen Textaufforderungen und Bilder als Eingabe; schließlich nutzt die Studie die belohnungsgewichtete Log-Likelihood, um das Vincent-Diagrammmodell zu verfeinern, um die Text-Bild-Ausrichtung zu verbessern.

Erhebung menschlicher Daten

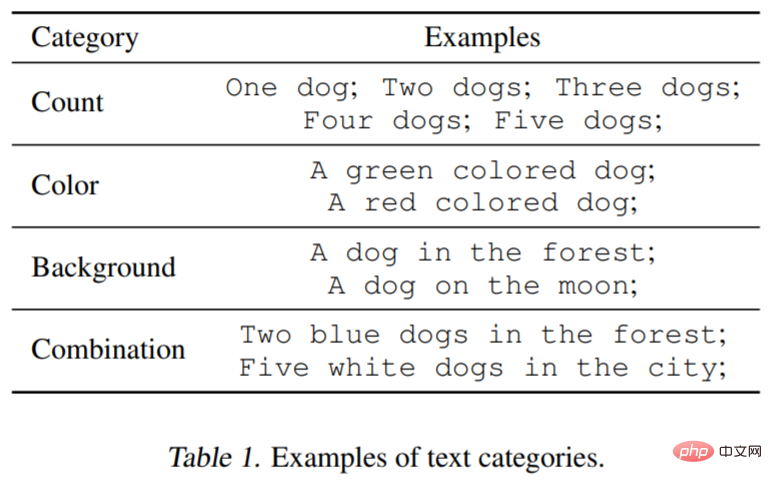

Um die Funktionalität von zu testen Basierend auf dem Vincent-Graphenmodell wurden in dieser Studie drei Arten von Textaufforderungen berücksichtigt: angegebene Anzahl, Farbe und Hintergrund. Für jede Kategorie generierte die Studie Eingabeaufforderungen, indem jedes Wort oder jede Phrase, die das Objekt beschrieb, wie z. B. Grün (Farbe) und ein Hund (Menge), gepaart wurden. Darüber hinaus berücksichtigte die Studie Kombinationen aus drei Kategorien (z. B. zwei grün gefärbte Hunde in einer Stadt). Tabelle 1 unten veranschaulicht die Datensatzklassifizierung besser. Jede Eingabeaufforderung wird zum Generieren von 60 Bildern verwendet, und das Modell ist hauptsächlich Stable Diffusion v1.5.

Menschlich. Feedback#🎜🎜 #

Als nächstes folgt menschliches Feedback zum generierten Bild. Drei von derselben Eingabeaufforderung generierte Bilder werden den Etikettierern vorgelegt und sie werden gebeten, zu bewerten, ob jedes generierte Bild mit der Eingabeaufforderung übereinstimmt, und die Bewertungskriterien werden gut oder schlecht sein. Da diese Aufgabe relativ einfach ist, reicht eine binäre Rückmeldung aus.

Belohnungslernen

Für die bessere Bewertung Die Bild-Text-Ausrichtung misst die Studie mithilfe einer Belohnungsfunktion  , die die CLIP-Einbettung von Bild x und Textaufforderung z auf Skalarwerte abbildet. Es wird dann verwendet, um menschliches Feedback k_y ∈ {0, 1} (1 = gut, 0 = schlecht) vorherzusagen.

, die die CLIP-Einbettung von Bild x und Textaufforderung z auf Skalarwerte abbildet. Es wird dann verwendet, um menschliches Feedback k_y ∈ {0, 1} (1 = gut, 0 = schlecht) vorherzusagen.

Formal gesehen ist die Belohnungsfunktion angesichts des menschlichen Feedback-Datensatzes D^human = {(x, z, y)} wird durch Minimierung des mittleren quadratischen Fehlers (MSE) trainiert:  Studien haben gezeigt, dass Datenerweiterungsmethoden die Dateneffizienz und Modelllernleistung erheblich verbessern können Um den Feedback-Datensatz effektiv zu nutzen, entwarf diese Studie ein einfaches Datenerweiterungsschema und Hilfsverluste für Belohnungslernen. Diese Studie verwendet erweiterte Eingabeaufforderungen in einer Hilfsaufgabe, d. h. das Klassifizierungsbelohnungslernen wird anhand der ursprünglichen Eingabeaufforderungen durchgeführt. Der Prompt-Klassifikator verwendet eine Belohnungsfunktion wie unten gezeigt: Aktualisieren Sie das Wensheng-Diagrammmodell. Da die Vielfalt des vom Modell generierten Datensatzes begrenzt ist, kann es zu einer Überanpassung kommen. Um dies abzumildern, minimierte die Studie auch den Verlust vor dem Training wie folgt:

Studien haben gezeigt, dass Datenerweiterungsmethoden die Dateneffizienz und Modelllernleistung erheblich verbessern können Um den Feedback-Datensatz effektiv zu nutzen, entwarf diese Studie ein einfaches Datenerweiterungsschema und Hilfsverluste für Belohnungslernen. Diese Studie verwendet erweiterte Eingabeaufforderungen in einer Hilfsaufgabe, d. h. das Klassifizierungsbelohnungslernen wird anhand der ursprünglichen Eingabeaufforderungen durchgeführt. Der Prompt-Klassifikator verwendet eine Belohnungsfunktion wie unten gezeigt: Aktualisieren Sie das Wensheng-Diagrammmodell. Da die Vielfalt des vom Modell generierten Datensatzes begrenzt ist, kann es zu einer Überanpassung kommen. Um dies abzumildern, minimierte die Studie auch den Verlust vor dem Training wie folgt:

Experimentelle Ergebnisse

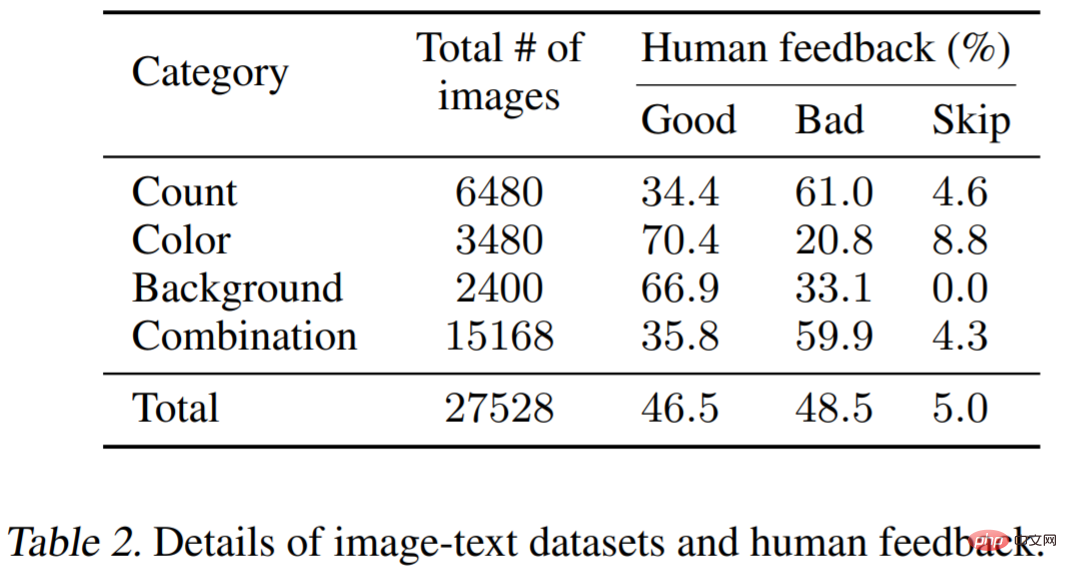

Der experimentelle Teil dient dazu, die Wirksamkeit des menschlichen Feedbacks zu testen, das an der Feinabstimmung des Modells beteiligt ist. Das im Experiment verwendete Modell ist Stable Diffusion v1.5; die Datensatzinformationen sind in Tabelle 1 (siehe oben) und Tabelle 2 aufgeführt. Tabelle 2 zeigt die Verteilung des Feedbacks, das von mehreren menschlichen Etikettierern bereitgestellt wird.

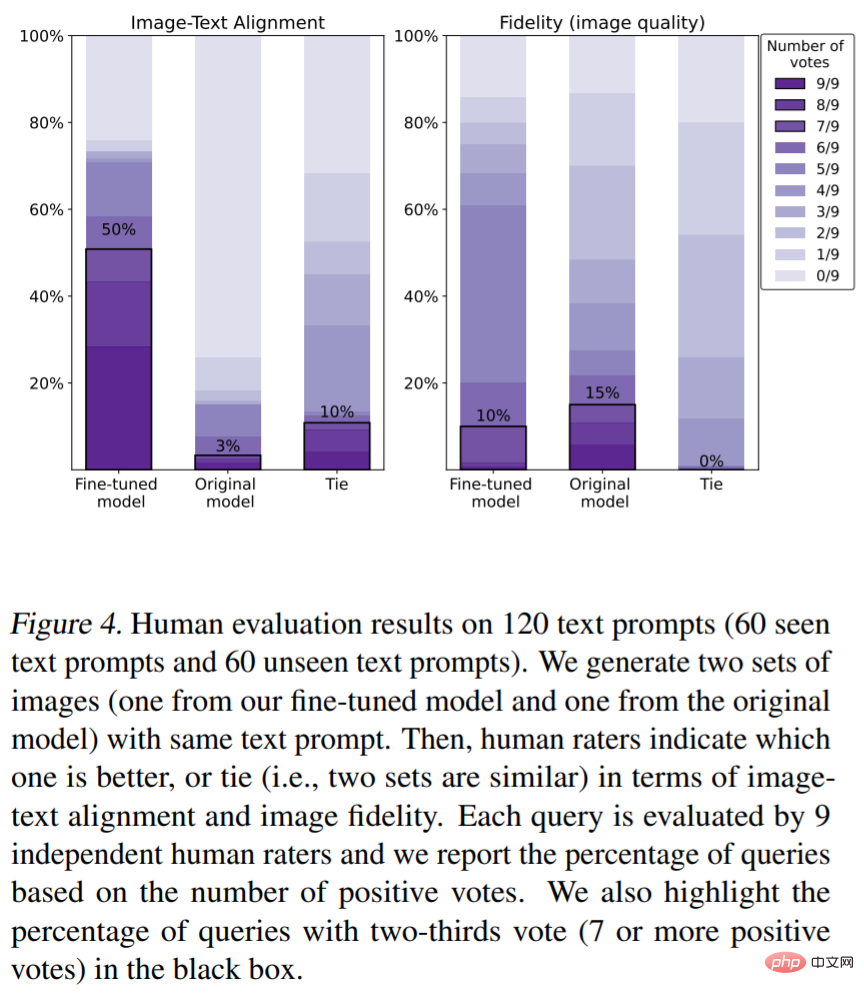

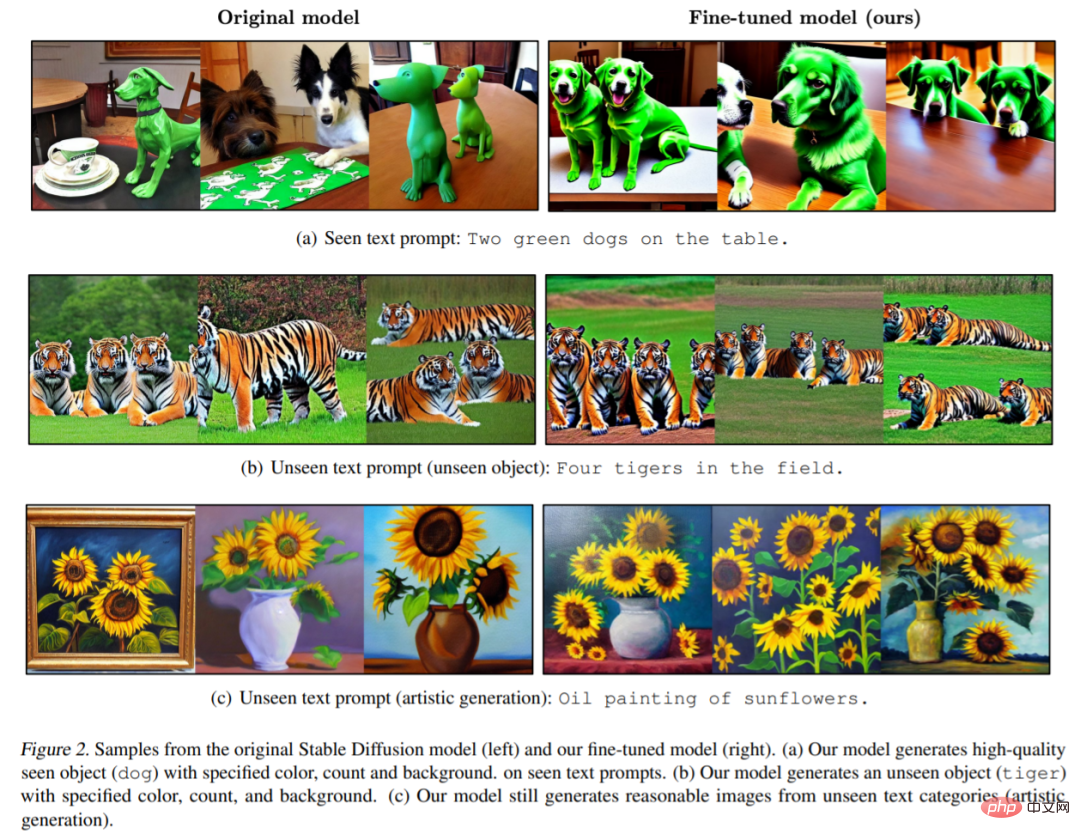

Menschliche Bewertungen der Text-Bild-Ausrichtung (Bewertungsmetriken sind Farbe, Anzahl). von Objekten). Wie in Abbildung 4 dargestellt, verbessert unsere Methode die Bild-Text-Ausrichtung erheblich. Insbesondere erhielten 50 % der vom Modell generierten Bilder mindestens zwei Drittel der Stimmen (die Anzahl der Stimmen betrug 7 oder mehr). Die Feinabstimmung verringert jedoch leicht die Bildtreue (15 % gegenüber 10 %). Abbildung 2 zeigt das entsprechende Modell des Originalmodells und die verfeinerte Version dieses Papierbildbeispiels. Es ist ersichtlich, dass das ursprüngliche Modell Bilder erzeugte, denen Details (wie Farbe, Hintergrund oder Anzahl) fehlten (Abbildung 2 (a)), und dass das von unserem Modell generierte Bild der durch die Eingabeaufforderung angegebenen Farbe, Anzahl und Hintergrund entspricht . Es ist erwähnenswert, dass unser Modell auch unsichtbare Textaufforderungsbilder mit sehr hoher Qualität erzeugen kann (Abbildung 2 (b)).

Belohnen Sie die Ergebnisse des Lernens. Abbildung 3(a) zeigt die Bewertungen des Modells für gesehene Textaufforderungen und unsichtbare Textaufforderungen. Belohnungen (grün) entsprechen eher typischen menschlichen Absichten als CLIP-Werte (rot).

Das obige ist der detaillierte Inhalt vonWas passiert beim Lernen von ChatGPT, wenn menschliches Feedback in die KI-Malerei eingeführt wird?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1380

1380

52

52

Ein tiefer Einblick in Modelle, Daten und Frameworks: eine ausführliche 54-seitige Übersicht über effiziente große Sprachmodelle

Jan 14, 2024 pm 07:48 PM

Ein tiefer Einblick in Modelle, Daten und Frameworks: eine ausführliche 54-seitige Übersicht über effiziente große Sprachmodelle

Jan 14, 2024 pm 07:48 PM

Large-Scale Language Models (LLMs) haben überzeugende Fähigkeiten bei vielen wichtigen Aufgaben bewiesen, darunter das Verständnis natürlicher Sprache, die Sprachgenerierung und das komplexe Denken, und hatten tiefgreifende Auswirkungen auf die Gesellschaft. Diese herausragenden Fähigkeiten erfordern jedoch erhebliche Schulungsressourcen (im linken Bild dargestellt) und lange Inferenzzeiten (im rechten Bild dargestellt). Daher müssen Forscher wirksame technische Mittel entwickeln, um ihre Effizienzprobleme zu lösen. Darüber hinaus wurden, wie auf der rechten Seite der Abbildung zu sehen ist, einige effiziente LLMs (LanguageModels) wie Mistral-7B erfolgreich beim Entwurf und Einsatz von LLMs eingesetzt. Diese effizienten LLMs können den Inferenzspeicher erheblich reduzieren und gleichzeitig eine ähnliche Genauigkeit wie LLaMA1-33B beibehalten

Das Stable Diffusion 3-Papier wird endlich veröffentlicht und die architektonischen Details werden enthüllt. Wird es helfen, Sora zu reproduzieren?

Mar 06, 2024 pm 05:34 PM

Das Stable Diffusion 3-Papier wird endlich veröffentlicht und die architektonischen Details werden enthüllt. Wird es helfen, Sora zu reproduzieren?

Mar 06, 2024 pm 05:34 PM

Der Artikel von StableDiffusion3 ist endlich da! Dieses Modell wurde vor zwei Wochen veröffentlicht und verwendet die gleiche DiT-Architektur (DiffusionTransformer) wie Sora. Nach seiner Veröffentlichung sorgte es für großes Aufsehen. Im Vergleich zur Vorgängerversion wurde die Qualität der von StableDiffusion3 generierten Bilder erheblich verbessert. Es unterstützt jetzt Eingabeaufforderungen mit mehreren Themen, und der Textschreibeffekt wurde ebenfalls verbessert, und es werden keine verstümmelten Zeichen mehr angezeigt. StabilityAI wies darauf hin, dass es sich bei StableDiffusion3 um eine Reihe von Modellen mit Parametergrößen von 800 M bis 8 B handelt. Durch diesen Parameterbereich kann das Modell direkt auf vielen tragbaren Geräten ausgeführt werden, wodurch der Einsatz von KI deutlich reduziert wird

Dieser Artikel reicht aus, um etwas über autonomes Fahren und Flugbahnvorhersage zu lesen!

Feb 28, 2024 pm 07:20 PM

Dieser Artikel reicht aus, um etwas über autonomes Fahren und Flugbahnvorhersage zu lesen!

Feb 28, 2024 pm 07:20 PM

Die Trajektorienvorhersage spielt eine wichtige Rolle beim autonomen Fahren. Unter autonomer Fahrtrajektorienvorhersage versteht man die Vorhersage der zukünftigen Fahrtrajektorie des Fahrzeugs durch die Analyse verschiedener Daten während des Fahrvorgangs. Als Kernmodul des autonomen Fahrens ist die Qualität der Trajektorienvorhersage von entscheidender Bedeutung für die nachgelagerte Planungssteuerung. Die Trajektorienvorhersageaufgabe verfügt über einen umfangreichen Technologie-Stack und erfordert Vertrautheit mit der dynamischen/statischen Wahrnehmung des autonomen Fahrens, hochpräzisen Karten, Fahrspurlinien, Fähigkeiten in der neuronalen Netzwerkarchitektur (CNN&GNN&Transformer) usw. Der Einstieg ist sehr schwierig! Viele Fans hoffen, so schnell wie möglich mit der Flugbahnvorhersage beginnen zu können und Fallstricke zu vermeiden. Heute werde ich eine Bestandsaufnahme einiger häufiger Probleme und einführender Lernmethoden für die Flugbahnvorhersage machen! Einführungsbezogenes Wissen 1. Sind die Vorschaupapiere in Ordnung? A: Schauen Sie sich zuerst die Umfrage an, S

DualBEV: BEVFormer und BEVDet4D deutlich übertreffen, öffnen Sie das Buch!

Mar 21, 2024 pm 05:21 PM

DualBEV: BEVFormer und BEVDet4D deutlich übertreffen, öffnen Sie das Buch!

Mar 21, 2024 pm 05:21 PM

In diesem Artikel wird das Problem der genauen Erkennung von Objekten aus verschiedenen Blickwinkeln (z. B. Perspektive und Vogelperspektive) beim autonomen Fahren untersucht, insbesondere wie die Transformation von Merkmalen aus der Perspektive (PV) in den Raum aus der Vogelperspektive (BEV) effektiv ist implementiert über das Modul Visual Transformation (VT). Bestehende Methoden lassen sich grob in zwei Strategien unterteilen: 2D-zu-3D- und 3D-zu-2D-Konvertierung. 2D-zu-3D-Methoden verbessern dichte 2D-Merkmale durch die Vorhersage von Tiefenwahrscheinlichkeiten, aber die inhärente Unsicherheit von Tiefenvorhersagen, insbesondere in entfernten Regionen, kann zu Ungenauigkeiten führen. Während 3D-zu-2D-Methoden normalerweise 3D-Abfragen verwenden, um 2D-Features abzutasten und die Aufmerksamkeitsgewichte der Korrespondenz zwischen 3D- und 2D-Features über einen Transformer zu lernen, erhöht sich die Rechen- und Bereitstellungszeit.

Das erste Weltmodell zur Erzeugung autonomer Fahrszenen mit mehreren Ansichten | DrivingDiffusion: Neue Ideen für BEV-Daten und Simulation

Oct 23, 2023 am 11:13 AM

Das erste Weltmodell zur Erzeugung autonomer Fahrszenen mit mehreren Ansichten | DrivingDiffusion: Neue Ideen für BEV-Daten und Simulation

Oct 23, 2023 am 11:13 AM

Einige persönliche Gedanken des Autors Im Bereich des autonomen Fahrens sind mit der Entwicklung BEV-basierter Teilaufgaben/End-to-End-Lösungen hochwertige Multi-View-Trainingsdaten und der entsprechende Aufbau von Simulationsszenen immer wichtiger geworden. Als Reaktion auf die Schwachstellen aktueller Aufgaben kann „hohe Qualität“ in drei Aspekte zerlegt werden: Long-Tail-Szenarien in verschiedenen Dimensionen: z. B. Nahbereichsfahrzeuge in Hindernisdaten und präzise Kurswinkel beim Schneiden von Autos sowie Spurliniendaten . Szenen wie Kurven mit unterschiedlichen Krümmungen oder Rampen/Zusammenführungen/Zusammenführungen, die schwer zu erfassen sind. Diese basieren häufig auf der Sammlung großer Datenmengen und komplexen Data-Mining-Strategien, die kostspielig sind. Echter 3D-Wert – hochkonsistentes Bild: Die aktuelle BEV-Datenerfassung wird häufig durch Fehler bei der Sensorinstallation/-kalibrierung, hochpräzisen Karten und dem Rekonstruktionsalgorithmus selbst beeinträchtigt. das hat mich dazu geführt

„Minecraft' verwandelt sich in eine KI-Stadt und NPC-Bewohner spielen Rollenspiele wie echte Menschen

Jan 02, 2024 pm 06:25 PM

„Minecraft' verwandelt sich in eine KI-Stadt und NPC-Bewohner spielen Rollenspiele wie echte Menschen

Jan 02, 2024 pm 06:25 PM

Bitte beachten Sie, dass dieser kantige Mann die Stirn runzelt und über die Identität der „ungebetenen Gäste“ vor ihm nachdenkt. Es stellte sich heraus, dass sie sich in einer gefährlichen Situation befand, und als ihr dies klar wurde, begann sie schnell mit der mentalen Suche nach einer Strategie zur Lösung des Problems. Letztendlich entschloss sie sich, vom Unfallort zu fliehen, dann so schnell wie möglich Hilfe zu suchen und sofort Maßnahmen zu ergreifen. Gleichzeitig dachte die Person auf der Gegenseite das Gleiche wie sie... In „Minecraft“ gab es eine solche Szene, in der alle Charaktere von künstlicher Intelligenz gesteuert wurden. Jeder von ihnen hat eine einzigartige Identität. Das zuvor erwähnte Mädchen ist beispielsweise eine 17-jährige, aber kluge und mutige Kurierin. Sie haben die Fähigkeit, sich zu erinnern und zu denken und in dieser kleinen Stadt in Minecraft wie Menschen zu leben. Was sie antreibt, ist ein brandneues,

I2V-Adapter aus der SD-Community: keine Konfiguration erforderlich, Plug-and-Play, perfekt kompatibel mit dem Tusheng-Video-Plug-in

Jan 15, 2024 pm 07:48 PM

I2V-Adapter aus der SD-Community: keine Konfiguration erforderlich, Plug-and-Play, perfekt kompatibel mit dem Tusheng-Video-Plug-in

Jan 15, 2024 pm 07:48 PM

Die Aufgabe der Bild-zu-Video-Generierung (I2V) ist eine Herausforderung im Bereich Computer Vision, die darauf abzielt, statische Bilder in dynamische Videos umzuwandeln. Die Schwierigkeit dieser Aufgabe besteht darin, dynamische Informationen in der zeitlichen Dimension aus einem einzelnen Bild zu extrahieren und zu generieren und dabei die Authentizität und visuelle Kohärenz des Bildinhalts zu wahren. Bestehende I2V-Methoden erfordern häufig komplexe Modellarchitekturen und große Mengen an Trainingsdaten, um dieses Ziel zu erreichen. Kürzlich wurde ein neues Forschungsergebnis „I2V-Adapter: AGeneralImage-to-VideoAdapter for VideoDiffusionModels“ unter der Leitung von Kuaishou veröffentlicht. Diese Forschung stellt eine innovative Bild-zu-Video-Konvertierungsmethode vor und schlägt ein leichtes Adaptermodul vor, d. h.

Rezension! Tiefe Modellfusion (LLM/Basismodell/Verbundlernen/Feinabstimmung usw.)

Apr 18, 2024 pm 09:43 PM

Rezension! Tiefe Modellfusion (LLM/Basismodell/Verbundlernen/Feinabstimmung usw.)

Apr 18, 2024 pm 09:43 PM

Am 23. September wurde das Papier „DeepModelFusion:ASurvey“ von der National University of Defense Technology, JD.com und dem Beijing Institute of Technology veröffentlicht. Deep Model Fusion/Merging ist eine neue Technologie, die die Parameter oder Vorhersagen mehrerer Deep-Learning-Modelle in einem einzigen Modell kombiniert. Es kombiniert die Fähigkeiten verschiedener Modelle, um die Verzerrungen und Fehler einzelner Modelle zu kompensieren und so eine bessere Leistung zu erzielen. Die tiefe Modellfusion bei groß angelegten Deep-Learning-Modellen (wie LLM und Basismodellen) steht vor einigen Herausforderungen, darunter hohe Rechenkosten, hochdimensionaler Parameterraum, Interferenzen zwischen verschiedenen heterogenen Modellen usw. Dieser Artikel unterteilt bestehende Methoden zur Tiefenmodellfusion in vier Kategorien: (1) „Musterverbindung“, die Lösungen im Gewichtsraum über einen verlustreduzierenden Pfad verbindet, um eine bessere anfängliche Modellfusion zu erzielen