Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

NVIDIA nutzt KI, um GPU-Rechenschaltungen zu entwerfen, die die Fläche im Vergleich zum fortschrittlichsten EDA um 25 % reduzieren und ihn so schneller und effizienter machen

NVIDIA nutzt KI, um GPU-Rechenschaltungen zu entwerfen, die die Fläche im Vergleich zum fortschrittlichsten EDA um 25 % reduzieren und ihn so schneller und effizienter machen

NVIDIA nutzt KI, um GPU-Rechenschaltungen zu entwerfen, die die Fläche im Vergleich zum fortschrittlichsten EDA um 25 % reduzieren und ihn so schneller und effizienter machen

Eine riesige Auswahl an Rechenschaltungen treibt NVIDIA-GPUs an, um eine beispiellose Beschleunigung von KI, Hochleistungsrechnen und Computergrafik zu ermöglichen. Daher ist die Verbesserung des Designs dieser Rechenschaltungen von entscheidender Bedeutung für die Verbesserung der GPU-Leistung und -Effizienz. Was wäre, wenn die KI lernen würde, diese Schaltkreise zu entwerfen? In einem aktuellen NVIDIA-Artikel mit dem Titel „PrefixRL: Optimization of Parallel Prefix Circuits using Deep Reinforcement Learning“ haben Forscher gezeigt, dass KI diese Schaltkreise nicht nur von Grund auf entwerfen kann, sondern auch, dass von KI entworfene Schaltkreise besser sind als solche, die von hochmodernen Schaltkreisen entworfen wurden. Modernste EDA-Tools (Electronic Design Automation) sind kleiner und schneller.

Papieradresse: https://arxiv.org/pdf/2205.07000.pdf#🎜 🎜#

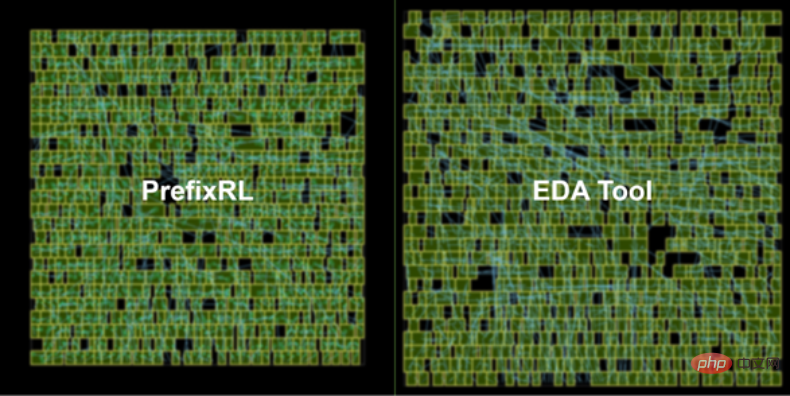

Die neueste NVIDIA Hopper GPU-Architektur verfügt über fast 13.000 von KI entworfene Schaltungsbeispiele. Abbildung 1 unten: Die von PrefixRL AI entworfene 64b-Addiererschaltung auf der linken Seite ist 25 % kleiner als die vom fortschrittlichsten EDA-Tool entworfene Schaltung auf der rechten Seite von Abbildung 1.

Computerchip Arithmetische Schaltkreise in Computern bestehen aus Netzwerken von Logikgattern (wie NAND, NOR und XOR) und Drähten. Ein idealer Schaltkreis sollte die folgenden Eigenschaften haben:

- Klein: kleinere Fläche, mehr Schaltkreise können auf dem Chip untergebracht werden; #Schnell: geringere Latenz, verbesserte Chipleistung;

- geringerer Stromverbrauch.

- In dieser NVIDIA-Studie konzentrierten sich die Forscher auf die Schaltungsfläche und die Latenz. Sie fanden heraus, dass der Stromverbrauch eng mit dem Bereich der interessierenden Schaltung zusammenhängt. Schaltungsfläche und Verzögerung sind oft konkurrierende Eigenschaften, daher ist es wünschenswert, die Pareto-Grenze für einen Entwurf zu finden, der diese Eigenschaften effektiv ausgleicht. Kurz gesagt hoffen die Forscher, dass die Schaltungsfläche für jede Verzögerung minimiert wird.

Deshalb konzentrieren sich Forscher in PrefixRL auf eine beliebte Klasse von Rechenschaltungen – parallele Präfixschaltungen. Verschiedene wichtige Schaltkreise in der GPU, wie Beschleuniger, Inkremente und Encoder, sind Präfixschaltkreise und können auf einer höheren Ebene als Präfixgraphen bezeichnet werden.

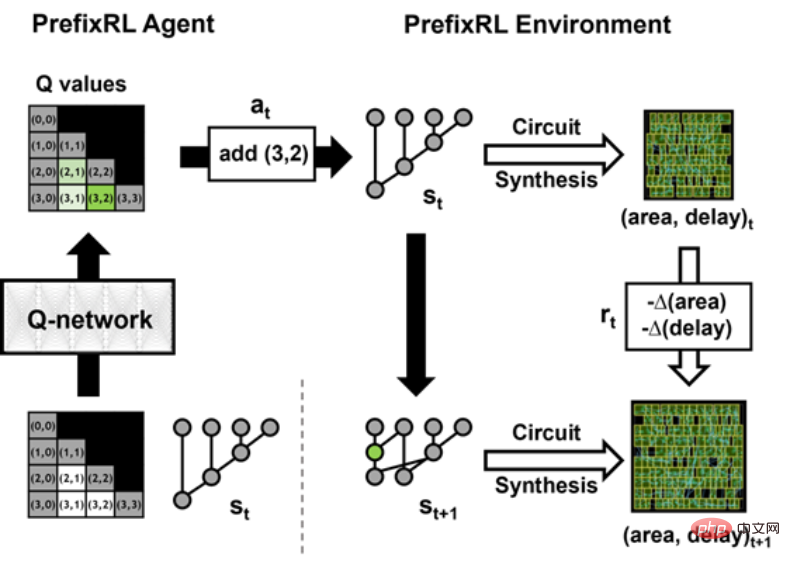

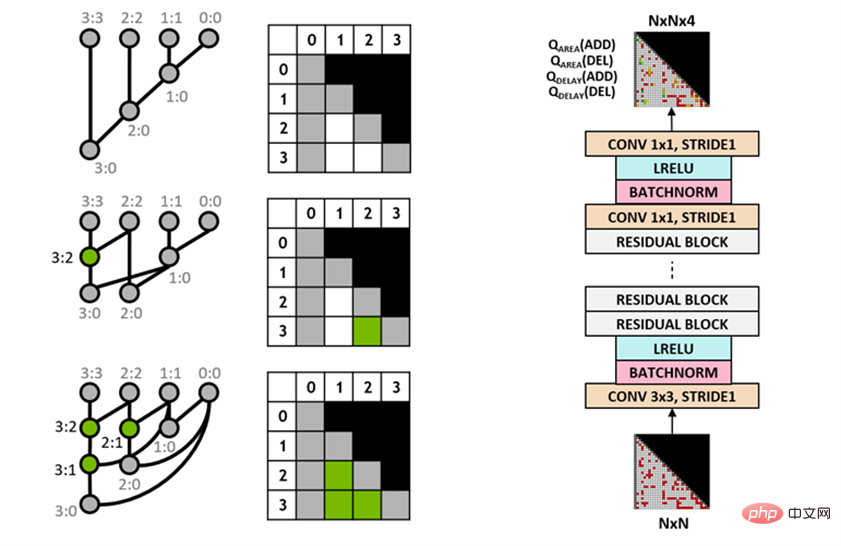

Dann stellt sich die Frage: Können KI-Agenten gute Präfixkarten entwerfen? Der Zustandsraum aller Präfixgraphen ist sehr groß O(2^n^n) und kann nicht mit Brute-Force-Methoden untersucht werden. Abbildung 2 unten zeigt eine Iteration von PrefixRL mit einer 4b-Schaltungsinstanz. Die Forscher verwendeten den Circuit Generator, um das Präfixdiagramm in einen Schaltkreis mit Drähten und Logikgattern umzuwandeln. Als nächstes werden diese generierten Schaltkreise durch ein physikalisches Synthesetool optimiert, das physikalische Syntheseoptimierungen wie Gate-Größe, Duplizierung und Puffereinfügung nutzt.

Aufgrund dieser Optimierungen der physikalischen Synthese werden die endgültigen Schaltungseigenschaften (Verzögerung, Fläche und Leistung) nicht direkt aus den ursprünglichen Eigenschaften des Präfixdiagramms (wie Pegel und) konvertiert Anzahl der Knoten) Komm. Aus diesem Grund lernt der KI-Agent, Präfixdiagramme zu entwerfen, optimiert jedoch die Eigenschaften der endgültigen Schaltung, die aus den Präfixdiagrammen generiert wird.

Arithmetik Schaltungsdesign als Reinforcement Learning (RL)-Aufgabe, bei der ein Agent trainiert wird, #🎜🎜 # zu optimieren Arithmetik Flächen- und Verzögerungseigenschaften von Schaltkreisen. Für die Präfixschaltung haben sie eine Umgebung entworfen, in der der RL-Agent Knoten im Präfixdiagramm hinzufügen oder entfernen und dann die folgenden Schritte ausführen kann: Diagramme werden normalisiert, um stets das korrekte Präfix und die korrekte Berechnung beizubehalten Syntheseoptimierung der Schaltung;

Messen Sie die Fläche und Verzögerungseigenschaften der Schaltung.

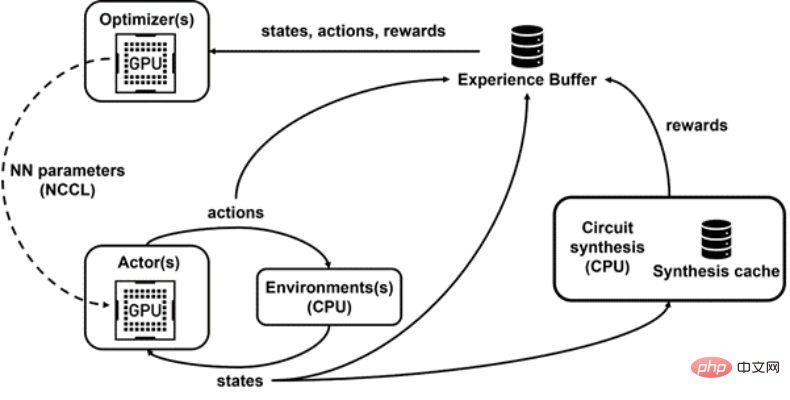

In der folgenden Animation baut der RL-Agent Schritt für Schritt den Präfixgraphen auf, indem er Knoten hinzufügt oder löscht. Bei jedem Schritt wird der Agent mit Verbesserungen bei der Leitungsfläche und der Latenz belohnt. Das Originalbild ist eine interaktive Version. Forscher verwenden Q-Learning-Algorithmus (Q-Learning), um das Design der Agentenschaltung zu trainieren. Wie in Abbildung 3 unten dargestellt, zerlegen sie das Präfixdiagramm in eine Rasterdarstellung, wobei jedes Element im Raster eindeutig einem Präfixknoten zugeordnet ist. Dieses Raster stellt die Ein- und Ausgänge dar, die für das Q-Netzwerk verwendet werden. Jedes Element im Eingaberaster stellt dar, ob der Knoten vorhanden ist oder nicht. Jedes Element im Ausgaberaster stellt den Q-Wert beim Hinzufügen oder Entfernen eines Knotens dar. Abbildung 3: 4b-Präfixdiagrammdarstellung (links) und vollständig faltende Q-Learning-Agentenarchitektur (rechts). PrefixRL ist rechenintensiv, erfordert in einer Physiksimulation 256 CPUs pro GPU und das Training einer 64b-Aufgabe erforderte über 32.000 GPU-Stunden. Dieses Mal hat NVIDIA mit Raptor eine interne verteilte Reinforcement-Learning-Plattform entwickelt, die die Hardwarevorteile von NVIDIA voll ausnutzt, um diese Art von Reinforcement-Learning auf industrieller Ebene durchzuführen (Abbildung 4 unten). Schließlich stellt Raptor GPU-fähige Datenstrukturen wie Wiedergabepuffer mit Multithread-Diensten bereit, um Erfahrungen von mehreren Arbeitern zu empfangen, Daten parallel zu stapeln und sie vorab auf die GPU zu laden. Abbildung 4: Forscher verwenden Raptor, um paralleles Training und Belohnungsberechnung zu entkoppeln, um Verzögerungen bei der Schaltkreissynthese zu überwinden. Die Forscher verwendeten ein Kompromissgewicht w (Bereich [0,1]), um die Flächen- und Verzögerungsziele zu kombinieren. Sie trainieren verschiedene Agenten mit unterschiedlichen Gewichten, um Pareto-Grenzen zu erhalten und so den Kompromiss zwischen Fläche und Latenz auszugleichen. Allerdings ist die Durchführung der physikalischen Synthese ein langsamer Prozess (~35 Sekunden für den 64b-Addierer), der das RL-Training und die Erkundung erheblich verlangsamen kann. Abbildung 5 unten zeigt die Fläche und Verzögerung der 64b-Addiererschaltung, die mit PrefixRL und der Pareto-dominierten Addiererschaltung der fortschrittlichsten EDA-Tools entwickelt wurde. Abbildung 5: Von PrefixRL entworfene Rechenschaltungen sind kleiner und schneller als von hochmodernen EDA-Tools entworfene Schaltungen. (links) Schaltungsarchitektur; (rechts) entsprechendes 64b-Addierer-Schaltkreis-Merkmalsdiagramm Es versteht sich, dass dies die erste Methode ist, bei der Deep Reinforcement Learning-Agenten zum Entwerfen arithmetischer Schaltkreise verwendet werden. NVIDIA stellt sich einen Entwurf für die Anwendung von KI auf reale Schaltungsdesignprobleme, den Aufbau von Aktionsräumen, Zustandsdarstellungen und RL-Agentenmodellen, die Optimierung für mehrere konkurrierende Ziele und die Überwindung langsamer Belohnungsberechnungen vor.

Vollständig faltender Q-Learning-Agent

Die Forscher haben eine vollständig faltende neuronale Netzwerkarchitektur übernommen, da die Eingabe und Ausgabe des Q-Learning-Agenten Gitterdarstellungen sind. Der Agent sagt Q-Werte für die Flächen- und Verzögerungsattribute getrennt voraus, da die Belohnungen für Fläche und Verzögerung während des Trainings separat beobachtbar sind.

Raptor für verteiltes Training

Raptor kann die Skalierbarkeit und Trainingsgeschwindigkeit von Trainingsmodellen verbessern, z. B. Jobplanung, benutzerdefinierte Netzwerke und GPU-fähige Datenstrukturen. Im Kontext von PrefixRL ermöglicht Raptor die hybride Zuweisung zwischen CPUs, GPUs und Spot-Instances. Die Netzwerke in dieser Reinforcement-Learning-Anwendung sind vielfältig und profitieren von Folgendem:

Abbildung 4 unten zeigt, dass das PrefixRL-Framework gleichzeitiges Training und Datenerfassung unterstützt und NCCL nutzt, um die neuesten Parameter effizient an die Teilnehmer (Akteure in der Abbildung unten) zu senden.

Belohnungsberechnung

Physisch synthetisierte Optimierung in einer RL-Umgebung kann verschiedene Lösungen generieren, die einen Kompromiss zwischen Fläche und Latenz eingehen. Forscher steuern physikalische Synthesewerkzeuge unter Verwendung der gleichen Kompromissgewichte, die auch zum Trainieren spezifischer Agenten verwendet werden.

Die Durchführung der physikalischen Syntheseoptimierung in der Schleife der Belohnungsberechnung hat die folgenden Vorteile:

Forscher entkoppeln die Belohnungsberechnung von Statusaktualisierungen, da der Agent nur den aktuellen Status des Präfixdiagramms benötigt, um Maßnahmen zu ergreifen, ohne Schaltkreissynthese oder vorherige Belohnungen. Dank Raptor können sie langwierige Belohnungsberechnungen auf einen Pool von CPU-Workern verlagern, um parallel physikalische Synthesen durchzuführen, während Akteuragenten die Ausführung in der Umgebung ohne Wartezeiten durchführen können.

Wenn der CPU-Worker die Belohnung zurückgibt, kann die Transformation in den Wiedergabepuffer eingebettet werden. Umfassende Belohnungen werden zwischengespeichert, um redundante Berechnungen zu vermeiden, wenn ein Zustand erneut auftritt. Ergebnisse und Ausblick

Die besten PrefixRL-Addierer erreichen bei gleicher Latenz 25 % weniger Fläche als EDA-Tool-Addierer. Diese Präfixgraphen, die nach der Optimierung der physikalischen Synthese auf Pareto-optimale Addiererschaltungen abgebildet werden, weisen unregelmäßige Strukturen auf.

Das obige ist der detaillierte Inhalt vonNVIDIA nutzt KI, um GPU-Rechenschaltungen zu entwerfen, die die Fläche im Vergleich zum fortschrittlichsten EDA um 25 % reduzieren und ihn so schneller und effizienter machen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem völlig kostenlosen KI-Gesichtstausch-Tool aus!

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1393

1393

52

52

1209

1209

24

24

Web3 Trading Platform Ranking_Web3 Globale Top Ten Summary Top Ten Summary

Apr 21, 2025 am 10:45 AM

Web3 Trading Platform Ranking_Web3 Globale Top Ten Summary Top Ten Summary

Apr 21, 2025 am 10:45 AM

Binance ist der Overlord des Global Digital Asset Trading -Ökosystems, und seine Merkmale umfassen: 1. Das durchschnittliche tägliche Handelsvolumen übersteigt 150 Milliarden US -Dollar, unterstützt 500 Handelspaare, die 98% der Mainstream -Währungen abdecken. 2. Die Innovationsmatrix deckt den Markt für Derivate, das Web3 -Layout und den Bildungssystem ab; 3. Die technischen Vorteile sind Millisekunden -Matching -Engines mit Spitzenvolumina von 1,4 Millionen Transaktionen pro Sekunde. 4. Compliance Progress hält 15 Länderlizenzen und legt konforme Einheiten in Europa und den Vereinigten Staaten ein.

Worldcoin (WLD) Preisprognose 2025-2031: Wird WLD bis 2031 $ erreichen?

Apr 21, 2025 pm 02:42 PM

Worldcoin (WLD) Preisprognose 2025-2031: Wird WLD bis 2031 $ erreichen?

Apr 21, 2025 pm 02:42 PM

Worldcoin (WLD) fällt auf dem Kryptowährungsmarkt mit seinen einzigartigen biometrischen Überprüfungs- und Datenschutzschutzmechanismen auf, die die Aufmerksamkeit vieler Investoren auf sich ziehen. WLD hat mit seinen innovativen Technologien, insbesondere in Kombination mit OpenAI -Technologie für künstliche Intelligenz, außerdem unter Altcoins gespielt. Aber wie werden sich die digitalen Vermögenswerte in den nächsten Jahren verhalten? Lassen Sie uns den zukünftigen Preis von WLD zusammen vorhersagen. Die Preisprognose von 2025 WLD wird voraussichtlich im Jahr 2025 ein signifikantes Wachstum in WLD erzielen. Die Marktanalyse zeigt, dass der durchschnittliche WLD -Preis 1,31 USD mit maximal 1,36 USD erreichen kann. In einem Bärenmarkt kann der Preis jedoch auf rund 0,55 US -Dollar fallen. Diese Wachstumserwartung ist hauptsächlich auf Worldcoin2 zurückzuführen.

Rangliste der Hebelbörsen im Währungskreis Die neuesten Empfehlungen der zehn meistgezogenen Börsen im Währungskreis

Apr 21, 2025 pm 11:24 PM

Rangliste der Hebelbörsen im Währungskreis Die neuesten Empfehlungen der zehn meistgezogenen Börsen im Währungskreis

Apr 21, 2025 pm 11:24 PM

Die Plattformen, die im Jahr 2025 im Leveraged Trading, Security und Benutzererfahrung hervorragende Leistung haben, sind: 1. OKX, geeignet für Hochfrequenzhändler und bieten bis zu 100-fache Hebelwirkung; 2. Binance, geeignet für Mehrwährungshändler auf der ganzen Welt und bietet 125-mal hohe Hebelwirkung; 3. Gate.io, geeignet für professionelle Derivate Spieler, die 100 -fache Hebelwirkung bietet; 4. Bitget, geeignet für Anfänger und Sozialhändler, die bis zu 100 -fache Hebelwirkung bieten; 5. Kraken, geeignet für stetige Anleger, die fünfmal Hebelwirkung liefert; 6. Bybit, geeignet für Altcoin -Entdecker, die 20 -fache Hebelwirkung bietet; 7. Kucoin, geeignet für kostengünstige Händler, die 10-fache Hebelwirkung bietet; 8. Bitfinex, geeignet für das Seniorenspiel

Was bedeutet Cross-Chain-Transaktion? Was sind die Cross-Chain-Transaktionen?

Apr 21, 2025 pm 11:39 PM

Was bedeutet Cross-Chain-Transaktion? Was sind die Cross-Chain-Transaktionen?

Apr 21, 2025 pm 11:39 PM

Börsen, die Cross-Chain-Transaktionen unterstützen: 1. Binance, 2. Uniswap, 3. Sushiswap, 4. Kurvenfinanzierung, 5. Thorchain, 6. 1inch Exchange, 7. DLN-Handel, diese Plattformen unterstützen Multi-Chain-Asset-Transaktionen durch verschiedene Technologien.

Warum ist der Anstieg oder Abfall der virtuellen Währungspreise? Warum ist der Anstieg oder Abfall der virtuellen Währungspreise?

Apr 21, 2025 am 08:57 AM

Warum ist der Anstieg oder Abfall der virtuellen Währungspreise? Warum ist der Anstieg oder Abfall der virtuellen Währungspreise?

Apr 21, 2025 am 08:57 AM

Faktoren der steigenden Preise für virtuelle Währung sind: 1. Erhöhte Marktnachfrage, 2. Verringertes Angebot, 3.. Rückgangsfaktoren umfassen: 1. Verringerte Marktnachfrage, 2. Erhöhtes Angebot, 3. Streik der negativen Nachrichten, 4. Pessimistische Marktstimmung, 5. makroökonomisches Umfeld.

Top 10 Cryptocurrency Exchange -Plattformen Die weltweit größte Liste der digitalen Währung

Apr 21, 2025 pm 07:15 PM

Top 10 Cryptocurrency Exchange -Plattformen Die weltweit größte Liste der digitalen Währung

Apr 21, 2025 pm 07:15 PM

Börsen spielen eine wichtige Rolle auf dem heutigen Kryptowährungsmarkt. Sie sind nicht nur Plattformen, an denen Investoren handeln, sondern auch wichtige Quellen für Marktliquidität und Preisentdeckung. Der weltweit größte virtuelle Währungsbörsen gehören zu den Top Ten, und diese Börsen sind nicht nur im Handelsvolumen weit voraus, sondern haben auch ihre eigenen Vorteile in Bezug auf Benutzererfahrung, Sicherheit und innovative Dienste. Börsen, die über die Liste stehen, haben normalerweise eine große Benutzerbasis und einen umfangreichen Markteinfluss, und deren Handelsvolumen und Vermögenstypen sind häufig mit anderen Börsen schwer zu erreichen.

Was sind die zehn besten Plattformen im Währungsaustauschkreis?

Apr 21, 2025 pm 12:21 PM

Was sind die zehn besten Plattformen im Währungsaustauschkreis?

Apr 21, 2025 pm 12:21 PM

Zu den Top -Börsen gehören: 1. Binance, das weltweit größte Handelsvolumen, unterstützt 600 Währungen und die Spot -Handhabungsgebühr beträgt 0,1%. 2. OKX, eine ausgewogene Plattform, unterstützt 708 Handelspaare, und die dauerhafte Vertragsabwicklungsgebühr beträgt 0,05%. 3. Gate.io deckt 2700 kleine Währungen ab, und die Gebühr für die Spot-Handhabung beträgt 0,1%-0,3%; 4. Coinbase, der US -Konformitäts -Benchmark, die Spot -Handhabungsgebühr beträgt 0,5%; 5. Kraken, die Top -Sicherheit und regelmäßige Reserveprüfung.

So gewinnen Sie Kernel Airdrop -Belohnungen für Binance vollständige Prozessstrategie

Apr 21, 2025 pm 01:03 PM

So gewinnen Sie Kernel Airdrop -Belohnungen für Binance vollständige Prozessstrategie

Apr 21, 2025 pm 01:03 PM

In der geschäftigen Welt der Kryptowährungen entstehen immer neue Möglichkeiten. Gegenwärtig zieht Kerneldao (Kernel) Airdrop -Aktivität viel Aufmerksamkeit auf sich und zieht die Aufmerksamkeit vieler Investoren auf sich. Also, was ist der Ursprung dieses Projekts? Welche Vorteile können BNB -Inhaber davon bekommen? Machen Sie sich keine Sorgen, das Folgende wird es einzeln für Sie enthüllen.