Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Diffusion + Zielerkennung = kontrollierbare Bilderzeugung! Das chinesische Team schlug GLIGEN vor, um die räumliche Position von Objekten perfekt zu steuern

Diffusion + Zielerkennung = kontrollierbare Bilderzeugung! Das chinesische Team schlug GLIGEN vor, um die räumliche Position von Objekten perfekt zu steuern

Diffusion + Zielerkennung = kontrollierbare Bilderzeugung! Das chinesische Team schlug GLIGEN vor, um die räumliche Position von Objekten perfekt zu steuern

Mit der Open Source von Stable Diffusion ist die Verwendung natürlicher Sprache zur Bilderzeugung nach und nach populär geworden, und es wurden auch viele AIGC-Probleme aufgedeckt, wie zum Beispiel, dass KI keine Hände zeichnen, Handlungsbeziehungen nicht verstehen kann und schwer zu kontrollieren ist Position von Objekten usw.

Der Hauptgrund ist, dass die „Eingabeschnittstelle“ nur über natürliche Sprache verfügt und keine feine Steuerung des Bildschirms erreichen kann.

Kürzlich haben Forschungs-Hotspots der University of Wisconsin-Madison, der Columbia University und Microsoft eine brandneue Methode GLIGEN vorgeschlagen, die die Funktionalität des bestehenden „vorab trainierten Text-zu-Bild-Diffusionsmodells“ basierend auf Erdungseingaben erweitert.

Papierlink: https://arxiv.org/pdf/2301.07093.pdf

Projekthomepage: https://gligen.github.io/

Erfahrungslink: https://huggingface.co/spaces/gligen/demo

Um einen großen Teil des konzeptionellen Wissens des vorab trainierten Modells beizubehalten, haben sich die Forscher nicht für eine Feinabstimmung des Modells entschieden , sondern verwendete stattdessen den Gating-Mechanismus, um die Eingabe weiterzugeben. Verschiedene Erdungsbedingungen werden in neue trainierbare Schichten eingefügt, um die Kontrolle über die Bilderzeugung in der offenen Welt zu erreichen.

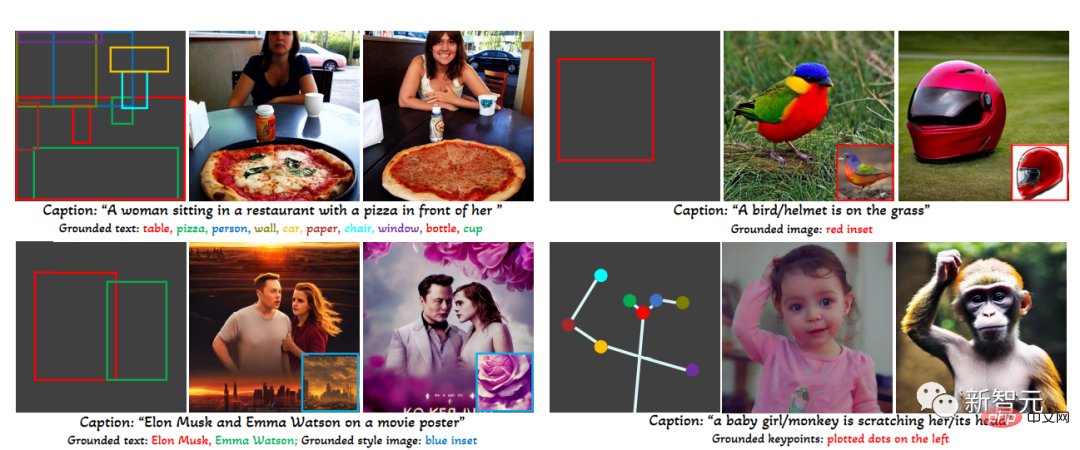

Derzeit unterstützt GLIGEN vier Eingänge.

(oben links) Textelement + Feld (oben rechts) Bildelement + Feld

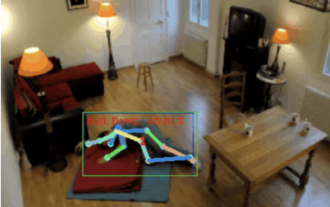

(unten links) Bildstil + Text + Feld (unten rechts) Textelement + Schlüssel Punkt

Experimentelle Ergebnisse zeigen auch, dass die Zero-Shot-Leistung von GLIGEN auf COCO und LVIS viel besser ist als die aktuell überwachte Layout-zu-Bild-Basislinie.

Kontrollierbare Bildgenerierung

Vor dem Diffusionsmodell waren generative kontradiktorische Netzwerke (GANs) immer führend auf dem Gebiet der Bildgenerierung, und ihr latenter Raum und ihre bedingte Eingabe wurden vollständig in Form von „kontrollierbaren Operationen“ implementiert. und „Generationen“-Forschung.

Textbedingte autoregressive Modelle und Diffusionsmodelle zeigen dank ihrer stabileren Lernziele und umfangreichen Schulungen zu Netzwerk-Bild-Text-gepaarten Daten eine erstaunliche Bildqualität und Konzeptabdeckung und verlassen schnell den Kreis und werden zu Hilfsmitteln in Kunstdesign und Kreation.

Bestehende groß angelegte Text-Bild-Generierungsmodelle können jedoch nicht auf andere Eingabemodi „über Text hinaus“ konditioniert werden. Ihnen fehlt die Fähigkeit, Konzepte genau zu lokalisieren oder Referenzbilder zur Steuerung des Generierungsprozesses zu verwenden, was den Ausdruck einschränkt Information.

Zum Beispiel ist es schwierig, die genaue Position eines Objekts mithilfe von Text zu beschreiben, aber Begrenzungsrahmen oder Schlüsselpunkte können leicht erreicht werden.

Einige vorhandene Tools wie Inpainting, Layout2img-Generierung usw. können andere modale Eingaben als Text verwenden, diese Eingaben werden jedoch selten für eine steuerbare Text2img-Generierung kombiniert.

Einige vorhandene Tools wie Inpainting, Layout2img-Generierung usw. können andere modale Eingaben als Text verwenden, diese Eingaben werden jedoch selten für eine steuerbare Text2img-Generierung kombiniert.

Darüber hinaus werden bisherige generative Modelle in der Regel unabhängig an aufgabenspezifischen Datensätzen trainiert, während im Bereich der Bilderkennung das langjährige Paradigma darin besteht, aus „großflächigen Bilddaten“ oder „Bild-Text-Paaren“ zu lernen „Ein vorab trainiertes Basismodell beginnt mit dem Aufbau eines Modells für eine bestimmte Aufgabe.

Diffusionsmodelle wurden auf Milliarden von Bild-Text-Paaren trainiert. Eine natürliche Frage ist: Können wir auf den vorhandenen vorab trainierten Diffusionsmodellen aufbauen und ihnen neue bedingte Eingaben geben?

Aufgrund des großen Umfangs an konzeptionellem Wissen, über das das vorab trainierte Modell verfügt, ist es möglicherweise möglich, bei anderen Generierungsaufgaben eine bessere Leistung zu erzielen und gleichzeitig eine bessere Steuerbarkeit als bestehende Modelle zur Text-Bild-Generierung zu erlangen.

GLIGEN

Basierend auf den oben genannten Zwecken und Ideen behält das von den Forschern vorgeschlagene GLIGEN-Modell weiterhin den Texttitel als Eingabe bei, ermöglicht aber auch andere Eingabemodalitäten, wie z. B. den Begrenzungsrahmen des Erdungskonzepts, die Erdungsreferenz Bild und der Schlüssel zum Erdungspunkt.Das Hauptproblem hierbei besteht darin, eine große Menge an ursprünglichem konzeptionellem Wissen im vorab trainierten Modell beizubehalten und gleichzeitig zu lernen, neue Grundinformationen einzufügen.

Um Wissensvergessen zu verhindern, schlugen die Forscher vor, die ursprünglichen Modellgewichte einzufrieren und eine neue trainierbare Gated-Transformer-Schicht hinzuzufügen, um die neue Erdungseingabe zu absorbieren Begrenzungsrahmen als Beispiel.

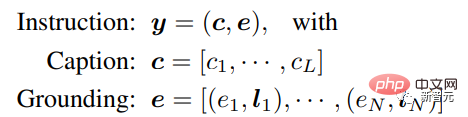

Befehlseingabe#🎜 🎜 #

Jedes Fugentextelement wird als Begrenzungsrahmen dargestellt, der die Koordinaten der oberen linken und unteren rechten Ecke enthält Wert.

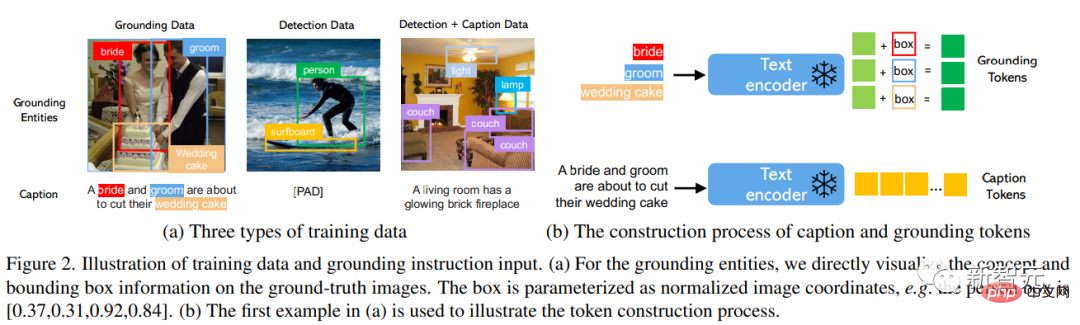

Es ist zu beachten, dass bestehende Layout2img-bezogene Arbeiten normalerweise ein Konzeptwörterbuch erfordern und während der Evaluierungsphase nur engmaschige Entitäten (z. B. COCO-Kategorien) verarbeiten können Forscher fanden heraus, dass Positionierungsinformationen im Trainingssatz mithilfe eines Textencoders, der Bildbeschreibungen kodiert, auf andere Konzepte verallgemeinert werden können. #🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜##Trainingsdaten#🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜##### 🎜🎜 ## 🎜🎜 #Die zum Generieren von Erdungsbildern verwendeten Trainingsdaten erfordern Text c und Erdungsentität e als Bedingungen. In der Praxis können die Datenanforderungen durch die Berücksichtigung flexiblerer Eingaben gelockert werden.

Es gibt drei Haupttypen von Daten#🎜🎜 #

1. Erdungsdaten

Jedem Bild ist ein Titel zugeordnet, der das gesamte Bild beschreibt; Substantiv-Entitäten werden aus Titeln extrahiert und mit Begrenzungsrahmen gekennzeichnet.

Jedem Bild ist ein Titel zugeordnet, der das gesamte Bild beschreibt; Substantiv-Entitäten werden aus Titeln extrahiert und mit Begrenzungsrahmen gekennzeichnet.

Da Substantiventitäten direkt aus Titeln in natürlicher Sprache übernommen werden, können sie ein umfangreicheres Vokabular abdecken, was für die fundierte Generierung von Open-World-Vokabeln von Vorteil ist.

2. Wählen Sie für definierte nahegelegene Kategorien (z. B. die 80 Objektkategorien in COCO) die Verwendung des leeren Titel-Tokens im klassifikatorfreier Leitfaden als Titel.

Die Anzahl der Erkennungsdaten (Millionen Ebenen) ist größer als die Basisdaten (tausend Ebenen), sodass die gesamten Trainingsdaten erheblich erhöht werden können.

3 Die Substantiv-Entität ist dieselbe wie die Substantiv-Entität in den Erkennungsdaten, und das Bild wird mit einem Texttitel beschrieben allein Es kann Situationen geben, in denen die Substantiv-Entität nicht vollständig mit der Entität im Titel übereinstimmt.

Zum Beispiel gibt der Titel nur eine allgemeine Beschreibung des Wohnzimmers und erwähnt nicht die Objekte in der Szene, während die Erkennungsanmerkung feinere Objekt- Level-Details.

Gesteuerter Aufmerksamkeitsmechanismus

#🎜 🎜#

Ziel der Forscher ist es, bestehenden groß angelegten sprachbildgenerierenden Modellen neue räumlich basierte Fähigkeiten zu verleihen, Großmaßstäbliche Diffusionsmodelle wurden vorab auf Bildtext im Webmaßstab trainiert, um das erforderliche Wissen zu erlangen, um realistische Bilder basierend auf vielfältigen und komplexen Sprachanweisungen zu synthetisieren. Aufgrund der hohen Kosten für die Vorabschulung ist die Leistung auch sehr gut und die Erweiterung neuer Fähigkeiten Es ist wichtig, dieses Wissen in den Modellgewichten beizubehalten, und neue Module können angepasst werden, um sich schrittweise an neue Fähigkeiten anzupassen.

Während des Trainingsprozesses wird der Gating-Mechanismus verwendet, um das Gerät schrittweise zu erden Neue Erdungsinformationen werden in vorab trainierte Modelle verschmolzen, ein Design, das Flexibilität im Sampling-Prozess während der Generierung ermöglicht, um Qualität und Kontrollierbarkeit zu verbessern.

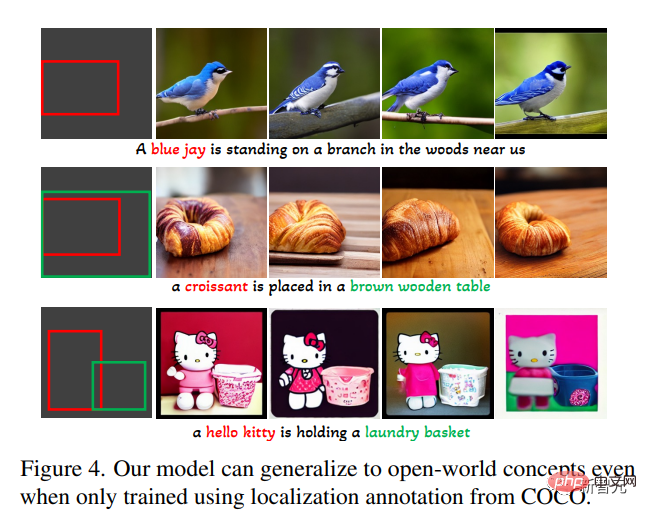

Es wurde im Experiment auch nachgewiesen, dass in der ersten Hälfte des Sampling-Schritts das komplette Modell (alle Schichten) verwendet wird und nur die ursprüngliche Schicht (ohne Gated Transformer) wird in der zweiten Halbschicht verwendet), können die generierten Ergebnisse die Erdungsbedingungen genauer widerspiegeln und eine höhere Bildqualität aufweisen. In der Aufgabe zur Generierung von geerdetem Text mit offenem Satz in Bilder verwenden Sie zunächst nur die Basisanmerkungen von COCO (COCO2014CD) für das Training und bewerten Sie, ob GLIGEN andere Basisentitäten als die COCO-Kategorie generieren kann. Experimenteller Teil

Es ist ersichtlich, dass GLIGEN neue Konzepte wie „blaue Krähe“, „Croissant“ oder neue Objektattribute wie „brauner Holztisch“ lernen kann, diese Informationen jedoch nicht im erscheinen Trainingskategorie Mitte.

Die Forscher glauben, dass dies daran liegt, dass GLIGENs eingeschränkte Selbstaufmerksamkeit gelernt hat, visuelle Merkmale, die geerdeten Entitäten im Titel entsprechen, für die folgende Queraufmerksamkeitsebene neu zu positionieren, und dass der gemeinsame Text im Raum der beiden Ebenen die Fähigkeit zur Generalisierung erlangt hat .

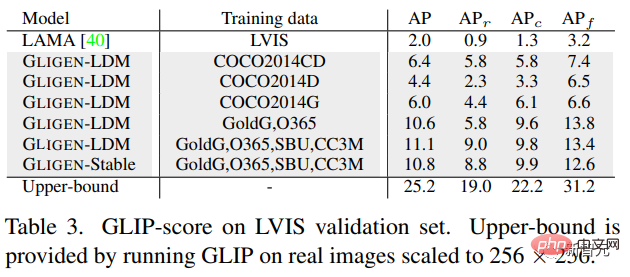

Das Experiment bewertete auch quantitativ die Nullschuss-Generierungsleistung dieses Modells auf LVIS, das 1203 Long-Tail-Objektkategorien enthält. Verwenden Sie GLIP, um Begrenzungsrahmen aus generierten Bildern vorherzusagen und den AP zu berechnen, und vergleichen Sie ihn mit modernsten Modellen, die für die Aufgabe „layout2img“ entwickelt wurden.

Das Modell wird nur auf COCO-Annotationen trainiert, schneidet jedoch viel besser ab als die überwachten Basislinien, wahrscheinlich weil die von Grund auf trainierten Basislinien Schwierigkeiten haben, aus begrenzten Annotationen zu lernen, während das GLIGEN-Modell das umfangreiche konzeptionelle Wissen des vorab trainierten Modells nutzen kann.

Im Allgemeinen:

1. Schlägt eine neue Methode zur Text2img-Generierung vor, die dem bestehenden Text2img-Diffusionsmodell neue Steuerbarkeit verleiht;

2. Durch Beibehaltung von pre Durch das Training von Gewichten und das Erlernen der schrittweisen Integration neuer Positionierungsebenen erreicht dieses Modell eine Open-World-Bounding-Box-Erzeugung und -Eingabe, das heißt, es integriert neue Positionierungskonzepte, die im Training nicht beobachtet wurden Die Leistung bei der Aufgabe „layout2img“ ist deutlich besser als beim vorherigen Stand der Technik, was beweist, dass große vorab trainierte generative Modelle die Leistung nachgelagerter Aufgaben verbessern können

Das obige ist der detaillierte Inhalt vonDiffusion + Zielerkennung = kontrollierbare Bilderzeugung! Das chinesische Team schlug GLIGEN vor, um die räumliche Position von Objekten perfekt zu steuern. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

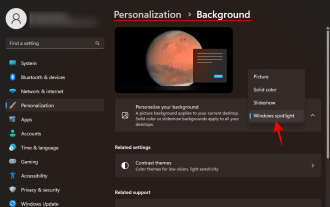

So löschen Sie den Verlauf der letzten Desktop-Hintergrundbilder in Windows 11

Apr 14, 2023 pm 01:37 PM

So löschen Sie den Verlauf der letzten Desktop-Hintergrundbilder in Windows 11

Apr 14, 2023 pm 01:37 PM

<p>Windows 11 verbessert die Personalisierung im System und ermöglicht es Benutzern, einen aktuellen Verlauf zuvor vorgenommener Desktop-Hintergrundänderungen anzuzeigen. Wenn Sie den Abschnitt „Personalisierung“ in der Anwendung „Windows-Systemeinstellungen“ aufrufen, werden Ihnen verschiedene Optionen angezeigt. Eine davon ist das Ändern des Hintergrundbilds. Aber jetzt ist es möglich, den neuesten Verlauf der auf Ihrem System eingestellten Hintergrundbilder anzuzeigen. Wenn Ihnen dies nicht gefällt und Sie den aktuellen Verlauf löschen oder löschen möchten, lesen Sie diesen Artikel weiter. Dort erfahren Sie mehr darüber, wie Sie dies mit dem Registrierungseditor tun. </p><h2>So verwenden Sie die Registrierungsbearbeitung

Die Sturzerkennung basiert auf der Erkennung menschlicher Skelettpunkte. Ein Teil des Codes wird mit Chatgpt vervollständigt

Apr 12, 2023 am 08:19 AM

Die Sturzerkennung basiert auf der Erkennung menschlicher Skelettpunkte. Ein Teil des Codes wird mit Chatgpt vervollständigt

Apr 12, 2023 am 08:19 AM

Hallo zusammen. Heute möchte ich Ihnen ein Projekt zur Sturzerkennung vorstellen. Genauer gesagt handelt es sich um die Erkennung menschlicher Bewegungen auf der Grundlage von Skelettpunkten. Es ist grob in drei Schritte unterteilt: Erkennung des menschlichen Körpers, Punktaktionsklassifizierung des menschlichen Skeletts. Der Quellcode des Projekts wurde gepackt. Informationen zum Erhalt finden Sie am Ende des Artikels. 0. chatgpt Zuerst müssen wir den überwachten Videostream abrufen. Dieser Code ist relativ fest. Wir können chatgpt den von chatgpt geschriebenen Code direkt vervollständigen lassen. Wenn es jedoch später um geschäftliche Aufgaben geht, beispielsweise die Verwendung von Mediapipe zur Identifizierung menschlicher Skelettpunkte, ist der von chatgpt bereitgestellte Code falsch. Ich denke, dass chatgpt als Toolbox verwendet werden kann, die unabhängig von der Geschäftslogik sein kann. Sie können versuchen, es an c zu übergeben

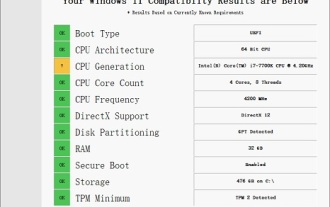

Lösung für i7-7700, kein Upgrade auf Windows 11 möglich

Dec 26, 2023 pm 06:52 PM

Lösung für i7-7700, kein Upgrade auf Windows 11 möglich

Dec 26, 2023 pm 06:52 PM

Die Leistung des i77700 reicht völlig aus, um Win11 auszuführen, aber Benutzer stellen fest, dass ihr i77700 nicht auf Win11 aktualisiert werden kann. Dies ist hauptsächlich auf die von Microsoft auferlegten Einschränkungen zurückzuführen, sodass sie es installieren können, solange sie diese Einschränkung überspringen. i77700 kann nicht auf win11 aktualisiert werden: 1. Weil Microsoft die CPU-Version begrenzt. 2. Nur die Intel-Versionen der achten Generation und höher können direkt auf Win11 aktualisiert werden. 3. Als 7. Generation kann der i77700 die Upgrade-Anforderungen von Win11 nicht erfüllen. 4. Der i77700 ist jedoch hinsichtlich der Leistung durchaus in der Lage, Win11 reibungslos zu nutzen. 5. Sie können also das Win11-Direktinstallationssystem dieser Site verwenden. 6. Nachdem der Download abgeschlossen ist, klicken Sie mit der rechten Maustaste auf die Datei und „laden“ sie. 7. Doppelklicken Sie, um den „One-Click“-Vorgang auszuführen

So laden Sie das Windows Spotlight-Hintergrundbild auf den PC herunter

Aug 23, 2023 pm 02:06 PM

So laden Sie das Windows Spotlight-Hintergrundbild auf den PC herunter

Aug 23, 2023 pm 02:06 PM

Bei Fenstern kommt die Ästhetik nie zu kurz. Von den idyllischen grünen Feldern von XP bis zum blauen, wirbelnden Design von Windows 11 erfreuen Standard-Desktop-Hintergründe seit Jahren die Benutzer. Mit Windows Spotlight haben Sie jetzt jeden Tag direkten Zugriff auf wunderschöne, beeindruckende Bilder für Ihren Sperrbildschirm und Ihr Desktop-Hintergrundbild. Leider bleiben diese Bilder nicht hängen. Wenn Sie sich in eines der Windows-Spotlight-Bilder verliebt haben, möchten Sie vielleicht wissen, wie Sie sie herunterladen können, damit Sie sie für eine Weile als Hintergrund behalten können. Hier finden Sie alles, was Sie wissen müssen. Was ist WindowsSpotlight? Window Spotlight ist ein automatischer Hintergrund-Updater, der unter Personalisierung > in der App „Einstellungen“ verfügbar ist

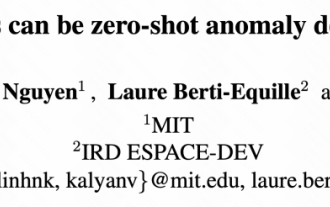

Das neueste Meisterwerk des MIT: Verwendung von GPT-3.5 zur Lösung des Problems der Erkennung von Zeitreihenanomalien

Jun 08, 2024 pm 06:09 PM

Das neueste Meisterwerk des MIT: Verwendung von GPT-3.5 zur Lösung des Problems der Erkennung von Zeitreihenanomalien

Jun 08, 2024 pm 06:09 PM

Heute möchte ich Ihnen einen letzte Woche vom MIT veröffentlichten Artikel vorstellen, in dem GPT-3.5-turbo verwendet wird, um das Problem der Erkennung von Zeitreihenanomalien zu lösen, und zunächst die Wirksamkeit von LLM bei der Erkennung von Zeitreihenanomalien überprüft wird. Im gesamten Prozess gibt es keine Feinabstimmung, und GPT-3.5-Turbo wird direkt zur Anomalieerkennung verwendet. Der Kern dieses Artikels besteht darin, wie man Zeitreihen in Eingaben umwandelt, die von GPT-3.5-Turbo erkannt werden können, und wie man sie entwirft Eingabeaufforderungen oder Pipelines, damit LLM die Anomalieerkennungsaufgabe lösen kann. Lassen Sie mich Ihnen diese Arbeit im Detail vorstellen. Titel des Bildpapiers: Largelingualmodelscanbezero-shotanomalydete

Wie verwende ich die Bildsemantiksegmentierungstechnologie in Python?

Jun 06, 2023 am 08:03 AM

Wie verwende ich die Bildsemantiksegmentierungstechnologie in Python?

Jun 06, 2023 am 08:03 AM

Mit der kontinuierlichen Weiterentwicklung der Technologie der künstlichen Intelligenz hat sich die Bildsemantiksegmentierungstechnologie zu einer beliebten Forschungsrichtung im Bereich der Bildanalyse entwickelt. Bei der semantischen Bildsegmentierung segmentieren wir verschiedene Bereiche in einem Bild und klassifizieren jeden Bereich, um ein umfassendes Verständnis des Bildes zu erreichen. Python ist eine bekannte Programmiersprache. Aufgrund seiner leistungsstarken Datenanalyse- und Datenvisualisierungsfähigkeiten ist es die erste Wahl auf dem Gebiet der Technologieforschung im Bereich der künstlichen Intelligenz. In diesem Artikel wird die Verwendung der Bildsemantiksegmentierungstechnologie in Python vorgestellt. 1. Vorkenntnisse werden vertieft

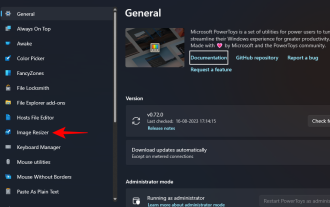

So ändern Sie die Größe von Bildern stapelweise mit PowerToys unter Windows

Aug 23, 2023 pm 07:49 PM

So ändern Sie die Größe von Bildern stapelweise mit PowerToys unter Windows

Aug 23, 2023 pm 07:49 PM

Wer täglich mit Bilddateien arbeitet, muss diese oft in der Größe anpassen, um sie an die Anforderungen seiner Projekte und Aufgaben anzupassen. Wenn Sie jedoch zu viele Bilder verarbeiten müssen, kann die Größenänderung einzelner Bilder viel Zeit und Mühe kosten. In diesem Fall kann ein Tool wie PowerToys nützlich sein, um unter anderem die Größe von Bilddateien mit dem Bild-Resizer-Dienstprogramm stapelweise zu ändern. Hier erfahren Sie, wie Sie Ihre Image Resizer-Einstellungen einrichten und mit PowerToys mit der Stapelgrößenänderung von Bildern beginnen. So ändern Sie die Größe von Bildern stapelweise mit PowerToys PowerToys ist ein All-in-One-Programm mit einer Vielzahl von Dienstprogrammen und Funktionen, die Ihnen helfen, Ihre täglichen Aufgaben zu beschleunigen. Eines seiner Dienstprogramme sind Bilder

iOS 17: So verwenden Sie das Zuschneiden mit einem Klick in Fotos

Sep 20, 2023 pm 08:45 PM

iOS 17: So verwenden Sie das Zuschneiden mit einem Klick in Fotos

Sep 20, 2023 pm 08:45 PM

Mit der iOS 17-Fotos-App erleichtert Apple das Zuschneiden von Fotos nach Ihren Vorgaben. Lesen Sie weiter, um zu erfahren, wie. Bisher umfasste das Zuschneiden eines Bildes in der Fotos-App in iOS 16 mehrere Schritte: Tippen Sie auf die Bearbeitungsoberfläche, wählen Sie das Zuschneidewerkzeug aus und passen Sie dann den Zuschnitt mithilfe einer Pinch-to-Zoom-Geste oder durch Ziehen an den Ecken des Zuschneidewerkzeugs an. In iOS 17 hat Apple diesen Vorgang dankenswerterweise vereinfacht, sodass beim Vergrößern eines ausgewählten Fotos in Ihrer Fotobibliothek automatisch eine neue Schaltfläche „Zuschneiden“ in der oberen rechten Ecke des Bildschirms angezeigt wird. Wenn Sie darauf klicken, wird die vollständige Zuschneideoberfläche mit der Zoomstufe Ihrer Wahl angezeigt, sodass Sie den gewünschten Teil des Bildes zuschneiden, das Bild drehen, umkehren, das Bildschirmverhältnis anwenden oder Markierungen verwenden können