Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Adaptive und unbeaufsichtigte Multi-Szenario-Modellierungspraxis in personalisierten Taobao-Empfehlungen

Adaptive und unbeaufsichtigte Multi-Szenario-Modellierungspraxis in personalisierten Taobao-Empfehlungen

Adaptive und unbeaufsichtigte Multi-Szenario-Modellierungspraxis in personalisierten Taobao-Empfehlungen

In diesem Artikel werden Gedanken und Praktiken zur adaptiven und unbeaufsichtigten Multi-Szenario-Modellierung in den personalisierten Empfehlungsszenarien von Taobao geteilt. Diese Arbeit wurde in CIKM 2022 veröffentlicht (Papiertitel: Scenario-Adaptive and Self-Supervised Model for Multi-Scenario Personalized Recommendation). In diesem Artikel wird vorgestellt, wie die Multi-Szenario-Modellierung die Migrationsbeziehung zwischen Volldomänenszenarien und Einzelszenarien detailliert beschreibt, um eine Domänenanpassung zu erreichen, und wie unbeaufsichtigte Daten in die Multi-Szenario-Modellierung eingeführt werden. Außerdem wird die Rolle vorgestellt der Multi-Szenario-Modellierung in der Empfehlungs- und Rückrufpraxis.

1. Hintergrundeinführung und Lösungsmotivation

Stellen Sie zunächst den geschäftlichen Hintergrund, die Modellierungsmotivation und die Lösungsauswahl der Multi-Szenario-Modellierung vor. Dieser Artikel konzentriert sich auf das Multi-Szenario-Modellierungsproblem von Empfehlungssystemen, das auch in verschiedenen Empfehlungssystemen ein häufiges Problem darstellt und dringend gelöst werden muss. Konkret werden rund 5 Fragen vorgestellt.

1. Frage 1: Was ist Multi-Szenario

kann aus der Geschäftsperspektive und der Modellperspektive erklärt werden. Aus geschäftlicher Sicht kann „Szenario“ einfach als verschiedene Empfehlungsportale oder Empfehlungs-Hosting-Seiten auf der Empfehlungsplattform verstanden werden. Beispielsweise kann im Werbebereich dieselbe Werbung auf unterschiedlichen Medienterminals platziert werden und gleichzeitig unterschiedlichen Übermittlungsformen entsprechen, beispielsweise Informationsfluss-Werbung oder Open-Screen-Werbung. Im Bereich E-Commerce wird es auch eine sehr umfangreiche Empfehlungsseite geben. Am Beispiel von Taobao gibt es eine Benutzeroberfläche für Produktempfehlungen auf der Startseite, Empfehlungsszenarien im Warenkorb und entsprechende Empfehlungen die Produktdetailseite. Im Bereich der Inhaltsempfehlung, beispielsweise in unserem eigentlichen Geschäft, dem Einkaufen auf Taobao, enthält die Empfehlungsseite eine One-Hop-Anzeigeszene mit zwei Spalten sowie einen immersiven, endlosen Fluss von Empfehlungen, der nach dem Klicken zur Eingabe nach oben und unten gleitet der zweite Hop. In diesen Beispielen kann jede gehostete Seite als Szene verwendet werden, und dieselbe Empfehlungsplattform verfügt auch über mehrere Empfehlungsszenen, die die Eigenschaften mehrerer Szenen zeigen.

Aus Sicht der Modellmodellierung können Multi-Szenario-Probleme einfach als mehrere Datensätze definiert werden, die denselben Merkmalsraum und Beschriftungsraum teilen, aber unterschiedliche Datenverteilungen aufweisen. Die in jedem Empfehlungsszenario aufgezeichneten Daten können einen entsprechenden Datensatz bilden. Obwohl jeder Datensatz aus unterschiedlichen Quellen stammt, sind ihr Merkmalssystem und ihr Beschriftungsraum konsistent. 2. Frage 2: Merkmale mehrerer Szenarien , und einige interaktive Verhaltensweisen wie Durchsuchen und Klicken bleiben in mehreren Szenen erhalten.

Der zweite Punkt ist, dass sich das Angebot überschneidet. Ob Werbung, Produkte oder Inhalte, es kann in verschiedenen Szenen platziert und angezeigt werden. Der dritte Punkt ist der Verteilungsunterschied zwischen den Szenarien. Aus dem Verhaltensmodell geht hervor, dass derselbe Benutzer mehrere verschiedene Szenarien besucht, und das Verhalten des Benutzers in dem Szenario kann aus Sicht des Angebots für dieselbe Werbung und dasselbe Produkt unterschiedlich sein oder Inhalt, die Belichtungsleistung und die Interaktionsleistung, die in verschiedenen Szenen angezeigt werden, sind ebenfalls unterschiedlich. Daher gibt es Unterschiede zwischen verschiedenen Szenarien hinsichtlich der Datenverteilung. Daher verkörpert das Multi-Szenario-Empfehlungsproblem, mit dem wir jetzt konfrontiert sind, die Charakterisierung der Gemeinsamkeit und Merkmale von Szenarien: Benutzer haben möglicherweise nachhaltige Interessen, aber ihr Ausdruck in verschiedenen Szenarien kann unterschiedlich sein.

Der vierte Punkt ist, dass die Feature-Räume und Ziele zwischen den Szenen konsistent sind. Verschiedene Szenen spiegeln mehr Unterschiede in der Datenverteilung wider, aber das Feature-System ist tatsächlich relativ konsistent. Darüber hinaus ist der Beschriftungsraum zwischen den Szenen gleich, was bedeutet, dass die Modellierungsaufgaben zwischen mehreren Szenen tatsächlich gleich sind. Zum Beispiel die Modellierung von Klickaufgaben in der Produktszene oder die Modellierung von Abschluss- oder Langzeitaufgaben in der Inhaltsszene.

3. Frage 3: Die Ziele der Multi-Szenario-ModellierungBasierend auf dem spezifischen Geschäftshintergrund hoffen wir, uns durch die Modellierung von Multi-Szenario-Problemen auf die Erreichung der folgenden zwei Ziele zu konzentrieren.

Das erste ist das Leistungsziel, das sich auf die Optimierung des Problems der Datenspärlichkeit konzentriert. Einzelempfehlungsszenarien sind normalerweise mit dem Problem spärlicher Benutzerverhaltensdaten konfrontiert, und dieses Phänomen ist in einigen kleinen oder neuen Szenarien besonders offensichtlich. Eines der wichtigen Ziele des Multi-Szenario-Problems besteht darin, das Problem der Datenspärlichkeit zu lindern und die Geschäftsindikatoren aller Szenarien durch den Informationsaustausch zwischen mehreren Szenarien zu verbessern.

Das zweite Ziel in Bezug auf Iteration sowie Betriebs- und Wartungskosten besteht darin, für jedes Szenario dediziertes Personal zuzuweisen und zu optimieren Nach einiger Zeit kann es erforderlich sein, den gesamten Zugriffs- und Modellschulungsprozess zu wiederholen. Dies bedeutet, dass alle Personalzuweisungen, Modellbereitstellungsarbeiten und Wartungskosten in einem positiven Zusammenhang mit der Anzahl der Szenarien stehen, was zu relativ hohen Gesamtwartungskosten und Iterationskosten führt.

Unter Berücksichtigung der tatsächlichen Kosten hoffen wir, ein einheitliches Algorithmus-Framework zu erstellen, das verschiedene Szenarien gleichzeitig bedienen und den schnellen Zugriff auf neue Szenarios unterstützen möchte. Ein weiteres Ziel, das das Modell erreicht hat.

Es sollte auch betont werden, dass sich Multi-Szenario-Probleme von den derzeit bekannten Multi-Target- und Cross-Domain-Problemen unterscheiden. Bei Problemen mit mehreren Szenarien liegt der Schwerpunkt darauf, dasselbe Feature-System zu nutzen, über mehrere unterschiedliche Datenquellen zu verfügen und dasselbe Ziel zu verfolgen. Multiziel bedeutet, dass mehrere unterschiedliche Optimierungsziele für dieselbe Datenquelle vorliegen. Domänenübergreifende Probleme werden normalerweise in eine Quelldomäne und eine Zieldomäne unterteilt. Im Allgemeinen wird davon ausgegangen, dass das Datenvolumen und die Wirkung der Quelldomäne überlegen sind, und dann wird die Quelldomäne verwendet, um die Wirkung der Zieldomäne zu verbessern . Bei Problemen mit mehreren Szenen besteht kein Zusammenhang zwischen den Vor- und Nachteilen der einzelnen Szenen. Das Ziel der Modellierung besteht darin, die Effekte aller Szenen zu verbessern.

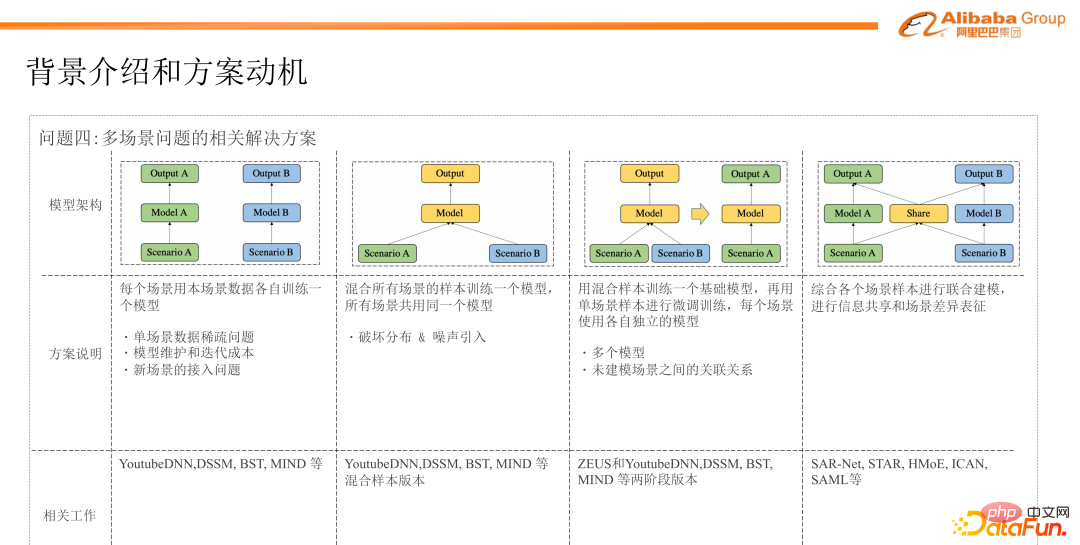

4. Verwandte Lösungen für Multi-Szenario-Probleme

in praktische Anwendungen umgesetzt Zur Modellierung dieser Art von Multi-Szenario-Problemen haben wir in der frühen Phase eine einfache Klassifizierung der in der Branche vorhandenen Lösungen vorgenommen und diese grob in die folgenden vier Typen unterteilt.

Der erste ist der intuitivste und auch das aktuelle Geschäft Eine für die Implementierung gewählte Lösung besteht darin, die jeweiligen Daten dieser Szenarien zu verwenden, um für jedes einzelne Szenario separate Modelle zu trainieren. Anschließend verfügt jedes Szenario über ein separates Modell. Auf diese Weise können in der Branche vorhandene Modellstrukturen für die Modellierung in unterschiedlichen Szenarien ausgewählt werden.

Natürlich weist diese Lösung auch einige Mängel auf, die sich hauptsächlich auf die folgenden Punkte konzentrieren. Der erste Punkt ist, dass diese Methode das Problem der Datenspärlichkeit in einem einzelnen Szenario nicht gut lösen kann Es kann verwendet werden, um die Funktionsinformationen anderer Szenen desselben Typs zu ergänzen. Insbesondere in einigen Szenen, in denen die Datenmenge relativ gering ist oder die Verhaltensdaten spärlich sind, ist das Problem der Datenspärlichkeit stärker ausgeprägt. Der zweite zuvor erwähnte Punkt ist, dass diese Modellierungsmethode mit einem Szenario und einem Modell relativ viel Personal und Ressourcen in Bezug auf Modellwartung und Iterationskosten verbraucht. Der dritte Punkt ist, dass bei der Einführung einiger neuer Szenarien im Unternehmen auch das Problem höherer Kosten entsteht.

Da der Ansatz mit einem einzelnen Szenario und einem einzelnen Modell das Problem spärlicher Stichproben aufweist, besteht die zweite Lösung darin, die Stichprobendaten aller Szenen zu mischen, ein Modell mit den gemischten Daten zu trainieren und diese dann bereitzustellen gleiches Modell für alle Szenen. Diese Methode kann zwei Probleme des ersten Schematyps lindern, da dieses Schema Samples aus allen Szenen verwendet und alle Szenen dasselbe Modell verwenden. Der Nachteil besteht jedoch darin, dass dieses relativ grobe gemischte Training von Datenproben die Datenverteilung zwischen den einzelnen Szenen zerstört und etwas Rauschen verursacht. Darüber hinaus kann der Gesamteffekt des Modells von den Daten einiger großer Szenen dominiert werden, wodurch die Auswirkungen einiger kleiner Szenen beeinflusst werden.

Die dritte Lösungsart besteht darin, eine zweistufige Trainingsmethode zu verwenden, d. h. zunächst ein gemischtes Training für Proben aus allen Szenarien durchzuführen, ein Basismodell zu trainieren und dann unabhängige Proben aus jedem Szenario zu verwenden Das ursprüngliche Basismodell wird innerhalb der Szene verfeinert. Im Hinblick auf die Modellbereitstellung und -schätzung wird jedes Szenario auch online gestellt und anhand des Modells geschätzt, das mit seinen eigenen Szenendaten verfeinert wird. Der Nachteil dieses Ansatzes besteht darin, dass für jedes Szenario ein eigenes Modell separat bereitgestellt werden muss. Darüber hinaus modelliert diese Methode des direkten Vortrainings und der Feinabstimmung die Beziehung zwischen Szenen nicht sehr gut.

Die letzte Kategorie ist derzeit die gängige Methode in der Branche für die Multi-Szenario-Modellierung. Durch die Nutzung der Multi-Task-Lernarchitektur werden die Daten jedes Szenarios in der Modellstruktur berücksichtigt, um eine gemeinsame Modellierung durchzuführen, und durch die Modellstruktur Das Design wird verwendet, um die gemeinsamen Ausdrücke und Unterschiede zwischen Szenen darzustellen. In den letzten zwei Jahren gab es in der Branche viele Versuche und Implementierungen. Beispielsweise wird SAR-Net auf ähnliche Weise wie MMOE trainiert, und STAR baut dieses weltweit gemeinsam genutzte Netzwerk und ein für jedes Szenario einzigartiges Netzwerk durch Matrix-Mapping auf zwischen Modellparametern, um die Charakterisierung dieses Szenenunterschieds zu erreichen, und andere Arbeiten, um diesen Szenenunterschied durch dynamische Parameternetzwerke darzustellen.

Angesichts der Mängel der ersten drei Arten von Methoden haben wir uns entschieden, nachfolgende Arbeiten auf der Grundlage gemeinsamer Schulungen durchzuführen.

5. Frage 5: Herausforderungen bei der Multi-Szenario-Modellierung im tatsächlichen Geschäft

In unserem tatsächlichen Geschäftsimplementierungsprozess, für diese Art der Multi-Szenario-Modellierung durch ein einheitliches Modell In der gemeinsamen Modellierung , stehen wir auch vor einigen spezifischeren Herausforderungen, die sich hauptsächlich in den folgenden Aspekten widerspiegeln.

Herausforderung 1: Wir verwenden die gemeinsame Modellierung in der Hoffnung, die Informationen aller Szenen vollständig zu nutzen, um das datenarme Problem einer einzelnen Szene zu lösen Andere Szenen Obwohl einige der zuvor genannten Methoden in einer bestimmten Szene Parametermatrixoperationen oder dynamische Parameternetzwerke verwenden, um die Gemeinsamkeiten und Unterschiede der Szene zu charakterisieren, sind diese Transformationsmethoden relativ implizit und können nicht auf interpretierbare Weise erklären, ob andere Szenen quantifiziert werden In die angegebene Szene migriert das Szenario Informationen und wie viele Informationen migriert werden. Daher ist die erste Herausforderung, vor der wir stehen, die Frage, wie eine verfeinerte und effektive Migration von Szeneninformationen erreicht werden kann. Vereinfacht ausgedrückt: Wie lässt sich modellieren, ob Informationen migriert werden sollen und wie viele Informationen migriert werden sollen?

Herausforderung 2: Beim Training des Modells konstruieren wir hauptsächlich positive Proben basierend auf Benutzerinteraktionsverhalten, wie z. B. Produktklicks oder positiven Feedbacksignalen wie der Vervollständigung von Videos, d. h. in gekennzeichneten Proben. Training ist Wird mit Daten durchgeführt, was in einigen Szenarien mit wenigen Verhaltensweisen zu ernsthaften Problemen mit spärlichen Daten führen kann. Wenn wir einige unbeaufsichtigte Aufgaben verwenden können, um die Trainingsdaten vom beschrifteten Probenraum auf den unbeschrifteten Probenraum zu erweitern, wird dies dazu beitragen, das Problem der Datenspärlichkeit zu lindern.

Herausforderung 3: Wir alle wissen, dass der gesamte Empfehlungslink in mehrere Kernphasen wie Rückruf und Sortierung unterteilt ist. In der frühen Forschung haben wir festgestellt, dass sich die gemeinsame Modellierung von Problemen mit mehreren Szenarien hauptsächlich auf die Ranking-Phase konzentriert, einschließlich einiger der oben aufgeführten Modelle, bei denen es sich im Grunde um Ranking-Modelle handelt. Als erste Stufe des gesamten Empfehlungslinks sieht sich der Rückruf mit sehr unterschiedlichen Kandidatengrößen, Abrufmethoden und Sortierungen konfrontiert. Daher ist die Implementierung einer gemeinsamen Multiszenario-Modellierung in der Rückrufphase auch eine Herausforderung für uns.

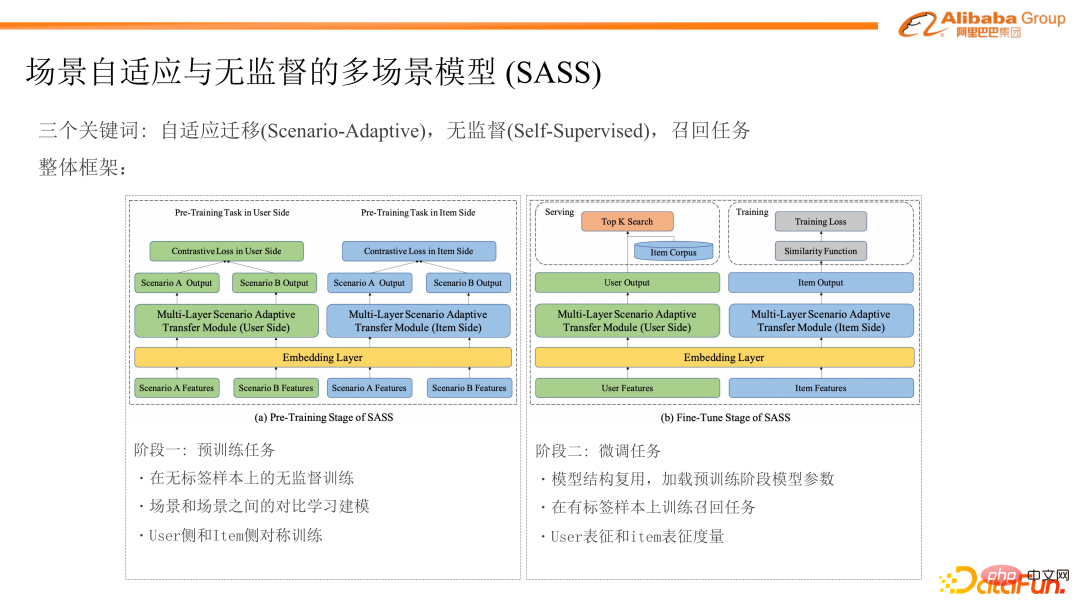

2. Szenenanpassung und unbeaufsichtigtes Multi-Szenen-Modell (SASS)

Das Folgende ist eine Einführung in unsere Modelllösung für die tatsächliche Geschäftsimplementierung. Dieses Modell wird als SASS bezeichnet. Diese Lösung konzentriert sich hauptsächlich auf drei Kernschlüsselwörter. Das erste ist die szenenadaptive Übertragung (Scenario-Adaptive), das zweite ist die unbeaufsichtigte (selbstüberwachte) und das dritte ist die Implementierungserkundung für Rückrufaufgaben.

Der Gesamtmodellrahmen enthält zwei Phasen, eine ist die Vortrainingsaufgabe und die andere ist die Feinabstimmungsaufgabe. Der erste Schritt besteht darin, eine unbeaufsichtigte Vortrainingsaufgabe an einem unbeschrifteten Beispielsatz zu erstellen und die Beziehung zwischen Szenen durch kontrastives Lernen zu modellieren. Da das gesamte Modell in der Rückrufphase implementiert wird, müssen außerdem die Benutzerseite und die Artikelseite unabhängig voneinander modelliert werden, sodass wir ein symmetrisches Strukturdesign auf der Benutzerseite und der Artikelseite haben.

Die zweite Stufe ist eine Feinabstimmungsaufgabe, bei der die Modellstruktur basierend auf der ersten Stufe wiederverwendet wird, einschließlich des Ladens der in der ersten Stufe vorab trainierten Einbettungs- und Netzwerkstrukturparameter. Darüber hinaus besteht die zweite Stufe darin, eine Rückrufaufgabe für den markierten Beispielraum zu trainieren und dann die Darstellungsvektoren der Benutzerseite und der Elementseite auszugeben. Als nächstes werden wir diese beiden Phasen im Detail vorstellen.

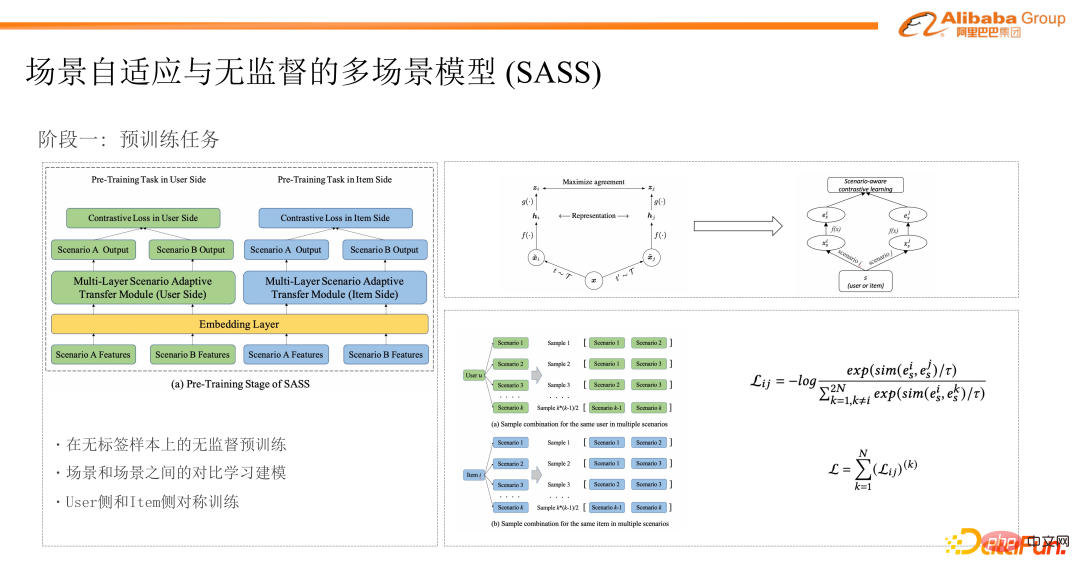

1. Phase 1: Vortrainingsaufgabe

Zuerst konstruieren wir in der ersten Phase der Vortrainingsaufgabe eine unbeaufsichtigte Aufgabe des kontrastiven Lernens zwischen Szenen. Wie in der oberen rechten Ecke der Abbildung gezeigt, sollte jeder mit dem klassischen Trainingsparadigma des kontrastiven Lernens vertraut sein. Dasselbe Objekt x erhält zwei unterschiedliche Merkmalssätze durch zwei verschiedene Datenverbesserungsmethoden und verwendet dann das Merkmalsextraktionsnetzwerk und die Zuordnung Das Netzwerk erhält schließlich zwei verschiedene Vektorausdrücke desselben Objekts, und dann kann der Darstellungsabstand zwischen den beiden Vektoren durch Vergleichen der erlernten Metrikverluste verkürzt werden, um unbeaufsichtigte Aufgaben vor dem Training zu erreichen.

Inspiriert von der Idee des kontrastiven Lernens kombinieren wir den Ausrichtungsausdruck zwischen Szenen in der Mehrszenenmodellierung mit der Vortrainingsaufgabe des kontrastiven Lernens. Wie bereits erwähnt, kann derselbe Benutzer auf mehrere verschiedene Szenen zugreifen und in verschiedenen Szenen unterschiedliche interaktive Verhaltensweisen zeigen, wodurch einige statistische Informationen zur Szene zurückbleiben. Daher können wir diesen Unterschied im Benutzerverhalten in verschiedenen Szenarien als eine natürliche Möglichkeit der Datenverbesserung betrachten. Die Interessen desselben Benutzers sind zwar kontinuierlich, es kann jedoch zu bestimmten Unterschieden in seinem Ausdruck zwischen verschiedenen Szenarien kommen. Auf dieser Grundlage bauen wir dann eine unbeaufsichtigte Aufgabe des kontrastiven Lernens auf.

Wenn wir uns das spezifische Modell ansehen, wie auf der linken Seite der Abbildung gezeigt, werden wir ein einheitliches Feature-System für verschiedene Szenarien erstellen, aber die spezifischen Werte der Features entsprechen den Szenarien. Beispielsweise teilen wir die Werte der Benutzer auf Verhaltensabfolge in Szenarien Offen, Benutzer haben entsprechende statistische Merkmale wie Interessen und Vorlieben in ihren jeweiligen Szenarien. Durch diese Aufteilungsmethode verfügt derselbe Benutzer über mehrere unterschiedliche Merkmalswertsätze, die sich auf das Szenario beziehen. In der Abbildung sind beispielsweise die Merkmale desselben Benutzers in Szene A und Szene B dargestellt, und dann können wir über ein einheitliches Darstellungsnetzwerk (dieses Darstellungsnetzwerk wird später vorgestellt) die jeweiligen Darstellungsvektoren desselben Benutzers in unterschiedlichen Darstellungen erhalten Szenen, und schließlich lernen Sie den Verlust durch Vergleich, um den Abstand zwischen den beiden zu verkürzen.

Worüber ich gerade gesprochen habe, ist die Trainingsmethode der Benutzerseite. Bei der Rückrufaufgabe werden die Benutzerseite und die Artikelseite normalerweise unabhängig voneinander modelliert. Daher verwendet die Artikelseite auch symmetrische Strukturen und Aufgaben für das Training, und die Benutzerseite und die Artikelseite teilen sich dieselbe Einbettungsschicht. Insbesondere teilen wir für dasselbe Element die Merkmalswerte auf der Elementseite in Szenen auf. Nachdem wir das Darstellungsnetzwerk auf der Elementseite durchlaufen haben, erhalten wir den Vektorausdruck jeder Szene und verwenden dann dasselbe kontrastive Lernen Verlust fürs Training.

Bei der Erstellung der Stichprobe haben wir eine Sonderbehandlung. Es können mehr als 2 Szenen vorhanden sein, die ein Benutzer besucht. Daher werden wir bei der Erstellung der Trainingsaufgabe des vergleichenden Lernens die vom Benutzer besuchten Szenen paarweise kombinieren, um mehrere Szenarien zu erstellen . Trainingsbeispiele. Auch auf der Artikelseite werden durch diese beiden Kombinationen mehrere Stichproben erstellt.

In der spezifischen kontrastiven Lernaufgabe folgten wir für das Training der Verlustform von InfoNCE.

Wir erreichen das Vortraining unbeschrifteter Daten zwischen mehreren Szenen durch Modellierungsszenen und vergleichende Lernaufgaben zwischen Szenen. Als nächstes stellen wir die Entwurfsdetails des wichtigeren Darstellungsnetzwerks im gesamten Modellrahmen vor.

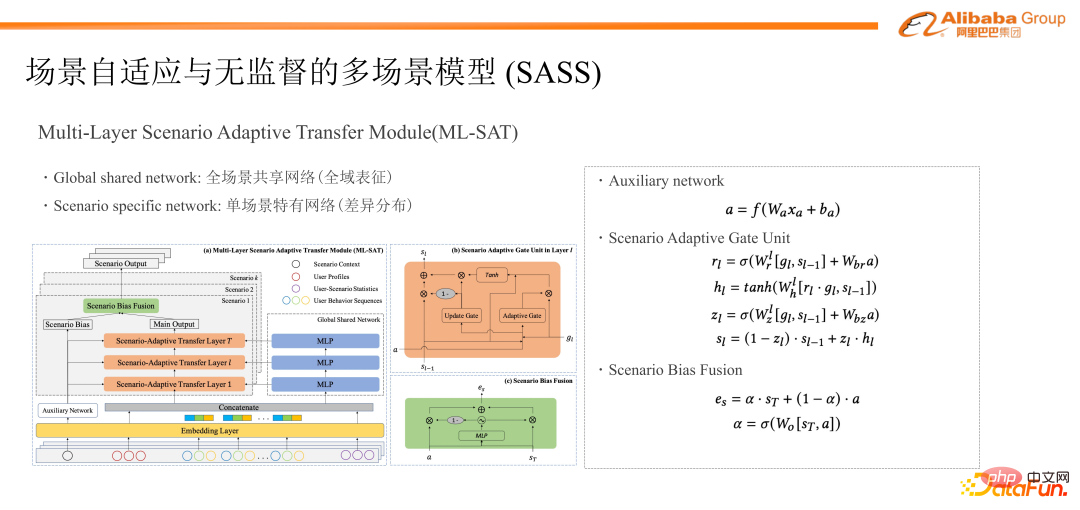

Das Szenendarstellungsnetzwerk im Modell ist ein mehrschichtiges, szenenadaptives Migrationsnetzwerk. Zunächst werden Parameter aus der Gesamtmodellstruktur in der Einbettungsschicht des Modells gemeinsam genutzt. Dieses Darstellungsnetzwerk kann als Ganzes in mehrere Komponenten unterteilt werden. Die erste ist das Netzwerk, das von der gesamten Szene gemeinsam genutzt wird. Dies ist der blaue Teil auf der linken Seite des Modells im Bild Alle Szenen werden hier durchlaufen und können als Darstellungsstruktur für das Training einer Mischung aller Szenenbeispiele auf der Benutzerseite oder der Artikelseite betrachtet werden.

Der zweite Teil ist die einzigartige Netzwerkstruktur jeder Szene, bei der es sich um den grauen Teil handelt, der jeder Szene im Bild entspricht. Die jeder Szene entsprechenden Proben werden über das entsprechende Netzwerk trainiert. Da die Netzwerkschichtparameter jeder Szene getrennt sind, können dieses Training und diese Darstellung die Unterschiede in der Verteilung zwischen den einzelnen Szenen gut beschreiben. Darüber hinaus führen wir in der unteren linken Ecke der Abbildung auch ein Hilfs-Bias-Netzwerk ein. Die Eingabe dieses Bias-Netzwerks umfasst Szenen-IDs und einige szenenspezifische Merkmale sowie einige kontextbezogene Merkmale. Dadurch können die Unterschiede und Bias-Informationen zwischen den Kontexten der Szenen auf der Grundlage eines gemeinsamen Systems weiter charakterisiert werden.

Im spezifischen Trainingsprozess tritt jedes Beispiel, nachdem es die einheitliche Feature-Einbettungsschicht durchlaufen und gespleißt hat, in das vollständige Szenenfreigabenetzwerk und das Netzwerk ein, das für die diesem Beispiel entsprechende Szene eindeutig ist, und führt eine Vorwärtsausbreitung durch und Backpropagation-Netzwerkschulung.

Gleichzeitig wird in der gesamten Netzwerkstruktur die Ausgabe jeder Schicht des Vollszenen-Sharing-Netzwerks durch eine szenenadaptive Gating-Einheit geleitet, um die Fusionsinformationen der gesamten Szene in eine einzelne zu migrieren Szene zur Realisierung von Szeneninformationen. Verfeinerte Migration zwischen. Einzelheiten finden Sie in der Struktur in der oberen rechten Ecke des Modells in der Abbildung. Die Migrationsstruktur umfasst hauptsächlich ein adaptives Gate und ein Update-Gate. Der Ausgabewert des adaptiven Gates wird verwendet, um zu steuern, wie viele Informationen in der gesamten Szene in eine einzelne Szene migriert werden können, während der Ausgang des Update-Gates dazu dient, die aus dem gesamten Szenennetzwerk migrierten Informationen und die Originalinformationen zu steuern Der Gewichtungswert der gewichteten Fusion. Die Eingaben dieser beiden Gate-Netzwerke umfassen die Informationen des gesamten Szenennetzwerks, die Informationen des einzelnen Szenennetzwerks und die Bias-Informationen der Szene selbst. Durch diese verfeinerte und adaptive Migrationsstruktur werden die Migrationsrichtung und die Menge der Migrationsinformationen der Szene modelliert und charakterisiert. Wir stapeln die Migrationsstruktur in mehreren Schichten und schließlich kann jede Probe eine Vektordarstellung der entsprechenden Szene erhalten. Schließlich wird die jeweilige Ausgabe jeder Szene mit der Bias-Ausgabe der entsprechenden Szene fusioniert, um ihren endgültigen Vektorausdruck für die entsprechende Szene zu erhalten.

2. Phase 2: Feinabstimmung der Aufgabe

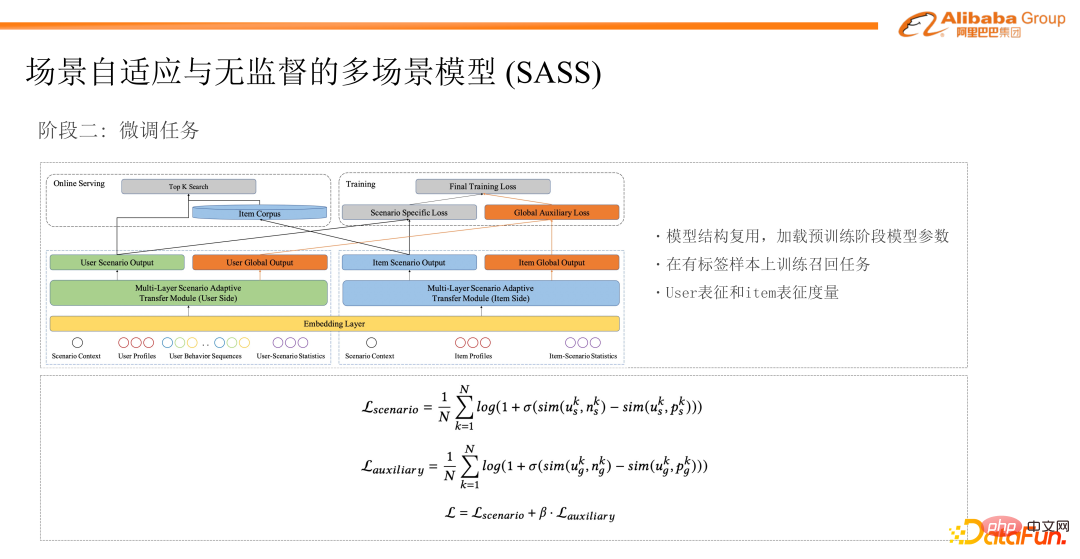

Die zweite Phase ist die Feinabstimmung der Aufgabe. Da wir das Modell in der Rückrufphase des empfohlenen Links implementieren möchten, sind die Ziele der Feinabstimmungsaufgabe und der Rückrufaufgabe aufeinander abgestimmt. In Bezug auf die Stichprobenauswahl verwenden wir die vom Benutzer angeklickten Elemente als positive Stichproben, konstruieren negative Stichproben durch Zufallsstichproben und berechnen dann den paarweisen Verlust durch die Konstruktion von Tripeln für das Training.

Darüber hinaus werden wir in der Feinabstimmungsphase die Modellstruktur und die Parameter wiederverwenden, das heißt, wir werden in der Feinabstimmungsphase dieselbe Darstellungsnetzwerkstruktur wie in der Vortrainingsphase wiederverwenden , und laden Sie die Einbettungsschicht und die Netzwerkparameter der Stufe vor dem Training, was der Beibehaltung der Informationen des unbeaufsichtigten Trainings zwischen den Szenen in der ersten Stufe entspricht.

Bei den Metrik-Matching-Aufgaben auf Benutzerseite und Artikelseite in der Feinabstimmungsphase haben wir außerdem eine neue Hilfsaufgabe eingeführt, um das Training zu unterstützen. Wie bereits erwähnt, kann jede Probe zwei Vektorausdrücke erhalten, nachdem sie durch das Darstellungsnetzwerk charakterisiert wurde. Der eine ist die eindeutige Vektorausgabe jedes einzelnen Szenennetzwerks. Dieser Vektor stellt seinen unabhängigen Ausdruck in jeder entsprechenden Szene dar Ausgabe, die den globalen Ausdruck von Benutzerfunktionen oder Artikelfunktionen darstellt. Daher enthält die Trainingsaufgabe in der gesamten Feinabstimmungsphase zwei Verluste, die zwischen der Benutzereinbettungs- und Artikeleinbettungsausgabe durch das Einzelszenennetzwerk trainiert werden, und der andere ist die Benutzereinbettungs- und Artikeleinbettungsausgabe, die der vollständigen Ausgabe entspricht Durch eine solche Berechnungsmethode kann auch ein weiterer Verlust ermittelt werden, und die gewichtete Summe der letzten beiden Verluste wird als endgültiger Verlust für das Training verwendet. Die Einführung der Hilfsaufgabe des vollständigen Szenenverlusts entspricht der Beschreibung des Ausdrucks desselben Benutzers und Elements in der gesamten Domäne, obwohl ihr Ausdruck möglicherweise nicht für den unabhängigen Merkmalsausdruck jeder Szene geeignet ist, wenn er zu a hinzugefügt wird Globale Aufgabe für das Training Schließlich ist es für die Konvergenz des Gesamteffekts von Vorteil, und eine anschließende experimentelle Analyse kann diesen Punkt ebenfalls belegen.

Als Nächstes stellen wir vor, wie das Rückrufmodell eingesetzt wird. Nachdem das Modelltraining abgeschlossen ist, werden wir das Modell in der Feinabstimmungsphase bereitstellen und online gehen. Bei der Online-Schätzung werden die Informationen jeder Szene durch das Netzwerk der entsprechenden Szene im Modell geleitet, um den Darstellungsvektor in dieser Szene zu erhalten.

Darüber hinaus wird in der Hilfsaufgabe die Ausgabe des gesamten Szenennetzwerks nur in der Trainingsphase verwendet, da es sich um eine gemischte Stichprobe handelt, es zu etwas Rauschen kommen kann und dann beim Schätzen jede Szene stillsteht verwendet die Ausgabe seiner eigenen Szene. Für die Rückrufaufgabe generieren wir auf der Artikelseite diesen Vektor für alle Kandidaten, erstellen dann den entsprechenden Index und generieren den Vektor dann während der Online-Schätzung durch Modellbereitstellung. Anschließend werden die Topk-Ergebnisse durch Vektorabruf erhalten und schließlich werden die Ergebnisse an die Sortierstufe zurückgegeben, um einige nachfolgende Vorgänge für den gesamten empfohlenen Link durchzuführen.

3. Experimentelle Analyse und praktische Anwendungen

Als nächstes werden wir einige experimentelle Analysen und praktische Anwendungen anhand dieses Modells vorstellen.

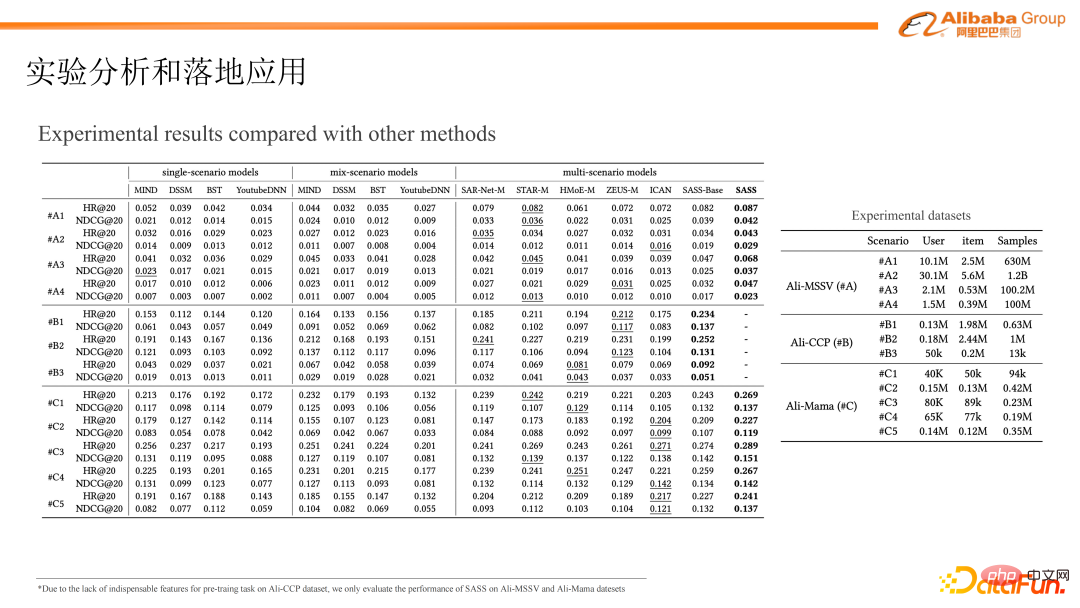

Wir haben die Wirkung mit anderen Methoden an zwei Open-Source-Datensätzen und dem Industriedatensatz unseres eigenen Unternehmens verglichen.

Die verglichenen Methoden sind hauptsächlich in drei Kategorien unterteilt: das traditionelle Einzelszenenmodell Da wir uns auf eine Rückrufaufgabe konzentrieren, vergleichen wir einige der beliebtesten Rückrufmethoden in der Branche, wie z wie YoutubeDNN und MIND, BST, DSSM usw. Diese Einzelszenenmodelle werden mit unabhängigen Stichproben aus jeder Szene trainiert. Der zweite Typ besteht darin, gemischte Proben aus mehreren Szenen für das Training zu verwenden. Das Modell verwendet immer noch das in der Branche häufig verwendete Einzelszenenmodell. Die dritte Kategorie sind einige in der Branche vorhandene und von uns vorgeschlagene Methoden zur gemeinsamen Modellierung mehrerer Szenarien. Einige dieser Methoden werden in der Sortierphase verwendet, und für die Implementierung in der Rückrufphase vergleichen wir diese Methoden ist leicht modifiziert – das heißt, die Ausgabe der letzten Schicht des Ranking-Modellnetzwerks wird als Darstellungsvektor zur Anpassung an die Rückrufaufgabe verwendet.

Die letzten beiden Spalten in der obigen Tabelle sind die von uns vorgeschlagenen Modelle, wobei SASS-Base eine Modellstruktur ohne Vortraining ist, während SASS eine Vortrainingsphase hinzufügt. Da der zweite von uns überprüfte Datensatz ein Problem mit fehlenden Funktionen aufweist und die Aufgabe vor dem Training nicht unterstützen kann, haben wir uns auf den Vergleich der Auswirkungen von SASS-Base und anderen Methoden auf diesen Datensatz konzentriert.

Aus dem Vergleich verschiedener Arten von Methoden haben wir mehrere wertvolle Schlussfolgerungen gezogen. Der erste Punkt ist, dass ein Einzelszenenmodell, das mit gemischten Stichproben trainiert wird, in den meisten Fällen weniger effektiv ist als ein Einzelszenenmodell, das mit seinen eigenen separaten Stichproben trainiert wird. Dies steht im Einklang mit der Schlussfolgerung unserer vorherigen Demonstration und Umfrage, dass diese Methode zum Mischen von Proben zu mehr Rauschen führen und die ursprüngliche Datenverteilung jeder Szene zerstören kann. Bei einigen kleinen Szenen mit besonders spärlichen Daten können jedoch gemischte Stichproben bessere Ergebnisse erzielen. Denn für diese Szenarien ist es schwierig, effektive Informationen zu lernen, wenn man mit spärlichen Daten trainiert. Die Verwendung dieser Methode mit gemischten Stichproben kann zwar verzerrt sein, sie kann jedoch durch die Vergrößerung der Stichprobengröße und die Effektverbesserung einige Vorteile bringen. Die zweite Schlussfolgerung ist, dass die durch die gemeinsame Modellierung mehrerer Szenarien trainierten Modelle im Allgemeinen besser sind als die ersten beiden Arten von Einzelszenario-Modellierungsmethoden. Das von uns vorgeschlagene Modell fügt keine Vortrainingsaufgaben hinzu, d. h. die SASS-Basis Modellstruktur: Grundsätzlich ist es in jeder Szene besser als andere gemeinsame Modellierungsmethoden für mehrere Szenen oder kann ähnliche Ergebnisse erzielen. Nach der Überlagerung der Vortrainingsaufgaben wurde der Gesamteffekt weiter verbessert.

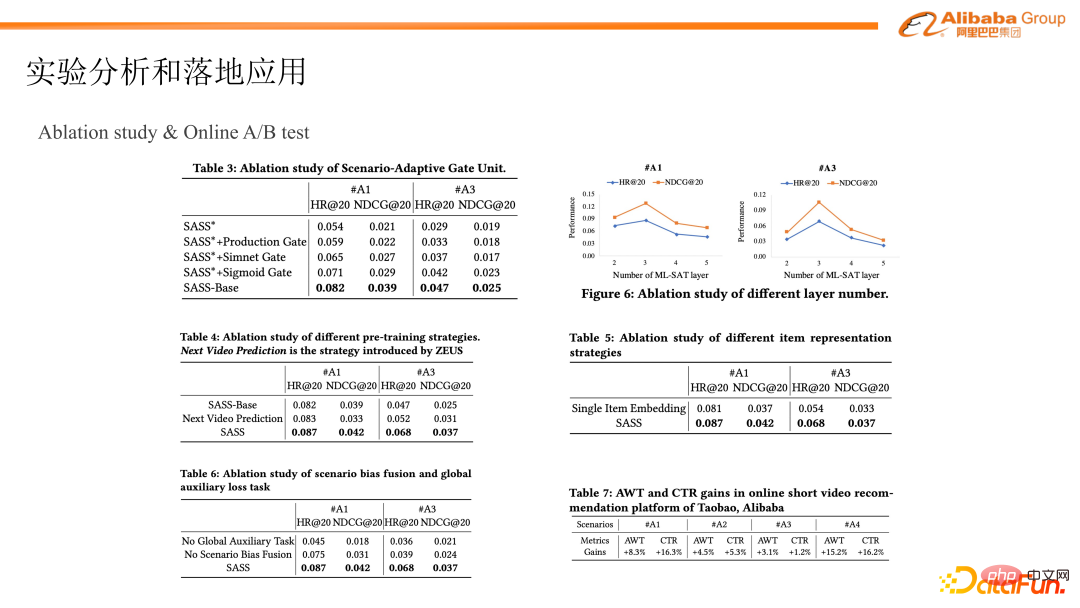

Die erste ist eine adaptive Gate-Struktur, die die Übertragung von Informationen von einer globalen Szene zu einer einzelnen Szene beschreibt. Wir haben die Struktur des Gate-Netzwerks des Modells mit anderen vorhandenen Gate-Migrationsmethoden verglichen, einschließlich (1) Verwendung einer Matrixmultiplikationszuordnung, um eine Informationsmigration zu erreichen (2) Verwendung zweier Funktionen, die Simnet ähneln. Diese Migrationsmethode dient der Durchführung von Addition, Multiplikation und Spleißen. und dann die Fusion über MLP durchführen; (3) Eine MOE-ähnliche Netzwerkstruktur, die über das Sigmoid-Gate migriert wird. Den tatsächlichen experimentellen Ergebnissen nach zu urteilen, kann unsere adaptive Methode schließlich gute Ergebnisse erzielen.

Der zweite Punkt besteht darin, zu vergleichen, ob Vortrainingsaufgaben hinzugefügt werden sollen und welche Auswirkungen verschiedene Arten von Vortrainingsaufgaben auf die experimentellen Ergebnisse haben. Die kontrastierende Vortrainingsmethode ist die Trainingsaufgabe, das nächste Video oder das nächste Element anhand der Verhaltenssequenz des Benutzers vorherzusagen. Nach dem Vergleich der Ergebnisse kann bewiesen werden, dass die Aufgabe vor dem Training hinzugefügt wurde und die Wirkung des Modells durch kontrastives Lernen zwischen Szenen verbessert werden kann.

Der dritte Punkt besteht darin, das Hilfsnetzwerk und eine Hilfsaufgabe im Modellstrukturentwurf zu demonstrieren. Eine davon besteht darin, dass wir in der Feinabstimmungsphase ein global gemeinsames Netzwerk einführen und die Ausgabeergebnisse dieses Netzwerks verwenden, um ein zusätzliches Feinabstimmungstraining durchzuführen. Die andere besteht darin, dass wir die szenenbezogenen Informationen in unseren Netzwerkstrukturentwurf integrieren für die Ausgabe jeder Szene. Experimentelle Ergebnisse belegen auch, dass die Hinzufügung dieser beiden Strukturen eine gewisse Verbesserung des Gesamtmodelleffekts bewirkt.

Da es sich bei unserem Repräsentationsnetzwerk außerdem um eine mehrschichtige Informationsübertragungsstruktur handelt, haben wir auch die Verbesserung der Wirkung unseres Modells durch Erhöhung der Anzahl der Netzwerkschichten verglichen. Es ist ersichtlich, dass der Gesamttrend darin besteht, dass sich der Modelleffekt mit zunehmender Anzahl der Netzwerkschichten zunächst verbessert und dann abnimmt. Die anschließende Erhöhung der Anzahl der Netzwerkschichten führte zu einer Verschlechterung des Effekts. Wir haben analysiert, dass dies möglicherweise daran liegt, dass die gesamte Parametermenge mit zunehmender Anzahl der Netzwerkschichten zunimmt und es zu einigen Überanpassungsphänomenen kommt. Darüber hinaus kann die Durchführung dieser großen Informationsmigration nach Erhalt der Darstellung der oberen Ebene dazu führen, dass die Darstellung einer einzelnen Szene anfälliger für den Einfluss der vollständigen Szeneninformationen wird. Daher kann eine Erhöhung der Anzahl der Schichten dieser mehrschichtigen Netzwerkstruktur den Effekt bis zu einem gewissen Grad verbessern, die Anzahl der Netzwerkschichten ist jedoch nicht unbedingt besser.

In der nächsten Reihe von Experimenten haben wir die Darstellungsvektoren verschiedener Elementseiten für die Rückrufaufgabe verglichen, da jede Szene beim Rückruf ihren eigenen Vektor generiert. Bei manchen Modellen mit mehreren Szenarien hat die Benutzerseite unterschiedliche Ausdrücke, aber die Elementseite wird nicht im Detail beschrieben. In unserer Rückrufaufgabe entsprechen die Benutzerseite und die Elementseite jeder Szene. Daher haben wir auch den Artikelausdruck verglichen, der jeder Szene entspricht, und die Einbettung auf derselben Artikelseite, die von der Szene gemeinsam genutzt wird. Durch Vergleich wurde festgestellt, dass die unabhängigen Vektorausdrücke jeder Szene auch auf der Elementseite unterschieden werden können.

Schließlich haben wir mit diesem Modell ein Online-A/B-Experiment in einem tatsächlichen Content-Empfehlungsszenario durchgeführt. Bei einigen experimentellen Indikatoren wurden gute Ergebnisse erzielt, insbesondere in einigen relativ kleinen Szenen oder bei spärlichen Daten ist die Verbesserungsrate höher.

Derzeit wurde die von uns vorgeschlagene Modelllösung in den Inhaltsempfehlungsszenarien von Taobao beworben, einschließlich kurzer Videos, Bild- und Textempfehlungen usw., und dieses Modell hat sich in verschiedenen Szenarien zu einer der wichtigsten Rückrufmethoden entwickelt.

4. Zusammenfassung

Lassen Sie uns abschließend zusammenfassen. Insgesamt ist das Problem, das wir lösen möchten, das Problem der Multi-Szenario-Modellierung im Empfehlungsbereich, das auch in Empfehlungssystemen ein häufiges Problem darstellt. Bei dieser Art der Multi-Szenario-Modellierung besteht unser Hauptziel darin, die Nutzung von Informationen zwischen verschiedenen Szenarien durch den Aufbau eines einheitlichen Frameworks zu maximieren. Diese gemeinsame Modellierungsmethode löst das Problem der Datenspärlichkeit und verbessert die Geschäftsindikatoren jedes Szenarios. Und durch die gleiche Methodenarchitektur werden die Kosten für die Modelliteration und -bereitstellung reduziert. Aber in unseren tatsächlichen Geschäftsanwendungen steht die Multi-Szenario-Modellierung vor drei zentralen Herausforderungen. Der erste Punkt ist, wie eine Verfeinerung und Migration effektiver Szeneninformationen erreicht werden kann. Außerdem geht es darum, wie das Problem der Datenspärlichkeit bei der Mehrszenenmodellierung gelöst werden kann und wie einige unbeschriftete Daten eingeführt werden können -Szenengelenkmodellierung Landung durchführen.

In unserer Praxis entwerfen wir diese adaptive Netzwerkarchitektur für die Übertragung von Szeneninformationen und konstruieren unbeaufsichtigte Aufgaben des kontrastiven Lernens zwischen Szenen, einschließlich Modellstrukturdesign, Trainingsmethoden und Bereitstellungsaufgaben, die an die Rückrufphase angepasst sind, um die oben genannten Herausforderungen zu lösen. Schließlich ist dieses szenenadaptive, unbeaufsichtigte Modell derzeit in allen Szenen gut implementiert und wird als Hauptabrufmethode verwendet. F1: Welche Indikatoren werden verwendet, um die Verbesserung des Modells in jedem Szenario zu bewerten?

A1: Dies ist ein Problem bei der Modellbewertung. Es muss den Modellierungszielen jedes Szenarios entsprechen und dann die Verbesserung der Indikatoren untersuchen nach Szenario. Wenn es sich um eine Aufgabe in der Rückrufphase handelt, werden für jede entsprechende Szene die rückrufbezogenen Bewertungsindikatoren ausgewählt, z. B. Trefferquote oder NDCG. Wenn es sich um die Sortierphase handelt, sollten wir uns hauptsächlich auf einige sortierungsbezogene Indikatoren wie AUC und GAUC konzentrieren.

F2: Sind die Funktionen der beiden SASS-Szenarien gleich?

A2: Erstens, weil wir ein Multiszenenproblem als Ganzes lösen. Wie die Definition zeigt, sind die Samples zwischen den einzelnen Szenen weitgehend ausgerichtet. Wenn wir also tatsächlich modellieren, versuchen wir, alle Features auszurichten und zu reduzieren. Für den Fall, dass jede Szene noch einige einzigartige Merkmale aufweist, haben wir außerdem ein Szenen-Bias-Netzwerk entworfen. Für diejenigen Merkmale, die nicht vollständig ausgerichtet werden können, werden wir sie in diese separate Netzwerkstruktur einfügen.F3: Haben Sie darüber nachgedacht, den Code als Open Source zu veröffentlichen?

A3: Dieser Codesatz wird derzeit in den tatsächlichen Geschäftsszenarien des Unternehmens verwendet, und Open Source muss den Compliance-Anforderungen des Unternehmens zur Offenlegung von Informationen entsprechen . Wir werden in Zukunft kommunizieren und möglicherweise eine Demoversion für Open Source bereitstellen.F4: Werden diese Modelle auch in der Rückrufphase verwendet?

A4: Unser aktuelles Modell selbst wird in der Rückrufphase implementiert, daher wird in einer solchen Rückrufphase auch das gesamte Modell eingesetzt Es handelt sich um eine relativ allgemeine Lösung, die mit einigen Modifikationen als Sortiermodell verwendet werden kann.F5: Welche Art von Negativstichproben wird im Modell verwendet?

A5: Negative Stichproben werden hauptsächlich in der Feinabstimmungsphase durchgeführt. Wir verwenden eine negative Stichprobenmethode, die bei Rückrufaufgaben häufiger vorkommt, bei der die Klicks des Benutzers als positive Stichproben verwendet werden und die negativen Stichproben basierend auf der Expositionswahrscheinlichkeit des Elements in jeder Szene zufällig ausgewählt werden. Dann in mehreren Szenen, da unsere gesamte Trainingsaufgabe weiterhin in jeder Szene separat trainiert wird. Daher werden bei der Negativabtastung auch die den Positivproben entsprechenden Negativproben zufällig im der Szene entsprechenden Belichtungsraum abgetastet. Auf diese Weise wird ein Paar aus positiven und negativen Proben erstellt.

F6: Können die Produkt-Kurzvideoszenenseite und die Themenseite des Taobao-Informationsflusses diesen Modellsatz verwenden? Kann es mit Produktempfehlungsszenarien kombiniert werden? Muss das Ziel vereinheitlicht werden? Videos haben beispielsweise manchmal lange Ziele.

A6: Lassen Sie mich das Inhaltsempfehlungsszenario aufschlüsseln, das derzeit auf Taobao implementiert ist. Das heißt, der Gesamtinhalt ist der Hauptträger, also auch Bilder, Texte und Videos. Dieses Stück ist vollständig anpassbar, da sein Gesamtfunktionssystem im Grunde das gleiche ist und vollständig wiederverwendet werden kann. Und ein weiterer Punkt ist eigentlich, was wir im nächsten Schritt tun müssen, nämlich die Produkte und Inhalte zu erwähnen, und ihre eigenen Datenverteilungs- und Feature-Systeme sind tatsächlich unterschiedlich. Dies kann eher als domänenübergreifendes Problem verstanden werden . Es handelt sich um eine Verschmelzung der Produktdomäne und der Inhaltsdomäne. Unsere nächste Arbeitsphase hofft auch, solche domänenübergreifenden Ideen in mehrere Szenarien einzuführen und einige Verhaltensinformationen von der Warendomäne in die Inhaltsdomäne zu migrieren. Dies ist der erste Punkt. Was den zweiten Punkt betrifft, was die Vereinheitlichung der Ziele betrifft, so haben wir die Vereinheitlichung der Ziele nun erreicht. Wenn es beispielsweise um Klicks auf der Startseite geht, verwenden wir das Klicksignal des Benutzers als positives Beispiel. In diesem endlosen Auf- und Abfluss gibt es jedoch tatsächlich keinen Benutzerklick. Dann verwenden wir das lange Spiel des Benutzers und andere Dauersignale wie die positive Stichprobe. Positives Feedback bedeutet, dass die Gesamtbezeichnung auf eine solche binäre Dimension abgeflacht wird.

F7: Können Sie die unbeaufsichtigte Aufgabe des vergleichenden Lernens zwischen Szenen im Detail vorstellen?

A7: Insgesamt folgen wir immer noch dieser vergleichenden Lernidee. Tatsächlich besteht der entscheidende Punkt darin, die Funktionen auf Szenen aufzuteilen und sie dann für die Vorstufe zu erstellen -Trainingsaufgaben können Sie auf meine vorherige PPT-Erklärung oder die Einführung in unserem Artikel (Szenario-adaptives und selbstüberwachtes Modell für personalisierte Empfehlung mit mehreren Szenarien) verweisen.

F8: Verwenden die Benutzerseite und die Artikelseite des Pre-Training-Modells Klickbeispiele?

A8: Die Vortrainingsaufgabe wird auf einem Raum ohne Beschriftungen ausgeführt. Ein Benutzer besucht beispielsweise a und besucht b. sowie einige statische Attributmerkmale des Benutzers und die historisch erhaltene Benutzerverhaltenssequenz, die jeder Szene entspricht, bilden dann ein Merkmalssystem für denselben Benutzer in den beiden Szenen a und b. Das Modellierungsziel des Vortrainings besteht darin, diesen Zugriffsbenutzer zu modellieren und den Abstand zwischen den beiden Darstellungsvektoren zwischen Szene a und Szene b durch ein solches Merkmalsmaß zu verkürzen. Daher handelt es sich tatsächlich um eine unbeaufsichtigte Aufgabe, die auf einem klickfreien Beispielbereich trainiert wird.

F9: Wie integriere ich mehrere Ziele in jede Szene?

A9: Das ist tatsächlich ein weiteres Problem. Wir hoffen, dass alle Szenen das gleiche Ziel haben B. das Klickziel oder das von uns umgewandelte Zwei-Kategorie-Ziel, zeigt tatsächlich, ob der Nutzer an diesem Inhalt oder diesem Video interessiert ist. Was die gerade erwähnte Multi-Szenen- und Multi-Target-Methode betrifft, so unterscheidet sie sich tatsächlich etwas von der Multi-Szene-Methode, aber ich verstehe, dass eine solche Multi-Target-Modellierungsmethode auf dieser Multi-Szenen-Modellierung aufgebaut werden kann. Denn derzeit wird viel an der gemeinsamen Darstellung mehrerer Szenen und mehrerer Ziele gearbeitet. In unserer aktuellen Architektur verfügt beispielsweise jedes Sample nach dem Durchlaufen des Darstellungsnetzwerks über einen unabhängigen Vektorausdruck, der jeder Szene entspricht Wir verwenden diesen Vektorausdruck als Eingabe und erstellen dann für jedes Ziel ein einzigartiges zielbezogenes Feature-Netzwerk. Wir können tatsächlich gemeinsame Aufgaben mit mehreren Zielen und mehreren Szenarien ausführen. Sie können unsere aktuelle Multi-Szenario-Trainingsmethode als Grundgerüst betrachten und darauf basierend weitere Multi-Ziel-Aufgaben modellieren. Ich denke, das macht Sinn. F10: Wie wird der Verlust des kontrastiven Lernens in der Vorbereitungsphase gestaltet?

A10: Dieser Verlust ähnelt tatsächlich der traditionellen vergleichenden Lernlösung, also in einer Stapelgröße von Among the Bei n Trainingsproben werden die beiden vom selben Benutzer oder Gegenstand in der entsprechenden Szene generierten Vektoren als positive Proben betrachtet, und die 2n-2 generierten Vektoren, die anderen Proben entsprechen, werden als negative Proben betrachtet. Auf diese Weise wird ein Verlust konstruiert zum Training.

F11: Wie kann man in der Vortrainingsphase mehrere Ansichten für ein Element erstellen?

A11: Worauf wir uns gerade konzentriert haben, ist die Benutzerseite, die Artikelseite hat also tatsächlich die gleiche Struktur. Auf der Artikelseite gibt es auch ein globales gemeinsames Netzwerk für den Artikel selbst und einen Ausdruck eines Netzwerkparameters für jeden Artikel in jeder Szene in jeder Szene. Durch die gleiche Modellmethode handelt es sich daher auf der Benutzerseite um eine vollständig symmetrische Struktur. Jedes Element wird durch einen solchen global gemeinsam genutzten Parameter und die Netzwerkstruktur jeder Szene migriert und verfügt schließlich über eine unabhängige Ausgabe, die sich auf die Szene bezieht.

F12: Wie aktuell ist das Modell? Wie oft werden Modelle aktualisiert? Ist es Flow-Training?

A12: Das ist eine gute Frage. Unser aktuelles Modell wird tatsächlich offline trainiert und täglich aktualisiert. Dann unternehmen wir auch einige Ersatzversuche, in der Hoffnung, die Aktualität zu verbessern und Streaming-Schulungen durch Online-Lernen durchzuführen. Natürlich gibt es derzeit noch einige Probleme, die sich hauptsächlich in einer solchen Multi-Szenario-Trainingsmethode widerspiegeln. Tatsächlich müssen bei dieser Art von Streaming-Training Daten aus mehreren Quellen eingegeben werden Der gleichzeitige Zugriff auf mehrere Quellen und die Sicherstellung eines stabilen Trainings stellen tatsächlich eine relativ große Herausforderung dar, sodass unser aktuelles Modell immer noch auf der Offline-Tagesebene aktualisiert wird. Möglicherweise werden wir in Zukunft einige Versuche unternehmen, z. B. das aktuelle gemeinsame Offline-Training mit mehreren Szenarien als Basismodell behandeln und dann die Streaming-Daten durch Modellwiederherstellung für ein einzelnes Szenario verfeinern und auf diese Weise iterative Aktualisierungen durchführen.

F13: Wie werden die vorab trainierten Beispiele erstellt?

A13: Das wurde gerade erst eingeführt. Der allgemeine Kernpunkt besteht darin, dass derselbe Benutzer den Ausdruck einiger Funktionen in verschiedenen Szenarien aufteilt. Beispielsweise weisen die beiden Szenarien a und b einige statische Funktionen auf und hinterlassen gleichzeitig unabhängige Benutzerverhalten in den entsprechenden Szenarien , sowie einige statistische Informationen eines solchen Benutzers in der entsprechenden Szene, wie z. B. Kategoriepräferenzen, Kontopräferenzen und einige statistische Merkmale wie die Klickexposition. Dies entspricht der Aufteilung der Feature-Struktur der Daten in verschiedene Szenarien, sodass derselbe Benutzer in verschiedenen Szenarien über unterschiedliche Features verfügen kann. Dies ist die Struktur der Features und der Beispiele. Wenn ein Benutzer mehrere Szenen besucht, werden die Szenen paarweise kombiniert, um ein solches Beispielpaar zu erstellen. Auf der Artikelseite kann ein Artikel dann auf mehreren Szenen platziert werden, sodass durch die paarweise Kombination zwischen mehreren Szenen auch Muster des Artikels erstellt werden können.

F14: Gibt es eine Indikatorenbewertung für kontrastives Lernen vor dem Training?

A14: Unsere Vortrainingsphase ist eine unbeaufsichtigte Aufgabe, die Darstellung ihrer Einbettung durch die Vortrainingsaufgabe zu erhalten die Initialisierung der entsprechenden Netzwerkparameter. Daher analysieren wir bei der Bewertung des kontrastiven Lernens vor dem Training hauptsächlich den Effekt durch visuelles Clustering von Vektoren, die in der Phase vor dem Training erzeugt wurden.

F15: Das Multi-Szenario-Modell hat in einigen Szenarien positive Renditen, in einigen Szenarien jedoch negative Renditen ?

A15: Dies ist eigentlich eine Darstellung der Gemeinsamkeiten und Unterschiede von Szenen. Die ursprüngliche Absicht unserer Multiszenenlösung ist die Vereinheitlichung nach dem Modell wird gestärkt, es wird in jedem Szenario optimiert. Natürlich ist es in der Realität, insbesondere in nachfolgenden Iterationen, nicht möglich, mit derselben Modellarchitektur in allen Szenarien einen 100-prozentigen Erfolg zu erzielen, und einige der Vorteile sind möglicherweise nicht offensichtlich. Zu diesem Zeitpunkt müssen wir also tatsächlich einige Feinabstimmungsentwürfe für die obere Struktur erstellen, die auf den Merkmalen jeder Szene in unserer aktuellen Multi-Szenario-Architektur basieren. Das heißt, Multi-Szenarien können in der zugrunde liegenden Einbettungsfreigabe und -information verwendet werden Migrations-Framework, um dies zu tun. Natürlich hat jedes Szenario seine eigenen Netzwerkeigenschaften. Beispielsweise verfügen einige starke Triggerinformationen im zweiten Hop über einige unabhängige Feature-Strukturen, die eine gewisse Anpassung auf der oberen Ebene erfordern.

F16: Wird das vorab trainierte Modell in verschiedenen Szenarien geteilt?

A16: Die zugrunde liegende Einbettung und das global gemeinsam genutzte Netzwerk werden von jeder Szene gemeinsam genutzt, und jede Szene entspricht ihrem eigenen Netzwerk. Parameter sind für jedes Szenario spezifisch .

F17: Bei der Suche nach dem Online-Datenbankindex sollten die Artikeldarstellungen für verschiedene Szenarien unterschiedlich sein Datenbank oder gemeinsam die Datenbank aufbauen?

A17: Wir verwenden derzeit eine geteilte Datenbankkonstruktionsmethode, das heißt, ein Kandidat, der jeder Szene entspricht, wird unabhängig in jeder Szene generiert .

F18: Ab welcher Größenordnung gilt die Stichprobengröße als spärliche kleine Szene?

A18: Darauf gibt es keine Standardantwort und es muss möglicherweise auf der Grundlage des tatsächlichen Geschäftsszenarios betrachtet werden.

F19: Wird bei dem Rückruf eine manuelle (strategische Produktmanager-)Strategie verwendet?

A19: Da es sich bei der Rückrufphase um einen Mehrkanalrückruf handelt, gibt es viele verschiedene Arten von Rückrufmethoden, wie z. B. Vektorrückruf usw Dann wird es auch einige manuelle Rückrufmethoden geben, die von einigen Betriebsindikatoren bereitgestellt werden. Daher ist die aktuelle Empfehlungsphase tatsächlich eine Fusion verschiedener Arten von Rückrufmethoden, und dann wird der Sortierseite eine einheitliche Bewertung gegeben. Speziell bei dem Modell, über das wir heute sprechen, liegt der Fokus weiterhin auf der Optimierung dieses Modells. F20: Kann das Einzelszenario-Modelltraining während der Initialisierung nur die vorab trainierten Parameter erben? Werden dann nach dem Training des Einzelszenenmodells die Parameter des vorab trainierten Modells weiterhin verwendet?

A20: Unser aktueller Plan besteht darin, Modellparameter in der Initialisierungsphase nach dem Modelltraining zu laden. Was die Einbettung und ob die Parameter nach dem Vortraining aktualisiert werden müssen, haben wir zwei Experimente durchgeführt. Das erste besteht darin, das vorab trainierte Modell nach dem Laden zu reparieren, und das zweite darin, währenddessen weiterhin an einem solchen Modelltraining teilzunehmen die Feinabstimmungsphase. Was wir dann derzeit verwenden, ist, die ursprünglichen vorab trainierten Modellparameter während der Feinabstimmungsphase neu zu trainieren.

F21: Wie wird die Reihenfolge mehrerer Szenen in der GRU mehrschichtiger Szenen bestimmt?

A21: Die Reihenfolge zwischen den Szenen ist zufällig, da unser Modell tatsächlich die Informationen einer solchen globalen Szene in eine einzelne Szene migriert, sodass die Trainingsreihenfolge zwischen den Szenen lautet tatsächlich randomisiert.

F22: Was ist der Unterschied zwischen den beiden Ansichtsfunktionen in der Vortrainingsphase? Liegt der Unterschied nur in der Szene?

A22: Ja, in Bezug auf Szenenunterschiede charakterisieren wir im Allgemeinen denselben Benutzer oder dasselbe Element durch die unterschiedlichen Eigenschaften in verschiedenen Szenen Betrachten Sie die Unterschiede zwischen Szenen als eine Möglichkeit zur Datenanreicherung. Nicht nur die Szene allein, sondern auch einige verhaltenstypische Darstellungen von Benutzern und Elementen in der Szene.

F23: Muss die Online-Schätzung vorab trainierte Ausdrücke in Schritten erhalten? Und dann einen Rückruf durchführen?

A23: Das Vortraining soll das Training unserer letzten Rückrufaufgabe unterstützen, daher werden wir bei der Schätzung nur die zweite Stufe der Feinabstimmungsaufgaben verwenden einsetzen. Sie können ein solches Twin-Tower-Strukturmodell als klassischeres DSSM verstehen. Daher wird die Modellstruktur in der Feinabstimmungsphase schließlich verwendet, um online zu gehen, und dann werden der benutzerseitige Ausdruck und der elementseitige Ausdruck ausgegeben, wenn die Darstellungseingabe geschätzt wird.

A24: Eine andere Möglichkeit, diese Frage zu formulieren, ist, ob der zweistufige Ansatz, den wir derzeit verwenden, in ein durchgängiges Training umgewandelt werden kann. Es geht darum, zwischen den Szenen der Trainingsaufgabe ein unbeaufsichtigtes Training durchzuführen und auf dieser Grundlage gleichzeitig ein gemeinsames Training des Benutzer- und Artikelrückrufs durchzuführen. Dieser Ansatz scheint machbar, aber der Grund, warum wir ihn nicht gemacht haben, ist, dass er das Problem der Verwendung unbeschrifteter Beispieldaten nicht löst. Das heißt, die in unseren zweistufigen Aufgaben verwendeten Proben unterscheiden sich tatsächlich. In der Vortrainingsphase wird ein größerer Bereich unbeschrifteter Daten verwendet, und in der Feinabstimmungsphase werden dann die beschrifteten Daten verwendet. Wenn gemeinsames Training verwendet wird, kann das Training nur für solche gekennzeichneten Daten durchgeführt werden, und der Probenraum wird tatsächlich reduziert. Dies unterscheidet sich etwas von unserer ursprünglichen Entwurfsabsicht. A25: Dadurch wird eine Migration auf jeder Ebene durchgeführt, d. h. bei einer mehrschichtigen Struktur führt eine einschichtige Struktur eine Nachricht aus Migrieren Sie diese Struktur und stapeln Sie sie dann. Nach den Ergebnissen eines aktuellen Experiments ist die Wirkung etwas besser, wenn Sie nach mehreren Vergleichen Schicht 3 auswählen. Daher ist in unserer tatsächlichen Geschäftsimplementierung die Anzahl der diesem Modell entsprechenden Schichten ebenfalls auf 3 festgelegt. A26: Unsere Aufgaben in der Vortrainings- und Feinabstimmungsphase sind inkrementelle Schulungen auf Tagesebene, und während der Feinabstimmung wird dann das Vortraining importiert -Tuning-Phase In dieser Phase sind beide Seiten gleichbedeutend mit einem parallelen inkrementellen Training und dem anschließenden Laden von Parametern in der Mitte. A27: Ich habe gerade erwähnt, dass unsere gesamte Trainingsmethode ein inkrementelles Training ist, sodass ihre Zeitfenster grundsätzlich aufeinander abgestimmt sind. F24: Können der Verlust des vergleichenden Lernens und der Verlust der Feinabstimmung gemeinsam trainiert werden?

F25: Werden im Modell der ML-SAT-Stufe die Funktionen von Update-Gate und Adapt-Gate selbst in jeder Schicht von MLP verwendet oder? Wird es nur wirksam, wenn die oberste Ebene zusammengeführt wird?

F26: Wie viele Tage an Daten werden für das Vortraining verwendet? Wird nur einmal vorab trainiert?

F27: Nutzen Vortraining und Feinabstimmung Daten aus demselben Zeitfenster?

Das obige ist der detaillierte Inhalt vonAdaptive und unbeaufsichtigte Multi-Szenario-Modellierungspraxis in personalisierten Taobao-Empfehlungen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1371

1371

52

52

Ich habe versucht, die Vibe -Codierung mit Cursor AI und es ist erstaunlich!

Mar 20, 2025 pm 03:34 PM

Ich habe versucht, die Vibe -Codierung mit Cursor AI und es ist erstaunlich!

Mar 20, 2025 pm 03:34 PM

Die Vibe -Codierung verändert die Welt der Softwareentwicklung, indem wir Anwendungen mit natürlicher Sprache anstelle von endlosen Codezeilen erstellen können. Inspiriert von Visionären wie Andrej Karpathy, lässt dieser innovative Ansatz Dev

Top 5 Genai Starts vom Februar 2025: GPT-4,5, GROK-3 & MEHR!

Mar 22, 2025 am 10:58 AM

Top 5 Genai Starts vom Februar 2025: GPT-4,5, GROK-3 & MEHR!

Mar 22, 2025 am 10:58 AM

Februar 2025 war ein weiterer bahnbrechender Monat für die Generative KI, die uns einige der am meisten erwarteten Modell-Upgrades und bahnbrechenden neuen Funktionen gebracht hat. Von Xais Grok 3 und Anthropics Claude 3.7 -Sonett, um g zu eröffnen

Wie benutze ich Yolo V12 zur Objekterkennung?

Mar 22, 2025 am 11:07 AM

Wie benutze ich Yolo V12 zur Objekterkennung?

Mar 22, 2025 am 11:07 AM

Yolo (Sie schauen nur einmal) war ein führender Echtzeit-Objekterkennungsrahmen, wobei jede Iteration die vorherigen Versionen verbessert. Die neueste Version Yolo V12 führt Fortschritte vor, die die Genauigkeit erheblich verbessern

Sora vs Veo 2: Welches erstellt realistischere Videos?

Mar 10, 2025 pm 12:22 PM

Sora vs Veo 2: Welches erstellt realistischere Videos?

Mar 10, 2025 pm 12:22 PM

Google's Veo 2 und Openais Sora: Welcher AI -Videogenerator regiert oberste? Beide Plattformen erzeugen beeindruckende KI -Videos, aber ihre Stärken liegen in verschiedenen Bereichen. Dieser Vergleich unter Verwendung verschiedener Eingabeaufforderungen zeigt, welches Werkzeug Ihren Anforderungen am besten entspricht. T

Gencast von Google: Wettervorhersage mit Gencast Mini Demo

Mar 16, 2025 pm 01:46 PM

Gencast von Google: Wettervorhersage mit Gencast Mini Demo

Mar 16, 2025 pm 01:46 PM

Gencast von Google Deepmind: Eine revolutionäre KI für die Wettervorhersage Die Wettervorhersage wurde einer dramatischen Transformation unterzogen, die sich von rudimentären Beobachtungen zu ausgefeilten AI-angetriebenen Vorhersagen überschreitet. Google DeepMinds Gencast, ein Bodenbrei

Ist Chatgpt 4 o verfügbar?

Mar 28, 2025 pm 05:29 PM

Ist Chatgpt 4 o verfügbar?

Mar 28, 2025 pm 05:29 PM

Chatgpt 4 ist derzeit verfügbar und weit verbreitet, wodurch im Vergleich zu seinen Vorgängern wie ChatGPT 3.5 signifikante Verbesserungen beim Verständnis des Kontextes und des Generierens kohärenter Antworten zeigt. Zukünftige Entwicklungen können mehr personalisierte Inters umfassen

Welche KI ist besser als Chatgpt?

Mar 18, 2025 pm 06:05 PM

Welche KI ist besser als Chatgpt?

Mar 18, 2025 pm 06:05 PM

Der Artikel erörtert KI -Modelle, die Chatgpt wie Lamda, Lama und Grok übertreffen und ihre Vorteile in Bezug auf Genauigkeit, Verständnis und Branchenauswirkungen hervorheben. (159 Charaktere)

O1 gegen GPT-4O: Ist OpenAIs neues Modell besser als GPT-4O?

Mar 16, 2025 am 11:47 AM

O1 gegen GPT-4O: Ist OpenAIs neues Modell besser als GPT-4O?

Mar 16, 2025 am 11:47 AM

Openais O1: Ein 12-tägiger Geschenkbummel beginnt mit ihrem bisher mächtigsten Modell Die Ankunft im Dezember bringt eine globale Verlangsamung, Schneeflocken in einigen Teilen der Welt, aber Openai fängt gerade erst an. Sam Altman und sein Team starten ein 12-tägiges Geschenk Ex