Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Neue Forschungsergebnisse aus Stanford und Berkeley stürzen Googles „Quantenüberlegenheit'! In der Theorie schön, in der Praxis jedoch nutzlos

Neue Forschungsergebnisse aus Stanford und Berkeley stürzen Googles „Quantenüberlegenheit'! In der Theorie schön, in der Praxis jedoch nutzlos

Neue Forschungsergebnisse aus Stanford und Berkeley stürzen Googles „Quantenüberlegenheit'! In der Theorie schön, in der Praxis jedoch nutzlos

Quantenüberlegenheit, diesen Begriff gibt es schon seit fast 4 Jahren.

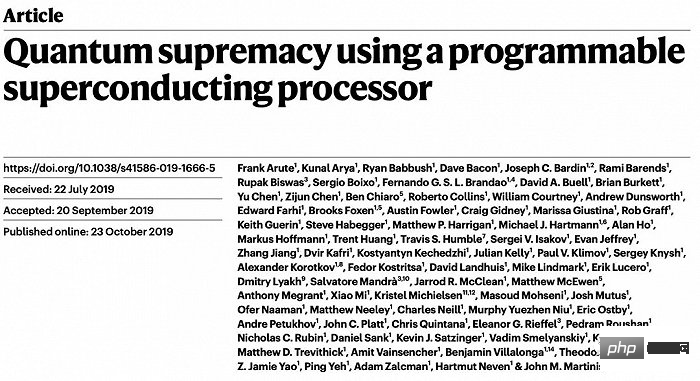

Im Jahr 2019 gaben Google-Physiker bekannt, dass sie mit einer 53-Qubit-Maschine erfolgreich die Quantenhegemonie erreicht hatten, was einen bedeutenden symbolischen Meilenstein darstellt.

In einem in Nature veröffentlichten Artikel wurde festgestellt, dass das Quantensystem nur 200 Sekunden brauchte, um eine Berechnung durchzuführen, während die gleiche Berechnung mit Summit, dem damals leistungsstärksten Supercomputer, etwa 10.000 Jahre dauerte.

Was ist Quantenüberlegenheit?

Die sogenannte „Quantenhegemonie“ oder „Quantenvorteil“ (im Folgenden „Quantenüberlegenheit“ genannt) bedeutet, dass die Aufgaben, die Quantencomputer erledigen können, über den Rahmen jedes möglichen klassischen Algorithmus hinausgehen.

Selbst wenn diese Aufgaben auf den fortschrittlichsten herkömmlichen Supercomputern ausgeführt werden, verliert der Algorithmus aufgrund der langen Berechnungszeit (oft Tausende von Jahren) seine praktische Bedeutung.

Interessanterweise heißt es in den Ergebnissen von Google im Jahr 2019 nur, dass die Quantenhegemonie erreicht wurde, erklärt aber nicht, in welchen konkreten Fällen Quantencomputer klassische Computer übertreffen.

Diese Frage ist schwer zu beantworten, da Quantencomputer derzeit von Fehlern geplagt werden, die sich ansammeln und die Leistung und Stabilität des Quantencomputings beeinträchtigen können.

Tatsächlich wollen Wissenschaftler im Vergleich zum Bereich der Verwirklichung der Quantenhegemonie eine andere Frage mehr wissen: Wenn Quantencomputer immer größer werden, ob klassische Algorithmen mithalten können.

Scott Aaronson, Informatiker an der University of Texas in Austin, sagte: „Wir hoffen, dass sich die Quantenseite irgendwann vollständig distanziert und diesen Wettbewerb vollständig beendet.“

Das spekulieren die meisten Forscher , Die Antwort ist nein.

Das heißt, klassische Algorithmen werden eines Tages überhaupt nicht mehr in der Lage sein, mit dem Tempo des Quantencomputings mitzuhalten, aber es ist ihnen nicht gelungen, dies genau und umfassend zu beweisen. Eine Möglichkeit, diese Schlussfolgerung endgültig zu beweisen, besteht darin, die Bedingungen zu finden, unter denen Quantencomputer einen „dauerhaften Vorteil“ gegenüber herkömmlichen Computern erzielen können.

Nun scheint es auf diese Frage eine vorläufige Antwort zu geben:

Zeitersparnis: Wenn die Fehlerkorrektur nicht mithalten kann, brechen solche Fehler die ideale „Quantenhegemonie“, die die Klassik ermöglicht Algorithmen, um mit Quantenalgorithmen Schritt zu halten.

Kürzlich hat ein gemeinsames Team der Harvard University, der University of California, Berkeley und der Hebrew University in Israel in einem auf Arxiv veröffentlichten Preprint-Artikel einen großen Schritt unternommen, um diese Schlussfolgerung zu bestätigen.

Sie zeigten, dass eine gezielte Fehlerkorrektur eine notwendige Voraussetzung für eine dauerhafte Quantenüberlegenheit beim Zufallsschaltkreis-Sampling ist, und stützten damit die Schlussfolgerungen der Google-Forschung vor einigen Jahren. Auf dem aktuellen Niveau der Quantenfehlerkorrektur gibt es tatsächlich keine Quantenüberlegenheit.

Es gibt keine „goldene Zone“ mehr für die Quantenüberlegenheit

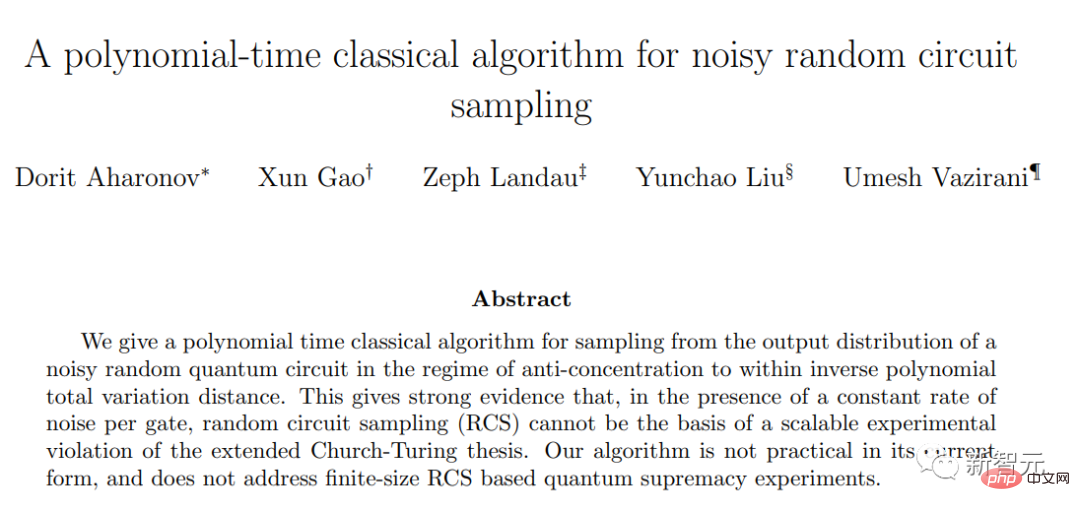

Die Forscher haben einen klassischen Algorithmus entwickelt, der Zufallsstichprobenexperimente simulieren kann, wenn Fehler vorliegen, um diese Schlussfolgerung zu beweisen.

Beginnen Sie mit einer Reihe von Qubits und manipulieren Sie diese Qubits nach dem Zufallsprinzip mithilfe von Operationen, die „Quantengatter“ genannt werden. Einige Quantengatter führen dazu, dass Paare von Qubits miteinander verschränkt werden, was bedeutet, dass sie einen gemeinsamen Quantenzustand haben, der nicht einzeln beschrieben werden kann.

Das wiederholte Einrichten dieser Quantengatter in mehrschichtigen Schaltkreisen kann es Qubits ermöglichen, in komplexere verschränkte Zustände einzutreten.

Um diesen Quantenzustand zu verstehen, haben die Forscher alle Qubits im Array gemessen. Dieses Verhalten führt dazu, dass der kollektive Quantenzustand aller Qubits in eine zufällige Folge gewöhnlicher Bits, nämlich Nullen und Einsen, zusammenfällt.

Die Anzahl der möglichen Ergebnisse wächst schnell mit der Anzahl der Qubits im Array. Im Google-Experiment von 2019 enthielten 53 Qubits fast 10 Billionen Ergebnisse.

Darüber hinaus erfordert diese Methode mehrere wiederholte Messungen aus einem Zufallsschaltkreis, um eine Wahrscheinlichkeitsverteilungskarte der Ergebnisse zu erstellen.

Die Frage zur Quantenüberlegenheit ist, ist es schwierig oder sogar unmöglich, diese Wahrscheinlichkeitsverteilung mit einem klassischen Algorithmus zu imitieren, der keine Verschränkung verwendet?

Im Jahr 2019 haben Google-Forscher bewiesen, dass dieses Ziel für fehlerfreie Quantenschaltungen, die keine Fehler erzeugen, schwierig ist. Es ist in der Tat schwierig, ein zufälliges Schaltkreis-Sampling-Experiment mit klassischen Algorithmen fehlerfrei zu simulieren.

Aus der Perspektive der Rechenkomplexität nimmt die Rechenkomplexität herkömmlicher Klassifizierungsalgorithmen exponentiell zu, wenn die Anzahl der Qubits zunimmt, während die Rechenkomplexität von Quantenalgorithmen polynomial zunimmt.

Wenn n groß genug ansteigt, bleibt ein Algorithmus, der in n exponentiell ist, weit hinter jedem Algorithmus zurück, der in n polynomial ist.

Das ist der Unterschied, auf den wir uns beziehen, wenn wir über ein Problem sprechen, das für einen klassischen Computer schwierig, für einen Quantencomputer jedoch einfach ist. Die besten klassischen Algorithmen benötigen exponentielle Zeit, während Quantencomputer Probleme in polynomieller Zeit lösen können.

Allerdings wurden in der Arbeit von 2019 die Auswirkungen von Fehlern, die durch unvollständige Quantengatter verursacht werden, nicht berücksichtigt, und die Schlussfolgerung der Forschung hinterließ tatsächlich eine Lücke. Mit anderen Worten: Kann eine zufällige Schaltungsabtastung ohne Fehlerkorrektur immer noch eine Quantenhegemonie erreichen?

Wenn man die akkumulierten Fehler berücksichtigt, die bei der Quantenverschränkung entstehen, wird sich tatsächlich die Schwierigkeit der Simulation von Experimenten mit Zufallsschaltungsabtastung mit klassischen Algorithmen erheblich verringern. Und wenn die Rechenkomplexität der klassischen Algorithmussimulation auf das gleiche Polynomniveau wie bei Quantenalgorithmen reduziert wird, wird es keine Quantenhegemonie mehr geben.

Diese neue Arbeit zeigt, dass es unter der Annahme, dass die Schaltkreistiefe konstant gehalten wird, sagen wir, sehr flache 3 Schichten, mit zunehmender Anzahl von Qubits nicht zu viel Quantenverschränkung gibt und die Ausgabe immer noch klassisch simuliert werden kann.

Wenn andererseits die Schaltungstiefe erhöht wird, um mit der zunehmenden Anzahl von Qubits Schritt zu halten, dann wird der kumulative Effekt von Quantengatterfehlern die durch die Verschränkung verursachte Komplexität verwässern und es wird immer noch einfacher, sie zu simulieren Ausgabe mit klassischen Algorithmen.

Zwischen den beiden gibt es eine „goldene Zone“, also das Fenster, in dem die Quantenhegemonie weiterhin überleben kann, also den Bereich, in dem herkömmliche Algorithmussimulationen mit der Quantenverschränkung nicht mithalten können.

Vor der Veröffentlichung dieses Artikels bestand die Quantenüberlegenheit immer noch, wenn die Anzahl der Qubits einen bestimmten Zwischenbereich erreichte, selbst als die Anzahl der Qubits zunahm.

Bei dieser Schaltungstiefe ist es schwierig, den klassischen Algorithmus bei jedem Schritt zu simulieren, auch wenn die Ausgabe aufgrund von Quantenalgorithmusfehlern stetig abnimmt.

Dieses neue Papier beseitigt diese „goldene Zone“ fast.

In der Arbeit wird ein klassischer Algorithmus zur Simulation zufälliger Schaltkreisabtastung abgeleitet und bewiesen, dass seine Laufzeit eine

Polynomfunktionder Zeit ist, die zum Ausführen des entsprechenden Quantenexperiments erforderlich ist, und nicht eine Exponentialfunktion. Dieses Ergebnis stellt einen engen theoretischen Zusammenhang zwischen der Geschwindigkeit der klassischen Methode der Zufallsschaltungsabtastung und der Quantenmethode her, das heißt, es erklärt, dass die in der Theorie erreichte Quantenhegemonie in der Praxis fast nicht existiert.

Der Grund, warum ich „fast“ sage, liegt darin, dass die Grundannahmen des neuen Algorithmus für einige flachere Schaltkreise ungültig sind und eine unbekannte „kleine Lücke“ hinterlässt.

Allerdings hegen nur wenige Forscher noch die Hoffnung, in dieser Lücke die Quantenüberlegenheit zu erreichen. Sogar Bill Fefferman, Informatiker an der University of Chicago und einer der Autoren des Google-Artikels von 2019, sagte: „Ich denke, die Chance ist ziemlich gering.“

Man kann sagen, dass nach den strengen Standards der rechnerischen Komplexitätstheorie die Zufallsschaltungsabtastung keine Quantenüberlegenheit mehr erzeugen wird.

Angesichts dieser Schlussfolgerung sind sich alle Forscher außerdem darüber einig, wie entscheidend die Quantenfehlerkorrektur für den langfristigen Erfolg des Quantencomputings sein wird. Fefferman sagte: „Am Ende haben wir herausgefunden, dass die Quantenfehlerkorrektur die Lösung ist.“

Das obige ist der detaillierte Inhalt vonNeue Forschungsergebnisse aus Stanford und Berkeley stürzen Googles „Quantenüberlegenheit'! In der Theorie schön, in der Praxis jedoch nutzlos. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1376

1376

52

52

Ein tiefer Einblick in Modelle, Daten und Frameworks: eine ausführliche 54-seitige Übersicht über effiziente große Sprachmodelle

Jan 14, 2024 pm 07:48 PM

Ein tiefer Einblick in Modelle, Daten und Frameworks: eine ausführliche 54-seitige Übersicht über effiziente große Sprachmodelle

Jan 14, 2024 pm 07:48 PM

Large-Scale Language Models (LLMs) haben überzeugende Fähigkeiten bei vielen wichtigen Aufgaben bewiesen, darunter das Verständnis natürlicher Sprache, die Sprachgenerierung und das komplexe Denken, und hatten tiefgreifende Auswirkungen auf die Gesellschaft. Diese herausragenden Fähigkeiten erfordern jedoch erhebliche Schulungsressourcen (im linken Bild dargestellt) und lange Inferenzzeiten (im rechten Bild dargestellt). Daher müssen Forscher wirksame technische Mittel entwickeln, um ihre Effizienzprobleme zu lösen. Darüber hinaus wurden, wie auf der rechten Seite der Abbildung zu sehen ist, einige effiziente LLMs (LanguageModels) wie Mistral-7B erfolgreich beim Entwurf und Einsatz von LLMs eingesetzt. Diese effizienten LLMs können den Inferenzspeicher erheblich reduzieren und gleichzeitig eine ähnliche Genauigkeit wie LLaMA1-33B beibehalten

Nvidias GPU der nächsten Generation zerschmettert H100 und wird enthüllt! Das erste 3-nm-Multichip-Moduldesign, vorgestellt im Jahr 2024

Sep 30, 2023 pm 12:49 PM

Nvidias GPU der nächsten Generation zerschmettert H100 und wird enthüllt! Das erste 3-nm-Multichip-Moduldesign, vorgestellt im Jahr 2024

Sep 30, 2023 pm 12:49 PM

3-nm-Prozess, Leistung übertrifft H100! Kürzlich brachten die ausländischen Medien DigiTimes die Nachricht, dass Nvidia die GPU der nächsten Generation, die B100, mit dem Codenamen „Blackwell“ entwickelt, angeblich als Produkt für Anwendungen im Bereich der künstlichen Intelligenz (KI) und des Hochleistungsrechnens (HPC). Der B100 wird den 3-nm-Prozess von TSMC sowie ein komplexeres Multi-Chip-Modul (MCM)-Design nutzen und im vierten Quartal 2024 erscheinen. Nvidia, das mehr als 80 % des GPU-Marktes für künstliche Intelligenz monopolisiert, kann mit dem B100 zuschlagen, solange das Eisen heiß ist, und in dieser Welle des KI-Einsatzes weitere Herausforderer wie AMD und Intel angreifen. Nach Schätzungen von NVIDIA wird erwartet, dass der Produktionswert dieses Bereichs bis 2027 ungefähr erreicht

Die leistungsstarke Kombination aus Diffusions- und Superauflösungsmodellen, der Technologie hinter Googles Bildgenerator Imagen

Apr 10, 2023 am 10:21 AM

Die leistungsstarke Kombination aus Diffusions- und Superauflösungsmodellen, der Technologie hinter Googles Bildgenerator Imagen

Apr 10, 2023 am 10:21 AM

In den letzten Jahren hat multimodales Lernen große Aufmerksamkeit erhalten, insbesondere in den beiden Richtungen der Text-Bild-Synthese und des kontrastiven Bild-Text-Lernens. Einige KI-Modelle haben aufgrund ihrer Anwendung bei der kreativen Bilderzeugung und -bearbeitung große öffentliche Aufmerksamkeit erregt, wie beispielsweise die von OpenAI eingeführten Textbildmodelle DALL・E und DALL-E 2 sowie GauGAN und GauGAN2 von NVIDIA. Um nicht zu übertreffen, hat Google Ende Mai sein eigenes Text-zu-Bild-Modell Imagen veröffentlicht, das die Grenzen der untertitelbedingten Bildgenerierung offenbar noch weiter erweitert. Mit nur einer Beschreibung einer Szene kann Imagen eine hohe Qualität und Auflösung erzeugen

Die umfassendste Übersicht über multimodale Großmodelle finden Sie hier! 7 Microsoft-Forscher arbeiteten intensiv zusammen, 5 Hauptthemen, 119 Seiten Dokument

Sep 25, 2023 pm 04:49 PM

Die umfassendste Übersicht über multimodale Großmodelle finden Sie hier! 7 Microsoft-Forscher arbeiteten intensiv zusammen, 5 Hauptthemen, 119 Seiten Dokument

Sep 25, 2023 pm 04:49 PM

Die umfassendste Übersicht über multimodale Großmodelle finden Sie hier! Es wurde von sieben chinesischen Forschern bei Microsoft verfasst und umfasst 119 Seiten. Es geht von zwei Arten multimodaler Forschungsrichtungen für große Modelle aus, die abgeschlossen wurden und immer noch an der Spitze stehen, und fasst fünf spezifische Forschungsthemen umfassend zusammen: visuelles Verständnis und visuelle Generierung Der vom einheitlichen visuellen Modell LLM unterstützte multimodale Großmodell-Multimodalagent konzentriert sich auf ein Phänomen: Das multimodale Grundmodell hat sich von spezialisiert zu universell entwickelt. Ps. Aus diesem Grund hat der Autor am Anfang des Artikels direkt ein Bild von Doraemon gezeichnet. Wer sollte diese Rezension (Bericht) lesen? Mit den ursprünglichen Worten von Microsoft: Solange Sie daran interessiert sind, das Grundwissen und die neuesten Fortschritte multimodaler Grundmodelle zu erlernen, egal ob Sie ein professioneller Forscher oder ein Student sind, ist dieser Inhalt sehr gut für Sie geeignet.

Neue Forschungsergebnisse zeigen das Potenzial von Quanten-Monte-Carlo, neuronale Netze bei der Überwindung von Beschränkungen zu übertreffen, und eine Unterausgabe von Nature beschreibt die neuesten Fortschritte

Apr 24, 2023 pm 09:16 PM

Neue Forschungsergebnisse zeigen das Potenzial von Quanten-Monte-Carlo, neuronale Netze bei der Überwindung von Beschränkungen zu übertreffen, und eine Unterausgabe von Nature beschreibt die neuesten Fortschritte

Apr 24, 2023 pm 09:16 PM

Nach vier Monaten wurde im internationalen Top-Journal Nature Communications eine weitere Gemeinschaftsarbeit zwischen ByteDance Research und Chen Jis Forschungsgruppe an der School of Physics der Peking-Universität veröffentlicht: der Artikel „Towards the Ground State of Moleculars Via Diffusion Monte Carlo Neural Networks“. Kombiniert neuronale Netze mit Diffusions-Monte-Carlo-Methoden und verbessert so die Anwendung neuronaler Netzmethoden in der Quantenchemie erheblich. Die Berechnungsgenauigkeit, Effizienz und Systemskala für verwandte Aufgaben sind zum neuesten SOTA geworden. Papierlink: https://www.nature.com

I2V-Adapter aus der SD-Community: keine Konfiguration erforderlich, Plug-and-Play, perfekt kompatibel mit dem Tusheng-Video-Plug-in

Jan 15, 2024 pm 07:48 PM

I2V-Adapter aus der SD-Community: keine Konfiguration erforderlich, Plug-and-Play, perfekt kompatibel mit dem Tusheng-Video-Plug-in

Jan 15, 2024 pm 07:48 PM

Die Aufgabe der Bild-zu-Video-Generierung (I2V) ist eine Herausforderung im Bereich Computer Vision, die darauf abzielt, statische Bilder in dynamische Videos umzuwandeln. Die Schwierigkeit dieser Aufgabe besteht darin, dynamische Informationen in der zeitlichen Dimension aus einem einzelnen Bild zu extrahieren und zu generieren und dabei die Authentizität und visuelle Kohärenz des Bildinhalts zu wahren. Bestehende I2V-Methoden erfordern häufig komplexe Modellarchitekturen und große Mengen an Trainingsdaten, um dieses Ziel zu erreichen. Kürzlich wurde ein neues Forschungsergebnis „I2V-Adapter: AGeneralImage-to-VideoAdapter for VideoDiffusionModels“ unter der Leitung von Kuaishou veröffentlicht. Diese Forschung stellt eine innovative Bild-zu-Video-Konvertierungsmethode vor und schlägt ein leichtes Adaptermodul vor, d. h.

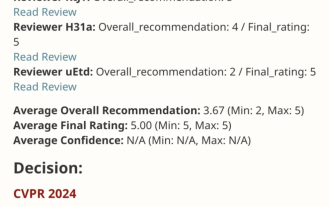

VPR 2024 perfektes Ergebnispapier! Meta schlägt EfficientSAM vor: schnell alles aufteilen!

Mar 02, 2024 am 10:10 AM

VPR 2024 perfektes Ergebnispapier! Meta schlägt EfficientSAM vor: schnell alles aufteilen!

Mar 02, 2024 am 10:10 AM

Diese Arbeit von EfficientSAM wurde mit einer perfekten Bewertung von 5/5/5 in CVPR2024 aufgenommen! Der Autor teilte das Ergebnis in den sozialen Medien mit, wie im Bild unten gezeigt: Der Gewinner des LeCun Turing Award hat dieses Werk ebenfalls wärmstens empfohlen! In einer aktuellen Forschung haben Meta-Forscher eine neue, verbesserte Methode vorgeschlagen, nämlich das Mask Image Pre-Training (SAMI) unter Verwendung von SAM. Diese Methode kombiniert MAE-Vortrainingstechnologie und SAM-Modelle, um hochwertige vorab trainierte ViT-Encoder zu erhalten. Durch SAMI versuchen Forscher, die Leistung und Effizienz des Modells zu verbessern und bessere Lösungen für Sehaufgaben bereitzustellen. Der Vorschlag dieser Methode bringt neue Ideen und Möglichkeiten zur weiteren Erforschung und Entwicklung der Bereiche Computer Vision und Deep Learning. durch die Kombination verschiedener

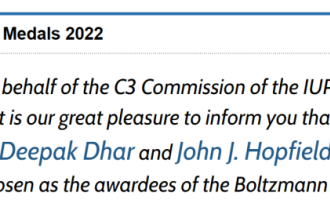

Bekanntgabe des Boltzmann-Preises 2022: Gründer von Hopfield Network gewinnt Auszeichnung

Aug 13, 2023 pm 08:49 PM

Bekanntgabe des Boltzmann-Preises 2022: Gründer von Hopfield Network gewinnt Auszeichnung

Aug 13, 2023 pm 08:49 PM

Die beiden Wissenschaftler, die den Boltzmann-Preis 2022 gewonnen haben, wurden bekannt gegeben. Diese Auszeichnung wurde vom IUPAP-Komitee für statistische Physik (C3) ins Leben gerufen, um Forscher zu würdigen, die herausragende Leistungen auf dem Gebiet der statistischen Physik erbracht haben. Der Gewinner muss ein Wissenschaftler sein, der zuvor weder einen Boltzmann-Preis noch einen Nobelpreis gewonnen hat. Dieser Preis wurde 1975 ins Leben gerufen und wird alle drei Jahre zum Gedenken an Ludwig Boltzmann, den Begründer der statistischen Physik, verliehen. Grund für die Auszeichnung: In Anerkennung der bahnbrechenden Beiträge von Deepak Dharistheoriginalstatement auf dem Gebiet der statistischen Physik, einschließlich der exakten Lösung selbstorganisierter Systeme kritisches Modell, Schnittstellenwachstum, Störung