Seit Alan Turing 1950 in seiner bahnbrechenden Arbeit „Computing Machinery and Intelligence“ erstmals die Frage „Können Maschinen denken?“ verlief, verlief die Entwicklung der künstlichen Intelligenz noch nicht reibungslos Ziel der „allgemeinen künstlichen Intelligenz“.

Das Feld hat jedoch immer noch unglaubliche Fortschritte gemacht, wie zum Beispiel: IBM Deep Blue Robot besiegte die Besten der Welt Schachspieler, die Geburt selbstfahrender Autos und AlphaGo von Google DeepMind, der die weltbesten Go-Spieler besiegt ... Die aktuellen Erfolge zeigen die besten Forschungs- und Entwicklungsergebnisse der letzten 65 Jahre.

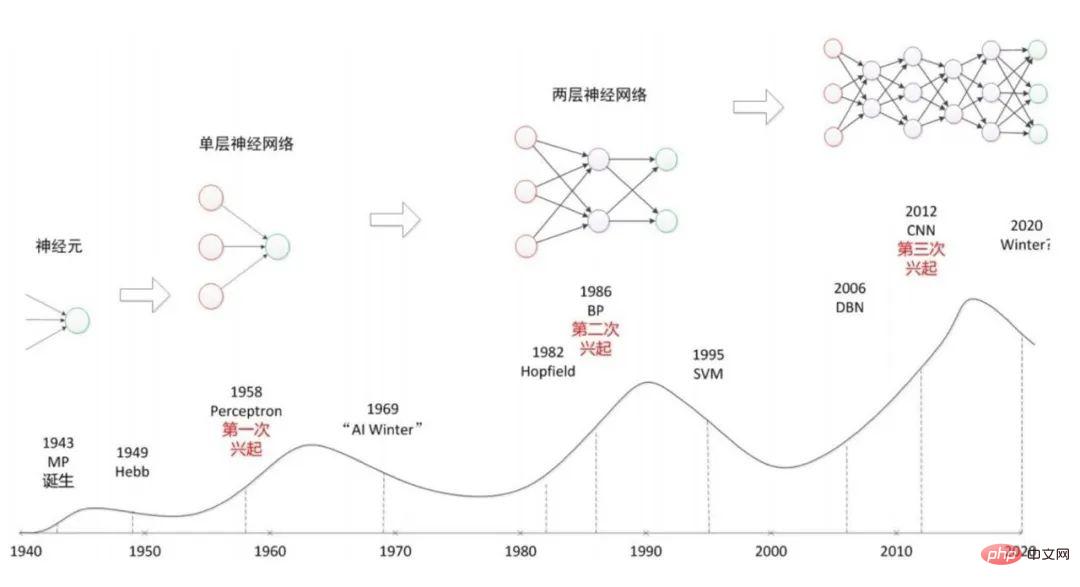

Es ist erwähnenswert, dass es in dieser Zeit einen gut dokumentierten „KI-Winter“ gab, der das frühe Verständnis der Menschen über künstliche Intelligenz fast völlig zunichte machte.

Einer der Faktoren, die zum KI-Winter führen, ist die Kluft zwischen Hype und tatsächlichen grundlegenden Fortschritten.

In den letzten Jahren gab es Spekulationen darüber, dass ein weiterer Winter der künstlichen Intelligenz bevorstehen könnte. Welche Faktoren könnten also eine Eiszeit der künstlichen Intelligenz auslösen?

zyklische Schwankungen in der künstlichen Intelligenz „AI Winter“ bezieht sich auf das öffentliche Interesse an künstlicher Intelligenzals geschäftlicher und akademischer Zeitraum, in dem in diese Technologien investiert wird allmählich rückläufig.

Künstliche Intelligenz entwickelte sich zunächst in den 1950er und 1960er Jahren rasant. Obwohl es in der künstlichen Intelligenz viele Fortschritte gab, blieben diese größtenteils akademisch.

In den frühen 1970er Jahren begann die Begeisterung der Menschen für künstliche Intelligenz zu schwinden, und diese düstere Zeit dauerte bis etwa 1980.

Während dieses Winters der künstlichen Intelligenz mangelt es den Aktivitäten zur Entwicklung menschenähnlicher Intelligenz für Maschinen zunehmend an Finanzmitteln. Im Sommer 1956 besetzte eine Gruppe von Mathematikern und Informatikern das Gebäude, in dem die oberste Mathematikabteilung des Dartmouth College untergebracht war.

Acht Wochen lang stellten sie sich gemeinsam ein neues Forschungsgebiet vor.

Als junger Professor an der Dartmouth University prägte John McCarthy den Begriff „künstliche Intelligenz“, als er einen Vorschlag für ein Seminar „Das Wort“ entwarf.

Er glaubte, dass der Workshop die Hypothese untersuchen sollte, dass „jeder Aspekt des menschlichen Lernens oder jedes andere Merkmal der Intelligenz im Prinzip präzise beschrieben werden kann, auch was das Sein betrifft.“ in der Lage, es mit einer Maschine zu simulieren.“

Bei diesem Treffen skizzierten Forscher grob die künstliche Intelligenz, wie wir sie heute kennen.

Es entstand das erste Lager der Wissenschaftler der künstlichen Intelligenz. „Symbolismus“ ist eine intelligente Simulationsmethode, die auf logischem Denken basiert und auch als Logik und Psychologie bekannt ist Computerschulen, deren Prinzipien hauptsächlich die Annahme eines physikalischen Symbolsystems und das Prinzip der begrenzten Rationalität sind, sind seit langem dominant in der Forschung im Bereich der künstlichen Intelligenz.

Ihr Expertensystem erreichte seinen Höhepunkt in den 1980er Jahren.

In den Jahren nach der Konferenz führte der „Konnektionismus“ die menschliche Intelligenz auf die hochrangigen Aktivitäten des menschlichen Gehirns zurück und betonte, dass Intelligenz von einer großen Anzahl von Menschen produziert wird einfache Einheiten bis hin zu komplexen Das Ergebnis von Zusammenschaltung und Parallelbetrieb.

Es beginnt mit Neuronen und untersucht dann neuronale Netzwerkmodelle und Gehirnmodelle, wodurch ein weiterer Entwicklungspfad für künstliche Intelligenz eröffnet wird. Die beiden Ansätze galten lange Zeit als sich ausschließend, beide Seiten glaubten, sie seien auf dem Weg zur allgemeinen künstlichen Intelligenz.

Wenn wir auf die Jahrzehnte seit diesem Treffen zurückblicken, können wir sehen, dass die Hoffnungen der KI-Forscher oft enttäuscht wurden und dass diese Rückschläge sie nicht davon abhielten, KI zu entwickeln.

Obwohl künstliche Intelligenz heute revolutionäre Veränderungen in der Industrie mit sich bringt und das Potenzial hat, den globalen Arbeitsmarkt zu revolutionieren, fragen sich viele Experten immer noch, ob die heutigen Anwendungen künstlicher Intelligenz an ihre Grenzen gestoßen sind.

Wie Charles Choi in Seven Revealed Ways AI Fail beschreibt, werden die Schwächen der heutigen Deep-Learning-Systeme immer offensichtlicher.

Allerdings sind Forscher nicht pessimistisch, was die Zukunft der künstlichen Intelligenz angeht. Möglicherweise steht uns in naher Zukunft ein weiterer KI-Winter bevor.

Aber dies könnte der Moment sein, in dem inspirierte KI-Ingenieure uns endlich in den ewigen Sommer des maschinellen Denkens führen.

Ein Artikel von Filip Piekniewski, einem Experten für Computer Vision und künstliche Intelligenz, mit dem Titel „AI Winter is Coming“ hat im Internet heftige Diskussionen ausgelöst.

Dieser Artikel kritisiert hauptsächlich den Hype um Deep Learning und glaubt, dass diese Technologie alles andere als revolutionär ist und mit Entwicklungsengpässen konfrontiert ist.

Das Interesse großer Unternehmen an künstlicher Intelligenz konvergiert tatsächlich, und möglicherweise steht ein weiterer Winter der Leistung künstlicher Intelligenz bevor.

Wird der Winter der künstlichen Intelligenz kommen? Seit 1993 hat der Bereich der künstlichen Intelligenz immer beeindruckendere Fortschritte gemacht. 1997 besiegte das Deep Blue-System von IBM als erstes den Schachweltmeister Gary﹒ Kasparovs Computerschachspieler.

Im Jahr 2005 fuhr ein fahrerloser Stanford-Roboter 131 Meilen auf einer Wüstenstraße, ohne eine einzige Stufe zu berühren, und gewann damit die DARPA Self-Driving Robot Challenge.

Anfang 2016 besiegte Googles DeepMind’s AlphaGo den weltbesten Go-Spieler.

Alles hat sich in den letzten zwanzig Jahren verändert.

Insbesondere mit der boomenden Entwicklung des Internets verfügt die Branche der künstlichen Intelligenz über genügend Bilder, Töne, Videos und andere Arten von Daten, um neuronale Netze zu trainieren und umfassend anzuwenden.

Aber der immer größer werdende Erfolg des Deep-Learning-Bereichs beruht auf der Erhöhung der Anzahl der Schichten in neuronalen Netzen und der Erhöhung der GPU-Zeit, die für deren Training benötigt wird.

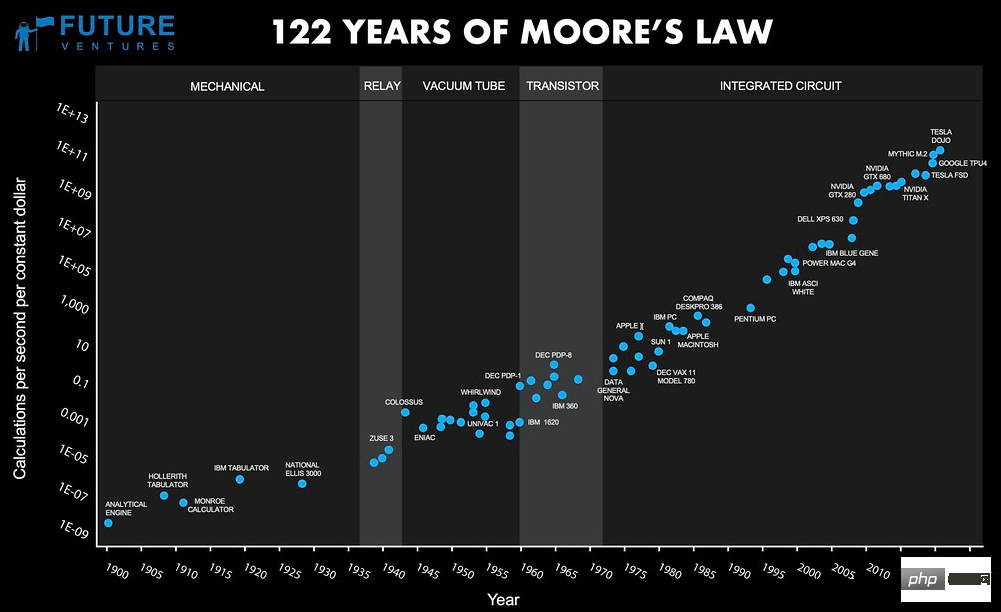

Eine Analyse des Forschungsunternehmens für künstliche Intelligenz OpenAI zeigt, dass sich die Rechenleistung, die zum Trainieren der größten Systeme für künstliche Intelligenz erforderlich ist, alle zwei Jahre und dann alle 3-4 Monate verdoppelt.

Wie Neil C. Thompson und Kollegen in „Diminishing Returns of Deep Learning“ schreiben, befürchten viele Forscher, dass sich der Rechenbedarf der KI auf einem unhaltbaren Weg befindet.

Ein häufiges Problem, mit dem die frühe Forschung zur künstlichen Intelligenz konfrontiert war, war ein schwerwiegender Mangel an Rechenleistung. Sie waren durch Hardware und nicht durch menschliche Intelligenz oder Fähigkeiten begrenzt.

Da die Rechenleistung in den letzten 25 Jahren erheblich zugenommen hat, sind auch die Fortschritte, die wir in der künstlichen Intelligenz gemacht haben, deutlich gestiegen.

Angesichts der steigenden Datenmengen und immer komplexer werdenden Algorithmen fügt die Welt jedoch jedes Jahr 20 ZB an Daten hinzu, und die Nachfrage nach KI-Rechenleistung steigt jedes Jahr um das Zehnfache. Diese Geschwindigkeit hat den Leistungszyklus bei weitem überschritten Verdoppelung nach dem Mooreschen Gesetz.

Wir nähern uns der theoretischen physikalischen Grenze der Anzahl an Transistoren, die auf einem Chip verbaut werden können.

Zum Beispiel verlangsamt Intel das Tempo bei der Einführung neuer Chip-Herstellungstechnologien, weil es schwierig ist, die Größe von Transistoren weiter zu reduzieren und gleichzeitig Kosten zu sparen. Kurz gesagt, das Ende des Mooreschen Gesetzes naht.

Bildnachweis: Ray Kurzwell, DFJ

Es gibt einige kurzfristige Lösungen, die für ein kontinuierliches Wachstum der Rechenleistung sorgen und so den Fortschritt der künstlichen Intelligenz fördern.

So gab Google Mitte 2017 bekannt, dass es einen speziellen Chip für künstliche Intelligenz namens „Cloud TPU“ entwickelt hat, der für das Training und die Ausführung tiefer neuronaler Netze optimiert ist.

Amazon entwickelt einen eigenen Chip für Alexa (persönlicher Assistent mit künstlicher Intelligenz). Gleichzeitig versuchen derzeit viele Startups, Chipdesigns für spezielle Anwendungen der künstlichen Intelligenz anzupassen.

Allerdings handelt es sich nur um kurzfristige Lösungen.

Was passiert, wenn uns die Optionen zur Optimierung des traditionellen Chipdesigns ausgehen? Werden wir einen weiteren KI-Winter erleben? Die Antwort lautet „Ja“, es sei denn, Quantencomputing kann das klassische Computing übertreffen und eine fundiertere Antwort finden.

Aber bis jetzt gibt es noch keinen Quantencomputer, der „Quantenüberlegenheit“ erreichen kann und effizienter ist als ein herkömmlicher Computer.

Wenn wir die Grenzen der traditionellen Rechenleistung erreichen, bevor die wahre „Quantenüberlegenheit“ eintrifft, befürchte ich, dass es in Zukunft einen weiteren Winter der künstlichen Intelligenz geben wird.

Die Probleme, mit denen sich Forscher der künstlichen Intelligenz auseinandersetzen, werden immer komplexer und treiben uns dazu, Alan Turings Vision einer künstlichen allgemeinen künstlichen Intelligenz zu verwirklichen. Allerdings gibt es noch viel zu tun.

Gleichzeitig wird es ohne die Hilfe des Quantencomputings sehr unwahrscheinlich sein, dass wir das volle Potenzial der künstlichen Intelligenz ausschöpfen.

Niemand kann mit Sicherheit sagen, ob der KI-Winter kommt.

Allerdings ist es wichtig, sich der potenziellen Risiken bewusst zu sein und genau auf die Anzeichen zu achten, damit wir im Ernstfall vorbereitet sind.

Das obige ist der detaillierte Inhalt vonWenn künstliche Intelligenz ihre Zukunftsvision nicht unterstützen kann, wird sie dann erneut einen „Winter' einläuten?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Anwendung künstlicher Intelligenz im Leben

Anwendung künstlicher Intelligenz im Leben

Was ist das Grundkonzept der künstlichen Intelligenz?

Was ist das Grundkonzept der künstlichen Intelligenz?

Detaillierte Erläuterung der Verwendung der Oracle-Substr-Funktion

Detaillierte Erläuterung der Verwendung der Oracle-Substr-Funktion

Empfohlene Datenanalyse-Websites

Empfohlene Datenanalyse-Websites

Was nützt Bitlocker?

Was nützt Bitlocker?

Grundlegende Verwendung der Insert-Anweisung

Grundlegende Verwendung der Insert-Anweisung

So fügen Sie Audio in ppt ein

So fügen Sie Audio in ppt ein

Wie wäre es mit der Binance-Börse?

Wie wäre es mit der Binance-Börse?