Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Verstoß gegen KI-Malerei ist bestätigt! Diffusionsmodelle erinnern sich möglicherweise an Ihre Fotos und alle vorhandenen Methoden zum Schutz der Privatsphäre sind wirkungslos

Verstoß gegen KI-Malerei ist bestätigt! Diffusionsmodelle erinnern sich möglicherweise an Ihre Fotos und alle vorhandenen Methoden zum Schutz der Privatsphäre sind wirkungslos

Verstoß gegen KI-Malerei ist bestätigt! Diffusionsmodelle erinnern sich möglicherweise an Ihre Fotos und alle vorhandenen Methoden zum Schutz der Privatsphäre sind wirkungslos

Dieser Artikel wird mit Genehmigung von AI New Media Qubit (öffentliche Konto-ID: QbitAI) nachgedruckt. Bitte wenden Sie sich für einen Nachdruck an die Quelle.

Verstoß gegen KI-Malerei wurde bestätigt!

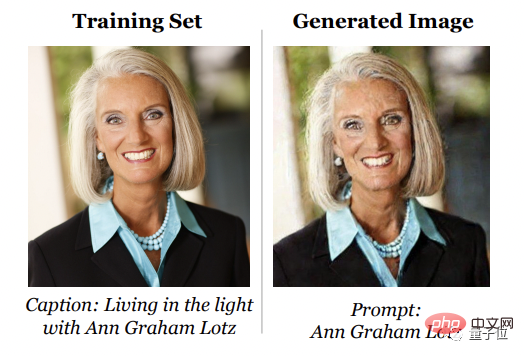

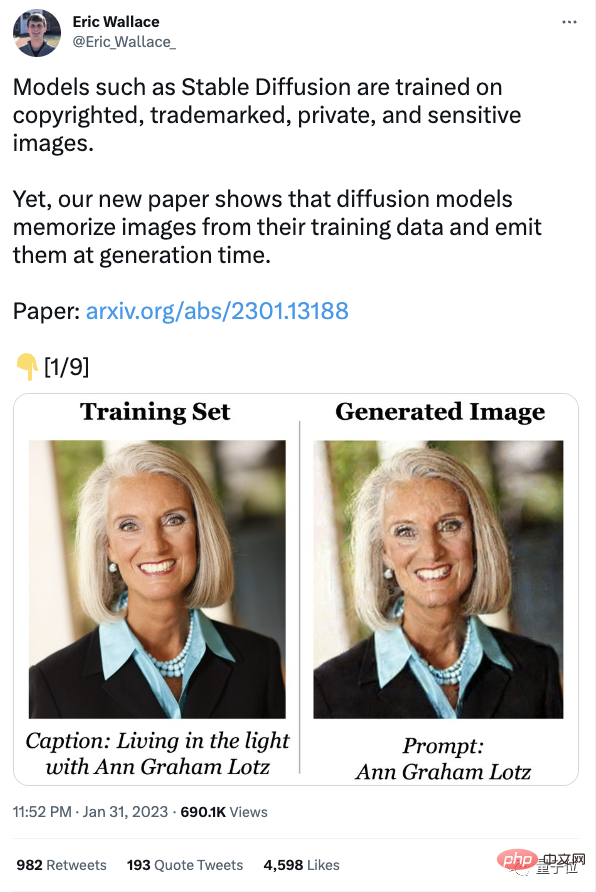

Die neuesten Forschungsergebnisse zeigen, dass das Diffusionsmodell die Proben im Trainingssatz „im Hinterkopf behält“ und sie bei der Generierung „imitiert“.

Mit anderen Worten, in den von Stable Diffusion generierten KI-Gemälden kann hinter jedem Schlag ein Verstoßvorfall stecken

Mit anderen Worten, in den von Stable Diffusion generierten KI-Gemälden kann hinter jedem Schlag ein Verstoßvorfall stecken

Nicht nur, dass nach Recherchen und Vergleichen die Fähigkeit des Diffusionsmodells, aus Trainingsbeispielen zu „plagiieren“, doppelt so hoch ist wie die von GAN, und je besser das Diffusionsmodell generiert wird, desto stärker ist seine Fähigkeit, sich Trainingsbeispiele zu merken.

Diese Forschung stammt von einem Team bestehend aus Google, DeepMind und UC Berkeley.Es gibt eine weitere schlechte Nachricht in der Zeitung, nämlich als Reaktion auf dieses Phänomen: „Alle bestehenden Methoden zum Schutz der Privatsphäre sind ungültig.“

Einige Leute beklagten: Es stellt sich heraus, dass es Sinn macht zu sagen, dass sie die urheberrechtlich geschützten Ergebnisse anderer Leute stehlen!

Unterstützen Sie die Klage! Verklagen Sie sie!

Jemand stand auf der Seite des Diffusionsmodells und sprach:

Einige Internetnutzer erweiterten die Ergebnisse des Papiers auch auf das beliebteste ChatGPT:

Alle vorhandenen Datenschutzmethoden sind ungültig

Diffusionsmodell Das Prinzip besteht darin, Rauschen zu entfernen und es dann wiederherzustellen. Was Forscher also tatsächlich untersuchen wollen, ist:

Die Bilder im Trainingsset stammen oft aus dem Internet. Sie sind urheberrechtlich geschützt, markenrechtlich geschützt und einige sind privat, wie zum Beispiel private medizinische Röntgenaufnahmen. Um herauszufinden, ob das Diffusionsmodell einzelne Trainingsmuster „speichern und regenerieren“ kann, schlugen die Forscher zunächst eine neue Definition von „Speicher“ vor.

Im Allgemeinen konzentriert sich die Definition des Gedächtnisses auf Textsprachmodelle. Wenn das Modell aufgefordert werden kann, eine Wort-für-Wort-Sequenz aus dem Trainingssatz wiederherzustellen, bedeutet dies, dass die Sequenz extrahiert und gespeichert wurde. Im Gegensatz dazudefinierte „Gedächtnis“

basierend auf der Bildähnlichkeit. Allerdings gibt das Team auch offen zu, dass die Definition von „Speicher“ konservativ ist.Das Bild links ist beispielsweise ein „Foto von Obama“, das mit Stable Diffusion erstellt wurde. Dieses Foto ähnelt keinem bestimmten Trainingsbild rechts, daher kann dieses Bild nicht als aus dem Speicher erstellt gezählt werden.

Aber das bedeutet nicht, dass die Fähigkeit von Stable Difusion, neue identifizierbare Bilder zu generieren, nicht das Urheberrecht und die Privatsphäre verletzt.

Als nächstes extrahierten sie mehr als 1.000 Trainingsbeispiele, darunter persönliche Fotos und Firmenausschreibungen, und entwarfen dann eine

zweistufige Datenextraktion  (Datenextraktionsangriff)

(Datenextraktionsangriff)

Durch die Anwendung dieses Ansatzes auf Stable Diffusion und Imagen extrahierte das Team über 100 ungefähre oder identische Kopien von Trainingsbildern. Es gibt sowohl identifizierbare persönliche Fotos als auch Markenlogos. Nach der Prüfung sind die meisten davon urheberrechtlich geschützt.

Um besser zu verstehen, wie „Gedächtnis“ entsteht, haben die Forscher dann eine Million Mal Stichproben aus dem Modell gezogen und Hunderte von Diffusionsmodellen auf CIFAR-10 trainiert.

Der Zweck besteht darin, zu analysieren, welche Verhaltensweisen in Bezug auf Modellgenauigkeit, Hyperparameter, Verbesserung und Deduplizierung Auswirkungen auf die Privatsphäre haben.

Endlich bin ich zu folgendem Schluss gekommen:

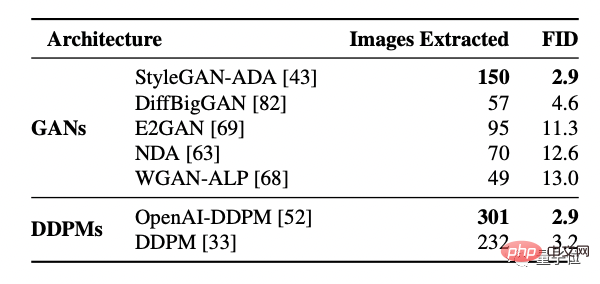

Erstens hat das Diffusionsmodell mehr Speicher als GAN.

Aber Diffusionsmodelle sind auch die Gruppe mit der schlechtesten Privatsphäre unter den bewerteten Bildmodellen, und sie verlieren mehr als doppelt so viele Trainingsdaten wie GANs.

Außerdem merken sich größere Modelle möglicherweise mehr Daten.

Mit dieser Schlussfolgerung untersuchten die Forscher auch das 2-Milliarden-Parameter-Text-Bild-Diffusionsmodell Imagen. Sie versuchten, 500 Bilder mit den höchsten Werten außerhalb der Verteilung zu extrahieren und verwendeten sie als Proben im Trainingsdatensatz alles auswendig gelernt.

Im Gegensatz dazu wurde die gleiche Methode auf die stabile Diffusion angewendet und es wurde kein Gedächtnisverhalten festgestellt.

Daher bietet Imagen bei kopierten und nicht kopierten Bildern eine schlechtere Privatsphäre als Stable Difusion. Die Forscher führen den Grund darauf zurück, dass das von Imagen verwendete Modell eine größere Kapazität als Stable Difusion hat und sich daher mehr Bilder merkt.

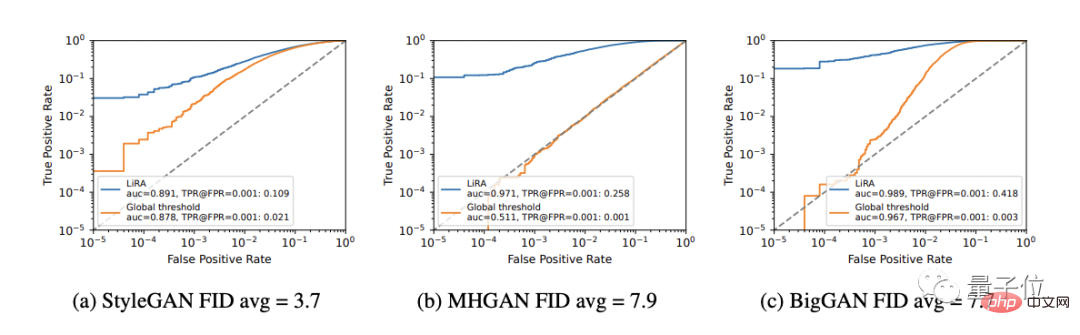

Darüber hinaus bessere generative Modelle (niedrigere FID-Werte) speichern mehr Daten.

Mit anderen Worten: Mit der Zeit verliert dasselbe Modell immer mehr an Privatsphäre und verletzt immer mehr Urheberrechte.

(GAN-Modell sortiert nach FID, je niedriger der FID-Wert, desto besser der Effekt)

Durch das Training des Modells stellte das Team fest, dass ein zunehmender Nutzen die Privatsphäre verringert, einfache Abwehrmaßnahmen (wie z Deduplizierung) )Nicht genug, um den Speichermangel vollständig zu beheben.

Daher bieten Technologien zur Verbesserung der Privatsphäre keinen akzeptablen Kompromiss zwischen Privatsphäre und Nutzen.

Letztendlich gab das Team vier Empfehlungen für diese Trainingsdiffusionsmodelle ab:

- Es wird empfohlen, den Trainingsdatensatz zu deduplizieren und Übertraining zu minimieren;

- Es wird empfohlen, Datenextraktion oder andere Prüftechniken zu verwenden, um die Privatsphäre des trainierten Modells zu bewerten Risiken;

- Wenn es eine praktischere Datenschutztechnologie gibt, wird empfohlen, diese so oft wie möglich zu verwenden.

- Ich hoffe, dass die von KI generierten Bilder den Benutzern keine datenschutzbezogenen Teile kostenlos zur Verfügung stellen.

Die Urheberrechtsinhaber haben nie aufgehört, ihre Rechte zu verteidigen

Sobald die Recherche vorliegt, kann sie Auswirkungen auf den laufenden Rechtsstreit haben.

Ende Januar verklagte der große Bruder der Galerie, Getty Images(Getty Images), Stability AI vor dem Londoner High Court wegen Urheberrechtsverletzung.

△Stability AI

Getty Images geht davon aus, dass Stability AI „Millionen urheberrechtlich geschützter Bilder illegal kopiert und verarbeitet hat“, um seine stabile Verbreitung zu trainieren.

Ein Teil der Trainingsdaten von Stable Difussion ist Open Source. Nach der Analyse und Prüfung der Wasserzeichen wurde festgestellt, dass viele Fotoagenturen, darunter auch Getty, unwissentlich große Mengen an Material für das Trainingsset von Stable Difussion bereitgestellt hatten, was einen großen Teil davon ausmachte.

Aber von Anfang bis Ende hat Stability AI die Fotoagentur nicht kontaktiert.

Viele KI-Unternehmen glauben, dass diese Praxis durch Gesetze wie die US-amerikanische Fair-Use-Doktrin geschützt ist, aber die meisten Urheberrechtsinhaber stimmen dieser Aussage nicht zu und glauben, dass dieses Verhalten ihre Rechte verletzt.

Obwohl Stability AI zuvor eine Erklärung abgegeben hat, dass Urheberrechtsinhaber in der nächsten Version ihre eigenen urheberrechtlich geschützten Werke in der Trainingsgalerie löschen können, gibt es zum jetzigen Zeitpunkt immer noch Leute, die davon nicht überzeugt sind.

Mitte Januar hatten drei Künstler eine Klage gegen Stability AI und Midjourney eingereicht.

Auch Rechtsexperten vertreten unterschiedliche Meinungen, um zu einer einheitlichen Meinung zu gelangen, aber alle sind sich einig, dass das Gericht über die Frage des Urheberrechtsschutzes entscheiden muss.

Craig Peters, CEO von Getty Images, sagte, dass das Unternehmen eine Mitteilung an Stability AI gesendet habe, in der es hieß: „Sie werden bald in Großbritannien verklagt“!

Das Unternehmen sagte außerdem:

Die durch Verstöße verursachten Verluste sind uns egal und wir haben nicht die Absicht, die Entwicklung von KI-Kunstwerkzeugen zu stoppen.

Stabilitäts-KI vor Gericht zu bringen liegt nicht im Interesse unserer Getty-Familie.

Die Entscheidung, zu klagen, hat einen tieferen langfristigen Zweck, und ich hoffe, dass das Gericht neue Gesetze erlässt , um den Status quo zu regeln.

Das obige ist der detaillierte Inhalt vonVerstoß gegen KI-Malerei ist bestätigt! Diffusionsmodelle erinnern sich möglicherweise an Ihre Fotos und alle vorhandenen Methoden zum Schutz der Privatsphäre sind wirkungslos. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1377

1377

52

52

Open Source! Jenseits von ZoeDepth! DepthFM: Schnelle und genaue monokulare Tiefenschätzung!

Apr 03, 2024 pm 12:04 PM

Open Source! Jenseits von ZoeDepth! DepthFM: Schnelle und genaue monokulare Tiefenschätzung!

Apr 03, 2024 pm 12:04 PM

0.Was bewirkt dieser Artikel? Wir schlagen DepthFM vor: ein vielseitiges und schnelles generatives monokulares Tiefenschätzungsmodell auf dem neuesten Stand der Technik. Zusätzlich zu herkömmlichen Tiefenschätzungsaufgaben demonstriert DepthFM auch hochmoderne Fähigkeiten bei nachgelagerten Aufgaben wie dem Tiefen-Inpainting. DepthFM ist effizient und kann Tiefenkarten innerhalb weniger Inferenzschritte synthetisieren. Lassen Sie uns diese Arbeit gemeinsam lesen ~ 1. Titel der Papierinformationen: DepthFM: FastMonocularDepthEstimationwithFlowMatching Autor: MingGui, JohannesS.Fischer, UlrichPrestel, PingchuanMa, Dmytr

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Stellen Sie sich ein Modell der künstlichen Intelligenz vor, das nicht nur die Fähigkeit besitzt, die traditionelle Datenverarbeitung zu übertreffen, sondern auch eine effizientere Leistung zu geringeren Kosten erzielt. Dies ist keine Science-Fiction, DeepSeek-V2[1], das weltweit leistungsstärkste Open-Source-MoE-Modell, ist da. DeepSeek-V2 ist ein leistungsstarkes MoE-Sprachmodell (Mix of Experts) mit den Merkmalen eines wirtschaftlichen Trainings und einer effizienten Inferenz. Es besteht aus 236B Parametern, von denen 21B zur Aktivierung jedes Markers verwendet werden. Im Vergleich zu DeepSeek67B bietet DeepSeek-V2 eine stärkere Leistung, spart gleichzeitig 42,5 % der Trainingskosten, reduziert den KV-Cache um 93,3 % und erhöht den maximalen Generierungsdurchsatz auf das 5,76-fache. DeepSeek ist ein Unternehmen, das sich mit allgemeiner künstlicher Intelligenz beschäftigt

KI untergräbt die mathematische Forschung! Der Gewinner der Fields-Medaille und der chinesisch-amerikanische Mathematiker führten 11 hochrangige Arbeiten an | Gefällt mir bei Terence Tao

Apr 09, 2024 am 11:52 AM

KI untergräbt die mathematische Forschung! Der Gewinner der Fields-Medaille und der chinesisch-amerikanische Mathematiker führten 11 hochrangige Arbeiten an | Gefällt mir bei Terence Tao

Apr 09, 2024 am 11:52 AM

KI verändert tatsächlich die Mathematik. Vor kurzem hat Tao Zhexuan, der diesem Thema große Aufmerksamkeit gewidmet hat, die neueste Ausgabe des „Bulletin of the American Mathematical Society“ (Bulletin der American Mathematical Society) weitergeleitet. Zum Thema „Werden Maschinen die Mathematik verändern?“ äußerten viele Mathematiker ihre Meinung. Der gesamte Prozess war voller Funken, knallhart und aufregend. Der Autor verfügt über eine starke Besetzung, darunter der Fields-Medaillengewinner Akshay Venkatesh, der chinesische Mathematiker Zheng Lejun, der NYU-Informatiker Ernest Davis und viele andere bekannte Wissenschaftler der Branche. Die Welt der KI hat sich dramatisch verändert. Viele dieser Artikel wurden vor einem Jahr eingereicht.

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

Anfang dieses Monats schlugen Forscher des MIT und anderer Institutionen eine vielversprechende Alternative zu MLP vor – KAN. KAN übertrifft MLP in Bezug auf Genauigkeit und Interpretierbarkeit. Und es kann MLP, das mit einer größeren Anzahl von Parametern ausgeführt wird, mit einer sehr kleinen Anzahl von Parametern übertreffen. Beispielsweise gaben die Autoren an, dass sie KAN nutzten, um die Ergebnisse von DeepMind mit einem kleineren Netzwerk und einem höheren Automatisierungsgrad zu reproduzieren. Konkret verfügt DeepMinds MLP über etwa 300.000 Parameter, während KAN nur etwa 200 Parameter hat. KAN hat eine starke mathematische Grundlage wie MLP und basiert auf dem universellen Approximationssatz, während KAN auf dem Kolmogorov-Arnold-Darstellungssatz basiert. Wie in der folgenden Abbildung gezeigt, hat KAN

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas tritt offiziell in die Ära der Elektroroboter ein! Gestern hat sich der hydraulische Atlas einfach „unter Tränen“ von der Bühne der Geschichte zurückgezogen. Heute gab Boston Dynamics bekannt, dass der elektrische Atlas im Einsatz ist. Es scheint, dass Boston Dynamics im Bereich kommerzieller humanoider Roboter entschlossen ist, mit Tesla zu konkurrieren. Nach der Veröffentlichung des neuen Videos wurde es innerhalb von nur zehn Stunden bereits von mehr als einer Million Menschen angesehen. Die alten Leute gehen und neue Rollen entstehen. Das ist eine historische Notwendigkeit. Es besteht kein Zweifel, dass dieses Jahr das explosive Jahr der humanoiden Roboter ist. Netizens kommentierten: Die Weiterentwicklung der Roboter hat dazu geführt, dass die diesjährige Eröffnungsfeier wie Menschen aussieht, und der Freiheitsgrad ist weitaus größer als der von Menschen. Aber ist das wirklich kein Horrorfilm? Zu Beginn des Videos liegt Atlas ruhig auf dem Boden, scheinbar auf dem Rücken. Was folgt, ist atemberaubend

Die Kuaishou-Version von Sora „Ke Ling' steht zum Testen offen: Sie generiert über 120 Sekunden Videos, versteht die Physik besser und kann komplexe Bewegungen genau modellieren

Jun 11, 2024 am 09:51 AM

Die Kuaishou-Version von Sora „Ke Ling' steht zum Testen offen: Sie generiert über 120 Sekunden Videos, versteht die Physik besser und kann komplexe Bewegungen genau modellieren

Jun 11, 2024 am 09:51 AM

Was? Wird Zootopia durch heimische KI in die Realität umgesetzt? Zusammen mit dem Video wird ein neues groß angelegtes inländisches Videogenerationsmodell namens „Keling“ vorgestellt. Sora geht einen ähnlichen technischen Weg und kombiniert eine Reihe selbst entwickelter technologischer Innovationen, um Videos zu produzieren, die nicht nur große und vernünftige Bewegungen aufweisen, sondern auch die Eigenschaften der physischen Welt simulieren und über starke konzeptionelle Kombinationsfähigkeiten und Vorstellungskraft verfügen. Den Daten zufolge unterstützt Keling die Erstellung ultralanger Videos von bis zu 2 Minuten mit 30 Bildern pro Sekunde, mit Auflösungen von bis zu 1080p und unterstützt mehrere Seitenverhältnisse. Ein weiterer wichtiger Punkt ist, dass es sich bei Keling nicht um eine vom Labor veröffentlichte Demo oder Video-Ergebnisdemonstration handelt, sondern um eine Anwendung auf Produktebene, die von Kuaishou, einem führenden Anbieter im Bereich Kurzvideos, gestartet wurde. Darüber hinaus liegt das Hauptaugenmerk darauf, pragmatisch zu sein, keine Blankoschecks auszustellen und sofort nach der Veröffentlichung online zu gehen. Das große Modell von Ke Ling wurde bereits in Kuaiying veröffentlicht.

Die Vitalität der Superintelligenz erwacht! Aber mit der Einführung der sich selbst aktualisierenden KI müssen sich Mütter keine Sorgen mehr über Datenengpässe machen

Apr 29, 2024 pm 06:55 PM

Die Vitalität der Superintelligenz erwacht! Aber mit der Einführung der sich selbst aktualisierenden KI müssen sich Mütter keine Sorgen mehr über Datenengpässe machen

Apr 29, 2024 pm 06:55 PM

Ich weine zu Tode. Die Daten im Internet reichen überhaupt nicht aus. Das Trainingsmodell sieht aus wie „Die Tribute von Panem“, und KI-Forscher auf der ganzen Welt machen sich Gedanken darüber, wie sie diese datenhungrigen Esser ernähren sollen. Dieses Problem tritt insbesondere bei multimodalen Aufgaben auf. Zu einer Zeit, als sie ratlos waren, nutzte ein Start-up-Team der Abteilung der Renmin-Universität von China sein eigenes neues Modell, um als erstes in China einen „modellgenerierten Datenfeed selbst“ in die Realität umzusetzen. Darüber hinaus handelt es sich um einen zweigleisigen Ansatz auf der Verständnisseite und der Generierungsseite. Beide Seiten können hochwertige, multimodale neue Daten generieren und Datenrückmeldungen an das Modell selbst liefern. Was ist ein Modell? Awaker 1.0, ein großes multimodales Modell, das gerade im Zhongguancun-Forum erschienen ist. Wer ist das Team? Sophon-Motor. Gegründet von Gao Yizhao, einem Doktoranden an der Hillhouse School of Artificial Intelligence der Renmin University.

Die U.S. Air Force präsentiert ihren ersten KI-Kampfjet mit großem Aufsehen! Der Minister führte die Testfahrt persönlich durch, ohne in den gesamten Prozess einzugreifen, und 100.000 Codezeilen wurden 21 Mal getestet.

May 07, 2024 pm 05:00 PM

Die U.S. Air Force präsentiert ihren ersten KI-Kampfjet mit großem Aufsehen! Der Minister führte die Testfahrt persönlich durch, ohne in den gesamten Prozess einzugreifen, und 100.000 Codezeilen wurden 21 Mal getestet.

May 07, 2024 pm 05:00 PM

Kürzlich wurde die Militärwelt von der Nachricht überwältigt: US-Militärkampfflugzeuge können jetzt mithilfe von KI vollautomatische Luftkämpfe absolvieren. Ja, erst kürzlich wurde der KI-Kampfjet des US-Militärs zum ersten Mal der Öffentlichkeit zugänglich gemacht und sein Geheimnis gelüftet. Der vollständige Name dieses Jägers lautet „Variable Stability Simulator Test Aircraft“ (VISTA). Er wurde vom Minister der US-Luftwaffe persönlich geflogen, um einen Eins-gegen-eins-Luftkampf zu simulieren. Am 2. Mai startete US-Luftwaffenminister Frank Kendall mit einer X-62AVISTA auf der Edwards Air Force Base. Beachten Sie, dass während des einstündigen Fluges alle Flugaktionen autonom von der KI durchgeführt wurden! Kendall sagte: „In den letzten Jahrzehnten haben wir über das unbegrenzte Potenzial des autonomen Luft-Luft-Kampfes nachgedacht, aber es schien immer unerreichbar.“ Nun jedoch,