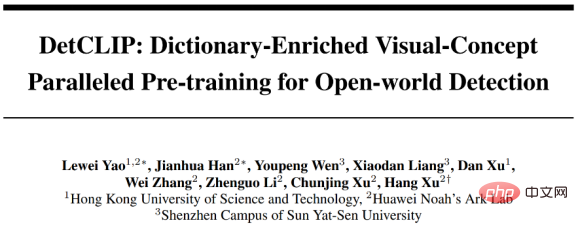

Das Problem der Erkennung offener Domänen bezieht sich auf das Problem, wie die Erkennung willkürlicher Kategorien in Downstream-Szenarien implementiert werden kann, indem eine große Anzahl von aus dem Internet gecrawlten Bild-Text-Paaren oder bestimmte Kategorien manuell annotierter Daten für das Training im Upstream verwendet werden. Zu den Anwendungen offener Domänenerkennungsmethoden in der Industrie gehören hauptsächlich die Erkennung von Straßenobjekten in autonomen Fahrsystemen, die Erkennung vollständiger Wolkenszenen usw.

Papieradresse: https://arxiv.org/abs/2209.09407

In diesem Artikel wird das von NeurIPS 2022 ausgewählte Papier „DetCLIP: Dictionary-Enriched Visual-Concept Paralleled Pre-training for Open“ geteilt -world Detection“ schlägt dieses Papier ein gemeinsames und effizientes paralleles Trainingsframework für mehrere Datenquellen für das Open-Domain-Erkennungsproblem vor und baut außerdem eine zusätzliche Wissensbasis auf, um implizite Beziehungen zwischen Kategorien bereitzustellen. Gleichzeitig gewann DetCLIP im von Microsoft organisierten Wettbewerb ECCV2022 OdinW (Object Detection in the Wild[1]) den ersten Platz in der Zero-Shot-Erkennung mit einem durchschnittlichen Erkennungsindex von 24,9 %.

Mit der Popularität multimodaler Pre-Training-Modelle (wie CLIP), die auf der Grundlage von aus dem Internet gecrawlten Bild- und Textpaaren trainiert werden, und ihrer hervorragenden Leistung im Bereich der Zero-Shot-Klassifizierung Immer mehr Methoden versuchen, diese Fähigkeit auf die dichte Vorhersage offener Domänen zu übertragen (z. B. Erkennung beliebiger Kategorien, Segmentierung usw.). Bestehende Methoden verwenden häufig vorab trainierte große Klassifizierungsmodelle, um eine Destillation auf Merkmalsebene durchzuführen [1] oder lernen durch Pseudo-Labeling-Beschriftung und Selbsttraining [2]. Dies ist jedoch häufig durch die Leistung großer Klassifizierungsmodelle begrenzt Unvollständige Beschriftungsanmerkung.

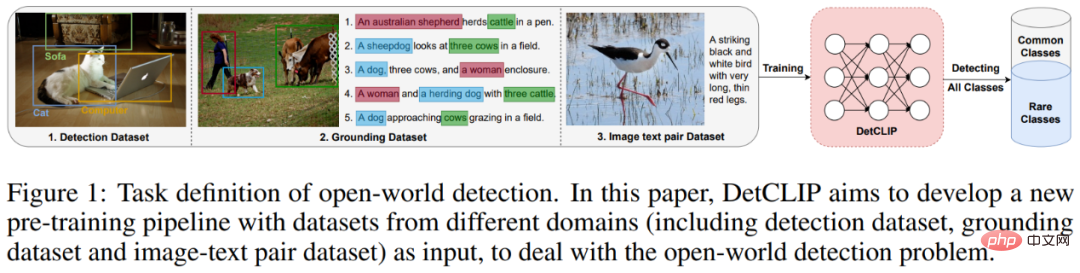

Das bestehende SOTA Open-Domain-Erkennungsmodell GLIP[3] führt ein gemeinsames Training mehrerer Datenquellen durch, indem es das Format der Erkennungsdaten in das Format der Grounding-Daten konvertiert und so die Vorteile verschiedener Datenquellen (der Erkennungsdaten) voll ausnutzt Der Satz stellt spezielle Anforderungen an allgemeine Kategorien (vollständigere Annotation), während der Grounding-Datensatz einen größeren Bereich an Kategorieabdeckungsintervallen aufweist. Wir haben jedoch festgestellt, dass die Art der Verkettung von Kategoriesubstantiven zu einer Verringerung der Gesamtlerneffizienz des Modells führt, während die direkte Verwendung von Kategoriewörtern als Texteingabe keine feinkörnigen A-priori-Beziehungen zwischen Kategorien liefern kann. Abbildung 1: Gemeinsame Open-Domain-Erkennungsmodell-Pipeline mit mehreren Datenquellen vor dem Training ] Einstufiges Erkennungsmodell, DetCLIP Es enthält einen Bild-Encoder

, um die Bildmerkmale des Erkennungsfelds

, um die Bildmerkmale des Erkennungsfelds

zu erhalten, und einen Text-Encoder , um die Textmerkmale der Kategorie zu erhalten

. Basierend auf den oben genannten Bildmerkmalen und Textmerkmalen werden dann der entsprechende Klassifizierungsausrichtungsverlust , der Mittelpunktverlust und der Regressionsverlust berechnet. Abbildung 2: DetCLIP-Modellrahmen mit paralleler Eingabe – Textunion Trainingsrahmen zur Optimierung der Trainingseffizienz; 2) Aufbau einer zusätzlichen Objektwissensbasis zur Unterstützung des Trainings zur Erkennung offener Domänen. Mehrere Datenquellen, paralleles Eingabe-Pre-Training-FrameworkIm Vergleich zu GLIP, das Erkennungsdaten durch Spleißen von Kategorienomen in eine Erdungsform (seriell) umwandelt, extrahieren wir die entsprechenden Nominalphrasen in den Erdungsdaten und kombinieren sie mit der Erkennung Kategorien in werden als unabhängige Eingaben verwendet und (parallel) in den Text-Encoder eingegeben, um unnötige Aufmerksamkeitsberechnungen zu vermeiden und eine höhere Trainingseffizienz zu erreichen.

Abbildung 3: Vergleich zwischen dem DetCLIP-Pre-Training-Framework für parallele Eingaben und GLIP

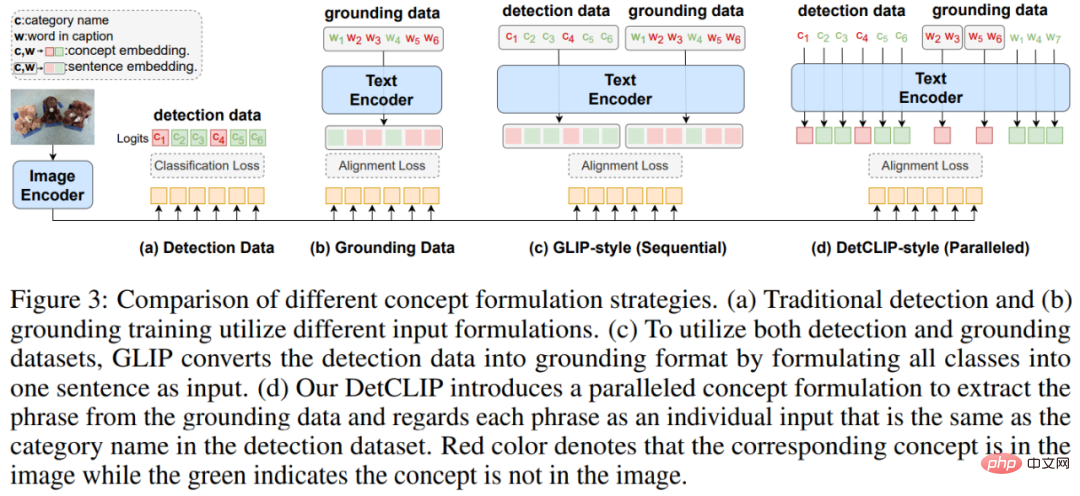

Um das Problem des uneinheitlichen Kategorieraums verschiedener Datenquellen (die Die gleichen Kategorienamen sind unterschiedlich oder die Kategorien enthalten usw.) und liefern Vorabinformationen für die Beziehung zwischen Kategorien. Wir bauen eine Objektwissensbasis auf, um eine effizientere Schulung zu erreichen.

Konstruktion: Wir integrieren gleichzeitig die Kategorien in den Erkennungsdaten, die Nominalphrasen im Bild-Text-Paar und die entsprechenden Definitionen, um die Objektwissensbasis aufzubauen.

Verwendung: 1. Wir verwenden die Definition der Objektwissensbasis, um die Kategoriewörter in den vorhandenen Erkennungsdaten zu erweitern und Vorabinformationen (Konzeptanreicherung) über die Beziehung zwischen Kategorien bereitzustellen.

Abbildung 4: Beispiel für die Verwendung der Objektwissensdatenbank zur Erweiterung der Kategoriewortdefinitionen

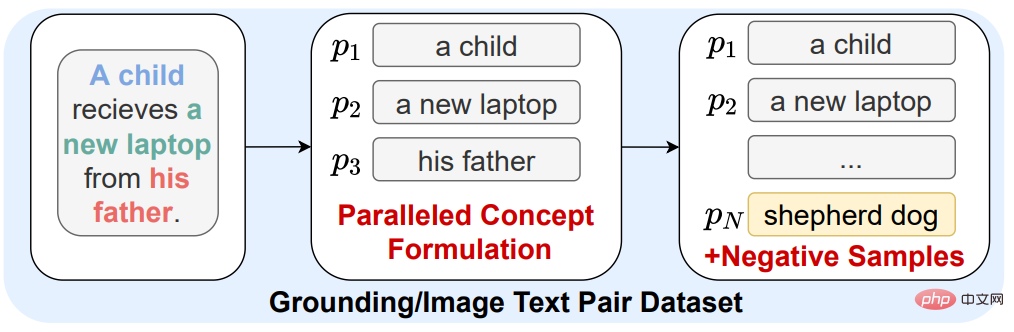

2. Aufgrund des Problems der unvollständigen Beschriftungsanmerkung in den Erdungsdaten und Bildunterschriftsdaten (erscheint (auf dem Bild) erscheint die Kategorie nicht in der Bildunterschrift), was zu einer sehr geringen Anzahl von Kategorien führt, die beim Training dieser Bilder als negative Stichproben verwendet werden können, was wiederum dazu führt, dass das Modell für einige ungewöhnliche Kategorien weniger unterscheidbar ist. Daher wählen wir zufällig Objektnomen aus der Objektwissensdatenbank als negative Stichprobenkategorien aus, um die Unterscheidung seltener Kategoriemerkmale durch das Modell zu verbessern (+Negativstichproben).

Abbildung 5: Einführung von Kategorien in die Objektwissensdatenbank als negative Beispielkategorien

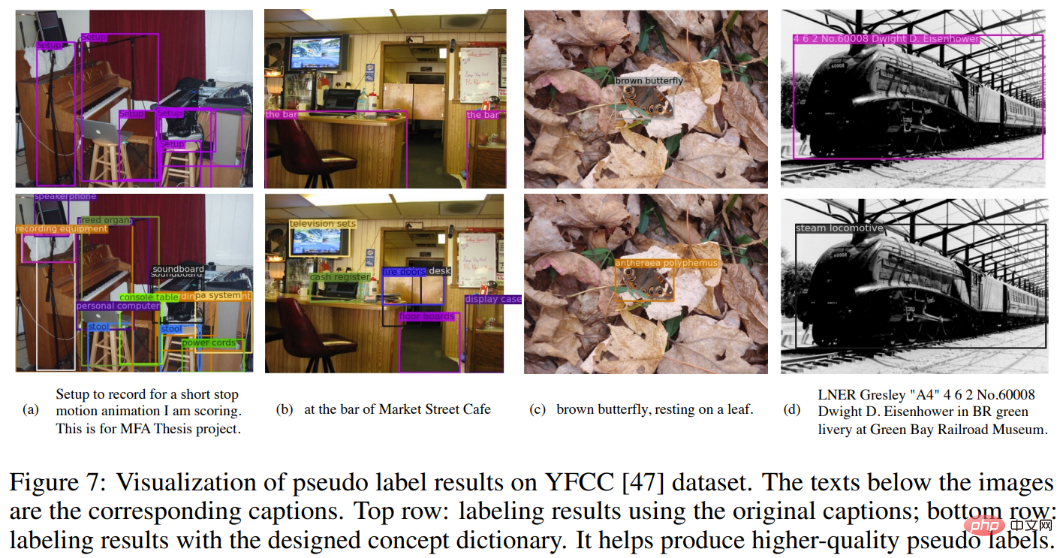

3. Für die Bild-Text-Paardaten ohne Rahmenanmerkung verwenden wir Huawei Noahs selbst recherchiertes The Modell FILIP [5] und das vorab trainierte RPN beschriften es, damit es für das Training in normale Erdungsdaten umgewandelt werden kann. Um gleichzeitig das Problem der unvollständigen Beschriftung von Objekten im Bild in der Bildunterschrift zu lindern, verwenden wir alle Kategoriephrasen in der Objektwissensdatenbank als Kandidatenkategorien für die Pseudokennzeichnung (zweite Zeile) und verwenden nur die Kategorie Anmerkungseffekt in der Beschriftung (erste Zeile) Der Vergleich sieht wie folgt aus:

Abbildung 6: Einführung von Kategorien in die Objektwissensdatenbank als Kandidatenkategorien für eine falsche Beschriftung

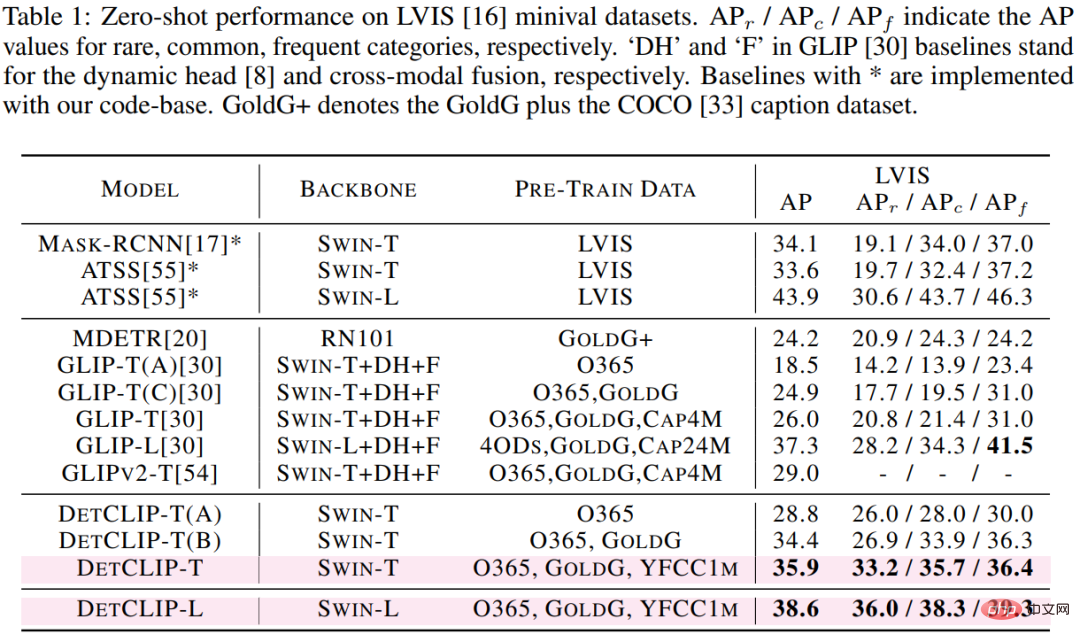

Wir haben den Downstream-LVIS-Erkennungsdatensatz (1203 Kategorien) verwendet, um die Open-Domain-Erkennungsleistung der vorgeschlagenen Methode zu überprüfen. Es ist ersichtlich, dass DetCLIP auf der auf dem Swin-T-Backbone basierenden Architektur eine AP-Verbesserung von 9,9 % erzielt hat im Vergleich zum bestehenden SOTA-Modell GLIP und eine Verbesserung von 12,4 in der Kategorie „Selten“ % AP, obwohl wir im Vergleich zu GLIP nur weniger als die Hälfte der Datenmenge verwenden. Beachten Sie, dass der Trainingssatz keine Bilder in LVIS enthält.

Tabelle 1: Vergleich der Zero-Shot-Übertragungsleistung verschiedener Methoden auf LVIS

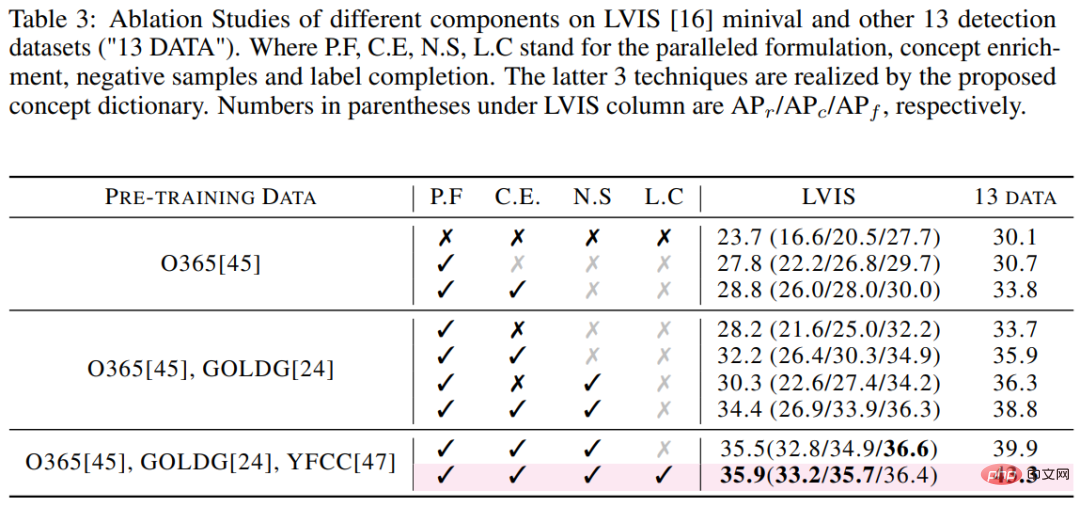

In Bezug auf die Trainingseffizienz, basierend auf den gleichen 32 V100-Hardwarebedingungen, die Trainingszeit von GLIP -T ist DetCLIP 5x von -T (10,7.000 GPU-Stunden vs. 2,0.000 GPU-Stunden). In Bezug auf die Testeffizienz ist die Inferenzeffizienz von DetCLIP-T auf Basis eines einzelnen V100 mit 2,3 FPS (0,4 Sekunden pro Bild) 20-mal höher als die 0,12 FPS von GLIP-T (8,6 Sekunden pro Bild). Wir haben auch separat die Auswirkungen der wichtigsten Innovationen von DetCLIP (paralleles Framework und Objektwissensbasis) auf die Genauigkeit untersucht.

Tabelle 3: Ergebnisse der DetCLIP-Ablationsstudie am LVIS-Datensatz Der Effekt wurde im Vergleich zu GLIP deutlich verbessert, insbesondere bei der Annotation seltener Kategorien und der Vollständigkeit der Annotation.

Abbildung 7: Visueller Vergleich der Vorhersageergebnisse von DetCLIP und GLIP im LVIS-Datensatz

Das obige ist der detaillierte Inhalt vonNeurIPS 2022 | DetCLIP, eine neue Methode zur Erkennung offener Domänen, verbessert die Argumentationseffizienz um das Zwanzigfache. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!