Backend-Entwicklung

Backend-Entwicklung

Python-Tutorial

Python-Tutorial

Um ein Haus in Shanghai zu mieten, habe ich mit Python über Nacht mehr als 20.000 Wohnungsinformationen durchsucht.

Um ein Haus in Shanghai zu mieten, habe ich mit Python über Nacht mehr als 20.000 Wohnungsinformationen durchsucht.

Um ein Haus in Shanghai zu mieten, habe ich mit Python über Nacht mehr als 20.000 Wohnungsinformationen durchsucht.

Aufgrund eines plötzlichen Arbeitswechsels liegt der neue Bürostandort weit entfernt von meinem jetzigen Wohnort, sodass ich ein neues Haus mieten muss.

Ich bin auf das E-Mule der Agentur gestiegen und habe angefangen, seltsame Ecken der Stadt zu erkunden.

Beim Wechsel zwischen verschiedenen Miet-Apps machte ich mir große Sorgen, weil die Effizienz sehr gering war:

Da ich mit meiner Freundin zusammen lebe, muss ich zunächst einmal die Arbeitsentfernung beider berücksichtigen Gleichzeitig sind die Funktionen zur Suche nach einem Haus basierend auf der Pendelzeit auf den Bahnsteigen relativ nutzlos. Einige Plattformen unterstützen nicht die gleichzeitige Auswahl mehrerer Standorte und einige Plattformen können nur Punkte mit derselben Pendelzeit automatisch auswählen von jedem Standort aus, was den Bedürfnissen der Benutzer nicht gerecht werden kann.

Zweitens gibt es aus Sicht eines Mieters zu viele Vermietungsplattformen und die Filter- und Sortierlogik jeder Plattform ist inkonsistent, was es schwierig macht, Informationen zu ähnlichen Immobilien horizontal zu vergleichen.

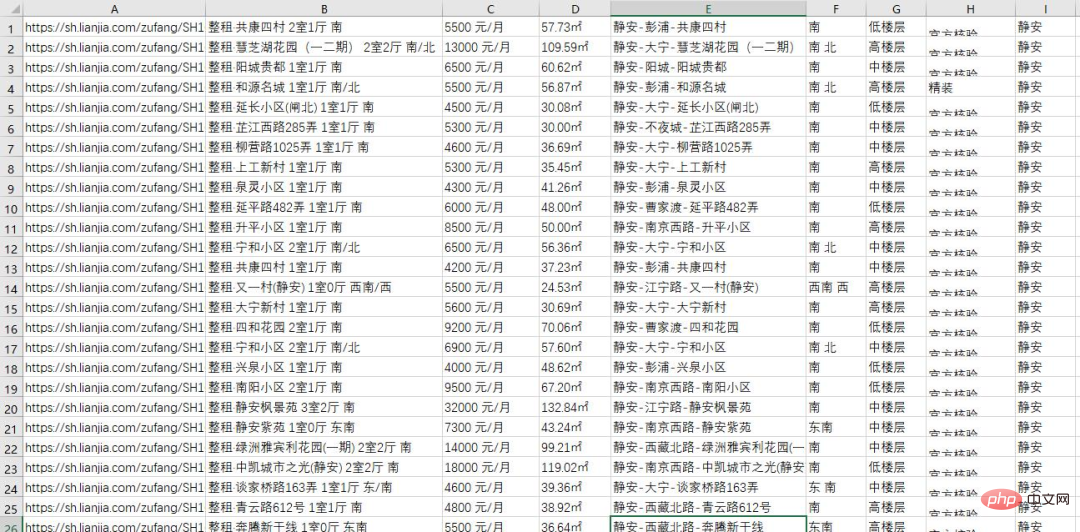

Aber das spielt keine Rolle. Als Programmierer muss man natürlich die Methoden der Programmierer nutzen, um Probleme zu lösen. Also habe ich gestern Abend ein Python-Skript verwendet, um alle Wohnungsinformationen einer Mietplattform im Raum Shanghai abzurufen, insgesamt mehr als 20.000 Stück:

Jetzt werde ich den gesamten Prozess des Crawlens der Daten mit Ihnen teilen.

Analysieren Sie die Seite und finden Sie den Einstiegspunkt.

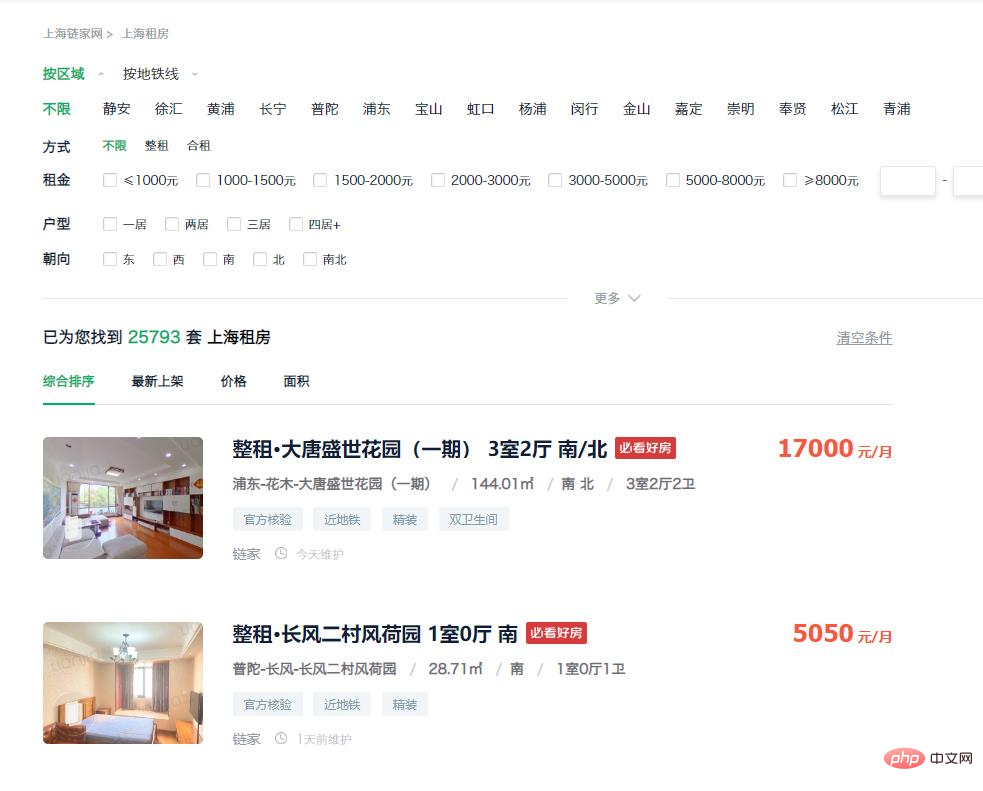

Betreten Sie zunächst die Vermietungsseite der Plattform. Sie können sehen, dass die Hausliste auf der Homepage bereits die meisten Informationen enthält, die wir benötigen, und diese Informationen können direkt vom Dom eingeholt werden Erwägen Sie daher, Webseitendaten direkt durch die Simulation von Anfragen zu sammeln.

https://sh.lianjia.com/zufang/

Als nächstes müssen wir uns überlegen, wie wir an die URL kommen. Durch Beobachtung haben wir herausgefunden, dass es in der Gegend mehr als 20.000 Häuser gibt, aber nur auf die ersten 100 Seiten mit Daten kann über die Webseite zugegriffen werden. Die Obergrenze der auf jeder Seite angezeigten Zahl liegt bei 30, was einem entspricht Insgesamt 3k. Es ist unmöglich, alle Informationen zu erhalten.

Aber wir können dieses Problem lösen, indem wir Filterbedingungen hinzufügen. Wählen Sie im Filterelement „Jing'an“ aus und geben Sie die folgende URL ein:

https://sh.lianjia.com/zufang/jingan/

Sie können sehen, dass es in der Gegend mehr als 2.000 Häuser mit 75 Datenseiten und 30 Elementen pro Seite gibt Alle Daten sind abrufbar. Daher können alle Daten in der Stadt erhalten werden, indem die Wohnungsdaten jedes Bezirks separat erfasst werden.

https://sh.lianjia.com/zufang/jingan/pg2/

Nachdem Sie auf die Schaltfläche für die zweite Seite geklickt haben, geben Sie die obige URL ein. Sie können feststellen, dass Sie die entsprechende Seitennummer eingeben können, solange Sie die Nummer nach pg ändern.

Hier besteht jedoch ein Problem: Die bei jedem Besuch derselben Anzahl von Seiten erfassten Daten sind unterschiedlich, was zu einer Duplizierung der erfassten Daten führt. Also klicken wir in den Sortierbedingungen auf „Neueste Version“ und geben den folgenden Link ein:

https://sh.lianjia.com/zufang/jingan/pg2rco11/

Die Reihenfolge der durch diese Sortiermethode erhaltenen Daten ist stabil. An diesem Punkt lautet unsere Idee: Besuchen Sie zuerst den ersten jedes kleinen Bereichs . Eine Seite, dann die maximale Anzahl von Seiten in der aktuellen Region über die erste Seite abrufen und dann auf die simulierte Anforderung zugreifen, um auf jede Seite zuzugreifen und alle Daten abzurufen.

Crawling-Daten

Nachdem Sie eine Idee haben, müssen Sie mit dem Schreiben des Codes beginnen. Der Code lautet wie folgt:

# 所有小地区对应的标识

list=['jingan','xuhui','huangpu','changning','putuo','pudong','baoshan','hongkou','yangpu','minhang','jinshan','jiading','chongming','fengxian','songjiang','qingpu']

# 存放所有链接

urls = []

for a in list:

urls.append('https://sh.lianjia.com/zufang/{}/pg1rco11/'.format(a))

# 设置请求头,避免ip被ban

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/81.0.4044.9 Safari/537.36'}

# 获取当前小地区第1页的dom信息

res = requests.get('https://sh.lianjia.com/zufang/{}/pg1rco11/'.format(a), headers=headers)

content = res.text

soup = BeautifulSoup(content, 'html.parser')

# 获取当前页面的最大页数

page_num = int(soup.find('div', attrs={'class': 'content__pg'}).attrs['data-totalpage'])

for i in range(2,page_num+1):

# 将所有链接保存到urls中

urls.append('https://sh.lianjia.com/zufang/{}/pg{}rco11/'.format(a,i))Danach müssen wir die erhaltenen URLs verarbeiten Der Code lautet wie folgt:

num=1

for url in urls:

print("正在处理第{}页数据...".format(str(num)))

res1 = requests.get(url, headers=headers)

content1 = res1.text

soup1 = BeautifulSoup(content1, 'html.parser')

infos = soup1.find('div', {'class': 'content__list'}).find_all('div', {'class': 'content__list--item'})Organisieren Sie die Daten und exportieren Sie die Datei.

Durch Beobachtung der Seitenstruktur können wir den Speicherort jedes Elements ermitteln entsprechendes Seitenelement und erhalten die Informationen, die wir benötigen.

Der vollständige Code ist hier beigefügt. Interessierte Freunde können die Regionalkennung und die kleine Regionalkennung im Link entsprechend ihren eigenen Bedürfnissen ersetzen und dann die Informationen ihrer eigenen Region erhalten. Die Crawling-Methoden anderer Mietplattformen sind größtenteils ähnlich, daher werde ich nicht näher darauf eingehen.

import time, re, csv, requests

import codecs

from bs4 import BeautifulSoup

print("****处理开始****")

with open(r'..sh.csv', 'wb+')as fp:

fp.write(codecs.BOM_UTF8)

f = open(r'..sh.csv','w+',newline='', encoding='utf-8')

writer = csv.writer(f)

urls = []

# 所有小地区对应的标识

list=['jingan','xuhui','huangpu','changning','putuo','pudong','baoshan','hongkou','yangpu','minhang','jinshan','jiading','chongming','fengxian','songjiang','qingpu']

# 存放所有链接

urls = []

for a in list:

urls.append('https://sh.lianjia.com/zufang/{}/pg1rco11/'.format(a))

# 设置请求头,避免ip被ban

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/81.0.4044.9 Safari/537.36'}

# 获取当前小地区第1页的dom信息

res = requests.get('https://sh.lianjia.com/zufang/{}/pg1rco11/'.format(a), headers=headers)

content = res.text

soup = BeautifulSoup(content, 'html.parser')

# 获取当前页面的最大页数

page_num = int(soup.find('div', attrs={'class': 'content__pg'}).attrs['data-totalpage'])

for i in range(2,page_num+1):

# 将所有链接保存到urls中

urls.append('https://sh.lianjia.com/zufang/{}/pg{}rco11/'.format(a,i))

num=1

for url in urls:

# 模拟请求

print("正在处理第{}页数据...".format(str(num)))

res1 = requests.get(url, headers=headers)

content1 = res1.text

soup1 = BeautifulSoup(content1, 'html.parser')

# 读取页面中数据

infos = soup1.find('div', {'class': 'content__list'}).find_all('div', {'class': 'content__list--item'})

# 数据处理

for info in infos:

house_url = 'https://sh.lianjia.com' + info.a['href']

title = info.find('p', {'class': 'content__list--item--title'}).find('a').get_text().strip()

group = title.split()[0][3:]

price = info.find('span', {'class': 'content__list--item-price'}).get_text()

tag = info.find('p', {'class': 'content__list--item--bottom oneline'}).get_text()

mixed = info.find('p', {'class': 'content__list--item--des'}).get_text()

mix = re.split(r'/', mixed)

address = mix[0].strip()

area = mix[1].strip()

door_orientation = mix[2].strip()

style = mix[-1].strip()

region = re.split(r'-', address)[0]

writer.writerow((house_url, title, group, price, area, address, door_orientation, style, tag, region))

time.sleep(0)

print("第{}页数据处理完毕,共{}条数据。".format(str(num), len(infos)))

num+=1

f.close()

print("****全部完成****")Nach einigen Operationen haben wir vollständige Wohnungsinformationen von verschiedenen lokalen Vermietungsplattformen eingeholt. Zu diesem Zeitpunkt können wir bereits durch einige grundlegende Filtermethoden die benötigten Daten erhalten.

Das obige ist der detaillierte Inhalt vonUm ein Haus in Shanghai zu mieten, habe ich mit Python über Nacht mehr als 20.000 Wohnungsinformationen durchsucht.. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1377

1377

52

52

Muss MySQL bezahlen?

Apr 08, 2025 pm 05:36 PM

Muss MySQL bezahlen?

Apr 08, 2025 pm 05:36 PM

MySQL hat eine kostenlose Community -Version und eine kostenpflichtige Enterprise -Version. Die Community -Version kann kostenlos verwendet und geändert werden, die Unterstützung ist jedoch begrenzt und für Anwendungen mit geringen Stabilitätsanforderungen und starken technischen Funktionen geeignet. Die Enterprise Edition bietet umfassende kommerzielle Unterstützung für Anwendungen, die eine stabile, zuverlässige Hochleistungsdatenbank erfordern und bereit sind, Unterstützung zu bezahlen. Zu den Faktoren, die bei der Auswahl einer Version berücksichtigt werden, gehören Kritikalität, Budgetierung und technische Fähigkeiten von Anwendungen. Es gibt keine perfekte Option, nur die am besten geeignete Option, und Sie müssen die spezifische Situation sorgfältig auswählen.

So verwenden Sie MySQL nach der Installation

Apr 08, 2025 am 11:48 AM

So verwenden Sie MySQL nach der Installation

Apr 08, 2025 am 11:48 AM

Der Artikel führt den Betrieb der MySQL -Datenbank vor. Zunächst müssen Sie einen MySQL -Client wie MySQLworkBench oder Befehlszeilen -Client installieren. 1. Verwenden Sie den Befehl mySQL-uroot-P, um eine Verbindung zum Server herzustellen und sich mit dem Stammkonto-Passwort anzumelden. 2. Verwenden Sie die Erstellung von Createdatabase, um eine Datenbank zu erstellen, und verwenden Sie eine Datenbank aus. 3.. Verwenden Sie CreateTable, um eine Tabelle zu erstellen, Felder und Datentypen zu definieren. 4. Verwenden Sie InsertInto, um Daten einzulegen, Daten abzufragen, Daten nach Aktualisierung zu aktualisieren und Daten nach Löschen zu löschen. Nur indem Sie diese Schritte beherrschen, lernen, mit gemeinsamen Problemen umzugehen und die Datenbankleistung zu optimieren, können Sie MySQL effizient verwenden.

Braucht MySQL das Internet?

Apr 08, 2025 pm 02:18 PM

Braucht MySQL das Internet?

Apr 08, 2025 pm 02:18 PM

MySQL kann ohne Netzwerkverbindungen für die grundlegende Datenspeicherung und -verwaltung ausgeführt werden. Für die Interaktion mit anderen Systemen, Remotezugriff oder Verwendung erweiterte Funktionen wie Replikation und Clustering ist jedoch eine Netzwerkverbindung erforderlich. Darüber hinaus sind Sicherheitsmaßnahmen (wie Firewalls), Leistungsoptimierung (Wählen Sie die richtige Netzwerkverbindung) und die Datensicherung für die Verbindung zum Internet von entscheidender Bedeutung.

Wie optimieren Sie die MySQL-Leistung für Hochlastanwendungen?

Apr 08, 2025 pm 06:03 PM

Wie optimieren Sie die MySQL-Leistung für Hochlastanwendungen?

Apr 08, 2025 pm 06:03 PM

Die MySQL-Datenbankleistung Optimierungshandbuch In ressourcenintensiven Anwendungen spielt die MySQL-Datenbank eine entscheidende Rolle und ist für die Verwaltung massiver Transaktionen verantwortlich. Mit der Erweiterung der Anwendung werden jedoch die Datenbankleistung Engpässe häufig zu einer Einschränkung. In diesem Artikel werden eine Reihe effektiver Strategien zur Leistungsoptimierung von MySQL -Leistung untersucht, um sicherzustellen, dass Ihre Anwendung unter hohen Lasten effizient und reaktionsschnell bleibt. Wir werden tatsächliche Fälle kombinieren, um eingehende Schlüsseltechnologien wie Indexierung, Abfrageoptimierung, Datenbankdesign und Caching zu erklären. 1. Das Design der Datenbankarchitektur und die optimierte Datenbankarchitektur sind der Eckpfeiler der MySQL -Leistungsoptimierung. Hier sind einige Kernprinzipien: Die Auswahl des richtigen Datentyps und die Auswahl des kleinsten Datentyps, der den Anforderungen entspricht, kann nicht nur Speicherplatz speichern, sondern auch die Datenverarbeitungsgeschwindigkeit verbessern.

Hadidb: Eine leichte, horizontal skalierbare Datenbank in Python

Apr 08, 2025 pm 06:12 PM

Hadidb: Eine leichte, horizontal skalierbare Datenbank in Python

Apr 08, 2025 pm 06:12 PM

Hadidb: Eine leichte, hochrangige skalierbare Python-Datenbank Hadidb (HadIDB) ist eine leichte Datenbank in Python mit einem hohen Maß an Skalierbarkeit. Installieren Sie HadIDB mithilfe der PIP -Installation: PipinstallHadIDB -Benutzerverwaltung erstellen Benutzer: createUser (), um einen neuen Benutzer zu erstellen. Die Authentication () -Methode authentifiziert die Identität des Benutzers. fromHadidb.operationImportUseruser_obj = user ("admin", "admin") user_obj.

Navicat -Methode zum Anzeigen von MongoDB -Datenbankkennwort

Apr 08, 2025 pm 09:39 PM

Navicat -Methode zum Anzeigen von MongoDB -Datenbankkennwort

Apr 08, 2025 pm 09:39 PM

Es ist unmöglich, das MongoDB -Passwort direkt über Navicat anzuzeigen, da es als Hash -Werte gespeichert ist. So rufen Sie verlorene Passwörter ab: 1. Passwörter zurücksetzen; 2. Überprüfen Sie die Konfigurationsdateien (können Hash -Werte enthalten). 3. Überprüfen Sie Codes (May Hardcode -Passwörter).

Kann sich MySQL Workbench mit Mariadb verbinden?

Apr 08, 2025 pm 02:33 PM

Kann sich MySQL Workbench mit Mariadb verbinden?

Apr 08, 2025 pm 02:33 PM

MySQL Workbench kann eine Verbindung zu MariADB herstellen, vorausgesetzt, die Konfiguration ist korrekt. Wählen Sie zuerst "Mariadb" als Anschlusstyp. Stellen Sie in der Verbindungskonfiguration Host, Port, Benutzer, Kennwort und Datenbank korrekt ein. Überprüfen Sie beim Testen der Verbindung, ob der Mariadb -Dienst gestartet wird, ob der Benutzername und das Passwort korrekt sind, ob die Portnummer korrekt ist, ob die Firewall Verbindungen zulässt und ob die Datenbank vorhanden ist. Verwenden Sie in fortschrittlicher Verwendung die Verbindungspooling -Technologie, um die Leistung zu optimieren. Zu den häufigen Fehlern gehören unzureichende Berechtigungen, Probleme mit Netzwerkverbindung usw. Bei Debugging -Fehlern, sorgfältige Analyse von Fehlerinformationen und verwenden Sie Debugging -Tools. Optimierung der Netzwerkkonfiguration kann die Leistung verbessern

Benötigt MySQL einen Server?

Apr 08, 2025 pm 02:12 PM

Benötigt MySQL einen Server?

Apr 08, 2025 pm 02:12 PM

Für Produktionsumgebungen ist in der Regel ein Server erforderlich, um MySQL auszuführen, aus Gründen, einschließlich Leistung, Zuverlässigkeit, Sicherheit und Skalierbarkeit. Server haben normalerweise leistungsstärkere Hardware, redundante Konfigurationen und strengere Sicherheitsmaßnahmen. Bei kleinen Anwendungen mit niedriger Last kann MySQL auf lokalen Maschinen ausgeführt werden, aber Ressourcenverbrauch, Sicherheitsrisiken und Wartungskosten müssen sorgfältig berücksichtigt werden. Für eine größere Zuverlässigkeit und Sicherheit sollte MySQL auf Cloud oder anderen Servern bereitgestellt werden. Die Auswahl der entsprechenden Serverkonfiguration erfordert eine Bewertung basierend auf Anwendungslast und Datenvolumen.