Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Untergraben Sie drei Konzepte! Die neueste Studie von Google: Ist es genauer, die „Ähnlichkeit' mit einem Modell mit schlechter Leistung zu berechnen?

Untergraben Sie drei Konzepte! Die neueste Studie von Google: Ist es genauer, die „Ähnlichkeit' mit einem Modell mit schlechter Leistung zu berechnen?

Untergraben Sie drei Konzepte! Die neueste Studie von Google: Ist es genauer, die „Ähnlichkeit' mit einem Modell mit schlechter Leistung zu berechnen?

BerechnungÄhnlichkeit zwischen Bildern ist ein offenes Problem in der Computer Vision.

Heutzutage, da die Bildgenerierung auf der ganzen Welt beliebt ist, ist Wie man „Ähnlichkeit“ definiert auch ein zentrales Thema bei der Bewertung der Authentizität generierter Bilder.

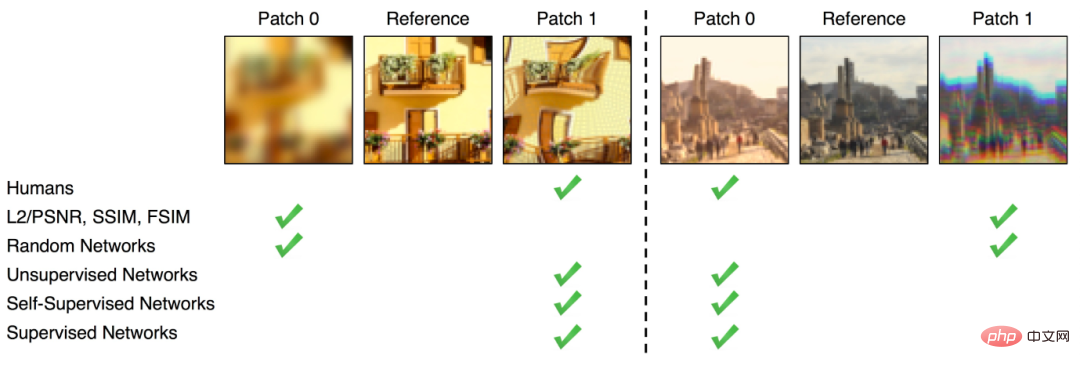

Obwohl es derzeit einige relativ direkte Methoden zur Berechnung der Bildähnlichkeit gibt, wie z. B. das Messen von Unterschieden in Pixeln (wie FSIM, SSIM), ist der mit dieser Methode erhaltene Ähnlichkeitsunterschied nicht derselbe wie der von der Bildähnlichkeit wahrgenommene Unterschied menschliches Auge Der Unterschied ist tiefgreifend.

Nach dem Aufstieg des Deep Learning stellten einige Forscher fest, dass die Zwischendarstellung, die nach dem Training auf ImageNet von einigen neuronalen Netzwerkklassifizierern wie AlexNet, VGG, SqueezeNet usw. erhalten wurde, für die Berechnung der Wahrnehmung verwendet werden kann Ähnlichkeit.

Mit anderen Worten: Einbettung kommt der Wahrnehmung der Menschen hinsichtlich der Ähnlichkeit mehrerer Bilder näher als Pixeln.

Natürlich ist das nur eine Hypothese .

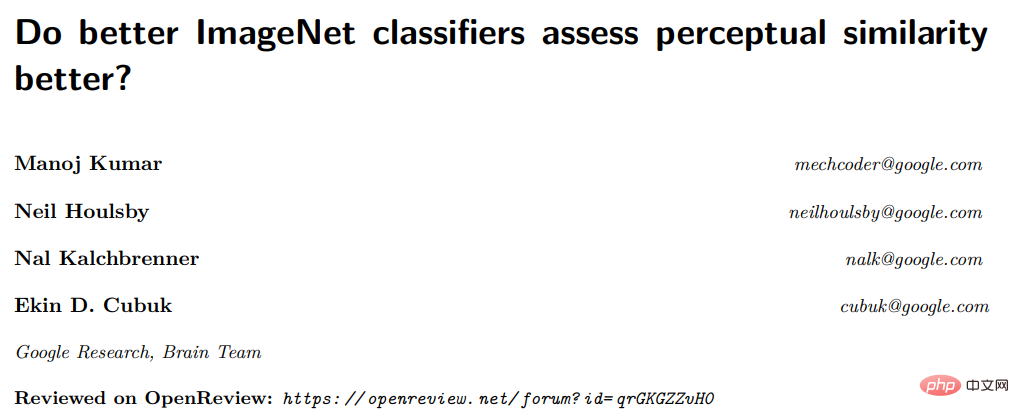

Kürzlich hat Google einen Artikel veröffentlicht, der speziell untersucht, ob der ImageNet-Klassifikator Wahrnehmungsähnlichkeit besser bewerten kann. 🔜 BAPPS-Datensatz Die „Wahrnehmungswerte“ wurden mit dem ImageNet-Klassifikator der ersten Generation untersucht. Um die Korrelation zwischen Genauigkeit und Wahrnehmungswerten sowie die Auswirkungen verschiedener Hyperparameter weiter zu bewerten, wurden in dem Artikel die Forschungsergebnisse des neuesten ViT-Modells hinzugefügt .

Je höher die Genauigkeit, desto schlechter ist die wahrgenommene Ähnlichkeit?

Es ist bekannt, dass die durch das Training auf ImageNet erlernten Funktionen gut auf viele nachgelagerte Aufgaben übertragen werden können und die Leistung nachgelagerter Aufgaben verbessern, was auch das Vortraining auf ImageNet zu einem Standardvorgang macht. Darüber hinaus bedeutet das Erreichen einer höheren Genauigkeit bei ImageNet oft eine bessere Leistung bei einer Vielzahl nachgelagerter Aufgaben, wie z. B. Robustheit gegenüber beschädigten Bildern, Daten außerhalb der Verteilung usw. Generalisierungsleistung und Transferlernen auf kleinere kategoriale Datensätze.

Aber in Bezug auf die Berechnung der Wahrnehmungsähnlichkeit scheint alles umgekehrt zu sein.

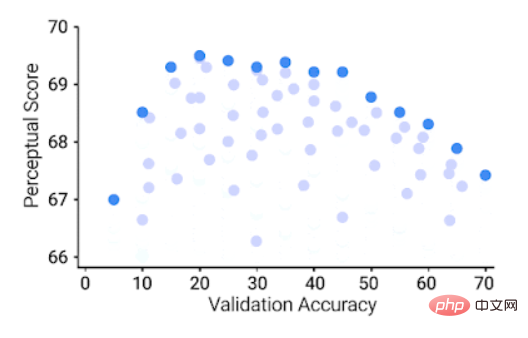

Modelle, die auf ImageNet eine hohe Genauigkeit erreichen, weisen tatsächlich schlechtere Wahrnehmungswerte auf, während Modelle mit „mittleren“ Werten die beste Leistung bei der Wahrnehmungsähnlichkeitsaufgabe aufweisen.

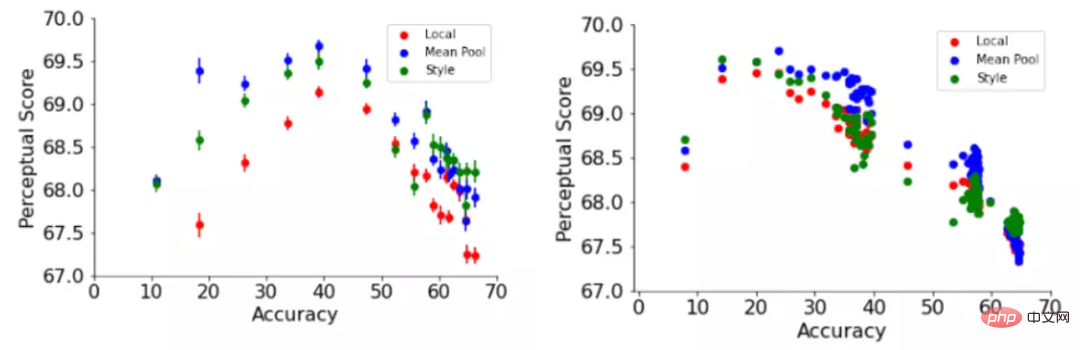

ImageNet 64 × 64 Validierungsgenauigkeit (x-Achse), 64 × 64 Wahrnehmungsbewertung auf dem BAPPS-Datensatz (y-Achse), jeder blaue Punkt stellt einen ImageNet-Klassifikator dar

Das können Sie Es ist ersichtlich, dass ein besserer ImageNet-Klassifikator bis zu einem gewissen Grad eine bessere Wahrnehmungsbewertung erzielt. Über einen bestimmten Schwellenwert hinaus führt eine Verbesserung der Genauigkeit jedoch zu einer Verringerung der Wahrnehmungsbewertung. Die Genauigkeit des Klassifikators ist moderat (20,0–40,0), was möglich ist die beste Wahrnehmungsbewertung .

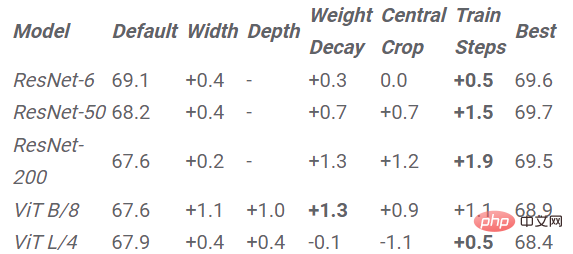

Der Artikel untersucht auch die Auswirkungen von Hyperparametern neuronaler Netze auf Wahrnehmungswerte wie Breite, Tiefe, Anzahl der Trainingsschritte, Gewichtsabschwächung, Etikettenglättung und Dropout.

Darüber hinaus führt eine Erhöhung der Klassifikatorgenauigkeit zu einer schlechteren Wahrnehmungsbewertung.

Zum Beispiel gibt der Artikel die Änderung der Wahrnehmungsbewertung relativ zu zwei Hyperparametern an: Trainingsschritte in ResNets und Breite in ViTs.

Früh gestoppte ResNets erzielten die besten Wahrnehmungswerte bei verschiedenen Tiefeneinstellungen von 6, 50 und 200.

Die Wahrnehmungswerte von ResNet-50 und ResNet-200 erreichten ihre höchsten Werte in den ersten Epochen von Training, aber nach dem Höhepunkt sank der Wahrnehmungswert des Klassifikators mit der besseren Leistung stärker.

Die Ergebnisse zeigen, dass die Trainings- und Lernratenanpassung von ResNets die Genauigkeit des Modells mit zunehmendem Schritt verbessern kann. Ebenso weist das Modell nach dem Höhepunkt auch eine progressive Abnahme der Wahrnehmungsähnlichkeitswerte auf, die dieser zunehmend zunehmenden Genauigkeit entspricht.

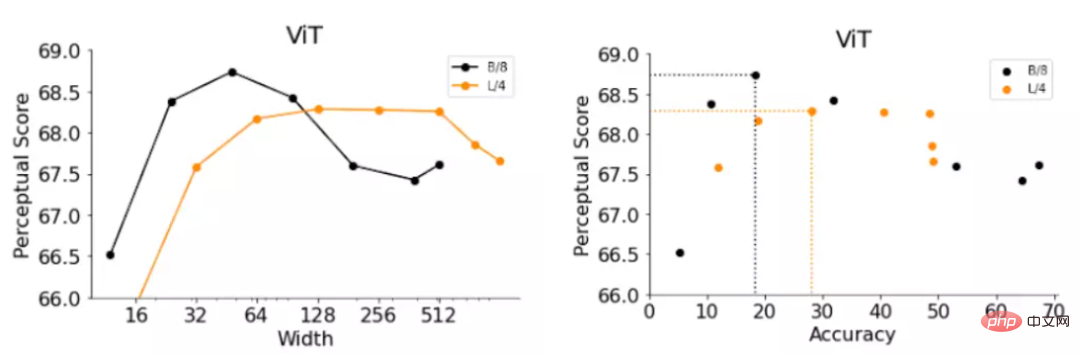

ViTs besteht aus einer Reihe von Transformer-Blöcken, die auf das Eingabebild angewendet werden. Die Breite des ViT-Modells ist die Anzahl der Ausgabeneuronen eines einzelnen Transformer-Blocks. Durch Erhöhen der Breite kann die Genauigkeit des Modells effektiv verbessert werden.

Durch Ersetzen der Breite der beiden ViT-Varianten erhielten die Forscher zwei Modelle B/8 (d. h. Basis-ViT-Modell, Patchgröße ist 4) und L/4 (d. h. Large-ViT-Modell) und bewerteten die Sexualität genau und Wahrnehmungsbewertungen.

Die Ergebnisse ähneln immer noch den frühen Stopp-ResNets-Beobachtungen, wobei schmalere ViTs mit geringerer Genauigkeit besser abschneiden als die Standardbreite.

Die optimalen Breiten von ViT-B/8 und ViT-L/4 betragen jedoch 6 % bzw. 12 % ihrer Standardbreiten. Das Papier enthält auch eine detailliertere experimentelle Liste für andere Hyperparameter B. Breite, Tiefe, Anzahl der Trainingsschritte, Gewichtsabfall, Label-Glättung und Dropout in ResNet und ViTs.

Wenn Sie also die wahrgenommene Ähnlichkeit verbessern möchten, ist die Strategie einfach: Reduzieren Sie einfach die Genauigkeit entsprechend.

Verbessern Sie die Wahrnehmungsbewertung durch Verkleinern des ImageNet-Modells. Die Werte in der Tabelle stellen die Verbesserung dar, die durch Skalieren des Modells mit gegebenen Hyperparametern gegenüber dem Modell mit Standard-Hyperparametern erzielt wird

gemäß In der obigen Schlussfolgerung schlagen wir eine einfache Strategie vor, um die Wahrnehmungsbewertung einer Architektur zu verbessern: Verkleinern Sie das Modell, um die Genauigkeit zu verringern, bis die optimale Wahrnehmungsbewertung erreicht ist.

In den experimentellen Ergebnissen ist auch die Verbesserung der Wahrnehmungsbewertung sichtbar, die durch die Verkleinerung jedes Modells für jeden Hyperparameter erzielt wird. Ein frühes Stoppen führt bei allen Architekturen mit Ausnahme von ViT-L/4 zu der höchsten Bewertungsverbesserung, und ein frühes Stoppen ist die effektivste Strategie, ohne dass zeitaufwändige Rastersuchen erforderlich sind.

Globale Wahrnehmungsfunktion

In früheren Arbeiten wurde die Wahrnehmungsähnlichkeitsfunktion mithilfe des euklidischen Abstands über Bildraumdimensionen berechnet.

Dieser Ansatz geht von einer direkten Entsprechung zwischen Pixeln aus, diese Entsprechung gilt jedoch möglicherweise nicht für gekrümmte, verschobene oder gedrehte Bilder.

In diesem Artikel haben die Forscher zwei Wahrnehmungsfunktionen übernommen, die auf der globalen Darstellung des Bildes basieren, nämlich die Stilverlustfunktion und die Normalisierung in der neuronalen Stilübertragungsarbeit, die die Stilähnlichkeit zwischen zwei Bildern erfasst Funktion. Die Stilverlustfunktion

vergleicht die Interkanal-Kreuzkorrelationsmatrix zwischen zwei Bildern, während die durchschnittliche Pooling-Funktion die räumlich gemittelte globale Darstellung vergleicht.

Die globale Perzeptronfunktion verbessert kontinuierlich die Wahrnehmungsbewertung sowohl der Standard-Hyperparameter des Netzwerktrainings als auch von ResNet-200 als Funktion der Trainingsepoche.

Der Artikel untersucht auch einige Annahmen, um die Genauigkeit und Beziehungen zu erklären zwischen Wahrnehmungswerten und leitete einige zusätzliche Erkenntnisse ab.

Zum Beispiel ist die Modellgenauigkeit ohne die häufig verwendete Sprungverbindung auch umgekehrt proportional zur Wahrnehmungsbewertung, wobei Schichten näher an der Ausgabe im Durchschnitt niedrigere Wahrnehmungsbewertungen aufweisen als Schichten näher an der Eingabe.

Außerdem wurden die Verzerrungsempfindlichkeit, die Granularität der ImageNet-Kategorie und die Ortsfrequenzempfindlichkeit weiter untersucht.

Kurz gesagt, dieser Artikel untersucht die Frage, ob eine Verbesserung der Klassifizierungsgenauigkeit zu besseren Wahrnehmungsmetriken führt. Er untersucht die Beziehung zwischen Genauigkeit und Wahrnehmungswerten auf ResNets und ViTs unter verschiedenen Hyperparametern und stellt fest, dass Wahrnehmungswerte und Genauigkeit ein umgekehrtes U darstellen. Typbeziehung, bei der Genauigkeits- und Wahrnehmungswerte bis zu einem gewissen Grad miteinander in Zusammenhang stehen und eine umgekehrte U-förmige Beziehung aufweisen.

Abschließend wird in dem Artikel die Beziehung zwischen Genauigkeit und Wahrnehmungsbewertung ausführlich erörtert, einschließlich Sprungverbindung, globaler Ähnlichkeitsfunktion, Verzerrungsempfindlichkeit, hierarchischer Wahrnehmungsbewertung, Ortsfrequenzempfindlichkeit und ImageNet-Kategoriegranularität.

Während die genaue Erklärung für den Kompromiss zwischen ImageNet-Genauigkeit und Wahrnehmungsähnlichkeit ein Rätsel bleibt, ist dieses Papier ein erster Schritt vorwärts.

Das obige ist der detaillierte Inhalt vonUntergraben Sie drei Konzepte! Die neueste Studie von Google: Ist es genauer, die „Ähnlichkeit' mit einem Modell mit schlechter Leistung zu berechnen?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1376

1376

52

52

CUDAs universelle Matrixmultiplikation: vom Einstieg bis zur Kompetenz!

Mar 25, 2024 pm 12:30 PM

CUDAs universelle Matrixmultiplikation: vom Einstieg bis zur Kompetenz!

Mar 25, 2024 pm 12:30 PM

Die allgemeine Matrixmultiplikation (GEMM) ist ein wesentlicher Bestandteil vieler Anwendungen und Algorithmen und außerdem einer der wichtigen Indikatoren zur Bewertung der Leistung der Computerhardware. Eingehende Forschung und Optimierung der Implementierung von GEMM können uns helfen, Hochleistungsrechnen und die Beziehung zwischen Software- und Hardwaresystemen besser zu verstehen. In der Informatik kann eine effektive Optimierung von GEMM die Rechengeschwindigkeit erhöhen und Ressourcen einsparen, was für die Verbesserung der Gesamtleistung eines Computersystems von entscheidender Bedeutung ist. Ein tiefgreifendes Verständnis des Funktionsprinzips und der Optimierungsmethode von GEMM wird uns helfen, das Potenzial moderner Computerhardware besser zu nutzen und effizientere Lösungen für verschiedene komplexe Computeraufgaben bereitzustellen. Durch Optimierung der Leistung von GEMM

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Stellen Sie sich ein Modell der künstlichen Intelligenz vor, das nicht nur die Fähigkeit besitzt, die traditionelle Datenverarbeitung zu übertreffen, sondern auch eine effizientere Leistung zu geringeren Kosten erzielt. Dies ist keine Science-Fiction, DeepSeek-V2[1], das weltweit leistungsstärkste Open-Source-MoE-Modell, ist da. DeepSeek-V2 ist ein leistungsstarkes MoE-Sprachmodell (Mix of Experts) mit den Merkmalen eines wirtschaftlichen Trainings und einer effizienten Inferenz. Es besteht aus 236B Parametern, von denen 21B zur Aktivierung jedes Markers verwendet werden. Im Vergleich zu DeepSeek67B bietet DeepSeek-V2 eine stärkere Leistung, spart gleichzeitig 42,5 % der Trainingskosten, reduziert den KV-Cache um 93,3 % und erhöht den maximalen Generierungsdurchsatz auf das 5,76-fache. DeepSeek ist ein Unternehmen, das sich mit allgemeiner künstlicher Intelligenz beschäftigt

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas tritt offiziell in die Ära der Elektroroboter ein! Gestern hat sich der hydraulische Atlas einfach „unter Tränen“ von der Bühne der Geschichte zurückgezogen. Heute gab Boston Dynamics bekannt, dass der elektrische Atlas im Einsatz ist. Es scheint, dass Boston Dynamics im Bereich kommerzieller humanoider Roboter entschlossen ist, mit Tesla zu konkurrieren. Nach der Veröffentlichung des neuen Videos wurde es innerhalb von nur zehn Stunden bereits von mehr als einer Million Menschen angesehen. Die alten Leute gehen und neue Rollen entstehen. Das ist eine historische Notwendigkeit. Es besteht kein Zweifel, dass dieses Jahr das explosive Jahr der humanoiden Roboter ist. Netizens kommentierten: Die Weiterentwicklung der Roboter hat dazu geführt, dass die diesjährige Eröffnungsfeier wie Menschen aussieht, und der Freiheitsgrad ist weitaus größer als der von Menschen. Aber ist das wirklich kein Horrorfilm? Zu Beginn des Videos liegt Atlas ruhig auf dem Boden, scheinbar auf dem Rücken. Was folgt, ist atemberaubend

KI untergräbt die mathematische Forschung! Der Gewinner der Fields-Medaille und der chinesisch-amerikanische Mathematiker führten 11 hochrangige Arbeiten an | Gefällt mir bei Terence Tao

Apr 09, 2024 am 11:52 AM

KI untergräbt die mathematische Forschung! Der Gewinner der Fields-Medaille und der chinesisch-amerikanische Mathematiker führten 11 hochrangige Arbeiten an | Gefällt mir bei Terence Tao

Apr 09, 2024 am 11:52 AM

KI verändert tatsächlich die Mathematik. Vor kurzem hat Tao Zhexuan, der diesem Thema große Aufmerksamkeit gewidmet hat, die neueste Ausgabe des „Bulletin of the American Mathematical Society“ (Bulletin der American Mathematical Society) weitergeleitet. Zum Thema „Werden Maschinen die Mathematik verändern?“ äußerten viele Mathematiker ihre Meinung. Der gesamte Prozess war voller Funken, knallhart und aufregend. Der Autor verfügt über eine starke Besetzung, darunter der Fields-Medaillengewinner Akshay Venkatesh, der chinesische Mathematiker Zheng Lejun, der NYU-Informatiker Ernest Davis und viele andere bekannte Wissenschaftler der Branche. Die Welt der KI hat sich dramatisch verändert. Viele dieser Artikel wurden vor einem Jahr eingereicht.

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

Anfang dieses Monats schlugen Forscher des MIT und anderer Institutionen eine vielversprechende Alternative zu MLP vor – KAN. KAN übertrifft MLP in Bezug auf Genauigkeit und Interpretierbarkeit. Und es kann MLP, das mit einer größeren Anzahl von Parametern ausgeführt wird, mit einer sehr kleinen Anzahl von Parametern übertreffen. Beispielsweise gaben die Autoren an, dass sie KAN nutzten, um die Ergebnisse von DeepMind mit einem kleineren Netzwerk und einem höheren Automatisierungsgrad zu reproduzieren. Konkret verfügt DeepMinds MLP über etwa 300.000 Parameter, während KAN nur etwa 200 Parameter hat. KAN hat eine starke mathematische Grundlage wie MLP und basiert auf dem universellen Approximationssatz, während KAN auf dem Kolmogorov-Arnold-Darstellungssatz basiert. Wie in der folgenden Abbildung gezeigt, hat KAN

Google ist begeistert: JAX-Leistung übertrifft Pytorch und TensorFlow! Es könnte die schnellste Wahl für das GPU-Inferenztraining werden

Apr 01, 2024 pm 07:46 PM

Google ist begeistert: JAX-Leistung übertrifft Pytorch und TensorFlow! Es könnte die schnellste Wahl für das GPU-Inferenztraining werden

Apr 01, 2024 pm 07:46 PM

Die von Google geförderte Leistung von JAX hat in jüngsten Benchmark-Tests die von Pytorch und TensorFlow übertroffen und belegt bei 7 Indikatoren den ersten Platz. Und der Test wurde nicht auf der TPU mit der besten JAX-Leistung durchgeführt. Obwohl unter Entwicklern Pytorch immer noch beliebter ist als Tensorflow. Aber in Zukunft werden möglicherweise mehr große Modelle auf Basis der JAX-Plattform trainiert und ausgeführt. Modelle Kürzlich hat das Keras-Team drei Backends (TensorFlow, JAX, PyTorch) mit der nativen PyTorch-Implementierung und Keras2 mit TensorFlow verglichen. Zunächst wählen sie eine Reihe von Mainstream-Inhalten aus

Tesla-Roboter arbeiten in Fabriken, Musk: Der Freiheitsgrad der Hände wird dieses Jahr 22 erreichen!

May 06, 2024 pm 04:13 PM

Tesla-Roboter arbeiten in Fabriken, Musk: Der Freiheitsgrad der Hände wird dieses Jahr 22 erreichen!

May 06, 2024 pm 04:13 PM

Das neueste Video von Teslas Roboter Optimus ist veröffentlicht und er kann bereits in der Fabrik arbeiten. Bei normaler Geschwindigkeit sortiert es Batterien (Teslas 4680-Batterien) so: Der Beamte hat auch veröffentlicht, wie es bei 20-facher Geschwindigkeit aussieht – auf einer kleinen „Workstation“, pflücken und pflücken und pflücken: Dieses Mal wird es freigegeben. Eines der Highlights Der Vorteil des Videos besteht darin, dass Optimus diese Arbeit in der Fabrik völlig autonom und ohne menschliches Eingreifen während des gesamten Prozesses erledigt. Und aus Sicht von Optimus kann es auch die krumme Batterie aufnehmen und platzieren, wobei der Schwerpunkt auf der automatischen Fehlerkorrektur liegt: In Bezug auf die Hand von Optimus gab der NVIDIA-Wissenschaftler Jim Fan eine hohe Bewertung ab: Die Hand von Optimus ist der fünffingrige Roboter der Welt am geschicktesten. Seine Hände sind nicht nur taktil

FisheyeDetNet: der erste Zielerkennungsalgorithmus basierend auf einer Fischaugenkamera

Apr 26, 2024 am 11:37 AM

FisheyeDetNet: der erste Zielerkennungsalgorithmus basierend auf einer Fischaugenkamera

Apr 26, 2024 am 11:37 AM

Die Zielerkennung ist ein relativ ausgereiftes Problem in autonomen Fahrsystemen, wobei die Fußgängererkennung einer der ersten Algorithmen ist, die eingesetzt werden. In den meisten Arbeiten wurde eine sehr umfassende Recherche durchgeführt. Die Entfernungswahrnehmung mithilfe von Fischaugenkameras für die Rundumsicht ist jedoch relativ wenig untersucht. Aufgrund der großen radialen Verzerrung ist es schwierig, die standardmäßige Bounding-Box-Darstellung in Fischaugenkameras zu implementieren. Um die obige Beschreibung zu vereinfachen, untersuchen wir erweiterte Begrenzungsrahmen-, Ellipsen- und allgemeine Polygondesigns in Polar-/Winkeldarstellungen und definieren eine mIOU-Metrik für die Instanzsegmentierung, um diese Darstellungen zu analysieren. Das vorgeschlagene Modell „fisheyeDetNet“ mit polygonaler Form übertrifft andere Modelle und erreicht gleichzeitig 49,5 % mAP auf dem Valeo-Fisheye-Kameradatensatz für autonomes Fahren