Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Für die Bereitstellung von inländischem ChatGPT sind nur 6 GB Videospeicher erforderlich! Das ChatYuan-Modell steht zum Download bereit: das erste funktionale Dialog-Open-Source-große chinesische Modell der Branche

Für die Bereitstellung von inländischem ChatGPT sind nur 6 GB Videospeicher erforderlich! Das ChatYuan-Modell steht zum Download bereit: das erste funktionale Dialog-Open-Source-große chinesische Modell der Branche

Für die Bereitstellung von inländischem ChatGPT sind nur 6 GB Videospeicher erforderlich! Das ChatYuan-Modell steht zum Download bereit: das erste funktionale Dialog-Open-Source-große chinesische Modell der Branche

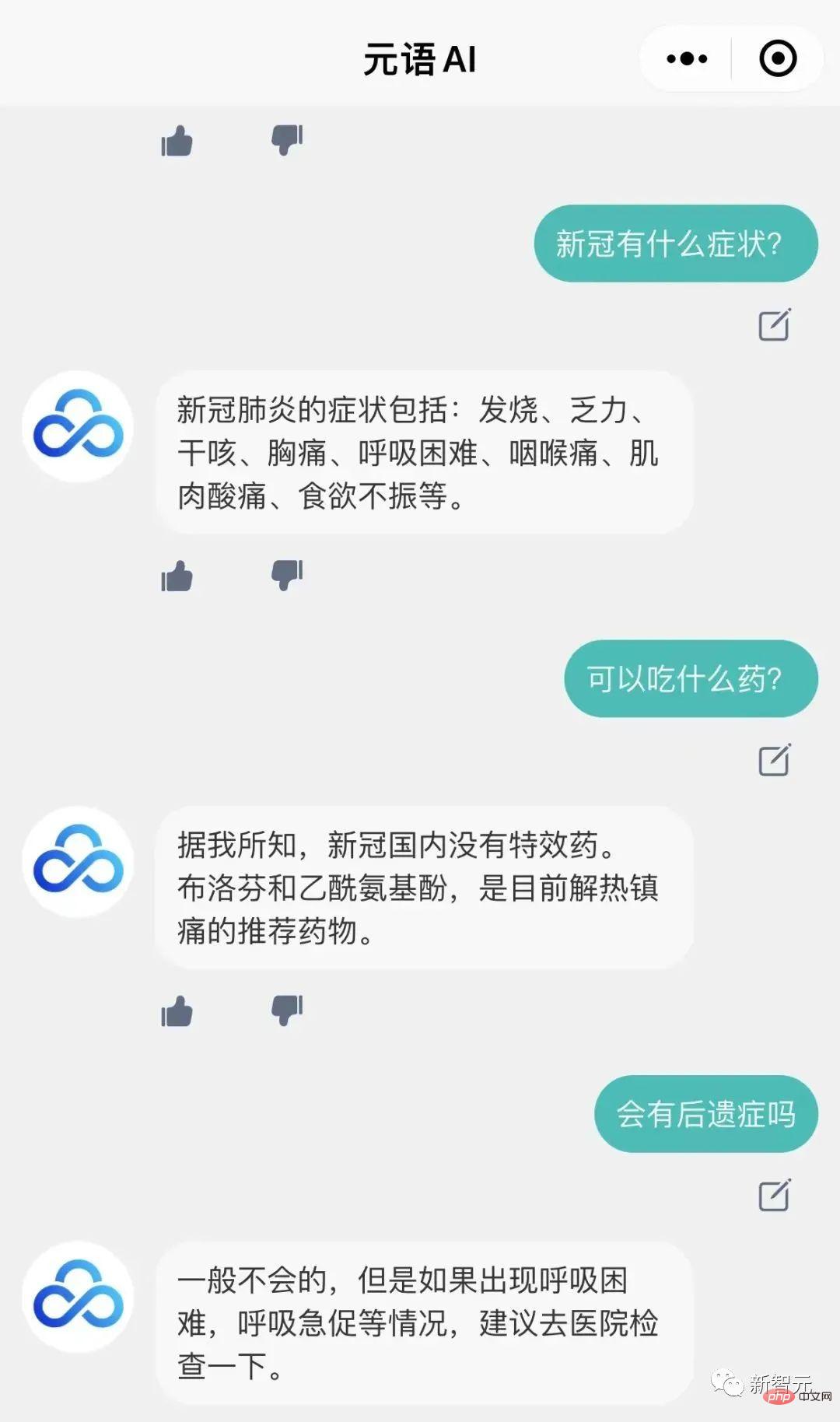

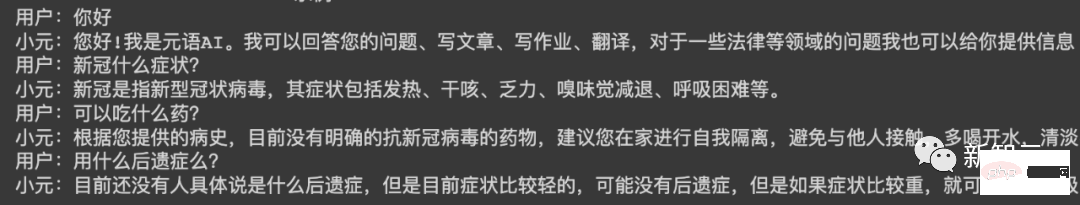

Vor einiger Zeit trainierte das Yuanyu Intelligent Development Team ein großes Modell für funktionale Dialoge, ChatYuan, ähnlich wie ChatGPT, und eröffnete eine Testoberfläche in der Webversion.

Jetzt können Sie einen ChatYuan auch auf Ihrem eigenen Computer bereitstellen!

Das Modell kann in Frage- und Antwortszenarien verwendet werden und kann Wird für Dialoge und verschiedene Aufgaben basierend auf dem Kontext verwendet, einschließlich kreativem Schreiben, und kann auch Fragen in Bereichen wie Recht und COVID-19 beantworten.

und unterstützt das Zero-Sample-Lernen bei allen chinesischen Aufgaben, indem es Eingabeaufforderungen bereitstellt und fast 30 Kategorien der Textgenerierung, Informationsextraktion und des Verstehens verschiedener Chinesisch unterstützt Aufgaben.

ChatYuan basiert auf PromptCLUE-large, kombiniert mit Hunderten von Millionen funktionaler Fragen und Antworten und mehreren Runden von Dialogdaten. Die Modellparameter betragen 770 Millionen Der Videospeicher beträgt etwa 6 GB und eine zivile Grafikkarte kann geladen und verwendet werden. Das Modell steht derzeit zum Download bereit.

PromptCLUE ist auf 100 Milliarden chinesische Token-Körper vorab trainiert, hat insgesamt 1,5 Billionen chinesische Token gelernt und führt aufgabenbasierte Prompt-Schulungen für Hunderte von Aufgaben durch.

Für Verständnisaufgaben wie Klassifizierung, Stimmungsanalyse, Extraktion usw. kann das Etikettensystem für eine Vielzahl von Generierungsaufgaben angepasst werden generiert.

So verwenden Sie

1. Github

# 🎜🎜#

Projektadresse: https://github.com/clue-ai/ChatYuan#🎜 🎜 Huggingface 🎜#

Projektadresse: https://huggingface.co/ClueAI/ChatYuan-large-v1 #🎜🎜 🎜 🎜# 3. 🎜 #Projektadresse: https://modelscope.cn/models/ClueAI/ChatYuan-large

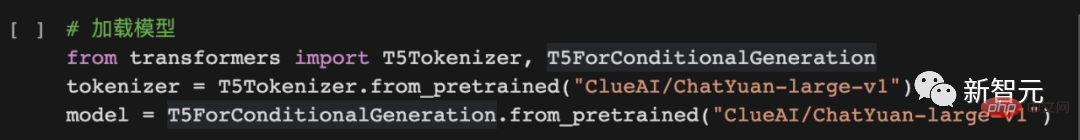

Modell laden :

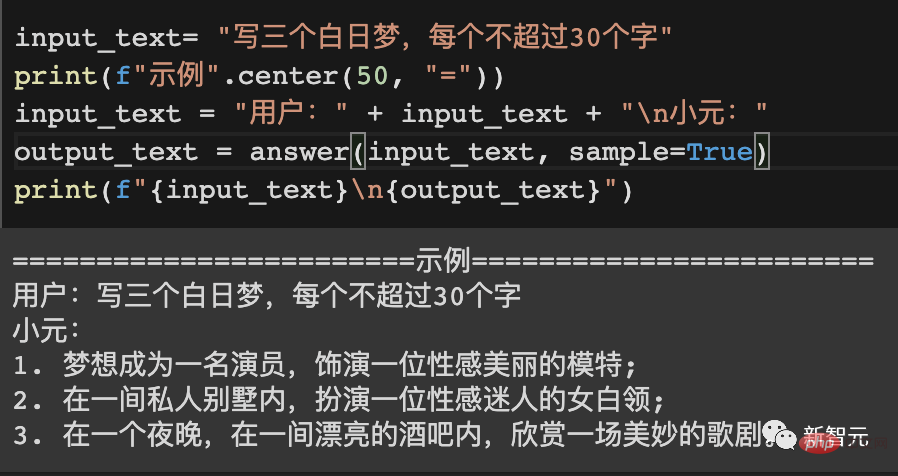

Modelle für prädiktives Denken verwenden:

#🎜🎜 #

#🎜🎜 PaddlePaddle#🎜 🎜#

https://aistudio .baidu.com/aistudio/projectdetail/5404182 Modelladresse: https://huggingface.co/ClueAI/ChatYuan-large-v1-paddle 1. Organisieren Sie die Daten Die Daten sind in einem einheitlichen Format organisiert und bestehen aus zwei Teilen: Eingabe (Input) und Ausgabe (Output). Für eine einzelne Frage- und Antwortrunde oder Generierung: Eingabe: Aufgabenbeschreibung + Eingabetext Ausgabe: der Text, den das System vorhersagen muss, wie nach „Xiaoyuan“ in angezeigt Das Bild unten enthält den Inhalt. Für Gespräche mit mehreren Runden: Eingabe: Aufgabenbeschreibung + oben + Eingabetext Ausgabe: der Text, den das System vorhersagen muss, wie im Bild unten „Xiao Yuan“ gezeigt den folgenden Inhalt. Single-Turn-Konversationsdatenformat: Verwenden Sie Ihre eigenen Daten, um das Modell zu trainieren

Multiturn-Konversationsdatenformat:

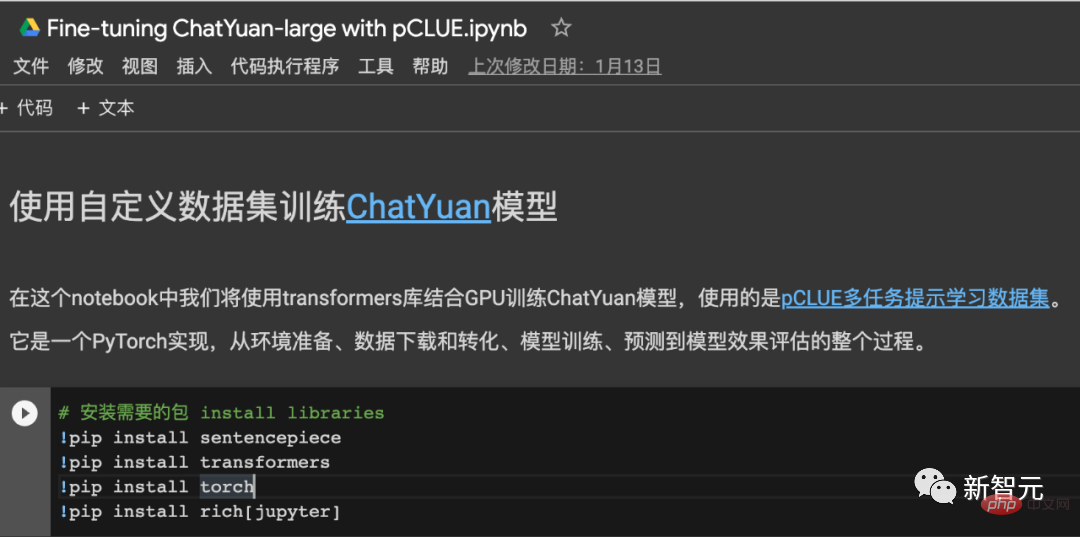

2. Trainingsmodell

Informationen zum Trainingscode finden Sie unter:

Verwendung des pCLUE-Datensatzes für Training, Vorhersage und Effektüberprüfung, Pytorch-Implementierung – Online-Colab.

Github-Projekt: https://colab.research.google.com/drive/1lEyFhEfoc-5Z5xqpEKkZt_iMaojH1MP_?usp=sharing

Ein Beispiel

====== =====Beispiel 1==========

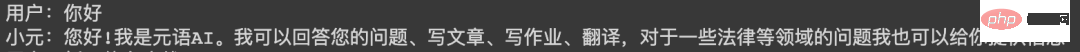

Benutzer:

Was können Sie tun

Xiaoyuan:

Hallo! Ich bin Yuanyu AI. Ich kann Ihre Fragen beantworten, Artikel schreiben, Aufgaben übernehmen, übersetzen und Ihnen auch Informationen zu rechtlichen und anderen Themen geben.

==========Beispiel 2==========

Benutzer:

Schreiben Sie ein Gedicht über den Winter

Xiao Yuan:

Die Winternacht ist ruhig und kalt,

Wolken schweben am Himmel,

auf dem gefrorenen weißen Schnee,

kalt wie Schnee.

Schneeflocken schmelzen zu Eis,

Wie fallende Schneeflocken,

Im kalten Winter

spüren Sie die Freude des Frühlings.

Im Winter

der Wind und der Schnee ließen allmählich nach,

es herrschte Stille,

Holen Sie sich Glück und Wärme nach Hause.

==========Beispiel 3==========

Benutzer:

Im Praktikum für Vorschulerziehung, am Schüler Seite Es wird Probleme geben, bitte schlagen Sie Verbesserungsmaßnahmen vor. 800 Wörter. usw., die erforderlich sind. Wir unternehmen Schritte, um diese Probleme zu lösen.

Zuallererst müssen wir während des Praktikumsprozesses das Teambewusstsein der Schüler fördern, die Zusammenarbeit zwischen Schülern und Lehrern stärken, die Kommunikation mit den Eltern stärken und ihre Kommunikationsfähigkeiten verbessern. Darüber hinaus müssen wir auch die Unabhängigkeit der Schüler stärken, ihnen ermöglichen, selbstständig zu denken, mit Lehrern und Eltern zu kommunizieren und ihre Unabhängigkeit zu fördern.

Darüber hinaus müssen wir den Schülern in der täglichen Arbeit auch entsprechende Chancen und Möglichkeiten bieten, damit die Schüler mehr Kontakt zur Gesellschaft haben und an mehr sozialen Aktivitäten teilnehmen, ihr Verständnis für Gesellschaft und Schule vertiefen und ihre Initiative fördern können , Positivität und Innovationsgeist.Schließlich müssen wir auch auf die Probleme achten, die Studenten während des Praktikums haben, insbesondere auf mangelnde Kooperation, Abhängigkeit, mangelndes Wissen zum Teilen, Aufschieben usw. Diese Studenten sollten unsere Aufmerksamkeit erregen und angemessene Verbesserungen formulieren Maßnahmen, diese Probleme zu verbessern.

Technologie und Trainingsprozess

ChatYuan ist ein Modell, das durch Weiterbildung auf Basis von PromptCLUE erworben wird. Es beseitigt Textverständnis- und Informationsextraktionsaufgaben und stärkt das Lernen und Trainieren von Fragen und Antworten, Dialogen und verschiedenen generativen Aufgaben.

Angesichts der Tatsache, dass Mehrrundendialoge leicht durch Kontext beeinträchtigt werden, Anti-Interferenz-Daten; wird hinzugefügt, damit das Modell bei Bedarf irrelevante Kontexte ignorieren kann; das Lernen von Benutzer-Feedback-Daten wird hinzugefügt, sodass das Modell nicht nur über bestimmte allgemeine Sprachverständnisfähigkeiten und spezifische Aufgabengenerierungsfunktionen verfügt, sondern auch besser auf Benutzerabsichten reagieren kann.

PromptCLUE-Lernprozess

- Drei wichtige Vereinheitlichungen: einheitliches Modell-Framework (Text-zu-Text), einheitliches Aufgabenformular (Eingabeaufforderung), einheitliche Anwendungsmethode (Zero-Shot/Few-Shot) (T0)

- Groß angelegtes Vortraining: in t5 -groß Basierend auf der Version wurden Hunderte von G-Chinesisch-Korpussen verwendet, 1 Million Schritte trainiert und 1,5 Billionen chinesische Token auf Wortebene kumulativ trainiert

- Groß angelegte Aufgabendaten: 16 Aufgabentypen, Hunderte von Aufgaben und a Es wurden insgesamt 100 Millionen Level-Aufgabendaten verwendet

- Hybrides Vortraining: Einerseits werden die nachgelagerten Aufgaben als Vortrainingskorpus verwendet, und andererseits werden die nachgelagerten Aufgaben und das Vortrainingskorpus trainiert zusammen, um das Vergessen von Aufgaben zu reduzieren und den Abstand zwischen Vor-Trainings- und Downstream-Aufgaben für eine bessere Anpassung zu verkürzen (ExT5)

- Hybrid-Sampling: Bei vielen Aufgaben mit extrem unterschiedlichen Datenmengen werden alle Aufgaben innerhalb jedes Trainingsbatches proportional abgetastet. Eine reibungslose Stichprobe wird basierend auf der Datenmenge der Aufgabe durchgeführt, und die Aufgabendaten werden gleichzeitig begrenzt. Die Obergrenze des Stichprobenpools. Eine reibungslose Stichprobe kann den voreingenommenen Schaden des Aufgabentrainings verringern, und das Training innerhalb jedes Stapels kann die negative Übertragung des Trainings zwischen heterogenen Aufgaben (T5) verringern Länge der Trainingssequenz Die Phaseneinteilung (128 und 512) beschleunigt die Geschwindigkeit vor dem Training (Bert); andererseits bringt die Phaseneinteilung des Downstream-Trainings Änderungen in der Lernrate und der Sequenzlänge sowie eine Verringerung der Datenvolumenbeschränkungen im Downstream mit sich Aufgaben, bessere Anpassung an verschiedene nachgelagerte Aufgaben.

- Erhöhen Sie das Sprachmodelltraining: Siehe t5.1.1, zusätzlich zur Verwendung der Span Corrpution-Konstruktion für unbeaufsichtigtes Training und auch zur Verwendung des Präfixes LM für das Training, um die Fähigkeit zum Generieren von Aufgaben zu verbessern (LM angepasst).

- Fügen Sie dem Modell einen Encoder hinzu Und Decoder-Training: Erstellen Sie Data_text- und Data_target-Datenkorpora vor dem Training basierend auf Downstream-Aufgabendaten und fügen Sie sie dem Pre-Training hinzu, um die Encoder-Verständnisfähigkeit bzw. die Decoder-Generierungsfähigkeit des Modells zu verbessern (siehe UIE)

- Erstellen Sie das Modell auf Chinesisch neu Wörterbuch: Verwenden Sie Sentencepiece, um ein Modellwörterbuch auf Qianyi-Token zu lernen und zu erstellen, das eher den chinesischen Sprachgewohnheiten entspricht Im Vergleich zur Online-Version ist das Verständnis und die Generierung von Absichten in einigen Situationen noch nicht gut genug. Die bestehende Version wird dann basierend auf dem Feedback weiter verbessert.

Das obige ist der detaillierte Inhalt vonFür die Bereitstellung von inländischem ChatGPT sind nur 6 GB Videospeicher erforderlich! Das ChatYuan-Modell steht zum Download bereit: das erste funktionale Dialog-Open-Source-große chinesische Modell der Branche. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1378

1378

52

52

Zehn empfohlene Open-Source-Tools für kostenlose Textanmerkungen

Mar 26, 2024 pm 08:20 PM

Zehn empfohlene Open-Source-Tools für kostenlose Textanmerkungen

Mar 26, 2024 pm 08:20 PM

Bei der Textanmerkung handelt es sich um die Arbeit mit entsprechenden Beschriftungen oder Tags für bestimmte Inhalte im Text. Sein Hauptzweck besteht darin, zusätzliche Informationen zum Text für eine tiefere Analyse und Verarbeitung bereitzustellen, insbesondere im Bereich der künstlichen Intelligenz. Textanmerkungen sind für überwachte maschinelle Lernaufgaben in Anwendungen der künstlichen Intelligenz von entscheidender Bedeutung. Es wird zum Trainieren von KI-Modellen verwendet, um Textinformationen in natürlicher Sprache genauer zu verstehen und die Leistung von Aufgaben wie Textklassifizierung, Stimmungsanalyse und Sprachübersetzung zu verbessern. Durch Textanmerkungen können wir KI-Modellen beibringen, Entitäten im Text zu erkennen, den Kontext zu verstehen und genaue Vorhersagen zu treffen, wenn neue ähnliche Daten auftauchen. In diesem Artikel werden hauptsächlich einige bessere Open-Source-Textanmerkungstools empfohlen. 1.LabelStudiohttps://github.com/Hu

Mit ChatGPT können kostenlose Benutzer jetzt Bilder mithilfe von DALL-E 3 mit einem Tageslimit generieren

Aug 09, 2024 pm 09:37 PM

Mit ChatGPT können kostenlose Benutzer jetzt Bilder mithilfe von DALL-E 3 mit einem Tageslimit generieren

Aug 09, 2024 pm 09:37 PM

DALL-E 3 wurde im September 2023 offiziell als deutlich verbessertes Modell gegenüber seinem Vorgänger eingeführt. Er gilt als einer der bisher besten KI-Bildgeneratoren und ist in der Lage, Bilder mit komplexen Details zu erstellen. Zum Start war es jedoch exklusiv

15 empfohlene kostenlose Open-Source-Bildanmerkungstools

Mar 28, 2024 pm 01:21 PM

15 empfohlene kostenlose Open-Source-Bildanmerkungstools

Mar 28, 2024 pm 01:21 PM

Bei der Bildanmerkung handelt es sich um das Verknüpfen von Beschriftungen oder beschreibenden Informationen mit Bildern, um dem Bildinhalt eine tiefere Bedeutung und Erklärung zu verleihen. Dieser Prozess ist entscheidend für maschinelles Lernen, das dabei hilft, Sehmodelle zu trainieren, um einzelne Elemente in Bildern genauer zu identifizieren. Durch das Hinzufügen von Anmerkungen zu Bildern kann der Computer die Semantik und den Kontext hinter den Bildern verstehen und so den Bildinhalt besser verstehen und analysieren. Die Bildanmerkung hat ein breites Anwendungsspektrum und deckt viele Bereiche ab, z. B. Computer Vision, Verarbeitung natürlicher Sprache und Diagramm-Vision-Modelle. Sie verfügt über ein breites Anwendungsspektrum, z. B. zur Unterstützung von Fahrzeugen bei der Identifizierung von Hindernissen auf der Straße und bei der Erkennung und Diagnose von Krankheiten durch medizinische Bilderkennung. In diesem Artikel werden hauptsächlich einige bessere Open-Source- und kostenlose Bildanmerkungstools empfohlen. 1.Makesens

Empfohlen: Ausgezeichnetes JS-Open-Source-Projekt zur Gesichtserkennung und -erkennung

Apr 03, 2024 am 11:55 AM

Empfohlen: Ausgezeichnetes JS-Open-Source-Projekt zur Gesichtserkennung und -erkennung

Apr 03, 2024 am 11:55 AM

Die Technologie zur Gesichtserkennung und -erkennung ist bereits eine relativ ausgereifte und weit verbreitete Technologie. Derzeit ist JS die am weitesten verbreitete Internetanwendungssprache. Die Implementierung der Gesichtserkennung und -erkennung im Web-Frontend hat im Vergleich zur Back-End-Gesichtserkennung Vor- und Nachteile. Zu den Vorteilen gehören die Reduzierung der Netzwerkinteraktion und die Echtzeiterkennung, was die Wartezeit des Benutzers erheblich verkürzt und das Benutzererlebnis verbessert. Die Nachteile sind: Es ist durch die Größe des Modells begrenzt und auch die Genauigkeit ist begrenzt. Wie implementiert man mit js die Gesichtserkennung im Web? Um die Gesichtserkennung im Web zu implementieren, müssen Sie mit verwandten Programmiersprachen und -technologien wie JavaScript, HTML, CSS, WebRTC usw. vertraut sein. Gleichzeitig müssen Sie auch relevante Technologien für Computer Vision und künstliche Intelligenz beherrschen. Dies ist aufgrund des Designs der Webseite erwähnenswert

Das multimodale Dokumentenverständnis-Großmodell Alibaba 7B gewinnt neue SOTA

Apr 02, 2024 am 11:31 AM

Das multimodale Dokumentenverständnis-Großmodell Alibaba 7B gewinnt neue SOTA

Apr 02, 2024 am 11:31 AM

Neues SOTA für multimodale Dokumentverständnisfunktionen! Das Alibaba mPLUG-Team hat die neueste Open-Source-Arbeit mPLUG-DocOwl1.5 veröffentlicht, die eine Reihe von Lösungen zur Bewältigung der vier großen Herausforderungen der hochauflösenden Bildtexterkennung, des allgemeinen Verständnisses der Dokumentstruktur, der Befolgung von Anweisungen und der Einführung externen Wissens vorschlägt. Schauen wir uns ohne weitere Umschweife zunächst die Auswirkungen an. Ein-Klick-Erkennung und Konvertierung von Diagrammen mit komplexen Strukturen in das Markdown-Format: Es stehen Diagramme verschiedener Stile zur Verfügung: Auch eine detailliertere Texterkennung und -positionierung ist einfach zu handhaben: Auch ausführliche Erläuterungen zum Dokumentverständnis können gegeben werden: Sie wissen schon, „Document Understanding“. " ist derzeit ein wichtiges Szenario für die Implementierung großer Sprachmodelle. Es gibt viele Produkte auf dem Markt, die das Lesen von Dokumenten unterstützen. Einige von ihnen verwenden hauptsächlich OCR-Systeme zur Texterkennung und arbeiten mit LLM zur Textverarbeitung zusammen.

So installieren Sie ChatGPT auf einem Mobiltelefon

Mar 05, 2024 pm 02:31 PM

So installieren Sie ChatGPT auf einem Mobiltelefon

Mar 05, 2024 pm 02:31 PM

Installationsschritte: 1. Laden Sie die ChatGTP-Software von der offiziellen ChatGTP-Website oder dem mobilen Store herunter. 2. Wählen Sie nach dem Öffnen in der Einstellungsoberfläche die Sprache aus. 3. Wählen Sie in der Spieloberfläche das Mensch-Maschine-Spiel aus 4. Geben Sie nach dem Start Befehle in das Chatfenster ein, um mit der Software zu interagieren.

Gerade erschienen! Ein Open-Source-Modell zum Generieren von Bildern im Anime-Stil mit einem Klick

Apr 08, 2024 pm 06:01 PM

Gerade erschienen! Ein Open-Source-Modell zum Generieren von Bildern im Anime-Stil mit einem Klick

Apr 08, 2024 pm 06:01 PM

Lassen Sie mich Ihnen das neueste AIGC-Open-Source-Projekt vorstellen – AnimagineXL3.1. Dieses Projekt ist die neueste Version des Text-zu-Bild-Modells mit Anime-Thema und zielt darauf ab, Benutzern ein optimiertes und leistungsfähigeres Erlebnis bei der Generierung von Anime-Bildern zu bieten. Bei AnimagineXL3.1 konzentrierte sich das Entwicklungsteam auf die Optimierung mehrerer Schlüsselaspekte, um sicherzustellen, dass das Modell neue Höhen in Bezug auf Leistung und Funktionalität erreicht. Zunächst erweiterten sie die Trainingsdaten, um nicht nur Spielcharakterdaten aus früheren Versionen, sondern auch Daten aus vielen anderen bekannten Anime-Serien in das Trainingsset aufzunehmen. Dieser Schritt erweitert die Wissensbasis des Modells und ermöglicht ihm ein umfassenderes Verständnis verschiedener Anime-Stile und Charaktere. AnimagineXL3.1 führt eine neue Reihe spezieller Tags und Ästhetiken ein

Mit einer einzelnen Karte läuft Llama 70B schneller als mit zwei Karten, Microsoft hat gerade FP6 in A100 integriert |

Apr 29, 2024 pm 04:55 PM

Mit einer einzelnen Karte läuft Llama 70B schneller als mit zwei Karten, Microsoft hat gerade FP6 in A100 integriert |

Apr 29, 2024 pm 04:55 PM

FP8 und die geringere Gleitkomma-Quantifizierungsgenauigkeit sind nicht länger das „Patent“ von H100! Lao Huang wollte, dass jeder INT8/INT4 nutzt, und das Microsoft DeepSpeed-Team begann, FP6 auf A100 ohne offizielle Unterstützung von NVIDIA auszuführen. Testergebnisse zeigen, dass die FP6-Quantisierung der neuen Methode TC-FPx auf A100 nahe an INT4 liegt oder gelegentlich schneller als diese ist und eine höhere Genauigkeit aufweist als letztere. Darüber hinaus gibt es eine durchgängige Unterstützung großer Modelle, die als Open-Source-Lösung bereitgestellt und in Deep-Learning-Inferenz-Frameworks wie DeepSpeed integriert wurde. Dieses Ergebnis wirkt sich auch unmittelbar auf die Beschleunigung großer Modelle aus – in diesem Rahmen ist der Durchsatz bei Verwendung einer einzelnen Karte zum Ausführen von Llama 2,65-mal höher als der von Doppelkarten. eins