Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Eine GPU, 20 Modelle pro Sekunde! NVIDIAs neues Spielzeug nutzt GET3D, um das Universum zu erschaffen

Eine GPU, 20 Modelle pro Sekunde! NVIDIAs neues Spielzeug nutzt GET3D, um das Universum zu erschaffen

Eine GPU, 20 Modelle pro Sekunde! NVIDIAs neues Spielzeug nutzt GET3D, um das Universum zu erschaffen

Abrakadabra!

In Bezug auf 2D-generierte 3D-Modelle hat NVIDIA seine selbsternannte „Weltklasse“-Forschung vorgestellt: GET3D.

Nach dem Training an 2D-Bildern generiert das Modell 3D-Formen mit hochauflösenden Texturen und komplexen geometrischen Details.

Wie mächtig ist es?

Anpassung von Form, Textur und Material

GET3D erhielt seinen Namen aufgrund seiner Fähigkeit, explizite texturierte 3D-Netze zu erzeugen.

Papieradresse: https://arxiv.org/pdf/2209.11163.pdf

Das heißt, die dadurch erzeugte Form hat die Form eines Dreiecksnetzes, genau wie ein Papiermodell. Gleiches, mit Strukturmaterial überzogen.

Der Schlüssel ist, dass dieses Modell eine Vielzahl hochwertiger Modelle generieren kann.

Zum Beispiel verschiedene Räder an Stuhlbeinen; Tierohren und -hörner; Texturen auf Autoreifen, menschliche Kleidung... .

Einzigartige Gebäude auf beiden Seiten der Straße, verschiedene vorbeifliegende Fahrzeuge und verschiedene vorbeifahrende Personengruppen ...

Wenn Sie durch manuelle Modellierung dieselbe virtuelle 3D-Welt erstellen möchten, ist dies sehr zeitaufwändig.

Obwohl frühere 3D-generierte KI-Modelle schneller sind als die manuelle Modellierung, fehlt es ihnen immer noch an der Fähigkeit, detailliertere Modelle zu generieren.

Selbst die neuesten inversen Rendering-Methoden können 3D-Objekte nur auf der Grundlage von 2D-Bildern generieren, die aus verschiedenen Winkeln aufgenommen wurden, und Entwickler können jeweils nur ein 3D-Objekt erstellen.

GET3D ist anders.

Entwickler können generierte Modelle problemlos in Game Engines, 3D-Modellierer und Filmrenderer importieren, um sie zu bearbeiten.

Wenn Entwickler GET3D-generierte Modelle in Grafikanwendungen exportieren, können sie realistische Lichteffekte anwenden, während sich das Modell innerhalb der Szene bewegt oder dreht.

Wie im Bild gezeigt:

Darüber hinaus kann GET3D auch textgeführte Formen generieren.

Mit StyleGAN-NADA, einem weiteren KI-Tool von NVIDIA, können Entwickler mithilfe von Textaufforderungen bestimmte Stile zu Bildern hinzufügen.

Zum Beispiel können Sie ein verputztes Auto in ein ausgebranntes Auto oder ein Taxi verwandeln.

Ein gewöhnliches Haus in ein Backsteinhaus, ein brennendes Haus oder sogar ein Spukhaus umwandeln.

Oder wenden Sie die Eigenschaften von Tiger- und Panda-Prints auf jedes Tier an ...

Es ist einfach das „Animal Crossing“ der Simpsons ...

NVIDIA gab bekannt, dass GET3D beim Training auf einer einzelnen NVIDIA-GPU etwa 20 Objekte pro Sekunde generieren kann.

Je größer und vielfältiger der Trainingsdatensatz ist, aus dem gelernt wird, desto vielfältiger und detaillierter wird die Ausgabe sein.

NVIDIA sagte, dass das Forschungsteam die A100-GPU verwendet habe, um das Modell in nur 2 Tagen mit etwa 1 Million Bildern zu trainieren.

Forschungsmethoden und -prozesse

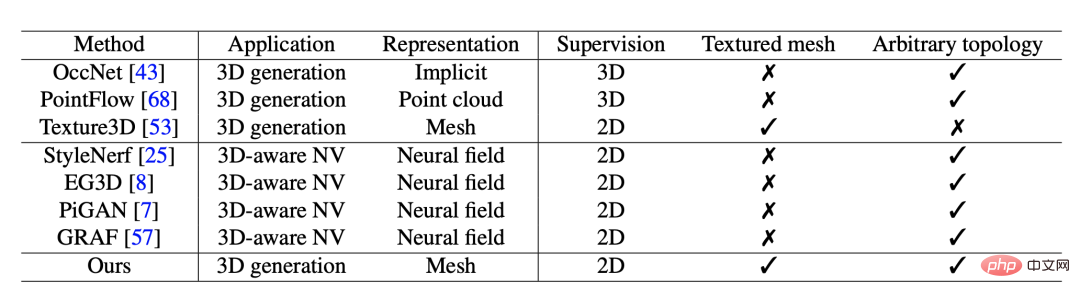

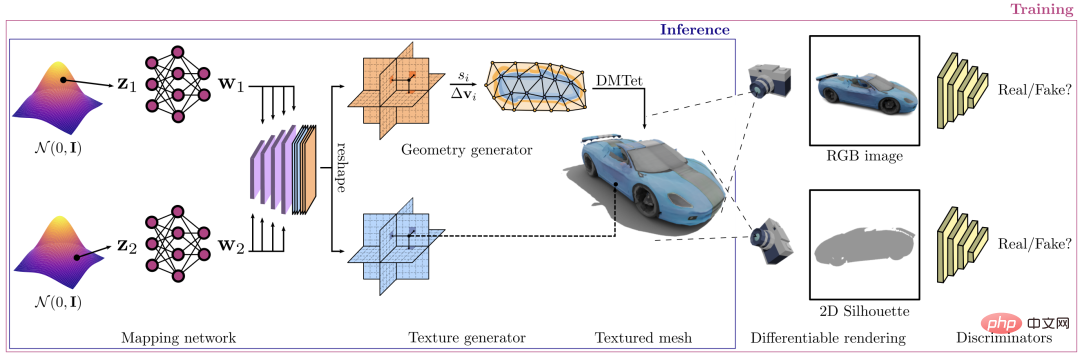

GET3D-Framework, dessen Hauptfunktion darin besteht, strukturierte dreidimensionale Formen zu synthetisieren.

Der Generierungsprozess gliedert sich in zwei Teile: Der erste Teil ist der Geometriezweig, der Oberflächennetze beliebiger Topologie ausgeben kann. Der andere Teil ist der Texturzweig, der ein Texturfeld erzeugt, aus dem Oberflächenpunkte abgefragt werden können.

Während des Trainingsprozesses wird ein differenzierbarer Rasterizer verwendet, um das resultierende Texturnetz effizient in ein zweidimensionales hochauflösendes Bild zu rendern. Der gesamte Prozess ist trennbar und ermöglicht ein gegnerisches Training aus Bildern durch die Ausbreitung der Gradienten des 2D-Diskriminators.

Danach wird der Gradient vom 2D-Diskriminator an die beiden Generatorzweige weitergegeben.

Die Forscher führten umfangreiche Experimente durch, um das Modell zu evaluieren. Sie verglichen zunächst die Qualität der von GET3D generierten 3D-Texturnetze mit vorhandenen Netzen, die mit den Datensätzen ShapeNet und Turbosquid generiert wurden.

Als nächstes optimierten die Forscher das Modell in Folgestudien auf Basis der Vergleichsergebnisse und führten weitere Experimente durch.

GET3D-Modell ist in der Lage, Phasentrennung in Geometrie und Textur durchzuführen.

Wie in der Abbildung gezeigt, wird in jeder Zeile die durch denselben versteckten Geometriecode erzeugte Form angezeigt, während der Texturcode geändert wird.

In jeder Spalte werden die Formen angezeigt, die durch denselben Textur-Ausblendcode generiert wurden, während der Geometriecode geändert wurde.

Darüber hinaus fügten die Forscher den Geometrie-Versteckcode von links nach rechts in die Formen ein, die durch denselben Textur-Versteckcode in jeder Zeile erzeugt wurden.

und die Formen, die durch denselben versteckten Geometriecode generiert werden, während der Texturcode von oben nach unten eingefügt wird. Die Ergebnisse zeigen, dass jede Interpolation für das generierte Modell von Bedeutung ist.

Innerhalb des Untergraphen jedes Modells ist GET3D in der Lage, fließende Übergänge zwischen verschiedenen Formen in allen Kategorien zu erzeugen.

Unterbrechen Sie in jeder Zeile lokal den versteckten Code, indem Sie ein kleines Rauschen hinzufügen. Auf diese Weise ist GET3D in der Lage, lokal Formen zu generieren, die ähnlich aussehen, sich aber leicht unterscheiden.

Die Forscher weisen darauf hin, dass zukünftige Versionen von GET3D die Kamerapositionsschätzungstechnologie verwenden könnten, die es Entwicklern ermöglicht, Modelle anhand realer Daten statt synthetischer Datensätze zu trainieren.

In Zukunft können Entwickler durch Verbesserungen GET3D auf einmal für eine Vielzahl von 3D-Formen trainieren, anstatt es jeweils für eine Objektkategorie trainieren zu müssen.

Sanja Fidler, Vizepräsidentin für künstliche Intelligenzforschung bei Nvidia, sagte:

GET3D bringt uns der Demokratisierung der KI-gesteuerten 3D-Inhaltserstellung einen Schritt näher. Seine Fähigkeit, texturierte 3D-Formen im Handumdrehen zu erzeugen, könnte für Entwickler von entscheidender Bedeutung sein und ihnen dabei helfen, virtuelle Welten schnell mit einer Vielzahl interessanter Objekte zu bevölkern.

Vorstellung des Autors

Der Erstautor des Artikels, Jun Gao, ist Doktorand in der Gruppe für maschinelles Lernen der University of Toronto und seine Betreuerin ist Sanja Fidler.

Zusätzlich zu seinen hervorragenden akademischen Qualifikationen ist er auch wissenschaftlicher Mitarbeiter am NVIDIA Toronto Artificial Intelligence Laboratory.

Seine Forschung konzentriert sich hauptsächlich auf Deep Learning (DL) mit dem Ziel des strukturierten Lernens geometrischer Darstellungen. Gleichzeitig zieht seine Forschung auch Erkenntnisse aus der menschlichen Wahrnehmung von 2D- und 3D-Bildern und Videos.

Solch ein herausragender Student kommt von der Peking-Universität. 2018 schloss er sein Studium mit einem Bachelor ab. Während seines Studiums an der Peking-Universität arbeitete er mit Professor Wang Liwei zusammen.

Nach seinem Abschluss absolvierte er außerdem Praktika an der Stanford University, MSRA und NVIDIA.

Die Ausbilder von Jun Gao sind ebenfalls führend in der Branche.

Fidler ist außerordentliche Professorin an der University of Toronto und Fakultätsmitglied am Vector Institute, wo sie auch Mitbegründerin ist.

Neben ihrer Lehrtätigkeit ist sie auch Vizepräsidentin für künstliche Intelligenzforschung bei NVIDIA und leitet ein Forschungslabor in Toronto.

Bevor sie nach Toronto kam, war sie Forschungsassistentin am Toyota Institute of Technology in Chicago. Das Institut befindet sich auf dem Campus der University of Chicago und gilt als akademische Einrichtung.

Fidlers Forschungsbereiche konzentrieren sich auf Computer Vision (CV) und maschinelles Lernen (ML), wobei der Schwerpunkt auf der Schnittstelle von CV und Grafik, 3D-Vision, 3D-Rekonstruktion und -Synthese sowie interaktiven Methoden der Bildannotation usw. liegt.

Das obige ist der detaillierte Inhalt vonEine GPU, 20 Modelle pro Sekunde! NVIDIAs neues Spielzeug nutzt GET3D, um das Universum zu erschaffen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1377

1377

52

52

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

Anfang dieses Monats schlugen Forscher des MIT und anderer Institutionen eine vielversprechende Alternative zu MLP vor – KAN. KAN übertrifft MLP in Bezug auf Genauigkeit und Interpretierbarkeit. Und es kann MLP, das mit einer größeren Anzahl von Parametern ausgeführt wird, mit einer sehr kleinen Anzahl von Parametern übertreffen. Beispielsweise gaben die Autoren an, dass sie KAN nutzten, um die Ergebnisse von DeepMind mit einem kleineren Netzwerk und einem höheren Automatisierungsgrad zu reproduzieren. Konkret verfügt DeepMinds MLP über etwa 300.000 Parameter, während KAN nur etwa 200 Parameter hat. KAN hat eine starke mathematische Grundlage wie MLP und basiert auf dem universellen Approximationssatz, während KAN auf dem Kolmogorov-Arnold-Darstellungssatz basiert. Wie in der folgenden Abbildung gezeigt, hat KAN

Das Grafikkarten-Erweiterungsdock Beelink EX verspricht keinen GPU-Leistungsverlust

Aug 11, 2024 pm 09:55 PM

Das Grafikkarten-Erweiterungsdock Beelink EX verspricht keinen GPU-Leistungsverlust

Aug 11, 2024 pm 09:55 PM

Eines der herausragenden Merkmale des kürzlich eingeführten Beelink GTi 14 ist, dass der Mini-PC über einen versteckten PCIe x8-Steckplatz an der Unterseite verfügt. Bei der Markteinführung gab das Unternehmen an, dass dies den Anschluss einer externen Grafikkarte an das System erleichtern würde. Beelink hat n

AMD FSR 3.1 eingeführt: Frame-Generierungsfunktion funktioniert auch auf Nvidia GeForce RTX- und Intel Arc-GPUs

Jun 29, 2024 am 06:57 AM

AMD FSR 3.1 eingeführt: Frame-Generierungsfunktion funktioniert auch auf Nvidia GeForce RTX- und Intel Arc-GPUs

Jun 29, 2024 am 06:57 AM

AMD löst sein ursprüngliches Versprechen vom 24. März ein und bringt FSR 3.1 im zweiten Quartal dieses Jahres auf den Markt. Was die Version 3.1 wirklich auszeichnet, ist die Entkopplung der Frame-Generierung von der Upscaling-Seite. Dadurch können Nvidia- und Intel-GPU-Besitzer den FSR 3 anwenden.

Das NVIDIA-Dialogmodell ChatQA wurde auf Version 2.0 weiterentwickelt, wobei die angegebene Kontextlänge 128 KB beträgt

Jul 26, 2024 am 08:40 AM

Das NVIDIA-Dialogmodell ChatQA wurde auf Version 2.0 weiterentwickelt, wobei die angegebene Kontextlänge 128 KB beträgt

Jul 26, 2024 am 08:40 AM

Die offene LLM-Community ist eine Ära, in der hundert Blumen blühen und konkurrieren. Sie können Llama-3-70B-Instruct, QWen2-72B-Instruct, Nemotron-4-340B-Instruct, Mixtral-8x22BInstruct-v0.1 und viele andere sehen hervorragende Darsteller. Allerdings weisen offene Modelle im Vergleich zu den proprietären Großmodellen GPT-4-Turbo in vielen Bereichen noch erhebliche Lücken auf. Zusätzlich zu allgemeinen Modellen wurden einige offene Modelle entwickelt, die sich auf Schlüsselbereiche spezialisieren, wie etwa DeepSeek-Coder-V2 für Programmierung und Mathematik und InternVL für visuelle Sprachaufgaben.

„AI Factory' wird die Neugestaltung des gesamten Software-Stacks vorantreiben, und NVIDIA stellt Llama3-NIM-Container für die Bereitstellung durch Benutzer bereit

Jun 08, 2024 pm 07:25 PM

„AI Factory' wird die Neugestaltung des gesamten Software-Stacks vorantreiben, und NVIDIA stellt Llama3-NIM-Container für die Bereitstellung durch Benutzer bereit

Jun 08, 2024 pm 07:25 PM

Laut Nachrichten dieser Website vom 2. Juni stellte Huang Renxun bei der laufenden Keynote-Rede von Huang Renxun 2024 Taipei Computex vor, dass generative künstliche Intelligenz die Neugestaltung des gesamten Software-Stacks fördern wird, und demonstrierte seine cloudnativen Mikrodienste NIM (Nvidia Inference Microservices). . Nvidia glaubt, dass die „KI-Fabrik“ eine neue industrielle Revolution auslösen wird: Am Beispiel der von Microsoft vorangetriebenen Softwareindustrie glaubt Huang Renxun, dass generative künstliche Intelligenz deren Umgestaltung im gesamten Stack vorantreiben wird. Um die Bereitstellung von KI-Diensten durch Unternehmen jeder Größe zu erleichtern, hat NVIDIA im März dieses Jahres die cloudnativen Mikrodienste NIM (Nvidia Inference Microservices) eingeführt. NIM+ ist eine Suite cloudnativer Mikroservices, die darauf optimiert sind, die Markteinführungszeit zu verkürzen

Keine OpenAI-Daten erforderlich, schließen Sie sich der Liste der großen Codemodelle an! UIUC veröffentlicht StarCoder-15B-Instruct

Jun 13, 2024 pm 01:59 PM

Keine OpenAI-Daten erforderlich, schließen Sie sich der Liste der großen Codemodelle an! UIUC veröffentlicht StarCoder-15B-Instruct

Jun 13, 2024 pm 01:59 PM

An der Spitze der Softwaretechnologie kündigte die Gruppe von UIUC Zhang Lingming zusammen mit Forschern der BigCode-Organisation kürzlich das StarCoder2-15B-Instruct-Großcodemodell an. Diese innovative Errungenschaft erzielte einen bedeutenden Durchbruch bei Codegenerierungsaufgaben, übertraf erfolgreich CodeLlama-70B-Instruct und erreichte die Spitze der Codegenerierungsleistungsliste. Die Einzigartigkeit von StarCoder2-15B-Instruct liegt in seiner reinen Selbstausrichtungsstrategie. Der gesamte Trainingsprozess ist offen, transparent und völlig autonom und kontrollierbar. Das Modell generiert über StarCoder2-15B Tausende von Anweisungen als Reaktion auf die Feinabstimmung des StarCoder-15B-Basismodells, ohne auf teure manuelle Annotationen angewiesen zu sein.

Übertrifft DPO umfassend: Das Team von Chen Danqi schlug eine einfache Präferenzoptimierung (SimPO) vor und verfeinerte außerdem das stärkste 8B-Open-Source-Modell

Jun 01, 2024 pm 04:41 PM

Übertrifft DPO umfassend: Das Team von Chen Danqi schlug eine einfache Präferenzoptimierung (SimPO) vor und verfeinerte außerdem das stärkste 8B-Open-Source-Modell

Jun 01, 2024 pm 04:41 PM

Um große Sprachmodelle (LLMs) an menschlichen Werten und Absichten auszurichten, ist es wichtig, menschliches Feedback zu lernen, um sicherzustellen, dass sie nützlich, ehrlich und harmlos sind. Im Hinblick auf die Ausrichtung von LLM ist Reinforcement Learning basierend auf menschlichem Feedback (RLHF) eine wirksame Methode. Obwohl die Ergebnisse der RLHF-Methode ausgezeichnet sind, gibt es einige Herausforderungen bei der Optimierung. Dazu gehört das Training eines Belohnungsmodells und die anschließende Optimierung eines Richtlinienmodells, um diese Belohnung zu maximieren. Kürzlich haben einige Forscher einfachere Offline-Algorithmen untersucht, darunter die direkte Präferenzoptimierung (Direct Preference Optimization, DPO). DPO lernt das Richtlinienmodell direkt auf der Grundlage von Präferenzdaten, indem es die Belohnungsfunktion in RLHF parametrisiert, wodurch die Notwendigkeit eines expliziten Belohnungsmodells entfällt. Diese Methode ist einfach und stabil

Yolov10: Ausführliche Erklärung, Bereitstellung und Anwendung an einem Ort!

Jun 07, 2024 pm 12:05 PM

Yolov10: Ausführliche Erklärung, Bereitstellung und Anwendung an einem Ort!

Jun 07, 2024 pm 12:05 PM

1. Einleitung In den letzten Jahren haben sich YOLOs aufgrund ihres effektiven Gleichgewichts zwischen Rechenkosten und Erkennungsleistung zum vorherrschenden Paradigma im Bereich der Echtzeit-Objekterkennung entwickelt. Forscher haben das Architekturdesign, die Optimierungsziele, Datenerweiterungsstrategien usw. von YOLO untersucht und erhebliche Fortschritte erzielt. Gleichzeitig behindert die Verwendung von Non-Maximum Suppression (NMS) bei der Nachbearbeitung die End-to-End-Bereitstellung von YOLO und wirkt sich negativ auf die Inferenzlatenz aus. In YOLOs fehlt dem Design verschiedener Komponenten eine umfassende und gründliche Prüfung, was zu erheblicher Rechenredundanz führt und die Fähigkeiten des Modells einschränkt. Es bietet eine suboptimale Effizienz und ein relativ großes Potenzial zur Leistungsverbesserung. Ziel dieser Arbeit ist es, die Leistungseffizienzgrenze von YOLO sowohl in der Nachbearbeitung als auch in der Modellarchitektur weiter zu verbessern. zu diesem Zweck