Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Die Entwickler lachen verrückt! Das schockierende Leck von LLaMa löste einen Aufruhr bei der Ersetzung von ChatGPT aus, und der Open-Source-LLM-Bereich veränderte sich.

Die Entwickler lachen verrückt! Das schockierende Leck von LLaMa löste einen Aufruhr bei der Ersetzung von ChatGPT aus, und der Open-Source-LLM-Bereich veränderte sich.

Die Entwickler lachen verrückt! Das schockierende Leck von LLaMa löste einen Aufruhr bei der Ersetzung von ChatGPT aus, und der Open-Source-LLM-Bereich veränderte sich.

Wer hätte gedacht, dass ein unerwarteter LLaMA-Leak den größten Innovationsfunken im Bereich Open Source LLM entfachen würde.

Eine Reihe herausragender ChatGPT-Open-Source-Alternativen – „Alpaca Family“ – erschien dann auf umwerfende Weise.

Die Reibung zwischen Open Source und API-basierter Verbreitung ist einer der dringendsten Widersprüche im generativen KI-Ökosystem.

Im Text-zu-Bild-Bereich zeigt die Veröffentlichung von Stable Diffusion deutlich, dass Open Source ein praktikabler Verteilungsmechanismus für das zugrunde liegende Modell ist.

Dies ist jedoch im Bereich großer Sprachmodelle nicht der Fall. Die größten Durchbrüche in diesem Bereich, wie beispielsweise Modelle wie GPT-4, Claude und Cohere, sind nur über APIs verfügbar.

Open-Source-Alternativen zu diesen Modellen weisen nicht das gleiche Leistungsniveau auf, insbesondere was die Fähigkeit betrifft, menschlichen Anweisungen zu folgen. Ein unerwartetes Leck veränderte diese Situation jedoch völlig.

„Episches“ Leak von LLaMA

Vor einigen Wochen hat Meta AI das große Sprachmodell LLaMA auf den Markt gebracht.

LLaMA verfügt über verschiedene Versionen, darunter die Parameter 7B, 13B, 33B und 65B. Obwohl es kleiner als GPT-3 ist, kann es bei vielen Aufgaben mit der Leistung von GPT-3 mithalten.

LLaMA war zunächst kein Open Source, aber eine Woche nach seiner Veröffentlichung wurde das Modell plötzlich auf 4chan durchgesickert, was Tausende von Downloads auslöste.

Dieser Vorfall kann als „episches Leck“ bezeichnet werden, da er zu einer endlosen Quelle für Innovationen im Bereich großer Sprachmodelle geworden ist.

In nur wenigen Wochen ist die Innovation der darauf aufbauenden LLM-Agenten explodiert.

Alpaka, Vicuna, Koala, ChatLLaMA, FreedomGPT, ColossalChat... Lassen Sie uns noch einmal Revue passieren lassen, wie diese Explosion der „Alpaka-Familie“ entstand.

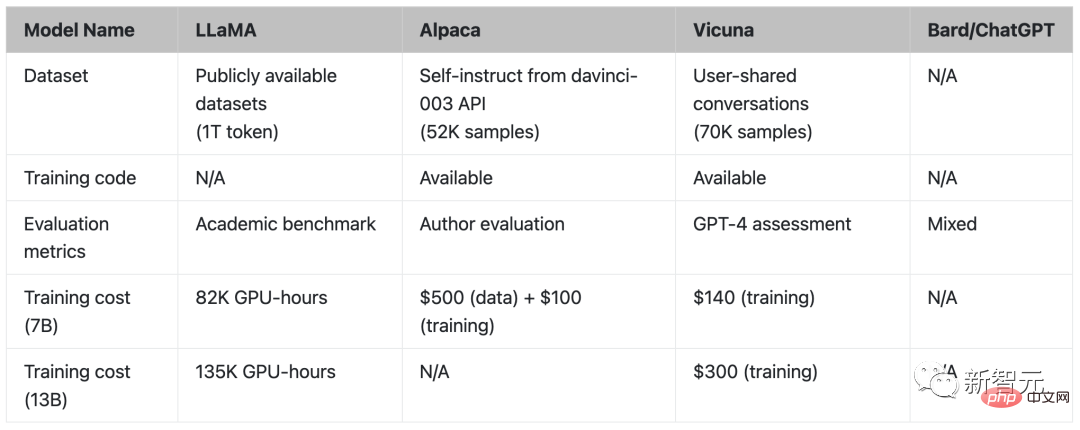

Alpaca Mitte März wurde das von Stanford herausgebrachte große Modell Alpaca populär.

Alpaca ist ein brandneues Modell, das von Metas LLaMA 7B verfeinert wurde. Es verwendet nur 52.000 Daten und seine Leistung entspricht ungefähr GPT-3.5.

Der Schlüssel ist, dass die Schulungskosten extrem niedrig sind, weniger als 600 US-Dollar.

Stanford-Forscher verglichen GPT-3.5 (text-davinci-003) und Alpaca 7B und stellten fest, dass die Leistung der beiden Modelle sehr ähnlich ist. Alpaca gewinnt 90 zu 89 Mal gegen GPT-3.5.

Wenn das Stanford-Team innerhalb des Budgets ein qualitativ hochwertiges Instruktionsfolgemodell trainieren möchte, muss es sich zwei wichtigen Herausforderungen stellen: ein leistungsstarkes vorab trainiertes Sprachmodell und ein qualitativ hochwertiges Instruktionsmodell, das den Daten folgt .

Genau, das LLaMA-Modell, das akademischen Forschern zur Verfügung gestellt wurde, löste das erste Problem.

Für die zweite Herausforderung gab der Artikel „Selbstunterricht: Sprachmodell mit selbst generierten Anweisungen ausrichten“ eine gute Inspiration, nämlich die Verwendung vorhandener starker Sprachmodelle zur automatischen Generierung von Unterrichtsdaten.

Die größte Schwäche des LLaMA-Modells ist die fehlende Feinabstimmung der Anleitung. Eine der größten Innovationen von OpenAI ist die Verwendung der Befehlsoptimierung auf GPT-3.

In diesem Zusammenhang nutzte Stanford ein vorhandenes großes Sprachmodell, um automatisch Demonstrationen der folgenden Anweisungen zu generieren.

Alpaka wird von Internetnutzern direkt als „stabile Verbreitung großer Textmodelle“ angesehen.

Vicuna Ende März stellten Forscher der UC Berkeley, der Carnegie Mellon University, der Stanford University und der UC San Diego Vicuna als Open-Source-Lösung zur Verfügung, eine fein abgestimmte Version von LLaMA, die der Leistung von GPT-4 entspricht.

Der 13-Milliarden-Parameter Vicuna wird durch die Feinabstimmung von LLaMA anhand der von ShareGPT gesammelten Benutzerkonversationen trainiert. Die Schulungskosten betragen fast 300 US-Dollar.

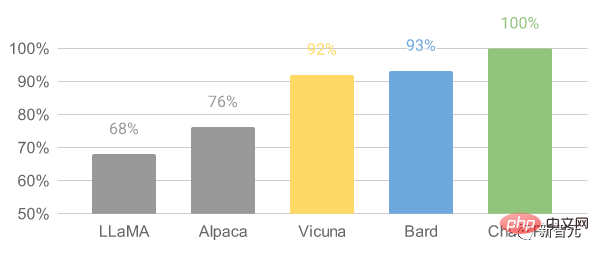

Die Ergebnisse zeigen, dass Vicuna-13B in mehr als 90 % der Fälle vergleichbare Fähigkeiten wie ChatGPT und Bard erreicht.

Für den Vicuna-13B-Trainingsprozess lauten die Details wie folgt:

Zunächst sammelten die Forscher etwa 70.000 Gespräche von der ChatGPT-Konversationsaustausch-Website ShareGPT.

Als nächstes optimierten die Forscher das von Alpaca bereitgestellte Trainingsskript, damit das Modell mehrere Gesprächsrunden und lange Sequenzen besser bewältigen kann. Anschließend wurde PyTorch FSDP für einen Trainingstag auf 8 A100-GPUs verwendet.

Im Hinblick auf die Bewertung der Modellqualität erstellten die Forscher 80 verschiedene Fragen und bewerteten die Modellausgabe mithilfe von GPT-4.

Um die verschiedenen Modelle zu vergleichen, kombinierten die Forscher die Ausgabe jedes Modells in einer einzigen Eingabeaufforderung und ließen dann GPT-4 bewerten, welches Modell die bessere Antwort lieferte (gut).

Vergleich von LLaMA, Alpaka, Vicuna und ChatGPT# 🎜🎜#

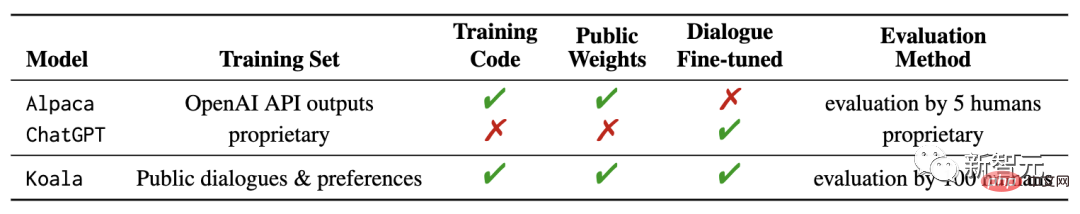

KoalaKürzlich hat das UC Berkeley AI Research Institute (BAIR) ein neues Modell „Koala“ (Koala) veröffentlicht, das OpenAI-GPT-Daten verwendet wird zur Feinabstimmung des Unterrichts verwendet. Das Besondere an Koala ist, dass es hochwertige Daten aus dem Netzwerk für das Training verwendet.

Forschungsergebnisse zeigen, dass Koala eine Vielzahl von Benutzeranfragen effektiv beantworten kann und Antworten generiert, die tendenziell beliebter sind als Alpaka, und zwar in mindestens der Hälfte der Fälle im Vergleich zu ChatGPT Der Effekt ist vergleichbar.

Die Forscher hoffen, dass die Ergebnisse dieses Experiments die Diskussion über die relative Leistung großer Closed-Source-Modelle im Vergleich zu kleinen öffentlichen Modellen vorantreiben können, insbesondere da die Ergebnisse dies zeigen Für diese kleinen Modelle, die lokal ausgeführt werden können, kann die Leistung großer Modelle erreicht werden, wenn die Trainingsdaten sorgfältig gesammelt werden.

Tatsächlich verwendete das zuvor von der Stanford University veröffentlichte Alpaca-Modell die LLaMA-Daten basierend auf dem GPT-Modell von OpenAI. Experimentelle Ergebnisse mit Feinabstimmung haben gezeigt, dass die richtigen Daten kleinere Open-Source-Modelle deutlich verbessern können.

Dies ist auch die ursprüngliche Absicht der Berkeley-Forscher, das Koala-Modell zu entwickeln und zu veröffentlichen, in der Hoffnung, einen weiteren experimentellen Beweis für die Ergebnisse dieser Diskussion zu liefern.

Koala optimiert kostenlose Interaktionsdaten aus dem Internet und legt besonderen Wert auf die Einbeziehung von Daten, die mit leistungsstarken Closed-Source-Modellen wie ChatGPT interagieren.

Anstatt so viele Webdaten wie möglich zu crawlen, um das Datenvolumen zu maximieren, konzentrierten sich die Forscher auf die Sammlung eines kleinen hochwertigen Datensatzes, einschließlich ChatGPT-destillierter Open-Source-Daten Daten usw. Nebuly verfügt über ChatLLaMA als Open-Source-Lösung, ein Framework, mit dem wir Gesprächsassistenten mithilfe unserer eigenen Daten erstellen können.

Mit ChatLLaMA können wir hyperpersonalisierte ChatGPT-ähnliche Assistenten erstellen, die unsere eigenen Daten und so wenig Rechenaufwand wie möglich verwenden.

Vorausgesetzt, dass wir uns in Zukunft nicht mehr auf einen großen Assistenten verlassen, der „alle regiert“, kann jeder seine eigene personalisierte Version des ChatGPT-Assistenten erstellen, und sie kann verschiedene menschliche Bedürfnisse unterstützen.

Die Erstellung eines solchen personalisierten Assistenten erfordert jedoch Anstrengungen an vielen Fronten: Erstellung von Datensätzen, effizientes Training mit RLHF und Inferenzoptimierung.

Der Zweck dieser Bibliothek besteht darin, Entwicklern Sicherheit zu geben, indem sie die Arbeit abstrahiert, die zum Optimieren und Sammeln großer Datenmengen erforderlich ist.

ChatLLaMA wurde entwickelt, um Entwicklern bei der Bewältigung einer Vielzahl von Anwendungsfällen zu helfen, die alle mit RLHF-Training und optimierter Inferenz zusammenhängen. Hier sind einige Referenzen zu Anwendungsfällen:

Erstellen Sie einen ChatGPT-ähnlichen personalisierten Assistenten für branchenspezifische Aufgaben (Recht, Medizin, Spiele, akademische Forschung usw.). );# 🎜🎜#

Sie möchten begrenzte Daten zur lokalen Hardware-Infrastruktur nutzen, um einen effizienten ChatGPT-ähnlichen Assistenten zu trainieren; 🎜#Ich möchte meine eigene personalisierte Version des ChatGPT-Assistenten erstellen und gleichzeitig außer Kontrolle geratene Kosten vermeiden;

- Ich möchte wissen, welche Modellarchitektur (LLaMA, OPT, GPTJ usw.) ist am besten für meine Anforderungen in Bezug auf Hardware, Computerbudget und Leistung geeignet , Marke und Manifest.

- FreedomGPT

- FreedomGPT wurde mit Electron und React erstellt. Es handelt sich um eine Desktop-Anwendung, mit der Benutzer lokal ausführen können Maschine Führen Sie LLaMA aus.

- Die einzigartige Funktion von FreedomGPT ist schon aus dem Namen ersichtlich – die Fragen, die es beantwortet, unterliegen keiner Zensur oder Sicherheitsfilterung.

- Diese App wurde von der KI-Risikokapitalgesellschaft Age of AI entwickelt.

FreedomGPT basiert auf Alpaka. FreedomGPT nutzt die charakteristischen Merkmale von Alpaca, da Alpaca relativ einfacher zugänglich und anpassbar ist als andere Modelle.

ChatGPT folgt den Nutzungsrichtlinien von OpenAI und schränkt Hass, Selbstverletzung, Drohungen, Gewalt und sexuelle Inhalte ein.

Im Gegensatz zu ChatGPT beantwortet FreedomGPT Fragen ohne Voreingenommenheit oder Bevorzugung und zögert nicht, kontroverse oder kontroverse Themen zu beantworten.

FreedomGPT antwortete sogar „Wie man zu Hause eine Bombe baut“, was OpenAI ausdrücklich aus GPT-4 entfernt hat.

FreedomGPT ist einzigartig, weil es Zensurbeschränkungen überwindet und kontroverse Themen ohne Garantien behandelt. Ihr Symbol ist die Freiheitsstatue, denn dieses einzigartige und kühne große Sprachmodell symbolisiert Freiheit.

FreedomGPT kann sogar lokal auf Ihrem Computer ausgeführt werden, ohne dass eine Internetverbindung erforderlich ist.

Darüber hinaus wird in Kürze eine Open-Source-Version veröffentlicht, die es Benutzern und Organisationen ermöglicht, sie vollständig anzupassen.

ColossalChat

ColossalChat, vorgeschlagen von UC Berkeley, benötigt nur weniger als 10 Milliarden Parameter, um zweisprachige Funktionen in Chinesisch und Englisch zu erreichen, und der Effekt entspricht ChatGPT und GPT-3.5.

Darüber hinaus reproduziert ColossalChat, basierend auf dem LLaMA-Modell, auch den vollständigen RLHF-Prozess, der derzeit das Open-Source-Projekt ist, das der ursprünglichen technischen Route von ChatGPT am nächsten kommt.

Zweisprachiger Chinesisch-Englisch-Trainingsdatensatz

ColossalChat hat einen zweisprachigen Datensatz veröffentlicht, der etwa 100.000 chinesische und englische Frage-Antwort-Paare enthält.

Dieser Datensatz wird aus echten Problemszenarien auf Social-Media-Plattformen gesammelt und als Seed-Datensatz bereinigt, mithilfe von Self-Instruct erweitert. Die Annotationskosten betragen etwa 900 US-Dollar.

Im Vergleich zu Datensätzen, die mit anderen Selbstlernmethoden generiert wurden, enthält dieser Datensatz realistischere und vielfältigere Startdaten, die ein breiteres Themenspektrum abdecken.

Dieser Datensatz eignet sich zur Feinabstimmung und zum RLHF-Training. ColossalChat kann bei der Bereitstellung hochwertiger Daten eine bessere Konversationsinteraktion erreichen und unterstützt auch Chinesisch.

Vollständige RLHF-Pipeline

Es gibt drei Stufen für die Algorithmusreplikation von RLHF:

In RLHF-Stufe1 wird der obige zweisprachige Datensatz für die Feinabstimmung überwachter Anweisungen verwendet das Modell.

In RLHF-Stage2 wird das Belohnungsmodell trainiert, indem verschiedene Ausgaben derselben Eingabeaufforderung manuell in eine Rangfolge gebracht werden, um entsprechende Bewertungen zuzuweisen, und dann das Training des Belohnungsmodells überwacht wird.

In RLHF-Stage3 wird der Reinforcement-Learning-Algorithmus verwendet, der den komplexesten Teil des Trainingsprozesses darstellt.

Ich glaube, dass bald weitere Projekte veröffentlicht werden.

Niemand hätte erwartet, dass dieser unerwartete Leak von LLaMA tatsächlich den größten Innovationsfunken im Bereich Open-Source-LLM entfachen würde.

Das obige ist der detaillierte Inhalt vonDie Entwickler lachen verrückt! Das schockierende Leck von LLaMa löste einen Aufruhr bei der Ersetzung von ChatGPT aus, und der Open-Source-LLM-Bereich veränderte sich.. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1376

1376

52

52

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Stellen Sie sich ein Modell der künstlichen Intelligenz vor, das nicht nur die Fähigkeit besitzt, die traditionelle Datenverarbeitung zu übertreffen, sondern auch eine effizientere Leistung zu geringeren Kosten erzielt. Dies ist keine Science-Fiction, DeepSeek-V2[1], das weltweit leistungsstärkste Open-Source-MoE-Modell, ist da. DeepSeek-V2 ist ein leistungsstarkes MoE-Sprachmodell (Mix of Experts) mit den Merkmalen eines wirtschaftlichen Trainings und einer effizienten Inferenz. Es besteht aus 236B Parametern, von denen 21B zur Aktivierung jedes Markers verwendet werden. Im Vergleich zu DeepSeek67B bietet DeepSeek-V2 eine stärkere Leistung, spart gleichzeitig 42,5 % der Trainingskosten, reduziert den KV-Cache um 93,3 % und erhöht den maximalen Generierungsdurchsatz auf das 5,76-fache. DeepSeek ist ein Unternehmen, das sich mit allgemeiner künstlicher Intelligenz beschäftigt

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas tritt offiziell in die Ära der Elektroroboter ein! Gestern hat sich der hydraulische Atlas einfach „unter Tränen“ von der Bühne der Geschichte zurückgezogen. Heute gab Boston Dynamics bekannt, dass der elektrische Atlas im Einsatz ist. Es scheint, dass Boston Dynamics im Bereich kommerzieller humanoider Roboter entschlossen ist, mit Tesla zu konkurrieren. Nach der Veröffentlichung des neuen Videos wurde es innerhalb von nur zehn Stunden bereits von mehr als einer Million Menschen angesehen. Die alten Leute gehen und neue Rollen entstehen. Das ist eine historische Notwendigkeit. Es besteht kein Zweifel, dass dieses Jahr das explosive Jahr der humanoiden Roboter ist. Netizens kommentierten: Die Weiterentwicklung der Roboter hat dazu geführt, dass die diesjährige Eröffnungsfeier wie Menschen aussieht, und der Freiheitsgrad ist weitaus größer als der von Menschen. Aber ist das wirklich kein Horrorfilm? Zu Beginn des Videos liegt Atlas ruhig auf dem Boden, scheinbar auf dem Rücken. Was folgt, ist atemberaubend

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

Anfang dieses Monats schlugen Forscher des MIT und anderer Institutionen eine vielversprechende Alternative zu MLP vor – KAN. KAN übertrifft MLP in Bezug auf Genauigkeit und Interpretierbarkeit. Und es kann MLP, das mit einer größeren Anzahl von Parametern ausgeführt wird, mit einer sehr kleinen Anzahl von Parametern übertreffen. Beispielsweise gaben die Autoren an, dass sie KAN nutzten, um die Ergebnisse von DeepMind mit einem kleineren Netzwerk und einem höheren Automatisierungsgrad zu reproduzieren. Konkret verfügt DeepMinds MLP über etwa 300.000 Parameter, während KAN nur etwa 200 Parameter hat. KAN hat eine starke mathematische Grundlage wie MLP und basiert auf dem universellen Approximationssatz, während KAN auf dem Kolmogorov-Arnold-Darstellungssatz basiert. Wie in der folgenden Abbildung gezeigt, hat KAN

KI untergräbt die mathematische Forschung! Der Gewinner der Fields-Medaille und der chinesisch-amerikanische Mathematiker führten 11 hochrangige Arbeiten an | Gefällt mir bei Terence Tao

Apr 09, 2024 am 11:52 AM

KI untergräbt die mathematische Forschung! Der Gewinner der Fields-Medaille und der chinesisch-amerikanische Mathematiker führten 11 hochrangige Arbeiten an | Gefällt mir bei Terence Tao

Apr 09, 2024 am 11:52 AM

KI verändert tatsächlich die Mathematik. Vor kurzem hat Tao Zhexuan, der diesem Thema große Aufmerksamkeit gewidmet hat, die neueste Ausgabe des „Bulletin of the American Mathematical Society“ (Bulletin der American Mathematical Society) weitergeleitet. Zum Thema „Werden Maschinen die Mathematik verändern?“ äußerten viele Mathematiker ihre Meinung. Der gesamte Prozess war voller Funken, knallhart und aufregend. Der Autor verfügt über eine starke Besetzung, darunter der Fields-Medaillengewinner Akshay Venkatesh, der chinesische Mathematiker Zheng Lejun, der NYU-Informatiker Ernest Davis und viele andere bekannte Wissenschaftler der Branche. Die Welt der KI hat sich dramatisch verändert. Viele dieser Artikel wurden vor einem Jahr eingereicht.

Google ist begeistert: JAX-Leistung übertrifft Pytorch und TensorFlow! Es könnte die schnellste Wahl für das GPU-Inferenztraining werden

Apr 01, 2024 pm 07:46 PM

Google ist begeistert: JAX-Leistung übertrifft Pytorch und TensorFlow! Es könnte die schnellste Wahl für das GPU-Inferenztraining werden

Apr 01, 2024 pm 07:46 PM

Die von Google geförderte Leistung von JAX hat in jüngsten Benchmark-Tests die von Pytorch und TensorFlow übertroffen und belegt bei 7 Indikatoren den ersten Platz. Und der Test wurde nicht auf der TPU mit der besten JAX-Leistung durchgeführt. Obwohl unter Entwicklern Pytorch immer noch beliebter ist als Tensorflow. Aber in Zukunft werden möglicherweise mehr große Modelle auf Basis der JAX-Plattform trainiert und ausgeführt. Modelle Kürzlich hat das Keras-Team drei Backends (TensorFlow, JAX, PyTorch) mit der nativen PyTorch-Implementierung und Keras2 mit TensorFlow verglichen. Zunächst wählen sie eine Reihe von Mainstream-Inhalten aus

Empfohlen: Ausgezeichnetes JS-Open-Source-Projekt zur Gesichtserkennung und -erkennung

Apr 03, 2024 am 11:55 AM

Empfohlen: Ausgezeichnetes JS-Open-Source-Projekt zur Gesichtserkennung und -erkennung

Apr 03, 2024 am 11:55 AM

Die Technologie zur Gesichtserkennung und -erkennung ist bereits eine relativ ausgereifte und weit verbreitete Technologie. Derzeit ist JS die am weitesten verbreitete Internetanwendungssprache. Die Implementierung der Gesichtserkennung und -erkennung im Web-Frontend hat im Vergleich zur Back-End-Gesichtserkennung Vor- und Nachteile. Zu den Vorteilen gehören die Reduzierung der Netzwerkinteraktion und die Echtzeiterkennung, was die Wartezeit des Benutzers erheblich verkürzt und das Benutzererlebnis verbessert. Die Nachteile sind: Es ist durch die Größe des Modells begrenzt und auch die Genauigkeit ist begrenzt. Wie implementiert man mit js die Gesichtserkennung im Web? Um die Gesichtserkennung im Web zu implementieren, müssen Sie mit verwandten Programmiersprachen und -technologien wie JavaScript, HTML, CSS, WebRTC usw. vertraut sein. Gleichzeitig müssen Sie auch relevante Technologien für Computer Vision und künstliche Intelligenz beherrschen. Dies ist aufgrund des Designs der Webseite erwähnenswert

Das multimodale Dokumentenverständnis-Großmodell Alibaba 7B gewinnt neue SOTA

Apr 02, 2024 am 11:31 AM

Das multimodale Dokumentenverständnis-Großmodell Alibaba 7B gewinnt neue SOTA

Apr 02, 2024 am 11:31 AM

Neues SOTA für multimodale Dokumentverständnisfunktionen! Das Alibaba mPLUG-Team hat die neueste Open-Source-Arbeit mPLUG-DocOwl1.5 veröffentlicht, die eine Reihe von Lösungen zur Bewältigung der vier großen Herausforderungen der hochauflösenden Bildtexterkennung, des allgemeinen Verständnisses der Dokumentstruktur, der Befolgung von Anweisungen und der Einführung externen Wissens vorschlägt. Schauen wir uns ohne weitere Umschweife zunächst die Auswirkungen an. Ein-Klick-Erkennung und Konvertierung von Diagrammen mit komplexen Strukturen in das Markdown-Format: Es stehen Diagramme verschiedener Stile zur Verfügung: Auch eine detailliertere Texterkennung und -positionierung ist einfach zu handhaben: Auch ausführliche Erläuterungen zum Dokumentverständnis können gegeben werden: Sie wissen schon, „Document Understanding“. " ist derzeit ein wichtiges Szenario für die Implementierung großer Sprachmodelle. Es gibt viele Produkte auf dem Markt, die das Lesen von Dokumenten unterstützen. Einige von ihnen verwenden hauptsächlich OCR-Systeme zur Texterkennung und arbeiten mit LLM zur Textverarbeitung zusammen.

Tesla-Roboter arbeiten in Fabriken, Musk: Der Freiheitsgrad der Hände wird dieses Jahr 22 erreichen!

May 06, 2024 pm 04:13 PM

Tesla-Roboter arbeiten in Fabriken, Musk: Der Freiheitsgrad der Hände wird dieses Jahr 22 erreichen!

May 06, 2024 pm 04:13 PM

Das neueste Video von Teslas Roboter Optimus ist veröffentlicht und er kann bereits in der Fabrik arbeiten. Bei normaler Geschwindigkeit sortiert es Batterien (Teslas 4680-Batterien) so: Der Beamte hat auch veröffentlicht, wie es bei 20-facher Geschwindigkeit aussieht – auf einer kleinen „Workstation“, pflücken und pflücken und pflücken: Dieses Mal wird es freigegeben. Eines der Highlights Der Vorteil des Videos besteht darin, dass Optimus diese Arbeit in der Fabrik völlig autonom und ohne menschliches Eingreifen während des gesamten Prozesses erledigt. Und aus Sicht von Optimus kann es auch die krumme Batterie aufnehmen und platzieren, wobei der Schwerpunkt auf der automatischen Fehlerkorrektur liegt: In Bezug auf die Hand von Optimus gab der NVIDIA-Wissenschaftler Jim Fan eine hohe Bewertung ab: Die Hand von Optimus ist der fünffingrige Roboter der Welt am geschicktesten. Seine Hände sind nicht nur taktil