Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Das Hinzufügen von Spezialeffekten erfordert nur einen Satz oder ein Bild. Die Firma Stable Diffusion hat AIGC genutzt, um neue Tricks zu spielen.

Das Hinzufügen von Spezialeffekten erfordert nur einen Satz oder ein Bild. Die Firma Stable Diffusion hat AIGC genutzt, um neue Tricks zu spielen.

Das Hinzufügen von Spezialeffekten erfordert nur einen Satz oder ein Bild. Die Firma Stable Diffusion hat AIGC genutzt, um neue Tricks zu spielen.

Ich glaube, viele Menschen haben den Charme der generativen KI-Technologie bereits verstanden, insbesondere nachdem sie den AIGC-Ausbruch im Jahr 2022 erlebt haben. Die von Stable Diffusion repräsentierte Text-zu-Bild-Generierungstechnologie war einst auf der ganzen Welt beliebt, und unzählige Benutzer strömten herbei, um ihre künstlerische Fantasie mithilfe von KI auszudrücken ...

# 🎜🎜# Im Vergleich zur Bildbearbeitung ist die Videobearbeitung ein anspruchsvolleres Thema. Sie erfordert die Synthese neuer Aktionen und nicht nur die Änderung des visuellen Erscheinungsbilds. Außerdem muss die zeitliche Konsistenz gewahrt bleiben.

Es gibt auch viele Unternehmen, die diesen Weg erkunden. Vor einiger Zeit hat Google Dreamix veröffentlicht, um das textbedingte Videodiffusionsmodell (VDM) auf die Videobearbeitung anzuwenden.

Kürzlich hat Runway, ein Unternehmen, das an der Entwicklung von Stable Diffusion beteiligt war, ein neues künstliches Intelligenzmodell „Gen-1“ auf den Markt gebracht, das durch die Anwendung von Texteingabeaufforderungen spezifiziert wird oder Referenzbilder Konvertieren Sie vorhandene Videos in neue Videos in jedem Stil.

Papierlink: https://arxiv.org /pdf/2302.03011.pdf

Projekthomepage: https://research.runwayml.com/gen1#🎜 🎜#

Im Jahr 2021 arbeitete Runway mit Forschern der Universität München zusammen, um die erste Version von Stable Diffusion zu entwickeln. Dann sprang Stability AI, ein britisches Startup, ein, um die Rechenkosten zu finanzieren, die zum Trainieren des Modells auf mehr Daten erforderlich waren. Im Jahr 2022 bringt Stability AI Stable Diffusion in den Mainstream und verwandelt es von einem Forschungsprojekt in ein globales Phänomen.Runway hofft, dass Gen-1 für Videos das tun kann, was Stable Diffusion für Bilder getan hat. „Wir haben eine Explosion von Modellen zur Bilderzeugung erlebt“, sagte Cristóbal Valenzuela, CEO und Mitbegründer von Runway. „Ich bin fest davon überzeugt, dass 2023 das Jahr des Videos sein wird.“ 1. Stilisierung. Übertragen Sie den Stil eines beliebigen Bildes oder einer Eingabeaufforderung auf jedes Bild Ihres Videos.

2. Storyboard. Verwandeln Sie Ihr Modell in ein vollständig stilisiertes und animiertes Rendering.

3. Isolieren Sie Themen in Videos und ändern Sie sie mithilfe einfacher Textansagen.

4. Verwandeln Sie texturloses Rendering in eine fotorealistische Ausgabe, indem Sie Eingabebilder oder Eingabeaufforderungen anwenden.

5. Nutzen Sie die volle Leistung von Gen-1, indem Sie Ihr Modell anpassen, um Ergebnisse mit höherer Wiedergabetreue zu erzielen.

In einer auf der offiziellen Website des Unternehmens veröffentlichten Demo wird gezeigt, wie Gen-1 den Videostil sanft verändern kann. Schauen wir uns einige Beispiele an.

Um beispielsweise „Menschen auf der Straße“ in „Tonpuppen“ zu verwandeln, benötigen Sie nur eine Eingabeaufforderungszeile:

# 🎜🎜##🎜 🎜#

Oder verwandeln Sie „auf dem Tisch gestapelte Bücher“ in „Stadtbild bei Nacht“:

#🎜🎜 ## 🎜🎜#

Von „Laufen auf dem Schnee“ bis „Laufen auf dem Mond“: #🎜 🎜##🎜 🎜#

# 🎜🎜##🎜🎜 #

Papierdetails

Visuelle Effekte und Videobearbeitung sind in der zeitgenössischen Medienlandschaft allgegenwärtig. Da videozentrierte Plattformen immer beliebter werden, steigt der Bedarf an intuitiveren und leistungsfähigeren Videobearbeitungstools. Aufgrund der zeitlichen Natur von Videodaten ist die Bearbeitung in diesem Format jedoch immer noch komplex und zeitaufwändig. Hochmoderne Modelle des maschinellen Lernens sind vielversprechend für die Verbesserung des Bearbeitungsprozesses, doch viele Methoden müssen ein Gleichgewicht zwischen zeitlicher Konsistenz und räumlichen Details finden. Generative Methoden zur Bildsynthese haben in letzter Zeit aufgrund der Einführung von Diffusionsmodellen, die auf der Bühne großer Datensätze trainiert wurden, einen rasanten Anstieg an Qualität und Popularität erfahren. Einige textbedingte Modelle wie DALL-E 2 und Stable Diffusion ermöglichen es unerfahrenen Benutzern, detaillierte Bilder mit nur einer Textaufforderung zu generieren. Latente Diffusionsmodelle bieten effiziente Methoden zur Erzeugung von Bildern durch Komposition in einem wahrnehmungsmäßig komprimierten Raum.

In diesem Artikel schlagen die Forscher ein kontrollierbares struktur- und inhaltsbewusstes Videodiffusionsmodell für nicht untertitelte Videos und gepaartes Training auf großen Datensätzen von Text-Bild-Daten vor . Wir haben uns für die Verwendung einer monokularen Tiefenschätzung entschieden, um die Struktur und Einbettungen darzustellen, die von einem vorab trainierten neuronalen Netzwerk zur Darstellung von Inhalten vorhergesagt wurden.

Diese Methode bietet mehrere leistungsstarke Steuerungsmodi während des Generierungsprozesses: Erstens trainierten die Forscher das Modell, ähnlich wie beim Bildsynthesemodell, um den abgeleiteten Videoinhalt, z Das Aussehen oder der Stil entspricht dem vom Benutzer bereitgestellten Bild oder Text (Abbildung 1). Zweitens wandten die Forscher, inspiriert durch den Diffusionsprozess, einen Informationsmaskierungsprozess auf die Strukturdarstellung an, um auswählen zu können, wie gut das Modell eine bestimmte Struktur unterstützt. Abschließend optimieren wir den Inferenzprozess durch eine benutzerdefinierte Leitmethode, die von klassifizierungsfreier Anleitung inspiriert ist, um die Kontrolle über die zeitliche Konsistenz der generierten Segmente zu erreichen.

Insgesamt sind die Highlights dieser Studie wie folgt: Die zeitliche Schicht wird in das Bildmodell eingeführt und gemeinsam auf Bildern und Videos trainiert, wodurch das latente Diffusionsmodell erweitert wird der Bereich der Videogenerierung;

schlägt ein Struktur- und Inhaltsbewusstsein vor. Ein Modell, das das Video unter Anleitung von Beispielbildern oder Texten modifiziert. Die Bearbeitung erfolgt vollständig innerhalb der Inferenzzeit und erfordert keine zusätzliche Schulung oder Vorverarbeitung für jedes Video. Diese Studie ist die erste, die zeigt, dass gemeinsames Training an Bild- und Videodaten die Inferenzzeit zur Kontrolle der zeitlichen Konsistenz ermöglicht. Für strukturelle Konsistenz können Sie durch Training auf verschiedenen Detailebenen in der Darstellung die gewünschten Einstellungen während der Inferenz auswählen beliebter als mehrere andere Methoden; Videos zu bestimmten Themen.

- Methode Für Recherchezwecke wäre es hilfreich, ein Video sowohl inhaltlich als auch strukturell zu betrachten. Mit Struktur meinen wir hier Merkmale, die seine Geometrie und Dynamik beschreiben, wie etwa die Form und Position seiner Körper sowie deren zeitliche Veränderungen. Bei Inhalten handelt es sich hier um Merkmale, die das Erscheinungsbild und die Semantik eines Videos beschreiben, beispielsweise die Farbe und den Stil von Objekten sowie die Beleuchtung der Szene. Das Ziel des Gen-1-Modells besteht darin, den Inhalt eines Videos zu bearbeiten und dabei seine Struktur beizubehalten.

- Um dieses Ziel zu erreichen, lernte der Forscher ein generatives Modell p (x|s, c) für Video x, dessen Bedingung die strukturelle Darstellung (dargestellt durch s) und ist Inhaltsdarstellung (gekennzeichnet mit c). Sie leiten die Formdarstellung s aus dem Eingabevideo ab und ändern sie basierend auf der Textaufforderung c, die die Bearbeitung beschreibt. Zunächst wird die Implementierung des generativen Modells als bedingtes latentes Videodiffusionsmodell beschrieben, und dann wird die Wahl der Form- und Inhaltsdarstellungen beschrieben. Abschließend wird der Optimierungsprozess des Modells diskutiert.

- Die Modellstruktur ist in Abbildung 2 dargestellt.

-

Experiment

Um die Methode zu evaluieren, nutzten die Forscher DAVIS-Videos und verschiedene Materialien. Um die Bearbeitungsaufforderung automatisch zu erstellen, führten die Forscher zunächst ein Untertitelmodell aus, um eine Beschreibung des ursprünglichen Videoinhalts zu erhalten, und verwendeten dann GPT-3, um die Bearbeitungsaufforderung zu generieren.

Qualitative Studie

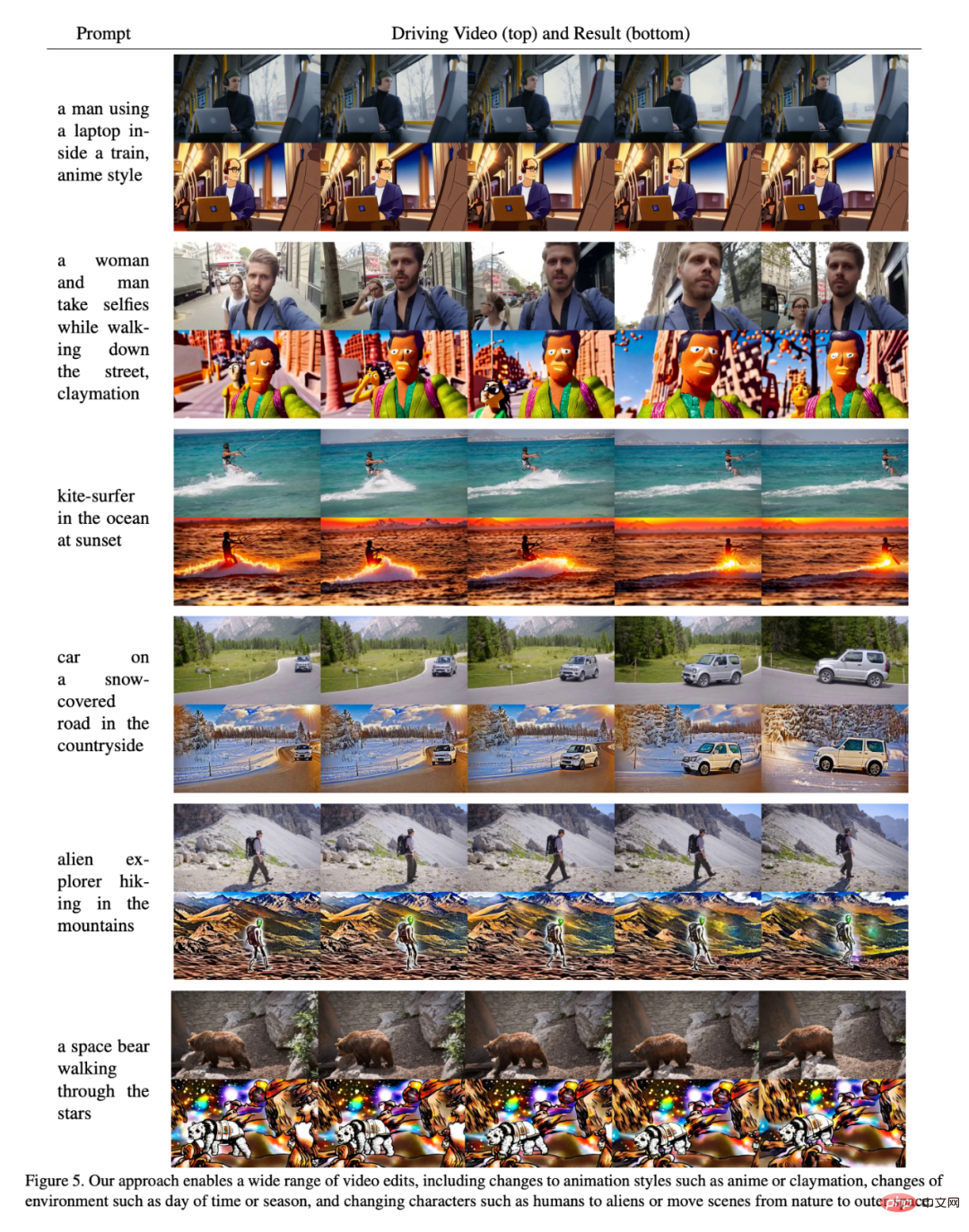

Wie in Abbildung 5 gezeigt, beweisen die Ergebnisse, dass die Methode in diesem Artikel bei einigen verschiedenen Eingaben gut funktioniert. Die Forscher führten außerdem eine Benutzerstudie mit Amazon Mechanical Turk (AMT) an einem Bewertungssatz von 35 repräsentativen Videobearbeitungsaufforderungen durch. Für jede Stichprobe wurden 5 Annotatoren gebeten, die Genauigkeit der Videobearbeitungsaufforderungen zwischen der Basismethode und unserer Methode zu vergleichen („Welches Video stellt die bereitgestellten bearbeiteten Untertitel besser dar?“) und dann nach dem Zufallsprinzip nacheinander präsentiert, wobei die Mehrheitsentscheidung zur endgültigen Entscheidung herangezogen wurde Ergebnis. Die Ergebnisse sind in Abbildung 7 dargestellt: Quantitative Bewertung. Die Leistung des Modells in diesem Artikel übertrifft in beiden Aspekten tendenziell das Basismodell (d. h. sie ist in der oberen rechten Ecke der Abbildung höher). Die Forscher stellten außerdem fest, dass es einen leichten Kompromiss bei der Erhöhung des Intensitätsparameters im Basismodell gibt: Eine größere Intensitätsskalierung bedeutet eine höhere Prompt-Konsistenz auf Kosten einer geringeren Frame-Konsistenz. Sie beobachteten auch, dass eine zunehmende strukturelle Skalierung zu einer höheren Eingabeaufforderungskonsistenz führt, da der Inhalt nicht mehr durch die Eingabestruktur bestimmt wird.

Anpassung

AnpassungAbbildung 10 zeigt ein Beispiel mit unterschiedlicher Anzahl an Anpassungsschritten und unterschiedlichen Ebenen struktureller Abhängigkeiten. Die Forscher stellten fest, dass die Anpassung die Treue zum Stil und Erscheinungsbild des Charakters erhöht, sodass trotz der Verwendung gesteuerter Videos von Charakteren mit unterschiedlichen Eigenschaften in Kombination mit höheren ts-Werten präzise Animationseffekte erzielt werden können.

Das obige ist der detaillierte Inhalt vonDas Hinzufügen von Spezialeffekten erfordert nur einen Satz oder ein Bild. Die Firma Stable Diffusion hat AIGC genutzt, um neue Tricks zu spielen.. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1382

1382

52

52

So löschen Sie den Verlauf der letzten Desktop-Hintergrundbilder in Windows 11

Apr 14, 2023 pm 01:37 PM

So löschen Sie den Verlauf der letzten Desktop-Hintergrundbilder in Windows 11

Apr 14, 2023 pm 01:37 PM

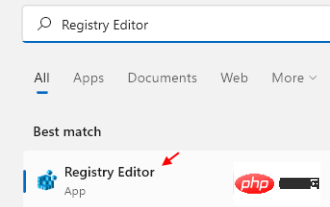

<p>Windows 11 verbessert die Personalisierung im System und ermöglicht es Benutzern, einen aktuellen Verlauf zuvor vorgenommener Desktop-Hintergrundänderungen anzuzeigen. Wenn Sie den Abschnitt „Personalisierung“ in der Anwendung „Windows-Systemeinstellungen“ aufrufen, werden Ihnen verschiedene Optionen angezeigt. Eine davon ist das Ändern des Hintergrundbilds. Aber jetzt ist es möglich, den neuesten Verlauf der auf Ihrem System eingestellten Hintergrundbilder anzuzeigen. Wenn Ihnen dies nicht gefällt und Sie den aktuellen Verlauf löschen oder löschen möchten, lesen Sie diesen Artikel weiter. Dort erfahren Sie mehr darüber, wie Sie dies mit dem Registrierungseditor tun. </p><h2>So verwenden Sie die Registrierungsbearbeitung

So laden Sie das Windows Spotlight-Hintergrundbild auf den PC herunter

Aug 23, 2023 pm 02:06 PM

So laden Sie das Windows Spotlight-Hintergrundbild auf den PC herunter

Aug 23, 2023 pm 02:06 PM

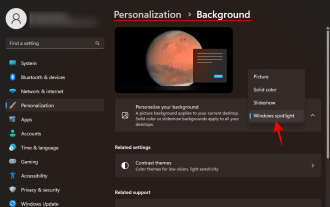

Bei Fenstern kommt die Ästhetik nie zu kurz. Von den idyllischen grünen Feldern von XP bis zum blauen, wirbelnden Design von Windows 11 erfreuen Standard-Desktop-Hintergründe seit Jahren die Benutzer. Mit Windows Spotlight haben Sie jetzt jeden Tag direkten Zugriff auf wunderschöne, beeindruckende Bilder für Ihren Sperrbildschirm und Ihr Desktop-Hintergrundbild. Leider bleiben diese Bilder nicht hängen. Wenn Sie sich in eines der Windows-Spotlight-Bilder verliebt haben, möchten Sie vielleicht wissen, wie Sie sie herunterladen können, damit Sie sie für eine Weile als Hintergrund behalten können. Hier finden Sie alles, was Sie wissen müssen. Was ist WindowsSpotlight? Window Spotlight ist ein automatischer Hintergrund-Updater, der unter Personalisierung > in der App „Einstellungen“ verfügbar ist

Wie verwende ich die Bildsemantiksegmentierungstechnologie in Python?

Jun 06, 2023 am 08:03 AM

Wie verwende ich die Bildsemantiksegmentierungstechnologie in Python?

Jun 06, 2023 am 08:03 AM

Mit der kontinuierlichen Weiterentwicklung der Technologie der künstlichen Intelligenz hat sich die Bildsemantiksegmentierungstechnologie zu einer beliebten Forschungsrichtung im Bereich der Bildanalyse entwickelt. Bei der semantischen Bildsegmentierung segmentieren wir verschiedene Bereiche in einem Bild und klassifizieren jeden Bereich, um ein umfassendes Verständnis des Bildes zu erreichen. Python ist eine bekannte Programmiersprache. Aufgrund seiner leistungsstarken Datenanalyse- und Datenvisualisierungsfähigkeiten ist es die erste Wahl auf dem Gebiet der Technologieforschung im Bereich der künstlichen Intelligenz. In diesem Artikel wird die Verwendung der Bildsemantiksegmentierungstechnologie in Python vorgestellt. 1. Vorkenntnisse werden vertieft

iOS 17: So verwenden Sie das Zuschneiden mit einem Klick in Fotos

Sep 20, 2023 pm 08:45 PM

iOS 17: So verwenden Sie das Zuschneiden mit einem Klick in Fotos

Sep 20, 2023 pm 08:45 PM

Mit der iOS 17-Fotos-App erleichtert Apple das Zuschneiden von Fotos nach Ihren Vorgaben. Lesen Sie weiter, um zu erfahren, wie. Bisher umfasste das Zuschneiden eines Bildes in der Fotos-App in iOS 16 mehrere Schritte: Tippen Sie auf die Bearbeitungsoberfläche, wählen Sie das Zuschneidewerkzeug aus und passen Sie dann den Zuschnitt mithilfe einer Pinch-to-Zoom-Geste oder durch Ziehen an den Ecken des Zuschneidewerkzeugs an. In iOS 17 hat Apple diesen Vorgang dankenswerterweise vereinfacht, sodass beim Vergrößern eines ausgewählten Fotos in Ihrer Fotobibliothek automatisch eine neue Schaltfläche „Zuschneiden“ in der oberen rechten Ecke des Bildschirms angezeigt wird. Wenn Sie darauf klicken, wird die vollständige Zuschneideoberfläche mit der Zoomstufe Ihrer Wahl angezeigt, sodass Sie den gewünschten Teil des Bildes zuschneiden, das Bild drehen, umkehren, das Bildschirmverhältnis anwenden oder Markierungen verwenden können

Verwenden Sie 2D-Bilder, um einen 3D-menschlichen Körper zu erstellen. Sie können jede Kleidung tragen und Ihre Bewegungen ändern.

Apr 11, 2023 pm 02:31 PM

Verwenden Sie 2D-Bilder, um einen 3D-menschlichen Körper zu erstellen. Sie können jede Kleidung tragen und Ihre Bewegungen ändern.

Apr 11, 2023 pm 02:31 PM

Dank der differenzierbaren Darstellung durch NeRF haben neuere generative 3D-Modelle beeindruckende Ergebnisse auf stationären Objekten erzielt. Allerdings stellt die 3D-Generierung in einer komplexeren und verformbareren Kategorie wie dem menschlichen Körper immer noch große Herausforderungen dar. In diesem Artikel wird eine effiziente kombinierte NeRF-Darstellung des menschlichen Körpers vorgeschlagen, die eine hochauflösende (512 x 256) 3D-Generierung des menschlichen Körpers ohne den Einsatz hochauflösender Modelle ermöglicht. EVA3D hat bestehende Lösungen bei vier umfangreichen Datensätzen zum menschlichen Körper deutlich übertroffen, und der Code ist Open Source. Papiername: EVA3D: Compositional 3D Human Generation from 2D image Collections Papieradresse: http

Neue Perspektive auf die Bilderzeugung: Diskussion NeRF-basierter Generalisierungsmethoden

Apr 09, 2023 pm 05:31 PM

Neue Perspektive auf die Bilderzeugung: Diskussion NeRF-basierter Generalisierungsmethoden

Apr 09, 2023 pm 05:31 PM

Die Erzeugung neuer perspektivischer Bilder (NVS) ist ein Anwendungsgebiet der Computer Vision. Im SuperBowl-Spiel von 1998 demonstrierte die RI NVS mit Multikamera-Stereovision (MVS). Damals wurde diese Technologie auf einen Sportfernsehsender übertragen Vereinigte Staaten, aber es wurde am Ende nicht kommerzialisiert; die britische BBC Broadcasting Company investierte in Forschung und Entwicklung dafür, aber es wurde nicht wirklich kommerzialisiert. Im Bereich des bildbasierten Renderings (IBR) gibt es einen Zweig der NVS-Anwendungen, nämlich das Tiefenbild-basierte Rendering (DBIR). Darüber hinaus musste das 3D-Fernsehen, das im Jahr 2010 sehr beliebt war, auch binokulare stereoskopische Effekte aus monokularen Videos erzielen, doch aufgrund der Unausgereiftheit der Technologie wurde es letztendlich nicht populär. Zu diesem Zeitpunkt begann man bereits mit der Erforschung von Methoden, die auf maschinellem Lernen basieren, wie z

So ändern Sie die Größe von Bildern stapelweise mit PowerToys unter Windows

Aug 23, 2023 pm 07:49 PM

So ändern Sie die Größe von Bildern stapelweise mit PowerToys unter Windows

Aug 23, 2023 pm 07:49 PM

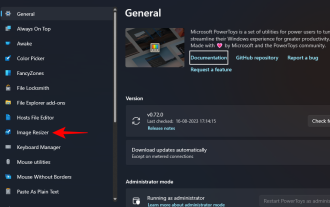

Wer täglich mit Bilddateien arbeitet, muss diese oft in der Größe anpassen, um sie an die Anforderungen seiner Projekte und Aufgaben anzupassen. Wenn Sie jedoch zu viele Bilder verarbeiten müssen, kann die Größenänderung einzelner Bilder viel Zeit und Mühe kosten. In diesem Fall kann ein Tool wie PowerToys nützlich sein, um unter anderem die Größe von Bilddateien mit dem Bild-Resizer-Dienstprogramm stapelweise zu ändern. Hier erfahren Sie, wie Sie Ihre Image Resizer-Einstellungen einrichten und mit PowerToys mit der Stapelgrößenänderung von Bildern beginnen. So ändern Sie die Größe von Bildern stapelweise mit PowerToys PowerToys ist ein All-in-One-Programm mit einer Vielzahl von Dienstprogrammen und Funktionen, die Ihnen helfen, Ihre täglichen Aufgaben zu beschleunigen. Eines seiner Dienstprogramme sind Bilder

Entfernen Sie Hautunreinheiten und Falten mit einem Klick: Detaillierte Interpretation des hochauflösenden Porträt-Hautschönheitsmodells ABPN der DAMO Academy

Apr 12, 2023 pm 12:25 PM

Entfernen Sie Hautunreinheiten und Falten mit einem Klick: Detaillierte Interpretation des hochauflösenden Porträt-Hautschönheitsmodells ABPN der DAMO Academy

Apr 12, 2023 pm 12:25 PM

Mit der rasanten Entwicklung der digitalen Kulturindustrie wird die Technologie der künstlichen Intelligenz zunehmend im Bereich der Bildbearbeitung und -verschönerung eingesetzt. Unter diesen ist die Hautverschönerung von Porträts zweifellos eine der am weitesten verbreiteten und gefragtesten Technologien. Herkömmliche Schönheitsalgorithmen nutzen filterbasierte Bildbearbeitungstechnologie, um automatisierte Hauterneuerungs- und Hautunreinheiten-Entfernungseffekte zu erzielen, und werden häufig in sozialen Netzwerken, Live-Übertragungen und anderen Szenarien eingesetzt. In der professionellen Fotobranche mit hohen Schwellenwerten sind manuelle Retuschierer jedoch aufgrund der hohen Anforderungen an Bildauflösung und Qualitätsstandards immer noch die wichtigste Produktionskraft bei der Schönheitsretusche von Porträts und erledigen Aufgaben wie Hautglättung, Entfernung von Hautunreinheiten, Aufhellung usw. Serie arbeiten. Normalerweise beträgt die durchschnittliche Bearbeitungszeit für die Hautverschönerung eines hochauflösenden Porträts durch einen professionellen Retuschierer 1-2 Minuten. In Bereichen wie Werbung, Film und Fernsehen, die eine höhere Präzision erfordern, ist dieser Vorgang erforderlich

Anpassung

Anpassung