Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Das neue Werk des Reinforcement-Learning-Guru Sergey Levine: Drei große Modelle bringen Robotern bei, ihren Weg zu erkennen

Das neue Werk des Reinforcement-Learning-Guru Sergey Levine: Drei große Modelle bringen Robotern bei, ihren Weg zu erkennen

Das neue Werk des Reinforcement-Learning-Guru Sergey Levine: Drei große Modelle bringen Robotern bei, ihren Weg zu erkennen

Ein Roboter mit einem großen eingebauten Modell hat gelernt, Sprachanweisungen zu befolgen, um sein Ziel zu erreichen, ohne auf eine Karte zu schauen. Diese Errungenschaft stammt aus der neuen Arbeit des Reinforcement-Learning-Gurus Sergey Levine.

Wie schwierig ist es, angesichts eines Ziels ohne Navigationsspuren erfolgreich anzukommen?

Diese Aufgabe ist auch für Menschen mit schlechtem Orientierungssinn eine große Herausforderung. Doch in einer aktuellen Studie „lernten“ mehrere Wissenschaftler den Roboter mit nur drei vorab trainierten Modellen.

Wir alle wissen, dass eine der zentralen Herausforderungen des Roboterlernens darin besteht, Roboter in die Lage zu versetzen, eine Vielzahl von Aufgaben gemäß anspruchsvollen menschlichen Anweisungen auszuführen. Dafür sind Roboter erforderlich, die menschliche Anweisungen verstehen können und über eine Vielzahl verschiedener Aktionen verfügen, um diese Anweisungen in der realen Welt auszuführen.

Für Anweisungen zur Verfolgung von Navigationsaufgaben konzentrierten sich frühere Arbeiten hauptsächlich auf das Lernen aus Flugbahnen, die mit Textanweisungen kommentiert wurden. Dies erleichtert möglicherweise das Verständnis von Textanweisungen, die Kosten für die Datenanmerkung haben jedoch eine weitverbreitete Verwendung dieser Technik verhindert. Andererseits haben neuere Arbeiten gezeigt, dass durch selbstüberwachtes Training zielkonditionierter Richtlinien eine robuste Navigation erlernt werden kann. Diese Methoden schulen visionsbasierte Controller an großen, unbeschrifteten Datensätzen durch Post-hoc-Neubeschriftung. Diese Methoden sind skalierbar, allgemein und robust, erfordern jedoch häufig die Verwendung umständlicher orts- oder bildbasierter Zielspezifikationsmechanismen.

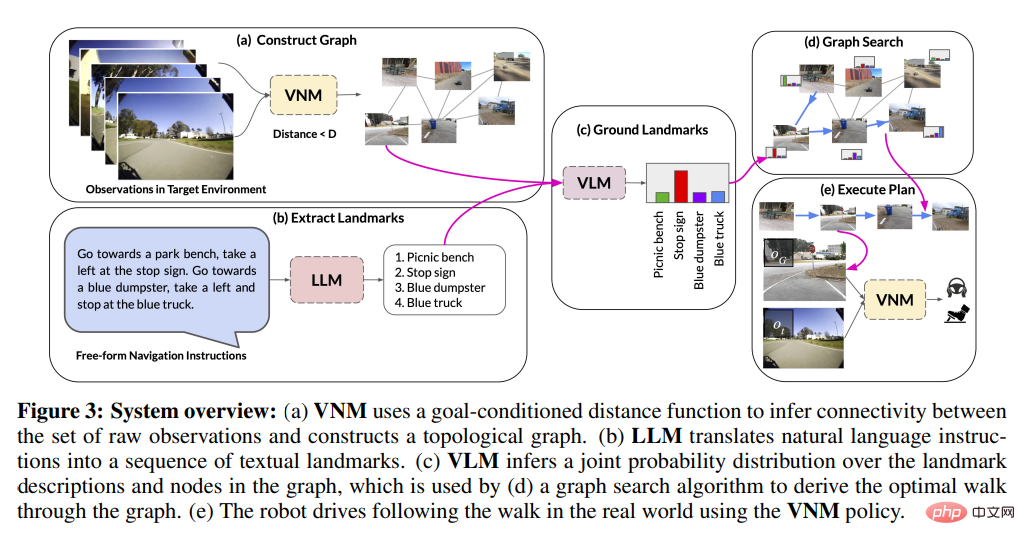

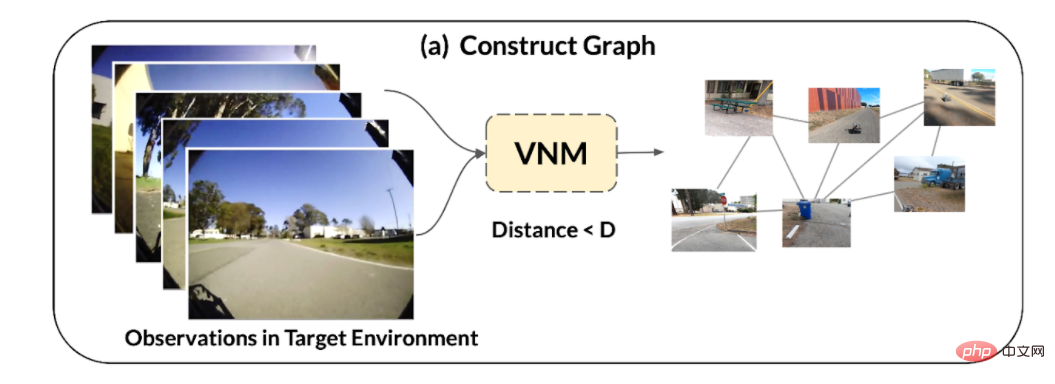

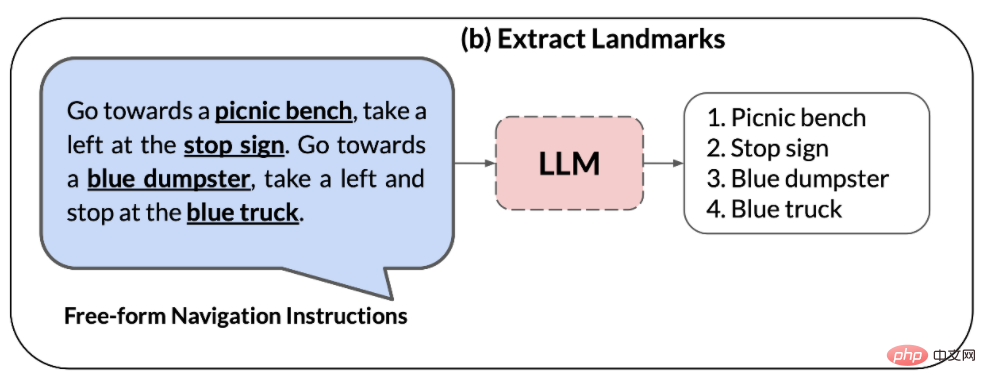

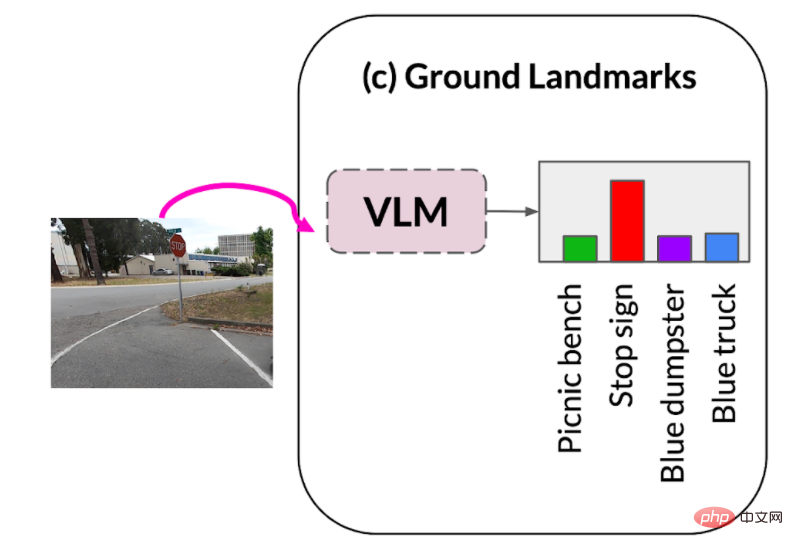

In einem aktuellen Artikel wollen Forscher der UC Berkeley, von Google und anderen Institutionen die Vorteile dieser beiden Methoden kombinieren, um mithilfe vorab trainierter Fähigkeiten ein selbstüberwachtes System für die Roboternavigation auf Navigationsdaten ohne Benutzeranmerkungen anwendbar zu machen des Modells, um Anweisungen in natürlicher Sprache auszuführen. Forscher nutzen diese Modelle, um eine „Schnittstelle“ zu bauen, die dem Roboter Aufgaben mitteilt. Dieses System nutzt die Generalisierungsfähigkeiten vorab trainierter Sprach- und Vision-Sprachmodelle, um es Robotersystemen zu ermöglichen, komplexe Anweisungen auf hoher Ebene zu akzeptieren. Der Forscher beobachtete: Schnittstellen können erstellt werden, indem handelsübliche, vorab trainierte Modelle genutzt werden, die auf großen Korpora visueller und sprachlicher Datensätze trainiert wurden, die weithin verfügbar sind und Zero-Shot-Generalisierungsfähigkeiten gezeigt haben, um eine spezifische Befehlsverfolgung zu ermöglichen. Um dies zu erreichen, kombinierten die Forscher die Vorteile von vorab trainierten Vision- und Sprachroboter-agnostischen Modellen sowie vorab trainierten Navigationsmodellen. Konkret verwendeten sie ein visuelles Navigationsmodell (VNM:ViNG), um die visuelle Ausgabe eines Roboters in eine topologische „mentale Karte“ der Umgebung umzuwandeln. Bei einer Freiform-Textanweisung wird ein vorab trainiertes großes Sprachmodell (LLM: GPT-3) verwendet, um die Anweisung in eine Reihe von Merkmalspunkten in Textform zu dekodieren. Anschließend wird ein visuelles Sprachmodell (VLM: CLIP) verwendet, um diese Textmerkmalspunkte in der topologischen Karte festzulegen, indem die gemeinsame Wahrscheinlichkeit von Merkmalspunkten und Knoten abgeleitet wird. Anschließend wird ein neuer Suchalgorithmus verwendet, um die probabilistische Zielfunktion zu maximieren und den Befehlspfad des Roboters zu finden, der dann vom VNM ausgeführt wird. Der Hauptbeitrag der Forschung ist die Navigationsmethode unter Großmodellen (LM Nav), ein spezifisches System zur Befehlsverfolgung. Es kombiniert drei große unabhängige vorab trainierte Modelle – ein selbstüberwachtes Robotersteuerungsmodell, das visuelle Beobachtungen und physische Aktionen nutzt (VNM), ein visuelles Sprachmodell, das Bilder in Text platziert, jedoch ohne konkrete Implementierungsumgebung (VLM), und ein großes Sprachmodell, das Text analysiert und übersetzt, aber keine visuelle Grundlage oder verkörperten Sinn (LLM) hat, um eine langfristige Befehlsverfolgung in komplexen realen Umgebungen zu ermöglichen. Zum ersten Mal instanziierten Forscher die Idee, vorab trainierte Seh- und Sprachmodelle mit zielbedingten Controllern zu kombinieren, um ohne Feinabstimmung umsetzbare Befehlspfade in der Zielumgebung abzuleiten. Bemerkenswert ist, dass alle drei Modelle auf großen Datensätzen trainiert werden, über selbstüberwachte Zielfunktionen verfügen und ohne Feinabstimmung sofort verwendet werden können – für das Training von LM Nav ist keine menschliche Annotation der Roboternavigationsdaten erforderlich.

-

Übersicht über das LM-Nav-Modell

Wie nutzen Forscher also vorab trainierte Bild- und Sprachmodelle, um Textschnittstellen für visuelle Navigationsmodelle bereitzustellen?

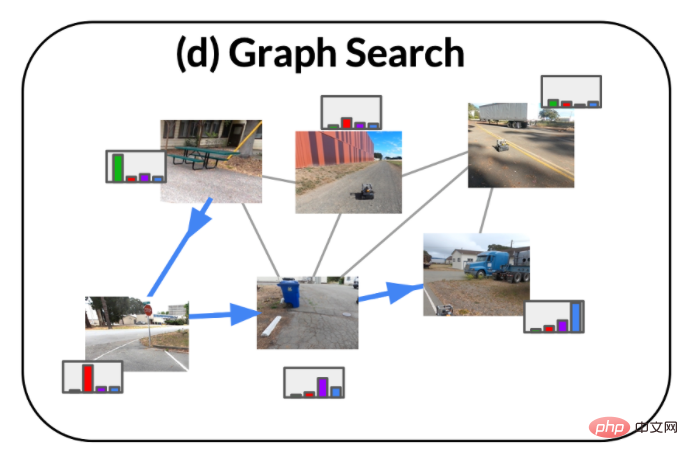

1. Bei einer Reihe von Beobachtungen in der Zielumgebung verwendet die zielbedingte Distanzfunktion, die Teil des visuellen Navigationsmodells (VNM) ist, um die Konnektivität zwischen ihnen abzuleiten und die Umgebungstopologie zu erstellen Diagramm der Konnektivität.

2. Das Large Language Model (LLM) wird verwendet, um Anweisungen in natürlicher Sprache in eine Reihe von Feature-Punkten zu zerlegen. Diese Feature-Punkte können als Zwischenziele für die Navigation verwendet werden.

3. Das Visual-Language Model (VLM) wird verwendet, um visuelle Beobachtungen basierend auf Feature-Point-Phrasen zu erstellen. Das visuelle Sprachmodell leitet eine gemeinsame Wahrscheinlichkeitsverteilung über die Merkmalspunktbeschreibungen und Bilder ab (die die Knoten in der obigen Grafik bilden).

4. Unter Verwendung der Wahrscheinlichkeitsverteilung von VLM und der von VNM abgeleiteten Graphenkonnektivität verwendet einen neuartigen Suchalgorithmus, um einen optimalen Befehlspfad in der Umgebung abzurufen, der (i) dem Original entspricht Anweisung, (ii) ist der kürzeste Weg im Diagramm, der das Ziel erreichen kann.

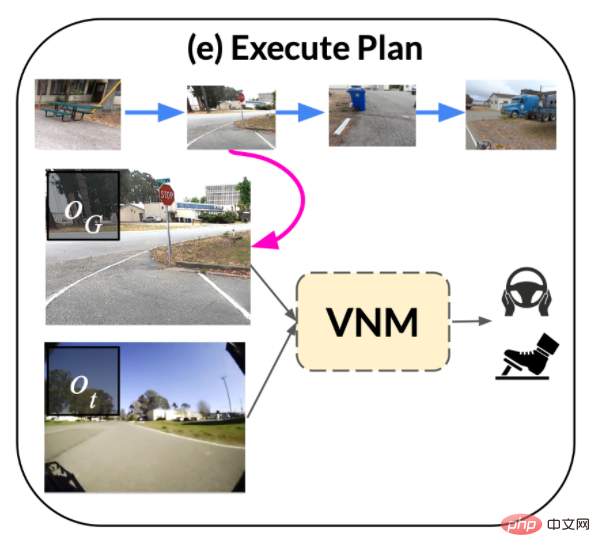

5. Dann Der Anweisungspfad wird von der Zielbedingungsrichtlinie ausgeführt, die Teil des VNM ist.

Experimentelle Ergebnisse

Qualitative Bewertung

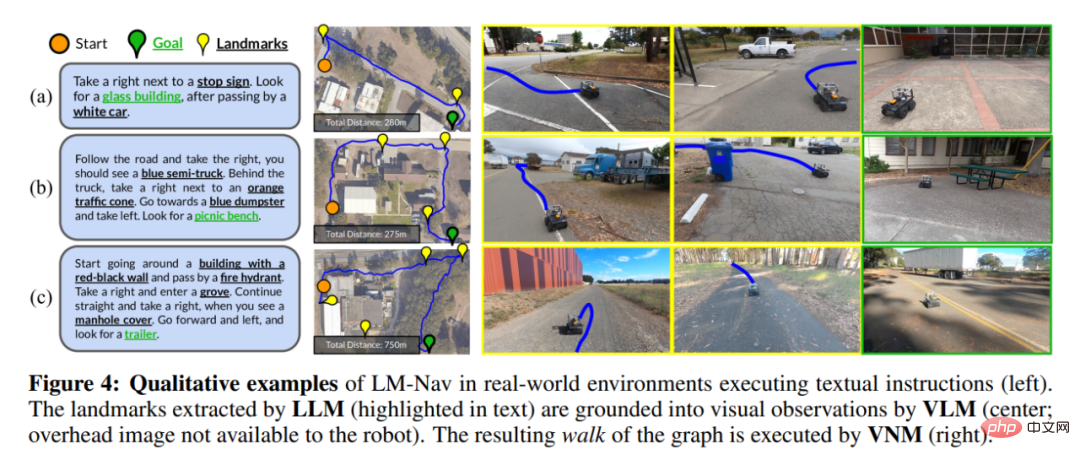

Abbildung 4 zeigt einige Beispiele für den vom Roboter zurückgelegten Weg (beachten Sie, dass der Roboter das Bild über dem Kopf und die räumliche Positionierung der Merkmalspunkte nicht erhalten kann). was gezeigt wird, ist nur ein visueller Effekt).

In Abbildung 4(a) ist LM-Nav in der Lage, einfache Feature-Punkte aus seinen vorherigen Durchquerungen erfolgreich zu lokalisieren und einen kurzen Weg zum Ziel zu finden. Obwohl es in der Umgebung mehrere Parkmerkmalspunkte gibt, ermöglicht die Zielfunktion in Gleichung 3 dem Roboter, den richtigen Parkmerkmalspunkt im Kontext auszuwählen, wodurch die Gesamtfahrstrecke minimiert wird.

Abbildung 4(b) verdeutlicht die Fähigkeit von LM-Nav, bestimmte Routen mit mehreren Feature-Punkten zu analysieren – auch wenn das direkte Erreichen des letzten Feature-Punkts die kürzeste Route ist, wenn der Anweisungspfad ignoriert wird, kann der Roboter dennoch einen A-Pfad finden besucht alle Feature-Punkte in der richtigen Reihenfolge.

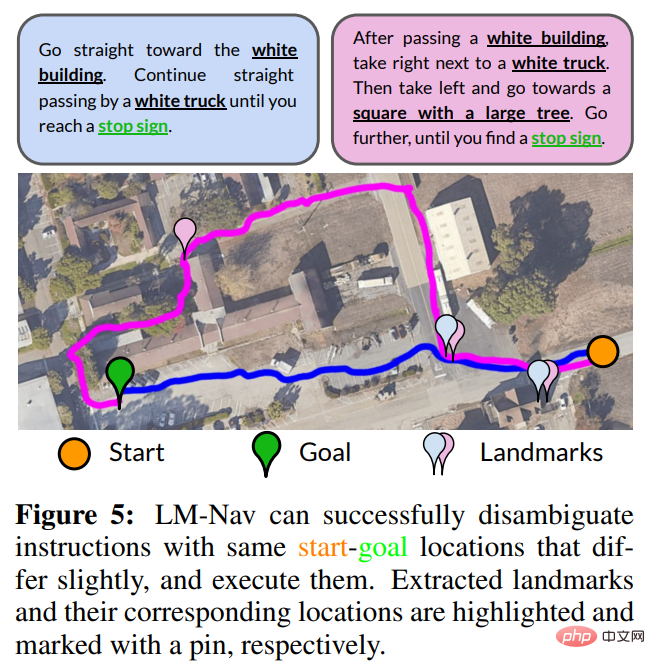

Verwenden Sie Direktiven zur Eindeutigkeit. Da das Ziel von LM Nav darin besteht, Anweisungen zu befolgen und nicht nur das Endziel zu erreichen, können unterschiedliche Anweisungen zu unterschiedlichen Durchquerungen führen. Abbildung 5 zeigt ein Beispiel, bei dem das Ändern von Anweisungen mehrere Pfade zu einem Ziel eindeutig machen kann. Für kürzere Eingabeaufforderungen (blau) bevorzugt LM Nav den direkteren Pfad. Wenn Sie eine detailliertere Route (Magenta) angeben, wählt LM Nav alternative Pfade durch verschiedene Sätze von Feature-Punkten.

Die Situation fehlender Feature-Punkte. Obwohl LM-Nav Feature-Punkte in Anweisungen effektiv analysieren, sie im Diagramm lokalisieren und den Weg zum Ziel finden kann, beruht dieser Prozess auf der Annahme, dass Feature-Punkte (i) in der realen Umgebung vorhanden sind und (ii) vorhanden sein können Von VLM anerkannt. Abbildung 4(c) zeigt eine Situation, in der der ausführbare Pfad einen der Feature-Punkte – einen Hydranten – nicht erreicht und einen Pfad um die Oberseite des Gebäudes statt um den Boden nimmt. Dieser Fehlerfall war darauf zurückzuführen, dass das VLM die Hydranten anhand der Beobachtungen des Roboters nicht erkennen konnte.

In einer unabhängigen Bewertung der Wirksamkeit von VLM beim Abrufen von Feature-Punkten stellten die Forscher fest, dass CLIP zwar das beste Standardmodell für diese Art von Aufgabe ist, eine kleine Anzahl „harter“ Feature-Punkte jedoch nicht abrufen kann , einschließlich Hydranten und Betonmischer. Aber in vielen realen Situationen kann der Roboter immer noch erfolgreich einen Weg finden, um die verbleibenden Feature-Punkte zu besuchen.

Quantitative Bewertung

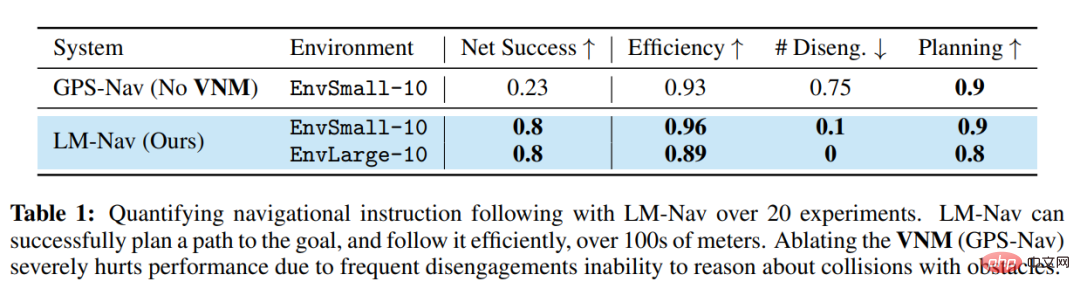

Tabelle 1 fasst die quantitative Leistung dieses Systems in 20 Anweisungen zusammen. In 85 % der Experimente war LM-Nav in der Lage, Anweisungen konsequent ohne Kollisionen oder Ablösungen zu befolgen (durchschnittlich ein Eingriff alle 6,4 Kilometer Fahrt). Im Vergleich zum Basismodell ohne Navigation schneidet LM-Nav durchweg besser bei der Ausführung effizienter, kollisionsfreier Zielpfade ab. Bei allen erfolglosen Experimenten kann der Fehler auf unzureichende Fähigkeiten in der Planungsphase zurückgeführt werden – die Unfähigkeit des Suchalgorithmus, bestimmte „harte“ Merkmalspunkte im Diagramm intuitiv zu lokalisieren – was zu einer unvollständigen Ausführung von Anweisungen führt. Eine Untersuchung dieser Fehlermodi ergab, dass der kritischste Teil des Systems die Fähigkeit des VLM ist, unbekannte Merkmalspunkte wie Hydranten und Szenen unter schwierigen Lichtverhältnissen wie unterbelichtete Bilder zu erkennen.

Das obige ist der detaillierte Inhalt vonDas neue Werk des Reinforcement-Learning-Guru Sergey Levine: Drei große Modelle bringen Robotern bei, ihren Weg zu erkennen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1376

1376

52

52

In diesem Artikel erfahren Sie mehr über SHAP: Modellerklärung für maschinelles Lernen

Jun 01, 2024 am 10:58 AM

In diesem Artikel erfahren Sie mehr über SHAP: Modellerklärung für maschinelles Lernen

Jun 01, 2024 am 10:58 AM

In den Bereichen maschinelles Lernen und Datenwissenschaft stand die Interpretierbarkeit von Modellen schon immer im Fokus von Forschern und Praktikern. Mit der weit verbreiteten Anwendung komplexer Modelle wie Deep Learning und Ensemble-Methoden ist das Verständnis des Entscheidungsprozesses des Modells besonders wichtig geworden. Explainable AI|XAI trägt dazu bei, Vertrauen in maschinelle Lernmodelle aufzubauen, indem es die Transparenz des Modells erhöht. Eine Verbesserung der Modelltransparenz kann durch Methoden wie den weit verbreiteten Einsatz mehrerer komplexer Modelle sowie der Entscheidungsprozesse zur Erläuterung der Modelle erreicht werden. Zu diesen Methoden gehören die Analyse der Merkmalsbedeutung, die Schätzung des Modellvorhersageintervalls, lokale Interpretierbarkeitsalgorithmen usw. Die Merkmalswichtigkeitsanalyse kann den Entscheidungsprozess des Modells erklären, indem sie den Grad des Einflusses des Modells auf die Eingabemerkmale bewertet. Schätzung des Modellvorhersageintervalls

Identifizieren Sie Über- und Unteranpassung anhand von Lernkurven

Apr 29, 2024 pm 06:50 PM

Identifizieren Sie Über- und Unteranpassung anhand von Lernkurven

Apr 29, 2024 pm 06:50 PM

In diesem Artikel wird vorgestellt, wie Überanpassung und Unteranpassung in Modellen für maschinelles Lernen mithilfe von Lernkurven effektiv identifiziert werden können. Unteranpassung und Überanpassung 1. Überanpassung Wenn ein Modell mit den Daten übertrainiert ist, sodass es daraus Rauschen lernt, spricht man von einer Überanpassung des Modells. Ein überangepasstes Modell lernt jedes Beispiel so perfekt, dass es ein unsichtbares/neues Beispiel falsch klassifiziert. Für ein überangepasstes Modell erhalten wir einen perfekten/nahezu perfekten Trainingssatzwert und einen schrecklichen Validierungssatz-/Testwert. Leicht geändert: „Ursache der Überanpassung: Verwenden Sie ein komplexes Modell, um ein einfaches Problem zu lösen und Rauschen aus den Daten zu extrahieren. Weil ein kleiner Datensatz als Trainingssatz möglicherweise nicht die korrekte Darstellung aller Daten darstellt. 2. Unteranpassung Heru.“

Die Entwicklung der künstlichen Intelligenz in der Weltraumforschung und der Siedlungstechnik

Apr 29, 2024 pm 03:25 PM

Die Entwicklung der künstlichen Intelligenz in der Weltraumforschung und der Siedlungstechnik

Apr 29, 2024 pm 03:25 PM

In den 1950er Jahren wurde die künstliche Intelligenz (KI) geboren. Damals entdeckten Forscher, dass Maschinen menschenähnliche Aufgaben wie das Denken ausführen können. Später, in den 1960er Jahren, finanzierte das US-Verteidigungsministerium künstliche Intelligenz und richtete Labore für die weitere Entwicklung ein. Forscher finden Anwendungen für künstliche Intelligenz in vielen Bereichen, etwa bei der Erforschung des Weltraums und beim Überleben in extremen Umgebungen. Unter Weltraumforschung versteht man die Erforschung des Universums, das das gesamte Universum außerhalb der Erde umfasst. Der Weltraum wird als extreme Umgebung eingestuft, da sich seine Bedingungen von denen auf der Erde unterscheiden. Um im Weltraum zu überleben, müssen viele Faktoren berücksichtigt und Vorkehrungen getroffen werden. Wissenschaftler und Forscher glauben, dass die Erforschung des Weltraums und das Verständnis des aktuellen Zustands aller Dinge dazu beitragen können, die Funktionsweise des Universums zu verstehen und sich auf mögliche Umweltkrisen vorzubereiten

Implementierung von Algorithmen für maschinelles Lernen in C++: Häufige Herausforderungen und Lösungen

Jun 03, 2024 pm 01:25 PM

Implementierung von Algorithmen für maschinelles Lernen in C++: Häufige Herausforderungen und Lösungen

Jun 03, 2024 pm 01:25 PM

Zu den häufigsten Herausforderungen, mit denen Algorithmen für maschinelles Lernen in C++ konfrontiert sind, gehören Speicherverwaltung, Multithreading, Leistungsoptimierung und Wartbarkeit. Zu den Lösungen gehören die Verwendung intelligenter Zeiger, moderner Threading-Bibliotheken, SIMD-Anweisungen und Bibliotheken von Drittanbietern sowie die Einhaltung von Codierungsstilrichtlinien und die Verwendung von Automatisierungstools. Praktische Fälle zeigen, wie man die Eigen-Bibliothek nutzt, um lineare Regressionsalgorithmen zu implementieren, den Speicher effektiv zu verwalten und leistungsstarke Matrixoperationen zu nutzen.

Wie kann KI Roboter autonomer und anpassungsfähiger machen?

Jun 03, 2024 pm 07:18 PM

Wie kann KI Roboter autonomer und anpassungsfähiger machen?

Jun 03, 2024 pm 07:18 PM

Im Bereich der industriellen Automatisierungstechnik gibt es zwei aktuelle Hotspots, die kaum zu ignorieren sind: Künstliche Intelligenz (KI) und Nvidia. Ändern Sie nicht die Bedeutung des ursprünglichen Inhalts, optimieren Sie den Inhalt, schreiben Sie den Inhalt neu, fahren Sie nicht fort: „Darüber hinaus sind beide eng miteinander verbunden, da Nvidia nicht auf seine ursprüngliche Grafikverarbeitungseinheit (GPU) beschränkt ist ) erweitert es seine GPU. Die Technologie erstreckt sich auf den Bereich der digitalen Zwillinge und ist eng mit neuen KI-Technologien verbunden. „Vor kurzem hat NVIDIA eine Zusammenarbeit mit vielen Industrieunternehmen geschlossen, darunter führende Industrieautomatisierungsunternehmen wie Aveva, Rockwell Automation und Siemens und Schneider Electric sowie Teradyne Robotics und seine Unternehmen MiR und Universal Robots. Kürzlich hat Nvidia gesammelt

Erklärbare KI: Erklären komplexer KI/ML-Modelle

Jun 03, 2024 pm 10:08 PM

Erklärbare KI: Erklären komplexer KI/ML-Modelle

Jun 03, 2024 pm 10:08 PM

Übersetzer |. Rezensiert von Li Rui |. Chonglou Modelle für künstliche Intelligenz (KI) und maschinelles Lernen (ML) werden heutzutage immer komplexer, und die von diesen Modellen erzeugten Ergebnisse sind eine Blackbox, die den Stakeholdern nicht erklärt werden kann. Explainable AI (XAI) zielt darauf ab, dieses Problem zu lösen, indem es Stakeholdern ermöglicht, die Funktionsweise dieser Modelle zu verstehen, sicherzustellen, dass sie verstehen, wie diese Modelle tatsächlich Entscheidungen treffen, und Transparenz in KI-Systemen, Vertrauen und Verantwortlichkeit zur Lösung dieses Problems gewährleistet. In diesem Artikel werden verschiedene Techniken der erklärbaren künstlichen Intelligenz (XAI) untersucht, um ihre zugrunde liegenden Prinzipien zu veranschaulichen. Mehrere Gründe, warum erklärbare KI von entscheidender Bedeutung ist. Vertrauen und Transparenz: Damit KI-Systeme allgemein akzeptiert und vertrauenswürdig sind, müssen Benutzer verstehen, wie Entscheidungen getroffen werden

Fünf Schulen des maschinellen Lernens, die Sie nicht kennen

Jun 05, 2024 pm 08:51 PM

Fünf Schulen des maschinellen Lernens, die Sie nicht kennen

Jun 05, 2024 pm 08:51 PM

Maschinelles Lernen ist ein wichtiger Zweig der künstlichen Intelligenz, der Computern die Möglichkeit gibt, aus Daten zu lernen und ihre Fähigkeiten zu verbessern, ohne explizit programmiert zu werden. Maschinelles Lernen hat ein breites Anwendungsspektrum in verschiedenen Bereichen, von der Bilderkennung und der Verarbeitung natürlicher Sprache bis hin zu Empfehlungssystemen und Betrugserkennung, und es verändert unsere Lebensweise. Im Bereich des maschinellen Lernens gibt es viele verschiedene Methoden und Theorien, von denen die fünf einflussreichsten Methoden als „Fünf Schulen des maschinellen Lernens“ bezeichnet werden. Die fünf Hauptschulen sind die symbolische Schule, die konnektionistische Schule, die evolutionäre Schule, die Bayes'sche Schule und die Analogieschule. 1. Der Symbolismus, auch Symbolismus genannt, betont die Verwendung von Symbolen zum logischen Denken und zum Ausdruck von Wissen. Diese Denkrichtung glaubt, dass Lernen ein Prozess der umgekehrten Schlussfolgerung durch das Vorhandene ist

Der Kehr- und Wischroboter Cloud Whale Xiaoyao 001 hat ein „Gehirn'! |. Erfahrung

Apr 26, 2024 pm 04:22 PM

Der Kehr- und Wischroboter Cloud Whale Xiaoyao 001 hat ein „Gehirn'! |. Erfahrung

Apr 26, 2024 pm 04:22 PM

Kehr- und Wischroboter gehören in den letzten Jahren zu den beliebtesten Smart-Home-Geräten bei Verbrauchern. Die damit verbundene Bequemlichkeit der Bedienung oder sogar die Notwendigkeit einer Bedienung ermöglicht es faulen Menschen, ihre Hände frei zu haben, was es den Verbrauchern ermöglicht, sich von der täglichen Hausarbeit zu „befreien“ und mehr Zeit mit den Dingen zu verbringen, die sie in getarnter Form genießen. Aufgrund dieser Begeisterung stellen fast alle Haushaltsgerätemarken auf dem Markt ihre eigenen Kehr- und Wischroboter her, was den gesamten Markt für Kehr- und Wischroboter sehr lebendig macht. Allerdings wird die schnelle Expansion des Marktes unweigerlich eine versteckte Gefahr mit sich bringen: Viele Hersteller werden die Taktik des Maschinenmeeres nutzen, um schnell mehr Marktanteile zu erobern, was zu vielen neuen Produkten ohne Upgrade-Punkte führen wird Es handelt sich um „Matroschka“-Modelle. Keine Übertreibung. Allerdings sind das nicht alle Kehr- und Wischroboter