Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Kann ein Sprachmodell mit 10 Milliarden Parametern nicht ausgeführt werden? Ein chinesischer Arzt vom MIT schlug die SmoothQuant-Quantifizierung vor, die den Speicherbedarf um die Hälfte reduzierte und die Geschwindigkeit um das 1,56-fache erhöhte!

Kann ein Sprachmodell mit 10 Milliarden Parametern nicht ausgeführt werden? Ein chinesischer Arzt vom MIT schlug die SmoothQuant-Quantifizierung vor, die den Speicherbedarf um die Hälfte reduzierte und die Geschwindigkeit um das 1,56-fache erhöhte!

Kann ein Sprachmodell mit 10 Milliarden Parametern nicht ausgeführt werden? Ein chinesischer Arzt vom MIT schlug die SmoothQuant-Quantifizierung vor, die den Speicherbedarf um die Hälfte reduzierte und die Geschwindigkeit um das 1,56-fache erhöhte!

Obwohl groß angelegte Sprachmodelle (LLM) eine starke Leistung aufweisen, kann die Anzahl der Parameter leicht Hunderte oder Hunderte von Milliarden erreichen, und der Bedarf an Computerausrüstung und Speicher ist so groß, dass sich normale Unternehmen dies nicht leisten können Es.

Quantisierung ist eine übliche Komprimierungsoperation, bei der die Genauigkeit von Modellgewichten (z. B. 32 Bit auf 8 Bit) reduziert wird, wodurch ein Teil der Leistung des Modells im Austausch für eine schnellere Inferenzgeschwindigkeit geopfert wird , weniger Speicherbedarf.

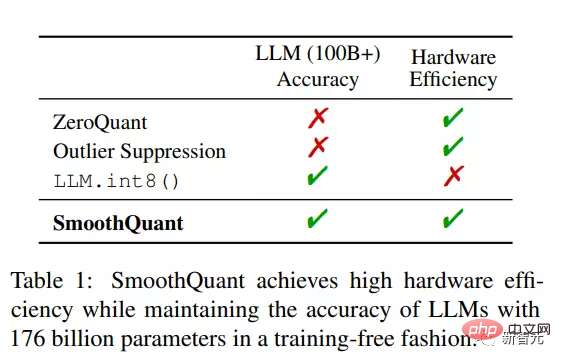

Aber bei LLMs mit mehr als 100 Milliarden Parametern können bestehende Komprimierungsmethoden weder die Genauigkeit des Modells aufrechterhalten noch können sie effizient auf Hardware laufen.

Kürzlich haben Forscher vom MIT und NVIDIA gemeinsam eine Allzweck-Post-Training-Quantisierungslösung (GPQ, General-Purpose Post-Training Quantization) SmoothQuant vorgeschlagen kann die Quantisierung mit 8-Bit-Gewichtung und 8-Bit-Aktivierung (W8A8) für große Sprachmodelle effizient implementieren und die Genauigkeit des Modells ohne Training aufrechterhalten.

Papierlink: https://arxiv.org/pdf/2211.10438.pdf#🎜 🎜#

Code-Link: https://github.com/mit-han-lab/smoothquant#🎜 🎜#

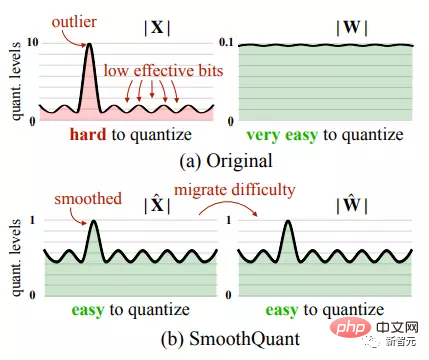

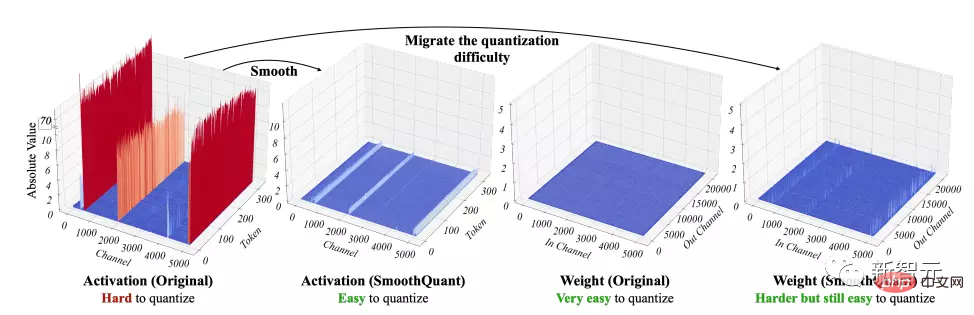

Da die Aktivierung schwieriger zu quantifizieren ist als die Gewichtung, migriert SmoothQuant die schwieriger zu quantifizierende Aktivierung durch mathematische Äquivalenttransformation in die Gewichtung und erreicht so eine reibungslose Verarbeitung von Aktivierungsausreißern.SmoothQuant ist in der Lage, Gewichtungen und Aktivierungen auf INT8 in verschiedenen Schichten aller LLMs, einschließlich OPT-175B, BLOOM-176B und GLM-130B, zu quantisieren.

Im Vergleich zu vorhandenen Methoden, die nur Gewichte quantisieren oder Aktivierungen mit gemischter Präzision quantisieren, weist

SmoothQuant eine höhere Hardwareeffizienz und Implementierung auf. Mit einer 1,56-fachen Beschleunigung ist der Speicher Die Anforderungen betragen nur die Hälfte des ursprünglichen LLM und es gibt fast keinen Verlust an Genauigkeit .

Dozent Song Han ist außerordentlicher Professor am MIT EECS. Sein Hauptforschungsschwerpunkt ist effizientes Deep Learning Technologie, die die Größe neuronaler Netze um eine Größenordnung reduzieren kann, ohne an Genauigkeit zu verlieren.

SmoothQuant

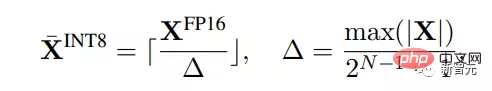

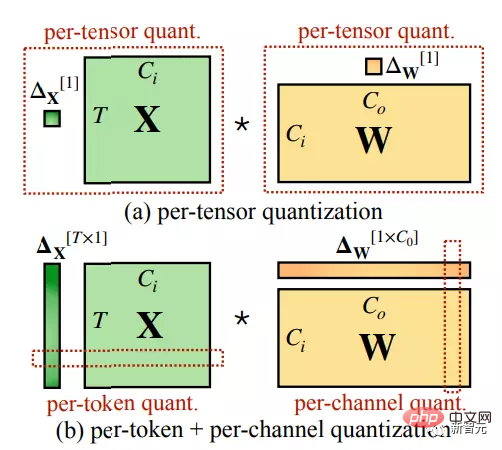

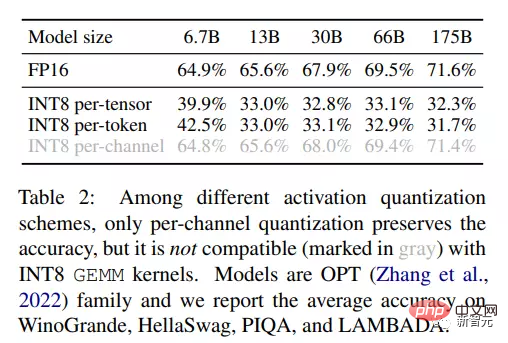

Quantisierung besteht darin, hochpräzise Werte diskreten Werten mit geringerer Präzision zuzuordnen, was in diesem Artikel untersucht wird Der Schwerpunkt lag hauptsächlich auf einer effizienteren ganzzahligen einheitlichen Quantisierung für Hardware, insbesondere INT8. Quantisierungsoperationen können mit unterschiedlicher Granularität durchgeführt werden, z. B. die Quantisierung pro Tensor wird auf die gesamte Gewichtsmatrix angewendet, die Quantisierung pro Token wird auf jeden Token bei der Aktivierung angewendet und die Quantisierung pro Kanal wird auf jeden Ausgabekanal der Gewichtung angewendet.

Durch Beobachtung der quantitativen Ergebnisse der Aktivierung erforschen Sie die Die Mitarbeiter fassten mehrere Muster zusammen:

Durch Beobachtung der quantitativen Ergebnisse der Aktivierung erforschen Sie die Die Mitarbeiter fassten mehrere Muster zusammen:

1. Quantifizierung ist schwieriger zu quantifizieren als Gewicht.

Die Gewichtsverteilung ist relativ gleichmäßiger und flacher. Frühere Forschungsergebnisse haben gezeigt, dass die Reduzierung des Gewichts großer Sprachmodelle auf INT8 oder sogar INT4 kaum Auswirkungen auf die Genauigkeit hat.

2 Ausreißer sind die Hauptschwierigkeit bei der Aktivierungsquantifizierung.

Ausreißer bei Aktivierungen sind normalerweise etwa 100-mal höher als normale Werte, was dazu führt, dass die Quantisierungsbits im Ausreißerkanal/-pegel sehr hoch sind ineffizient.

3. Es wird behoben, dass abnormale Werte in einem bestimmten Kanal angezeigt werden .

Ausreißer treten nur in einem kleinen Teil der Kanäle auf, aber wenn es einen Ausreißer in einem Kanal gibt, können diese Ausreißer in diesem erscheinen alle Token.

Die Varianz aller Kanäle in einem bestimmten Token wird groß sein (einige Kanäle werden sehr groß sein, aber die meisten klein), aber die Varianz eines gegebenen Kanals über alle Token-Grade wird klein sein (Ausreißerkanäle werden groß sein).

Da Ausreißer die Eigenschaften eines kontinuierlichen Auftretens und einer geringen Varianz innerhalb jedes Kanals aufweisen, ist der Quantisierungsfehler viel kleiner als pro Kanal, wenn bei Aktivierungen eine Quantisierung pro Kanal durchgeführt wird -Tensorquantisierung.

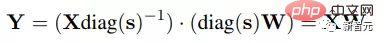

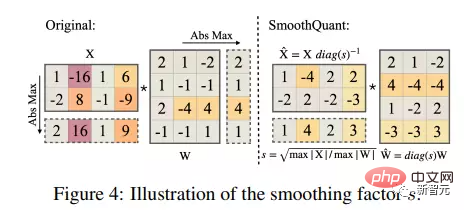

Durch ein einfaches Experiment bestätigten die Ergebnisse erneut die Idee des Forschers. Bei Quantisierung auf INT8 ist die Genauigkeit pro Kanal viel höher als pro Tensor und pro-. Bei der Token-Quantifizierung entspricht die Genauigkeit nahezu der FP16-Basislinie. Die Forscher glätteten die Eingangsaktivierung mithilfe eines Glättungsfaktors s pro Kanal. Um die mathematische Äquivalenz linearer Schichten aufrechtzuerhalten, müssen die Gewichte auch umgekehrt skaliert werden.

Da die Eingabe X normalerweise durch vorherige lineare Operationen (wie lineare Ebenen, Ebenennormen usw.) generiert wird. ), Daher kann der Glättungsfaktor problemlos offline in die Parameter der vorherigen Schicht integriert werden, ohne dass der Kernel-Aufruf-Overhead durch zusätzliche Skalierung entsteht. In anderen Fällen, beispielsweise wenn die Eingabe von der Residual-Addition stammt, kann dem Residual-Zweig eine zusätzliche Skalierung hinzugefügt werden.

Verschiebung der Quantifizierungsschwierigkeit von Aktivierung auf Gewicht

Verschiebung der Quantifizierungsschwierigkeit von Aktivierung auf Gewicht

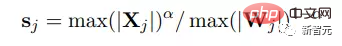

Smooths Ziel ist es, pro Kanal einen The auszuwählen Der Glättungsfaktor s erleichtert die Quantifizierung dieser Umkehroperation.

Um den Quantisierungsfehler zu reduzieren, sollten die effektiven Quantisierungsbits aller Kanäle erhöht werden. Wenn die maximale Größe aller Kanäle gleich ist, ist die Gesamtzahl der effektiven Quantisierungsbits am größten.

Daher ist einer der direktesten Glättungsfaktoren der Maximalwert jedes Kanals in der Eingabe, wodurch sichergestellt werden kann, dass nach der Teilung alle Aktivierungskanäle den gleichen Maximalwert haben, wodurch eine einfachere Quantifizierung erreicht wird.Es ist jedoch zu beachten, dass der Aktivierungsbereich dynamisch und für verschiedene Eingabebeispiele unterschiedlich ist. Daher verwendeten die Forscher Kalibrierungsproben aus dem Datensatz vor dem Training, um die Größe der Aktivierungskanäle abzuschätzen.

Da diese Formel alle Quantifizierungsschwierigkeiten auf die Gewichte überträgt, kann festgestellt werden, dass in diesem Fall der Quantisierungsfehler der Gewichte groß ist, was zu einer starken Verringerung der Genauigkeit führt.Andererseits können Sie auch alle Quantisierungsschwierigkeiten von Gewichten auf Aktivierungen verschieben, indem Sie sj = 1/ max(|Wj |) wählen. . Ebenso ist die Modellleistung aufgrund übermäßiger Aktivierungsquantisierungsfehler schlecht. Daher muss die Quantifizierungsschwierigkeit zwischen Gewichtungen und Aktivierungen aufgeteilt werden, damit beide leicht zu quantifizieren sind.

Die Forscher führten einen Hyperparameter der Übertragungsstärke α ein, um die Schwierigkeit der Übertragung von Aktivierungen auf Gewichte zu steuern.

Es kann festgestellt werden, dass für die meisten Modelle, wie z. B. OPT- und BLOOM-Modelle, α = 0,5 ein guter Gleichgewichtspunkt ist, der die Quantisierungsschwierigkeit gleichmäßig verteilen kann, insbesondere bei Verwendung desselben Quantisierers für Gewichte und Aktivierungen.

Diese Formel garantiert, dass die Gewichte und Aktivierungen entsprechender Kanäle ähnliche Maximalwerte haben und somit die gleiche Quantisierungsschwierigkeit aufweisen.

Für einige andere Modelle mit relativ großen Aktivierungsausreißern, wie z. B. GLM-130B mit 30 % Ausreißern, was für die Aktivierungsquantifizierung schwieriger ist, können Sie einen größeren α (z. B. 0,75) wählen, der viel größer ist der Quantifizierungsschwierigkeit wird auf Gewichte übertragen.

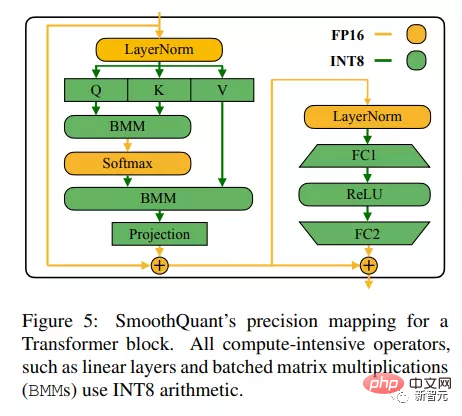

SmoothQuant wird auf den Transformer-Block angewendet.

Die lineare Ebene übernimmt die meisten Parameter und Berechnungen des LLM-Modells. Standardmäßig skaliert SmoothQuant die Eingabeaktivierungen aller linearen Schichten im Transformer und quantisiert die linearen Schichten mit W8A8, was die Quantisierung des BMM-Operators in der Aufmerksamkeitsberechnung ermöglicht.

In diesem Prozess wird INT8 zunächst verwendet, um die Eingaben und Gewichte rechenintensiver Operatoren wie BMM in der linearen Schicht und der Aufmerksamkeitsschicht zu quantifizieren, während die Operationen anderer leichter Elemente wie Softmax und LayerNorm beibehalten werden Durch Aktivierung wie FP16 trägt ein solches Design dazu bei, Genauigkeit und Inferenzeffizienz in Einklang zu bringen.

Experimenteller Teil

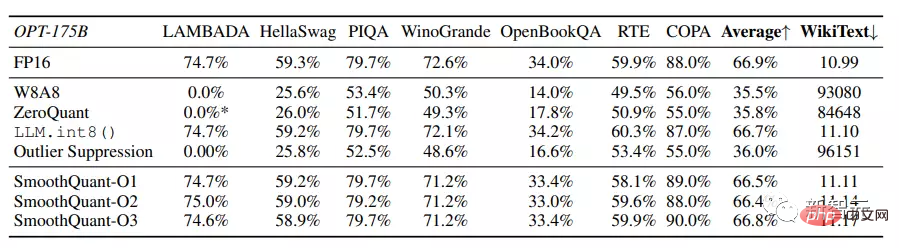

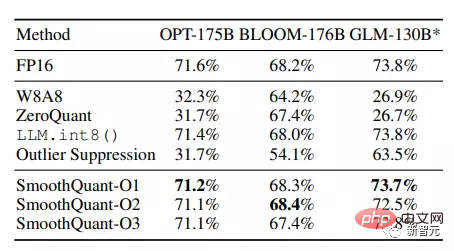

Die Forscher wählten drei große Sprachmodelle zur Evaluierung von SmoothQuant aus, darunter OPT, BLOOM und GLM-130B; und verwendeten sieben Zero-Shot-Aufgaben, darunter LAMBADA, HellaSwag, PIQA, WinoGrande, OpenBookQA, RTE, COPA et al.

Experimentelle Ergebnisse zeigen, dass SmoothQuant das Quantisierungsproblem sehr großer LLMs bewältigen kann, deren Aktivierungen schwieriger zu quantifizieren sind.

SmoothQuant kann bei allen Auswertungsdatensätzen mit der Genauigkeit von FP16 mithalten, während die Basislinien W8A8, ZeroQuant und Outlier Suppression nahezu zufällige Ergebnisse liefern.

Und SmoothQuant kann alle offenen LLMs mit mehr als 100B Parametern verlustfrei quantisieren.

Die O1- und O2-Stufen von SmoothQuant behalten erfolgreich die Gleitkommagenauigkeit bei, während die O3-Stufe (statisch pro Tensor) die durchschnittliche Genauigkeit möglicherweise um 0,8 % reduziert zum Unterschied zwischen statisch erfassten Statistiken und Aktivierungsstatistiken für reale Auswertungsstichproben.

Trotzdem kann SmoothQuant-O1 mit der Genauigkeit von FP16 mithalten, während SmoothQuant-O3 die Genauigkeit nur um 1 % reduziert, was deutlich besser ist als die Basislinie.

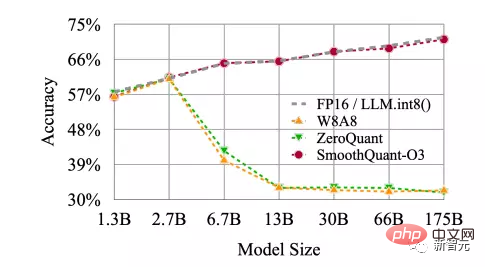

SmoothQuant ist nicht nur für sehr große LLMs mit über 100B-Parametern effektiv, sondern liefert auch stabile Ergebnisse für kleinere LLMs. SmoothQuant kann auf allen Skalen von OPT-Modellen funktionieren und erreicht die FP16-Genauigkeit der INT8-Quantisierung.

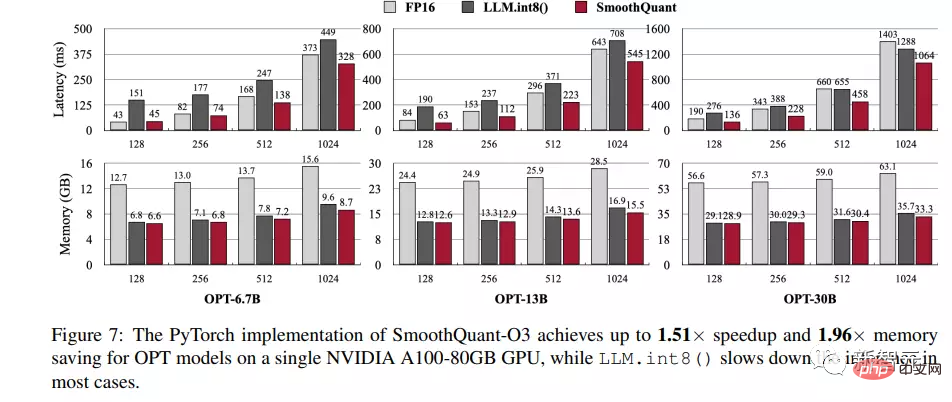

Um die Geschwindigkeitsverbesserungen und Speichereinsparungen durch die Integration von SmoothQuant-O3 in PyTorch und FasterTransformer zu demonstrieren, haben wir die End-to-End-Latenz beim Generieren aller versteckten Zustände für einen Stapel von jeweils 4 Sätzen gemessen, auch bekannt als die Kontextlatenz und zeichnete die maximale GPU-Speichernutzung während dieses Prozesses auf.

Da Huggingface die Modellparallelität nicht unterstützt, haben die Forscher die Leistung der PyTorch-Implementierung von SmoothQuant nur auf einer einzelnen GPU gemessen und daher OPT-6.7B, OPT-13B und OPT-30B zur Bewertung ausgewählt.

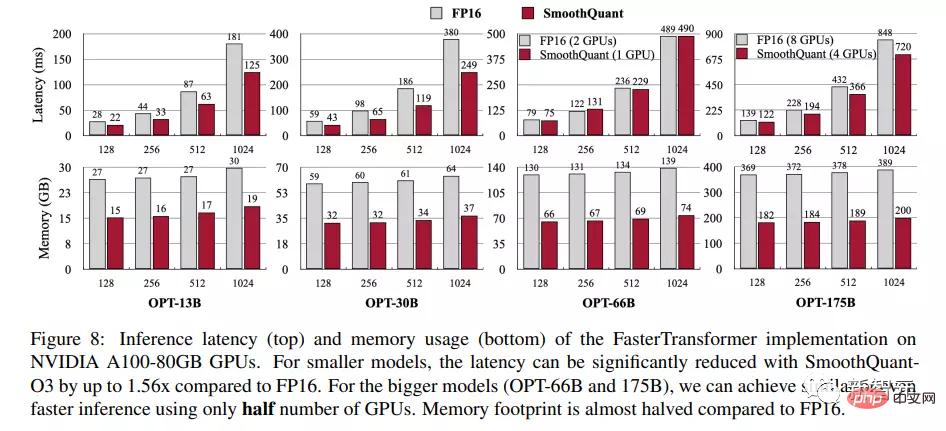

In der FasterTransformer-Bibliothek kann SmoothQuant nahtlos mit dem Tensor-Parallelismus-Algorithmus verbunden werden, sodass die Forscher die Single-GPU- und Multi-GPU-Benchmarks von SmoothQuant auf OPT-13B, OPT-30B, OPT-66B und OPT-175B getestet haben.

Experimentelle Ergebnisse, die auf dem NVIDIA A100 80-GB-GPU-Server durchgeführt wurden, zeigen, dass SmoothQuant in Bezug auf Inferenzlatenz und Spitzenspeichernutzung basierend auf der PyTorch-Implementierung immer schneller ist als die FP16-Basislinie. Wenn die Sequenzlänge 256 beträgt, erreicht es auf OPT-30B das 1,51-fache Geschwindigkeitserhöhung.

Sie können auch einen Trend erkennen, dass die Beschleunigung umso offensichtlicher ist, je größer das Modell ist, aber LLM.int8() ist fast immer langsamer als die FP16-Basislinie, was auch auf den enormen Overhead gemischter Modelle zurückzuführen ist. Präzisionsaktivierungsdarstellung.

In Bezug auf den Speicher können sowohl SmoothQuant als auch LLM.int8() die Speichernutzung des FP16-Modells fast halbieren, während SmoothQuant etwas mehr Speicher spart, da es vollständig INT8 GEMM nutzt.

Im Vergleich zur FP16-Implementierung von OPT durch FasterTransformer kann SmoothQuant-O3 die Ausführung von OPT-13B und OPT-30B bei Verwendung einer einzelnen GPU-Latenzzeit weiter reduzieren , bis zu 1,56x.

Das obige ist der detaillierte Inhalt vonKann ein Sprachmodell mit 10 Milliarden Parametern nicht ausgeführt werden? Ein chinesischer Arzt vom MIT schlug die SmoothQuant-Quantifizierung vor, die den Speicherbedarf um die Hälfte reduzierte und die Geschwindigkeit um das 1,56-fache erhöhte!. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1377

1377

52

52

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Stellen Sie sich ein Modell der künstlichen Intelligenz vor, das nicht nur die Fähigkeit besitzt, die traditionelle Datenverarbeitung zu übertreffen, sondern auch eine effizientere Leistung zu geringeren Kosten erzielt. Dies ist keine Science-Fiction, DeepSeek-V2[1], das weltweit leistungsstärkste Open-Source-MoE-Modell, ist da. DeepSeek-V2 ist ein leistungsstarkes MoE-Sprachmodell (Mix of Experts) mit den Merkmalen eines wirtschaftlichen Trainings und einer effizienten Inferenz. Es besteht aus 236B Parametern, von denen 21B zur Aktivierung jedes Markers verwendet werden. Im Vergleich zu DeepSeek67B bietet DeepSeek-V2 eine stärkere Leistung, spart gleichzeitig 42,5 % der Trainingskosten, reduziert den KV-Cache um 93,3 % und erhöht den maximalen Generierungsdurchsatz auf das 5,76-fache. DeepSeek ist ein Unternehmen, das sich mit allgemeiner künstlicher Intelligenz beschäftigt

KI untergräbt die mathematische Forschung! Der Gewinner der Fields-Medaille und der chinesisch-amerikanische Mathematiker führten 11 hochrangige Arbeiten an | Gefällt mir bei Terence Tao

Apr 09, 2024 am 11:52 AM

KI untergräbt die mathematische Forschung! Der Gewinner der Fields-Medaille und der chinesisch-amerikanische Mathematiker führten 11 hochrangige Arbeiten an | Gefällt mir bei Terence Tao

Apr 09, 2024 am 11:52 AM

KI verändert tatsächlich die Mathematik. Vor kurzem hat Tao Zhexuan, der diesem Thema große Aufmerksamkeit gewidmet hat, die neueste Ausgabe des „Bulletin of the American Mathematical Society“ (Bulletin der American Mathematical Society) weitergeleitet. Zum Thema „Werden Maschinen die Mathematik verändern?“ äußerten viele Mathematiker ihre Meinung. Der gesamte Prozess war voller Funken, knallhart und aufregend. Der Autor verfügt über eine starke Besetzung, darunter der Fields-Medaillengewinner Akshay Venkatesh, der chinesische Mathematiker Zheng Lejun, der NYU-Informatiker Ernest Davis und viele andere bekannte Wissenschaftler der Branche. Die Welt der KI hat sich dramatisch verändert. Viele dieser Artikel wurden vor einem Jahr eingereicht.

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas tritt offiziell in die Ära der Elektroroboter ein! Gestern hat sich der hydraulische Atlas einfach „unter Tränen“ von der Bühne der Geschichte zurückgezogen. Heute gab Boston Dynamics bekannt, dass der elektrische Atlas im Einsatz ist. Es scheint, dass Boston Dynamics im Bereich kommerzieller humanoider Roboter entschlossen ist, mit Tesla zu konkurrieren. Nach der Veröffentlichung des neuen Videos wurde es innerhalb von nur zehn Stunden bereits von mehr als einer Million Menschen angesehen. Die alten Leute gehen und neue Rollen entstehen. Das ist eine historische Notwendigkeit. Es besteht kein Zweifel, dass dieses Jahr das explosive Jahr der humanoiden Roboter ist. Netizens kommentierten: Die Weiterentwicklung der Roboter hat dazu geführt, dass die diesjährige Eröffnungsfeier wie Menschen aussieht, und der Freiheitsgrad ist weitaus größer als der von Menschen. Aber ist das wirklich kein Horrorfilm? Zu Beginn des Videos liegt Atlas ruhig auf dem Boden, scheinbar auf dem Rücken. Was folgt, ist atemberaubend

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

Anfang dieses Monats schlugen Forscher des MIT und anderer Institutionen eine vielversprechende Alternative zu MLP vor – KAN. KAN übertrifft MLP in Bezug auf Genauigkeit und Interpretierbarkeit. Und es kann MLP, das mit einer größeren Anzahl von Parametern ausgeführt wird, mit einer sehr kleinen Anzahl von Parametern übertreffen. Beispielsweise gaben die Autoren an, dass sie KAN nutzten, um die Ergebnisse von DeepMind mit einem kleineren Netzwerk und einem höheren Automatisierungsgrad zu reproduzieren. Konkret verfügt DeepMinds MLP über etwa 300.000 Parameter, während KAN nur etwa 200 Parameter hat. KAN hat eine starke mathematische Grundlage wie MLP und basiert auf dem universellen Approximationssatz, während KAN auf dem Kolmogorov-Arnold-Darstellungssatz basiert. Wie in der folgenden Abbildung gezeigt, hat KAN

Google ist begeistert: JAX-Leistung übertrifft Pytorch und TensorFlow! Es könnte die schnellste Wahl für das GPU-Inferenztraining werden

Apr 01, 2024 pm 07:46 PM

Google ist begeistert: JAX-Leistung übertrifft Pytorch und TensorFlow! Es könnte die schnellste Wahl für das GPU-Inferenztraining werden

Apr 01, 2024 pm 07:46 PM

Die von Google geförderte Leistung von JAX hat in jüngsten Benchmark-Tests die von Pytorch und TensorFlow übertroffen und belegt bei 7 Indikatoren den ersten Platz. Und der Test wurde nicht auf der TPU mit der besten JAX-Leistung durchgeführt. Obwohl unter Entwicklern Pytorch immer noch beliebter ist als Tensorflow. Aber in Zukunft werden möglicherweise mehr große Modelle auf Basis der JAX-Plattform trainiert und ausgeführt. Modelle Kürzlich hat das Keras-Team drei Backends (TensorFlow, JAX, PyTorch) mit der nativen PyTorch-Implementierung und Keras2 mit TensorFlow verglichen. Zunächst wählen sie eine Reihe von Mainstream-Inhalten aus

FisheyeDetNet: der erste Zielerkennungsalgorithmus basierend auf einer Fischaugenkamera

Apr 26, 2024 am 11:37 AM

FisheyeDetNet: der erste Zielerkennungsalgorithmus basierend auf einer Fischaugenkamera

Apr 26, 2024 am 11:37 AM

Die Zielerkennung ist ein relativ ausgereiftes Problem in autonomen Fahrsystemen, wobei die Fußgängererkennung einer der ersten Algorithmen ist, die eingesetzt werden. In den meisten Arbeiten wurde eine sehr umfassende Recherche durchgeführt. Die Entfernungswahrnehmung mithilfe von Fischaugenkameras für die Rundumsicht ist jedoch relativ wenig untersucht. Aufgrund der großen radialen Verzerrung ist es schwierig, die standardmäßige Bounding-Box-Darstellung in Fischaugenkameras zu implementieren. Um die obige Beschreibung zu vereinfachen, untersuchen wir erweiterte Begrenzungsrahmen-, Ellipsen- und allgemeine Polygondesigns in Polar-/Winkeldarstellungen und definieren eine mIOU-Metrik für die Instanzsegmentierung, um diese Darstellungen zu analysieren. Das vorgeschlagene Modell „fisheyeDetNet“ mit polygonaler Form übertrifft andere Modelle und erreicht gleichzeitig 49,5 % mAP auf dem Valeo-Fisheye-Kameradatensatz für autonomes Fahren

Tesla-Roboter arbeiten in Fabriken, Musk: Der Freiheitsgrad der Hände wird dieses Jahr 22 erreichen!

May 06, 2024 pm 04:13 PM

Tesla-Roboter arbeiten in Fabriken, Musk: Der Freiheitsgrad der Hände wird dieses Jahr 22 erreichen!

May 06, 2024 pm 04:13 PM

Das neueste Video von Teslas Roboter Optimus ist veröffentlicht und er kann bereits in der Fabrik arbeiten. Bei normaler Geschwindigkeit sortiert es Batterien (Teslas 4680-Batterien) so: Der Beamte hat auch veröffentlicht, wie es bei 20-facher Geschwindigkeit aussieht – auf einer kleinen „Workstation“, pflücken und pflücken und pflücken: Dieses Mal wird es freigegeben. Eines der Highlights Der Vorteil des Videos besteht darin, dass Optimus diese Arbeit in der Fabrik völlig autonom und ohne menschliches Eingreifen während des gesamten Prozesses erledigt. Und aus Sicht von Optimus kann es auch die krumme Batterie aufnehmen und platzieren, wobei der Schwerpunkt auf der automatischen Fehlerkorrektur liegt: In Bezug auf die Hand von Optimus gab der NVIDIA-Wissenschaftler Jim Fan eine hohe Bewertung ab: Die Hand von Optimus ist der fünffingrige Roboter der Welt am geschicktesten. Seine Hände sind nicht nur taktil

Mit einer einzelnen Karte läuft Llama 70B schneller als mit zwei Karten, Microsoft hat gerade FP6 in A100 integriert |

Apr 29, 2024 pm 04:55 PM

Mit einer einzelnen Karte läuft Llama 70B schneller als mit zwei Karten, Microsoft hat gerade FP6 in A100 integriert |

Apr 29, 2024 pm 04:55 PM

FP8 und die geringere Gleitkomma-Quantifizierungsgenauigkeit sind nicht länger das „Patent“ von H100! Lao Huang wollte, dass jeder INT8/INT4 nutzt, und das Microsoft DeepSpeed-Team begann, FP6 auf A100 ohne offizielle Unterstützung von NVIDIA auszuführen. Testergebnisse zeigen, dass die FP6-Quantisierung der neuen Methode TC-FPx auf A100 nahe an INT4 liegt oder gelegentlich schneller als diese ist und eine höhere Genauigkeit aufweist als letztere. Darüber hinaus gibt es eine durchgängige Unterstützung großer Modelle, die als Open-Source-Lösung bereitgestellt und in Deep-Learning-Inferenz-Frameworks wie DeepSpeed integriert wurde. Dieses Ergebnis wirkt sich auch unmittelbar auf die Beschleunigung großer Modelle aus – in diesem Rahmen ist der Durchsatz bei Verwendung einer einzelnen Karte zum Ausführen von Llama 2,65-mal höher als der von Doppelkarten. eins