Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Lao Huang hält eine spezielle „Atombombe' für ChatGPT bereit, um die Szene explodieren zu lassen, und die NVIDIA H100 Extreme Edition ist zehnmal schneller!

Lao Huang hält eine spezielle „Atombombe' für ChatGPT bereit, um die Szene explodieren zu lassen, und die NVIDIA H100 Extreme Edition ist zehnmal schneller!

Lao Huang hält eine spezielle „Atombombe' für ChatGPT bereit, um die Szene explodieren zu lassen, und die NVIDIA H100 Extreme Edition ist zehnmal schneller!

NVIDIA, du gewinnst!

Auf der gerade zu Ende gegangenen GTC-Konferenz, mit dem Bildschirm voller „generativer KI“ und einem H100 NVLINK-Chip, der die ChatGPT-Rechenleistung unterstützt und zehnmal schneller wird, hätte Huang diese Worte fast auf sein Gesicht geschrieben: „Das bin ich.“ der Gewinner“.

ChatGPT, Microsoft 365, Azure, Stable Diffusion, DALL-E, Midjourney ... all diese beliebten und explosiven KI-Produkte, NVIDIA kann an ihnen allen teilhaben.

Die weltweite Popularität von ChatGPT zu Beginn dieses Jahres ließ den Aktienkurs von Nvidia in die Höhe schnellen und sein Marktwert stieg direkt um mehr als 70 Milliarden US-Dollar. Derzeit beträgt die Marktkapitalisierung von Nvidia 640 Milliarden US-Dollar.

Jetzt ist der iPhone-Moment der KI gekommen, die vierte technologische Revolution steht vor der Tür und Nvidia könnte mit seinem A100 und H100 der größte Gewinner werden.

Auf der GTC-Konferenz kündigte Huang NVIDIAs bemerkenswerte Fortschritte bei GPUs, Beschleunigungsbibliotheken, Computerlithographie und Cloud-Plattformen an und machte sogar eine mutige Aussage: NVIDIA wird das TSMC im KI-Kreis sein!

Einige Leute haben spekuliert, dass die heutige Rede vollständig mit dem AIGC-Modell auf dem H100 erstellt wurde.

Die dedizierte ChatGPT-GPU ist da

Die größte Ankündigung auf dieser Konferenz ist der für ChatGPT entwickelte NVIDIA H100 NVLINK.

Aufgrund der enormen Nachfrage nach Rechenleistung hat NVIDIA eine neue Hopper-GPU für die Inferenz von LLMs wie ChatGPT, PCIE H100 mit Dual-GPU-NVLINK und 94B Speicher auf den Markt gebracht.

Tatsächlich ist die Geschichte des Deep Learning seit 2012 eng mit NVIDIA verbunden.

Lao Huang sagte, dass der Deep-Learning-Veteran Hinton und die Studenten Alex Kerchevsky und Ilya Suskever 2012 beim Training von AlexNet die GeForce GTX 580 verwendeten.

Anschließend gewann AlexNet auf einen Schlag den ImageNet-Bildklassifizierungswettbewerb und wurde zum einzigartigen Punkt der Deep-Learning-Explosion.

Und nach 10 Jahren nutzte Ilya Suskever von OpenAI auch NVIDIAs DGX, um GPT3 und GPT3.5 hinter ChatGPT zu trainieren.

Lao Huang sagte stolz, dass derzeit die einzige GPU in der Cloud, die ChatGPT tatsächlich verarbeiten kann, die HGX A100 ist.

Aber im Vergleich zum A100 ist ein Server, der mit vier H100-Paaren und Dual-GPU-NVLINK ausgestattet ist, zehnmal schneller! Denn H100 kann die Verarbeitungskosten von LLM um eine Größenordnung senken.

KI befindet sich an einem Wendepunkt, da generative KI eine Welle von Möglichkeiten schafft, die dazu führen, dass die Inferenz-Arbeitslast schrittweise zunimmt.

In der Vergangenheit war die Gestaltung eines Cloud-Rechenzentrums für den Umgang mit generativer KI eine große Herausforderung.

Einerseits wäre es idealerweise besser, einen Beschleuniger zu verwenden, um das Rechenzentrum elastisch zu machen; andererseits kann kein Beschleuniger die Vielfalt an Algorithmen, Modellen, Datentypen und Größen optimal bewältigen. Die One Architecture-Plattform von NVIDIA bietet sowohl Beschleunigungsfähigkeiten als auch Flexibilität.

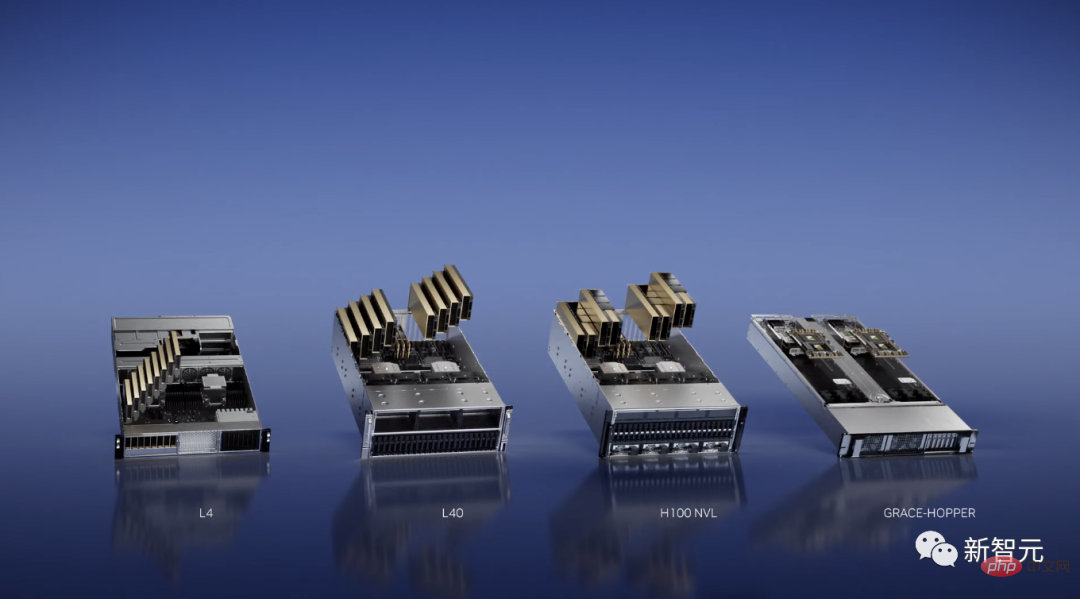

Und heute gab NVIDIA die Einführung einer neuen Inferenzplattform bekannt. Jede Konfiguration ist für eine bestimmte Art von Arbeitslast optimiert.

Für KI-Video-Workloads hat NVIDIA beispielsweise L4 eingeführt, das über optimierte Videodekodierung und -transkodierung, Videoinhaltsüberprüfung und Videoanruffunktionen verfügt.

Und ein 8-GPU-L4-Server wird mehr als hundert Dual-Socket-CPU-Server ersetzen, die zur Verarbeitung von KI-Videos verwendet werden.

Gleichzeitig brachte NVIDIA auch L40 für generative KI wie Omniverse, Grafik-Rendering und Text-zu-Bild/Video auf den Markt. Seine Leistung ist zehnmal so hoch wie die der beliebtesten Cloud-Inferenz-GPU T4 von Nvidia.

Derzeit basieren die leistungsstarken Funktionen der von Runway eingeführten generativen KI-Modelle Gen-1 und Gen-2 auf NVIDIA-GPUs.

Darüber hinaus hat NVIDIA auch einen neuen Superchip Grace-Hopper auf den Markt gebracht, der für Empfehlungssysteme und Vektordatenbanken geeignet ist.

Die Grenzen von Chips herausfordern und die Computerlithographie um das 40-fache beschleunigen

Im Chipbereich hat NVIDIA zusammen mit TSMC, ASML und Synopsys nach vier Jahren endlich einen großen Durchbruch in der Computerlithographietechnologie geschafft – NVIDIA cuLitho computational Lithographie Keku.

Nachdem die Grenze des 2-nm-Prozesses erreicht ist, ist die Fotolithographie der Durchbruch.

Computerlithographie simuliert das Verhalten von Licht, wenn es mit dem Fotolack interagiert, nachdem es das optische Element passiert hat. Durch die Anwendung inverser physikalischer Algorithmen können wir das Muster auf der Maske vorhersagen, um das endgültige Muster auf dem Wafer zu erzeugen.

Computerlithographie ist der größte Rechenaufwand im Bereich Chip-Design und -Herstellung und verbraucht jedes Jahr mehrere zehn Milliarden CPU-Stunden. Im Gegensatz dazu ermöglicht der neue von NVIDIA entwickelte Algorithmus die parallele Ausführung immer komplexerer computergestützter Lithografie-Workflows auf GPUs.

Zusammengefasst kann cuLitho nicht nur die Rechengeschwindigkeit um das 40-fache erhöhen, sondern auch den Stromverbrauch um das bis zu 9-fache senken.

Nvidias H100 benötigt beispielsweise 89 Masken.

Bei Verarbeitung durch die CPU dauert jede Maske zwei Wochen. Wenn Sie cuLitho auf der GPU ausführen, dauert die Verarbeitung einer Maske nur 8 Stunden.

Und TSMC kann auch 4.000 Hopper-GPUs in 500 DGX H100-Systemen verwenden, um die Arbeit zu erledigen, die bisher bis zu 40.000 CPU-basierte Server erforderte, und die Leistung wird von 35 MW auf 5 MW reduziert.

Es ist erwähnenswert, dass die cuLitho-Beschleunigungsbibliothek auch mit GPUs der Ampere- und Volta-Architektur kompatibel ist, Hopper jedoch die schnellste Lösung ist.

Lao Huang sagte, dass Waferfabriken ihre Produktion steigern und sich auf die Entwicklung von 2 nm und mehr vorbereiten können, da sich die Fotolithographietechnologie bereits an der Grenze der Physik befindet.

AIs iPhone-Moment

In den letzten Monaten war ChatGPT überwältigend und steht kurz vor der vierten technologischen Revolution. Auch der Spruch „Wir befinden uns im iPhone-Moment der KI“ ist weit verbreitet.

Auf der GTC-Konferenz wiederholte Lao Huang diesen Satz aufgeregt dreimal.

Der iPhone-Moment naht, Startups wie OpenAI konkurrieren um die Entwicklung disruptiver Produkte und Geschäftsmodelle, während etablierte Unternehmen wie Google und Microsoft nach Möglichkeiten suchen, damit umzugehen.

All ihre Handlungen sind auf das Dringlichkeitsgefühl bei der Formulierung von KI-Strategien zurückzuführen, das durch generative KI auf der ganzen Welt ausgelöst wird.

NVIDIA Accelerated Computing beginnt mit dem KI-Supercomputer DGX, der auch der Motor hinter den aktuellen Durchbrüchen bei großen Sprachmodellen ist.

Bei GTC sagte Lao Huang stolz, dass ich persönlich den weltweit ersten DGX an OpenAI übergeben habe.

Seitdem hat die Hälfte der Fortune-100-Unternehmen DGXAI-Supercomputer installiert.

DGX ist mit 8 H100-GPU-Modulen ausgestattet, und H100 ist mit einer Transformer-Engine ausgestattet, die erstaunliche Modelle wie ChatGPT verarbeiten kann.

Acht H100-Module sind über NVLINK Switch miteinander verbunden und ermöglichen so eine umfassende, nicht blockierende Kommunikation. Acht H100 arbeiten wie eine riesige GPU zusammen.

Was Lao Huang noch mehr begeistert, ist die Ankündigung von Microsoft, dass Azure eine private Vorschauversion seines KI-Supercomputers H100 eröffnen wird.

sagte auch: „Der DGX-Supercomputer ist eine moderne KI-Fabrik. Wir befinden uns im iPhone-Moment der KI.“ #一手Bringing chatGPT

Im letzten Jahrzehnt hat die Kombination aus Beschleunigung und vertikaler Skalierung es verschiedenen Anwendungen ermöglicht, millionenfache Leistungsverbesserungen zu erzielen.

Das beeindruckendste Beispiel ist die Einführung des AlexNet Deep Learning Frameworks im Jahr 2012.

Zu diesem Zeitpunkt absolvierten Alex Krizhevsky, Ilya Suskever und Hinton das Training mit 14 Millionen Bildern auf der GeForce GTX 580, die 262 Petaflops verarbeiten kann.

Zehn Jahre später wurde Transformer auf den Markt gebracht.

Ilya Suskever trainierte GPT-3, um das nächste Wort vorherzusagen, was eine Million Mal mehr Gleitkommaoperationen erforderte als das Training des AlexNet-Modells.

Daraus entstand eine KI, die die Welt schockierte – ChatGPT.

Um es in einem Satz von Lao Huang zusammenzufassen:

Das bedeutet, dass eine neue Computerplattform ist geboren, der „iPhone-Moment“ der KI ist gekommen. Beschleunigtes Rechnen und KI-Technologie sind in der Realität angekommen.

Die Beschleunigungsbibliothek ist der Kern des beschleunigten Rechnens. Diese Beschleunigungsbibliotheken verbinden verschiedene Anwendungen und stellen dann eine Verbindung zu verschiedenen Branchen her und bilden ein Netzwerk innerhalb des Netzwerks.

Nach 30 Jahren Entwicklung wurden Tausende von Anwendungen durch NVIDIA-Bibliotheken beschleunigt, die nahezu alle Bereiche der Wissenschaft und Industrie abdecken.

Derzeit sind alle NVIDIA-GPUs mit CUDA kompatibel.

Die vorhandenen 300 Beschleunigungsbibliotheken und 400 KI-Modelle decken ein breites Spektrum an Bereichen wie Quantencomputing, Datenverarbeitung und maschinelles Lernen ab.

Auf dieser GTC-Konferenz gab Nvidia bekannt, dass es 100 davon aktualisiert hat.

Die NVIDIA Quantum-Plattform besteht aus Bibliotheken und Systemen, die es Forschern ermöglichen, Quantenprogrammierungsmodelle, Systemarchitekturen und Algorithmen voranzutreiben.

cuQuantum ist eine Beschleunigungsbibliothek für die Simulation von Quantenschaltungen. Unternehmen wie IBM und Baidu haben diese Beschleunigungsbibliothek in ihre Simulationsframeworks integriert.

Open Quantum CUDA ist NVIDIAs hybrides GPU-Quantum-Programmiermodell. Nvidia kündigte außerdem die Einführung einer Quantenkontrollverbindung an, die in Zusammenarbeit mit Quantum Machines entwickelt wurde. Es kann Nvidia-GPUs mit Quantencomputern verbinden, um Fehlerkorrekturen mit extrem hoher Geschwindigkeit durchzuführen.

Außerdem wurde eine neue RAFT-Bibliothek eingeführt, um die Indizierung, das Laden von Daten und die Suche nach nächsten Nachbarn zu beschleunigen.

Darüber hinaus kündigte NVIDIA auch DGX Quantum an, das auf DGX basiert und die neueste Open-Source-Plattform CUDA Quantum nutzt. Diese neue Plattform bietet Forschern, die sich mit Quantencomputing beschäftigen, ein revolutionäres High -Leistung und Architektur mit geringer Latenz. NVIDIA hat außerdem die NVIDIA Triton Management Service-Software eingeführt, um Triton-Inferenzinstanzen im gesamten Rechenzentrum automatisch zu skalieren und zu orchestrieren. Geeignet für die Multi-GPU- und Multi-Knoten-Inferenz großer Sprachmodelle wie GPT-3.

CV-CUDA für Computer Vision und VPF für die Videoverarbeitung sind Nvidias neue Cloud-Scale-Beschleunigungsbibliotheken.

Lao Huang gab bekannt, dass CV-CUDA Beta die Vor- und Nachverarbeitung optimiert, einen höheren Cloud-Durchsatz erreicht und Kosten und Energieverbrauch um ein Viertel senkt.

Derzeit kümmert sich Microsoft um die visuelle Suche und Runway um seinen generativen KI-Videoverarbeitungsprozess, die beide CV-CUDA- und VRF-Bibliotheken verwenden.

Darüber hinaus hat NVIDIA Accelerated Computing auch dazu beigetragen, dass die Genomik Meilensteinentwicklungen erreicht hat. Durch den Einsatz von NVIDIA-Instrumenten ist die Reduzierung der Kosten für die Sequenzierung des gesamten Genoms auf 100 US-Dollar ein weiterer Meilenstein.

NVIDIA Parabrics Beschleunigungsbibliothek kann für eine End-to-End-Genomanalyse in der Cloud oder innerhalb des Instruments verwendet werden und ist für verschiedene öffentliche Cloud- und Genomikplattformen geeignet.

ChatGPT läuft, NVIDIA verdient Geld

Jetzt haben ChatGPT, Stable Diffusion, DALL-E und Midjourney das weltweite Bewusstsein für generative KI geweckt.

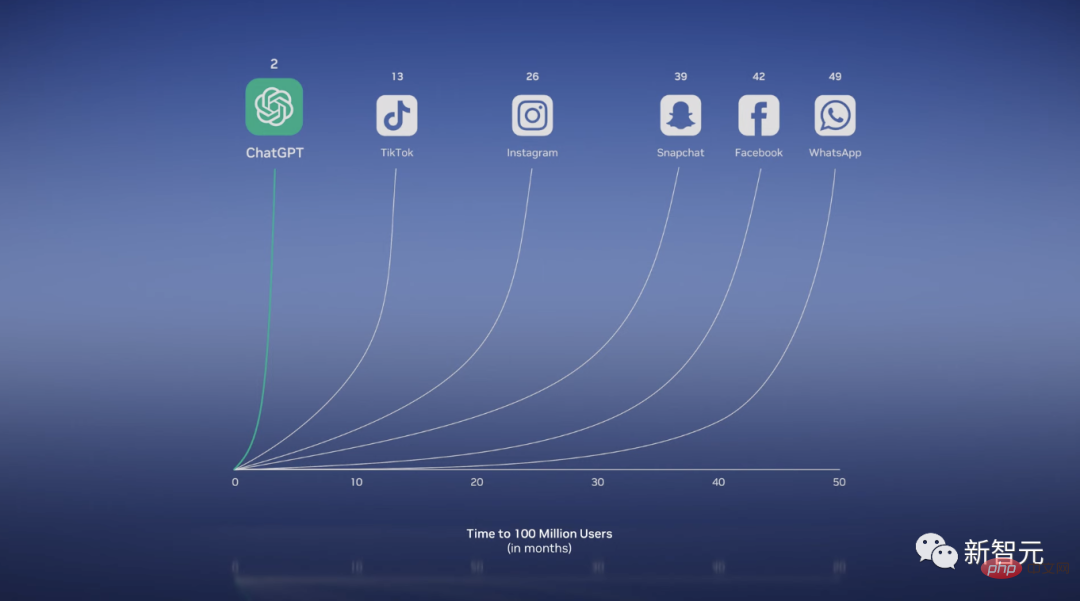

Das beliebte Brathähnchen ChatGPT hat nur zwei Monate nach seiner Einführung die 100-Millionen-Monats-Nutzerzahl überschritten und ist zur am schnellsten wachsenden Anwendung in der Geschichte geworden.

Man kann sagen, dass es sich um einen Computer handelt. Sie können nicht nur Texte generieren, Gedichte schreiben, Forschungsarbeiten umschreiben, mathematische Probleme lösen und sogar programmieren.

Viele bahnbrechende Ergebnisse haben die heutige generative KI hervorgebracht.

Transformer ist in der Lage, auf massiv parallele Weise Kontext und Bedeutung aus den Beziehungen und Abhängigkeiten von Daten zu lernen. Dadurch können LLMs aus riesigen Datenmengen lernen und nachgelagerte Aufgaben ohne explizite Schulung ausführen.

Darüber hinaus kann ein von der Physik inspiriertes Diffusionsmodell durch unbeaufsichtigtes Lernen Bilder erzeugen.

Lao Huang kam zu dem Schluss, dass wir in nur einem Dutzend Jahren von der Identifizierung von Katzen zur Erzeugung von Katzen in Raumanzügen gelangt sind, die auf dem Mond laufen.

Mittlerweile kann man sagen, dass es sich bei der generativen KI um eine neue Art von Computer handelt, einen Computer, der in menschlicher Sprache programmiert werden kann.

Früher war es das ausschließliche Privileg von Programmierern, dem Computer zu befehlen, Probleme zu lösen, aber jetzt kann jeder Programmierer sein.

Wie Bill Gates gab auch Huang eine ähnliche Definition: Generative KI ist eine neue Computerplattform, ähnlich wie PC, Internet, mobile Geräte und Cloud.

Durch Debuild können wir Webanwendungen direkt entwerfen und bereitstellen, solange wir klarstellen, was wir wollen.

Es ist klar, dass generative KI fast jede Branche neu gestalten wird.

Um der „TSMC“ in der KI-Branche zu sein

In diesem Zusammenhang müssen professionelle Unternehmen ihre eigenen proprietären Daten verwenden, um maßgeschneiderte Modelle zu erstellen.

Dann verkündete Lao Huang stolz, dass die Branche eine Gießerei ähnlich wie TSMC braucht, um maßgeschneiderte große Sprachmodelle zu bauen, und NVIDIA ist dieses „TSMC“!

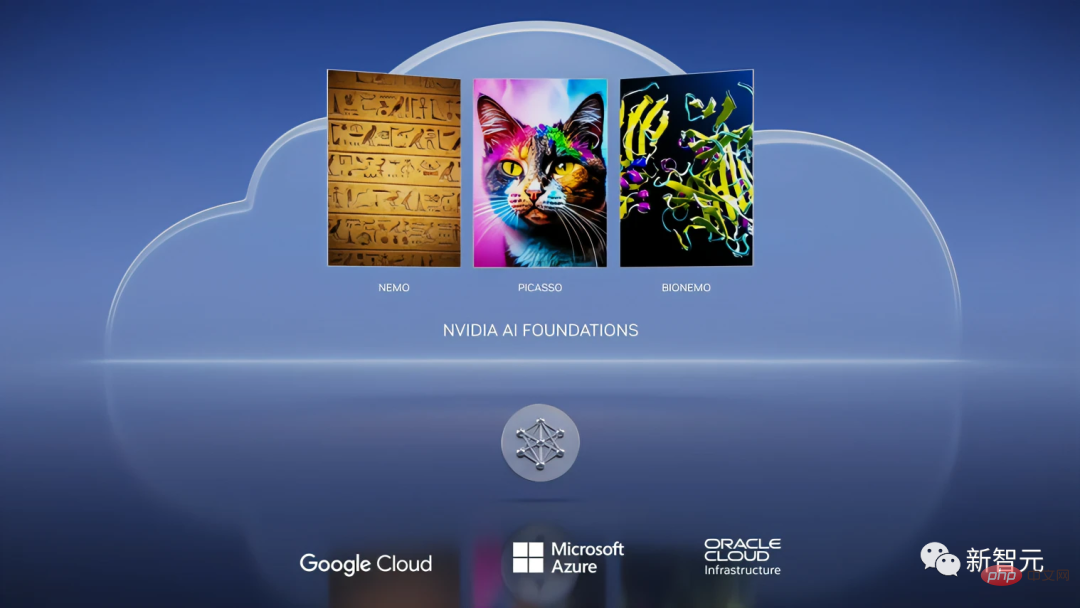

Auf der Konferenz kündigte NVIDIA die Einführung des Cloud-Dienstes NVIDIA AI Foundations an, der es Kunden ermöglicht, LLM und generative KI anzupassen.

Dieser Cloud-Service umfasst Sprach-, Seh- und biologische Modellproduktionsdienste.

Unter anderem wird Nemo verwendet, um ein benutzerdefiniertes generatives Text-zu-Text-Sprachmodell zu erstellen.

Und Picasso ist ein Modellbauer für visuelle Sprachen, mit dem benutzerdefinierte Modelle trainiert werden können, einschließlich Bildern, Videos und 3D-Anwendungen.

Senden Sie einfach einen API-Aufruf mit Textaufforderungen und Metadaten an Picasso, und Picasso verwendet das Modell in der DGX Cloud, um das generierte Material an die Anwendung zurückzusenden.

Was noch erstaunlicher ist, ist, dass Sie durch den Import dieser Materialien in NVIDIA Omniverse realistische Metaverse-Anwendungen und Simulationen digitaler Zwillinge erstellen können.

Darüber hinaus arbeitet NVIDIA auch mit Shutterstock zusammen, um generative Edify-3D-Modelle zu entwickeln.

Gleichzeitig wird die Zusammenarbeit zwischen NVIDIA und Adobe weiter ausgebaut, wobei generative KI in den täglichen Arbeitsablauf von Vermarktern und Kreativen integriert wird und ein besonderes Augenmerk auf den Schutz der Urheberrechte von Künstlern gelegt wird.

Das dritte Fachgebiet ist die Biologie.

Heute hat der Wert der Arzneimittelforschungs- und -entwicklungsbranche fast 2 Billionen Yuan erreicht, mit Forschungs- und Entwicklungsinvestitionen von bis zu 250 Milliarden US-Dollar.

NVIDIA Clara ist ein medizinisches und gesundheitliches Anwendungsframework für Bildgebung, Instrumentierung, Genomanalyse und Arzneimittelentwicklung.

Eine beliebte Richtung in der Biosphäre besteht in letzter Zeit darin, generative KI zu nutzen, um Krankheitsziele zu entdecken und neue Moleküle oder Proteinmedikamente zu entwickeln.

Entsprechend ermöglicht BIONEMO Benutzern die Verwendung proprietärer Daten zur Erstellung, Feinabstimmung und Bereitstellung benutzerdefinierter Modelle, einschließlich Proteinvorhersagemodellen wie AlphaFold, ESMFold und OpenFold.

Abschließend kam Lao Huang zu dem Schluss, dass NVIDIA AI Foundations ein Cloud-Dienst und eine Gießerei für die Erstellung benutzerdefinierter Sprachmodelle und generativer KI ist.

Laohuang Cloud Service, monatliche Miete beträgt 36.999 US-Dollar

NVIDIA hat dieses Mal auch einen Cloud-Service eingeführt.

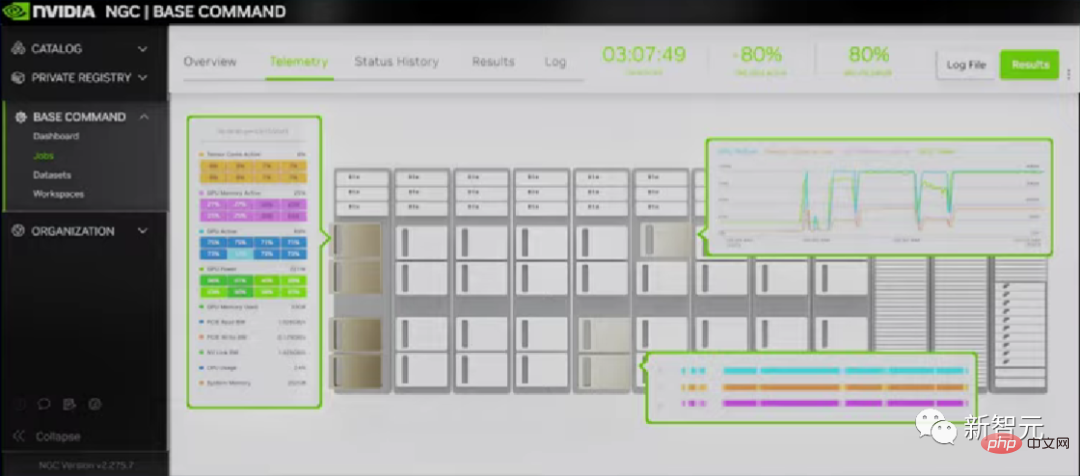

Das Unternehmen erkannte die Bedürfnisse der Kunden nach einem einfacheren und schnelleren Zugriff auf NVIDIA AI und führte daher NVIDIA DGX Cloud ein.

DGX Cloud arbeitet mit Microsoft Azure, Google GCP und Oracle OCI zusammen. Mit nur einem Browser und dem NVIDIA DGX AI-Supercomputer können Sie sofort auf jedes Unternehmen zugreifen!

In dieser Cloud können Sie die NVIDIA AI Enterprise-Beschleunigungsbibliothekssuite ausführen, um die End-to-End-Entwicklung und Bereitstellung von KI direkt zu lösen.

Darüber hinaus stellt die Cloud nicht nur NVIDIA AI bereit, sondern auch mehrere große Cloud-Dienstanbieter auf der Welt.

Und NVIDIAs erste NVIDIA DGX Cloud ist Oracle Cloud Infrastructure (OCI).

In OCI vereinen sich NVIDIA CX-7 und BlueField-3 zu einem leistungsstarken Supercomputer.

Berichten zufolge können Unternehmen DGX Cloud jetzt ab 36.999 US-Dollar pro Monat mieten.

Abschließend gibt es natürlich noch das reservierte Programm der jährlichen GTC-Konferenz-Omniversum. Lao Huang kündigte das Update der Metaverse-Plattform Omniverse an.

Jetzt bereiten sich Microsoft und NVIDIA darauf vor, Omniverse Hunderten Millionen Microsoft 365- und Azure-Benutzern zugänglich zu machen.

Darüber hinaus gibt es Neuigkeiten, dass Lao Huang speziell einen „H800“ entwickelt hat, der auf den Erfahrungen des vorherigen A800 basiert und die Datenübertragungsrate zwischen Chips reduziert, um den Export von H100 nach China unter Einhaltung der Vorschriften zu ermöglichen bis H100 Etwa 50 %.

Zusammenfassend hat Lao Huang auf dieser Konferenz deutlich gemacht, dass NVIDIA der TSMC im Bereich KI sein möchte, der OEMs wie eine Waferfabrik zur Verfügung stellt und auf dieser Grundlage andere Unternehmen der Branche Algorithmen trainieren können.

Kann dieses Geschäftsmodell erfolgreich sein?

Das obige ist der detaillierte Inhalt vonLao Huang hält eine spezielle „Atombombe' für ChatGPT bereit, um die Szene explodieren zu lassen, und die NVIDIA H100 Extreme Edition ist zehnmal schneller!. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1376

1376

52

52

Laravels Geospatial: Optimierung interaktiver Karten und großen Datenmengen

Apr 08, 2025 pm 12:24 PM

Laravels Geospatial: Optimierung interaktiver Karten und großen Datenmengen

Apr 08, 2025 pm 12:24 PM

Verarbeiten Sie 7 Millionen Aufzeichnungen effizient und erstellen Sie interaktive Karten mit Geospatial -Technologie. In diesem Artikel wird untersucht, wie über 7 Millionen Datensätze mithilfe von Laravel und MySQL effizient verarbeitet und in interaktive Kartenvisualisierungen umgewandelt werden können. Erstes Herausforderungsprojektanforderungen: Mit 7 Millionen Datensätzen in der MySQL -Datenbank wertvolle Erkenntnisse extrahieren. Viele Menschen erwägen zunächst Programmiersprachen, aber ignorieren die Datenbank selbst: Kann sie den Anforderungen erfüllen? Ist Datenmigration oder strukturelle Anpassung erforderlich? Kann MySQL einer so großen Datenbelastung standhalten? Voranalyse: Schlüsselfilter und Eigenschaften müssen identifiziert werden. Nach der Analyse wurde festgestellt, dass nur wenige Attribute mit der Lösung zusammenhängen. Wir haben die Machbarkeit des Filters überprüft und einige Einschränkungen festgelegt, um die Suche zu optimieren. Kartensuche basierend auf der Stadt

Wie man MySQL löst, kann nicht gestartet werden

Apr 08, 2025 pm 02:21 PM

Wie man MySQL löst, kann nicht gestartet werden

Apr 08, 2025 pm 02:21 PM

Es gibt viele Gründe, warum MySQL Startup fehlschlägt und durch Überprüfung des Fehlerprotokolls diagnostiziert werden kann. Zu den allgemeinen Ursachen gehören Portkonflikte (prüfen Portbelegung und Änderung der Konfiguration), Berechtigungsprobleme (Überprüfen Sie den Dienst Ausführen von Benutzerberechtigungen), Konfigurationsdateifehler (Überprüfung der Parametereinstellungen), Datenverzeichniskorruption (Wiederherstellung von Daten oder Wiederaufbautabellenraum), InnoDB-Tabellenraumprobleme (prüfen IBDATA1-Dateien), Plug-in-Ladeversagen (Überprüfen Sie Fehlerprotokolle). Wenn Sie Probleme lösen, sollten Sie sie anhand des Fehlerprotokolls analysieren, die Hauptursache des Problems finden und die Gewohnheit entwickeln, Daten regelmäßig zu unterstützen, um Probleme zu verhindern und zu lösen.

So verwenden Sie MySQL nach der Installation

Apr 08, 2025 am 11:48 AM

So verwenden Sie MySQL nach der Installation

Apr 08, 2025 am 11:48 AM

Der Artikel führt den Betrieb der MySQL -Datenbank vor. Zunächst müssen Sie einen MySQL -Client wie MySQLworkBench oder Befehlszeilen -Client installieren. 1. Verwenden Sie den Befehl mySQL-uroot-P, um eine Verbindung zum Server herzustellen und sich mit dem Stammkonto-Passwort anzumelden. 2. Verwenden Sie die Erstellung von Createdatabase, um eine Datenbank zu erstellen, und verwenden Sie eine Datenbank aus. 3.. Verwenden Sie CreateTable, um eine Tabelle zu erstellen, Felder und Datentypen zu definieren. 4. Verwenden Sie InsertInto, um Daten einzulegen, Daten abzufragen, Daten nach Aktualisierung zu aktualisieren und Daten nach Löschen zu löschen. Nur indem Sie diese Schritte beherrschen, lernen, mit gemeinsamen Problemen umzugehen und die Datenbankleistung zu optimieren, können Sie MySQL effizient verwenden.

Remote Senior Backend Engineers (Plattformen) benötigen Kreise

Apr 08, 2025 pm 12:27 PM

Remote Senior Backend Engineers (Plattformen) benötigen Kreise

Apr 08, 2025 pm 12:27 PM

Remote Senior Backend Engineer Job Vacant Company: Circle Standort: Remote-Büro-Jobtyp: Vollzeitgehalt: 130.000 bis 140.000 US-Dollar Stellenbeschreibung Nehmen Sie an der Forschung und Entwicklung von Mobilfunkanwendungen und öffentlichen API-bezogenen Funktionen, die den gesamten Lebenszyklus der Softwareentwicklung abdecken. Die Hauptaufgaben erledigen die Entwicklungsarbeit unabhängig von RubyonRails und arbeiten mit dem Front-End-Team von React/Redux/Relay zusammen. Erstellen Sie die Kernfunktionalität und -verbesserungen für Webanwendungen und arbeiten Sie eng mit Designer und Führung während des gesamten funktionalen Designprozesses zusammen. Fördern Sie positive Entwicklungsprozesse und priorisieren Sie die Iterationsgeschwindigkeit. Erfordert mehr als 6 Jahre komplexes Backend für Webanwendungen

Kann MySQL JSON zurückgeben?

Apr 08, 2025 pm 03:09 PM

Kann MySQL JSON zurückgeben?

Apr 08, 2025 pm 03:09 PM

MySQL kann JSON -Daten zurückgeben. Die JSON_EXTRACT -Funktion extrahiert Feldwerte. Über komplexe Abfragen sollten Sie die Where -Klausel verwenden, um JSON -Daten zu filtern, aber auf die Leistungsauswirkungen achten. Die Unterstützung von MySQL für JSON nimmt ständig zu, und es wird empfohlen, auf die neuesten Versionen und Funktionen zu achten.

Verstehen von Säureeigenschaften: Die Säulen einer zuverlässigen Datenbank

Apr 08, 2025 pm 06:33 PM

Verstehen von Säureeigenschaften: Die Säulen einer zuverlässigen Datenbank

Apr 08, 2025 pm 06:33 PM

Detaillierte Erläuterung von Datenbanksäureattributen Säureattribute sind eine Reihe von Regeln, um die Zuverlässigkeit und Konsistenz von Datenbanktransaktionen sicherzustellen. Sie definieren, wie Datenbanksysteme Transaktionen umgehen, und sorgen dafür, dass die Datenintegrität und -genauigkeit auch im Falle von Systemabstürzen, Leistungsunterbrechungen oder mehreren Benutzern gleichzeitiger Zugriff. Säureattributübersicht Atomizität: Eine Transaktion wird als unteilbare Einheit angesehen. Jeder Teil schlägt fehl, die gesamte Transaktion wird zurückgerollt und die Datenbank behält keine Änderungen bei. Wenn beispielsweise eine Banküberweisung von einem Konto abgezogen wird, jedoch nicht auf ein anderes erhöht wird, wird der gesamte Betrieb widerrufen. begintransaktion; updateAccountsSetBalance = Balance-100WH

MySQL kann nach dem Herunterladen nicht installiert werden

Apr 08, 2025 am 11:24 AM

MySQL kann nach dem Herunterladen nicht installiert werden

Apr 08, 2025 am 11:24 AM

Die Hauptgründe für den Fehler bei MySQL -Installationsfehlern sind: 1. Erlaubnisprobleme, Sie müssen als Administrator ausgeführt oder den Sudo -Befehl verwenden. 2. Die Abhängigkeiten fehlen, und Sie müssen relevante Entwicklungspakete installieren. 3. Portkonflikte müssen Sie das Programm schließen, das Port 3306 einnimmt, oder die Konfigurationsdatei ändern. 4. Das Installationspaket ist beschädigt. Sie müssen die Integrität herunterladen und überprüfen. 5. Die Umgebungsvariable ist falsch konfiguriert und die Umgebungsvariablen müssen korrekt entsprechend dem Betriebssystem konfiguriert werden. Lösen Sie diese Probleme und überprüfen Sie jeden Schritt sorgfältig, um MySQL erfolgreich zu installieren.

Master SQL Limit -Klausel: Steuern Sie die Anzahl der Zeilen in einer Abfrage

Apr 08, 2025 pm 07:00 PM

Master SQL Limit -Klausel: Steuern Sie die Anzahl der Zeilen in einer Abfrage

Apr 08, 2025 pm 07:00 PM

SQllimit -Klausel: Steuern Sie die Anzahl der Zeilen in Abfrageergebnissen. Die Grenzklausel in SQL wird verwendet, um die Anzahl der von der Abfrage zurückgegebenen Zeilen zu begrenzen. Dies ist sehr nützlich, wenn große Datensätze, paginierte Anzeigen und Testdaten verarbeitet werden und die Abfrageeffizienz effektiv verbessern können. Grundlegende Syntax der Syntax: SelectColumn1, Spalte2, ... Fromtable_Namelimitnumber_of_rows; number_of_rows: Geben Sie die Anzahl der zurückgegebenen Zeilen an. Syntax mit Offset: SelectColumn1, Spalte2, ... Fromtable_NamelimitOffset, Number_of_rows; Offset: Skip überspringen