Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

In Bezug auf AGI und ChatGPT sind Stuart Russell und Zhu Songchun dieser Meinung

In Bezug auf AGI und ChatGPT sind Stuart Russell und Zhu Songchun dieser Meinung

In Bezug auf AGI und ChatGPT sind Stuart Russell und Zhu Songchun dieser Meinung

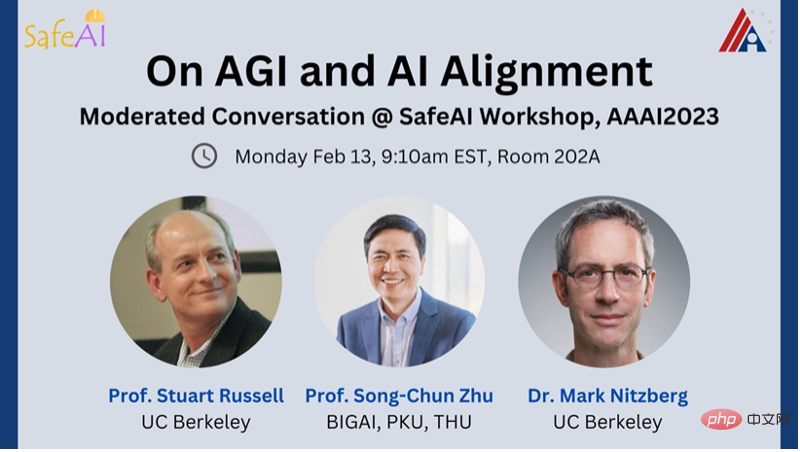

Mark Nitzberg: Heute haben wir die Ehre, zwei Top-Experten für künstliche Intelligenz zur Teilnahme an diesem SafeAI-Seminar einzuladen.

Das sind: Stuart Russell, Informatiker an der University of California, Berkeley, Direktor des Center for Class-Compatible Artificial Intelligence (CHAI) und Mitglied des Lenkungsausschusses des Artificial Intelligence Research Laboratory (BAIR). Stellvertretender Vorsitzender des Ausschusses für künstliche Intelligenz und Robotik des Weltwirtschaftsforums, AAAS Fellow und AAAI Fellow.

Zhu Songchun, Präsident des Beijing Institute of General Artificial Intelligence, Lehrstuhlinhaber der Universität Peking, Dekan der School of Intelligence und des Forschungsinstituts für künstliche Intelligenz der Universität Peking und Lehrstuhlinhaber für Grundlagenwissenschaften an der Tsinghua-Universität.

Mark Nitzberg: Was ist „Allgemeine Künstliche Intelligenz“? Gibt es einen genau definierten Test, um festzustellen, wann wir es erstellt haben?

Stuart Russell: Allgemeine künstliche Intelligenz wurde als in der Lage beschrieben, alle Aufgaben zu erledigen, zu denen Menschen fähig sind, aber das ist nur eine allgemeine Aussage. Wir hoffen, dass allgemeine künstliche Intelligenz Dinge tun kann, die Menschen nicht können, beispielsweise das gesamte Wissen zusammenfassen oder komplexe Teilcheninteraktionen simulieren.

Um allgemeine künstliche Intelligenz zu studieren, können wir von Benchmarks spezifischer Aufgaben zu allgemeinen Eigenschaften der Aufgabenumgebung übergehen, wie z. B. teilweise Beobachtbarkeit, langfristig, Unvorhersehbarkeit usw. und Fragen selbst, wenn Sie in der Lage sind, Komplettlösungen für diese Immobilien anzubieten. Wenn wir über diese Fähigkeit verfügen, sollte die allgemeine künstliche Intelligenz in der Lage sein, automatisch Aufgaben zu erledigen, die Menschen erledigen können, und dennoch die Fähigkeit haben, mehr Aufgaben zu erledigen. Obwohl es einige Tests (wie BigBench) gibt, die den Anspruch erheben, Allgemeingültigkeit zu testen, decken sie keine Aufgaben ab, die für Systeme der künstlichen Intelligenz unzugänglich sind, wie zum Beispiel „Können Sie einen Gravitationswellendetektor erfinden?“

Zhu Songchun: Vor ein paar Jahren dachten viele Menschen, dass das Erreichen allgemeiner künstlicher Intelligenz ein unerreichbares Ziel sei. Die jüngste Popularität von ChatGPT hat jedoch alle mit Erwartungen erfüllt, und es scheint, dass allgemeine künstliche Intelligenz in greifbare Nähe gerückt ist. Als ich das Beijing Institute of General Artificial Intelligence (BIGAI), eine neue Forschungs- und Entwicklungseinrichtung in China, gründete, entschied ich mich ausdrücklich dafür, AGI als Teil des Namens der Institution zu verwenden, um sie von spezialisierter künstlicher Intelligenz zu unterscheiden. Das Wort „Tong“ in Tongyuan setzt sich aus den drei Buchstaben „A“, „G“ und „I“ zusammen. Entsprechend der Aussprache des Wortes „tong“ nennen wir die allgemeine künstliche Intelligenz auch TongAI.

Allgemeine künstliche Intelligenz ist die ursprüngliche Absicht und das ultimative Ziel der Forschung im Bereich der künstlichen Intelligenz. Das Ziel besteht darin, einen allgemein intelligenten Agenten mit autonomen Wahrnehmungs-, Erkenntnis-, Entscheidungs-, Lern-, Ausführungs- und sozialen Kooperationsfähigkeiten zu realisieren, der im Einklang mit menschlichen Emotionen, Ethik und moralischen Konzepten steht. In den letzten 20 bis 30 Jahren haben Menschen jedoch riesige Mengen an geheimen Daten verwendet, um Aufgaben wie Gesichtserkennung, Zielerkennung und Textübersetzung nacheinander zu lösen. Dies hat die Frage aufgeworfen, wie viele Aufgaben möglich sind als universell angesehen werden?

Ich glaube, dass es drei Schlüsselvoraussetzungen gibt, um allgemeine künstliche Intelligenz zu erreichen. 1) Ein Generalagent ist in der Lage, unbegrenzte Aufgaben zu bewältigen, einschließlich solcher, die in komplexen und dynamischen physischen und sozialen Umgebungen nicht vordefiniert sind. 2) Ein Generalagent sollte autonom sein in der Lage, Aufgaben selbst zu generieren und zu erledigen, genau wie Menschen. 3) Ein Generalagent sollte ein Wertesystem haben, da seine Ziele durch Werte definiert sind. Intelligente Systeme werden durch kognitive Architekturen mit Wertesystemen angetrieben.

Mark Nitzberg: Glauben Sie, dass große Sprachmodelle (LLMs) und andere Grundtypen allgemeine künstliche Intelligenz erreichen können? In einem kürzlich von einem Professor der Stanford University verfassten Artikel wird behauptet, dass Sprachmodelle möglicherweise mentale Zustände haben, die mit denen eines 9-jährigen Kindes vergleichbar sind. Was halten Sie von dieser Aussage?

Zhu Songchun: Obwohl große Sprachmodelle einige erstaunliche Fortschritte gemacht haben, werden wir beim Vergleich der oben genannten drei Standards feststellen, dass große Sprachmodelle noch nicht die Anforderungen der allgemeinen künstlichen Intelligenz erfüllen .

1) Große Sprachmodelle verfügen nur über begrenzte Fähigkeiten bei der Verarbeitung von Aufgaben. Sie können nur Aufgaben im Textbereich bewältigen und nicht mit der physischen und sozialen Umgebung interagieren. Das bedeutet, dass Modelle wie ChatGPT die Bedeutung von Sprache nicht wirklich „verstehen“ können, weil sie keine Körper haben, um den physischen Raum zu erleben. Chinesische Philosophen haben seit langem das Konzept der „Einheit von Wissen und Handeln“ erkannt, das heißt, das „Wissen“ der Menschen über die Welt basiert auf „Handeln“. Dies ist auch der Schlüssel dafür, ob die allgemeine Intelligenz wirklich in die physische Welt und in die menschliche Gesellschaft eindringen kann. Nur wenn künstliche Agenten in die reale physische Welt und die menschliche Gesellschaft eingesetzt werden, können sie die physischen Beziehungen zwischen Dingen in der realen Welt und die sozialen Beziehungen zwischen verschiedenen intelligenten Agenten wirklich verstehen und lernen und so die „Einheit von Wissen und Handeln“ erreichen.

2) Große Sprachmodelle sind nicht autonom. Sie erfordern, dass der Mensch jede Aufgabe spezifisch definiert, genau wie ein „Riesenpapagei“, der nur trainierte Äußerungen nachahmen kann. Wirklich autonome Intelligenz sollte der „Krähenintelligenz“ ähneln. Krähen können Aufgaben autonom erledigen, die intelligenter sind als die heutigen KI-Systeme, die dieses Potenzial noch nicht haben.

3) Obwohl ChatGPT in großem Umfang an verschiedenen Textdatenkorpora, einschließlich Texten mit impliziten menschlichen Werten, trainiert wurde, verfügt es nicht über die Fähigkeit, menschliche Werte zu verstehen oder mit menschlichen Werten im Einklang zu stehen, d. h. es fehlt der sogenannte moralische Kompass.

Was die Entdeckung des Papiers betrifft, dass das Sprachmodell möglicherweise einen mentalen Zustand hat, der dem eines 9-jährigen Kindes entspricht, halte ich es für etwas übertrieben, dass das Papier durch einige experimentelle Tests eine Antwort finden kann 93 % der Fragen richtig, entspricht dem Niveau eines 9-jährigen Kindes. Aber wenn einige regelbasierte Maschinen ähnliche Tests bestehen können, können wir dann sagen, dass diese Maschinen über eine Theorie des Geistes verfügen? Auch wenn GPT diesen Test bestehen kann, spiegelt dies nur seine Fähigkeit wider, diesen Theory of Mind-Test zu bestehen, und bedeutet nicht, dass es über eine Theory of Mind verfügt. Gleichzeitig müssen wir auch über die Praxis der Verwendung dieser traditionellen Gedanken nachdenken Testaufgaben, um zu überprüfen, ob die Maschine eine Theorie des Geistes entwickelt hat. Ist sie streng und legal? Warum können Maschinen diese Aufgaben ohne Theorie des Geistes erledigen?

Stuart Russell: In einer Arbeit von 1948 stellte Turing das Problem, intelligente Aktionen aus einer riesigen Nachschlagetabelle zu generieren. Dies ist nicht praktikabel, denn wenn Sie 2000 Wörter generieren möchten, benötigen Sie eine Tabelle mit etwa 10^10000 Einträgen, um alle möglichen Sequenzen zu speichern, ebenso wie die Fenstergröße eines großen Sprachmodells, das Transformatoren verwendet. Ein solches System mag sehr intelligent erscheinen, tatsächlich fehlen ihm jedoch mentale Zustände und Denkprozesse (die Grundbedeutung klassischer Systeme der künstlichen Intelligenz).

Tatsächlich gibt es keine Beweise dafür, dass ChatGPT irgendeinen Geisteszustand besitzt, geschweige denn einen, der dem eines 9-jährigen Kindes ähnelt. LLMs sind nicht in der Lage, komplexe Verallgemeinerungen zu erlernen und auszudrücken, weshalb sie große Mengen an Textdaten benötigen, weit mehr, als ein 9-Jähriger bewältigen kann, und sie produzieren trotzdem Fehler. Es ist wie ein Schachprogramm, das Sequenzen ähnlicher Züge aus früheren Großmeisterpartien (z. B. d4, c6, Sc3 usw.) erkennt und dann den nächsten Zug in dieser Sequenz ausgibt. Auch wenn man es meistens als Meisterschachspieler bezeichnen würde, führt es gelegentlich illegale Züge aus, weil es das Brett oder die Figuren nicht kennt oder weiß, dass das Ziel darin besteht, den Gegner schachmatt zu setzen.

In gewisser Weise ist ChatGPT in jedem Bereich so. Wir sind nicht sicher, ob es einen Bereich gibt, den es wirklich versteht. Einige Fehler können möglicherweise behoben werden, dies ist jedoch so, als würden Sie Fehler in der Wertetabelle für logarithmische Funktionen beheben. Wenn jemand unter „log“ nur „den Wert in der Tabelle auf Seite 17“ versteht, wird das Problem durch Beheben des Tippfehlers nicht gelöst. Diese Tabelle deckt die Bedeutung und Definition von „Logarithmus“ noch nicht ab und kann daher überhaupt nicht abgeleitet werden. Das Erweitern der Tabellengröße um mehr Daten löst das Problem nicht an der Wurzel.

Mark Nitzberg: Stuart, Sie waren einer der Ersten, der uns vor den existenziellen Risiken allgemeiner künstlicher Intelligenz gewarnt hat, weil Sie dachten, es sei wie Kernenergie. Warum glauben Sie das? Wie können wir das verhindern? Matsuzumi, über welche Risiken künstlicher Intelligenz machen Sie sich am meisten Sorgen?

Stuart Russell: Tatsächlich war Turing einer der ersten, der gewarnt hat. Er sagte 1951: „Sobald eine Maschine anfängt zu denken, wird sie uns bald übertreffen. Daher sollten wir irgendwann damit rechnen, dass die Maschine in der Lage sein wird, sie zu beherrschen.“ Bald wird es schwierig sein, die Macht aufrechtzuerhalten, insbesondere wenn diese Agenten falsche oder unvollständige Ziele haben.

Wenn jemand es für alarmierend hält, diese Risiken jetzt in Betracht zu ziehen, können Sie ihn direkt fragen: Wie behält man die Macht angesichts einer Intelligenz, die mächtiger ist als Menschen, für immer? Ich würde gerne ihre Antworten hören. Darüber hinaus gibt es im Bereich der künstlichen Intelligenz immer noch einige Leute, die versuchen, das Problem zu umgehen und die Erreichbarkeit von AGI zu leugnen, ohne Beweise dafür vorzulegen.

Das EU-Gesetz über künstliche Intelligenz definiert ein Standardsystem für künstliche Intelligenz, das von Menschen definierte Ziele erreichen kann. Mir wurde gesagt, dass dieser Standard von der OECD stamme, und die OECD-Leute sagten mir, dass er aus einer früheren Version meines Lehrbuchs stamme. Nun, ich denke diese Definition eines Standard-KI-Systems ist grundsätzlich fehlerhaft, weil wir nicht ganz genau sagen können, was wir von der KI in der realen Welt erwarten und wie die Zukunft aussehen soll . Ein KI-System, das die falschen Ziele verfolgt, wird eine Zukunft herbeiführen, die wir nicht wollen.

Ein Beispiel sind Empfehlungssysteme in sozialen Medien: Empfehlungssysteme versuchen, die Klickraten oder das Engagement zu maximieren, und sie haben gelernt, dies zu erreichen, indem sie Menschen manipulieren und sie in eine vorhersehbarere und scheinbar extremere Version meiner selbst verwandeln. Wenn wir die KI „besser“ machen, werden sich die menschlichen Ergebnisse nur verschlechtern.

Stattdessen müssen wir KI-Systeme bauen, die 1) nur auf den Nutzen des Menschen abzielen und 2) deutlich machen, dass sie keine Ahnung haben, was das bedeutet. Da die KI die wahre Bedeutung menschlicher Interessen nicht versteht, muss sie über menschliche Vorlieben im Unklaren bleiben, um sicherzustellen, dass wir die Kontrolle darüber behalten . Maschinen sollten abgeschaltet werden können, wenn sie sich über menschliche Vorlieben nicht im Klaren sind. Sobald es keine Unsicherheit mehr über die Ziele der KI gibt, sind die Menschen diejenigen, die Fehler machen, und die Maschinen können nicht mehr ausgeschaltet werden.

Zhu Songchun:Wenn allgemeine künstliche Intelligenz Realität wird, könnte sie auf lange Sicht eine Bedrohung für die menschliche Existenz darstellen. Wenn wir auf die lange Geschichte der Intelligenzentwicklung zurückblicken, können wir schließen, dass die Geburt der allgemeinen künstlichen Intelligenz fast unvermeidlich ist.

Moderne wissenschaftliche Forschung zeigt, dass sich Lebensformen auf der Erde ständig weiterentwickeln, von anorganischer Materie über organische Materie, einzelne Zellen, mehrzellige Organismen bis hin zu Pflanzen, Tieren und schließlich zu intelligenten Lebewesen wie dem Menschen. Dies zeigt, dass es einen kontinuierlichen Evolutionsprozess von „physisch“ zu „intelligent“ gibt. Wo ist die Grenze zwischen unbelebten Objekten und lebender Intelligenz? Diese Frage ist sehr wichtig, denn es geht darum, die „intelligenten Agenten“ zu verstehen und zu definieren, die in der zukünftigen Gesellschaft mit uns koexistieren werden. Ich denke, diese Antwort hängt mit dem „Grad des Lebens“ zusammen, von unbelebten bis hin zu einfachen Lebensformen zu komplexen intelligenten Agenten. „Lebensgrad“ „Intelligenz“ wird immer größer und „Intelligenz“ wird immer komplexer. Wir haben keinen Grund zu der Annahme, dass der Mensch das Ende sein wird Evolutionsspektrum Dies deutet auch darauf hin, dass es möglich ist, dass die allgemeine Intelligenz in Zukunft den Menschen übertreffen wird.

Um zu verhindern, dass zukünftige allgemeine künstliche Intelligenz eine Bedrohung für die Menschheit darstellt, können wir den Fähigkeitsraum und den Werteraum der allgemeinen Intelligenz schrittweise freigeben. Genau wie wenn wir einem Roboter gegenüberstehen, haben wir ihn zunächst in einen „Käfig“ gesperrt und langsam seine Berechtigungen geöffnet. Nun sind auf bestimmten Straßenabschnitten fahrerlose Fahrzeuge aufgetaucht. Wir können zunächst die anwendbaren Anlässe und Aktionsräume des Systems der künstlichen Intelligenz auf bestimmte Bereiche beschränken. Da unser Vertrauen in Maschinen zunimmt und wir uns vergewissert haben, dass KI-Systeme sicher und kontrollierbar sind, werden wir ihnen nach und nach mehr Raum geben. Darüber hinaus sollten wir die Transparenz in algorithmischen Entscheidungsprozessen fördern. Wenn wir die kognitive Architektur allgemeiner künstlicher Intelligenz explizit darstellen können, also wissen, wie sie funktioniert, können wir sie besser steuern.

Mark Nitzberg: Stuart, welche Richtungen können in Ihrer Forschungsarbeit als ausgerichtete Forschung angesehen werden?

Stuart Russell: Unser Hauptziel bei CHAI ist es, die oben genannte Vision zu verwirklichen, nämlich ein künstliches Intelligenzsystem aufzubauen, das mit Zielunsicherheiten umgehen kann. Bestehende Methoden, vielleicht mit Ausnahme des Nachahmungslernens, gehen alle im Voraus von einem festen, bekannten Ziel für das System der künstlichen Intelligenz aus, sodass diese Methoden möglicherweise neu gestaltet werden müssen.

Kurz gesagt, wir versuchen, ein System zu simulieren, in dem mehrere Menschen und mehrere Maschinen interagieren. Da jeder seine eigenen Vorlieben hat, die Maschine aber viele Menschen beeinflussen kann, definieren wir die Nutzenfunktion der Maschine als die Summe der Nutzenfunktionen der Menschen. Allerdings stehen wir vor drei Problemen.

Die erste Frage ist, wie man die Vorlieben verschiedener Menschen aggregieren kann, damit die Maschine die Bedürfnisse der meisten Menschen verstehen und erfüllen kann. Es wurde vermutet, dass die Addition eine gute Aggregationsfunktion sein könnte, da jeder gleich gewichtet ist und ein gutes Formgefühl hat, was in der Arbeit des Ökonomen John Harsanyi und anderer gut demonstriert wird. Aber es muss andere Perspektiven geben.

Die zweite Frage ist, wie wir den Reichtum der Präferenzstruktur charakterisieren, also die Reihenfolge der Verteilungen über alle möglichen Zukünfte des Universums. Dabei handelt es sich um sehr komplexe Datenstrukturen, die weder im Menschen noch explizit sind Gehirn oder die Bodendarstellung. Deshalb brauchen wir Möglichkeiten, Präferenzen effizient zu sortieren, zu zerlegen und zu kombinieren.

Es gibt derzeit einige KI-Forschungsversuche, sogenannte „CP-Netze“ zur Darstellung einiger komplexer Nutzenfunktionen zu verwenden. Die Art und Weise, wie CP-Netze Nutzenfunktionen mit mehreren Attributen zerlegen, ist die gleiche wie Bayes’sche Netze für komplexe Mehrfachvariablen Wahrscheinlichkeitsmodelle funktionieren auf die gleiche Weise. Künstliche Intelligenz untersucht jedoch nicht wirklich den Inhalt des menschlichen Glücks, was angesichts des Anspruchs dieses Fachgebiets, Menschen zu helfen, überraschend ist. Es gibt tatsächlich akademische Gemeinschaften, die sich in Bereichen wie Wirtschaft, Soziologie, Entwicklung usw. mit dem menschlichen Wohlbefinden befassen und dazu neigen, Listen mit Faktoren wie Gesundheit, Sicherheit, Wohnen, Ernährung usw. zu erstellen. Diese Listen dienen in erster Linie dazu, Prioritäten zu kommunizieren Der Rest der Menschheit und die öffentliche Ordnung berücksichtigen möglicherweise nicht viele „offensichtliche“ unausgesprochene Präferenzen, wie z. B. den Wunsch, körperlich gesund zu sein. Meines Wissens haben diese Forscher noch keine wissenschaftliche Theorie zur Vorhersage menschlichen Verhaltens entwickelt, aber für die KI benötigen wir die vollständige menschliche Präferenzstruktur, einschließlich aller möglichen unausgesprochenen Präferenzen, wenn wir etwas Wichtiges übersehen haben, das Probleme verursachen könnte.

Die dritte Frage ist, wie man aus menschlichem Verhalten auf Präferenzen schließen und die Plastizität menschlicher Präferenzen charakterisieren kann. Wenn sich Vorlieben im Laufe der Zeit ändern, für wen arbeitet KI – Sie heute oder Sie morgen? Wir wollen nicht, dass künstliche Intelligenz unsere Präferenzen ändert, um sie an leicht erreichbare Weltzustände anzupassen, was dazu führen wird, dass die Welt an Vielfalt verliert.

Zusätzlich zu diesen grundlegenden Forschungsfragen denken wir auch darüber nach, wie wir all diese Techniken der künstlichen Intelligenz (Suchalgorithmen, Planungsalgorithmen, dynamische Programmieralgorithmen, Reinforcement Learning usw.) auf einer breiteren Basis rekonstruieren können. Ein Schlüsselmerkmal des neuen Systems ist der Fluss von Präferenzinformationen von Menschen zu Maschinen, während das System läuft. Das ist in der realen Welt ganz normal. Wir bitten zum Beispiel einen Taxifahrer, „uns zum Flughafen zu bringen“. Dies ist tatsächlich ein umfassenderes Ziel als unser wahres Ziel. Als wir eine Meile entfernt waren, fragte uns der Fahrer, welches Terminal wir brauchten. Wenn wir näher kommen, fragt der Fahrer möglicherweise, welche Fluggesellschaft verfügbar ist, um uns zum richtigen Gate zu bringen. (Aber nicht genau, wie viele Millimeter von der Tür entfernt!) Wir müssen also die Form der Unsicherheit und Präferenzübertragung definieren, die für eine bestimmte Klasse von Algorithmen am besten geeignet ist. Beispielsweise verwendet ein Suchalgorithmus eine Kostenfunktion, damit die Maschine dies tun kann setzt Grenzen für diese Funktion voraus und verfeinert die Grenzen, indem er Menschen fragt, welche von zwei Handlungsabfolgen angemessener ist.

... und menschliche Vorlieben, dann entscheiden Sie, was zu tun ist. Das ist möglicherweise nicht der Fall.

Mark Nitzberg: Song Chun, bitte stellen Sie die von Ihnen durchgeführte Forschung zur Wertausrichtung vor. Zhu Songchun: Wenn wir über Werteausrichtung sprechen, müssen wir zuerst über „Wert“ sprechen. Ich denke, die aktuelle Forschung im Bereich der künstlichen Intelligenz sollte sich von datengesteuert zu wertgesteuert ändern. Verschiedene intelligente Verhaltensweisen von Menschen werden durch Werte bestimmt, und Menschen können Werte schnell verstehen und lernen. Wenn Sie beispielsweise auf einem Stuhl sitzen, können wir durch die Kraftanalyse des Kontakts zwischen Stuhl und Körper den Gleichgewichtszustand beobachten und so implizit auf den Wert „Komfort“ schließen. Dieser Wert lässt sich vielleicht nicht genau mit Worten beschreiben, aber er kann durch die Interaktion mit dem Stuhl ausgedrückt werden. Wir können auch durch die Art und Weise, wie sie ihre Kleidung falten, etwas über den ästhetischen Wert der Menschen erfahren. Darüber hinaus denke ich, dass das Wertesystem über einen einheitlichen Satz von Darstellungen verfügt und der aktuelle Reichtum an Präferenzen auf die Zuordnung einheitlicher Werte zu unterschiedlichen Bedingungen zurückzuführen ist. Unser Wert ändert sich je nach Situation. Wenn Sie beispielsweise auf den Bus warten, möchten Sie möglicherweise länger bleiben, damit Sie einsteigen können Möglicherweise möchten Sie, dass die Tür sofort geschlossen wird. KI-Systeme müssen in der Lage sein, sich schnell an Veränderungen unserer Vorlieben anzupassen, daher ist eine wertorientierte kognitive Architektur für KI unerlässlich. Um allgemeine Intelligenz auf der menschlichen kognitiven Ebene zu erreichen, haben wir das Element der Werteausrichtung in unsere BIGAI-Forschung einbezogen und ein Mensch-Computer-Interaktionssystem mit vier Ausrichtungen aufgebaut. Die erste Ausrichtung ist eine gemeinsame Darstellung, einschließlich eines gemeinsamen Verständnisses der Welt. Bei der zweiten Ausrichtung handelt es sich um gemeinsames Kernwissen wie gesunden Menschenverstand in Physik, Kausalketten, Logik usw. Die dritte Ausrichtung sind gemeinsame soziale Normen, die vorschreiben, dass KI den Normen der menschlichen Gesellschaft folgen und angemessenes Verhalten beibehalten soll. Die vierte Ausrichtung ist der gemeinsame Wert, dass KI mit menschlichen ethischen Grundsätzen in Einklang gebracht werden muss. Wir haben eine bidirektionale Mensch-Roboter-Wertausrichtungsstudie in Echtzeit veröffentlicht. Diese Forschung schlägt ein erklärbares künstliches Intelligenzsystem vor. In diesem System leitet eine Gruppe von Robotern durch Echtzeitinteraktion mit dem Benutzer und Benutzerfeedback die Wertziele des Benutzers ab und vermittelt dem Benutzer gleichzeitig seinen Entscheidungsprozess durch „Erklärungen“, damit der Benutzer den Wert versteht Grundlage für die Beurteilung des Roboters. Darüber hinaus generiert das System Erklärungen, die für Benutzer leichter verständlich sind, indem es auf die intrinsischen Wertpräferenzen des Benutzers schließt und die beste Art der Erklärung vorhersagt. Mark Nitzberg: Welche Eigenschaften von KI-Systemen lassen uns zu dem Schluss kommen, dass sie nicht zu allgemeiner künstlicher Intelligenz führen werden? Zhu Songchun: Wie beurteilen wir, ob eine KI eine allgemeine künstliche Intelligenz ist? Einer der wichtigen Faktoren ist, wie sehr wir ihr vertrauen. Vertrauen hat zwei Ebenen: Die eine ist das Vertrauen in die Fähigkeiten der KI und die andere das Vertrauen in die Frage, ob KI den Emotionen und Werten der Menschen förderlich ist. Heutige KI-Systeme können beispielsweise Bilder sehr gut erkennen, aber um Vertrauen aufzubauen, müssen sie erklärbar und verständlich sein. Manche Technologien sind sehr leistungsfähig, aber wenn sie nicht erklärt werden können, gelten sie als nicht vertrauenswürdig. Dies ist besonders wichtig in Bereichen wie Waffen oder Luftfahrtsystemen, wo die Kosten von Fehlern hoch sind. In diesem Fall ist die emotionale Dimension des Vertrauens wichtiger und KIs müssen erklären, wie sie Entscheidungen treffen, um das Vertrauen der Menschen zu erlangen. Daher müssen wir das gegenseitige Verständnis durch Iteration, Kommunikation und Zusammenarbeit zwischen Menschen und Maschinen verbessern und dann einen Konsens erzielen und „gerechtfertigtes Vertrauen“ erzeugen. Stuart Russell: Aktuelle KI-Systeme sind nicht universell, weil Schaltkreise die Universalität nicht gut erfassen. Wir haben dies bereits daran gesehen, dass große Sprachmodelle Schwierigkeiten haben, die Grundregeln der Arithmetik zu erlernen. Unsere neuesten Untersuchungen zeigen, dass Go-Systeme mit künstlicher Intelligenz, die zuvor Menschen besiegt haben, die Konzepte „großer Drache“ und „Leben oder Tod“ trotz Millionen von Beispielen nicht richtig verstehen können. besiegte das Go-Programm. Wenn wir davon überzeugt sind, dass künstliche Intelligenz der Menschheit von Nutzen sein wird, dann müssen wir wissen, wie sie funktioniert. Wir müssen künstliche Intelligenzsysteme auf einem semantisch zusammensetzbaren Substrat aufbauen, das durch explizite Logik und Wahrscheinlichkeitstheorie unterstützt wird, und so als gute Grundlage für die Erreichung allgemeiner künstlicher Intelligenz in der Zukunft dienen. Ein möglicher Weg, ein solches System zu schaffen, ist die probabilistische Programmierung, etwas, das wir bei CHAI kürzlich erforschen wollten. Es hat mich ermutigt zu sehen, wie Matsuzumi mit BIGAI eine ähnliche Richtung einschlägt.

Das obige ist der detaillierte Inhalt vonIn Bezug auf AGI und ChatGPT sind Stuart Russell und Zhu Songchun dieser Meinung. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1376

1376

52

52

Bytedance Cutting führt SVIP-Supermitgliedschaft ein: 499 Yuan für ein fortlaufendes Jahresabonnement, das eine Vielzahl von KI-Funktionen bietet

Jun 28, 2024 am 03:51 AM

Bytedance Cutting führt SVIP-Supermitgliedschaft ein: 499 Yuan für ein fortlaufendes Jahresabonnement, das eine Vielzahl von KI-Funktionen bietet

Jun 28, 2024 am 03:51 AM

Diese Seite berichtete am 27. Juni, dass Jianying eine von FaceMeng Technology, einer Tochtergesellschaft von ByteDance, entwickelte Videobearbeitungssoftware ist, die auf der Douyin-Plattform basiert und grundsätzlich kurze Videoinhalte für Benutzer der Plattform produziert Windows, MacOS und andere Betriebssysteme. Jianying kündigte offiziell die Aktualisierung seines Mitgliedschaftssystems an und führte ein neues SVIP ein, das eine Vielzahl von KI-Schwarztechnologien umfasst, wie z. B. intelligente Übersetzung, intelligente Hervorhebung, intelligente Verpackung, digitale menschliche Synthese usw. Preislich beträgt die monatliche Gebühr für das Clipping von SVIP 79 Yuan, die Jahresgebühr 599 Yuan (Hinweis auf dieser Website: entspricht 49,9 Yuan pro Monat), das fortlaufende Monatsabonnement beträgt 59 Yuan pro Monat und das fortlaufende Jahresabonnement beträgt 499 Yuan pro Jahr (entspricht 41,6 Yuan pro Monat). Darüber hinaus erklärte der Cut-Beamte auch, dass diejenigen, die den ursprünglichen VIP abonniert haben, das Benutzererlebnis verbessern sollen

Kontexterweiterter KI-Codierungsassistent mit Rag und Sem-Rag

Jun 10, 2024 am 11:08 AM

Kontexterweiterter KI-Codierungsassistent mit Rag und Sem-Rag

Jun 10, 2024 am 11:08 AM

Verbessern Sie die Produktivität, Effizienz und Genauigkeit der Entwickler, indem Sie eine abrufgestützte Generierung und ein semantisches Gedächtnis in KI-Codierungsassistenten integrieren. Übersetzt aus EnhancingAICodingAssistantswithContextUsingRAGandSEM-RAG, Autor JanakiramMSV. Obwohl grundlegende KI-Programmierassistenten natürlich hilfreich sind, können sie oft nicht die relevantesten und korrektesten Codevorschläge liefern, da sie auf einem allgemeinen Verständnis der Softwaresprache und den gängigsten Mustern beim Schreiben von Software basieren. Der von diesen Coding-Assistenten generierte Code eignet sich zur Lösung der von ihnen zu lösenden Probleme, entspricht jedoch häufig nicht den Coding-Standards, -Konventionen und -Stilen der einzelnen Teams. Dabei entstehen häufig Vorschläge, die geändert oder verfeinert werden müssen, damit der Code in die Anwendung übernommen wird

Sieben coole technische Interviewfragen für GenAI und LLM

Jun 07, 2024 am 10:06 AM

Sieben coole technische Interviewfragen für GenAI und LLM

Jun 07, 2024 am 10:06 AM

Um mehr über AIGC zu erfahren, besuchen Sie bitte: 51CTOAI.x Community https://www.51cto.com/aigc/Translator|Jingyan Reviewer|Chonglou unterscheidet sich von der traditionellen Fragendatenbank, die überall im Internet zu sehen ist erfordert einen Blick über den Tellerrand hinaus. Large Language Models (LLMs) gewinnen in den Bereichen Datenwissenschaft, generative künstliche Intelligenz (GenAI) und künstliche Intelligenz zunehmend an Bedeutung. Diese komplexen Algorithmen verbessern die menschlichen Fähigkeiten, treiben Effizienz und Innovation in vielen Branchen voran und werden zum Schlüssel für Unternehmen, um wettbewerbsfähig zu bleiben. LLM hat ein breites Anwendungsspektrum und kann in Bereichen wie der Verarbeitung natürlicher Sprache, der Textgenerierung, der Spracherkennung und Empfehlungssystemen eingesetzt werden. Durch das Lernen aus großen Datenmengen ist LLM in der Lage, Text zu generieren

Kann LLM durch Feinabstimmung wirklich neue Dinge lernen: Die Einführung neuen Wissens kann dazu führen, dass das Modell mehr Halluzinationen hervorruft

Jun 11, 2024 pm 03:57 PM

Kann LLM durch Feinabstimmung wirklich neue Dinge lernen: Die Einführung neuen Wissens kann dazu führen, dass das Modell mehr Halluzinationen hervorruft

Jun 11, 2024 pm 03:57 PM

Large Language Models (LLMs) werden auf riesigen Textdatenbanken trainiert und erwerben dort große Mengen an realem Wissen. Dieses Wissen wird in ihre Parameter eingebettet und kann dann bei Bedarf genutzt werden. Das Wissen über diese Modelle wird am Ende der Ausbildung „verdinglicht“. Am Ende des Vortrainings hört das Modell tatsächlich auf zu lernen. Richten Sie das Modell aus oder verfeinern Sie es, um zu erfahren, wie Sie dieses Wissen nutzen und natürlicher auf Benutzerfragen reagieren können. Aber manchmal reicht Modellwissen nicht aus, und obwohl das Modell über RAG auf externe Inhalte zugreifen kann, wird es als vorteilhaft angesehen, das Modell durch Feinabstimmung an neue Domänen anzupassen. Diese Feinabstimmung erfolgt mithilfe von Eingaben menschlicher Annotatoren oder anderer LLM-Kreationen, wobei das Modell auf zusätzliches Wissen aus der realen Welt trifft und dieses integriert

Um ein neues wissenschaftliches und komplexes Frage-Antwort-Benchmark- und Bewertungssystem für große Modelle bereitzustellen, haben UNSW, Argonne, die University of Chicago und andere Institutionen gemeinsam das SciQAG-Framework eingeführt

Jul 25, 2024 am 06:42 AM

Um ein neues wissenschaftliches und komplexes Frage-Antwort-Benchmark- und Bewertungssystem für große Modelle bereitzustellen, haben UNSW, Argonne, die University of Chicago und andere Institutionen gemeinsam das SciQAG-Framework eingeführt

Jul 25, 2024 am 06:42 AM

Herausgeber | Der Frage-Antwort-Datensatz (QA) von ScienceAI spielt eine entscheidende Rolle bei der Förderung der Forschung zur Verarbeitung natürlicher Sprache (NLP). Hochwertige QS-Datensätze können nicht nur zur Feinabstimmung von Modellen verwendet werden, sondern auch effektiv die Fähigkeiten großer Sprachmodelle (LLMs) bewerten, insbesondere die Fähigkeit, wissenschaftliche Erkenntnisse zu verstehen und zu begründen. Obwohl es derzeit viele wissenschaftliche QS-Datensätze aus den Bereichen Medizin, Chemie, Biologie und anderen Bereichen gibt, weisen diese Datensätze immer noch einige Mängel auf. Erstens ist das Datenformular relativ einfach, die meisten davon sind Multiple-Choice-Fragen. Sie sind leicht auszuwerten, schränken jedoch den Antwortauswahlbereich des Modells ein und können die Fähigkeit des Modells zur Beantwortung wissenschaftlicher Fragen nicht vollständig testen. Im Gegensatz dazu offene Fragen und Antworten

Fünf Schulen des maschinellen Lernens, die Sie nicht kennen

Jun 05, 2024 pm 08:51 PM

Fünf Schulen des maschinellen Lernens, die Sie nicht kennen

Jun 05, 2024 pm 08:51 PM

Maschinelles Lernen ist ein wichtiger Zweig der künstlichen Intelligenz, der Computern die Möglichkeit gibt, aus Daten zu lernen und ihre Fähigkeiten zu verbessern, ohne explizit programmiert zu werden. Maschinelles Lernen hat ein breites Anwendungsspektrum in verschiedenen Bereichen, von der Bilderkennung und der Verarbeitung natürlicher Sprache bis hin zu Empfehlungssystemen und Betrugserkennung, und es verändert unsere Lebensweise. Im Bereich des maschinellen Lernens gibt es viele verschiedene Methoden und Theorien, von denen die fünf einflussreichsten Methoden als „Fünf Schulen des maschinellen Lernens“ bezeichnet werden. Die fünf Hauptschulen sind die symbolische Schule, die konnektionistische Schule, die evolutionäre Schule, die Bayes'sche Schule und die Analogieschule. 1. Der Symbolismus, auch Symbolismus genannt, betont die Verwendung von Symbolen zum logischen Denken und zum Ausdruck von Wissen. Diese Denkrichtung glaubt, dass Lernen ein Prozess der umgekehrten Schlussfolgerung durch das Vorhandene ist

SOTA Performance, eine multimodale KI-Methode zur Vorhersage der Protein-Ligand-Affinität in Xiamen, kombiniert erstmals molekulare Oberflächeninformationen

Jul 17, 2024 pm 06:37 PM

SOTA Performance, eine multimodale KI-Methode zur Vorhersage der Protein-Ligand-Affinität in Xiamen, kombiniert erstmals molekulare Oberflächeninformationen

Jul 17, 2024 pm 06:37 PM

Herausgeber |. KX Im Bereich der Arzneimittelforschung und -entwicklung ist die genaue und effektive Vorhersage der Bindungsaffinität von Proteinen und Liganden für das Arzneimittelscreening und die Arzneimitteloptimierung von entscheidender Bedeutung. Aktuelle Studien berücksichtigen jedoch nicht die wichtige Rolle molekularer Oberflächeninformationen bei Protein-Ligand-Wechselwirkungen. Auf dieser Grundlage schlugen Forscher der Universität Xiamen ein neuartiges Framework zur multimodalen Merkmalsextraktion (MFE) vor, das erstmals Informationen über Proteinoberfläche, 3D-Struktur und -Sequenz kombiniert und einen Kreuzaufmerksamkeitsmechanismus verwendet, um verschiedene Modalitäten zu vergleichen Ausrichtung. Experimentelle Ergebnisse zeigen, dass diese Methode bei der Vorhersage von Protein-Ligand-Bindungsaffinitäten Spitzenleistungen erbringt. Darüber hinaus belegen Ablationsstudien die Wirksamkeit und Notwendigkeit der Proteinoberflächeninformation und der multimodalen Merkmalsausrichtung innerhalb dieses Rahmens. Verwandte Forschungen beginnen mit „S

GlobalFoundries erschließt Märkte wie KI und erwirbt die Galliumnitrid-Technologie von Tagore Technology und zugehörige Teams

Jul 15, 2024 pm 12:21 PM

GlobalFoundries erschließt Märkte wie KI und erwirbt die Galliumnitrid-Technologie von Tagore Technology und zugehörige Teams

Jul 15, 2024 pm 12:21 PM

Laut Nachrichten dieser Website vom 5. Juli veröffentlichte GlobalFoundries am 1. Juli dieses Jahres eine Pressemitteilung, in der die Übernahme der Power-Galliumnitrid (GaN)-Technologie und des Portfolios an geistigem Eigentum von Tagore Technology angekündigt wurde, in der Hoffnung, seinen Marktanteil in den Bereichen Automobile und Internet auszubauen Anwendungsbereiche für Rechenzentren mit künstlicher Intelligenz, um höhere Effizienz und bessere Leistung zu erforschen. Da sich Technologien wie generative künstliche Intelligenz (GenerativeAI) in der digitalen Welt weiterentwickeln, ist Galliumnitrid (GaN) zu einer Schlüssellösung für nachhaltiges und effizientes Energiemanagement, insbesondere in Rechenzentren, geworden. Auf dieser Website wurde die offizielle Ankündigung zitiert, dass sich das Ingenieurteam von Tagore Technology im Rahmen dieser Übernahme mit GF zusammenschließen wird, um die Galliumnitrid-Technologie weiterzuentwickeln. G