Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Wie weit hat sich Transformer im Bereich Reinforcement Learning entwickelt? Die Tsinghua-Universität, die Peking-Universität und andere haben gemeinsam eine Rezension von TransformRL veröffentlicht

Wie weit hat sich Transformer im Bereich Reinforcement Learning entwickelt? Die Tsinghua-Universität, die Peking-Universität und andere haben gemeinsam eine Rezension von TransformRL veröffentlicht

Wie weit hat sich Transformer im Bereich Reinforcement Learning entwickelt? Die Tsinghua-Universität, die Peking-Universität und andere haben gemeinsam eine Rezension von TransformRL veröffentlicht

Reinforcement Learning (RL) bietet eine mathematische Form für sequentielle Entscheidungsfindung, und auch Deep Reinforcement Learning (DRL) hat in den letzten Jahren große Fortschritte gemacht. Probleme mit der Stichprobeneffizienz behindern jedoch die weit verbreitete Anwendung von Deep-Reinforcement-Learning-Methoden in der realen Welt. Um dieses Problem zu lösen, besteht ein wirksamer Mechanismus darin, eine induktive Vorspannung in das DRL-Framework einzuführen.

Beim Deep Reinforcement Learning sind Funktionsnäherungen sehr wichtig. Im Vergleich zum Architekturdesign beim überwachten Lernen (Supervised Learning, SL) werden die Architekturdesignprobleme beim DRL jedoch immer noch selten untersucht. Die meisten bestehenden Arbeiten zu RL-Architekturen wurden von der betreuten/halbüberwachten Lerngemeinschaft vorangetrieben. Bei der Verarbeitung von Eingaben auf der Grundlage hochdimensionaler Bilder in DRL besteht beispielsweise die Einführung von Faltungs-Neuronalen Netzen (CNN) [LeCun et al., 1998; Mnih et al., 2015]; Beobachtbarkeit) Ein gängiger Ansatz für Bilder ist die Einführung rekurrenter neuronaler Netze (RNN) [Hochreiter und Schmidhuber, 1997; Hausknecht und Stone, 2015].

In den letzten Jahren hat die Transformer-Architektur [Vaswani et al., 2017] eine bessere Leistung als CNN und RNN gezeigt und ist bei immer mehr SL-Aufgaben zu einem Lernparadigma geworden [Devlin et al., 2018; Dosovitskiy et al., 2020; Dong et al., 2018]. Die Transformer-Architektur unterstützt die Modellierung langfristiger Abhängigkeiten und verfügt über eine hervorragende Skalierbarkeit [Khan et al., 2022]. Inspiriert durch den Erfolg von SL haben die Menschen ein starkes Interesse daran entwickelt, Transformer auf das verstärkende Lernen anzuwenden, in der Hoffnung, die Vorteile von Transformer auf den Bereich RL anzuwenden. Die Verwendung von

Transformer in RL lässt sich auf eine Studie von Zambaldi et al. aus dem Jahr 2018 zurückführen, in der der Selbstaufmerksamkeitsmechanismus für das relationale Denken strukturierter Zustandsdarstellungen verwendet wurde. Anschließend versuchten viele Forscher, die Selbstaufmerksamkeit auf das Repräsentationslernen anzuwenden, um Beziehungen zwischen Entitäten für ein besseres politisches Lernen zu extrahieren [Vinyals et al., 2019;

Zusätzlich zur Verwendung von Transformer für das Repräsentationslernen wurde Transformer in früheren Arbeiten auch zur Erfassung multitemporaler Abhängigkeiten verwendet, um Probleme mit der teilweisen Beobachtbarkeit zu lösen [Parisotto et al., 2020; Parisotto und Salakhutdinov, 2021]. Offline-RL [Levine et al., 2020] hat wegen seiner Fähigkeit, große Offline-Datensätze zu nutzen, Aufmerksamkeit erregt. Inspiriert durch Offline-RL zeigen neuere Untersuchungen, dass die Transformer-Struktur direkt als Modell für die sequentielle Entscheidungsfindung verwendet werden kann [Chen et al., 2021] und auf mehrere Aufgaben und Bereiche verallgemeinert werden kann [Lee et al ., 2022; Carroll et al., 2022].

Tatsächlich steht die Verwendung von Transformer als Funktionsnäherung beim Reinforcement Learning vor einigen besonderen Herausforderungen, darunter:

- Die Trainingsdaten eines Reinforcement Learning Agents sind normalerweise eine Funktion der aktuellen Richtlinie, die eine Funktion von ist Die aktuelle Richtlinie beim Lernen von Transformer führt zu Nichtstationarität.

- Bestehende RL-Algorithmen reagieren normalerweise sehr empfindlich auf Designentscheidungen während des Trainingsprozesses, einschließlich Modellarchitektur und Modellkapazität [Henderson et al., 2018]; Transformator-basierte Architekturen unterliegen häufig hohen Rechen- und Speicherkosten, was Training und Inferenz im RL-Lernprozess teuer macht.

- In der KI für Videospiele hängt beispielsweise die Effizienz der Stichprobengenerierung (die die Trainingsleistung in hohem Maße beeinflusst) vom Rechenaufwand des RL-Richtliniennetzwerks und des Wertnetzwerks ab [Ye et al., 2020a ; Berner et al., 2019].

Um die Entwicklung des Bereichs des Verstärkungslernens besser voranzutreiben, haben Forscher der Tsinghua-Universität, der Peking-Universität, des Zhiyuan Artificial Intelligence Research Institute und von Tencent gemeinsam einen Übersichtsartikel zu Transformer (d. h. TransformRL) im Verstärkungslernen veröffentlicht, fasst die zusammen aktuelle bestehende Methoden und Herausforderungen und diskutiert zukünftige Entwicklungsrichtungen. Der Autor ist davon überzeugt, dass TransformRL eine wichtige Rolle bei der Stimulierung des Potenzials des verstärkenden Lernens spielen wird.

- Kapitel 2 stellt das Hintergrundwissen von RL und Transformer vor und stellt dann kurz vor, wie die beiden kombiniert werden; 3 beschreibt die Entwicklung der Netzwerkarchitektur in RL und die seit langem bestehenden Herausforderungen in RL, die eine umfassende Erforschung der Transformer-Architektur behindert haben klassifizierte und aktuelle repräsentative Methoden werden diskutiert;

- Kapitel 5 fasst mögliche zukünftige Forschungsrichtungen zusammen und zeigt sie auf.

- Der Kerninhalt beginnt mit Kapitel 3 des Papiers.

- Netzwerkarchitektur in RL

Die Architektur des Funktionsnähers

von Deep Q- Netzwerk Seit der Pionierarbeit von [Mnih et al., 2015] wurden viele Anstrengungen zur Netzwerkarchitektur von DRL-Agenten unternommen. Verbesserungen der Netzwerkarchitektur beim Reinforcement Learning werden hauptsächlich in zwei Kategorien unterteilt.

Der erste Typ besteht darin, neue Strukturen zu entwerfen und die induktive RL-Vorspannung zu kombinieren, um die Schwierigkeit von Trainingsstrategien oder Wertfunktionen zu verringern. Beispielsweise schlugen [Wang et al. 2016] eine Duell-Netzwerkarchitektur vor, bei der ein Netzwerk für die Zustandswertfunktion und das andere für die zustandsbezogene Aktionsvorteilsfunktion verwendet wird. Dieses Architekturdesign kombiniert induktive Voreingenommenheit.

Der andere Typ besteht darin, zu untersuchen, ob häufig verwendete neuronale Netzwerktechniken (wie Regularisierung, Restverbindung (Verbindung überspringen), Batch-Normalisierung) auf RL angewendet werden können. Beispielsweise haben [Ota et al. 2020] herausgefunden, dass die Erhöhung der Eingabedimension bei gleichzeitiger Verwendung eines Online-Feature-Extraktors zur Verbesserung der Zustandsdarstellung dazu beitragen kann, die Leistung und Stichprobeneffizienz von DRL-Algorithmen zu verbessern. [Sinha et al. 2020] schlugen eine äußerst dichte Architektur für DRL-Agenten vor, die Restverbindungen für effizientes Lernen und induktive Verzerrungen nutzt, um das Problem der Datenverarbeitungsungleichheit zu lindern. [Ota et al. 2021] nutzen DenseNet [Huang et al., 2017] und entkoppeltes Repräsentationslernen, um den Informationsfluss und die Gradienten in großen Netzwerken zu verbessern. Aufgrund der überlegenen Leistung von Transformer haben Forscher kürzlich versucht, die Transformer-Architektur auf Richtlinienoptimierungsalgorithmen anzuwenden, stellten jedoch fest, dass gewöhnliche Transformer-Designs bei RL-Aufgaben keine ideale Leistung erzielen können [Parisotto et al., 2020].

Angesichts der Herausforderungen

Obwohl in den letzten Jahren basierend auf Die Transformer-Architektur hat im SL-Bereich große Fortschritte gemacht, aber die Anwendung von Transformer auf RL ist nicht einfach. Tatsächlich gibt es mehrere einzigartige Herausforderungen.

Aus RL-Sicht weisen viele Studien darauf hin, dass bestehende RL-Algorithmen sehr empfindlich auf die Architektur tiefer neuronaler Netze reagieren [Henderson et al., 2018; Engstrom et al ., 2019; Andrychowicz et al., 2020]. Erstens führt der Paradigmenwechsel zwischen Datenerfassung und Richtlinienoptimierung im RL zu Instabilität im Training. Zweitens reagieren RL-Algorithmen oft sehr empfindlich auf Designentscheidungen, die während des Trainings getroffen werden. [Emmons et al. 2021] zeigen, dass eine sorgfältige Auswahl der Modellarchitektur und Regularisierung für die Leistung von DRL-Agenten entscheidend ist.

Aus Transformer-Sicht haben Transformer-basierte Architekturen Probleme mit großem Speicherbedarf und hoher Latenz, was ihre effiziente Bereitstellung und Inferenz behindert. In letzter Zeit wurde viel Forschung zu Verbesserungen der Rechen- und Speichereffizienz der ursprünglichen Transformer-Architektur betrieben, der Großteil dieser Arbeit konzentrierte sich jedoch auf den SL-Bereich.

Im Bereich RL schlugen Parisotto und Salakhutdinov vor, das auf einem Transformator mit großer Kapazität basierende Lernmodell in ein Aktormodell mit kleiner Kapazität umzuwandeln, um die hohe Inferenzverzögerung zu vermeiden von Transformer. Allerdings ist dieser Ansatz immer noch speicher- und rechenintensiv. Derzeit werden effiziente oder leichte Transformatoren von der RL-Community nicht vollständig erforscht.

Transformer im Reinforcement Learning

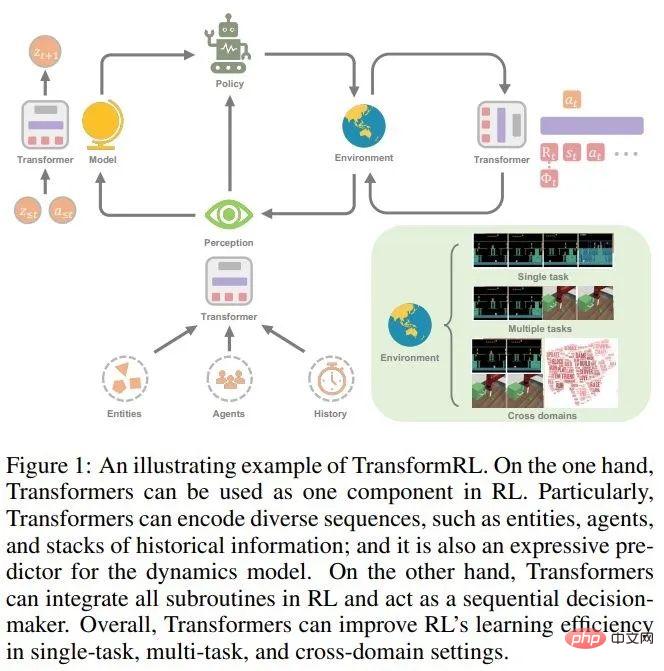

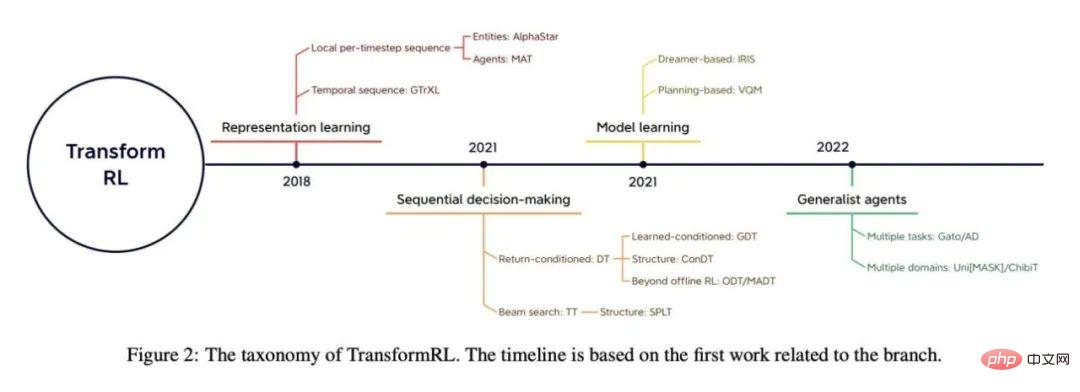

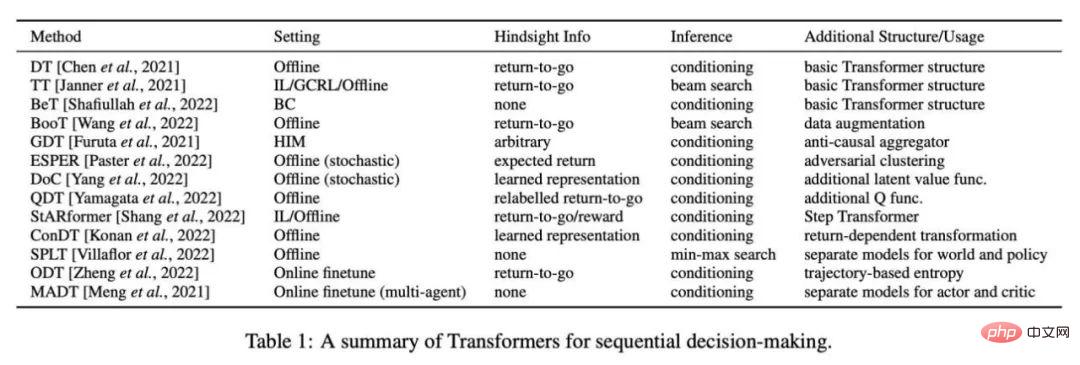

Obwohl Transformer zum Grundmodell für die meisten Forschungsarbeiten zum überwachten Lernen geworden ist, wurde es aus diesem Grund nicht in RL verwendet Die oben genannten Herausforderungen sind seit langem nicht mehr weit verbreitet. Tatsächlich verwendeten die meisten frühen Versuche von TransformRL Transformer für das Lernen von Zustandsdarstellungen oder die Bereitstellung von Speicherinformationen, während für das Lernen von Agenten weiterhin Standard-RL-Algorithmen verwendet wurden, wie z. B. Lernen über zeitliche Differenzen und Richtlinienoptimierung.Trotz der Einführung von Transformer als Funktionsnäherung werden diese Methoden daher immer noch von traditionellen RL-Frameworks herausgefordert. Bis vor kurzem ermöglichte Offline-RL das Erlernen optimaler Richtlinien aus umfangreichen Offline-Daten. Inspiriert durch Offline-RL behandeln neuere Arbeiten das RL-Problem weiter als ein Problem der bedingten Sequenzmodellierung mit fester Erfahrung. Dadurch wird die Bootstrapping-Fehlerherausforderung im herkömmlichen RL umgangen, sodass die Transformer-Architektur ihre leistungsstarken sequentiellen Modellierungsfunktionen freisetzen kann. Der Artikel gibt einen Überblick über den Fortschritt von TransformRL und stellt bestehende Methoden nach Klassifizierung vor. Die Autoren klassifizieren bestehende Methoden in vier Kategorien: Repräsentationslernen, Modelllernen, sequentielle Entscheidungsfindung und Allzweckagenten. Abbildung 2 zeigt einen Überblick über die relevanten Klassifizierungen.

Transformer für das Repräsentationslernen

Angesichts der sequentiellen Natur von RL-Aufgaben ist es sinnvoll, das Transformer-Encoder-Modul zu verwenden. Tatsächlich müssen verschiedene Sequenzen in RL-Aufgaben verarbeitet werden, wie zum Beispiel lokale Sequenzen pro Zeitschritt (Multi-Entity-Sequenzen [Vinyals et al., 2019; Baker et al., 2019], Multi-Agent-Sequenzen [Wen et al. , 2022]), Zeitreihen ([Parisotto et al., 2020; Banino et al., 2021]) usw.

Encoder für lokale Sequenzen pro Zeitschritt

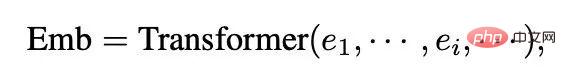

Der bedeutende frühe Erfolg dieses Ansatzes spiegelte sich in der Verwendung von Transformern zur Verarbeitung der komplexen Informationen einer variablen Anzahl von vom Agenten beobachteten Entitäten wider. [Zambaldi et al., 2018a] schlugen zunächst die Verwendung der Multi-Head-Punktproduktaufmerksamkeit vor, um das relationale Denken strukturierter Beobachtungen zu erfassen, und dann implementierte AlphaStar [Vinyals et al., 2019] die Handhabung in einer anspruchsvollen Multi-Agenten-Umgebung (StarCraft II). Multi-Entity-Beobachtungen. In diesem als Entitätstransformer bezeichneten Mechanismus werden Beobachtungen in der folgenden Form codiert:

wobei e_i die Beobachtung der Entität i durch den Agenten darstellt, entweder direkt aus der gesamten Beobachtung herausgeschnitten oder vom Entitäts-Tokenizer bereitgestellt.

Einige Folgearbeiten bereichern den Entity-Transformer-Mechanismus. [Hu et al. 2020] schlugen eine kompatible Entkopplungsstrategie vor, um Aktionen explizit mit verschiedenen Entitäten zu verknüpfen und einen Aufmerksamkeitsmechanismus für die Richtlinieninterpretation zu nutzen. Um eine anspruchsvolle visuelle Nachahmung auf einmal zu erreichen, nutzen Dasari und Gupta [2021] Transformer, um Darstellungen zu erlernen, die sich auf aufgabenspezifische Elemente konzentrieren.

Ähnlich wie über Beobachtungen verstreute Entitäten verwenden einige Studien Transformer, um andere lokale Sequenzen pro Zeitschritt zu verarbeiten. Tang und Ha [2021] nutzen den Aufmerksamkeitsmechanismus von Transformer, um Wahrnehmungssequenzen zu verarbeiten und eine permutationsinvariante Eingabestrategie zu entwickeln. In inkompatiblem Multitask-RL schlugen [Kurin et al., 2020] die Verwendung von Transformer vor, um morphologisches Domänenwissen zu extrahieren.

Timing Encoder

Gleichzeitig ist es auch sinnvoll, Transformer zur Verarbeitung von Timing-Sequenzen zu verwenden. Als Speicherarchitektur wird ein zeitlicher Encoder verwendet,

wobei o_t die Beobachtung des Agenten zum Zeitpunkt t darstellt und Emb_0:t die Einbettung historischer Beobachtungen von der ersten Beobachtung bis zur aktuellen Beobachtung darstellt.

In früheren Arbeiten war [Mishra et al. 2018] nicht in der Lage, zeitliche Sequenzen mit einem Vanilla-Transformer zu verarbeiten und stellte fest, dass dieser bei einigen spezifischen Aufgaben sogar schlechtere Ergebnisse lieferte als eine Zufallsrichtlinie. Gated Transformer-XL (GTrXL) [Parisotto et al., 2020] ist die erste effiziente Lösung, die Transformer als Speicherarchitektur zur Verarbeitung von Trajektorien verwendet. GTrXL modifiziert die Transformer-XL-Architektur [Dai et al., 2019] durch Identity Map Reordering, um einen „Sprung“-Pfad von der sequentiellen Eingabe zur Transformer-Ausgabe bereitzustellen, was dazu beitragen kann, von Anfang an einen stabilen Trainingsprozess zu bilden. [Loynd et al. 2020] schlugen einen Speichervektor-Verknüpfungsmechanismus für langfristige Abhängigkeiten vor und [Irie et al. 2021] kombinierten einen linearen Transformator mit einem Fast Weight Programmer für eine bessere Leistung. [Melo 2022] schlug die Verwendung eines Selbstaufmerksamkeitsmechanismus vor, um die Speicherwiederherstellung für speicherbasiertes Meta-RL zu simulieren.

Obwohl Transformer mit zunehmendem Speicher und zunehmender Parametergröße eine bessere Leistung als LSTM/RNN erbringt, ist es auf RL nicht dateneffizient. Nachfolgende Arbeiten nutzen einige selbstüberwachte Hilfsaufgaben, um das Lernen zu erleichtern [Banino et al., 2021] oder verwenden vorab trainierte Transformer-Architekturen als zeitliche Encoder [Li et al., 2022; Fan et al., 2022].

Transformer für Modelllernen

Neben der Verwendung von Transformer als Encoder für die Sequenzeinbettung dient die Transformer-Architektur auch als Rückgrat des Umgebungsmodells in modellbasierten Algorithmen. Im Gegensatz zu Vorhersagen, die auf einstufigen Beobachtungen und Aktionen basieren, ermöglichen Transformer Umgebungsmodellen die Vorhersage von Übergängen, die auf einer bestimmten Länge historischer Informationen basieren.

Tatsächlich wurde der Erfolg von Dreamer und seinen nachfolgenden Algorithmen [Hafner et al., 2020, 2021; Seo et al., 2022] in einigen teilweise beobachtbaren Umgebungen oder Aufgaben nachgewiesen, die auf der Geschichte basierende Gedächtnismechanismen erfordern. Vorteile des Informationsweltmodells. Ein auf historischen Informationen basierendes Weltmodell besteht aus einem Beobachtungsencoder, der abstrakte Informationen erfasst, und einem Transformationsmodell, das Transformationen im latenten Raum lernt.

Es gab Studien, die Transformer-Architektur anstelle von RNN verwendeten, um geschichtsbasierte Weltmodelle zu erstellen. [Chen et al. 2022] Ersetzen Sie das RNN-basierte Recurrent State-Space Model (RSSM) in Dreamer durch das Transformer-basierte Modell TSSM (Transformer State-Space Model). IRIS (Imagination with autoRegression over an Inner Speech) [Micheli et al., 2022] lernt ein Transformer-basiertes Weltmodell durch autoregressives Lernen der Rollout-Erfahrung ohne KL-Balancing wie Dreamer und ist in Atari implementiert [Bellemare et al., 2013] und gute Ergebnisse erzielt.

Darüber hinaus gibt es auch Studien, die versuchen, Transformer-basierte Weltmodelle für die Planung zu nutzen. [Ozair et al. 2021] verifizierten die Wirksamkeit der Planung mithilfe des Transformer-Transformationsmodells zur Erledigung stochastischer Aufgaben. [Sun et al. 2022] schlugen ein zielkonditioniertes Transformer-Transformationsmodell vor, das bei der visuellen Planung von Verfahrensaufgaben wirksam ist.

Sowohl RNN als auch Transformer eignen sich zum Erlernen von Weltmodellen basierend auf historischen Informationen. [Micheli et al. 2022] stellten jedoch fest, dass die Transformer-Architektur im Vergleich zu Dreamer ein dateneffizienteres Weltmodell ist. Experimentelle Ergebnisse zu TSSM zeigen, dass die Transformer-Architektur bei Aufgaben, die ein Langzeitgedächtnis erfordern, eine gute Leistung erbringt.

Transformer für sequentielle Entscheidungsfindung

Transformer lässt sich nicht nur als Hochleistungsarchitektur in traditionelle RL-Algorithmen integrieren, sondern kann auch direkt als sequentielles Entscheidungsmodell verwendet werden. Dies liegt daran, dass RL als ein Problem der bedingten Sequenzmodellierung betrachtet werden kann: Generieren Sie Aktionssequenzen, die hohe Belohnungen bringen.

Angesichts der hervorragenden Genauigkeit von Transformer bei der Sequenzvorhersage schlägt Bootstrapped Transformer (BooT) [Wang et al., 2022] vor, Daten über Bootstrap Transformer zu generieren und gleichzeitig die Daten für die sequentielle Entscheidungsfindung zu optimieren. Bootstrapping Transformer zur Datenerweiterung kann die Anzahl und Abdeckung von Offline-Datensätzen erweitern und dadurch die Leistung verbessern. Insbesondere vergleicht BooT verschiedene Datengenerierungsschemata und Bootstrapping-Schemata, um zu analysieren, wie BooT das Lernen von Richtlinien erleichtert. Die Ergebnisse zeigen, dass es ohne zusätzliche Einschränkungen Daten generieren kann, die mit dem zugrunde liegenden MDP konsistent sind.

Transformator für Universalagenten

Decision Transformer hat bei verschiedenen Aufgaben mit Offline-Daten eine große Rolle gespielt. Einige Forscher haben begonnen zu überlegen, ob Transformer es Allzweckagenten ermöglichen kann, mehrere verschiedene Aufgaben oder Probleme wie in den Bereichen CV und NLP zu lösen.

Auf mehrere Aufgaben verallgemeinern

Einige Forscher greifen auf die Idee zurück, große Datensätze in CV und NLP vorab zu trainieren, und versuchen, die Verallgemeinerung von großen Multitasking-Aufgaben zu abstrahieren Datensätze Strategie. Multi-Game Decision Transformer (MGDT) [Lee et al., 2022] ist eine Variante von DT, die DT anhand eines vielfältigen Datensatzes lernt, der aus Experten- und Nicht-Expertendaten besteht, und eine Reihe von Parametern verwendet, um eine nahezu menschliche Leistung zu erzielen Atari-Spiele. Um eine Leistung auf Expertenebene für Datensätze auf Nicht-Expertenebene zu erhalten, hat MGDT einen Mechanismus zur Argumentation von Expertenaktionen entwickelt, um die Return-to-Go-Posterior-Verteilung auf Expertenebene aus der Return-to-Go-Prior-Verteilung zu berechnen und sie entsprechend zu berechnen zur Bayes'schen Formel Standard-Experten-Return-to-go-Wahrscheinlichkeit.

In ähnlicher Weise ist Switch Trajectory Transformer (SwitchTT) [Lin et al., 2022] eine Multitasking-Erweiterung von TT, die ein spärliches Aktivierungsmodell nutzt, um die FFN-Schicht durch eine hybride Expertenschicht zu ersetzen, um effizientes Multitasking zu erreichen Offline-Lernen. Darüber hinaus verwendet SwitchTT einen verteilten Trajektorienwertschätzer, um die Unsicherheit von Wertschätzungen zu modellieren. Durch diese beiden Verbesserungen ist SwitchTT in Bezug auf Leistung und Trainingsgeschwindigkeit deutlich besser als TT. MGDT und SwitchTT nutzen die Erfahrungen aus mehreren Aufgaben und verschiedenen Richtlinien auf Leistungsebene, um eine allgemeine Richtlinie zu erlernen. Der Aufbau umfangreicher Multitasking-Datensätze ist jedoch nicht trivial.

Im Gegensatz zu umfangreichen Datensätzen in CV und NLP, die normalerweise umfangreiche Daten aus dem Internet und einfache manuelle Kennzeichnung verwenden, fehlen sequentiellen Entscheidungsdaten in RL immer Handlungsinformationen und sie sind nicht einfach zu kennzeichnen. Daher schlugen [Baker et al. 2022] ein halbüberwachtes Schema zum Erlernen eines Transformer-basierten inversen dynamischen Modells (IDM) unter Verwendung umfangreicher Online-Daten ohne Aktionsinformationen vor. Das Modell nutzt vergangene und zukünftige Beobachtungen, um Handlungsinformationen vorherzusagen, und ist in der Lage, große Mengen an Online-Videodaten zu kennzeichnen. IDM wird anhand eines kleinen Datensatzes erlernt, der manuell gekennzeichnete Aktionen enthält, und ist ausreichend genau.

Viele bestehende Arbeiten im NLP haben die Wirksamkeit von Prompt bei der Anpassung an neue Aufgaben bewiesen, und einige Arbeiten nutzen Prompt-Technologie basierend auf DT-Methoden, um eine schnelle Anpassung zu erreichen. Der auf Eingabeaufforderungen basierende Entscheidungstransformator (Prompt-DT) [Xu et al., 2022] probiert eine Reihe von Transformationen als Eingabeaufforderungen aus einem Demonstrationsdatensatz mit wenigen Schüssen und verallgemeinert die Strategie mit wenigen Schüssen auf Offline-Meta-RL-Aufgaben. [Reed et al. 2022] nutzen die prompt-basierte Architektur weiter, um einen Generalagenten (Gato) durch autoregressive Sequenzmodellierung an sehr großen Datensätzen zu erlernen, die natürliche Sprache, Bilder, zeitliche Entscheidungsfindung und multimodale Daten umfassen. Gato ist in der Lage, eine Reihe von Aufgaben aus verschiedenen Bereichen auszuführen, darunter Texterstellung und Entscheidungsfindung.

[Laskin et al. 2022] schlugen Algorithmic Distillation (AD) vor, um Transformer in einer episodenübergreifenden Sequenz eines RL-Algorithmus-Lernprozesses mit einer einzigen Aufgabe zu trainieren. Daher kann der Transformer auch bei neuen Aufgaben lernen, seine Richtlinien während des autoregressiven Generierungsprozesses schrittweise zu verbessern.

Verallgemeinerung auf ein breiteres Spektrum von Bereichen

Transformer ist nicht nur eine Verallgemeinerung auf mehrere Aufgaben, sondern auch ein leistungsstarkes „allgemeines“ Modell, das in einer Reihe von Bereichen im Zusammenhang mit sequentiellen Entscheidungen verwendet werden kann. Herstellung. Inspiriert von der maskierten Sprachmodellierungstechnologie [Devlin et al., 2018] in NLP schlug [Carroll et al. 2022] Uni [MASK] vor, das verschiedene häufig verwendete Forschungsbereiche zu Maskenschlussproblemen vereint, einschließlich Verhaltensklonen, Offline-RL und GCRL , vergangenes/zukünftiges Denken und dynamische Vorhersage. Uni [MASK] vergleicht verschiedene Maskenschemata, darunter aufgabenspezifische Masken, Zufallsmasken und fein abgestimmte Varianten. Die Ergebnisse zeigen, dass ein einzelner Transformer, der mit einer Zufallsmaske trainiert wurde, beliebige Inferenzaufgaben lösen kann.

Darüber hinaus haben [Reid et al. 2022] herausgefunden, dass es von Vorteil ist, DT mithilfe eines Transformers zu optimieren, der auf einem Sprachdatensatz oder einem multimodalen Datensatz mit Sprachmodalitäten vorab trainiert wurde. Dies zeigt, dass auch Wissen aus Nicht-RL-Domänen für das RL-Training durch Transformatoren genutzt werden kann.

Interessierte Leser können den Originaltext des Artikels lesen, um weitere Forschungsdetails zu erfahren.

Das obige ist der detaillierte Inhalt vonWie weit hat sich Transformer im Bereich Reinforcement Learning entwickelt? Die Tsinghua-Universität, die Peking-Universität und andere haben gemeinsam eine Rezension von TransformRL veröffentlicht. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem völlig kostenlosen KI-Gesichtstausch-Tool aus!

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

Worldcoin (WLD) Preisprognose 2025-2031: Wird WLD bis 2031 $ erreichen?

Apr 21, 2025 pm 02:42 PM

Worldcoin (WLD) Preisprognose 2025-2031: Wird WLD bis 2031 $ erreichen?

Apr 21, 2025 pm 02:42 PM

Worldcoin (WLD) fällt auf dem Kryptowährungsmarkt mit seinen einzigartigen biometrischen Überprüfungs- und Datenschutzschutzmechanismen auf, die die Aufmerksamkeit vieler Investoren auf sich ziehen. WLD hat mit seinen innovativen Technologien, insbesondere in Kombination mit OpenAI -Technologie für künstliche Intelligenz, außerdem unter Altcoins gespielt. Aber wie werden sich die digitalen Vermögenswerte in den nächsten Jahren verhalten? Lassen Sie uns den zukünftigen Preis von WLD zusammen vorhersagen. Die Preisprognose von 2025 WLD wird voraussichtlich im Jahr 2025 ein signifikantes Wachstum in WLD erzielen. Die Marktanalyse zeigt, dass der durchschnittliche WLD -Preis 1,31 USD mit maximal 1,36 USD erreichen kann. In einem Bärenmarkt kann der Preis jedoch auf rund 0,55 US -Dollar fallen. Diese Wachstumserwartung ist hauptsächlich auf Worldcoin2 zurückzuführen.

Was bedeutet Cross-Chain-Transaktion? Was sind die Cross-Chain-Transaktionen?

Apr 21, 2025 pm 11:39 PM

Was bedeutet Cross-Chain-Transaktion? Was sind die Cross-Chain-Transaktionen?

Apr 21, 2025 pm 11:39 PM

Börsen, die Cross-Chain-Transaktionen unterstützen: 1. Binance, 2. Uniswap, 3. Sushiswap, 4. Kurvenfinanzierung, 5. Thorchain, 6. 1inch Exchange, 7. DLN-Handel, diese Plattformen unterstützen Multi-Chain-Asset-Transaktionen durch verschiedene Technologien.

Warum ist der Anstieg oder Abfall der virtuellen Währungspreise? Warum ist der Anstieg oder Abfall der virtuellen Währungspreise?

Apr 21, 2025 am 08:57 AM

Warum ist der Anstieg oder Abfall der virtuellen Währungspreise? Warum ist der Anstieg oder Abfall der virtuellen Währungspreise?

Apr 21, 2025 am 08:57 AM

Faktoren der steigenden Preise für virtuelle Währung sind: 1. Erhöhte Marktnachfrage, 2. Verringertes Angebot, 3.. Rückgangsfaktoren umfassen: 1. Verringerte Marktnachfrage, 2. Erhöhtes Angebot, 3. Streik der negativen Nachrichten, 4. Pessimistische Marktstimmung, 5. makroökonomisches Umfeld.

Aavenomics ist eine Empfehlung, das Aave -Protokoll -Token zu ändern und Token -Rückkauf einzuführen, die die Quorum -Anzahl von Personen erreicht hat.

Apr 21, 2025 pm 06:24 PM

Aavenomics ist eine Empfehlung, das Aave -Protokoll -Token zu ändern und Token -Rückkauf einzuführen, die die Quorum -Anzahl von Personen erreicht hat.

Apr 21, 2025 pm 06:24 PM

Aavenomics ist ein Vorschlag zur Änderung des Aave -Protokoll -Tokens und zur Einführung von Token -Repos, die ein Quorum für Aavedao implementiert hat. Marc Zeller, Gründer der AAVE -Projektkette (ACI), kündigte dies auf X an und stellte fest, dass sie eine neue Ära für die Vereinbarung markiert. Marc Zeller, Gründer der Aave Chain Initiative (ACI), kündigte auf X an, dass der Aavenomics -Vorschlag das Modifizieren des Aave -Protokoll -Tokens und die Einführung von Token -Repos umfasst, hat ein Quorum für Aavedao erreicht. Laut Zeller ist dies eine neue Ära für die Vereinbarung. AVEDAO -Mitglieder stimmten überwiegend für die Unterstützung des Vorschlags, der am Mittwoch 100 pro Woche betrug

So gewinnen Sie Kernel Airdrop -Belohnungen für Binance vollständige Prozessstrategie

Apr 21, 2025 pm 01:03 PM

So gewinnen Sie Kernel Airdrop -Belohnungen für Binance vollständige Prozessstrategie

Apr 21, 2025 pm 01:03 PM

In der geschäftigen Welt der Kryptowährungen entstehen immer neue Möglichkeiten. Gegenwärtig zieht Kerneldao (Kernel) Airdrop -Aktivität viel Aufmerksamkeit auf sich und zieht die Aufmerksamkeit vieler Investoren auf sich. Also, was ist der Ursprung dieses Projekts? Welche Vorteile können BNB -Inhaber davon bekommen? Machen Sie sich keine Sorgen, das Folgende wird es einzeln für Sie enthüllen.

Was sind die Hybrid -Blockchain -Handelsplattformen?

Apr 21, 2025 pm 11:36 PM

Was sind die Hybrid -Blockchain -Handelsplattformen?

Apr 21, 2025 pm 11:36 PM

Vorschläge für die Auswahl eines Kryptowährungsaustauschs: 1. Für die Liquiditätsanforderungen ist Priorität Binance, Gate.io oder OKX aufgrund seiner Bestelltiefe und der starken Volatilitätsbeständigkeit. 2. Compliance and Security, Coinbase, Kraken und Gemini haben strenge regulatorische Bestätigung. 3. Innovative Funktionen, Kucoins sanftes Stakel und Derivatdesign von Bitbit eignen sich für fortschrittliche Benutzer.

Die zehn Top-Empfehlungen zur Plattform für Echtzeitdaten auf den Währungskreismärkten werden veröffentlicht

Apr 22, 2025 am 08:12 AM

Die zehn Top-Empfehlungen zur Plattform für Echtzeitdaten auf den Währungskreismärkten werden veröffentlicht

Apr 22, 2025 am 08:12 AM

Zu den für Anfängern geeigneten Kryptowährungsdatenplattformen gehören CoinMarketCap und nicht-kleine Trompete. 1. CoinmarketCap bietet globale Rangliste für den Preis, den Marktwert und der Handelsvolumen für Anfänger für Anfänger und Grundanalyse. 2. Das nichtklammernde Angebot bietet eine chinesisch-freundliche Schnittstelle, die chinesischen Benutzern geeignet ist, um potenzielle Projekte mit geringem Risiko schnell zu untersuchen.

Rexas Finance (RXS) kann Solana (SOL), Cardano (ADA), XRP und Dogecoin (Doge) im Jahr 2025 übertreffen

Apr 21, 2025 pm 02:30 PM

Rexas Finance (RXS) kann Solana (SOL), Cardano (ADA), XRP und Dogecoin (Doge) im Jahr 2025 übertreffen

Apr 21, 2025 pm 02:30 PM

Auf dem volatilen Kryptowährungsmarkt suchen Anleger nach Alternativen, die über die beliebten Währungen hinausgehen. Obwohl bekannte Kryptowährungen wie Solana (SOL), Cardano (ADA), XRP und Doge (DOGE) auch Herausforderungen wie Marktgefühle, regulatorische Unsicherheit und Skalierbarkeit gegenübersehen. Ein neues aufstrebendes Projekt, Rexasfinance (RXS), entsteht jedoch. Es stützt sich nicht auf Prominenteffekte oder Hype, sondern konzentriert sich auf die Kombination der realen Vermögenswerte (RWA) mit Blockchain-Technologie, um den Anlegern eine innovative Möglichkeit zum Investieren zu bieten. Diese Strategie hofft, eines der erfolgreichsten Projekte von 2025 zu sein. Rexasfi