Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Wie modelliert GNN raumzeitliche Informationen? Eine Übersicht über „Spatial-temporal Graph Neural Network' an der Queen Mary University of London, eine kurze Erläuterung der Methode des räumlich-zeitlichen Graph Neural Network

Wie modelliert GNN raumzeitliche Informationen? Eine Übersicht über „Spatial-temporal Graph Neural Network' an der Queen Mary University of London, eine kurze Erläuterung der Methode des räumlich-zeitlichen Graph Neural Network

Wie modelliert GNN raumzeitliche Informationen? Eine Übersicht über „Spatial-temporal Graph Neural Network' an der Queen Mary University of London, eine kurze Erläuterung der Methode des räumlich-zeitlichen Graph Neural Network

Diese leistungsstarken Algorithmen haben in den letzten Jahren großes Interesse geweckt. Diese Leistung basiert jedoch auf der Annahme einer statischen Diagrammstruktur, die die Leistung von neuronalen Diagrammnetzen einschränkt, wenn sich Daten im Laufe der Zeit ändern. Das sequentielle graphische neuronale Netzwerk ist eine Erweiterung des graphischen neuronalen Netzwerks, das Zeitfaktoren berücksichtigt.

In den letzten Jahren wurden verschiedene sequentielle graphische neuronale Netzwerkalgorithmen vorgeschlagen und haben in mehreren zeitbezogenen Anwendungen eine Leistung erzielt, die anderen Deep-Learning-Algorithmen überlegen ist. In dieser Rezension werden interessante Themen im Zusammenhang mit neuronalen Netzen mit räumlichen und zeitlichen Graphen erörtert, darunter Algorithmen, Anwendungen und offene Herausforderungen.

Papieradresse: https://www.php.cn/link/1915523773b16865a73a38acc952ccda

1. Einführung

Graph Neural Network (GNN) ist eine Art Deep-Learning-Modell, das speziell für die Verarbeitung von Diagrammstrukturdaten entwickelt wurde . Diese Modelle nutzen die Graphtopologie, um aussagekräftige Darstellungen der Knoten und Kanten des Graphen zu lernen. Graphische neuronale Netze sind eine Erweiterung traditioneller Faltungs-neuronaler Netze und haben sich bei Aufgaben wie der Diagrammklassifizierung, der Knotenklassifizierung und der Verbindungsvorhersage als effektiv erwiesen. Einer der Hauptvorteile von GNNs besteht darin, dass sie auch dann eine gute Leistung beibehalten, wenn die Größe des zugrunde liegenden Diagramms zunimmt, da die Anzahl der lernbaren Parameter unabhängig von der Anzahl der Knoten im Diagramm ist. Graphische neuronale Netze (GNN) werden häufig in verschiedenen Bereichen wie Empfehlungssystemen, Arzneimittelentwicklung und -biologie sowie Ressourcenzuweisung in autonomen Systemen eingesetzt. Diese Modelle sind jedoch auf statische Diagrammdaten beschränkt, bei denen die Diagrammstruktur festgelegt ist. In den letzten Jahren haben zeitveränderliche Diagrammdaten zunehmend Aufmerksamkeit erregt, da sie in verschiedenen Systemen auftauchen und wertvolle zeitliche Informationen enthalten. Zu den Anwendungen zeitveränderlicher Diagrammdaten gehören multivariate Zeitreihendaten, soziale Netzwerke, audiovisuelle Systeme usw.

Um dieser Nachfrage gerecht zu werden, ist eine neue GNN-Familie entstanden: das spatiotemporale GNN, das sowohl die räumlichen als auch die zeitlichen Dimensionen der Daten berücksichtigt, indem es die zeitliche Darstellung der Diagrammstruktur lernt. Dieses Papier bietet einen umfassenden Überblick über modernste räumlich-zeitliche graphische neuronale Netze. Dieser Artikel beginnt mit einem kurzen Überblick über verschiedene Arten von neuronalen Netzen mit raumzeitlichen Graphen und deren Grundannahmen. Die spezifischen Algorithmen, die in raumzeitlichen GNNs verwendet werden, werden detaillierter untersucht und bieten gleichzeitig eine nützliche Taxonomie für die Gruppierung dieser Modelle. Das Papier bietet außerdem einen Überblick über verschiedene Anwendungen raumzeitlicher GNNs und hebt Schlüsselbereiche hervor, in denen diese Modelle verwendet wurden, um hochmoderne Ergebnisse zu erzielen. Abschließend werden die Herausforderungen des Fachgebiets und zukünftige Forschungsrichtungen diskutiert. Zusammenfassend zielt dieser Aufsatz darauf ab, eine umfassende und eingehende Untersuchung raumzeitlicher graphischer neuronaler Netze bereitzustellen und den aktuellen Stand des Fachgebiets, die wichtigsten Herausforderungen, die noch angegangen werden müssen, und die spannenden zukünftigen Möglichkeiten dieser Modelle hervorzuheben.

2. Algorithmus

Raum-Zeit-Graph-Neuronale Netzwerke können aus algorithmischer Sicht in zwei Kategorien unterteilt werden: spektralbasiert und raumbasiert. Eine weitere Klassifizierungskategorie sind Methoden, die Zeitvariationen einführen: ein anderer Algorithmus für maschinelles Lernen oder die Definition der Zeit in einer Diagrammstruktur.

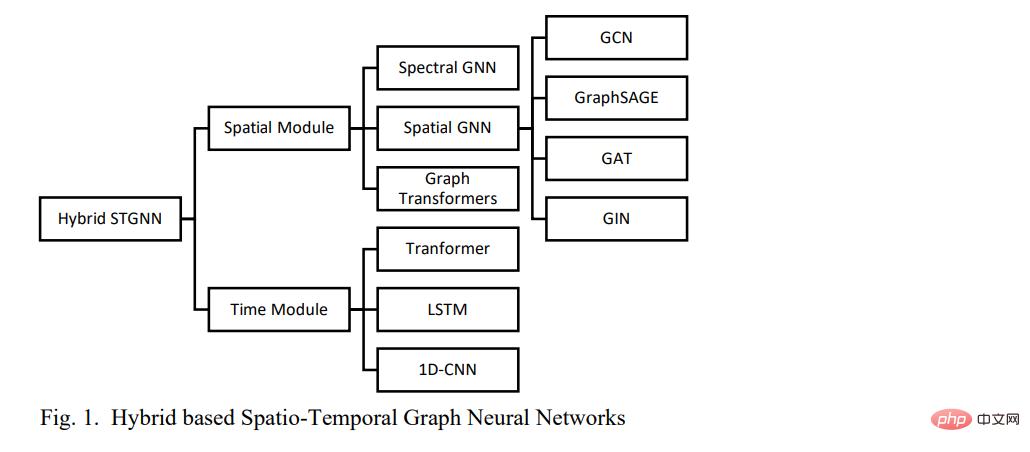

2.1 Hybrides neuronales Netzwerk mit raumzeitlichem Graphen

Hybrides neuronales Netzwerk mit raumzeitlichem Graphen besteht aus zwei Hauptkomponenten: einer räumlichen Komponente und einer zeitlichen Komponente. In hybriden räumlich-zeitlichen graphischen neuronalen Netzwerken werden graphische neuronale Netzwerkalgorithmen verwendet, um räumliche Abhängigkeiten in Daten zu modellieren.

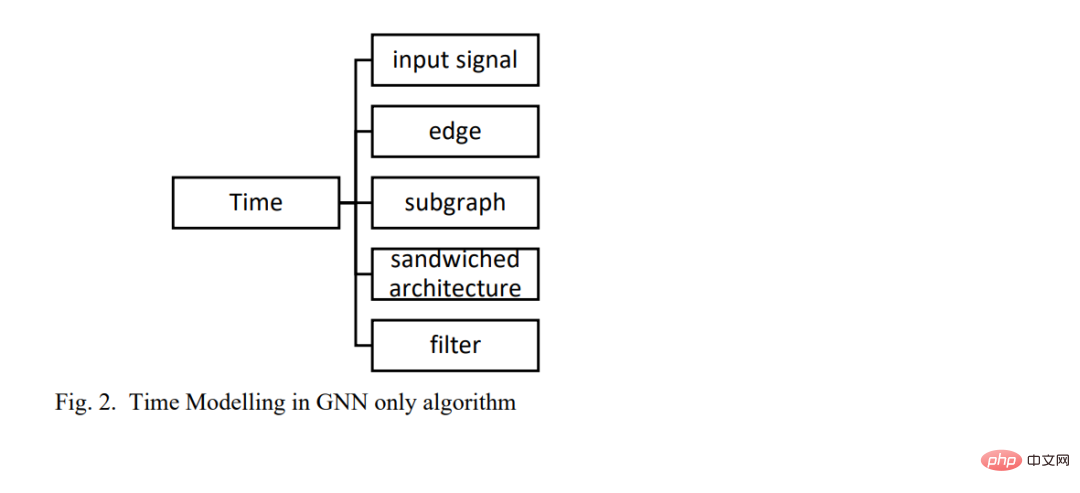

2.2 Solo-Graph Neural Network

Eine andere Möglichkeit, Zeit in einem räumlich-zeitlichen Graphen-Neuronalen Netzwerk zu modellieren, besteht darin, den Zeitrahmen im GNN selbst zu definieren. Es wurden verschiedene Methoden vorgeschlagen, darunter: Zeit als Kanten definieren, Zeit als Signale in GNNs eingeben, Zeit als Untergraphen modellieren und andere Architekturen für maschinelles Lernen in GNNs einbetten (Abbildung 2). 3. Anwendungen

3.1 Multivariable Zeitreihenvorhersage Zu den Anwendungen gehören Verkehrsprognosen, Covid-Prognosen, Photovoltaik-Stromverbrauch, RSU-Kommunikation und seismische Anwendungen.

3.2 Charakterinteraktion

Beim maschinellen Lernen und Computer Vision ist das Lernen von räumlich-zeitlichen Domänen immer noch ein sehr herausforderndes Problem. Die größte Herausforderung besteht darin, Interaktionen zwischen Objekten und übergeordneten Konzepten in großen raumzeitlichen Kontexten zu modellieren [18]. Bei solch einer schwierigen Lernaufgabe ist es entscheidend, räumliche Beziehungen, lokale Erscheinungen sowie komplexe Interaktionen und Veränderungen im Laufe der Zeit effektiv zu modellieren. [18] führte ein räumlich-zeitliches graphisches neuronales Netzwerkmodell ein, das sich in Raum und Zeit wiederholt und sich zur Erfassung des lokalen Erscheinungsbilds und komplexer Interaktionen auf hoher Ebene verschiedener Entitäten und Objekte in sich verändernden Weltszenen eignet [18].

3.3 Dynamische Graphdarstellung

Sequentielles Lernen der Graphdarstellung wurde schon immer als ein sehr wichtiger Aspekt beim maschinellen Lernen von Graphen angesehen [15,31]. Mit Blick auf die Einschränkung, dass bestehende Methoden auf diskreten Schnappschüssen von Sequenzdiagrammen basieren und keine leistungsstarken Darstellungen erfassen können, [3] wurde eine dynamische Lernmethode für die Darstellung von Graphen vorgeschlagen, die auf neuronalen Netzen mit räumlichen und zeitlichen Graphen basiert. Darüber hinaus verwenden [15] jetzt raumzeitliches GNN, um Gehirnkarten dynamisch darzustellen. Multi-Target-Tracking Das Multi-Target-Tracking in Videos basiert stark auf der Modellierung der räumlich-zeitlichen Interaktionen zwischen Zielen [16]. [16] schlugen einen Algorithmus für ein räumlich-zeitliches graphisches neuronales Netzwerk vor, um die räumlichen und zeitlichen Interaktionen zwischen Objekten zu modellieren.

3.4 Gebärdensprachdolmetschen

Gebärdensprache nutzt eine visuell-manuelle Methode zur Bedeutungsvermittlung und ist das wichtigste Kommunikationsmittel für gehörlose und schwerhörige Gruppen. Um die Kommunikationslücke zwischen gesprochenen Sprachbenutzern und Gebärdensprachbenutzern zu schließen, wird maschinelle Lerntechnologie eingeführt. Traditionell ist die neuronale maschinelle Übersetzung weit verbreitet, es sind jedoch fortschrittlichere Methoden erforderlich, um die räumlichen Eigenschaften von Gebärdensprachen zu erfassen. [13] schlugen ein Gebärdensprachübersetzungssystem vor, das auf einem neuronalen Netzwerk mit räumlichen und zeitlichen Graphen basiert und über eine starke Fähigkeit zur Erfassung der raumzeitlichen Struktur der Gebärdensprache verfügt und im Vergleich zur herkömmlichen neuronalen maschinellen Übersetzungsmethode die beste Leistung erzielt [13].

3.5 Technologie-Wachstumsranking

Das Verständnis der Wachstumsrate der Technologie ist ein zentraler Schlüssel für die Geschäftsstrategie der Technologieabteilung. Darüber hinaus kann die Prognose der Wachstumsraten von Technologien und ihrer Beziehungen untereinander Geschäftsentscheidungen in den Bereichen Produktdefinition, Marketingstrategien und Forschung und Entwicklung unterstützen. [32] schlugen eine Vorhersagemethode für das Wachstumsranking der Technologie sozialer Netzwerke vor, die auf einem neuronalen Netzwerk mit räumlichen und zeitlichen Diagrammen basiert.

4. Fazit

Graphische neuronale Netze haben in den letzten Jahren großes Interesse erfahren. Diese leistungsstarken Algorithmen erweitern Deep-Learning-Modelle auf nichteuklidische Räume. Graph-Neuronale Netze sind jedoch auf statische Graph-Strukturannahmen beschränkt, was die Leistung von Graph-Neuronalen Netzen einschränkt, wenn sich Daten im Laufe der Zeit ändern. Das sequentielle graphische neuronale Netzwerk ist eine Erweiterung des graphischen neuronalen Netzwerks, das Zeitfaktoren berücksichtigt. Dieser Artikel bietet einen umfassenden Überblick über räumlich-zeitliche graphische neuronale Netze. In diesem Artikel wird eine Taxonomie vorgeschlagen, die räumlich-zeitliche graphische neuronale Netze auf der Grundlage zeitvariabler Methoden in zwei Kategorien unterteilt. Das breite Anwendungsspektrum raumzeitlicher graphischer neuronaler Netze wird ebenfalls diskutiert. Abschließend werden zukünftige Forschungsrichtungen vorgeschlagen, die auf den offenen Herausforderungen basieren, mit denen neuronale Netze mit räumlichen und zeitlichen Graphen derzeit konfrontiert sind.

Referenzen:https://www.php.cn/link/1915523773b16865a73a38acc952ccda

Das obige ist der detaillierte Inhalt vonWie modelliert GNN raumzeitliche Informationen? Eine Übersicht über „Spatial-temporal Graph Neural Network' an der Queen Mary University of London, eine kurze Erläuterung der Methode des räumlich-zeitlichen Graph Neural Network. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1376

1376

52

52

Methoden und Schritte zur Verwendung von BERT für die Stimmungsanalyse in Python

Jan 22, 2024 pm 04:24 PM

Methoden und Schritte zur Verwendung von BERT für die Stimmungsanalyse in Python

Jan 22, 2024 pm 04:24 PM

BERT ist ein vorab trainiertes Deep-Learning-Sprachmodell, das 2018 von Google vorgeschlagen wurde. Der vollständige Name lautet BidirektionalEncoderRepresentationsfromTransformers, der auf der Transformer-Architektur basiert und die Eigenschaften einer bidirektionalen Codierung aufweist. Im Vergleich zu herkömmlichen Einweg-Codierungsmodellen kann BERT bei der Textverarbeitung gleichzeitig Kontextinformationen berücksichtigen, sodass es bei Verarbeitungsaufgaben in natürlicher Sprache eine gute Leistung erbringt. Seine Bidirektionalität ermöglicht es BERT, die semantischen Beziehungen in Sätzen besser zu verstehen und dadurch die Ausdrucksfähigkeit des Modells zu verbessern. Durch Vorschulungs- und Feinabstimmungsmethoden kann BERT für verschiedene Aufgaben der Verarbeitung natürlicher Sprache verwendet werden, wie z. B. Stimmungsanalyse und Benennung

YOLO ist unsterblich! YOLOv9 wird veröffentlicht: Leistung und Geschwindigkeit SOTA~

Feb 26, 2024 am 11:31 AM

YOLO ist unsterblich! YOLOv9 wird veröffentlicht: Leistung und Geschwindigkeit SOTA~

Feb 26, 2024 am 11:31 AM

Heutige Deep-Learning-Methoden konzentrieren sich darauf, die am besten geeignete Zielfunktion zu entwerfen, damit die Vorhersageergebnisse des Modells der tatsächlichen Situation am nächsten kommen. Gleichzeitig muss eine geeignete Architektur entworfen werden, um ausreichend Informationen für die Vorhersage zu erhalten. Bestehende Methoden ignorieren die Tatsache, dass bei der schichtweisen Merkmalsextraktion und räumlichen Transformation der Eingabedaten eine große Menge an Informationen verloren geht. Dieser Artikel befasst sich mit wichtigen Themen bei der Datenübertragung über tiefe Netzwerke, nämlich Informationsengpässen und umkehrbaren Funktionen. Darauf aufbauend wird das Konzept der programmierbaren Gradienteninformation (PGI) vorgeschlagen, um die verschiedenen Änderungen zu bewältigen, die tiefe Netzwerke zur Erreichung mehrerer Ziele erfordern. PGI kann vollständige Eingabeinformationen für die Zielaufgabe zur Berechnung der Zielfunktion bereitstellen und so zuverlässige Gradienteninformationen zur Aktualisierung der Netzwerkgewichte erhalten. Darüber hinaus wird ein neues, leichtgewichtiges Netzwerk-Framework entworfen

Jenseits von ORB-SLAM3! SL-SLAM: Szenen mit wenig Licht, starkem Jitter und schwacher Textur werden verarbeitet

May 30, 2024 am 09:35 AM

Jenseits von ORB-SLAM3! SL-SLAM: Szenen mit wenig Licht, starkem Jitter und schwacher Textur werden verarbeitet

May 30, 2024 am 09:35 AM

Heute diskutieren wir darüber, wie Deep-Learning-Technologie die Leistung von visionbasiertem SLAM (Simultaneous Localization and Mapping) in komplexen Umgebungen verbessern kann. Durch die Kombination von Methoden zur Tiefenmerkmalsextraktion und Tiefenanpassung stellen wir hier ein vielseitiges hybrides visuelles SLAM-System vor, das die Anpassung in anspruchsvollen Szenarien wie schlechten Lichtverhältnissen, dynamischer Beleuchtung, schwach strukturierten Bereichen und starkem Jitter verbessern soll. Unser System unterstützt mehrere Modi, einschließlich erweiterter Monokular-, Stereo-, Monokular-Trägheits- und Stereo-Trägheitskonfigurationen. Darüber hinaus wird analysiert, wie visuelles SLAM mit Deep-Learning-Methoden kombiniert werden kann, um andere Forschungen zu inspirieren. Durch umfangreiche Experimente mit öffentlichen Datensätzen und selbst abgetasteten Daten demonstrieren wir die Überlegenheit von SL-SLAM in Bezug auf Positionierungsgenauigkeit und Tracking-Robustheit.

Latente Raumeinbettung: Erklärung und Demonstration

Jan 22, 2024 pm 05:30 PM

Latente Raumeinbettung: Erklärung und Demonstration

Jan 22, 2024 pm 05:30 PM

Latent Space Embedding (LatentSpaceEmbedding) ist der Prozess der Abbildung hochdimensionaler Daten auf niedrigdimensionalen Raum. Im Bereich des maschinellen Lernens und des tiefen Lernens handelt es sich bei der Einbettung latenter Räume normalerweise um ein neuronales Netzwerkmodell, das hochdimensionale Eingabedaten in einen Satz niedrigdimensionaler Vektordarstellungen abbildet. Dieser Satz von Vektoren wird oft als „latente Vektoren“ oder „latent“ bezeichnet Kodierungen". Der Zweck der Einbettung latenter Räume besteht darin, wichtige Merkmale in den Daten zu erfassen und sie in einer prägnanteren und verständlicheren Form darzustellen. Durch die Einbettung latenter Räume können wir Vorgänge wie das Visualisieren, Klassifizieren und Clustern von Daten im niedrigdimensionalen Raum durchführen, um die Daten besser zu verstehen und zu nutzen. Die Einbettung latenter Räume findet in vielen Bereichen breite Anwendung, z. B. bei der Bilderzeugung, der Merkmalsextraktion, der Dimensionsreduzierung usw. Die Einbettung des latenten Raums ist das Wichtigste

Verstehen Sie in einem Artikel: die Zusammenhänge und Unterschiede zwischen KI, maschinellem Lernen und Deep Learning

Mar 02, 2024 am 11:19 AM

Verstehen Sie in einem Artikel: die Zusammenhänge und Unterschiede zwischen KI, maschinellem Lernen und Deep Learning

Mar 02, 2024 am 11:19 AM

In der heutigen Welle rasanter technologischer Veränderungen sind künstliche Intelligenz (KI), maschinelles Lernen (ML) und Deep Learning (DL) wie helle Sterne und führen die neue Welle der Informationstechnologie an. Diese drei Wörter tauchen häufig in verschiedenen hochaktuellen Diskussionen und praktischen Anwendungen auf, aber für viele Entdecker, die neu auf diesem Gebiet sind, sind ihre spezifische Bedeutung und ihre internen Zusammenhänge möglicherweise noch immer rätselhaft. Schauen wir uns also zunächst dieses Bild an. Es ist ersichtlich, dass zwischen Deep Learning, maschinellem Lernen und künstlicher Intelligenz ein enger Zusammenhang und eine fortschreitende Beziehung besteht. Deep Learning ist ein spezifischer Bereich des maschinellen Lernens und des maschinellen Lernens

Super stark! Top 10 Deep-Learning-Algorithmen!

Mar 15, 2024 pm 03:46 PM

Super stark! Top 10 Deep-Learning-Algorithmen!

Mar 15, 2024 pm 03:46 PM

Fast 20 Jahre sind vergangen, seit das Konzept des Deep Learning im Jahr 2006 vorgeschlagen wurde. Deep Learning hat als Revolution auf dem Gebiet der künstlichen Intelligenz viele einflussreiche Algorithmen hervorgebracht. Was sind Ihrer Meinung nach die zehn besten Algorithmen für Deep Learning? Im Folgenden sind meiner Meinung nach die besten Algorithmen für Deep Learning aufgeführt. Sie alle nehmen hinsichtlich Innovation, Anwendungswert und Einfluss eine wichtige Position ein. 1. Hintergrund des Deep Neural Network (DNN): Deep Neural Network (DNN), auch Multi-Layer-Perceptron genannt, ist der am weitesten verbreitete Deep-Learning-Algorithmus. Als er erstmals erfunden wurde, wurde er aufgrund des Engpasses bei der Rechenleistung in Frage gestellt Jahre, Rechenleistung, Der Durchbruch kam mit der Datenexplosion. DNN ist ein neuronales Netzwerkmodell, das mehrere verborgene Schichten enthält. In diesem Modell übergibt jede Schicht Eingaben an die nächste Schicht und

1,3 ms dauert 1,3 ms! Tsinghuas neueste Open-Source-Architektur für mobile neuronale Netzwerke RepViT

Mar 11, 2024 pm 12:07 PM

1,3 ms dauert 1,3 ms! Tsinghuas neueste Open-Source-Architektur für mobile neuronale Netzwerke RepViT

Mar 11, 2024 pm 12:07 PM

Papieradresse: https://arxiv.org/abs/2307.09283 Codeadresse: https://github.com/THU-MIG/RepViTRepViT funktioniert gut in der mobilen ViT-Architektur und zeigt erhebliche Vorteile. Als nächstes untersuchen wir die Beiträge dieser Studie. In dem Artikel wird erwähnt, dass Lightweight-ViTs bei visuellen Aufgaben im Allgemeinen eine bessere Leistung erbringen als Lightweight-CNNs, hauptsächlich aufgrund ihres Multi-Head-Selbstaufmerksamkeitsmoduls (MSHA), das es dem Modell ermöglicht, globale Darstellungen zu lernen. Allerdings wurden die architektonischen Unterschiede zwischen Lightweight-ViTs und Lightweight-CNNs noch nicht vollständig untersucht. In dieser Studie integrierten die Autoren leichte ViTs in die effektiven

So verwenden Sie CNN- und Transformer-Hybridmodelle, um die Leistung zu verbessern

Jan 24, 2024 am 10:33 AM

So verwenden Sie CNN- und Transformer-Hybridmodelle, um die Leistung zu verbessern

Jan 24, 2024 am 10:33 AM

Convolutional Neural Network (CNN) und Transformer sind zwei verschiedene Deep-Learning-Modelle, die bei verschiedenen Aufgaben eine hervorragende Leistung gezeigt haben. CNN wird hauptsächlich für Computer-Vision-Aufgaben wie Bildklassifizierung, Zielerkennung und Bildsegmentierung verwendet. Es extrahiert lokale Merkmale auf dem Bild durch Faltungsoperationen und führt eine Reduzierung der Merkmalsdimensionalität und räumliche Invarianz durch Pooling-Operationen durch. Im Gegensatz dazu wird Transformer hauptsächlich für Aufgaben der Verarbeitung natürlicher Sprache (NLP) wie maschinelle Übersetzung, Textklassifizierung und Spracherkennung verwendet. Es nutzt einen Selbstaufmerksamkeitsmechanismus, um Abhängigkeiten in Sequenzen zu modellieren und vermeidet so die sequentielle Berechnung in herkömmlichen rekurrenten neuronalen Netzen. Obwohl diese beiden Modelle für unterschiedliche Aufgaben verwendet werden, weisen sie Ähnlichkeiten in der Sequenzmodellierung auf