Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Gemeinsam produziert von Qingbei! Eine Umfrage zum Verständnis der Besonderheiten des „Transformer+Reinforcement Learning'

Gemeinsam produziert von Qingbei! Eine Umfrage zum Verständnis der Besonderheiten des „Transformer+Reinforcement Learning'

Gemeinsam produziert von Qingbei! Eine Umfrage zum Verständnis der Besonderheiten des „Transformer+Reinforcement Learning'

Seit seiner Veröffentlichung hat sich das Transformer-Modell schnell zu einer gängigen neuronalen Architektur im Bereich der Verarbeitung natürlicher Sprache und Computer Vision in überwachten Lernumgebungen entwickelt.

Obwohl die Begeisterung für Transformer aufgrund der Eigenschaften von RL selbst begonnen hat, sich über den Bereich Reinforcement Learning auszubreiten B. die Notwendigkeit eindeutiger Merkmale, Architekturdesign usw., die aktuelle Kombination aus Transformer und Verstärkungslernen ist nicht reibungslos und es fehlen relevante Papiere für eine umfassende Zusammenfassung auf dem Entwicklungsweg.

Kürzlich veröffentlichten Forscher der Tsinghua-Universität, der Peking-Universität und Tencent gemeinsam einen Forschungsbericht über die Kombination von Transformer und Reinforcement Learning, in dem sie die Anwendung von Reinforcement Learning systematisch überprüften. Die Motivation und Entwicklungsgeschichte des Einsatzes von Transformer beim Lernen.

Papierlink: https://arxiv.org/pdf/2301.03044.pdf#🎜 🎜#

Der Artikel ordnet bestehende verwandte Arbeitsergebnisse ein, führt ausführliche Diskussionen zu jedem Teilgebiet und fasst abschließend die Zukunftsaussichten dieser Forschungsrichtung zusammen.

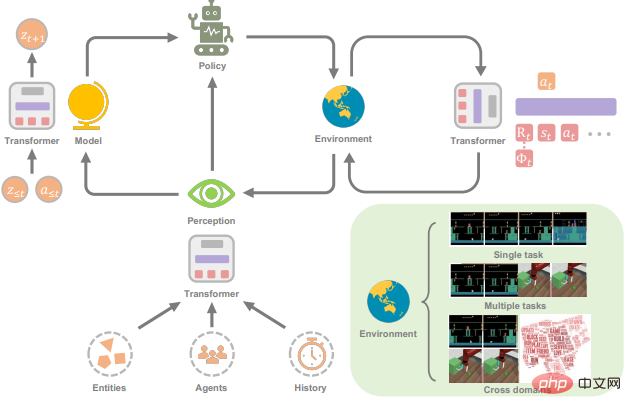

Transformer mit RLReinforcement Learning (RL) bietet eine mathematische Form für sequentielle Entscheidungsfindung, die das Modell automatisch intelligent werden lassen kann Verhalten.

RL bietet einen allgemeinen Rahmen für lernbasierte Steuerung. Mit der Einführung tiefer neuronaler Netze wurde in jüngster Zeit auch die Vielseitigkeit des tiefen Verstärkungslernens (DRL) erreicht Jahrelang wurden enorme Fortschritte erzielt, aber Probleme mit der Probeneffizienz behindern die weitverbreitete Anwendung von DRL in der realen Welt.

Um dieses Problem zu lösen, besteht ein wirksamer Mechanismus darin, eine induktive Vorspannung in das DRL-Framework einzuführen. Der wichtigere ist die Wahl der Funktions-Approximator-Architektur ), wie etwa die Parametrisierung neuronaler Netze für DRL-Agenten.

Das Problem der Auswahl des Architekturdesigns in DRL im Vergleich zu dem im überwachten Lernen (SL) ist jedoch immer noch nicht vollständig erforscht, und die meisten vorhandenen Arbeiten zu RL-Architekturen waren es motiviert durch den Erfolg der (halb-)überwachten Lerngemeinschaft.

Eine gängige Praxis zum Umgang mit hochdimensionalen bildbasierten Eingaben in DRL ist beispielsweise die Einführung von Convolutional Neural Networks (CNN); Teilweise Beobachtbarkeit Der Ansatz besteht in der Einführung wiederkehrender neuronaler Netze (RNN).

In den letzten Jahren hat die Transformer-Architektur das Lernparadigma in einer Vielzahl von SL-Aufgaben revolutioniert und eine überlegene Leistung gegenüber CNN und RNN gezeigt Architektur kann längere Abhängigkeiten mit hervorragender Skalierbarkeit modellieren.

Inspiriert durch den Erfolg von SL ist das Interesse der Branche an der Anwendung von Transformer beim verstärkenden Lernen stark gestiegen. Dies lässt sich auf einen Artikel aus dem Jahr 2018 zurückführen, in dem das Selbst -Aufmerksamkeitsmechanismus war relationales Denken für strukturierte Zustandsdarstellungen.

Danach begannen viele Forscher, Selbstaufmerksamkeit auf das Repräsentationslernen anzuwenden, um Beziehungen zwischen Entitäten zu extrahieren, was zu einem besseren politischen Lernen führen kann.

Zusätzlich zum Lernen der Zustandsdarstellung wurde in früheren Arbeiten auch Transformer verwendet, um die zeitliche Abhängigkeit mehrerer Schritte zur Adressierung zu erfassen einige Probleme mit der Beobachtbarkeit.

In letzter Zeit hat Offline-RL aufgrund seiner Fähigkeit, große Offline-Datensätze zu nutzen, auch Aufmerksamkeit erregt. Verwandte Forschungsergebnisse zeigen auch, dass die Transformer-Architektur direkt als verwendet werden kann ein Modell zur Reihenfolgeentscheidung und kann auf mehrere Aufgaben und Domänen verallgemeinert werden.

Der Zweck dieser Forschungsarbeit besteht darin, das Gebiet der Transformers in Reinforcement Learning (TransformRL) vorzustellen.

Obwohl Transformer als Basismodell für die meisten aktuellen SL-Forschungen gilt, wird es in der RL-Community noch weniger erforscht. Im Vergleich zum SL-Feld erfordert die Verwendung von Transformer als Funktionsnäherung in RL tatsächlich die Lösung einiger anderer Probleme:

1 Die Trainingsdaten von RL-Agenten sind normalerweise a Funktion der aktuellen Richtlinie, die zu Nichtstationarität (Nichtstationarität) im Transformer-Lernprozess führt.

2 Bestehende RL-Algorithmen reagieren normalerweise sehr empfindlich auf Designentscheidungen während des Trainingsprozesses, einschließlich Netzwerkarchitektur und -kapazität.

3 Transformer-basierte Architekturen leiden oft unter hohen Rechen- und Speicherkosten, was bedeutet, dass Training und Inferenz langsam und teuer sind.

Beispielsweise wirkt sich in einigen Fällen künstlicher Intelligenz in Spielen die Effizienz der Probengenerierung stark auf die Trainingsleistung aus, abhängig vom Netzwerk und Wert der RL-Richtlinie Berechnen Sie die Kosten.

Die Zukunft von TransformRL

Der Fortschritt von Transformers für RL wird im Artikel kurz besprochen. Zu seinen Vorteilen gehören hauptsächlich: #🎜 🎜#

1 Transformers können als leistungsstarkes Modul in RL verwendet werden, beispielsweise als Darstellungsmodul oder Weltmodell; 2. Transformer Kann als Sequenzentscheider verwendet werden;

3. Transformer kann die Generalisierungsleistung über Aufgaben und Domänen hinweg verbessern.

Angesichts der Tatsache, dass Transformer in der breiteren Gemeinschaft der künstlichen Intelligenz eine starke Leistung gezeigt hat, glauben die Forscher, dass die Kombination von Transformer und RL eine vielversprechende Forschungsrichtung ist, wie im Folgenden einige Zukunftsaussichten aufgeführt und offene Fragen in diese Richtung.

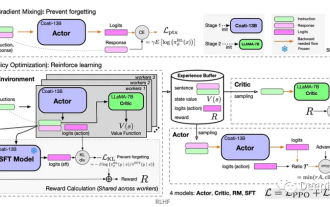

Kombination von Reinforcement Learning und (selbst-)überwachtem Lernen

Nachverfolgung Mit der Entwicklung von TransformRL kann festgestellt werden, dass seine Trainingsmethode sowohl RL als auch (selbst-)überwachtes Lernen abdeckt.

Bei Verwendung als Darstellungsmodul, das unter einem herkömmlichen RL-Framework trainiert wird, ist die Optimierung der Transformer-Architektur normalerweise instabil. Das Paradigma des (selbst)überwachten Lernens kann das tödliche Triadenproblem beseitigen, wenn Transformer zur Lösung von Entscheidungsproblemen durch Sequenzmodellierung verwendet werden.

Im Rahmen des (selbst)überwachten Lernens wird die Leistung der Strategie stark durch die Qualität der Offline-Daten eingeschränkt, und es gibt eine klare Unterscheidung zwischen Ausbeutung und Erkundung Der Kompromiss besteht nicht mehr, sodass bessere Richtlinien erlernt werden können, wenn RL und (selbst)überwachtes Lernen beim Transformer-Lernen kombiniert werden.

Einige Arbeiten haben beaufsichtigte Vortrainings- und Feinabstimmungslösungen für die RL-Teilnahme ausprobiert, aber bei relativ festen Strategien wird die Erkundung begrenzt sein, was ebenfalls einen Engpass darstellt gelöst werden Eine der Fragen.

Außerdem sind die zur Leistungsbewertung verwendeten Aufgaben relativ einfach. Transfomer kann dieses (selbst)überwachte Lernen auf größere Datensätze und komplexere Umgebungen skalieren Auch reale Anwendungen verdienen eine weitere Erforschung.

Darüber hinaus hoffen die Forscher, dass zukünftige Arbeiten mehr theoretische und empirische Einblicke in die Bedingungen liefern werden, unter denen solches (selbst-)überwachtes Lernen voraussichtlich gute Leistungen erbringen wird.

Verbinden Sie Online- und Offline-Lernen durch Transformer

Der Einstieg in Offline-RL ist ein Meilenstein für TransformRL, aber tatsächlich ist die Nutzung von Transformer zur Erfassung von Abhängigkeiten in Entscheidungssequenzen und zur Abstraktion von Strategien hauptsächlich mit der beträchtlichen Menge der verwendeten Offline-Daten verbunden .

Für einige Entscheidungsaufgaben ist es jedoch nicht möglich, in praktischen Anwendungen auf das Online-Framework zu verzichten.Einerseits ist es bei manchen Aufgaben nicht so einfach, an Expertendaten zu kommen, andererseits sind manche Umgebungen offen (wie Minecraft), Das bedeutet, dass Strategien kontinuierlich angepasst werden müssen, um Aufgaben zu bewältigen, die bei Online-Interaktionen nicht auftreten.

Forscher glauben daher, dass es notwendig ist, Online-Lernen und Offline-Lernen zu verbinden. Die meisten Forschungsfortschritte nach Decision Transformer konzentrieren sich auf Offline-Lernrahmen und einige Arbeitsversuche, das Paradigma des Offline-Vortrainings und der Online-Feinabstimmung zu übernehmen. Die Verteilungsverschiebung bei der Online-Feinabstimmung besteht jedoch immer noch bei Offline-RL-Algorithmen, und Forscher erwarten, dieses Problem durch einige spezielle Designs des Entscheidungstransformators zu lösen. Darüber hinaus ist es eine interessante offene Frage, wie man einen Online-Entscheidungstransformator von Grund auf trainiert. Auf Entscheidungsprobleme zugeschnittene Transformer-Struktur Die aktuelle Transformer-Struktur in der Methodenreihe Decision Transformer ist hauptsächlich Vanilla Transformer, der ursprünglich für Textsequenzen entwickelt wurde und möglicherweise einige Funktionen aufweist, die nicht geeignet sind für die Entscheidungsfindung Art des Problems. Ist es beispielsweise angemessen, einen Vanilla-Selbstaufmerksamkeitsmechanismus für Trajektoriensequenzen zu verwenden? Müssen verschiedene Elemente in einer Entscheidungssequenz oder verschiedene Teile desselben Elements bei der Positionseinbettung unterschieden werden? Da es darüber hinaus viele Varianten der Darstellung von Trajektorien als Sequenzen in verschiedenen Decision Transformer-Algorithmen gibt, mangelt es immer noch an systematischer Forschung, wie daraus ausgewählt werden kann. Wie wählt man beispielsweise robuste Hintsight-Informationen aus, wenn man solche Algorithmen in der Industrie einsetzt? Und der Vanilla-Transformer ist auch eine rechenintensive Struktur, was ihn sowohl in der Trainings- als auch in der Inferenzphase teuer macht und einen hohen Speicherbedarf hat, was auch die Länge der Abhängigkeiten begrenzt, die er erfassen kann. Um diese Probleme zu lindern, haben einige NLP-Arbeiten die Struktur von Transformer verbessert, es lohnt sich jedoch auch zu untersuchen, ob eine ähnliche Struktur für Entscheidungsprobleme verwendet werden kann. Verwenden Sie Transformers, um allgemeinere Agenten zu implementieren Die Überprüfung von Transformers für generalistische Agenten im Artikel hat das Potenzial von Transformers als allgemeine Strategie gezeigt. Tatsächlich ermöglicht das Design von Transformer die Verarbeitung mehrerer Modalitäten (wie Bilder, Videos, Text und Sprache) unter Verwendung eines ähnlichen Ansatzes zur Verarbeitung von Blöcken und zeigt eine hervorragende Skalierbarkeit für Netzwerke mit extrem großer Kapazität und große Datenmengen. Jüngste Arbeiten haben auch erhebliche Fortschritte bei der Schulung von Agenten gemacht, die in der Lage sind, multimodale und domänenübergreifende Aufgaben auszuführen. Angesichts der Tatsache, dass diese Agenten auf große Datensätze trainiert werden, ist noch nicht sicher, ob sie sich den Datensatz einfach merken und ob sie effektiv verallgemeinern können. Daher ist es immer noch eine Frage, die es wert ist, untersucht zu werden, wie man einen Agenten lernt, der ohne starke Annahmen auf ungesehene Aufgaben verallgemeinern kann. Darüber hinaus sind Forscher auch neugierig, ob Transformer leistungsstark genug ist, um ein allgemeines Weltmodell zu erlernen, das für verschiedene Aufgaben und Szenarien verwendet werden kann. RL für Transformers Obwohl in dem Artikel erläutert wurde, wie RL vom Transformer-Modell profitieren kann, ist die Verwendung von RL zur Verbesserung des Transformer-Trainings immer noch ein interessantes offenes Problem, das noch nicht gut erforscht ist . Wie Sie sehen können, kann das aktuelle Reinforcement Learning from Human Feedback (RLHF) ein Belohnungsmodell lernen und den RL-Algorithmus verwenden, um den Transformer zu optimieren, um das Sprachmodell mit menschlichen Absichten in Einklang zu bringen. In Zukunft glauben Forscher, dass RL ein nützliches Werkzeug sein kann, um die Leistung von Transformer in anderen Bereichen weiter zu verbessern.

Das obige ist der detaillierte Inhalt vonGemeinsam produziert von Qingbei! Eine Umfrage zum Verständnis der Besonderheiten des „Transformer+Reinforcement Learning'. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1376

1376

52

52

Probleme beim Design von Belohnungsfunktionen beim verstärkenden Lernen

Oct 09, 2023 am 11:58 AM

Probleme beim Design von Belohnungsfunktionen beim verstärkenden Lernen

Oct 09, 2023 am 11:58 AM

Probleme beim Design von Belohnungsfunktionen beim Reinforcement Learning Einführung Reinforcement Learning ist eine Methode, die optimale Strategien durch die Interaktion zwischen einem Agenten und der Umgebung lernt. Beim verstärkenden Lernen ist die Gestaltung der Belohnungsfunktion entscheidend für den Lerneffekt des Agenten. In diesem Artikel werden Probleme beim Design von Belohnungsfunktionen beim Reinforcement Learning untersucht und spezifische Codebeispiele bereitgestellt. Die Rolle der Belohnungsfunktion und der Zielbelohnungsfunktion sind ein wichtiger Teil des Verstärkungslernens und werden zur Bewertung des Belohnungswerts verwendet, den der Agent in einem bestimmten Zustand erhält. Sein Design hilft dem Agenten dabei, die langfristige Ermüdung durch die Auswahl optimaler Maßnahmen zu maximieren.

Tiefgreifendes Q-Learning-Verstärkungslernen mit der Roboterarmsimulation von Panda-Gym

Oct 31, 2023 pm 05:57 PM

Tiefgreifendes Q-Learning-Verstärkungslernen mit der Roboterarmsimulation von Panda-Gym

Oct 31, 2023 pm 05:57 PM

Reinforcement Learning (RL) ist eine Methode des maschinellen Lernens, die es einem Agenten ermöglicht, durch Versuch und Irrtum zu lernen, wie er sich in seiner Umgebung verhält. Agenten werden dafür belohnt oder bestraft, dass sie Maßnahmen ergreifen, die zu den gewünschten Ergebnissen führen. Im Laufe der Zeit lernt der Agent, Maßnahmen zu ergreifen, die seine erwartete Belohnung maximieren. RL-Agenten werden normalerweise mithilfe eines Markov-Entscheidungsprozesses (MDP) trainiert, einem mathematischen Rahmen zur Modellierung sequentieller Entscheidungsprobleme. MDP besteht aus vier Teilen: Zustand: eine Reihe möglicher Zustände der Umgebung. Aktion: Eine Reihe von Aktionen, die ein Agent ausführen kann. Übergangsfunktion: Eine Funktion, die die Wahrscheinlichkeit des Übergangs in einen neuen Zustand anhand des aktuellen Zustands und der aktuellen Aktion vorhersagt. Belohnungsfunktion: Eine Funktion, die dem Agenten für jede Conversion eine Belohnung zuweist. Das Ziel des Agenten besteht darin, eine Richtlinienfunktion zu erlernen.

Deep-Reinforcement-Learning-Technologie in C++

Aug 21, 2023 pm 11:33 PM

Deep-Reinforcement-Learning-Technologie in C++

Aug 21, 2023 pm 11:33 PM

Die Deep-Reinforcement-Learning-Technologie ist ein Zweig der künstlichen Intelligenz, der viel Aufmerksamkeit erregt hat. Sie hat mehrere internationale Wettbewerbe gewonnen und wird auch häufig in persönlichen Assistenten, autonomem Fahren, Spielintelligenz und anderen Bereichen eingesetzt. Bei der Umsetzung von Deep Reinforcement Learning ist C++ als effiziente und hervorragende Programmiersprache besonders wichtig, wenn die Hardwareressourcen begrenzt sind. Deep Reinforcement Learning kombiniert, wie der Name schon sagt, Technologien aus den beiden Bereichen Deep Learning und Reinforcement Learning. Um es einfach zu verstehen: Deep Learning bezieht sich auf das Lernen von Funktionen aus Daten und das Treffen von Entscheidungen durch den Aufbau eines mehrschichtigen neuronalen Netzwerks.

Eine weitere Revolution im Reinforcement Learning! DeepMind schlägt eine „Algorithmus-Destillation' vor: einen erforschbaren, vorab trainierten Reinforcement-Learning-Transformer

Apr 12, 2023 pm 06:58 PM

Eine weitere Revolution im Reinforcement Learning! DeepMind schlägt eine „Algorithmus-Destillation' vor: einen erforschbaren, vorab trainierten Reinforcement-Learning-Transformer

Apr 12, 2023 pm 06:58 PM

Bei aktuellen Sequenzmodellierungsaufgaben kann Transformer als die leistungsstärkste neuronale Netzwerkarchitektur bezeichnet werden, und das vorab trainierte Transformer-Modell kann Eingabeaufforderungen als Bedingungen oder In-Context-Lernen verwenden, um sich an verschiedene nachgelagerte Aufgaben anzupassen. Die Generalisierungsfähigkeit groß angelegter vorab trainierter Transformer-Modelle wurde in mehreren Bereichen überprüft, z. B. Textvervollständigung, Sprachverständnis, Bilderzeugung usw. Seit letztem Jahr gibt es relevante Arbeiten, die belegen, dass das Modell durch die Behandlung von Offline-Reinforcement-Learning (Offline-RL) als Sequenzvorhersageproblem Richtlinien aus Offline-Daten lernen kann. Aber aktuelle Ansätze lernen Richtlinien entweder aus Daten, die kein Lernen enthalten

Wie kann man die Go-Sprache verwenden, um tiefgreifende Forschung zum verstärkten Lernen durchzuführen?

Jun 10, 2023 pm 02:15 PM

Wie kann man die Go-Sprache verwenden, um tiefgreifende Forschung zum verstärkten Lernen durchzuführen?

Jun 10, 2023 pm 02:15 PM

Deep Reinforcement Learning (DeepReinforcementLearning) ist eine fortschrittliche Technologie, die Deep Learning und Reinforcement Learning kombiniert. Sie wird häufig in der Spracherkennung, Bilderkennung, Verarbeitung natürlicher Sprache und anderen Bereichen eingesetzt. Als schnelle, effiziente und zuverlässige Programmiersprache kann die Go-Sprache bei der tiefgreifenden Forschung zum Reinforcement Learning hilfreich sein. In diesem Artikel wird erläutert, wie Sie mithilfe der Go-Sprache tiefgreifende Forschung zum verstärkten Lernen durchführen können. 1. Installieren Sie die Go-Sprache und die zugehörigen Bibliotheken und beginnen Sie mit der Verwendung der Go-Sprache für tiefgreifendes, verstärkendes Lernen.

Steuerung eines doppelgelenkigen Roboterarms mit dem DDPG-Lernalgorithmus von Actor-Critic

May 12, 2023 pm 09:55 PM

Steuerung eines doppelgelenkigen Roboterarms mit dem DDPG-Lernalgorithmus von Actor-Critic

May 12, 2023 pm 09:55 PM

In diesem Artikel stellen wir das Training intelligenter Agenten zur Steuerung eines zweigelenkigen Roboterarms in der Reacher-Umgebung vor, einem Unity-basierten Simulationsprogramm, das mit dem UnityML-Agents-Toolkit entwickelt wurde. Unser Ziel ist es, die Zielposition mit hoher Genauigkeit zu erreichen, daher können wir hier den hochmodernen DeepDeterministicPolicyGradient (DDPG)-Algorithmus verwenden, der für kontinuierliche Zustands- und Aktionsräume entwickelt wurde. Praxisnahe Anwendungen Roboterarme spielen eine entscheidende Rolle in der Fertigung, in Produktionsanlagen, bei der Erforschung des Weltraums sowie bei Such- und Rettungseinsätzen. Es ist sehr wichtig, den Roboterarm mit hoher Präzision und Flexibilität zu steuern. Durch den Einsatz verstärkender Lerntechniken können diese Robotersysteme in die Lage versetzt werden, ihr Verhalten in Echtzeit zu lernen und anzupassen.

Wie kann man Reinforcement Learning nutzen, um die Benutzerbindung von Kuaishou zu verbessern?

May 07, 2023 pm 06:31 PM

Wie kann man Reinforcement Learning nutzen, um die Benutzerbindung von Kuaishou zu verbessern?

May 07, 2023 pm 06:31 PM

Das Hauptziel des Kurzvideo-Empfehlungssystems besteht darin, das DAU-Wachstum durch eine verbesserte Benutzerbindung voranzutreiben. Daher ist die Kundenbindung einer der wichtigsten Indikatoren für die Geschäftsoptimierung jeder APP. Bei der Aufbewahrung handelt es sich jedoch um eine langfristige Rückmeldung nach mehreren Interaktionen zwischen Benutzern und dem System, und es ist schwierig, sie in ein einzelnes Element oder eine einzelne Liste zu zerlegen. Daher ist es schwierig, die Aufbewahrung mithilfe herkömmlicher Punkt- und Listenfunktionen direkt zu optimieren. weise Modelle. Methoden des Reinforcement Learning (RL) optimieren langfristige Belohnungen durch die Interaktion mit der Umgebung und eignen sich zur direkten Optimierung der Nutzerbindung. Diese Arbeit modelliert das Aufbewahrungsoptimierungsproblem als Markov-Entscheidungsprozess (MDP) mit unendlicher Horizontanforderungsgranularität. Jedes Mal, wenn der Benutzer das Empfehlungssystem auffordert, über eine Aktion zu entscheiden, wird es verwendet, um mehrere verschiedene kurzfristige Feedbackschätzungen (Beobachtungsdauer,

Lernen Sie, eine Leiterplatte in 20 Minuten zusammenzubauen! Das Open-Source-SERL-Framework weist eine Erfolgsquote bei der Präzisionskontrolle von 100 % auf und ist dreimal schneller als Menschen

Feb 21, 2024 pm 03:31 PM

Lernen Sie, eine Leiterplatte in 20 Minuten zusammenzubauen! Das Open-Source-SERL-Framework weist eine Erfolgsquote bei der Präzisionskontrolle von 100 % auf und ist dreimal schneller als Menschen

Feb 21, 2024 pm 03:31 PM

Jetzt können Roboter Präzisionsaufgaben in der Fabriksteuerung erlernen. In den letzten Jahren wurden auf dem Gebiet der Lerntechnologie zur Verstärkung von Robotern erhebliche Fortschritte erzielt, z. B. beim Gehen im Vierfüßlerstand, beim Greifen, bei der geschickten Manipulation usw., die meisten davon beschränken sich jedoch auf die Labordemonstrationsphase. Die umfassende Anwendung der Robotic Reinforcement Learning-Technologie in tatsächlichen Produktionsumgebungen steht noch vor vielen Herausforderungen, was ihren Anwendungsbereich in realen Szenarien bis zu einem gewissen Grad einschränkt. Im Prozess der praktischen Anwendung der Reinforcement-Learning-Technologie ist es notwendig, mehrere komplexe Probleme zu überwinden, darunter die Einstellung des Belohnungsmechanismus, das Zurücksetzen der Umgebung, die Verbesserung der Probeneffizienz und die Gewährleistung der Aktionssicherheit. Branchenexperten betonen, dass die Lösung der vielen Probleme bei der tatsächlichen Implementierung der Reinforcement-Learning-Technologie ebenso wichtig ist wie die kontinuierliche Innovation des Algorithmus selbst. Vor dieser Herausforderung standen Forscher der University of California, Berkeley, der Stanford University, der University of Washington und